Transparens i AI-synlighetsinsatser: Bästa praxis för öppenhet

Lär dig väsentlig AI-transparens och de bästa praxis för öppenhet. Upptäck beteendemässiga, verbala och tekniska metoder för öppenhet för att bygga förtroende o...

Regulatoriska krav på att finansiella institutioner transparent redovisar sin användning av artificiell intelligens i beslutsfattande, riskhantering och kundnära applikationer. Omfattar SEC:s, CFPB:s, FINRA:s och andra myndigheters förväntningar på dokumentation av AI-styrning, modellprestanda och effekter på konsumenter och marknader.

Regulatoriska krav på att finansiella institutioner transparent redovisar sin användning av artificiell intelligens i beslutsfattande, riskhantering och kundnära applikationer. Omfattar SEC:s, CFPB:s, FINRA:s och andra myndigheters förväntningar på dokumentation av AI-styrning, modellprestanda och effekter på konsumenter och marknader.

Finansiell AI-redovisning avser de regulatoriska krav och bästa praxis som gäller för finansiella institutioner att transparent redovisa sin användning av artificiell intelligens i beslutsprocesser, riskhantering och kundnära applikationer. Det omfattar SEC:s, CFPB:s, FINRA:s och andra myndigheters förväntningar på dokumentation av AI-styrning, modellprestanda och potentiella effekter på konsumenter och marknader. I december 2024 lade SEC:s Investor Advisory Committee (IAC) fram en formell rekommendation om att myndigheten ska utfärda riktlinjer som kräver att emittenter redovisar information om påverkan av artificiell intelligens på deras företag. IAC hänvisade till en “brist på konsekvens” i samtida AI-redovisningar, vilket “kan vara problematiskt för investerare som söker tydlig och jämförbar information.” Endast 40 % av S&P 500-bolagen tillhandahåller AI-relaterad redovisning, och endast 15 % redovisar information om styrelsens tillsyn av AI, trots att 60 % av S&P 500-bolagen ser AI som en väsentlig risk.

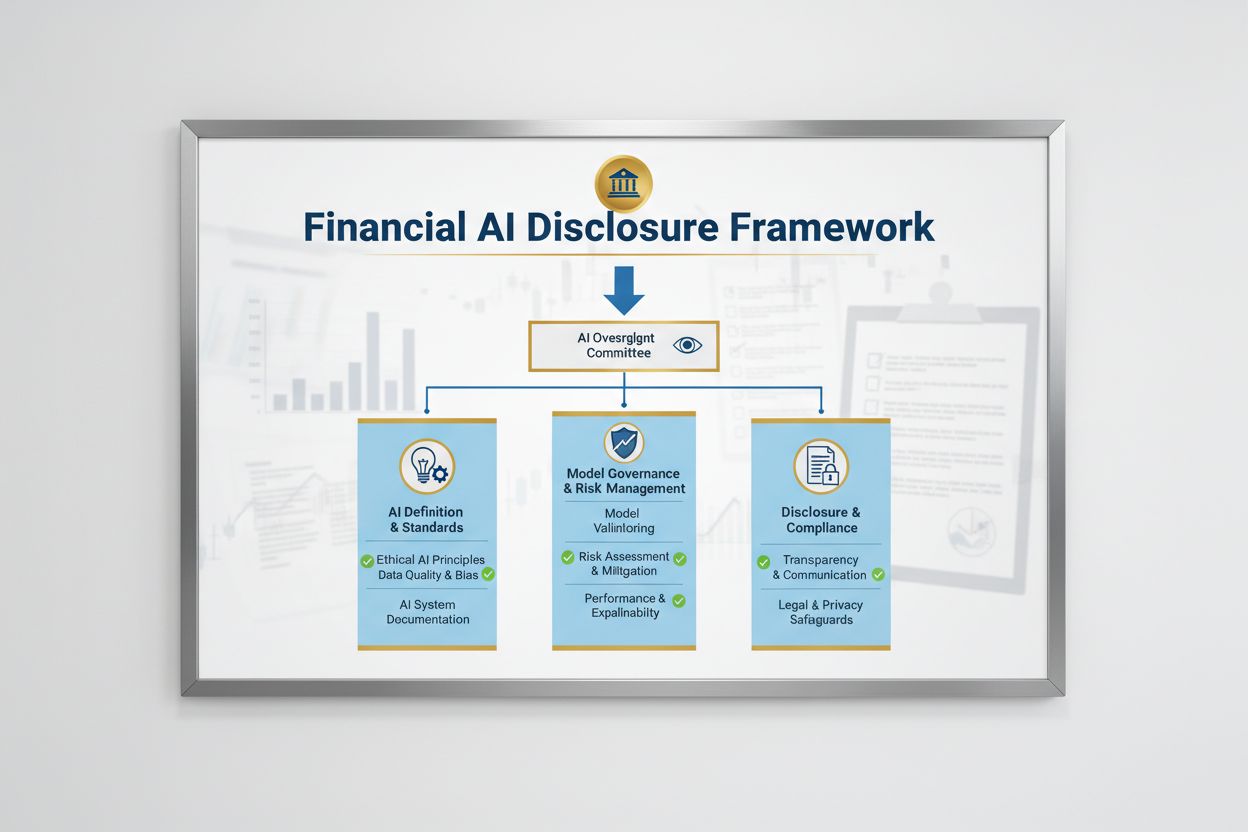

Det regulatoriska landskapet för finansiell AI-redovisning formas av flera federala myndigheter som tillämpar befintliga teknikneutrala lagar på AI-system. SEC:s Investor Advisory Committee föreslog en initial ram med tre huvudpelare: (1) att emittenter ska definiera vad de menar med “Artificiell Intelligens”, (2) redovisa styrelsens tillsynsmekanismer för AI-implementering, och (3) rapportera om väsentliga AI-implementeringar och deras effekter på interna processer och kundnära produkter. Utöver SEC har CFPB, FINRA, OCC och Federal Reserve alla utfärdat riktlinjer som betonar att befintliga konsumentskyddslagar – inklusive regler om rättvis kreditgivning, dataskydd och bedrägeribekämpning – gäller AI-system oavsett teknik. Dessa myndigheter har ett teknikneutralt synsätt, vilket innebär att skyldigheter enligt Equal Credit Opportunity Act (ECOA), Fair Credit Reporting Act (FCRA), Gramm-Leach-Bliley Act (GLBA) och Unfair or Deceptive Acts or Practices (UDAAP) kvarstår när AI används.

| Regulator | Fokusområde | Nyckelkrav |

|---|---|---|

| SEC | Investerarredovisning, intressekonflikter | Definiera AI, redovisa styrelsens tillsyn, rapportera väsentliga implementeringar |

| CFPB | Rättvis kreditgivning, konsumentskydd | Säkerställ att AI-modeller följer ECOA, tillhandahåll negativa beslutsmeddelanden |

| FINRA | Värdepappershandel, kundkommunikation | Upprätta AI-styrningspolicyer, övervaka AI-användning i alla funktioner |

| OCC/Federal Reserve/FDIC | Bankmodellstyrning, operativ risk | Validera AI-modeller, dokumentera kontroller, bedöm tillförlitlighet |

| FTC | Bedrägliga metoder, datahantering | Övervaka AI-relaterade påståenden, förhindra otillbörlig dataanvändning |

Effektiv finansiell AI-redovisning kräver tydlig tillsyn på styrelsenivå av AI-implementering och riskhantering. SEC:s IAC-rekommendation betonar att investerare har ett legitimt intresse av att förstå om det finns tydliga ansvarslinjer kring implementering av AI-teknik i interna processer och produktlinjer. Finansiella institutioner måste upprätta styrningsstrukturer som tilldelar ansvar för AI-tillsyn till styrelsen eller en utsedd styrelsekommitté, så att AI-relaterade risker hanteras på högsta organisationsnivå. Denna styrningsram ska inkludera dokumenterade policyer och rutiner för AI-utveckling, testning, validering och implementering, med regelbunden rapportering till styrelsen om modellprestanda, identifierade risker och åtgärder. Utan tydligt styrelseansvar riskerar finansiella institutioner regulatorisk granskning och eventuella ingripanden för bristande tillsyn av väsentliga AI-system.

Finansiella institutioner måste separat redovisa de väsentliga effekterna av AI-implementering på interna processer och kundnära produkter. För interna processer ska redovisningen behandla AI:s påverkan på humankapital (såsom personalneddragningar eller behov av kompetensutveckling), korrekthet i finansiell rapportering, styrningsprocesser och cybersäkerhetsrisker. För kundnära frågor ska institutioner redovisa investeringar i AI-drivna plattformar, integration av AI i produkter och tjänster, regulatoriska effekter av AI-användning samt hur AI påverkar prissättningsstrategier och affärsmål. SEC rekommenderar att dessa redovisningar integreras i befintliga disclosure-poster enligt Regulation S-K (såsom Items 101, 103, 106 och 303) baserat på väsentlighet, snarare än att skapa helt nya kategorier. Detta tillvägagångssätt gör att finansiella institutioner kan använda befintliga ramar och samtidigt ge investerare tydlig, jämförbar information om AI:s roll i verksamhet och strategi.

Hög datakvalitet är grundläggande för ansvarsfull AI-användning inom finansiella tjänster, men många institutioner har svårt att skapa datastyrningsramverk som möter regulatoriska förväntningar. Finansiella institutioner måste säkerställa att data som används för att träna, testa och validera AI-modeller är ren, komplett, standardiserad och heltäckande, med tydlig dokumentation av datakällor, härkomst och eventuella begränsningar. Dataskyddsåtgärder måste förebygga “datagiftning” – manipulation av träningsdata för att underminera modellernas integritet – samt skydda mot obehörig åtkomst eller röjande av känslig information. Gramm-Leach-Bliley Act (GLBA) ger grundskydd för konsumentdata, men många tillsynsmyndigheter och konsumentförespråkare menar att skyddet är otillräckligt i AI-sammanhang, särskilt mot bakgrund av ökad datainsamling och användning för modellträning. Finansiella institutioner måste även hantera immaterialrättsliga frågor genom att säkerställa rätt till användning av data för AI-utveckling och respektera tredje parts immateriella rättigheter. Att införa robusta datastyrningsramverk, inklusive principer för dataminimering, åtkomstkontroller och regelbundna revisioner, är avgörande för att visa regulatorisk efterlevnad.

Tillsynsmyndigheter har tydliggjort att AI-modeller som används vid finansiella beslut måste testas för bias och potentiellt diskriminerande utfall, oavsett modellens övergripande noggrannhet eller prestanda. “Black box”-problemet – där komplexa AI-system producerar resultat som är svåra eller omöjliga att förklara – innebär stora efterlevnadsrisker, särskilt i kundnära tillämpningar som kreditprövning, prissättning och bedrägeribekämpning. Finansiella institutioner måste införa processer för att upptäcka och motverka bias genom hela modellens livscykel, inklusive biastester vid utveckling, validering och löpande övervakning. Efterlevnad av rättvis kreditgivning kräver att institutioner kan förklara de specifika skälen till negativa beslut (som kreditavslag) och visa att AI-modellen inte har en negativ effekt på skyddade grupper. Tester av “mindre diskriminerande alternativ” – metoder som uppnår samma affärsmål med mindre bias – förväntas alltmer av tillsynsmyndigheter. Många institutioner inför förklarbar AI (xAI), till exempel analys av feature importance och beslutsgränser, för att öka transparens och ansvar i AI-beslut.

Finansiella institutioner som använder AI i kundnära applikationer måste följa befintliga konsumentskyddslagar, inklusive krav på negativa beslutsmeddelanden, dataskydd och rättvis behandling. När ett AI-system används för att fatta eller påverka beslut om kredit, försäkring eller andra finansiella produkter har konsumenter rätt att få veta varför de nekades eller fick sämre villkor. CFPB har betonat att kreditgivare som omfattas av Equal Credit Opportunity Act (ECOA) inte får använda “black box”-modeller när de inte kan ge specifika och korrekta skäl till negativa beslut. Dessutom gäller UDAAP-standarder för AI-system som kan skada konsumenter genom oklar datainsamling, integritetsbrott eller att styra mot olämpliga produkter. Finansiella institutioner måste säkerställa att AI-system som används i kundservice, produktrekommendationer och kontohantering är transparenta med sin AI-användning och ger tydlig information om hur konsumentdata samlas in, används och skyddas.

De flesta finansiella institutioner förlitar sig på tredjepartsleverantörer för att utveckla, implementera eller underhålla AI-system, vilket innebär betydande skyldigheter inom hantering av tredjepartsrisker (TPRM). De federala bankmyndigheternas Interagency Guidance on Third-Party Relationships betonar att finansiella institutioner fortfarande är ansvariga för prestanda och efterlevnad av tredjeparts AI-system, även om de inte själva utvecklat modellen. Effektiv TPRM för AI kräver grundlig due diligence före leverantörsavtal, inklusive bedömning av leverantörens datastyrning, modellvalidering och förmåga att ge insyn i modellernas funktion. Finansiella institutioner måste även övervaka koncentrationsrisk – den potentiella systemeffekten om ett fåtal AI-leverantörer drabbas av störningar eller fel. Risker i leverantörskedjan, inklusive datakällors tillförlitlighet och stabiliteten i tredjepartsinfrastruktur, måste utvärderas och dokumenteras. Avtal med AI-leverantörer bör innehålla tydliga krav på datasäkerhet, modellövervakning, incidentrapportering och möjlighet till revision eller testning av AI-systemet. Mindre finansiella institutioner kan särskilt ha svårt med den tekniska kompetens som krävs för att utvärdera komplexa AI-system, vilket skapar behov av branschstandarder eller certifieringsprogram för leverantörsgranskning.

Finansiella institutioner som verkar över landsgränser möter en alltmer komplex väv av AI-regleringar, där EU:s AI-förordning är den mest omfattande ramen hittills. EU AI Act klassar AI-system som används i kreditbedömning, bedrägeribekämpning och anti-penningtvätt som “högrisk”, vilket kräver omfattande dokumentation, biastester, mänsklig tillsyn och konformitetsprövning. OECD och G7 har också utfärdat principer och rekommendationer för ansvarsfull AI-styrning inom finansiella tjänster, med fokus på transparens, rättvisa, ansvar och mänsklig tillsyn. Många av dessa internationella standarder har extraterritoriell räckvidd, vilket innebär att finansiella institutioner som betjänar kunder inom EU, Storbritannien eller andra reglerade jurisdiktioner kan behöva följa dessa standarder även om de är baserade någon annanstans. Arbetet med regulatorisk harmonisering pågår, men betydande skillnader kvarstår mellan olika jurisdiktioner, vilket skapar efterlevnadsutmaningar för globala finansiella institutioner. Proaktiv anpassning till de högsta internationella standarderna – såsom EU AI Act och OECD-principerna – kan hjälpa institutioner att förbereda sig för framtida regler och minska risken för ingripanden i flera jurisdiktioner.

Finansiella institutioner bör implementera omfattande dokumentations- och styrningspraxis för att visa efterlevnad av förväntningar kring finansiell AI-redovisning. Viktiga bästa praxis inkluderar:

Genom att anta dessa praxis kan finansiella institutioner minska regulatoriska risker, bygga förtroende hos intressenter och positionera sig som ledare inom ansvarsfull AI-användning inom finanssektorn.

Finansiell AI-redovisning avser regulatoriska krav på att finansiella institutioner transparent redovisar sin användning av artificiell intelligens i beslutsfattande, riskhantering och kundnära applikationer. Det omfattar SEC:s, CFPB:s, FINRA:s och andra myndigheters förväntningar på dokumentation av AI-styrning, modellprestanda och effekter på konsumenter och marknader. SEC:s Investor Advisory Committee rekommenderade i december 2024 att finansiella institutioner definierar sin användning av AI, redovisar styrelsens tillsynsmekanismer och rapporterar om väsentliga AI-implementeringar.

Finansiella institutioner måste redovisa AI-användning för att skydda investerare, konsumenter och marknadens integritet. Tillsynsmyndigheter har funnit att endast 40 % av S&P 500-bolagen tillhandahåller AI-relaterad redovisning, vilket skapar inkonsekvens och informationsluckor för investerare. Redovisningskrav säkerställer att intressenter förstår hur AI påverkar finansiella beslut, riskhantering och konsumentutfall. Dessutom gäller befintliga konsumentskyddslagar – inklusive regler om rättvis kreditgivning och dataskydd – även AI-system, vilket gör redovisning avgörande för regulatorisk efterlevnad.

SEC:s Investor Advisory Committee rekommenderade tre huvudpelare för AI-redovisning: (1) att emittenter måste definiera vad de menar med 'Artificiell Intelligens', (2) redovisa styrelsens tillsynsmekanismer för AI-implementering, och (3) rapportera om väsentliga AI-implementeringar och deras effekter på interna processer och kundnära produkter. Dessa rekommendationer syftar till att ge investerare tydlig och jämförbar information om hur AI påverkar finansiella institutioners verksamhet och strategi.

Finansiell AI-redovisning fokuserar specifikt på regulatoriska krav för transparent kommunikation om AI-användning till externa intressenter (investerare, tillsynsmyndigheter, konsumenter), medan allmän AI-styrning avser interna processer och kontroller för att hantera AI-system. Redovisning är den utåtriktade delen av AI-styrningen och säkerställer att intressenter har tillgång till väsentlig information om AI-implementering, risker och effekter. Båda är viktiga för ansvarsfull AI-användning inom finansiella tjänster.

Redovisning av AI-implementering ska omfatta både interna processer och effekter på kundnära verksamhet. För interna processer bör institutioner redovisa påverkan på humankapital, finansiell rapportering, styrning och cybersäkerhetsrisker. För kundnära produkter ska redovisningen täcka investeringar i AI-drivna plattformar, integration av AI i produkter, regulatoriska effekter och hur AI påverkar prissättning eller affärsstrategier. Redovisningen bör integreras i befintliga regulatoriska redovisningspunkter (såsom SEC:s Regulation S-K) baserat på väsentlighet.

Regler om rättvis kreditgivning, inklusive Equal Credit Opportunity Act (ECOA) och Fair Credit Reporting Act (FCRA), gäller AI-system som används vid kreditbeslut oavsett teknik. Finansiella institutioner måste kunna förklara de specifika skälen för negativa beslut (t.ex. kreditavslag) och visa att deras AI-modeller inte har en negativ effekt på skyddade grupper. Tillsynsmyndigheter förväntar sig att institutionerna testar AI-modeller för bias, använder 'mindre diskriminerande alternativ' där det är lämpligt och dokumenterar tester av rättvisa och validering.

De flesta finansiella institutioner förlitar sig på tredjepartsleverantörer för AI-system, vilket skapar betydande skyldigheter kring hantering av tredjepartsrisker (TPRM). Finansiella institutioner är fortsatt ansvariga för prestanda och efterlevnad av tredjeparts AI-system, även om de inte själva utvecklat modellen. Effektiv TPRM för AI kräver grundlig due diligence, löpande övervakning, bedömning av leverantörens datastyrning och dokumentation av modellprestanda. Institutioner måste även övervaka koncentrationsrisk – den potentiella systemeffekten om ett fåtal AI-leverantörer drabbas av störningar.

Europeiska unionens AI-förordning utgör den mest omfattande regulatoriska ramen för AI och klassar finansiella AI-system som 'högrisk', vilket kräver omfattande dokumentation, biastester och mänsklig tillsyn. OECD och G7 har också utfärdat principer för ansvarsfull AI-styrning. Många av dessa internationella standarder har extraterritoriell räckvidd, vilket innebär att finansiella institutioner som betjänar kunder i reglerade jurisdiktioner kan behöva följa dessa standarder. Proaktiv anpassning till internationella standarder kan hjälpa institutioner att förbereda sig för framtida regler och minska risken för ingripanden.

Spåra hur din finansiella institution refereras i AI-svar över GPT:er, Perplexity och Google AI Overviews. Säkerställ att ditt varumärke behåller synlighet och korrekthet i AI-genererat finansiellt innehåll.

Lär dig väsentlig AI-transparens och de bästa praxis för öppenhet. Upptäck beteendemässiga, verbala och tekniska metoder för öppenhet för att bygga förtroende o...

Övervaka hur ditt finansiella varumärke syns i AI-genererade svar. Lär dig regelefterlevnad, synlighetsstrategier och optimeringstekniker för reglerade finansie...

Lär dig hur AI-plattformar som ChatGPT, Perplexity och Google AI Overviews utvärderar finansiellt innehåll. Förstå YMYL-krav, E-E-A-T-standarder och efterlevnad...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.