Medicinsk E-E-A-T: Bygg trovärdigt hälsoinnehåll för AI

Lär dig hur du bygger trovärdigt hälsoinnehåll med hjälp av E-E-A-T-principerna. Upptäck strategier för att etablera medicinsk auktoritet, expertis och förtroen...

Efterlevnad av AI inom hälso- och sjukvård syftar på att artificiella intelligenssystem som används inom hälso- och sjukvården följer tillämpliga regulatoriska, juridiska och etiska standarder som styr deras utveckling, implementering och drift. Detta omfattar krav på medicinsk noggrannhet, patientsäkerhet, dataskydd och klinisk effektivitet över flera jurisdiktioner. Efterlevnadslandskapet bygger på YMYL-standarder (Your Money or Your Life) och krav på medicinsk noggrannhet som kräver evidensbaserad validering av kliniska påståenden.

Efterlevnad av AI inom hälso- och sjukvård syftar på att artificiella intelligenssystem som används inom hälso- och sjukvården följer tillämpliga regulatoriska, juridiska och etiska standarder som styr deras utveckling, implementering och drift. Detta omfattar krav på medicinsk noggrannhet, patientsäkerhet, dataskydd och klinisk effektivitet över flera jurisdiktioner. Efterlevnadslandskapet bygger på YMYL-standarder (Your Money or Your Life) och krav på medicinsk noggrannhet som kräver evidensbaserad validering av kliniska påståenden.

Efterlevnad av AI inom hälso- och sjukvård syftar på att artificiella intelligenssystem som används inom hälso- och sjukvården följer tillämpliga regulatoriska, juridiska och etiska standarder som styr deras utveckling, implementering och drift. Detta omfattar ett omfattande ramverk som säkerställer att AI-drivna vårdlösningar uppfyller strikta krav på medicinsk noggrannhet, patientsäkerhet, dataskydd och klinisk effektivitet. Vikten av efterlevnad av AI inom hälso- och sjukvård kan inte överskattas, eftersom bristande efterlevnad kan leda till skada för patienter, regulatoriska påföljder, förlust av klinisk trovärdighet och juridiskt ansvar för vårdorganisationer och teknikleverantörer. Efterlevnadslandskapet bygger på två grundpelare: YMYL-standarder (Your Money or Your Life) som betonar innehållets trovärdighet och krav på medicinsk noggrannhet som kräver evidensbaserad validering av kliniska påståenden. Organisationer som implementerar AI inom hälso- och sjukvården måste navigera i komplexa regulatoriska krav över flera jurisdiktioner samtidigt som de upprätthåller högsta nivå av transparens och ansvarstagande.

YMYL (Your Money or Your Life) är ett Google-koncept för sökkvalitet som identifierar innehållskategorier där felaktigheter direkt kan påverka användarens hälsa, säkerhet, ekonomiska stabilitet eller välbefinnande. I vårdsammanhang gäller YMYL för alla AI-system som tillhandahåller medicinsk information, diagnostiskt stöd, behandlingsrekommendationer eller hälsoråd, eftersom dessa direkt påverkar kritiska hälsobeslut. Googles E-E-A-T-kriterier—Expertis, Erfarenhet, Auktoritet och Trovärdighet—fastställer kvalitetsnivån för vårdinnehåll och kräver att AI-system uppvisar klinisk kunskap, validering i verkliga miljöer, erkänd auktoritet inom medicinska områden och konsekvent tillförlitlighet. AI-system inom hälso- och sjukvården måste uppfylla YMYL-standarder genom att säkerställa att alla medicinska påståenden stöds av kliniska bevis, tydligt redovisa AI:s inblandning i rekommendationer och upprätthålla transparent dokumentation av träningsdatakällor och valideringsmetoder. Ett avgörande krav för YMYL-kompatibel AI inom hälso- och sjukvård är granskning av legitimerad kliniker, där kvalificerade medicinska experter validerar AI-resultat före klinisk användning och etablerar tillsynsmekanismer för kontinuerlig övervakning av prestanda. Tabellen nedan illustrerar hur YMYL-krav översätts till specifika implementationsstandarder för AI inom hälso- och sjukvård:

| Krav | YMYL-standard | Implementering inom AI för hälso- och sjukvård |

|---|---|---|

| Innehållets noggrannhet | Påståenden måste vara faktamässigt korrekta och evidensbaserade | AI-algoritmer validerade mot kliniska guldstandarder med dokumenterade känslighets-/specificitetsmått |

| Källauktoritet | Innehåll skapat av erkända experter | AI-system utvecklade med kliniska rådgivande grupper och granskade valideringsstudier |

| Transparens | Tydlig information om innehållets begränsningar | Tydlig märkning av AI-inblandning, tillförlitlighetspoäng och begränsningar i användargränssnitt |

| Expertisdemonstration | Visad ämneskunskap | Protokoll för klinisk granskning, fortbildning för AI-utvecklare och dokumenterad klinisk expertis hos valideringsteam |

| Trovärdighetssignaler | Meriter, källhänvisningar och professionell status | Regulatoriska godkännanden (FDA), kliniska studiedata, institutionsanknytningar och tredjepartsgranskningar |

| Biasminskning | Rättvis representation över demografier | Validering över olika patientgrupper med dokumenterad rättviseanalys och bias-testresultat |

FDA (Food and Drug Administration) har en central reglerande roll i tillsynen av AI-baserade medicintekniska produkter och fastställer krav före och efter marknadsintroduktion för att säkerställa säkerhet och effektivitet innan klinisk användning. Software as a Medical Device (SaMD)-klassificering avgör regulatoriska vägar baserat på risknivå, där AI-system som diagnostiserar, behandlar eller övervakar medicinska tillstånd vanligtvis kräver FDA-tillsyn. FDA erbjuder tre huvudsakliga förhandsgranskningsvägar: 510(k)-vägen för produkter som är väsentligen likvärdiga med befintliga godkända produkter (vanligast för AI-applikationer med lägre risk), De Novo-vägen för nya AI-teknologier utan föregångare och PMA (Premarket Approval) för högriskprodukter som kräver omfattande kliniska bevis. Krav på prestandabedömning och validering innebär att utvecklare måste genomföra rigorösa tester som visar algoritmens noggrannhet, robusthet över olika patientgrupper och säkerhet i verkliga kliniska miljöer, samt dokumentation av träningsdata, valideringsmetoder och prestandamått. FDA:s AI/ML-handlingsplan från 2021 och efterföljande vägledningsdokument betonar behovet av algoritmtransparens, övervakning av prestanda i verklig miljö och ändringsprotokoll som säkerställer att AI-system bibehåller klinisk validitet när de utvecklas vidare. Vårdgivare måste ha omfattande regulatorisk dokumentation inklusive kliniska valideringsstudier, riskbedömningar och bevis på efterlevnad av tillämplig FDA-vägledning under hela produktens livscykel.

HIPAA (Health Insurance Portability and Accountability Act) efterlevnad är obligatorisk för alla AI-system inom hälso- och sjukvården som behandlar skyddad hälsodata (PHI) och kräver strikta kontroller över hur patientdata samlas in, lagras, överförs och används vid AI-modellträning och inferens. Privacy Rule begränsar användning och utlämnande av PHI till minimalt nödvändiga nivåer, medan Security Rule kräver tekniska och administrativa skyddsåtgärder såsom kryptering, åtkomstkontroller, granskningsloggar samt rutiner för incidentrapportering för AI-system som hanterar känslig hälsodata. Avidentifiering av träningsdata är en viktig efterlevnadsmekanism som kräver borttagning eller omvandling av 18 specifika identifierare för att möjliggöra AI-utveckling utan direkt exponering av PHI, även om återidentifieringsrisker kvarstår med avancerad analys. Vårdorganisationer står inför unika utmaningar vid implementering av AI under HIPAA, inklusive att balansera behovet av stora, representativa datamängder för modellträning mot strikta principer om dataminimering, hantera tredjepartsleverantörers efterlevnad vid utkontraktering av AI-utveckling, och upprätthålla granskningsspår som visar HIPAA-efterlevnad under hela AI-livscykeln. HIPAA-efterlevnad är inte valfri utan grundläggande för AI-implementering inom hälso- och sjukvården, eftersom överträdelser leder till betydande civilrättsliga påföljder, straffrättsligt ansvar och oåterkallelig skada på organisationens rykte och patientförtroende.

Klinisk validering av AI-algoritmer inom hälso- och sjukvården kräver rigorösa bevisstandarder som visar att AI-system presterar säkert och effektivt i avsedda kliniska användningsområden innan de används i stor skala. Vårdorganisationer måste upprätta valideringsramverk som är anpassade till kliniska studiedesigner, inklusive prospektiva studier där AI-rekommendationer jämförs med guldstandarddiagnoser, bedömning av prestanda över olika patientgrupper och dokumentation av felmönster och gränsfall där AI-prestandan försämras. Identifiering av bias och rättvisa är avgörande delar av valideringen och kräver systematisk utvärdering av AI-prestanda mellan olika etniska, köns-, ålders- och socioekonomiska grupper för att identifiera och motverka algoritmisk snedvridning som kan förstärka ojämlikheter inom vården. Förklarbarhet och tolkbarhet är krav som säkerställer att kliniker kan förstå AI:s resonemang, verifiera rekommendationer mot kliniskt omdöme och identifiera när AI-resultat bör ifrågasättas eller utredas vidare. Följande centrala valideringskrav utgör grunden för kliniskt välgrundad AI inom hälso- och sjukvården:

GDPR (General Data Protection Regulation) och internationella dataskyddsramverk fastställer strikta krav för AI-system inom hälso- och sjukvård som verkar över landsgränser, med särskild betoning på patientens samtycke, dataminimering och individuella rättigheter till åtkomst och radering. EU AI Act inför riskbaserad reglering av AI-system, klassificerar AI inom hälso- och sjukvård som hög risk och kräver bedömning av efterlevnad, mänsklig tillsyn och transparensdokumentation före marknadsintroduktion. Regionala variationer i reglering av AI för hälso- och sjukvård speglar olika politiska prioriteringar: Storbritannien upprätthåller GDPR-anpassade standarder med sektorsspecifik vägledning från Information Commissioner’s Office, Australien betonar algoritmisk transparens och ansvar genom Automated Decision Systems-ramverket, och Kanada kräver efterlevnad av PIPEDA (Personal Information Protection and Electronic Documents Act) med vårdspecifika tillämpningar. Harmoniseringsinitiativ via internationella standardiseringsorganisationer som ISO och IEC driver fram gemensamma ramverk för AI-validering, riskhantering och dokumentation, även om betydande regulatoriska skillnader kvarstår mellan jurisdiktioner. Global efterlevnad är viktig eftersom vårdorganisationer och AI-leverantörer som verkar internationellt måste navigera i överlappande och ibland motstridiga regelverk, vilket kräver styrningsstrukturer som uppfyller de högsta tillämpliga standarderna i samtliga regioner.

Effektiv efterlevnad av AI inom hälso- och sjukvård kräver att robusta styrningsramverk etableras som definierar roller, ansvar och beslutsmandat för AI-utveckling, validering, implementering och övervakning inom organisationen. Dokumentation och granskningsspår är kritiska efterlevnadsmekanismer och kräver omfattande register över beslut under algoritmutveckling, protokoll och resultat från valideringsstudier, kliniska granskningsprocesser, användarutbildning och prestandaövervakning, vilka visar efterlevnad vid regulatoriska inspektioner och rättsliga processer. Övervakning efter marknadsintroduktion och kontinuerliga övervakningsprotokoll säkerställer att implementerade AI-system bibehåller klinisk validitet över tid, med systematisk insamling av prestandadata från verkliga miljöer, identifiering av prestandaförsämring eller nya säkerhetsproblem samt dokumenterade rutiner för återträning eller modifiering av algoritmer. Leverantörshantering och tredjepartsprogram för efterlevnad etablerar avtalskrav, granskningsrutiner och prestandastandarder som säkerställer att externa utvecklare, dataleverantörer och tjänsteleverantörer uppfyller organisationens efterlevnadskrav och regulatoriska skyldigheter. Hälso- och sjukvårdsorganisationer bör införa styrningsstrukturer inklusive kliniska rådgivande grupper, efterlevnadskommittéer och tvärfunktionella team för AI-tillsyn, etablera granskningsspår som dokumenterar alla betydande beslut och ändringar, genomföra regelbundna granskningar efter marknadsintroduktion samt upprätthålla omfattande leverantörsavtal med specificerade efterlevnadsansvar och prestandastandarder.

Vårdgivare står inför betydande efterlevnadsgap i nuvarande AI-implementeringar, inklusive otillräcklig klinisk validering av algoritmer före användning, bristande biasbedömning över olika patientgrupper och begränsad transparens kring AI:s roll i kliniska beslut. Det regulatoriska landskapet utvecklas snabbt, med uppdaterade FDA-vägledningar, internationella standarder och vårdpolicyramverk som förändras ofta, vilket skapar osäkerhet för organisationer som vill implementera avancerad AI-teknik samtidigt som de bibehåller regulatorisk efterlevnad. Nya verktyg och teknologier förbättrar möjligheterna till efterlevnadsövervakning; till exempel hjälper plattformar som AmICited organisationer att spåra hur AI-system inom hälso- och sjukvård och efterlevnadsinformation refereras i det bredare AI-ekosystemet, vilket ger insyn i hur vårdvarumärken och regulatorisk vägledning integreras i andra AI-system. Framtida efterlevnadstrender pekar mot ökat fokus på övervakning av prestanda i verklig miljö, algoritmisk transparens och förklarbarhet, rättvise- och jämlikhetsbedömning samt kontinuerliga valideringsramverk som betraktar AI-implementering som en pågående process snarare än en engångsgodkännandehändelse. Vårdorganisationer måste anta proaktiva strategier för efterlevnad som förutser regulatorisk utveckling, investera i styrningsstruktur och klinisk expertis samt bibehålla flexibilitet för att anpassa sig i takt med att standarder och förväntningar fortsätter att utvecklas.

Efterlevnad av AI inom hälso- och sjukvård syftar på att artificiella intelligenssystem följer regulatoriska, juridiska och etiska standarder som styr deras utveckling, implementering och drift inom vårdmiljöer. Det omfattar krav på medicinsk noggrannhet, patientsäkerhet, dataskydd och klinisk effektivitet, vilket säkerställer att AI-system uppfyller YMYL-standarder och krav på evidensbaserad validering innan klinisk användning.

YMYL (Your Money or Your Life) är ett Google-koncept för sökkvalitet som identifierar innehåll som kan påverka användarens hälsa och välbefinnande avsevärt. AI-system inom hälso- och sjukvård måste uppfylla YMYL-standarder genom att säkerställa att alla medicinska påståenden stöds av kliniska bevis, tydligt redovisa AI:s inblandning och upprätthålla transparent dokumentation av träningsdatakällor och valideringsmetoder.

De främsta regulatoriska ramverken inkluderar FDA:s tillsyn av AI-baserade medicintekniska produkter, HIPAA-efterlevnad för system som hanterar skyddad hälsodata, GDPR och EU AI Act för internationellt dataskydd samt regionala standarder i Storbritannien, Australien och Kanada. Varje ramverk fastställer specifika krav på säkerhet, effektivitet, integritet och transparens.

Klinisk validering är en rigorös testprocess som visar att AI-system fungerar säkert och effektivt i avsedda kliniska användningsområden. Den inkluderar prospektiva studier som jämför AI-rekommendationer med guldstandarddiagnoser, bedömning av prestanda över olika patientgrupper, identifiering av bias och rättvisebedömning samt dokumentation av förklarbarhet och tolkbarhet för klinikers förståelse.

HIPAA-efterlevnad är obligatorisk för alla AI-system inom hälso- och sjukvård som behandlar skyddad hälsodata (PHI). Det kräver strikta kontroller över datainsamling, lagring, överföring och användning i AI-modellträning, inklusive kryptering, åtkomstkontroller, granskningsloggar, rutiner för incidentrapportering samt avidentifiering av träningsdata för att ta bort eller omvandla 18 specifika identifierare.

FDA övervakar AI-baserade medicintekniska produkter genom förhandsgranskningsvägar, inklusive 510(k) för i stort sett likvärdiga produkter, De Novo-klassificering för nya AI-teknologier och PMA-godkännande för högriskprodukter. FDA kräver omfattande dokumentation av algoritmutveckling, valideringsstudier, prestandamått, övervakning i verkliga miljöer och modifieringsprotokoll under produktens hela livscykel.

Stora utmaningar inkluderar otillräcklig klinisk validering före implementering, bristande biasbedömning över olika patientgrupper, begränsad transparens kring AI:s roll i kliniska beslut, balansgång mellan dataminimering och behov av träningsdata, hantering av tredjepartsleverantörers efterlevnad samt att navigera i snabbt föränderliga regulatoriska landskap över flera jurisdiktioner.

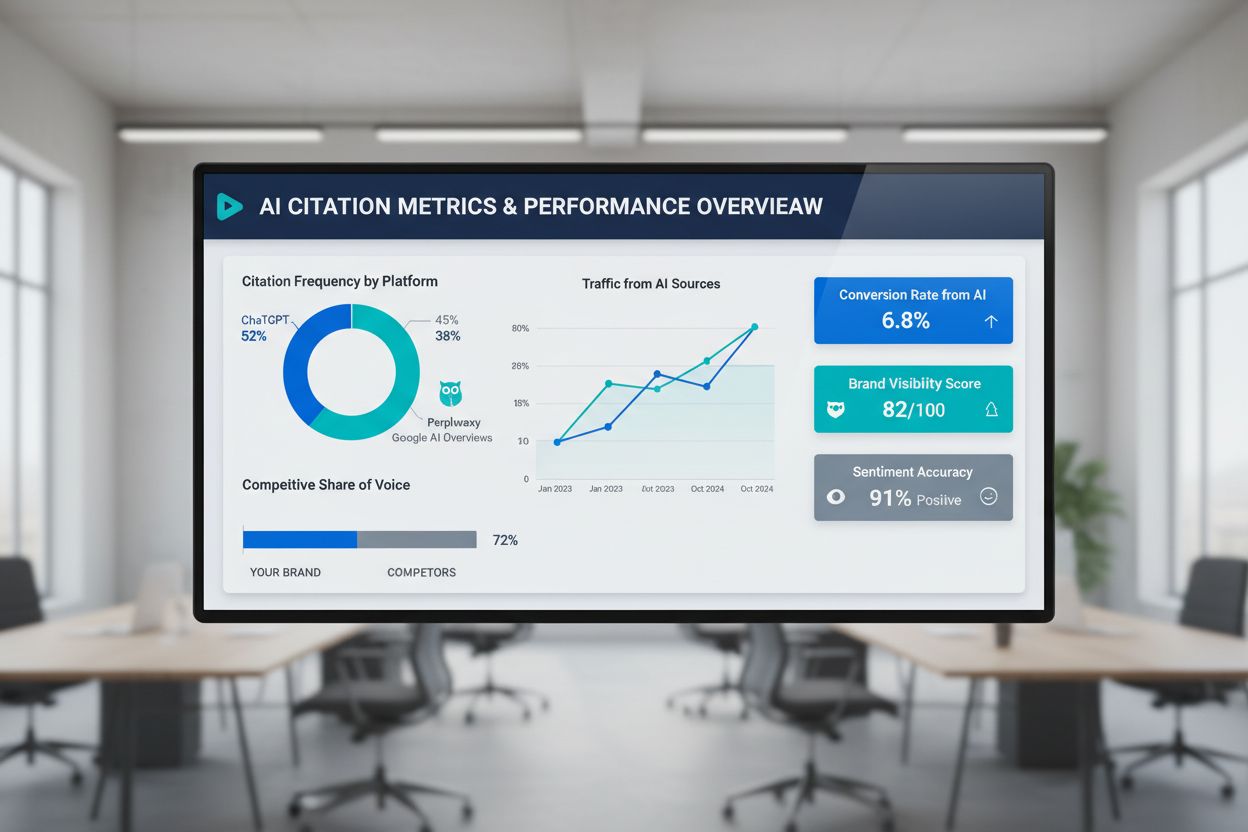

Organisationer kan använda AI-övervakningsplattformar som AmICited för att spåra hur deras varumärken inom hälso- och sjukvård, efterlevnadsinformation och regulatorisk vägledning refereras i AI-system som ChatGPT, Perplexity och Google AI Overviews. Detta ger insyn i hur efterlevnadsstandarder för hälso- och sjukvård integreras i bredare AI-ekosystem och hjälper till att identifiera potentiell felaktig framställning av medicinsk information.

Spåra hur ditt varumärke inom hälso- och sjukvård och efterlevnadsinformation refereras i AI-system som ChatGPT, Perplexity och Google AI Overviews med AmICited.

Lär dig hur du bygger trovärdigt hälsoinnehåll med hjälp av E-E-A-T-principerna. Upptäck strategier för att etablera medicinsk auktoritet, expertis och förtroen...

Lär dig vad eftersläpande AI-indikatorer är, hur de skiljer sig från ledande indikatorer och varför spårning av faktiska citeringar, AI-trafik och konverteringa...

Lär dig hur du optimerar Your Money or Your Life (YMYL)-innehåll för AI-sökmotorer som ChatGPT, Perplexity och Googles AI Overviews. Bemästra E-E-A-T-signaler, ...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.