Skapa LLM-meta-svar: Självständiga insikter som AI kan citera

Lär dig hur du skapar LLM-meta-svar som AI-system citerar. Upptäck strukturella tekniker, strategier för svarstäthet och citeringsklara innehållsformat som ökar...

Innehåll som direkt adresserar hur språkmodeller kan tolka och besvara relaterade frågor, utformat för att förbättra synligheten i AI-genererade svar över plattformar som ChatGPT, Google AI Overviews och Perplexity. LLM Meta Svar representerar syntetiserade svar som kombinerar information från flera källor till sammanhängande, konversationsmässiga svar som möter användarens avsikt.

Innehåll som direkt adresserar hur språkmodeller kan tolka och besvara relaterade frågor, utformat för att förbättra synligheten i AI-genererade svar över plattformar som ChatGPT, Google AI Overviews och Perplexity. LLM Meta Svar representerar syntetiserade svar som kombinerar information från flera källor till sammanhängande, konversationsmässiga svar som möter användarens avsikt.

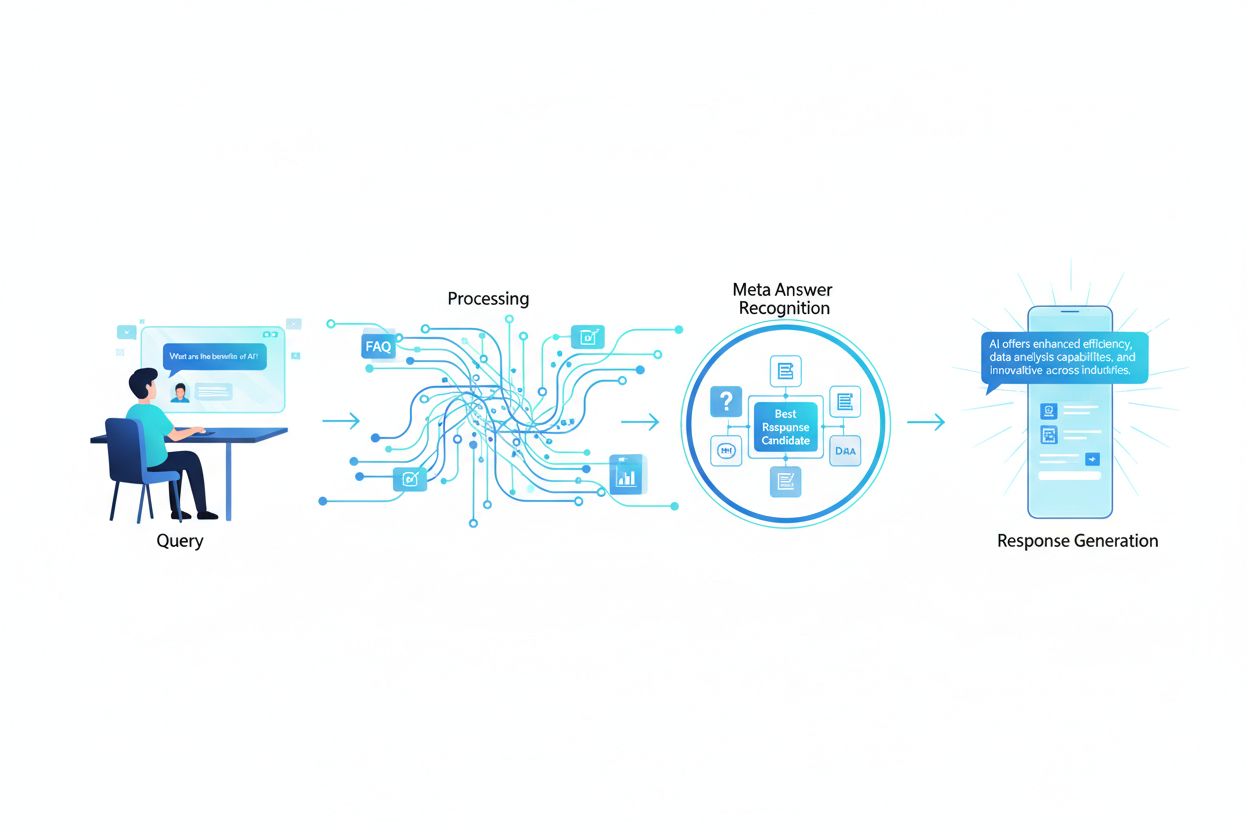

LLM Meta Svar representerar de syntetiserade, AI-genererade svar som stora språkmodeller producerar när användare frågar via plattformar som ChatGPT, Claude eller Googles AI Overviews. Dessa svar skiljer sig grundläggande från traditionella sökresultat eftersom de kombinerar information från flera källor till ett sammanhängande, konversationsmässigt svar som direkt möter användarens avsikt. Istället för att presentera en lista med länkar analyserar LLM:er hämtat innehåll och genererar egen text som inkorporerar fakta, perspektiv och insikter från deras träningsdata och retrieval-augmented generation (RAG)-system. Att förstå hur LLM:er konstruerar dessa meta-svar är avgörande för innehållsskapare som vill att deras arbete ska citeras och refereras i AI-genererade svar. Synligheten för ditt innehåll i dessa AI-svar har blivit lika viktigt som att ranka i traditionella sökresultat, vilket gör LLM-optimering (LLMO) till en kritisk komponent i modern innehållsstrategi.

När en användare skickar en fråga till en LLM matchar systemet inte bara nyckelord som traditionella sökmotorer gör. Istället utför LLM:er semantisk analys för att förstå den underliggande avsikten, kontexten och nyanserna i frågan. Modellen bryter ner frågan i konceptuella komponenter, identifierar relaterade ämnen och entiteter samt avgör vilken typ av svar som vore mest hjälpsamt—om det är en definition, jämförelse, steg-för-steg-guide eller en analytisk synvinkel. LLM:er hämtar sedan relevant innehåll från sin kunskapsbas med hjälp av RAG-system som prioriterar källor baserat på relevans, auktoritet och omfattning. Hämtningen tar inte bara hänsyn till exakta nyckelordsöverensstämmelser utan även semantisk likhet, ämnesrelationer och hur väl innehållet adresserar specifika aspekter av frågan. Det betyder att ditt innehåll måste vara upptäckbart inte bara för exakta nyckelord, utan för de semantiska begreppen och relaterade ämnen som användare faktiskt frågar om.

| Faktor för frågetolkning | Traditionell sökning | LLM Meta Svar |

|---|---|---|

| Matchningsmetod | Nyckelords-matchning | Semantisk förståelse |

| Resultatformat | Länkslista | Syntetiserad berättelse |

| Källval | Relevansrankning | Relevans + omfattning + auktoritet |

| Kontexthänsyn | Begränsad | Omfattande semantisk kontext |

| Sammansättning av svar | Användaren måste läsa flera källor | AI kombinerar flera källor |

| Citeringskrav | Valfritt | Ofta inkluderat |

För att ditt innehåll ska väljas ut och citeras i LLM meta-svar måste det ha flera avgörande egenskaper som överensstämmer med hur dessa system utvärderar och syntetiserar information. För det första måste ditt innehåll visa tydlig expertis och auktoritet inom ämnet, med starka E-E-A-T-signaler (Experience, Expertise, Authoritativeness, Trustworthiness) som hjälper LLM:er att identifiera pålitliga källor. För det andra bör innehållet ge verkligt informationsvärde—unika insikter, data eller perspektiv som tillför något utöver det som vanligtvis finns. För det tredje måste ditt innehåll vara strukturerat så att LLM:er enkelt kan tolka och extrahera relevant information, med tydlig hierarki och logisk uppbyggnad. Fjärde, semantisk rikedom är väsentlig; ditt innehåll bör utforska relaterade koncept grundligt, använda varierad terminologi och bygga omfattande ämnesauktoritet istället för att enbart fokusera på enskilda nyckelord. Femte, aktualitet är mycket viktigt för aktuella ämnen, eftersom LLM:er prioriterar ny, uppdaterad information när de syntetiserar svar. Slutligen bör ditt innehåll inkludera stödjande bevis genom källhänvisningar, data och externa referenser som bygger förtroende hos LLM-systemen.

Viktiga egenskaper som förbättrar LLM-citering:

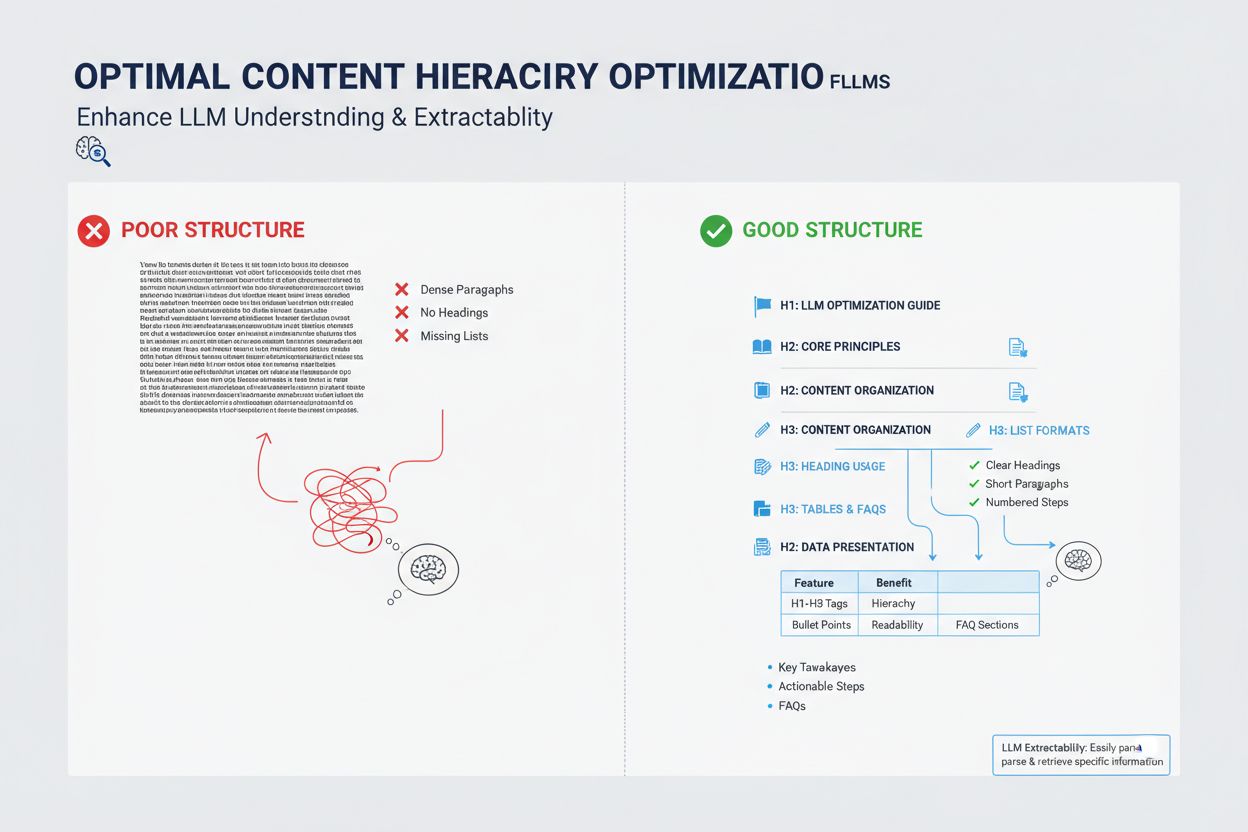

Hur du strukturerar ditt innehåll har stor inverkan på om LLM:er väljer det för meta-svar, eftersom dessa system är optimerade för att extrahera och syntetisera välorganiserad information. LLM:er föredrar starkt innehåll med tydliga rubrikhierarkier (H1, H2, H3) som skapar logisk informationsarkitektur, vilket gör att modellen kan förstå relationen mellan koncept och effektivt extrahera relevanta sektioner. Punktlistor och numrerade listor är särskilt värdefulla eftersom de presenterar information i lättlästa, avgränsade enheter som LLM:er enkelt kan använda i sina syntetiserade svar. Tabeller är särskilt kraftfulla för LLM-synlighet eftersom de presenterar strukturerad data i ett format som är lätt för AI-system att tolka och referera till. Korta stycken (3–5 meningar) fungerar bättre än täta textblock, då de gör det lättare för LLM:er att identifiera och extrahera specifik information utan att behöva sålla bland irrelevant innehåll. Dessutom ger schema markup (FAQ, Artikel, HowTo) tydliga signaler till LLM:er om ditt innehålls struktur och syfte, vilket markant ökar sannolikheten för citering.

Även om LLM meta-svar och utvalda utdrag kan verka lika på ytan, representerar de i grunden olika mekanismer för innehållssynlighet och kräver distinka optimeringsstrategier. Utvalda utdrag väljs ut av traditionella sökalgoritmer från befintligt webbinnehåll och visas på en specifik position på sökresultatsidan, vanligtvis med 40–60 ord av extraherad text. LLM meta-svar, däremot, är AI-genererade svar som syntetiserar information från flera källor till en ny, originell berättelse som kan vara längre och mer omfattande än någon enskild källa. Utvalda utdrag belönar innehåll som direkt besvarar en specifik fråga i ett koncist format, medan LLM meta-svar belönar omfattande, auktoritativt innehåll som ger djup ämnesbevakning. Citeringsmekanismerna skiljer sig avsevärt: utvalda utdrag visar en källänk men innehållet i sig extraheras ordagrant, medan LLM meta-svar kan parafrasera eller syntetisera ditt innehåll och vanligtvis inkluderar attribution. Dessutom är utvalda utdrag huvudsakligen optimerade för traditionell sökning, medan LLM meta-svar är optimerade för AI-plattformar och kanske inte syns i sökresultat alls.

| Aspekt | Utvalda utdrag | LLM Meta Svar |

|---|---|---|

| Genereringsmetod | Algoritm extraherar befintlig text | AI syntetiserar från flera källor |

| Visningsformat | Plats på sökresultatsida | AI-plattformssvar |

| Innehållslängd | Vanligtvis 40–60 ord | 200–500+ ord |

| Citeringsstil | Källänk med extraherad text | Attribution med parafraserat innehåll |

| Optimeringsfokus | Koncisa direkta svar | Omfattande auktoritet |

| Plattform | Google Sök | ChatGPT, Claude, Google AI Overviews |

| Synlighetsmått | Sökvisningar | AI-svarsciteringar |

Semantisk rikedom—djup och bredd i konceptuell täckning i ditt innehåll—är en av de viktigaste men ofta förbisedda faktorerna i LLM-optimering. LLM:er letar inte bara efter ditt målnyckelord; de analyserar de semantiska relationerna mellan koncept, den kontextuella informationen kring ditt huvudämne och hur grundligt du utforskar relaterade idéer. Innehåll med hög semantisk rikedom använder varierad terminologi, undersöker flera vinklar av ett ämne och bygger kopplingar mellan relaterade begrepp, vilket hjälper LLM:er att förstå att ditt innehåll är genuint auktoritativt snarare än ytligt nyckelordsoptimerat. När du skriver om ett ämne, inkludera relaterade termer, synonymer och konceptuellt närliggande idéer som hjälper LLM:er placera ditt innehåll i ett bredare kunskapsnätverk. Till exempel bör en artikel om “content marketing” naturligt inkludera diskussioner om målgruppssegmentering, köparpersonas, innehållsdistribution, analys och ROI—inte för att du fyller med nyckelord, utan för att dessa koncept är semantiskt relaterade och nödvändiga för att förstå ämnet på djupet. Detta semantiska djup signalerar till LLM:er att du har genuin expertis och kan ge de nyanserade, mångfacetterade svar som användare söker.

LLM:er utvärderar auktoritet annorlunda än traditionella sökmotorer och lägger större vikt vid signaler som indikerar verklig expertis och trovärdighet snarare än bara länkpopularitet. Författaruppgifter och påvisad erfarenhet är särskilt viktiga; LLM:er föredrar innehåll från erkända experter, praktiker eller organisationer med etablerad auktoritet inom sitt område. Externa källhänvisningar och referenser till andra auktoritativa källor bygger förtroende hos LLM-systemen, eftersom de visar att ditt innehåll bygger på bredare kunskap och bekräftas av andra experter. Konsistens över flera innehållsdelar inom ett ämne hjälper till att etablera ämnesauktoritet; LLM:er känner igen när en författare eller organisation har publicerat flera omfattande delar om relaterade ämnen. Tredjepartsvalidering genom omnämnanden, citat eller referenser från andra auktoritativa källor ökar din synlighet i LLM meta-svar markant. Egen forskning, egen data eller unika metoder ger starka auktoritetssignaler eftersom de representerar information som inte finns någon annanstans. Dessutom visar en uppdaterad publiceringshistorik och regelbunden uppdatering av innehåll att du är aktivt engagerad i ämnet och håller dig uppdaterad.

Auktoritetssignaler som påverkar LLM-val:

Innehållets aktualitet har blivit allt viktigare för LLM-synlighet, särskilt för ämnen där information snabbt förändras eller där nya utvecklingar kraftigt påverkar svaret. LLM:er tränas på data med kunskapsgränser, men de förlitar sig alltmer på RAG-system som hämtar aktuell information från webben, vilket innebär att både publiceringsdatum och uppdateringsfrekvens direkt påverkar om ditt innehåll väljs för meta-svar. För ständigt aktuella ämnen signalerar regelbundna uppdateringar—även mindre ändringar som uppdaterar publiceringsdatumet—till LLM:er att ditt innehåll är aktivt underhållet och tillförlitligt. För tidskänsliga ämnen som branschtrender, teknikuppdateringar eller aktuella händelser prioriteras föråldrat innehåll aktivt ner av LLM-system till förmån för nyare källor. Bästa praxis är att upprätta ett underhållsschema där du granskar och uppdaterar viktiga delar kvartalsvis eller halvårsvis, förnyar statistik, lägger till nya exempel och införlivar senaste utvecklingen. Detta löpande underhåll förbättrar inte bara din LLM-synlighet utan visar också för både AI-system och mänskliga läsare att du är en aktuell, pålitlig informationskälla.

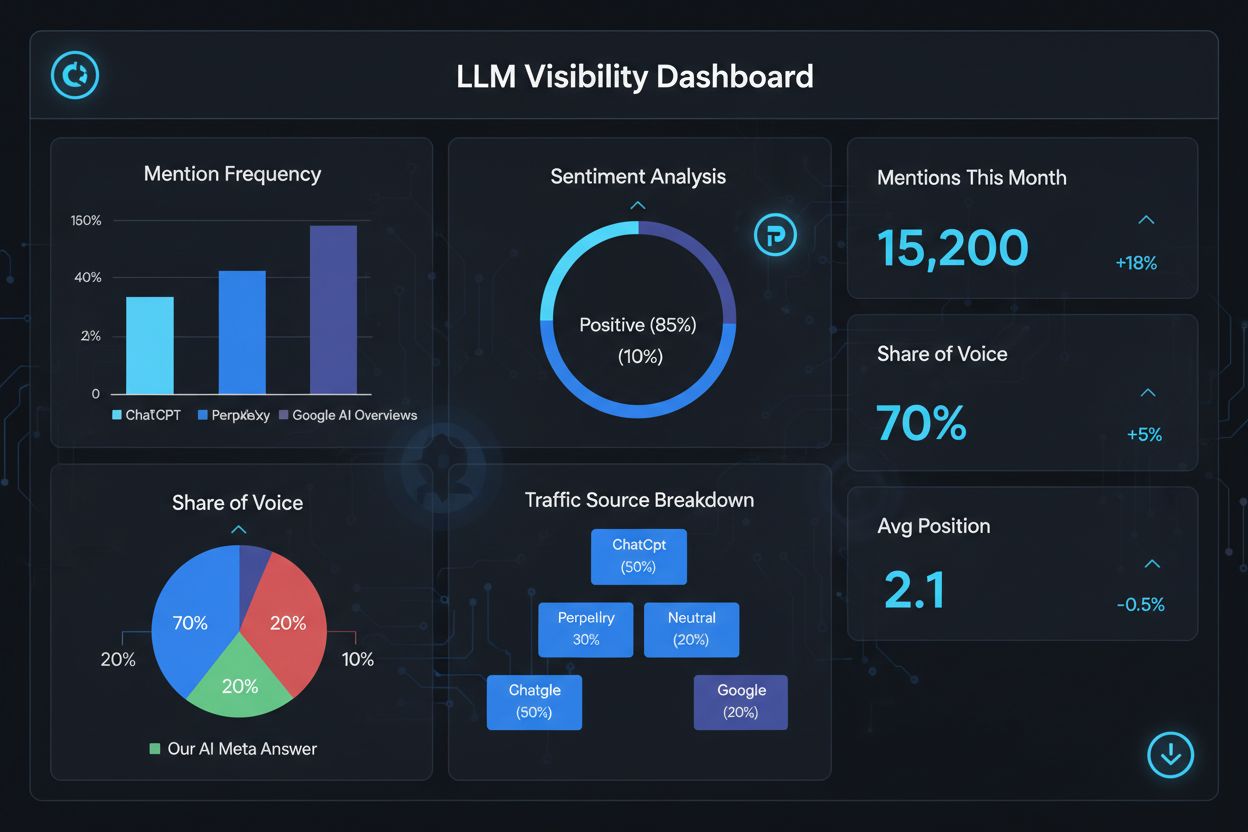

Att mäta din framgång med LLM meta-svar kräver andra mått och verktyg än traditionell SEO, eftersom dessa svar existerar utanför det traditionella sökresultatsystemet. Verktyg som AmICited.com erbjuder specialiserad övervakning som spårar när och var ditt innehåll syns i AI-genererade svar, vilket ger dig insikt i vilka delar som citeras och hur ofta. Du bör övervaka flera nyckelvärden: citeringsfrekvens (hur ofta ditt innehåll syns i LLM-svar), citeringskontext (vilka ämnen som triggar din inkludering), källdiversitet (om du citeras över olika LLM-plattformar) och svarens positionering (om ditt innehåll är framträdande i det syntetiserade svaret). Spåra vilka specifika sidor eller sektioner som oftast citeras, eftersom detta visar vilken typ av information LLM:er värderar högst. Övervaka förändringar i citeringsmönster över tid för att identifiera vilka optimeringsinsatser som fungerar och vilka ämnen som behöver vidareutvecklas. Analysera också de frågor som triggar dina citeringar för att förstå hur LLM:er tolkar användaravsikt och vilka semantiska variationer som är mest effektiva.

Viktiga mått för LLM meta-svar-prestanda:

Att optimera för LLM meta-svar kräver ett strategiskt tillvägagångssätt som kombinerar teknisk implementation, innehållskvalitet och kontinuerlig mätning. Börja med att genomföra omfattande ämnesforskning för att identifiera luckor där din expertis kan erbjuda unikt värde som LLM:er prioriterar framför generiska källor. Strukturera ditt innehåll med tydliga hierarkier, använd H2- och H3-rubriker för att skapa en logisk informationsarkitektur som LLM:er enkelt kan tolka och extrahera från. Implementera schema markup (FAQ, Artikel, HowTo) för att tydligt signalera innehållets struktur och syfte till LLM-system, vilket avsevärt förbättrar upptäckbarheten. Utveckla omfattande, auktoritativt innehåll som utforskar ditt ämne från flera vinklar, inkorporerar relaterade koncept och bygger semantisk rikedom som visar genuin expertis. Inkludera egen forskning, data eller insikter som ger informationsvärde och särskiljer ditt innehåll från konkurrenter. Underhåll ett regelbundet uppdateringsschema och förnya viktiga delar kvartalsvis för att säkerställa aktualitet och signalera pågående auktoritet. Bygg ämnesauktoritet genom att skapa flera relaterade delar som tillsammans etablerar din expertis inom ett ämnesområde. Använd tydligt, direkt språk som besvarar specifika frågor användare ställer, vilket gör det lätt för LLM:er att extrahera och syntetisera ditt innehåll. Slutligen, övervaka din LLM-citeringsprestanda med specialiserade verktyg för att identifiera vad som fungerar och kontinuerligt förfina din strategi baserat på datadrivna insikter.

LLM Meta Svar fokuserar på hur språkmodeller tolkar och citerar innehåll, medan traditionell SEO fokuserar på placering i sökresultat. LLM:er prioriterar relevans och tydlighet framför domänauktoritet, vilket gör välstrukturerat, svarsförst-innehåll viktigare än bakåtlänkar. Ditt innehåll kan bli citerat i LLM-svar även om det inte rankas i Googles toppresultat.

Strukturera innehåll med tydliga rubriker, ge direkta svar direkt, använd schema markup (FAQ, Artikel), inkludera källhänvisningar och statistik, upprätthåll ämnesauktoritet och se till att din webbplats är genomsökningsbar för AI-botar. Fokusera på semantisk rikedom, informationsvärde och omfattande ämnesbevakning snarare än snäv nyckelordsinriktning.

LLM:er extraherar utdrag från välorganiserat innehåll enklare. Tydliga rubriker, listor, tabeller och korta stycken hjälper modeller att identifiera och citera relevant information. Studier visar att sidor citerade av LLM:er har betydligt fler strukturerade element än genomsnittliga webbsidor, vilket gör struktur till en avgörande rankningsfaktor.

Ja. Till skillnad från traditionell SEO prioriterar LLM:er frågerelevans och innehållskvalitet framför domänauktoritet. En välstrukturerad, mycket relevant nischsida kan bli citerad av LLM:er även om den inte rankas i Googles toppresultat, vilket gör expertis och tydlighet viktigare än webbplatsauktoritet.

Uppdatera innehåll regelbundet, särskilt för tidskänsliga ämnen. Lägg till tidsangivelser som visar när innehållet senast uppdaterades. För ständigt aktuella ämnen rekommenderas kvartalsvisa genomgångar. Färskt innehåll signalerar noggrannhet till LLM:er, ökar sannolikheten för citering och visar pågående auktoritet.

AmICited.com är specialiserat på att övervaka AI-omnämnanden över ChatGPT, Perplexity och Google AI Overviews. Andra verktyg inkluderar Semrushs AI SEO Toolkit, Ahrefs Brand Radar och Peec AI. Dessa verktyg spårar omnämnandefrekvens, andel röst, sentiment och hjälper dig mäta optimeringsframgång.

Schema markup (FAQ, Artikel, HowTo) ger maskinläsbar struktur som hjälper LLM:er att förstå och extrahera innehåll mer exakt. Det signalerar innehållstyp och avsikt, vilket gör din sida mer sannolik att väljas för relevanta frågor och förbättrar den övergripande upptäckbarheten.

Externa omnämnanden på auktoritativa webbplatser (nyheter, Wikipedia, branschpublikationer) bygger trovärdighet och ökar chanserna att LLM:er citerar ditt innehåll. Flera oberoende källor som nämner ditt varumärke eller din data skapar ett mönster av auktoritet som LLM:er känner igen och belönar med högre citeringsfrekvens.

Spåra hur ditt varumärke syns i AI-genererade svar över ChatGPT, Perplexity och Google AI Overviews med AmICiteds specialiserade övervakningsplattform.

Lär dig hur du skapar LLM-meta-svar som AI-system citerar. Upptäck strukturella tekniker, strategier för svarstäthet och citeringsklara innehållsformat som ökar...

Lär dig identifiera och rikta in dig på LLM-källsidor för strategiska bakåtlänkar. Upptäck vilka AI-plattformar som citerar källor mest och optimera din länkstr...

Kritisk analys av LLMs.txt effektivitet. Upptäck om denna AI-innehållsstandard är oumbärlig för din webbplats eller bara hype. Riktig data om användning, plattf...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.