Spamdetektering

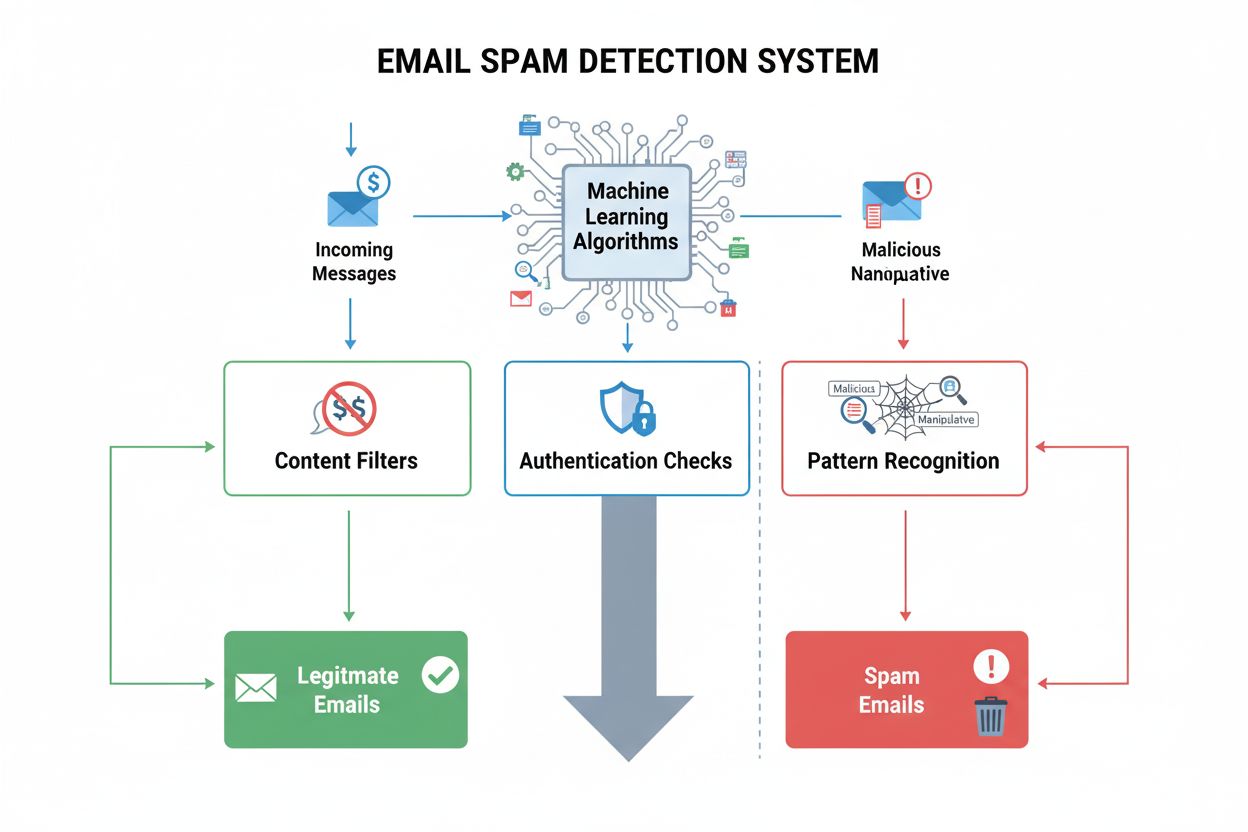

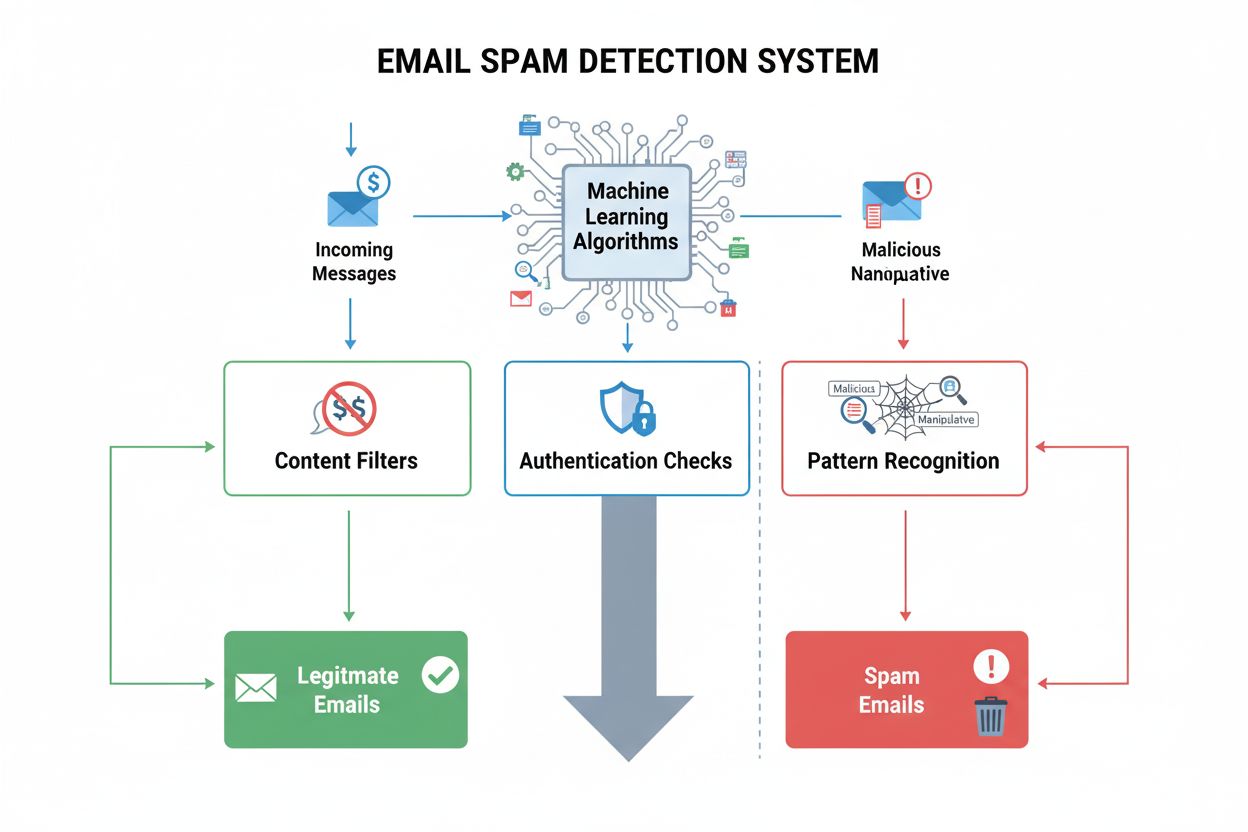

Spamdetektering identifierar oönskat, manipulerande innehåll med ML-algoritmer och beteendeanalys. Lär dig hur AI-system filtrerar spam i e-post, sociala medier...

Sökmotorspam avser avsiktliga manipulationstaktiker som används för att artificiellt påverka sökmotorrankningar genom vilseledande tekniker som bryter mot sökmotorns riktlinjer. Dessa metoder inkluderar bland annat keyword stuffing, cloaking, länknätverk och dold text, utformade för att lura algoritmer snarare än att ge verkligt värde till användare.

Sökmotorspam avser avsiktliga manipulationstaktiker som används för att artificiellt påverka sökmotorrankningar genom vilseledande tekniker som bryter mot sökmotorns riktlinjer. Dessa metoder inkluderar bland annat keyword stuffing, cloaking, länknätverk och dold text, utformade för att lura algoritmer snarare än att ge verkligt värde till användare.

Sökmotorspam, även känt som spamdexing, avser avsiktlig manipulation av sökmotorindex genom vilseledande tekniker utformade för att artificiellt höja en webbplats ranking. Begreppet omfattar en rad oetiska metoder som bryter mot sökmotorns riktlinjer, inklusive keyword stuffing, cloaking, länknätverk, dold text och sneaky redirects. Dessa taktiker prioriterar att lura sökalgoritmer framför att ge verkligt värde till användarna och undergräver därmed sökresultatens integritet. När sökmotorer upptäcker spam på en webbplats införs vanligtvis straff, från sämre placeringar till fullständig borttagning från indexet, vilket gör sidan osynlig för potentiella besökare.

Sökmotorspam har funnits sedan internets barndom då sökalgoritmer var mindre sofistikerade och lättare att manipulera. Under 1990- och tidiga 2000-talet spreds spamdexing-tekniker när webbansvariga upptäckte att de kunde höja rankingen genom enkel nyckelordsupprepning och länkmanipulation. I takt med att sökmotorerna utvecklades, särskilt efter Googles introduktion av PageRank och senare algoritmuppdateringar som Panda (2011) och Penguin (2012), blev upptäckt och bestraffning av spam allt mer avancerad. Framväxten av SpamBrain, Googles AI-baserade spamförebyggande system lanserat 2022, markerade ett stort skifte mot maskininlärningsdriven spamdetektering. Idag använder sökmotorer avancerade algoritmer som analyserar hundratals rankingfaktorer, vilket gör traditionella spamtaktiker i det närmaste verkningslösa – men skapar samtidigt nya möjligheter för sofistikerade manipulationsförsök.

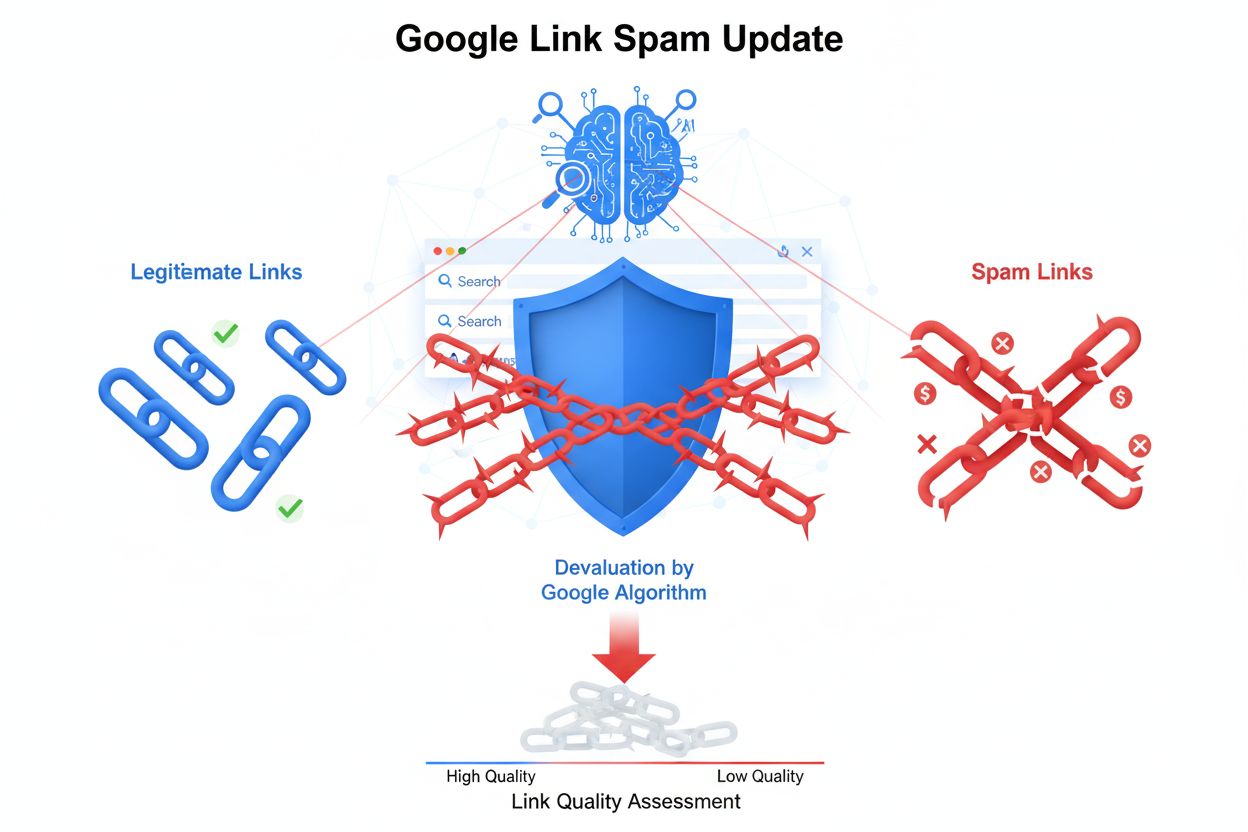

Keyword stuffing är fortfarande en av de mest igenkännbara spamtaktikerna och innebär onaturlig upprepning av nyckelord i sidinnehåll, metataggar och dolda element. Praktiken ökar nyckelordsdensiteten artificiellt utan att ge sammanhängande eller värdefull information till läsaren. Cloaking är en mer avancerad taktik där olika innehåll visas för sökmotorernas crawlers än för användare, ofta med hjälp av JavaScript eller serverteknik för att skilja på bot- och mänskliga besökare. Länknätverk och Private Blog Networks (PBNs) utgör en annan kategori spam, där nätverk av lågkvalitativa webbplatser skapas enbart för att generera artificiella bakåtlänkar till målsidor. Dessa nätverk utnyttjar att sökmotorer historiskt har värderat bakåtlänkar högt som rankingsignal, men moderna algoritmer har blivit skickliga på att identifiera och devalvera sådana konstgjorda länkstrukturer.

Sneaky redirects manipulerar användarbeteende genom att skicka besökare till andra URL:er än vad sökmotorerna ser, ofta till irrelevanta eller skadliga sidor efter att användaren klickat i sökresultaten. Dold text och länkar innebär att man placerar innehåll i samma färg som bakgrunden, använder extremt små typsnitt eller placerar text utanför synligt område – så att det är osynligt för besökaren men synligt för sökmotorernas crawlers. Kommentarspam och forumspam utnyttjar plattformar för användargenererat innehåll genom att automatiskt posta länkar och reklam i bloggar, forum och sociala medier. Innehållsscraping är när innehåll kopieras från andra webbplatser utan tillåtelse eller ändring och publiceras igen för att konstgjort öka sajtens innehåll och fånga söktrafik. Alla dessa taktiker är försök att lura sökalgoritmer snarare än att förtjäna ranking genom legitima metoder.

| Aspekt | Sökmotorspam (Black Hat) | Legitim SEO (White Hat) | Gray Hat SEO |

|---|---|---|---|

| Huvudmål | Manipulera algoritmer via vilseledning | Ge värde till användare och tjäna ranking naturligt | Utnyttja gråzoner i riktlinjer |

| Innehållskvalitet | Låg kvalitet, keyword stuffing eller kopierat | Högkvalitativt, originellt, användarfokuserat innehåll | Blandad kvalitet, vissa tveksamma metoder |

| Länkbygge | Artificiella länkar från nätverk, PBNs eller hackade sajter | Naturliga länkar genom kvalitetsinnehåll | Köpta länkar eller ömsesidiga länksamarbeten |

| Tekniska metoder | Cloaking, dold text, sneaky redirects | Ren HTML, korrekta metataggar, strukturerad data | JavaScript-omdirigeringar, doorway-sidor |

| Användarupplevelse | Dålig; innehåll för algoritmer, ej användare | Utmärkt; innehåll för nöjda användare | Måttlig; viss kompromiss med användarupplevelse |

| Sökmotorsstraff | Manuella åtgärder, borttagning, rankingfall | Inga; kontinuerlig rankingförbättring | Risk för straff om upptäckt |

| Långsiktig hållbarhet | Ohållbart; straff oundvikliga | Hållbart; bygger varaktig auktoritet | Riskabelt; beror på upptäcktsrisk |

| Återhämtningstid | Månader till år; vissa fördelar förlorade | Ej aktuellt; inga straff | Veckor till månader om upptäckt |

SpamBrain innebär ett grundläggande skifte i hur sökmotorer bekämpar spam med hjälp av artificiell intelligens och maskininlärning. Systemet, som lanserades av Google 2022, analyserar mönster på miljarder webbplatser för att identifiera spamegenskaper med oöverträffad precision. Det arbetar oavbrutet och granskar både on-page-faktorer (innehållskvalitet, nyckelordsfördelning, struktur) och off-page-signaler (länkprofiler, domänhistorik, användarbeteende). SpamBrains maskininlärningsmodeller är tränade på stora datamängder med både känd spam och legitima webbplatser, vilket gör att systemet kan känna igen nya spamvarianter innan de blir utbredda. AI-systemet kan identifiera avancerade spamförsök som annars skulle undgå regelbaserade filter, såsom samordnade länkscheman, innehållsmanipulation och utnyttjande av hackade webbplatser. Google har rapporterat att SpamBrain minskat lågkvalitativt och ooriginellt innehåll i sökresultaten med cirka 45 % sedan införandet, vilket visar AI-drivna spamdetekteringens effektivitet.

Spridningen av sökmotorspam försämrar direkt kvaliteten och nyttan av sökresultat för slutanvändaren. När spamrankat innehåll hamnar högt möter användarna irrelevant, lågkvalitativ eller vilseledande information istället för auktoritativa svar på sina frågor. Denna försämring undergräver förtroendet för sökmotorer och tvingar plattformarna att investera mycket i spamdetektering och sanering. Förekomsten av spam skapar även en orättvis konkurrenssituation där legitima företag tillfälligt kan få svårt att konkurrera mot sajter med oetiska metoder. Sökmotorer svarar på spamutbredning med regelbundna spamuppdateringar – förbättringar av deras spamdetekteringssystem som annonseras och spåras separat från kärnalgoritmuppdateringarna. Googles spamuppdatering i december 2024, till exempel, rullades ut globalt på alla språk och tog upp till en vecka att genomföra, vilket visar omfattningen och frekvensen av spambekämpningen. Den ständiga kapprustningen mellan spammare och sökmotorer kräver stora resurser och tekniska insatser som annars kunnat användas till att förbättra sökkvaliteten.

Webbplatser som ertappas med sökmotorspam riskerar allt från algoritmiska straff till manuella åtgärder och total borttagning från indexet. Manuella åtgärder är Googles mest direkta svar på spam – mänskliga granskare identifierar överträdelser och tilldelar specifika straff via Google Search Console. Dessa åtgärder informerar webbplatsägare om överträdelser som onaturliga länkar, keyword stuffing eller cloaking, och resulterar ofta i kraftiga rankingfall eller borttagning ur sökresultaten. Algoritmiska straff sker när Googles automatiska system upptäcker spammönster och minskar en sajts synlighet utan mänsklig inblandning. Dessa straff kan vara temporära, tills spammen åtgärdas och sajten genomsöks igen, eller permanenta vid allvarliga eller upprepade överträdelser. I värsta fall blir sajter helt deindexerade, d.v.s. de syns inte längre alls i Googles sökresultat och förlorar all organisk synlighet. För att återhämta sig från manuella åtgärder krävs omfattande sanering, noggrann dokumentation av åtgärder och en omprövningsbegäran via Google Search Console. Även efter lyckad återhämtning går det dock inte att återfå rankingfördelar som skapats med spamlänkar – dessa är permanent förlorade.

Framväxten av AI-drivna söksystem som ChatGPT, Perplexity, Google AI Overviews och Claude innebär nya dimensioner i spamproblematiken. Dessa system hämtar sitt innehåll från webben för att generera svar och är sårbara för spam och lågkvalitativt material som kan påverka resultaten. Till skillnad från traditionella sökmotorer, som visar rankade listor, sammanfattar AI-system information till naturliga språk och kan därmed förstärka spam om det påverkar träningsdata eller hämtade källor. Organisationer som AmICited har vuxit fram för att möta denna utmaning och erbjuder övervakning av AI-promptar, där man ser var varumärken och domäner förekommer i AI-genererade svar. Denna övervakning är viktig eftersom spam i AI-svar kan skada varumärkets rykte och synlighet på andra sätt än i traditionella sökresultat. I takt med att AI-system blir allt viktigare för informationssökning växer också behovet av att förebygga och hantera spam i dessa nya sökparadigm. Utmaningen för AI-system är att skilja auktoritativa källor från spam när de avgör vad som ska inkluderas i svaren.

Organisationer som vill ha hållbar synlighet i sök bör införa omfattande strategier för att undvika spamtaktiker och följa sökmotorns riktlinjer. Innehållsstrategin ska prioritera original, högkvalitativt och användarfokuserat innehåll som naturligt införlivar relevanta nyckelord utan konstgjord upprepning eller manipulation. Länkbyggande ska ske via naturliga bakåtlänkar tack vare kvalitetsinnehåll, branschrelationer och legitim outreach – inte genom att köpa länkar eller delta i länkscheman. Teknisk SEO bör betona ren HTML, korrekta metataggar, strukturerad data och transparenta omdirigeringar som behandlar sökmotorer och användare likadant. Regelbundna revisioner av innehåll, länkar och tekniska element hjälper till att upptäcka potentiella spamproblem innan de leder till straff. Övervakningsverktyg ska spåra rankingar, länkprofiler och synlighet för att upptäcka ovanliga förändringar som kan tyda på spam eller attacker från konkurrenter. Användarupplevelseoptimering innebär att innehållet i första hand riktas till mänskliga besökare, med SEO som sekundärt fokus. Organisationer bör även införa tydliga interna policys som förbjuder spamtaktiker och utbilda medarbetare i riskerna och konsekvenserna av manipulation.

Framtiden för detektering av sökmotorspam kommer i allt högre grad att förlita sig på avancerad artificiell intelligens och maskininlärning som kan identifiera sofistikerade manipulationer i realtid. SpamBrain och liknande AI-system kommer att fortsätta utvecklas för att snabbare upptäcka nya spamvarianter än vad spammare hinner ta fram dem, vilket skapar en accelererande kapprustning mellan upptäckt och undvikande. Integration av AI-drivna söksystem i vanliga sökupplevelser kommer att kräva nya spamdetekteringsmetoder anpassade till hur dessa system hämtar och syntetiserar information. Sannolikt kommer sökmotorer att införa mer sofistikerad användarbeteendeanalys för att upptäcka spam baserat på hur riktiga användare interagerar med innehållet, snarare än enbart på tekniska signaler. Plattformsövergripande övervakning blir allt viktigare eftersom spamtaktiker utvecklas för att rikta sig mot flera söksystem samtidigt – traditionella sökmotorer, AI-chattbottar och nya sökparadigm. Uppkomsten av generativt AI-innehåll skapar nya spamutmaningar, eftersom automatiserade system kan generera trovärdigt men lågkvalitativt eller vilseledande innehåll i stor skala. Organisationer som AmICited kommer att få en allt viktigare roll för att hjälpa varumärken övervaka sin synlighet i olika söksystem och upptäcka spamhot innan de påverkar synligheten. I slutändan är det mest effektiva spamskyddet en kombination av avancerad algoritmisk detektering, mänsklig expertis, användarfeedback och branschgemensamt arbete för att upprätthålla sökkvalitet och användarnas förtroende.

Sökmotorspam bryter mot sökmotorns riktlinjer och använder vilseledande taktiker för att manipulera rankningar, medan legitim SEO följer white-hat-metoder som ger verkligt värde till användare. Legitim SEO fokuserar på att skapa kvalitativt innehåll, förtjäna naturliga bakåtlänkar och förbättra användarupplevelsen, medan spamtaktiker som keyword stuffing och cloaking försöker lura algoritmer. Googles riktlinjer förbjuder uttryckligen spamtaktiker, och webbplatser som använder dem riskerar manuella straff eller att helt tas bort från sökresultaten.

Google använder **SpamBrain**, ett AI-baserat spamförebyggande system som kontinuerligt övervakar webbplatser för att hitta överträdelser av spampolicys. SpamBrain använder maskininlärningsalgoritmer för att identifiera mönster kopplade till spam, inklusive onaturliga länkmönster, keyword stuffing, cloaking och andra vilseledande tekniker. Systemet analyserar både on-page och off-page-faktorer, användarbeteendesignaler och kvalitetsmått på innehållet för att skilja mellan legitimt innehåll och spam. Google utför även manuella granskningar och tar emot användarrapporter genom Search Console för att identifiera och straffa spammiga webbplatser.

De viktigaste spamtaktikerna för sökmotorer inkluderar **keyword stuffing** (överdriven användning av nyckelord på sidor), **cloaking** (visar olika innehåll för sökmotorer och användare), **sneaky redirects** (omdirigerar användare till andra sidor än vad sökmotorer ser), **länknätverk** (nätverk av lågkvalitativa sajter skapade enbart för länkning), **dold text och länkar** (innehåll osynligt för användare men synligt för crawlers) och **kommentarspam** (automatiserat spam i kommentarer och forum). Varje taktik försöker manipulera sökalgoritmer genom vilseledning istället för att ge verkligt användarvärde.

Google inför flera olika straff för sökmotorspam, från sämre placeringar till total borttagning från indexet. Sajter kan få **manuella åtgärder** via Google Search Console som pekar på specifika överträdelser, eller påverkas av algoritmiska spamuppdateringar som automatiskt minskar synligheten. I allvarliga fall kan webbplatser tas bort helt från Googles index och bli osynliga i sökresultaten. För att återhämta sig krävs att alla spamelement identifieras och tas bort, därefter begärs en omprövning via Search Console. Återhämtningsprocessen kan ta månader, och vissa fördelar i rankingen som uppnåtts via spamlänkar kan inte återfås.

Sökmotorspam innebär stora utmaningar för AI-drivna söksystem som **ChatGPT**, **Perplexity** och **Google AI Overviews**. Dessa system förlitar sig på webbens innehåll för att generera svar, och spam kan förorena deras träningsdata eller påverka deras resultat. Plattformar som AmICited övervakar var varumärken och domäner dyker upp i AI-svar, och hjälper organisationer att se om spam eller lågkvalitativt innehåll påverkar synligheten. I takt med att AI-system blir vanligare blir spamdetektering allt viktigare för att dessa plattformar ska kunna ge korrekt och pålitlig information till användare.

Ja, webbplatser kan återhämta sig från spamstraff, men processen kräver omfattande åtgärder. Webbplatsägare måste identifiera alla spamelement – inklusive keyword stuffing, onaturliga länkar, cloaking och dolt innehåll – och ta bort dem helt. Efter saneringen bör de skicka en omprövningsbegäran via Google Search Console med detaljerad dokumentation om vilka ändringar som gjorts. Återhämtning tar vanligtvis flera månader då Googles system behöver tid att genomsöka och omvärdera sajten. Fördelar i rankingen som tidigare uppnåtts med spamlänkar kan dock inte återfås, så sajten måste fokusera på att bygga legitim auktoritet genom kvalitetsinnehåll och naturlig länkanskaffning.

Att övervaka sökmotorspam är avgörande eftersom spam kan skada varumärkets rykte och synlighet i sökplattformar. Konkurrenter kan använda spamtaktiker riktade mot ditt varumärke, eller så kan din egen webbplats bli komprometterad och användas för spam. Verktyg som **AmICited** hjälper organisationer att följa sina varumärkesomnämnanden i AI-sök och traditionella sökmotorer, och identifierar om spam eller lågkvalitativt innehåll visas istället för legitim varumärkesinformation. Denna övervakning möjliggör proaktiv upptäckt av spamproblem och hjälper till att upprätthålla varumärkesintegritet i sökresultat och AI-genererade svar.

Börja spåra hur AI-chatbotar nämner ditt varumärke på ChatGPT, Perplexity och andra plattformar. Få handlingsbara insikter för att förbättra din AI-närvaro.

Spamdetektering identifierar oönskat, manipulerande innehåll med ML-algoritmer och beteendeanalys. Lär dig hur AI-system filtrerar spam i e-post, sociala medier...

Lär dig vad keyword stuffing är, varför det är skadligt för SEO, hur Google upptäcker det och bästa praxis för att undvika denna black-hat-taktik som skadar ran...

Lär dig om Googles Link Spam Update som nedvärderar manipulerande bakåtlänkar. Förstå hur SpamBrain upptäcker länkspam, påverkan på SEO och bästa praxis för eti...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.