Konverzní poměry AI návštěvnosti: Proč kvalita převyšuje kvantitu

Zjistěte, proč návštěvnost z AI konvertuje 23x lépe než z organického vyhledávání. Naučte se optimalizovat pro AI platformy a měřit skutečné ROI z AI návštěvník...

Zjistěte, proč je kvalita dat pro AI modely důležitější než jejich množství. Naučte se strategie alokace zdrojů, nákladové důsledky a praktické rámce pro optimalizaci investic do trénovacích dat pro AI.

Zažitá moudrost ve strojovém učení dlouho zněla: „Čím více dat, tím lépe.“ Nové výzkumy však tuto představu zpochybňují a přinášejí přesvědčivé důkazy, že kvalita dat výrazně převyšuje množství při určování výkonu AI modelů. Studie z arxiv z roku 2024 (2411.15821) zkoumající malé jazykové modely ukázala, že kvalita trénovacích dat hraje mnohem větší roli než samotný objem, což odhaluje, že vztah mezi množstvím dat a přesností modelu je mnohem složitější, než se dříve myslelo. Důsledky pro náklady jsou značné: organizace, které masivně investují do sběru dat bez důrazu na kvalitu, často plýtvají prostředky na ukládání, zpracování i výpočetní výkon, přičemž zvyšující se objem už jen minimálně zlepšuje výsledky modelů.

Kvalita dat není jednorozměrný pojem, ale vícerozměrný rámec zahrnující několik klíčových aspektů. Přesnost znamená, jak věrně data odrážejí realitu a zda jsou štítky přiřazeny správně. Konzistence zajišťuje, že data mají jednotný formát a standardy v celém datasetu. Úplnost měří, zda jsou k dispozici všechny potřebné informace bez výrazných mezer či chybějících hodnot. Relevance určuje, zda data přímo odpovídají problému, který má AI model řešit. Spolehlivost označuje důvěryhodnost zdroje dat a jeho stabilitu v čase. Nakonec šum představuje nežádoucí odchylky nebo chyby, které mohou trénink modelu zavádět. Pochopení těchto dimenzí pomáhá organizacím strategicky určovat priority při správě dat.

| Dimenze kvality | Definice | Dopad na AI |

|---|---|---|

| Přesnost | Správnost štítků a reprezentace dat | Přímo ovlivňuje spolehlivost predikcí modelu; špatně označená data způsobují systematické chyby |

| Konzistence | Jednotné formátování a standardizovaná struktura | Umožňuje stabilní trénink; nekonzistence mate trénovací algoritmy |

| Úplnost | Přítomnost všech potřebných informací bez mezer | Chybějící hodnoty snižují efektivní množství dat, dopad na zobecnění modelu |

| Relevance | Data přímo odpovídají doméně problému | Vysoce relevantní data překonají velké objemy obecných dat |

| Spolehlivost | Důvěryhodnost a stabilita zdrojů dat | Nespolehlivé zdroje zavádějí systematickou bias; ovlivňuje robustnost modelu |

| Šum | Nežádoucí odchylky a chyby měření | Řízený šum zvyšuje odolnost; nadměrný šum zhoršuje výkon |

Honba za množstvím dat bez zajištění kvality spouští řetězec problémů, které přesahují pouhé metriky modelového výkonu. Výzkum Rishabha Iyera ukazuje, že pokusy s šumem ve štítcích vedou k dramatickému poklesu přesnosti — špatně označená data aktivně zhoršují výkon modelu, místo aby byla jen neutrálními příklady. Kromě přesnosti čelí organizace rostoucím nákladům na ukládání a zpracování dat, která výsledky modelů nezlepšují, a také výrazným ekologickým dopadům zbytečné výpočetní zátěže. Ještě závažnější je to v medicíně: dataset s tisíci špatně označenými snímky RTG může naučit model sebevědomě dělat nebezpečné diagnostické chyby a ohrozit pacienty. Falešná úspora levných, nekvalitních dat se projeví při započtení nákladů na přeškolování modelů, ladění a selhání při nasazení způsobených špatnými trénovacími daty.

Doménová kvalita systematicky překonává obecné objemy v praktických aplikacích AI. Představte si sentimentální klasifikátor trénovaný na filmových recenzích: pečlivě vybraný dataset 10 000 filmových recenzí výrazně překoná obecný sentimentální dataset se 100 000 příklady ze světa financí, sociálních sítí a produktových recenzí. Relevance trénovacích dat ke konkrétnímu problému je mnohem důležitější než samotný objem, protože modely se učí vzory specifické pro distribuční charakteristiky dat. Pokud data nejsou relevantní k cílové aplikaci, model se učí falešné korelace a nedokáže zobecnit na reálné případy. Organizace by měly upřednostnit menší, přesně zacílené datasety před hromaděním obrovských obecných datasetů, které vyžadují náročné filtrování a předzpracování.

Optimální strategie práce s daty neleží v žádném extrému, ale ve vyhledání „zlaté střední cesty“ — ideálního bodu, kde je množství a kvalita dat vyvážena s ohledem na konkrétní problém. Příliš málo dat, byť perfektně označených, vede k podtrénování modelu a neschopnosti zachytit složitost reálných vzorů. Naopak přebytek dat se slabou kvalitou přináší výpočetní plýtvání a nestabilitu tréninku. Studie z arxiv to dokládá konkrétně: minimální duplikace zvýšila přesnost o 0,87 % při 25% úrovni duplikace, zatímco nadměrná duplikace (100 %) způsobila katastrofální pokles přesnosti o 40 %. Ideální rovnováha závisí na řadě faktorů — typu algoritmu, složitosti problému, dostupných výpočetních zdrojích i přirozené variabilitě ve vašem cílovém oboru. Distribuce dat by měla odrážet reálnou variabilitu, nikoli být uměle jednotná — tak modely zvládnou rozmanitost, kterou potkají v produkci.

Ne všechna přidaná data jsou přínosná — klíčový rozdíl mezi užitečnou augmentací a škodlivou degradací je zásadní pro efektivní strategii. Řízené úpravy a augmentační techniky zvyšují odolnost modelu tím, že algoritmům umožní naučit se zvládat reálné variace — např. mírné otočení, změny osvětlení nebo drobné odchylky ve štítkování. Skvělou ukázkou je dataset MNIST s ručně psanými číslicemi: modely trénované na augmentovaných datech (otáčené, škálované nebo mírně deformované číslice) lépe zobecní na skutečný rukopis než modely trénované pouze na původních obrázcích. Naopak silná korupce — náhodný šum, systematické špatné označení nebo vnášení nerelevantních dat — výkon degraduje a plýtvá výpočetními prostředky. Rozdíl je v úmyslu: augmentace je cíleně navržená, aby odrážela realistické variace, zatímco balast je bezcílný šum, který algoritmy mate. Organizace musí tyto přístupy rozlišovat při rozšiřování datasetů.

Pro organizace s omezenými zdroji je aktivní učení silným řešením, které snižuje nároky na data a zároveň udržuje nebo zvyšuje výkon modelu. Místo pasivního sběru a označování všech dat algoritmy aktivního učení vyberou ty neoznačené příklady, které jsou pro model nejpřínosnější, čímž dramaticky snižují zátěž lidské anotace. Díky tomu lze dosáhnout vysokého výkonu s výrazně menším množstvím označených dat, protože lidské úsilí cílí na nejdůležitější příklady. Aktivní učení demokratizuje vývoj AI tím, že umožňuje i týmům bez obřích rozpočtů na anotaci stavět efektivní modely pomocí strategického výběru dat místo prostého objemu. Efektivnějším učením s menším množstvím dat organizace rychleji iterují, snižují náklady a mohou více investovat do zajištění kvality než do nekonečného sběru dat.

Strategická alokace zdrojů vyžaduje dávat kvalitu přednost před množstvím při rozhodování o datech. Organizace by měly investovat do robustních validačních pipeline, které odhalí chyby dříve, než se data dostanou do trénovacích datasetů, a implementovat automatické kontroly konzistence, úplnosti i přesnosti. Nástroje pro profilaci dat dokáží ve velkém odhalit problémy s kvalitou — chyby ve štítkování, chybějící hodnoty nebo nerelevantní příklady, které je třeba řešit ještě před tréninkem. Aktivní učení snižuje objem dat, která musí projít lidskou kontrolou, a zajišťuje, že kontrolované příklady jsou maximálně přínosné. Průběžné sledování výkonu modelu v produkci ukáže, zda problémy s kvalitou trénovacích dat způsobují reálná selhání, a umožní rychlé uzavření zpětné vazby pro zlepšování. Optimální strategie kombinuje sběr dat s pečlivou správou, přičemž 1 000 perfektně označených příkladů často překoná 100 000 šumových, a to jak výkonem modelu, tak celkovými náklady.

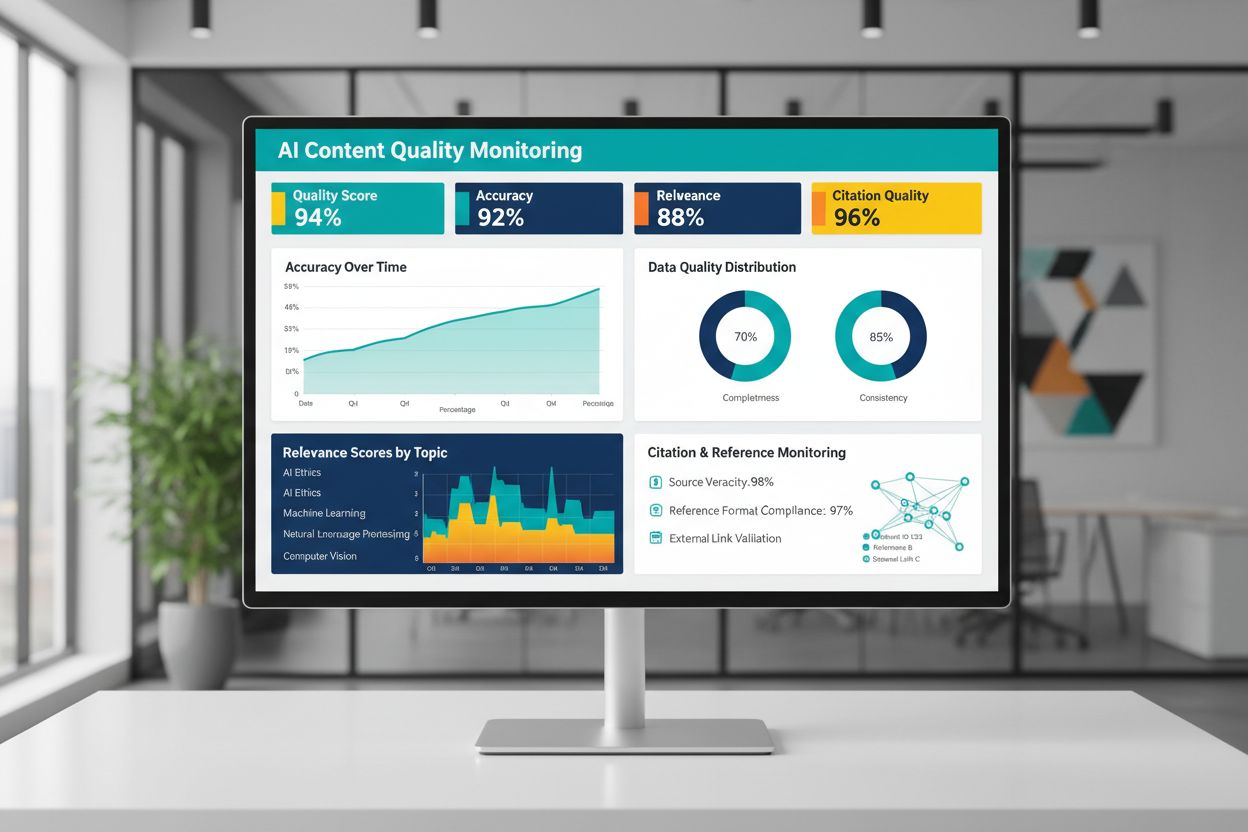

Kvalita AI-generovaného nebo AI-trénovaného obsahu závisí zásadně na kvalitě trénovacích dat, proto je průběžné monitorování výstupů AI klíčové pro udržení spolehlivosti. Platformy jako AmICited.com tuto potřebu řeší tím, že monitorují AI odpovědi a sledují přesnost citací — což je přímý ukazatel kvality a důvěryhodnosti obsahu. Pokud jsou AI systémy trénovány na nekvalitních datech s chybnými citacemi nebo nepřesnými informacemi, jejich výstupy tyto chyby přebírají a mohou šířit dezinformace ve velkém. Nástroje pro monitoring by měly sledovat nejen metriky přesnosti, ale také relevantnost, konzistenci a přítomnost důkazů pro tvrzení AI. Organizace zavádějící AI musí vytvořit zpětné vazby, které odhalí, kdy výstupy nesplňují očekávané standardy kvality, a umožnit rychlé přeškolení nebo úpravu dat. Investice do monitorovací infrastruktury se vyplatí tím, že zachytí pokles kvality včas, dříve než ovlivní uživatele nebo poškodí důvěryhodnost organizace.

Převést zásady kvality dat do praxe vyžaduje strukturovaný přístup začínající posouzením a pokračující měřením a iterací. Začněte zhodnocením současného stavu — získejte přehled o kvalitě trénovacích dat pomocí auditů a profilace. Definujte jasné metriky kvality v souladu s vaším konkrétním použitím, ať už jde o prahové hodnoty přesnosti, standardy konzistence či kritéria relevance. Zaveďte procesy správy dat, které stanoví odpovědnosti, validační postupy a kontrolní brány před vstupem dat do trénovacích pipeline. Začněte s menšími, pečlivě vybranými datasety místo okamžitého zpracování obřích objemů — umožní to nastavit standardy a procesy v přehledném měřítku. Zlepšení měřte důsledně srovnáním výkonu modelu před a po kvalitativních zásazích, což slouží jako důkaz pro další investice. Škálujte postupně, jak budete ladit procesy, a rozšiřujte sběr dat až po prokázání, že zlepšení kvality přináší skutečné výkonnostní přínosy.

Ne. Nedávný výzkum ukazuje, že kvalita dat je často důležitější než jejich množství. Nekvalitní, špatně označená nebo nerelevantní data mohou výkon modelu dokonce zhoršit, a to i ve velkém měřítku. Klíčem je najít správnou rovnováhu mezi dostatečným množstvím pro efektivní trénink a zachováním vysokých standardů kvality.

Kvalita dat zahrnuje několik dimenzí: přesnost (správné označení), konzistenci (jednotné formátování), úplnost (žádné chybějící hodnoty), relevantnost (souhlasí s vaším problémem), spolehlivost (důvěryhodné zdroje) a úroveň šumu. Definujte metriky specifické pro vaše použití a nastavte validační brány, které odhalí problémy s kvalitou ještě před začátkem tréninku.

Ideální velikost závisí na složitosti algoritmu, typu problému a dostupných zdrojích. Místo honby za maximální velikostí směřujte do 'zlaté střední cesty' — tolik dat, abyste zachytili reálné vzory, ale nebyli zahlceni nerelevantními nebo redundantními příklady. Začněte s menším, pečlivě vybraným datasetem a navyšujte podle zlepšení výkonu.

Augmentace dat znamená řízené úpravy (rotace, drobné zkreslení, změny osvětlení), které zachovávají správné označení a zároveň učí modely zvládat reálnou variabilitu. Na rozdíl od balastu je augmentace úmyslná a odráží realistické odchylky, díky čemuž jsou modely odolnější v provozu.

Aktivní učení identifikuje, které neoznačené příklady jsou pro model nejpřínosnější, a výrazně snižuje nutnost anotace. Místo označování všech dostupných dat zaměříte lidské úsilí na nejdůležitější příklady a dosáhnete vysokého výkonu s výrazně menším množstvím označených dat.

Dejte přednost kvalitě před kvantitou. Investujte do validačních pipeline, nástrojů pro profilaci a procesů správy, které zajišťují kvalitní trénovací data. Výzkumy ukazují, že 1 000 perfektně označených příkladů často překoná 100 000 šumových, a to jak v modelovém výkonu, tak v celkových nákladech.

Nekvalitní data vedou k mnoha nákladům: opětovný trénink modelu, ladění chyb, selhání v nasazení, náklady na úložiště i výpočetní plýtvání. V kritických oblastech jako je medicína může špatná kvalita dat vést k vážným chybám. Falešná úspora levných dat se projeví, když zahrnete tyto skryté náklady.

Zaveďte průběžné sledování AI výstupů — sledujte přesnost, relevantnost, konzistenci a kvalitu citací. Platformy jako AmICited monitorují, jak AI systémy odkazují na informace a sledují přesnost citací. Vytvořte zpětné vazby mezi provozním výkonem a kvalitou trénovacích dat pro rychlé zlepšování.

Sledujte, jak AI systémy odkazují na vaši značku a zajistěte přesnost obsahu pomocí monitorovací platformy AmICited. Získejte přehled o kvalitě AI-generovaných odpovědí o vaší firmě.

Zjistěte, proč návštěvnost z AI konvertuje 23x lépe než z organického vyhledávání. Naučte se optimalizovat pro AI platformy a měřit skutečné ROI z AI návštěvník...

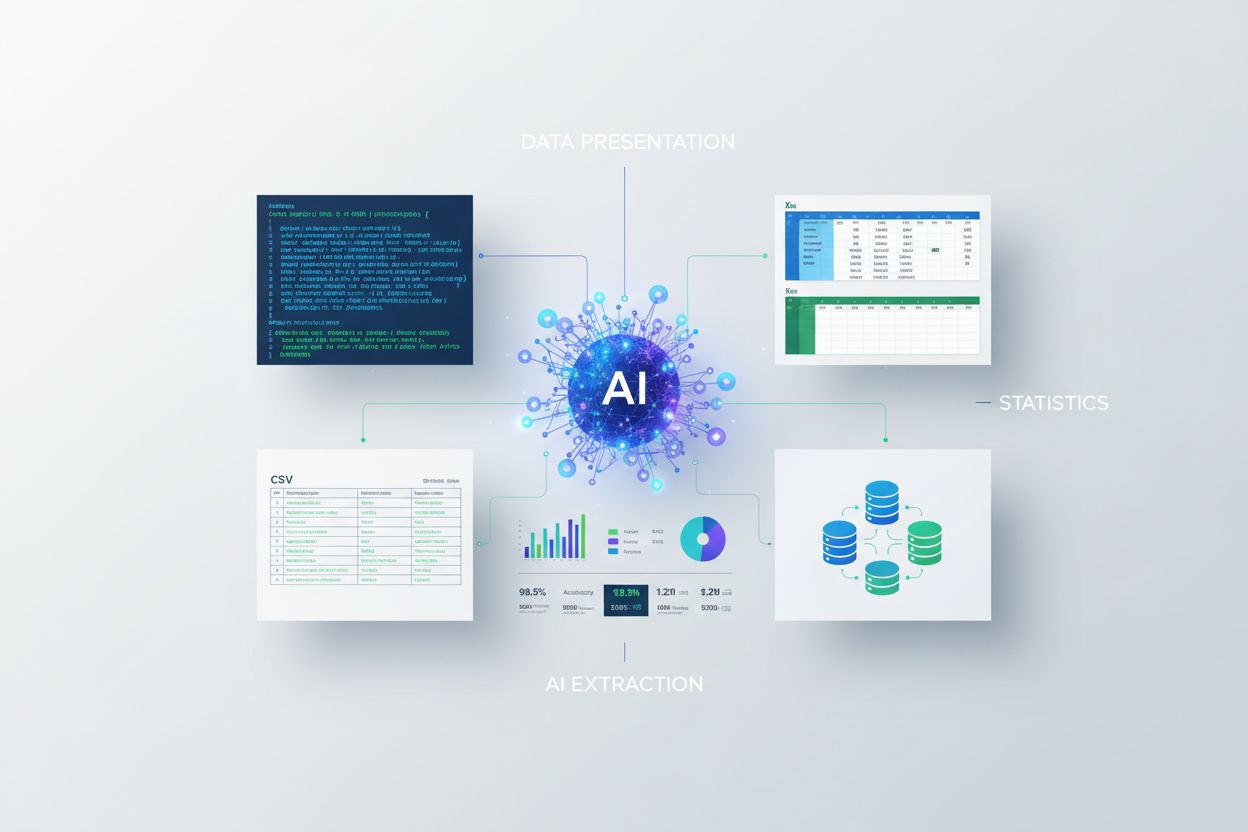

Naučte se, jak prezentovat statistiky pro AI extrakci. Objevte osvědčené postupy pro formátování dat, rozdíly mezi JSON a CSV a jak zajistit, že vaše data budou...

Diskuze komunity o požadavcích na kvalitu obsahu pro citace ve vyhledávání AI. Pochopení, jaký kvalitativní práh musí obsah splňovat pro ChatGPT, Perplexity a d...

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.