Ovlivňuje JavaScript procházení AI roboty? Dopad na viditelnost ve vyhledávání AI

Zjistěte, jak JavaScript ovlivňuje viditelnost pro AI crawlery. Objevte, proč AI boti nemohou vykreslovat JavaScript, jaký obsah zůstává skrytý a jak optimalizo...

Zjistěte, proč AI crawleři jako ChatGPT nevidí obsah renderovaný JavaScriptem a jak zajistit, aby byl váš web viditelný pro AI systémy. Objevte renderovací strategie pro AI viditelnost.

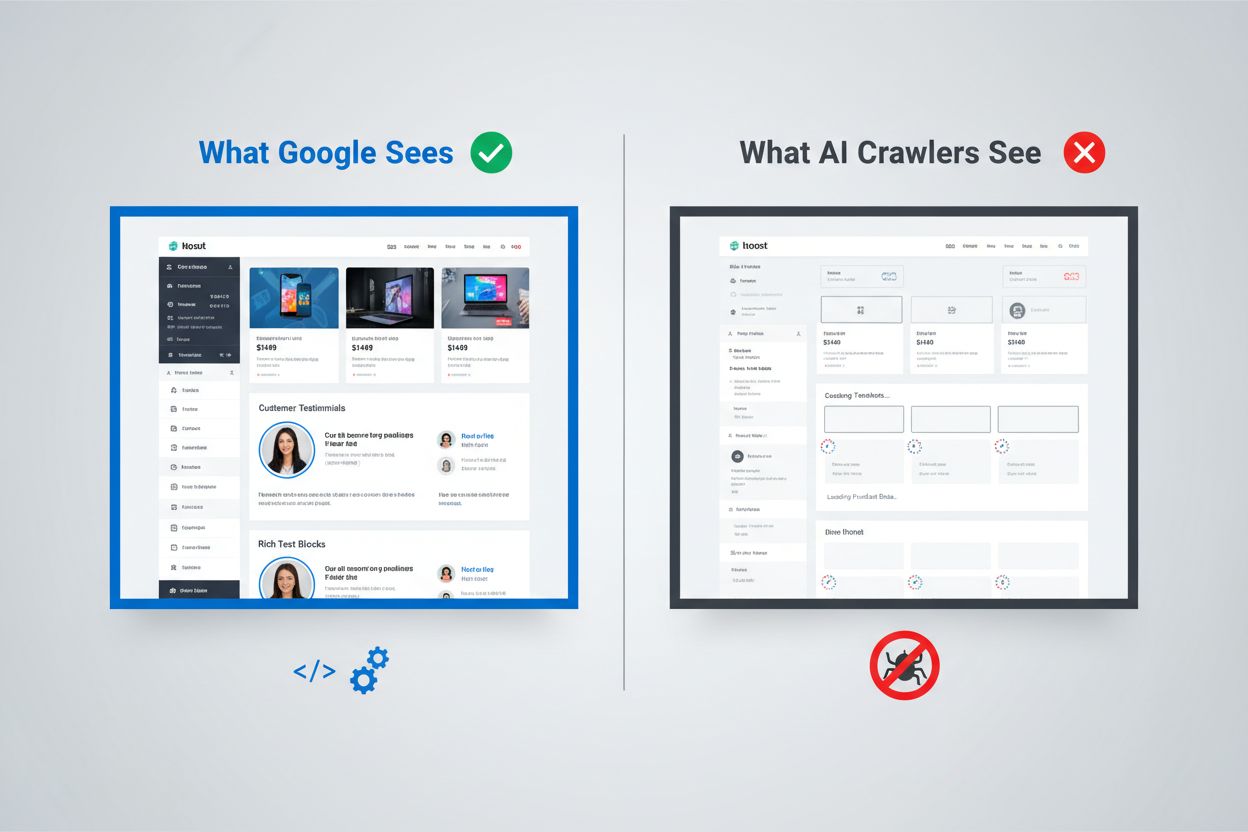

Digitální prostředí se zásadně proměnilo, ale většina organizací se s tím ještě nevyrovnala. Zatímco sofistikovaný renderovací systém Googlu dokáže spouštět JavaScript a indexovat dynamicky generovaný obsah, AI crawleři jako ChatGPT, Perplexity a Claude fungují za zcela odlišných podmínek. Vzniká tak zásadní mezera ve viditelnosti: obsah, který je pro lidské uživatele a dokonce i pro vyhledávač Google zcela v pořádku, může být naprosto neviditelný pro AI systémy, které stále více přivádějí návštěvnost a ovlivňují nákupní rozhodování. Rozpoznání tohoto rozdílu není jen technická zajímavost – stává se klíčové pro udržení viditelnosti napříč celým digitálním ekosystémem. Hraje se o hodně a řešení jsou složitější, než si většina organizací uvědomuje.

Přístup Googlu k renderování JavaScriptu představuje jeden z nejsofistikovanějších systémů, které byly kdy pro indexaci webu vytvořeny. Tento vyhledávací gigant využívá dvouvlnový renderovací systém, v němž se stránky nejprve procházejí kvůli statickému HTML obsahu, a teprve poté se znovu renderují pomocí bezhlavého prohlížeče Chrome prostřednictvím služby Web Rendering Service (WRS). Během této druhé vlny Google spustí JavaScript, sestaví kompletní DOM (Document Object Model) a zachytí plně vykreslený stav stránky. Tento proces zahrnuje i cache renderování, takže Google může opakovaně využívat již zpracované verze stránek a šetřit tak zdroje. Celý systém je navržen tak, aby zvládl složitost moderních webových aplikací a zároveň umožnil procházet miliardy stránek. Google do této schopnosti investuje obrovské výpočetní zdroje, provozuje tisíce instancí bezhlavého Chromu, aby zpracoval obsah těžký na JavaScript. Pro organizace, které se spoléhají na Google Search, to znamená, že jejich obsah renderovaný na straně klienta má šanci být viditelný – ale jen proto, že Google vybudoval mimořádně drahou infrastrukturu, která to umožňuje.

AI crawleři fungují za zásadně odlišných ekonomických a architektonických podmínek, které činí provádění JavaScriptu nepraktickým. Omezené zdroje jsou hlavní překážkou: spuštění JavaScriptu vyžaduje zapnutí prohlížečových enginů, správu paměti a udržování stavu mezi požadavky – což jsou na velkém měřítku nákladné operace. Většina AI crawlerů pracuje s časovými limity 1–5 sekund, takže musí obsah stáhnout a zpracovat extrémně rychle, nebo požadavek zcela opustit. Z pohledu nákladů a přínosů se JavaScript pro AI nevyplácí; dokážou zpracovat mnohem více obsahu prostým načtením statického HTML, než kdyby renderovaly každý navštívený web. Navíc zpracovatelský pipeline pro trénink velkých jazykových modelů obvykle při ingestu odstraňuje CSS a JavaScript a zaměřuje se pouze na sémantický HTML obsah. Architektonická filozofie je jiná: Google postavil renderování do jádra svého indexovacího systému, protože relevance vyhledávání závisí na pochopení vykresleného obsahu, zatímco AI systémy dávají přednost šíři pokrytí před hloubkou renderování. To není omezení, které by bylo snadno překonatelné – je to základní součást ekonomiky těchto systémů.

Když AI crawler požádá o stránku, dostane surový HTML soubor bez jakéhokoli spuštění JavaScriptu, což často znamená, že vidí zcela jinou verzi obsahu než běžný uživatel. Single Page Applications (SPA) postavené na Reactu, Vue nebo Angularu jsou obzvlášť problematické, protože většinou zasílají jen minimální HTML a spoléhají výhradně na JavaScript pro doplnění obsahu stránky. AI crawler, který navštíví Reactový e-shop, může dostat HTML obsahující prázdné <div id="root"></div> bez jakýchkoli informací o produktech, cenách nebo popiscích. Crawler vidí pouze kostru stránky, ale ne její podstatu. U obsahově bohatých webů to znamená, že katalogy produktů, blogové články, ceníky a dynamické sekce obsahu v pohledu AI crawleru prostě neexistují. Skutečné příklady jsou běžné: srovnávací tabulka funkcí SaaS platformy může být zcela neviditelná, doporučené produkty e-shopu nemusí být zaindexované a dynamicky nahrávané články zpravodajského webu se mohou zobrazit jako prázdné stránky. HTML, které AI crawleři dostanou, bývá jen aplikační obal – skutečný obsah je v JavaScriptových bundlích, které se nikdy nespustí. Vzniká tak situace, kdy stránka v prohlížeči vypadá dokonale, ale pro AI systémy je téměř prázdná.

Dopad této renderovací mezery daleko přesahuje technické otázky a přímo ovlivňuje příjmy, viditelnost i konkurenční pozici. Když AI crawleři nevidí váš obsah, několik klíčových obchodních funkcí trpí:

Celkově se může stát, že organizace, které investují do obsahu a uživatelského zážitku, zůstávají pro stále důležitější třídu uživatelů a systémů neviditelné. Tento problém se sám nevyřeší – vyžaduje cílený zásah.

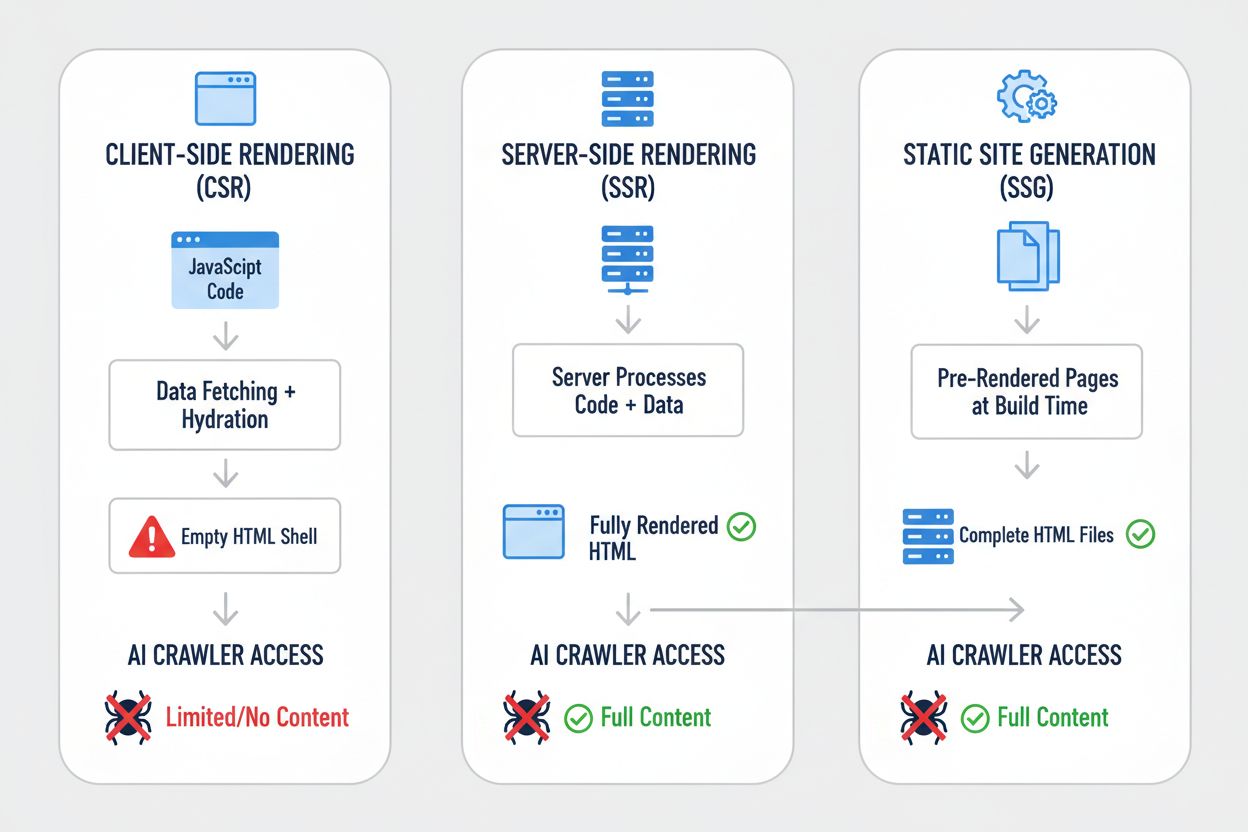

Různé renderovací strategie dávají při pohledu očima AI crawlerů dramaticky odlišné výsledky. Volba renderovacího přístupu zásadně určuje, co AI systémy mohou vidět a indexovat. Takto se jednotlivé strategie liší:

| Strategie | Co AI vidí | Dopad na AI viditelnost | Složitost | Ideální pro |

|---|---|---|---|---|

| Server-Side Rendering (SSR) | Kompletní HTML se všemi vykreslenými daty | Plná viditelnost – AI vidí vše | Vysoká | Obsahově bohaté weby, projekty kritické na SEO |

| Static Site Generation (SSG) | Předgenerované HTML soubory | Výborná viditelnost – obsah je statické HTML | Střední | Blogy, dokumentace, marketingové weby |

| Client-Side Rendering (CSR) | Prázdná HTML kostra, minimum obsahu | Špatná viditelnost – AI vidí jen obal | Nízká | Reálné dashboardy, interaktivní nástroje |

| Hybridní (SSR + CSR) | Počáteční HTML + doplnění na straně klienta | Dobrá viditelnost – základní obsah je vidět | Velmi vysoká | Složitější aplikace s dynamickými prvky |

| Pre-renderovací služba | Uložené vykreslené HTML | Dobrá viditelnost – záleží na kvalitě služby | Střední | Stávající CSR weby, kde je třeba rychlá náprava |

| API-first + HTML markup | Strukturovaná data + HTML obsah | Výborná viditelnost – pokud je správně implementováno | Vysoká | Moderní weby, headless CMS |

Každá strategie znamená jiný kompromis mezi složitostí vývoje, výkonem, uživatelským zážitkem a AI viditelností. Zásadní poznání je, že viditelnost pro AI systémy úzce souvisí s tím, zda je obsah ve statickém HTML – ať už je HTML generováno při build procesu, na požádání nebo servírováno z cache. Organizace by měly hodnotit renderovací strategii nejen podle UX a výkonu, ale i s ohledem na AI crawlery.

Server-Side Rendering (SSR) představuje zlatý standard v AI viditelnosti, protože doručuje kompletní, vykreslené HTML všem – prohlížečům i AI crawlerům. SSR znamená, že server spustí váš aplikační kód a vygeneruje celé HTML ještě před odesláním klientovi, takže AI crawler dostane kompletně vykreslenou stránku hned napoprvé. Moderní frameworky jako Next.js, Nuxt.js a SvelteKit výrazně usnadnily praktické nasazení SSR, protože automaticky řeší hydrataci (převzetí stránky JavaScriptem na klientu). Výhody SSR přesahují AI viditelnost: typicky zlepšuje Core Web Vitals, zkracuje Time to First Contentful Paint a nabízí lepší výkon pro pomalá připojení. Nevýhodou je vyšší zátěž serveru a složitější správa stavu mezi serverem a klientem. Pro organizace, pro které je AI viditelnost klíčová – zejména obsahově bohaté weby, e-shopy a SaaS aplikace – je SSR často nejlépe obhajitelnou volbou. Investice do SSR infrastruktury se vrací v několika směrech: lepší SEO, vyšší AI viditelnost, lepší uživatelský zážitek i lepší výkonové metriky.

Static Site Generation (SSG) přistupuje k věci jinak – stránky se předrenderují při build procesu a vzniknou statické HTML soubory, které lze okamžitě servírovat každému požadavku. Nástroje jako Hugo, Gatsby a Astro posunuly SSG na novou úroveň, včetně podpory dynamického obsahu přes API a inkrementálního generování. AI crawler, který požádá o stránku vygenerovanou SSG, dostane kompletní, statické HTML se vším obsahem – tedy perfektní viditelnost. Výkon je vynikající: statické soubory se načítají rychleji než jakékoli dynamické renderování a infrastruktura je minimální. Omezením je, že SSG je nejvhodnější pro obsah, který se často nemění; při změnách je třeba stránky přegenerovat a znovu nasadit. Pro blogy, dokumentaci, marketingové stránky a obsahově bohaté weby je SSG často optimální volbou. Kombinace výborné AI viditelnosti, skvělého výkonu a nízkých nároků na infrastrukturu dělá ze SSG atraktivní řešení pro mnoho případů. U aplikací vyžadujících personalizaci v reálném čase nebo časté změny obsahu je však SSG bez dalších mechanismů méně praktické.

Client-Side Rendering (CSR) zůstává populární navzdory významným nevýhodám pro AI viditelnost, hlavně proto, že nabízí nejlepší zkušenost vývojářům a největší flexibilitu pro interaktivní aplikace. U CSR server pošle jen minimum HTML a spoléhá na to, že stránku sestaví JavaScript v prohlížeči – což znamená, že AI crawler vidí téměř nic. React, Vue a Angular mají CSR jako výchozí přístup a mnoho organizací na tom postavilo celou svou technologickou infrastrukturu. Důvody jsou jasné: CSR umožňuje bohaté, interaktivní zážitky, aktualizace v reálném čase a plynulé přechody. Problém je, že tato flexibilita je vykoupena minimální AI viditelností. Pokud aplikace vyžaduje CSR – dashboardy v reálném čase, kolaborativní nástroje, komplexní interaktivní aplikace – existují řešení. Pre-renderovací služby jako Prerender.io dokáží generovat statické HTML snímky CSR stránek a servírovat je crawlerům, zatímco uživatelům zůstává interaktivní verze. Alternativou jsou hybridní přístupy, kdy klíčový obsah je renderován na serveru a interaktivní prvky zůstávají na klientu. Klíčová myšlenka: CSR by měl být zvolen vědomě s plným pochopením dopadů na viditelnost, ne jako výchozí stav.

Praktická řešení vyžadují systematický postup od poznání současného stavu přes implementaci po průběžné sledování. Začněte auditem: použijte nástroje jako Screaming Frog, Semrush nebo vlastní skripty, které prolezou váš web očima AI crawleru a ukáží, co je skutečně viditelné v surovém HTML. Implementujte úpravy renderování podle výsledků auditu – může jít o migraci na SSR, zavedení SSG pro vhodné sekce nebo pre-rendering klíčových stránek. Důkladně testujte porovnáním toho, co vidí AI crawler vs. prohlížeč; použijte curl pro získání surového HTML a porovnejte ho s vykreslenou verzí. Průběžně monitorujte, abyste měli jistotu, že změny renderování časem nevedou ke ztrátě viditelnosti. U velkých webů má smysl začít u nejhodnotnějších stránek – produktových a cenových stránek, klíčových sekcí obsahu – a teprve potom řešit zbytek. Nástroje jako Lighthouse, PageSpeed Insights a vlastní monitorovací řešení pomohou sledovat výkon i AI viditelnost. Investice do správného řešení se projeví ve vyšší SEO, AI viditelnosti i celkovém výkonu webu.

Testování a sledování renderovací strategie vyžaduje konkrétní techniky, které odhalí, co AI crawleři skutečně vidí. Nejjednodušší je použít curl pro stažení surového HTML bez spuštění JavaScriptu:

curl -s https://example.com | grep -i "product\|price\|description"

Takto přesně vidíte, co crawler obdrží – pokud se v tomto výstupu klíčový obsah neobjeví, AI systémy ho neuvidí. Testování v prohlížeči přes Chrome DevTools vám ukáže rozdíl mezi počátečním HTML a plně vykresleným DOM; otevřete DevTools, přejděte na záložku Network a prohlédněte si počáteční odpověď HTML oproti finálnímu stavu stránky. Pro průběžné sledování použijte syntetický monitoring, který pravidelně stahuje stránky jako AI crawler a upozorní na zhoršení viditelnosti. Sledujte metriky jako „procento obsahu viditelného v počátečním HTML“ a „čas do viditelnosti obsahu“, abyste rozuměli svému renderovacímu výkonu. Některé organizace si budují vlastní monitorovací dashboardy, které porovnávají AI viditelnost i vůči konkurenci a poskytují přehled, kdo optimalizuje pro AI a kdo ne. Klíčové je, aby bylo monitorování kontinuální a akceschopné – problémy s viditelností je třeba zachytit a opravit rychle, ne až za měsíce po poklesu návštěvnosti.

Budoucnost schopností AI crawlerů je nejistá, ale současná omezení se v dohledné době pravděpodobně zásadně nezmění. OpenAI experimentovala s pokročilejšími crawlery jako Comet a Atlas browsery, které JavaScript spouštět umí, ale zatím zůstávají experimentální a nejsou nasazeny ve velkém pro sběr tréninkových dat. Základní ekonomika se nezměnila: spouštění JavaScriptu ve velkém je stále drahé a pipeline pro trénink dat více těží ze šíře než z hloubky. I kdyby AI crawleři časem získali schopnosti renderovat JavaScript, optimalizace, které uděláte nyní, vám neublíží – serverem vykreslený obsah vždy lépe slouží uživatelům, načítá se rychleji a má lepší SEO. Rozumný přístup je tedy optimalizovat pro AI viditelnost už teď, nečekat na zlepšení crawlerů. Znamená to brát AI viditelnost jako plnohodnotnou součást renderovací strategie, ne jako vedlejší efekt. Kdo tento posun udělá dřív, získá konkurenční výhodu, jakmile se AI systémy stanou pro návštěvnost a viditelnost stále důležitějšími.

Monitorování AI viditelnosti a sledování pokroku v čase vyžaduje správné nástroje a metriky. AmICited.com nabízí praktické řešení pro sledování, jak se váš obsah objevuje v AI generovaných odpovědích a jaká je vaše viditelnost napříč různými AI systémy. Díky sledování, které vaše stránky jsou citovány, citovány či odkazovány v AI generovaném obsahu, získáte skutečný přehled o dopadu svých optimalizací renderování. Platforma vám pomůže poznat, který obsah je pro AI systémy viditelný a který stále zůstává skrytý, a poskytuje konkrétní data o efektivitě vaší strategie. Jakmile implementujete SSR, SSG nebo pre-rendering, AmICited.com vám umožní změřit skutečné zlepšení AI viditelnosti – uvidíte, zda se vaše optimalizace opravdu promítá do vyššího počtu citací a zmínek. Tato zpětná vazba je zásadní pro obhájení investice do renderovacích úprav a určení, které stránky potřebují další optimalizaci. Kombinací technického monitoringu toho, co AI crawleři vidí, s byznys metrikami o tom, jak často váš obsah skutečně figuruje v AI odpovědích, získáte kompletní přehled o své AI viditelnosti.

Ne, ChatGPT a většina AI crawlerů nedokáže spustit JavaScript. Vidí pouze surové HTML z počátečního načtení stránky. Jakýkoli obsah vložený JavaScriptem po načtení stránky zůstává pro AI systémy zcela neviditelný, na rozdíl od Googlu, který používá bezhlavé prohlížeče Chrome pro renderování JavaScriptu.

Google používá bezhlavé prohlížeče Chrome k renderování JavaScriptu, podobně jako skutečný prohlížeč. Je to náročné na prostředky, ale Google má infrastrukturu, která to zvládá ve velkém měřítku. Googleův dvouvlnový renderovací systém nejprve prochází statické HTML, poté znovu renderuje stránky se spuštěním JavaScriptu, aby zachytil kompletní DOM.

Vypněte JavaScript ve svém prohlížeči a načtěte svůj web, nebo použijte příkaz curl pro zobrazení surového HTML. Pokud chybí klíčový obsah, AI crawleři jej také neuvidí. Můžete také použít nástroje jako Screaming Frog v režimu 'Text Only', abyste prolezli svůj web tak, jak by to udělal AI crawler.

Ne. Můžete také použít generování statických stránek, pre-renderovací služby nebo hybridní přístupy. Nejlepší řešení závisí na typu vašeho obsahu a frekvenci aktualizací. SSR je vhodné pro dynamický obsah, SSG pro stabilní obsah a pre-renderovací služby pro stávající CSR weby.

Google zvládá JavaScript, takže vaše pozice by neměly být přímo ovlivněny. Optimalizace pro AI crawleři však často zlepšuje celkovou kvalitu webu, výkon a uživatelský zážitek, což může nepřímo prospět i vašim pozicím v Googlu.

Záleží na frekvenci procházení daného AI systému. ChatGPT-User prochází na vyžádání, když uživatelé požadují obsah, zatímco GPTBot prochází velmi zřídka s dlouhými intervaly mezi obnovením. Změny se mohou v AI odpovědích projevit až po týdnech, ale pokrok můžete sledovat pomocí nástrojů jako AmICited.com.

Pre-renderovací služby se snadněji implementují a udržují s minimálními změnami kódu, zatímco SSR nabízí větší kontrolu a lepší výkon pro dynamický obsah. Volte podle svých technických možností, frekvence aktualizací obsahu a složitosti aplikace.

Ano, můžete použít robots.txt k zablokování konkrétních AI crawlerů jako GPTBot. Znamená to však, že váš obsah se neobjeví v odpovědích generovaných AI, což může snížit viditelnost a návštěvnost z AI vyhledávacích nástrojů a asistentů.

Sledujte, jak AI systémy odkazují na vaši značku napříč ChatGPT, Perplexity a Google AI Overviews. Identifikujte mezery ve viditelnosti a měřte dopad svých optimalizací renderování.

Zjistěte, jak JavaScript ovlivňuje viditelnost pro AI crawlery. Objevte, proč AI boti nemohou vykreslovat JavaScript, jaký obsah zůstává skrytý a jak optimalizo...

Zjistěte, jak SSR a CSR strategie vykreslování ovlivňují viditelnost pro AI crawlery, citace značky v ChatGPT a Perplexity a vaši celkovou přítomnost ve vyhledá...

Zjistěte, jak prerendrování zpřístupňuje JavaScriptový obsah AI crawlerům jako ChatGPT, Claude a Perplexity. Objevte nejlepší technická řešení pro optimalizaci ...

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.