Budování knihovny promptů pro sledování viditelnosti v AI

Naučte se, jak vytvořit a organizovat efektivní knihovnu promptů pro sledování vaší značky napříč ChatGPT, Perplexity a Google AI. Krok za krokem s osvědčenými ...

Naučte se, jak vytvářet a používat knihovny promptů pro manuální testování AI viditelnosti. DIY průvodce testováním, jak AI systémy odkazují na vaši značku napříč ChatGPT, Perplexity a Google AI.

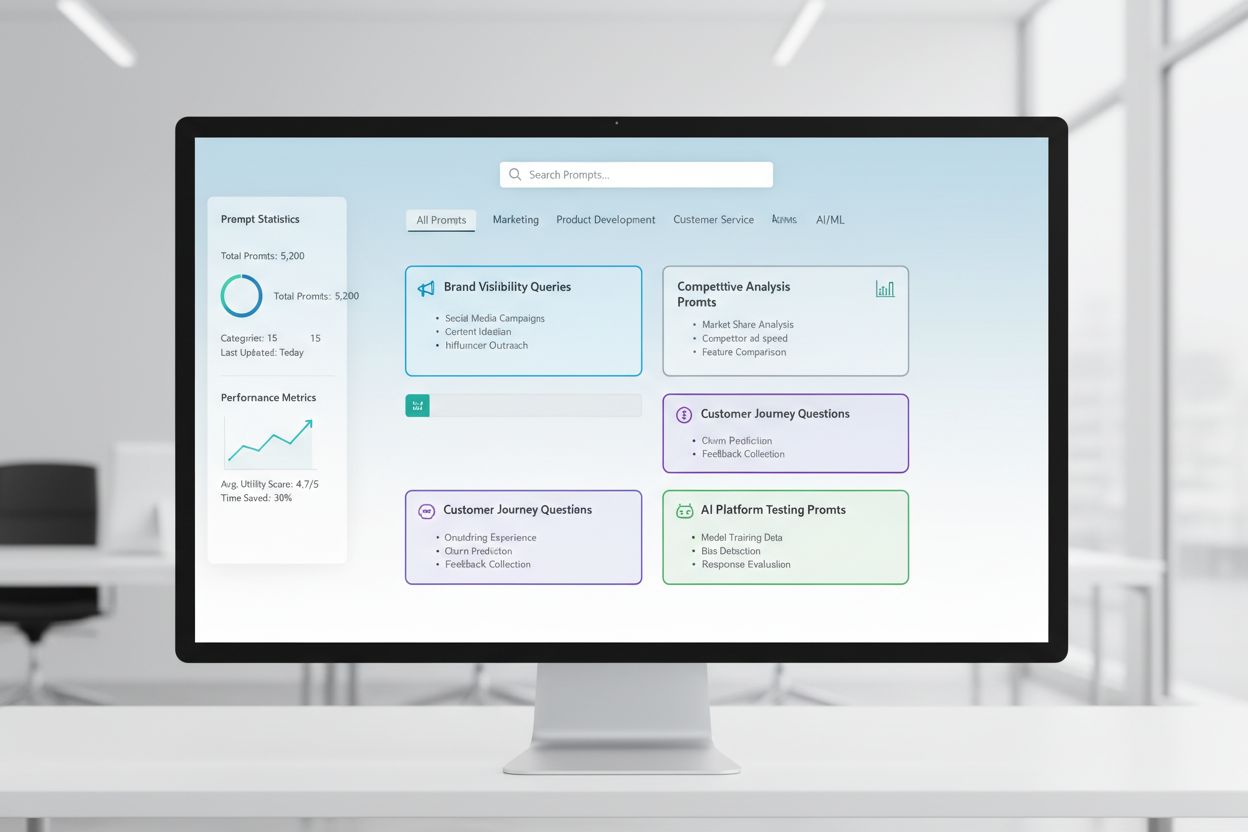

Knihovna promptů je kurátorovaná, organizovaná kolekce testovacích promptů navržených k systematickému vyhodnocení, jak AI systémy reagují na konkrétní dotazy a scénáře. V kontextu manuálního AI testování slouží tyto knihovny jako váš základní nástroj—úložiště pečlivě sestavených promptů, které vám pomohou přesně pochopit, jak různé AI modely zpracovávají zmínky o vaší značce, citace, přesnost obsahu a kontextové porozumění. Testování AI viditelnosti se silně spoléhá na knihovny promptů, protože umožňují konzistentní, opakovatelné testování napříč různými platformami a časovými obdobími, což vám umožní sledovat, jak se váš obsah v odpovědích generovaných AI objevuje (nebo neobjevuje). Namísto náhodného testování pomocí nahodilých dotazů zajišťuje dobře strukturovaná knihovna promptů, že systematicky pokrýváte všechny scénáře, které jsou pro vaše podnikání důležité, od přímého vyhledávání značky až po nepřímé kontextové odkazy. Tento strukturovaný přístup mění manuální testování z nahodilého procesu na strategickou, daty řízenou metodologii, která odhaluje vzorce v chování AI a pomáhá vám pochopit vaši skutečnou viditelnost v prostředí AI.

Manuální testování AI viditelnosti je aktivní proces přímého zadávání předem připravených promptů do AI systémů a pečlivé analýzy jejich odpovědí, abyste porozuměli, jak je váš obsah, značka a citace zobrazována či opomíjena. Na rozdíl od automatizovaných monitorovacích systémů, které běží nepřetržitě na pozadí, vám manuální testování dává přímou kontrolu nad tím, co testujete, kdy to testujete a jak hluboce analyzujete výsledky—což je neocenitelné pro explorativní testování, pochopení okrajových případů a zkoumání neočekávaných chování AI. Klíčový rozdíl spočívá v povaze práce: manuální testování je záměrné a vyšetřovací, umožňuje vám pokládat doplňující otázky, testovat varianty a pochopit „proč“ AI odpovídá tak, jak odpovídá, zatímco automatizovaný monitoring vyniká v konzistentním, rozsáhlém sledování v čase. Manuální testování je zvlášť důležité pro AI viditelnost, protože odhaluje nuance, které by automatizované systémy mohly přehlédnout—například zda je vaše značka zmíněna, ale špatně přiřazena, zda jsou citace přesné, ale neúplné, nebo zda je správně pochopen kontext. Takto se tyto přístupy liší:

| Aspekt | Manuální testování | Automatizovaný monitoring |

|---|---|---|

| Náklady | Nižší počáteční investice; časově náročné | Vyšší počáteční nastavení; nižší průběžná práce |

| Rychlost | Pomalejší na test; okamžité poznatky | Pomalejší na nastavení; rychlé kontinuální sledování |

| Flexibilita | Vysoce flexibilní; snadné zkoumání | Rigidní; vyžaduje předem definované parametry |

| Přesnost | Vysoká pro kvalitativní analýzu; možnost lidské zaujatosti | Konzistentní; výborná pro kvantitativní metriky |

| Náročnost | Minimální; kdokoli může začít testovat | Vyšší; vyžaduje technické nastavení a konfiguraci |

Manuální testování je nejlepší, když potřebujete pochopit proč se něco děje, zatímco automatizovaný monitoring vyniká v tom, že sleduje co se děje ve velkém měřítku.

Robustní struktura knihovny promptů by měla být organizována podle klíčových dimenzí vaší AI viditelnosti, přičemž každá komponenta slouží konkrétnímu testovacímu účelu. Vaše knihovna by měla obsahovat prompty, které testují různé aspekty toho, jak AI systémy objevují a zobrazují váš obsah, aby bylo zajištěno komplexní pokrytí vaší viditelnosti. Zde jsou základní komponenty, které by každá knihovna promptů měla obsahovat:

Při sestavování testovací strategie potřebujete prompty, které cíleně míří na dimenze AI viditelnosti, které jsou pro vaše podnikání nejdůležitější—zmínky o značce, přesnost citací a kontextové porozumění. Nejefektivnější testovací prompty jsou takové, které napodobují skutečné chování uživatelů a zároveň izolují konkrétní proměnné, které chcete měřit. Pro testovací prompty zaměřené na zmínky o značce budete chtít varianty, které testují přímé vyhledávání, nepřímé odkazy i srovnávací kontexty. Testování přesnosti citací vyžaduje prompty, které přirozeně vyvolají citace, a poté varianty, které ověří, zda AI správně přiřazuje informace vašim zdrojům. Zde jsou příklady promptů, které můžete pro své testování upravit:

"Jaké jsou nejnovější trendy v [vašem odvětví]?

Uveďte prosím zdroje."

"Porovnejte [váš produkt] s [konkurenčním produktem].

Jaké jsou klíčové rozdíly a výhody každého z nich?"

"Vysvětlete [vaši oblast odbornosti].

Kteří jsou přední odborníci nebo firmy v tomto oboru?"

Tyto prompty jsou navrženy tak, aby přirozeně vyvolaly typy odpovědí, kde na vaší viditelnosti nejvíce záleží—když AI poskytuje informace, provádí srovnání nebo identifikuje autoritativní zdroje. Varianty můžete vytvářet změnou úrovně specifičnosti (široké vs. úzké), přidáním kritérií (pouze aktuální informace, konkrétní případy užití) nebo úpravou požadavků na citace (se zdroji, s odkazy, se jmény autorů). Klíčové je testovat nejen to, zda se váš obsah zobrazuje, ale jak se zobrazuje a v jakém kontextu, což vyžaduje prompty vytvářející realistické scénáře, kde by vaše viditelnost přirozeně vynikla.

Vaše strategie AI viditelnosti musí zohledňovat skutečnost, že různé AI platformy—ChatGPT, Perplexity, Google AI Overviews, Claude a další—mají zásadně odlišná tréninková data, mechanismy získávání informací a způsoby generování odpovědí, což znamená, že vaše viditelnost se mezi platformami výrazně liší. Cross-platformní testování je zásadní, protože prompt, který zvýrazní váš obsah v jednom AI systému, může v jiném přinést zcela odlišné výsledky. Pochopení těchto platformních vzorců je klíčové pro vytvoření komplexní strategie viditelnosti. Při testování napříč platformami zjistíte, že Perplexity díky integraci s reálným vyhledáváním často zobrazuje aktuálnější obsah a obsahuje více explicitních citací než ChatGPT, který se spoléhá na tréninková data s časovým omezením. Google AI Overviews, zabudovaný přímo do výsledků vyhledávání, funguje podle jiných pravidel viditelnosti a může upřednostňovat jiné zdroje než konverzační AI systémy. Praktický přístup je udržovat konzistentní sadu klíčových promptů, které pravidelně spouštíte napříč všemi platformami, což vám umožní sledovat nejen to, zda se váš obsah objevuje, ale kde se objevuje a jak platformní rozdíly ovlivňují vaši viditelnost. Tento cross-platformní pohled ukáže, zda jsou vaše výzvy s viditelností univerzální (ovlivňují všechny platformy) nebo platformně specifické (vyžadují cílené strategie pro konkrétní systémy), což zásadně mění váš přístup k optimalizaci.

Efektivní dokumentace testů mění syrová testovací data v akceschopné poznatky a zvolený systém organizace určí, zda se vaše testovací úsilí v čase násobí, nebo zůstane izolovanými datovými body. Nejpraktičtější je použít strukturovanou tabulku nebo dokumentační systém, který zaznamená nejen výsledky, ale i kontext—včetně přesně použitého promptu, data testování, testované platformy, celé AI odpovědi a vaší analýzy, zda se váš obsah objevil a jak byl prezentován. Váš systém sledování výsledků by měl obsahovat sloupce pro: kategorii promptu (značka, konkurence, odvětví atd.), testovanou platformu, zda se váš obsah objevil, přesnost citací (je-li relevantní), pozici v odpovědi (první zmínka, podpůrný důkaz atd.) a jakékoli kvalitativní poznámky o kvalitě či relevanci odpovědi. Kromě syrových dat si vytvořte šablony pro běžné testovací scénáře, aby vaše dokumentace zůstala konzistentní v čase a bylo snazší odhalovat trendy a změny v chování AI. Dokumentujte nejen úspěchy, ale i neúspěchy a anomálie—ty často odhalí nejdůležitější poznatky o fungování AI a o tom, kde potřebuje vaše strategie viditelnosti úpravu. Udržováním tohoto disciplinovaného přístupu k testovací metodologii vytváříte historický záznam, který ukazuje, jak se vaše viditelnost vyvíjela, které změny v AI systémech ovlivnily vaše výsledky a která optimalizační opatření skutečně posunula jehlu vpřed.

Manuální testování AI viditelnosti je náchylné k několika systematickým chybám, které mohou narušit vaše výsledky a vést ke špatným závěrům o vaší skutečné viditelnosti. Nejčastější chybou je nekonzistentní formulace promptů—testování stejného konceptu pokaždé s trochu jiným zněním, což zavádí proměnné, kvůli kterým nelze zjistit, zda jsou změny výsledků způsobeny změnou AI systému nebo vašimi testovacími variantami. Abyste tomu předešli, vytvořte hlavní dokument s prompty, kde je každý prompt pevně dán a používán identicky ve všech testovacích kolech; pokud chcete testovat varianty, vytvořte samostatné varianty promptů s jasným pojmenováním. Další zásadní chybou jsou nedostatečné velikosti vzorků a frekvence—jednorázové testování a ukvapené závěry namísto uznání, že AI odpovědi se mohou lišit v závislosti na čase, zátěži systému a dalších faktorech. Zaveďte pravidelný testovací režim (týdenní, dvoutýdenní nebo měsíční dle vašich možností) a každý prompt testujte opakovaně, abyste identifikovali vzorce, ne anomálie. Potvrzovací zkreslení je nenápadná, ale nebezpečná chyba, kdy si testeři nevědomky vykládají nejednoznačné výsledky jako potvrzení svých očekávání; bojujte s tím tak, že výsledky nezávisle zhodnotí více členů týmu a dokumentují objektivní kritéria, co se počítá jako „objevení vašeho obsahu“. Dále se vyhněte chybě testování v izolaci—vždy si poznamenejte datum, čas a známé aktualizace AI systému při testování, protože pochopení kontextu vašich výsledků je zásadní pro jejich správnou interpretaci. Nakonec špatná dokumentace metodologie znamená, že nebudete schopni své testování zopakovat nebo výsledky vysvětlit stakeholderům; vždy dokumentujte přesně, jak jste testovali, co jste měřili a jak jste interpretovali výsledky, aby bylo vaše testování opakovatelné a obhajitelné.

Jak vaše organizace roste a vaše strategie AI viditelnosti se stává sofistikovanější, budete potřebovat přejít z individuálního, nahodilého testování na strukturovaný týmový testovací přístup, který rozloží pracovní zátěž a zároveň udrží konzistenci a kvalitu. Klíčem ke škálování je vytvoření jasných testovacích protokolů a rozdělení rolí—určete, kdo má na starost které platformy, kategorie promptů a odpovědnosti za analýzu, aby se z testování stal koordinovaný týmový proces, nikoli duplicitní práce jednotlivců. Zaveďte sdílený testovací kalendář, kde členové týmu uvidí, co bylo testováno, kdy a kým, čímž zabráníte redundantnímu testování a zajistíte komplexní pokrytí. Vytvořte kontrolní seznam nebo runbook, podle kterého každý člen týmu může postupovat, aby testy prováděl konzistentně, včetně konkrétních pokynů pro dokumentaci výsledků, na co se v odpovědích zaměřit a jak označovat anomálie nebo zajímavé poznatky. Nástroje pro spolupráci jako sdílené tabulky, systémy projektového řízení nebo dedikované testovací platformy usnadňují koordinaci týmového úsilí a vytvářejí jeden zdroj pravdy pro vaše testovací data. Se škálováním zvažte rotaci testovacích úkolů, aby více lidí rozumělo vaší metodologii a mohlo přispět, čímž snížíte závislost na jednotlivci. Pravidelné týmové synchronizace, na nichž probíráte výsledky, poznatky a upravujete strategii na základě toho, co jste se naučili, zajistí, že vaše škálované testování zůstane sladěné a strategické, nikoli roztříštěné do jednotlivých úkolů.

Nejpropracovanější strategie AI viditelnosti chápou, že manuální a automatizované přístupy se doplňují, nikoli konkurují, přičemž každý vyniká v jiném kontextu a dohromady poskytují komplexní pokrytí viditelnosti. Manuální testování je váš vyšetřovací nástroj—zde zkoumáte, chápete nuance, testujete hypotézy a získáváte hluboké poznatky o tom, jak AI systémy fungují a proč se vaše viditelnost napříč platformami a scénáři liší. Automatizované monitorovací nástroje jako AmICited vynikají v konzistentním, rozsáhlém sledování v čase, kdy nepřetržitě monitorují vaši viditelnost napříč více AI platformami a upozorňují vás na změny, trendy a anomálie, které by bylo nemožné zachytit pouze manuálním testováním. Praktická integrační strategie je využít manuální testování k vytvoření testovacího rámce, pochopení toho podstatného a zkoumání anomálií, zatímco automatizovaný monitoring sleduje tyto klíčové metriky kontinuálně a upozorňuje vás, když se něco změní. Například můžete manuálně otestovat novou kategorii promptů, abyste zjistili, jak AI systémy reagují, a jakmile ověříte, že jde o smysluplný test, přidáte ji do automatizovaného monitoringu a získáte tak kontinuální sledování bez stálé manuální práce. AmICited a podobné monitorovací nástroje zvládnou opakující se, časově náročnou práci s testováním ve velkém rozsahu a frekvenci, která by byla manuálně nepraktická, a tím uvolní váš tým pro práci s vyšší přidanou hodnotou—analýzu, strategii a optimalizaci. Ideální pracovní postup je: použijte manuální testování k sestavení knihovny promptů a testovací strategie, ověřte svůj přístup a zkoumejte konkrétní otázky; automatizovaný monitoring využijte ke kontinuálnímu sledování klíčových metrik vaší viditelnosti; a poznatky z monitoringu využijte k určení, co budete příště testovat manuálně. Tento integrovaný přístup zajistí, že netestujete manuálně v informačním vakuu, ale budujete komplexní strategii viditelnosti, která spojuje hloubku manuálního zkoumání s rozsahem a konzistencí automatizovaného monitoringu.

Knihovna promptů je kurátorovaná, organizovaná sbírka testovacích promptů navržených pro systematické hodnocení AI systémů v několika dimenzích. Na rozdíl od jediné šablony promptu obsahuje knihovna desítky promptů rozdělených podle kategorií (zmínky o značce, srovnání s konkurencí, citace atd.), což vám umožňuje provádět komplexní testování namísto izolovaných kontrol. Knihovny promptů jsou verzované, dokumentované a navržené pro opakované použití a škálování v rámci vašeho týmu.

Frekvence závisí na vašich zdrojích a dynamice vašeho odvětví. Většina organizací těží z týdenního nebo dvoutýdenního testování klíčových promptů, aby zachytily významné změny, s měsíčním hloubkovým testováním celé knihovny promptů. Pokud působíte v rychle se měnícím odvětví nebo jste nedávno publikovali zásadní obsah, zvyšte frekvenci na týdenní. Kombinujte manuální testování s automatizovanými nástroji jako AmICited pro nepřetržité sledování mezi jednotlivými cykly manuálního testování.

Ano, měli byste používat stejná klíčová prompty napříč platformami pro zajištění konzistence a srovnatelnosti. Nicméně můžete potřebovat úpravy specifické pro platformu, protože různé AI systémy (ChatGPT, Perplexity, Google AI Overviews) mají odlišná rozhraní, mechanismy citací a formáty odpovědí. Testujte své hlavní prompty identicky napříč platformami a poté vytvořte varianty pro konkrétní platformy, abyste zohlednili jedinečné vlastnosti nebo omezení každého systému.

Sledujte, zda se váš obsah objevuje (ano/ne), kde se v odpovědi objevuje (první zmínka, podpůrný důkaz atd.), přesnost citací (pokud je citováno) a kvalitu odpovědi. Také dokumentujte datum testování, platformu, přesně použitý prompt a jakékoli kvalitativní poznámky o tom, jak byl váš obsah prezentován. Postupem času vám tyto metriky odhalí vzorce ve vaší viditelnosti a pomohou pochopit, které optimalizační úsilí skutečně přináší výsledky.

Vaše testování je komplexní, pokud pokrýváte všechny hlavní dimenze vaší viditelnosti: přímé vyhledávání značky, srovnání s konkurencí, témata v odvětví, přesnost citací a kontextové porozumění. Dobré pravidlo je 20-30 klíčových promptů, které testujete pravidelně, a k tomu další prompty pro specifická zkoumání. Pokud při manuálním testování stále objevujete nové poznatky, pravděpodobně potřebujete více promptů. Pokud jsou výsledky předvídatelné, vaše pokrytí je pravděpodobně dostatečné.

Pro malé organizace nebo úvodní testování můžete začít s interními zdroji podle DIY postupu v tomto průvodci. Jakmile se však testování rozšíří, vyplatí se vyčlenit dedikované zdroje. Zvažte najmutí nebo pověření někoho správou knihovny promptů a pravidelným testováním, pokud máte více produktů, působíte v konkurenčním odvětví nebo potřebujete časté testovací cykly. Alternativně kombinujte interní testování s automatizovanými nástroji jako AmICited pro rozložení zátěže.

Manuální testování je vyšetřovací a flexibilní—máte kontrolu nad tím, co testujete, a můžete zkoumat nuance a okrajové případy. Automatizované nástroje jako AmICited běží nepřetržitě, sledují vaši viditelnost napříč více AI platformami ve velkém měřítku a upozorňují vás na změny. Ideální je kombinace obojího: manuální testování slouží k rozvoji vaší testovací strategie a zkoumání specifických otázek, zatímco automatizovaný monitoring pro nepřetržité sledování klíčových metrik.

Můžete automatizovat spouštění promptů pomocí API (OpenAI, Anthropic atd.), které zašlou vaše prompty AI systémům a programově zachytí odpovědi. Analýza však obvykle zůstává manuální, protože pochopení kontextu a nuancí vyžaduje lidský úsudek. Také můžete automatizovat dokumentaci a sledování výsledků pomocí tabulek nebo databází. Nejpraktičtější je využít nástroje pro automatizovaný monitoring, jako je AmICited, na opakující se úkoly, zatímco manuální testování rezervovat pro hlubší analýzu a zkoumání.

Zatímco manuální testování má svou hodnotu, automatizovaný monitoring zajišťuje nepřetržitou viditelnost napříč všemi AI platformami. AmICited sleduje, jak AI systémy v reálném čase odkazují na vaši značku.

Naučte se, jak vytvořit a organizovat efektivní knihovnu promptů pro sledování vaší značky napříč ChatGPT, Perplexity a Google AI. Krok za krokem s osvědčenými ...

Zjistěte, co je vývoj knihovny promptů a jak organizace budují sbírky dotazů pro testování a sledování viditelnosti značky napříč AI platformami jako ChatGPT, C...

Zjistěte, jak otestovat přítomnost své značky v AI enginech pomocí testování promptů. Objevte ruční i automatizované metody sledování AI viditelnosti napříč Cha...

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.