Referenční karta AI crawlerů: Přehled všech botů na jednom místě

Kompletní průvodce AI crawlery a boty. Identifikujte GPTBot, ClaudeBot, Google-Extended a dalších 20+ AI crawlerů podle user agentů, rychlostí procházení a stra...

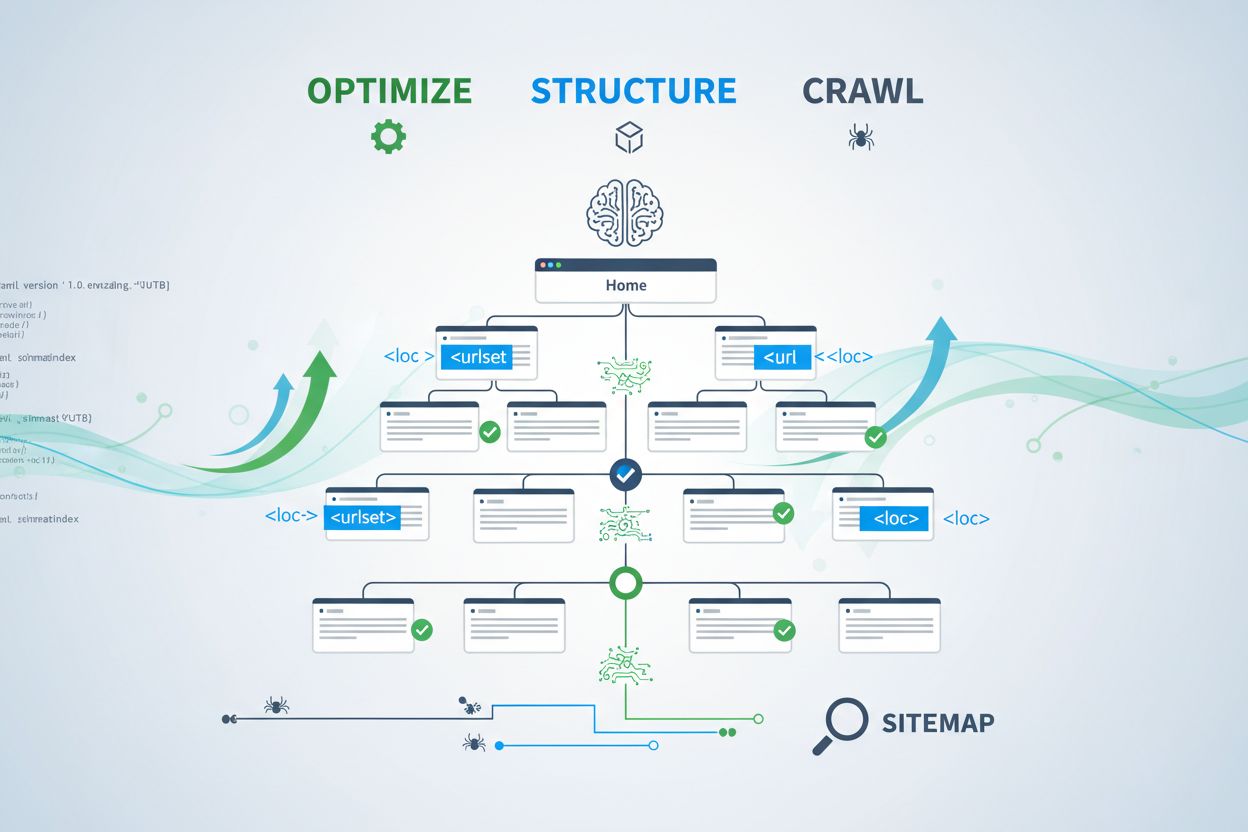

Zjistěte, jak optimalizovat XML sitemapy pro AI crawlery jako GPTBot a ClaudeBot. Zvládněte osvědčené postupy práce se sitemapami a zvyšte viditelnost v AI odpovědích i indexaci LLM.

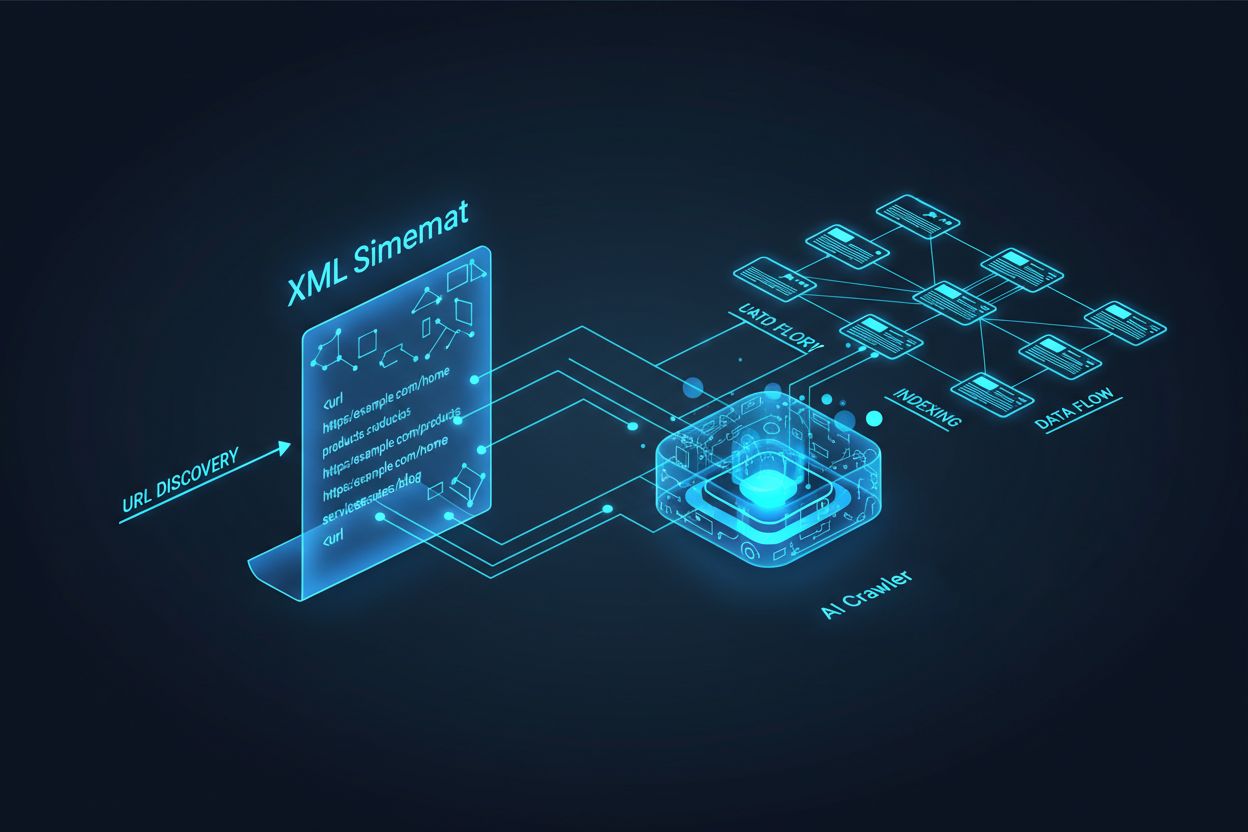

AI crawlery jako GPTBot, ClaudeBot a PerplexityBot fungují zásadně odlišně od tradičních vyhledávacích botů. Zatímco Googlebot indexuje stránky pro řazení ve výsledcích vyhledávání, AI crawlery extrahují znalosti pro trénink a vylepšování velkých jazykových modelů, které pohánějí konverzační vyhledávání a AI generované odpovědi. Bez správně optimalizované XML sitemapy zůstane váš obsah těmto klíčovým systémům neviditelný, bez ohledu na jeho kvalitu či autoritu. Přemýšlejte o své sitemapě jako o mapě, která AI systémům přesně ukazuje, kde žije váš nejcennější obsah a jak je uspořádán.

Rozlišení mezi tradičními vyhledávacími crawlery a AI crawlery je zásadní pro pochopení, proč je optimalizace sitemap důležitější než kdy dřív. Tradiční vyhledávače jako Google se zaměřují na řazení jednotlivých stránek podle klíčových slov, zatímco AI crawlery upřednostňují zachycení znalostí a sémantické porozumění. Tady je jejich rozdíl:

| Aspekt | Tradiční crawlery (Googlebot) | AI crawlery (GPTBot, ClaudeBot) |

|---|---|---|

| Hlavní účel | Řadit stránky ve výsledcích vyhledávání | Extrahovat znalosti pro trénování LLM a odpovědi v reálném čase |

| Zaměření | Metadata, interní odkazy, hodnoticí signály | Struktura obsahu, sémantický význam, hustota faktů |

| Priorita procházení | Podle PageRanku a aktuálnosti | Podle autority, tematické relevance a hodnoty znalostí |

| Dopad na citace | Přivádí návštěvnost přes modré odkazy | Určuje, zda se váš obsah objeví v AI odpovědích |

| Zpracování JavaScriptu | Spouští a vykresluje JavaScript | Často JavaScript přeskočí; upřednostňuje serverem vykreslené HTML |

Tento zásadní rozdíl znamená, že optimalizovat pouze pro tradiční SEO již nestačí. Vaše sitemap teď musí plnit dvojí účel: pomáhat vyhledávačům pochopit strukturu webu a zároveň navádět AI systémy na vaše nejhodnotnější znalostní zdroje.

XML sitemap funguje jako plán vašeho webu, který crawlerům výslovně sděluje, které stránky existují a jak zapadají do vaší obsahové strategie. Pro AI systémy má sitemap ještě důležitější funkci než pro tradiční vyhledávače. AI crawlery využívají sitemapy k pochopení tematické architektury vašeho webu, identifikaci prioritního obsahu a určení, které stránky si zaslouží hlubší analýzu. Pokud je vaše sitemap kompletní a dobře organizovaná, AI systémy mohou efektivněji objevit a posoudit váš obsah pro zařazení do generovaných odpovědí. Naopak, neúplná nebo zastaralá sitemap vytváří slepá místa, kvůli kterým se AI systémy nikdy nedostanou k vašim nejdůležitějším stránkám. Dopad je přímý: stránky, které nejsou v sitemapě, mají výrazně menší šanci být citovány AI systémy, bez ohledu na jejich kvalitu nebo relevanci.

Vytvořit efektivní sitemap pro AI crawlery znamená víc než jen vypsat všechny URL vašeho webu. Sitemap by měl být strategicky sestavený a obsahovat pouze stránky, které přinášejí skutečnou hodnotu uživatelům i AI systémům. Zásadní osvědčené postupy:

Dobře strukturovaná sitemap funguje jako kvalitativní filtr a signalizuje AI systémům, že jste svůj obsah pečlivě vybrali a každá uvedená URL si zaslouží pozornost. Tento strategický přístup výrazně zvyšuje šanci na zařazení do AI odpovědí.

Aktuálnost je jedním z nejsilnějších hodnoticích faktorů v AI vyhledávacích systémech. Když AI crawlery hodnotí, které zdroje citovat v odpovědích, kladou velký důraz na čerstvost obsahu. Lastmod razítko v XML sitemapě je hlavním signálem, kdy byl váš obsah naposledy aktualizován. Zastaralá nebo chybějící razítka mohou způsobit, že i autoritativní obsah bude přiřazen nižší prioritu ve prospěch novějších zdrojů. Pokud sitemap ukazuje, že stránka nebyla několik let aktualizována, AI systémy mohou předpokládat, že informace jsou neaktuální, a zvolit raději konkurenční obsah. Naopak, přesná lastmod razítka odrážející skutečné změny signalizují AI crawlerům, že vaše informace jsou aktuální a spolehlivé. U časově citlivých témat jako ceny, regulace či trendy je udržování přesných razítek ještě důležitější. Automatizované aktualizace razítek přes CMS zajistí, že každá změna obsahu se ihned promítne do sitemapy a maximalizuje vaši viditelnost v AI odpovědích.

Zatímco sitemapy zvou crawlery k indexaci obsahu, soubory robots.txt řídí, které části webu mohou crawlery navštěvovat. Tyto dva soubory musí fungovat v souladu, aby maximalizovaly vaši AI viditelnost. Častou chybou je vytvořit komplexní sitemap a zároveň blokovat AI crawlery v robots.txt, což vede ke zmatku crawlerů a snížení vaší viditelnosti. Váš robots.txt by měl výslovně povolit hlavní AI crawlery jako GPTBot, ClaudeBot a PerplexityBot k přístupu k vašemu obsahu. Robots.txt můžete strategicky využít k blokaci pouze těch stránek, které nemají být indexovány, např. administrace, přihlašovací stránky nebo duplicitní verze obsahu. Klíčem je, aby pravidla robots.txt odpovídala strategii sitemapy—je-li stránka v sitemapě, musí být přístupná dle robots.txt. Pravidelné audity obou souborů pomáhají odhalit chyby, které mohou nenápadně omezovat vaši AI viditelnost.

Nejúčinnější AI optimalizační strategie vnímají sitemapy a strukturovaná data jako doplňkové systémy, které se navzájem posilují. Když sitemap zvýrazňuje stránku jako důležitou a tato stránka obsahuje odpovídající schéma, posíláte AI crawlerům konzistentní signály o účelu a hodnotě stránky. Například pokud vaše sitemap upřednostňuje návod, měla by tato stránka obsahovat schéma HowTo, které poskytuje strukturované informace o jednotlivých krocích. Podobně produktové stránky v sitemapě by měly obsahovat schéma Product s informacemi o ceně, dostupnosti a recenzích. Toto sladění vytváří ucelený datový obraz, kterému AI systémy snadno rozumí a důvěřují. Pokud se sitemapy a strukturovaná data rozcházejí, AI crawlery si nejsou jisté účelem stránky, což snižuje šanci na citaci. Zajištěním souladu mezi strategií sitemapy a implementací schémat vytváříte jednotný signál, který dramaticky zvyšuje šanci na zařazení do AI odpovědí.

Různé typy obsahu vyžadují různé strategie sitemap, aby byla maximalizována AI viditelnost. Blogové příspěvky, produktové stránky, popisy služeb a FAQ obsah mají různý účel a měly by být optimalizovány odpovídajícím způsobem:

| Typ obsahu | Strategie pro sitemapu | Doporučené schéma | Priority |

|---|---|---|---|

| Blogové příspěvky a články | Zahrnout s přesnými daty publikace a aktualizace | Article, NewsArticle, BlogPosting | Upřednostnit aktuální nebo evergreen obsah; pravidelně aktualizovat lastmod |

| Produktové stránky | Zahrnout s aktualizacemi skladu; zvážit samostatnou produktovou sitemapu | Product, Offer, AggregateRating | Zvýraznit nejprodávanější a nové produkty; často aktualizovat ceny |

| Stránky služeb | Zahrnout s daty aktualizace služeb | Service, LocalBusiness, ProfessionalService | Upřednostnit klíčové služby; aktualizovat dostupnost a ceny |

| FAQ stránky | Zahrnout s datem aktualizace obsahu | FAQPage, Question, Answer | Upřednostnit komplexní FAQ; aktualizovat odpovědi při změně informací |

| Video obsah | Zahrnout do video sitemapy s náhledem a délkou | VideoObject, Video | Přidat přepisy; aktualizovat počty zhlédnutí a engagement |

| Obrázkový obsah | Zahrnout do image sitemapy s popisky | ImageObject, Product (pro produktové obrázky) | Optimalizovat alt text; přidat popisné titulky |

Tento diferencovaný přístup zajistí, že každý typ obsahu dostane odpovídající optimalizaci pro AI objevení. Přizpůsobením strategie sitemap vašemu obsahovému mixu maximalizujete šanci, že AI systémy najdou a citují vaše nejhodnotnější zdroje.

Standard llms.txt, navržený koncem roku 2024, představuje experimentální způsob, jak AI systémům pomoci porozumět struktuře webu. Na rozdíl od XML sitemapy je llms.txt soubor ve formátu Markdown, který poskytuje lidsky čitelný obsahový přehled webu. Uvádí vaše nejdůležitější stránky a zdroje ve formátu, který jazykové modely snáze zpracují a pochopí. Přestože je koncept slibný, současné důkazy naznačují, že llms.txt má oproti tradičním XML sitemapám jen minimální vliv na AI viditelnost. Hlavní AI crawlery jako GPTBot a ClaudeBot stále spoléhají především na XML sitemapy pro zjištění URL a signály aktuálnosti. Místo nahrazení XML sitemapy vnímejte llms.txt jako doplňkový nástroj, který může AI systémům nabídnout další kontext. Pokud llms.txt implementujete, zajistěte, aby doplňoval a nenahrazoval vaši hlavní sitemap strategii, a nejprve se zaměřte na dokonalou XML sitemapu s přesnými razítky a strategickým výběrem obsahu.

I dobře míněné weby často dělají zásadní chyby v sitemapách, které potichu omezují jejich AI viditelnost. Pochopení a vyvarování se těchto chyb je zásadní pro maximalizaci přítomnosti v AI odpovědích:

Odstranění těchto běžných chyb může okamžitě zlepšit vaši AI viditelnost. Začněte auditem vaší současné sitemapy podle tohoto seznamu a opravte zjištěné problémy.

Udržování optimalizované sitemapy vyžaduje průběžné sledování a validaci. Několik nástrojů vám pomůže zajistit, že vaše sitemap zůstává efektivní pro AI crawlery. Google Search Console nabízí vestavěnou validaci sitemap i přehled o počtu URL indexovaných z vaší sitemapy. Screaming Frog SEO Spider umožňuje procházet celý web a porovnat výsledky se sitemapou, čímž odhalíte chybějící či neplatné URL. XML validátory kontrolují syntaxi sitemap a ověřují, že splňuje protokol XML sitemap. U větších firemních webů mají platformy jako Semrush a Ahrefs funkce analýzy sitemapy a sledují změny v čase. Pravidelné audity—ideálně měsíčně—vám umožní odhalit problémy dříve, než ovlivní vaši AI viditelnost. Nastavte si upomínky na kontrolu sitemapy vždy, když významně měníte obsah, spouštíte nové sekce nebo upravujete architekturu webu.

Pochopení, jak AI crawlery interagují s vaší sitemapou, vyžaduje aktivní monitoring a analýzu. Vaše serverové logy obsahují cenná data o tom, kteří AI crawlery váš web navštěvují, jak často jej procházejí a které stránky upřednostňují. Analýzou těchto logů můžete odhalit vzorce a optimalizovat svou sitemapu. Nástroje jako AmICited.com vám umožní sledovat, jak často je váš obsah citován AI systémy jako ChatGPT, Claude, Perplexity a Google AI Overviews, což poskytuje přímou zpětnou vazbu o efektivitě sitemapy. Google Analytics lze nastavit tak, aby sledoval referral návštěvnost z AI systémů a ukázal, které stránky generují největší AI viditelnost. Korelací těchto dat se strukturou sitemapy zjistíte, které typy obsahu a témata nejvíce rezonují s AI systémy. Tento datově řízený přístup vám umožní neustále ladit strategii sitemapy a upřednostňovat obsah, který generuje nejvíce AI citací a viditelnosti.

Kromě základní optimalizace sitemapy mohou pokročilé strategie výrazně zvýšit vaši AI viditelnost. Vytváření samostatných sitemap pro různé typy obsahu—například samostatné blogové, produktové a video sitemapy—umožní aplikovat optimalizaci specifickou pro daný typ. Dynamická generace sitemapy, kdy se sitemap aktualizuje v reálném čase při změně obsahu, zajišťuje, že AI crawlery vždy vidí nejaktuálnější obsah. U velkých firemních webů s tisíci stránkami pomáhá implementace hierarchických sitemap a strategické prioritizace zaměřit AI crawlery na nejcennější obsah. Některé organizace vytvářejí AI-specifické sitemapy, které zvýrazňují pouze stránky s nejvyšší autoritou a hodnotou pro citace, čímž dávají AI systémům jasně najevo, které stránky si zaslouží prioritu. Integrace strategie sitemapy s CMS zajistí, že optimalizace probíhá automaticky a nevyžaduje ruční zásahy. Tyto pokročilé přístupy vyžadují více technických znalostí, ale mohou přinést výrazné zlepšení AI viditelnosti u složitých obsahových ekosystémů.

Krajina AI crawlerů se rychle vyvíjí, vznikají noví crawlery a standardy jako llms.txt získávají na popularitě. Budování odolné strategie sitemapy znamená vnést do systémů flexibilitu a sledovat vývoj v oboru. Implementujte generování sitemap, které snadno přizpůsobíte novým požadavkům crawlerů bez nutnosti manuálního přepracování. Sledujte oznámení hlavních AI firem o nových crawlerech a aktualizujte podle toho svůj robots.txt i strategii sitemapy. Zvažte dlouhodobou hodnotu AI viditelnosti oproti kontrole nad obsahem—zatímco některé organizace se rozhodnou AI crawlery blokovat, trend ukazuje, že AI citace budou čím dál důležitější pro zviditelnění značky. Vytvořte jasné zásady, jak bude vaše organizace řídit přístup AI crawlerů a využití obsahu. Pokud budete k sitemapě přistupovat jako k živému dokumentu, který se vyvíjí s AI prostředím, zajistíte, že váš obsah zůstane snadno objevitelný a citovatelný i s další transformací vyhledávání a objevování.

Sitemap byste měli aktualizovat vždy, když publikujete nový obsah nebo provádíte významné změny na existujících stránkách. Ideálně implementujte automatizovanou generaci sitemap, aby se aktualizace prováděly ihned. U webů s častými změnami obsahu jsou doporučeny denní aktualizace, u statických webů postačí měsíční kontrola.

Většina hlavních AI crawlerů jako GPTBot a ClaudeBot respektuje pravidla robots.txt, ale ne všechny. Nejlepší praxí je výslovně povolit AI crawlery ve vašem robots.txt, místo spoléhání se na výchozí chování. Sledujte své serverové logy, abyste ověřili, že crawlery se chovají dle očekávání.

XML sitemapy jsou strojově čitelné soubory, které uvádějí všechny vaše URL s metadaty, jako jsou lastmod časová razítka. llms.txt je novější standard založený na Markdownu, který má poskytnout AI systémům lidsky čitelný obsahový přehled. V současnosti jsou pro AI viditelnost důležitější XML sitemapy, zatímco llms.txt je spíše doplňkový.

Zkontrolujte své serverové logy na uživatelské agenty jako 'GPTBot', 'ClaudeBot', 'PerplexityBot' a 'Google-Extended'. Můžete také využít nástroje jako AmICited.com k monitorování, jak často je váš obsah citován AI systémy, což značí úspěšné procházení a indexaci.

Ano, vytvořením samostatných sitemap pro blogy, produkty, videa a obrázky můžete aplikovat optimalizační strategie specifické pro daný typ obsahu. To také pomáhá AI crawlerům lépe porozumět struktuře vašeho obsahu a může zlepšit efektivitu procházení u rozsáhlých webů.

XML sitemap by měl obsahovat maximálně 50 000 URL na soubor. U větších webů použijte indexy sitemap k organizaci více souborů. AI crawlery zvládnou velké sitemapy, ale rozdělení do logických sekcí zlepšuje efektivitu procházení a usnadňuje správu.

Lastmod časová razítka signalizují AI crawlerům aktuálnost obsahu. Novost je silný hodnoticí faktor v AI systémech, takže přesná časová razítka pomáhají vašemu obsahu soutěžit o citace. Vždy používejte automatické systémy pro aktualizaci razítek pouze při skutečné změně obsahu—nikdy nenastavujte falešná razítka ručně.

Ano, špatně udržovaný sitemap může výrazně poškodit vaši AI viditelnost. Neplatné odkazy, zastaralé URL, nepřesná časová razítka a neúplné pokrytí snižují šanci, že vás AI systémy budou citovat. Pravidelné audity a údržba jsou zásadní pro ochranu vaší AI viditelnosti.

Sledujte, jak často je váš obsah citován ChatGPT, Claude, Perplexity a Google AI Overviews. Optimalizujte svou strategii sitemap na základě skutečných dat o AI citacích.

Kompletní průvodce AI crawlery a boty. Identifikujte GPTBot, ClaudeBot, Google-Extended a dalších 20+ AI crawlerů podle user agentů, rychlostí procházení a stra...

Objevte klíčové technické SEO faktory ovlivňující vaši viditelnost v AI vyhledávačích jako ChatGPT, Perplexity a Google AI Mode. Zjistěte, jak rychlost načítání...

Zjistěte, jak povolit AI botům jako GPTBot, PerplexityBot a ClaudeBot procházet váš web. Nastavte robots.txt, vytvořte llms.txt a optimalizujte svůj web pro AI ...

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.