Kontextové okno

Vysvětlení kontextového okna: maximální počet tokenů, které LLM dokáže najednou zpracovat. Zjistěte, jak kontextová okna ovlivňují přesnost AI, halucinace a mon...

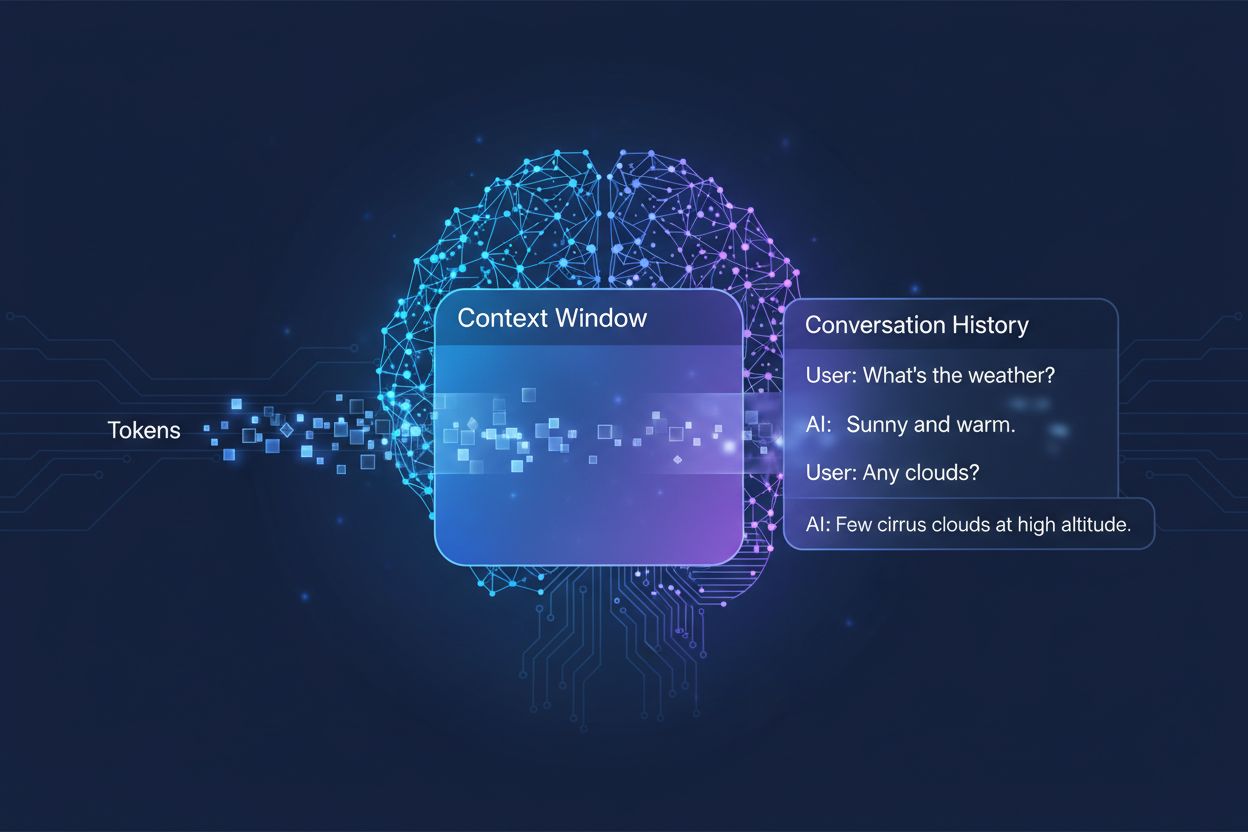

Množství předchozí konverzace, které AI systém zohledňuje při generování odpovědí, měřené v tokenech. Určuje, kolik textu dokáže AI zpracovat najednou, a přímo ovlivňuje kvalitu a soudržnost jejích výstupů v rámci víceotáčkových konverzací.

Množství předchozí konverzace, které AI systém zohledňuje při generování odpovědí, měřené v tokenech. Určuje, kolik textu dokáže AI zpracovat najednou, a přímo ovlivňuje kvalitu a soudržnost jejích výstupů v rámci víceotáčkových konverzací.

Kontextové okno je maximální množství textu, které může AI jazykový model během konverzace nebo úlohy najednou zpracovat a brát v potaz. Lze si jej představit jako pracovní paměť modelu—stejně jako lidé mohou mít v bezprostředním povědomí jen omezené množství informací, i AI modely dokážou „vidět“ jen určité množství textu před a za aktuální pozicí. Tato kapacita se měří v tokenech, což jsou malé jednotky textu, které obvykle představují slova nebo jejich části (v průměru jedno anglické slovo odpovídá přibližně 1,5 tokenu). Porozumění kontextovému oknu vašeho modelu je zásadní, protože přímo určuje, kolik informací může AI při generování odpovědí zohlednit, což je základní omezení efektivity modelu při zvládání složitých, víceotáčkových konverzací nebo rozsáhlých dokumentů.

Moderní jazykové modely, zejména architektury založené na transformerech, zpracovávají text převodem na tokeny a následnou analýzou vztahů mezi všemi tokeny uvnitř kontextového okna najednou. Transformer architektura, představená v přelomovém článku z roku 2017 „Attention is All You Need“, využívá mechanismus zvaný self-attention k určení, které části vstupu jsou pro sebe navzájem nejrelevantnější. Tento attention mechanismus umožňuje modelu vážit důležitost jednotlivých tokenů vůči sobě a chápat kontext a význam v rámci celého okna. Tento proces je však s rostoucím kontextovým oknem výpočetně náročný, protože attention mechanismus musí počítat vztahy mezi každým tokenem a všemi ostatními—jde o problém kvadratického škálování. Následující tabulka ukazuje, jak si různé přední AI modely vedou z hlediska schopností kontextových oken:

| Model | Kontextové okno (tokeny) | Datum vydání |

|---|---|---|

| GPT-4 | 128 000 | březen 2023 |

| Claude 3 Opus | 200 000 | březen 2024 |

| Gemini 1.5 Pro | 1 000 000 | květen 2024 |

| GPT-4 Turbo | 128 000 | listopad 2023 |

| Llama 2 | 4 096 | červenec 2023 |

Tyto odlišné kapacity odrážejí různé konstrukční volby a výpočetní kompromisy každé organizace; větší okna umožňují sofistikovanější aplikace, ale vyžadují více výpočetního výkonu.

Cesta k větším kontextovým oknům představuje jeden z nejzásadnějších pokroků v možnostech AI za poslední dekádu. Rané rekurentní neuronové sítě (RNN) a dlouhodobá krátkodobá paměť (LSTM) měly s kontextem potíže, protože text zpracovávaly sekvenčně a těžko si udržovaly informace z vzdálenějších částí vstupu. Průlom přišel v roce 2017 s představením transformerové architektury, která umožnila paralelní zpracování celých sekvencí a zásadně zlepšila schopnost modelu udržet kontext u delších textů. Na tomto základě vznikl GPT-2 v roce 2019 s impozantními možnostmi generování textu a kontextovým oknem o velikosti 1 024 tokenů, následovaný GPT-3 v roce 2020 s 2 048 tokeny a nakonec GPT-4 v roce 2023 se 128 000 tokeny. Každý tento pokrok byl důležitý, protože rozšířil možnosti modelů: větší okna znamenala, že modely zvládnou delší dokumenty, udrží soudržnost v rámci víceotáčkových konverzací a rozpoznají jemné vztahy mezi vzdálenými koncepty v textu. Exponenciální růst velikostí kontextových oken odráží jak inovace v architektuře, tak zvýšenou dostupnost výpočetních prostředků v předních AI laboratořích.

Větší kontextová okna zásadně rozšiřují možnosti AI modelů a umožňují aplikace, které byly dříve nemožné nebo velmi omezené. Klíčové výhody:

Zlepšená kontinuita konverzace: Modely si udrží povědomí o celé historii konverzace, není nutné opakovaně vysvětlovat kontext a dialogy jsou přirozenější a soudržnější místo roztříštěných.

Zpracování dokumentů ve velkém rozsahu: Větší okna umožňují AI analyzovat celé dokumenty, vědecké práce či kód v jednom kroku, hledat vzory a vztahy v celém obsahu bez ztráty informací z předchozích částí.

Lepší schopnosti uvažování a analýzy: S větším množstvím kontextu dokážou modely provádět složitější úkoly vyžadující pochopení vztahů mezi více koncepty, což je činí účinnějšími pro výzkum, analýzu a řešení komplexních problémů.

Snížení režie přepínání kontextu: Uživatelé už nemusí modelu opakovaně shrnovat nebo znovu předkládat informace; model pracuje s celou historií konverzace, což snižuje tření a zvyšuje efektivitu spolupráce.

Lepší zvládání nuancovaných úloh: Aplikace jako právní revize dokumentů, analýza zdravotnických záznamů a kontrola kódu výrazně těží ze schopnosti zohlednit kompletní kontext, což vede k přesnějším a důkladnějším výsledkům.

Bezproblémové workflovy s více dokumenty: Profesionálové mohou pracovat s více souvisejícími dokumenty najednou, model dokáže informace provazovat a odhalovat souvislosti, které by u menších kontextových oken nebyly možné.

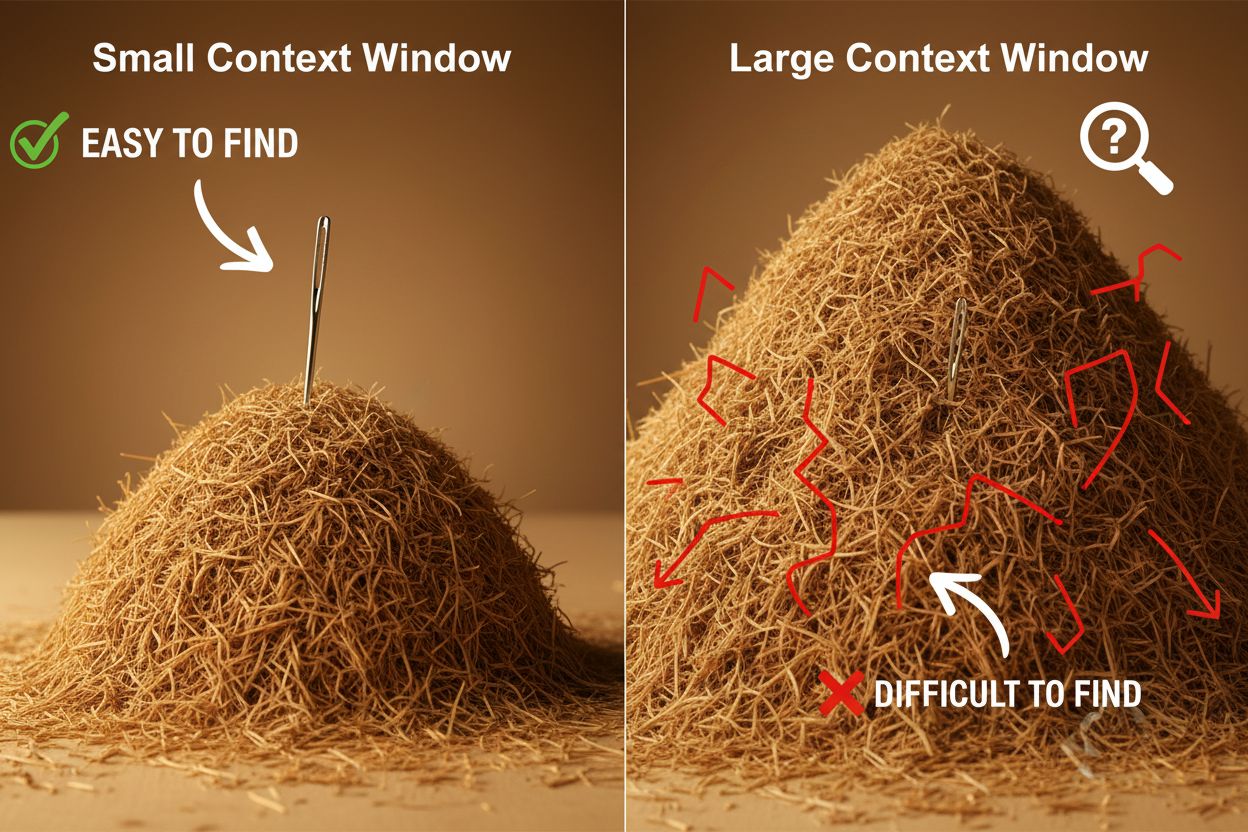

Navzdory výhodám přinášejí velká kontextová okna významné technické i praktické výzvy, kterým musí vývojáři a uživatelé čelit. Nejzřejmější je výpočetní náročnost: zpracování delších sekvencí vyžaduje exponenciálně více paměti a výkonu kvůli kvadratickému škálování attention mechanismu, což znamená, že větší kontextová okna jsou mnohem dražší na provoz. Vyšší výpočetní náročnost také způsobuje zpoždění (latenci), protože delší kontextová okna znamenají pomalejší odpovědi—a to je kritické pro aplikace, kde uživatelé očekávají rychlé reakce. Dalším méně očividným, avšak důležitým problémem je jev „jehly v kupce sena“, kdy má model potíže najít a využít relevantní informaci, pokud je schovaná ve velmi velkém kontextovém okně, a někdy si vede hůř než s menším oknem. K tomu se přidává i context rot, kdy informace ze začátku dlouhého kontextového okna mají na výstup modelu čím dál menší vliv, protože attention mechanismus dává přednost novějším tokenům. Tyto výzvy znamenají, že prosté maximalizování velikosti kontextového okna není vždy optimálním řešením pro každý případ použití.

Porozumění jevu context rot je klíčové pro efektivní práci s velkými kontextovými okny: jak sekvence narůstají, tokeny na začátku kontextu mají tendenci mít stále menší vliv na výstup modelu, což znamená, že důležité informace mohou být fakticky „zapomenuty“, i když jsou technicky stále v okně. Děje se to proto, že attention budget—kapacita modelu věnovat se všem tokenům—je rozprostřena na delší úsek textu. Naštěstí existuje několik sofistikovaných technik, které tato omezení řeší. Retrieval-Augmented Generation (RAG) ukládá informace do externích databází a načítá jen ty nejrelevantnější v daný okamžik, čímž efektivně rozšiřuje znalostní základnu modelu bez potřeby masivního kontextového okna. Context compaction techniky shrnují nebo komprimují méně důležité informace a zachovávají ty nejpodstatnější, čímž šetří tokeny. Strukturované poznámky motivují uživatele k hierarchickému uspořádání informací, což modelu usnadňuje prioritizaci a nalezení klíčových konceptů. Tato řešení jsou strategická v tom, co se do kontextového okna dostane a jak je to organizováno, místo snahy vtěsnat do paměti vše najednou.

Rozšířená kontextová okna moderních AI modelů umožnila mnoho reálných aplikací, které byly dříve nepraktické nebo nemožné. Zákaznická podpora dnes může v jednom požadavku projít celou historii ticketu i s relevantní dokumentací, což umožňuje přesnější a kontextuálně vhodné odpovědi bez nutnosti, aby zákazník opakovaně vysvětloval svou situaci. Analýza dokumentů a výzkum se změnily díky modelům, které zvládnou nahrát celé vědecké práce, smlouvy nebo technické specifikace, najít klíčové informace a odpovídat na detailní dotazy k obsahu, jehož přečtení by lidem trvalo hodiny. Kontrola kódu a vývoj software těží z kontextových oken dost velkých na to, aby pojmuly celé soubory nebo i více navazujících souborů, což AI umožňuje chápat architektonické vzory a dávat inteligentnější návrhy. Tvorba dlouhých textů a iterativní psaní jsou efektivnější, když model udrží přehled o tónu, stylu a dějové linii celého dokumentu během editace. Analýza přepisů schůzek a syntéza výzkumu využívají velká kontextová okna k extrakci postřehů z hodin konverzací nebo desítek zdrojových dokumentů, čímž odhalují témata a propojení, která by bylo těžké manuálně najít. Tyto aplikace ukazují, že velikost kontextového okna má přímý dopad na praktickou hodnotu pro profesionály napříč odvětvími.

Vývoj kontextových oken naznačuje, že v blízké budoucnosti dojde k dalším dramatickým rozšířením; Gemini 1.5 Pro již nabízí kontextové okno o velikosti 1 000 000 tokenů a výzkumné laboratoře zkoumají ještě větší kapacity. Budoucnost však není jen o velikosti—pravděpodobně půjde i o dynamická kontextová okna, která budou inteligentně přizpůsobovat svoji velikost podle úkolu, přidělí víc kapacity u složitějších dotazů a méně u jednodušších, což zlepší efektivitu a sníží náklady. Výzkumníci také pracují na efektivnějších attention mechanismech, které sníží výpočetní náročnost větších oken a mohou prolomit kvadratickou bariéru škálování, která dnes velikost limituje. Jak tyto technologie dozrávají, lze očekávat, že kontextová okna přestanou být omezením a stanou se vyřešeným problémem, což vývojářům umožní soustředit se na další aspekty schopností a spolehlivosti AI. Další generaci AI aplikací bude pravděpodobně určovat spojení větších oken, lepší efektivity a chytřejší správy kontextu, což umožní případy použití, které si zatím ani nedokážeme představit.

Kontextové okno je celkové množství textu (měřené v tokenech), které může AI model najednou zpracovat, zatímco limit tokenů označuje maximální počet tokenů, které model zvládne. Tyto pojmy se často zaměňují, ale kontextové okno konkrétně označuje pracovní paměť dostupnou během jednoho inferenčního kroku, zatímco limit tokenů může zahrnovat i omezení výstupu nebo limity využití API.

Větší kontextová okna obecně zlepšují kvalitu odpovědí tím, že modelu umožňují zohlednit více relevantních informací a lépe udržet kontinuitu konverzace. Extrémně velká okna však mohou někdy kvalitu zhoršit kvůli jevu 'context rot', kdy má model problém určit důležitost informací v obrovském množství textu. Optimální velikost kontextového okna závisí na konkrétním úkolu a organizaci informací.

Větší kontextová okna vyžadují více výpočetního výkonu kvůli kvadratickému škálování attention mechanismu v transformer modelech. Attention mechanismus musí vypočítat vztahy mezi každým tokenem a všemi ostatními, takže zdvojnásobení kontextového okna zhruba zčtyřnásobí výpočetní náročnost. Proto jsou větší kontextová okna dražší na provoz a způsobují pomalejší odezvu.

Problém 'jehly v kupce sena' nastává, když má AI model potíže najít a využít relevantní informaci ('jehlu'), která je ukryta v obrovském kontextovém okně ('kupce sena'). Modely někdy podávají horší výkony s extrémně velkými kontextovými okny, protože jejich attention mechanismus se rozptýlí mezi příliš mnoho informací, což ztěžuje identifikaci toho, co je skutečně důležité.

Pro maximalizaci efektivity kontextového okna organizujte informace přehledně a hierarchicky, umisťujte nejdůležitější informace na začátek nebo konec kontextu, používejte strukturované formáty jako JSON nebo markdown a zvažte použití Retrieval-Augmented Generation (RAG) pro dynamické načítání nejrelevantnějších informací. Vyhněte se zahlcení modelu nerelevantními detaily, které spotřebovávají tokeny bez přidané hodnoty.

Kontextové okno je technická kapacita modelu pro zpracování textu najednou, zatímco historie konverzace je skutečný záznam předchozích zpráv v konverzaci. Historie konverzace se musí vejít do kontextového okna, ale kontextové okno zahrnuje také místo pro systémové prompty, instrukce a další metadata. Historie konverzace může být delší než kontextové okno, což vyžaduje shrnutí nebo zkrácení.

Žádné AI modely v současnosti nemají skutečně neomezená kontextová okna, protože všechny mají architektonická a výpočetní omezení. Některé modely jako Gemini 1.5 Pro však nabízejí extrémně velká okna (1 000 000 tokenů) a techniky jako Retrieval-Augmented Generation (RAG) mohou efektivně rozšířit znalostní bázi modelu za hranice kontextového okna dynamickým načítáním informací podle potřeby.

Velikost kontextového okna přímo ovlivňuje náklady na API, protože větší okna vyžadují více výpočetních prostředků ke zpracování. Většina poskytovatelů AI API účtuje podle spotřeby tokenů, takže použití většího kontextového okna znamená více zpracovaných tokenů a vyšší náklady. Někteří poskytovatelé také účtují prémiové sazby za modely s většími kontextovými okny, proto je důležité zvolit správnou velikost modelu pro vaše konkrétní potřeby.

AmICited sleduje, jak AI systémy jako ChatGPT, Perplexity a Google AI Overviews citují a odkazují na váš obsah. Zjistěte, jaká je vaše viditelnost v AI a monitorujte zmínky o vaší značce napříč AI platformami.

Vysvětlení kontextového okna: maximální počet tokenů, které LLM dokáže najednou zpracovat. Zjistěte, jak kontextová okna ovlivňují přesnost AI, halucinace a mon...

Zjistěte, co jsou kontextová okna v jazykových modelech AI, jak fungují, jaký mají dopad na výkon modelu a proč jsou důležitá pro AI aplikace a monitoring....

Diskuze komunity o kontextových oknech AI a jejich dopadu na obsahový marketing. Porozumění tomu, jak limity kontextu ovlivňují zpracování vašeho obsahu AI....

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.