AI Crawl Analytics

Zjistěte, co je AI crawl analytics a jak analýza serverových logů sleduje chování AI crawlerů, vzorce přístupu k obsahu a viditelnost na AI poháněných vyhledáva...

Analýza logovacích souborů je proces zkoumání serverových přístupových logů za účelem porozumění tomu, jak se prohledávače vyhledávačů a AI boti chovají na webu, což odhaluje vzory procházení, technické problémy a příležitosti k optimalizaci pro SEO výkon.

Analýza logovacích souborů je proces zkoumání serverových přístupových logů za účelem porozumění tomu, jak se prohledávače vyhledávačů a AI boti chovají na webu, což odhaluje vzory procházení, technické problémy a příležitosti k optimalizaci pro SEO výkon.

Analýza logovacích souborů je systematické zkoumání serverových přístupových logů za účelem pochopení, jak prohledávače vyhledávačů, AI boti a uživatelé interagují s webovou stránkou. Tyto logy jsou automaticky generovány webovým serverem a obsahují detailní záznamy o každém HTTP požadavku na váš web, včetně IP adresy požadovatele, časového razítka, požadované URL, HTTP status kódu a user-agent řetězce. Pro SEO specialisty slouží analýza logovacích souborů jako definitivní zdroj pravdy o chování crawlerů a odhaluje vzorce, které povrchové nástroje jako Google Search Console nebo tradiční crawlery nemohou zachytit. Na rozdíl od simulovaných crawlů nebo agregovaných analytických dat poskytují serverové logy nefiltrovaný, prvotní důkaz o tom, co přesně vyhledávače a AI systémy na vašem webu v reálném čase dělají.

Význam analýzy logovacích souborů exponenciálně vzrostl s vývojem digitálního prostředí. S více než 51 % globální internetové návštěvnosti generované roboty (ACS, 2025) a s tím, jak se AI crawlery jako GPTBot, ClaudeBot a PerplexityBot stávají běžnými návštěvníky webů, není pochopení chování crawlerů volitelné – je nezbytné pro udržení viditelnosti v tradičním i nově vznikajícím AI vyhledávání. Analýza logovacích souborů překlenuje mezeru mezi tím, co si myslíte, že se na vašem webu děje, a tím, co se skutečně děje, a umožňuje datově podložená rozhodnutí, která přímo ovlivňují pozice ve vyhledávání, rychlost indexace a celkový organický výkon.

Analýza logovacích souborů je pilířem technického SEO po celá desetiletí, ale její význam v posledních letech dramaticky vzrostl. Historicky se SEO specialisté spolehli především na Google Search Console a nástroje třetích stran pro pochopení chování vyhledávačů. Tyto nástroje však mají zásadní omezení: Google Search Console poskytuje pouze agregovaná, vzorkovaná data od crawlerů Googlu; crawlery třetích stran pouze simulují chování crawlerů místo skutečných interakcí; a žádný z těchto nástrojů efektivně nesleduje ne-Google vyhledávače nebo AI boty.

Vzestup AI vyhledávacích platforem zásadně změnil krajinu. Podle výzkumu Cloudflare z roku 2024 Googlebot tvoří 39 % veškeré AI a vyhledávací crawler návštěvnosti, zatímco AI-specific crawlery jsou nyní nejrychleji rostoucím segmentem. Jen AI boti od Meta generují 52 % AI crawler návštěvnosti, což je více než dvojnásobek oproti Google (23 %) či OpenAI (20 %). To znamená, že weby nyní navštěvují desítky různých typů botů, z nichž mnozí nerespektují tradiční SEO pravidla ani robots.txt. Analýza logovacích souborů je jedinou metodou, která zachytí kompletní obraz, takže je nepostradatelná pro moderní SEO strategii.

Globální trh správy logů má podle prognóz vzrůst z 3 228,5 milionu USD v roce 2025 na výrazně vyšší hodnoty do roku 2029 při složené roční míře růstu (CAGR) 14,6 %. Tento růst odráží rostoucí uznání podniku, že analýza logů je zásadní pro bezpečnost, monitoring výkonu i SEO optimalizaci. Organizace masivně investují do automatizovaných nástrojů pro analýzu logů a AI platforem, které dokážou v reálném čase zpracovávat miliony záznamů a měnit surová data v akční poznatky s přímým dopadem na byznys.

Když uživatel nebo bot požádá o stránku na vašem webu, webový server tento požadavek zpracuje a zaznamená podrobné informace o interakci. Tento proces probíhá automaticky a kontinuálně, čímž vzniká komplexní auditní stopa veškeré serverové aktivity. Pochopení tohoto procesu je klíčové pro správnou interpretaci dat z logovacích souborů.

Typický průběh začíná tím, že crawler (ať už Googlebot, AI bot, nebo uživatelský prohlížeč) odešle HTTP GET požadavek na váš server, včetně user-agent řetězce identifikujícího požadovatele. Server požadavek přijme, zpracuje a vrátí HTTP status kód (200 pro úspěch, 404 pro nenalezeno, 301 pro trvalé přesměrování atd.) společně s požadovaným obsahem. Každá taková interakce je zaznamenána do přístupového logu serveru jako záznam s časovým razítkem, IP adresou, požadovanou URL, HTTP metodou, status kódem, velikostí odpovědi, referrerem a user-agent řetězcem.

HTTP status kódy jsou pro SEO analýzu obzvlášť důležité. Kód 200 značí úspěšné doručení stránky; 3xx značí přesměrování; 4xx značí chyby na straně klienta (např. 404 Nenalezeno); 5xx značí chyby serveru. Analýzou rozložení těchto kódů v logech lze odhalit technické problémy bránící crawlerům v přístupu k obsahu. Například pokud crawler opakovaně dostává odpověď 404 na důležité stránky, jde o signál rozbitého odkazu či chybějícího obsahu vyžadující okamžitou nápravu.

User-agent řetězce jsou stejně důležité pro identifikaci, kteří boti váš web navštěvují. Každý crawler má jedinečný user-agent řetězec. Googlebot například obsahuje “Googlebot/2.1”, GPTBot “GPTBot/1.0” a ClaudeBot “ClaudeBot”. Rozborem těchto řetězců můžete segmentovat logy podle typu crawleru a zjistit, které boty upřednostňují jaký obsah a jak se jejich vzorce procházení liší. Takto detailní analýza umožňuje cílenou optimalizaci pro různé vyhledávače a AI systémy.

| Aspekt | Analýza logovacích souborů | Google Search Console | Crawlery třetích stran | Analytické nástroje |

|---|---|---|---|---|

| Zdroj dat | Serverové logy (prvotní data) | Data o crawlování od Googlu | Simulované crawlery | Sledování chování uživatelů |

| Kompletnost | 100 % všech požadavků | Vzorkovaná, agregovaná data | Pouze simulace | Jen lidská návštěvnost |

| Pokrytí botů | Všichni crawlery (Google, Bing, AI boti) | Pouze Google | Simulované crawlery | Žádná data o botech |

| Historická data | Plná historie (dle uchování) | Omezený časový rozsah | Jednorázový crawl | Historie dostupná |

| Reálný čas | Ano (automatizací) | Zpožděné reporty | Ne | Zpožděné reporty |

| Viditelnost crawl budgetu | Přesné vzorce procházení | Vysoká úroveň, souhrny | Odhadované | Nepoužitelné |

| Technické problémy | Detailní (status kódy, odezvy) | Omezená viditelnost | Simulované problémy | Nepoužitelné |

| Sledování AI botů | Ano (GPTBot, ClaudeBot, atd.) | Ne | Ne | Ne |

| Cena | Zdarma (serverové logy) | Zdarma | Placené nástroje | Zdarma/Placené |

| Složitost nastavení | Střední až vysoká | Jednoduché | Jednoduché | Jednoduché |

Analýza logovacích souborů je dnes nepostradatelná pro pochopení interakce vyhledávačů a AI systémů s vaším webem. Na rozdíl od Google Search Console, která poskytuje pouze pohled Googlu a agregovaná data, logy zachycují kompletní obraz veškeré crawler aktivity. Tento komplexní pohled je zásadní pro identifikaci plýtvání crawl budgetem, kdy vyhledávače tráví čas na málo hodnotných stránkách místo klíčového obsahu. Výzkumy ukazují, že velké weby často promrhají 30–50 % crawl budgetu na nevýznamné URL jako stránkované archivy, faceted navigace nebo zastaralý obsah.

Vzestup AI vyhledávání dělá z analýzy logovacích souborů ještě kritičtější nástroj. Jak se AI boti typu GPTBot, ClaudeBot a PerplexityBot stávají pravidelnými návštěvníky webů, je pochopení jejich chování klíčové pro optimalizaci viditelnosti ve výsledcích AI. Tyto boty se často chovají jinak než tradiční crawlery – mohou ignorovat robots.txt, procházet agresivněji nebo se zaměřovat na specifické typy obsahu. Analýza logovacích souborů jediná tyto vzorce odhalí a umožní vám optimalizovat web pro AI i řídit přístup botů cílenými pravidly.

Technické SEO problémy, které by jinak zůstaly skryté, lze odhalit právě v logech. Řetězení přesměrování, chyby serveru 5xx, pomalé načítání stránek či problémy s vykreslováním JavaScriptu – to vše zanechává stopy v serverových logech. Analýzou těchto vzorců můžete upřednostnit opravy s přímým dopadem na dostupnost a indexaci ve vyhledávačích. Například pokud logy ukazují, že Googlebot opakovaně dostává chybu 503 při procházení určité sekce webu, víte přesně, kde zaměřit technické úsilí.

Získání serverových logů je prvním krokem, ale postup se liší podle hostingu. Na vlastních serverech s Apache nebo NGINX jsou logy obvykle ve /var/log/apache2/access.log nebo /var/log/nginx/access.log. K těmto souborům se dostanete přes SSH nebo správce souborů vašeho serveru. U spravovaných WordPress hostingů jako WP Engine či Kinsta jsou logy k dispozici v administračním rozhraní hostingu nebo přes SFTP, některé služby ale přístup omezují kvůli výkonu.

Content Delivery Networks (CDN) jako Cloudflare, AWS CloudFront či Akamai vyžadují speciální nastavení pro získání logů. Cloudflare nabízí Logpush, který posílá HTTP logy do úložiště (AWS S3, Google Cloud Storage, Azure Blob Storage) pro další analýzu. AWS CloudFront umožňuje standardní logování do S3 bucketů. Tyto CDN logy jsou zásadní pro pochopení chování botů při distribuci obsahu přes CDN, protože zachycují požadavky na hraně, nikoliv jen na původním serveru.

U sdíleného hostingu je přístup k logům často omezený. Poskytovatelé jako Bluehost nebo GoDaddy nabízejí částečné logy přes cPanel, které se často rotačně přepisují a mohou postrádat důležitá pole. Pokud potřebujete plnou analýzu logů a jste na sdíleném hostingu, zvažte upgrade na VPS nebo spravovaný hosting s plným přístupem k logům.

Po získání logů je důležitá jejich příprava. Surové logovací soubory obsahují požadavky od všech – uživatelů, botů, scraperů i škodlivých aktérů. Pro SEO analýzu je třeba odfiltrovat nerelevantní provoz a zaměřit se na aktivitu vyhledávačů a AI botů. Typicky to znamená:

Analýza logovacích souborů odkrývá poznatky, které jiné SEO nástroje neukážou, a tvoří základ pro strategická optimalizační rozhodnutí. Jedním z nejcennějších je analýza vzorců procházení, která ukazuje, které stránky vyhledávače navštěvují a jak často. Sledováním četnosti crawlů v čase zjistíte, zda Google zvyšuje nebo snižuje pozornost u konkrétních sekcí webu. Náhlý pokles crawl frekvence může znamenat technický problém nebo snížení důležitosti stránky, zatímco nárůst značí pozitivní reakci na optimalizaci.

Efektivita crawl budgetu je další zásadní poznatek. Analýzou poměru úspěšných (2xx) odpovědí vůči chybám (4xx, 5xx) identifikujete sekce webu, kde crawlery naráží na problémy. Pokud určitý adresář stabilně vrací chyby 404, plýtvá se crawl budgetem na rozbité odkazy. Podobně, pokud crawleři tráví nepřiměřeně mnoho času na stránkovaných URL nebo faceted navigaci, plýtvá se rozpočtem na málo hodnotný obsah. Analýza logů toto kvantifikuje a umožňuje spočítat potenciální dopad optimalizace.

Objevování osiřelých stránek je unikátní výhodou analýzy logovacích souborů. Osiřelé stránky jsou URL bez interních odkazů, které existují mimo strukturu webu. Tradiční crawlery je často nenajdou, protože je neobjeví přes interní prolinkování. Logy však odhalí, že je vyhledávače přesto procházejí – často proto, že na ně vedou externí odkazy nebo jsou v zastaralých sitemapách. Identifikací těchto stránek můžete rozhodnout, zda je začlenit, přesměrovat nebo odstranit.

Analýza chování AI botů je stále důležitější. Segmentací logů podle user-agentů AI botů zjistíte, jaký obsah upřednostňují, jak často navštěvují váš web a zda narážejí na technické překážky. Například když GPTBot pravidelně crawlí vaše FAQ stránky, ale blog téměř nenavštěvuje, znamená to, že AI systémy považují FAQ obsah za hodnotnější pro tréninková data. Tento poznatek může ovlivnit vaši obsahovou strategii a pomoci optimalizovat web pro AI viditelnost.

Úspěšná analýza logovacích souborů vyžaduje správné nástroje i strategický přístup. Log File Analyzer od Screaming Frog je jedním z nejpopulárnějších specializovaných nástrojů – nabízí přehledné rozhraní pro zpracování velkých logů, identifikaci bot vzorců a vizualizaci dat o crawlerech. Botify poskytuje podnikovou analýzu logů integrovanou s SEO metrikami a umožňuje korelovat aktivitu botů s pozicemi a návštěvností. Bot Clarity od seoClarity integruje analýzu logů přímo do SEO platformy, což usnadňuje propojení crawler dat s dalšími SEO metrikami.

Pro organizace s vysokou návštěvností nebo složitou infrastrukturou nabízejí AI platformy pro analýzu logů jako Splunk, Sumo Logic a Elastic Stack pokročilé možnosti – automatizované rozpoznávání vzorců, detekci anomálií i prediktivní analytiku. Tyto platformy zvládají v reálném čase zpracovat miliony záznamů a automaticky identifikovat nové typy botů či neobvyklou aktivitu, která může značit bezpečnostní hrozby nebo technické problémy.

Osvědčené postupy při analýze logovacích souborů zahrnují:

S rostoucím významem AI vyhledávání je monitoring AI botů prostřednictvím analýzy logovacích souborů klíčovou SEO funkcí. Sledováním, kteří AI boti váš web navštěvují, jaký obsah procházejí a jak často, pochopíte, jak se váš obsah dostává do AI vyhledávacích nástrojů a generativních AI modelů. Tato data vám umožní rozhodnout, zda a jak konkrétním AI botům povolíte, zablokujete nebo omezíte přístup pomocí robots.txt nebo HTTP hlaviček.

Optimalizace crawl budgetu je možná nejvýznamnější aplikací analýzy logovacích souborů. U velkých webů s tisíci či miliony stránek je crawl budget omezený zdroj. Analýzou logů zjistíte stránky, které jsou procházeny nepřiměřeně často vzhledem ke své důležitosti, i stránky, které by se měly procházet častěji, ale nejsou. Typické scénáře plýtvání crawl budgetem zahrnují:

Řešením těchto problémů – úpravou robots.txt, kanonizací, noindex tagy nebo technickými zásahy – můžete přesunout crawl budget na hodnotný obsah a zlepšit rychlost indexace i viditelnost stránek klíčových pro byznys.

Budoucnost analýzy logovacích souborů je formována rychlým vývojem AI vyhledávání. Jak do ekosystému vstupuje více AI botů a jejich chování se sofistikuje, analýza logů bude ještě zásadnější pro pochopení, jak je váš obsah objevován, zpřístupňován a využíván AI systémy. Mezi nastupující trendy patří:

Analýza logů v reálném čase poháněná strojovým učením umožní SEO specialistům detekovat a reagovat na crawl problémy během minut místo dnů. Automatizované systémy budou identifikovat nové typy botů, signalizovat neobvyklé vzorce a navrhovat optimalizační kroky bez manuálního zásahu. Tento posun od reaktivní k proaktivní analýze umožní trvale udržovat optimální crawlabilitu a indexaci.

Integrace se sledováním viditelnosti v AI propojí logovací data s metrikami výkonu v AI vyhledávání. SEO specialisté budou místo izolované analýzy logů korelovat chování crawlerů se skutečnou viditelností ve výsledcích generovaných AI a přesně chápat, jak crawl vzorce ovlivňují pozice v AI vyhledávání. Tato integrace nabídne bezprecedentní vhled do toho, jak obsah putuje od crawlů přes AI tréninková data až po odpovědi uživatelům.

Etické řízení botů bude stále důležitější, protože organizace budou řešit, kterým AI botům umožnit přístup k obsahu. Analýza logovacích souborů umožní detailní kontrolu přístupu botů, takže vydavatelé mohou povolit užitečné AI crawlery a blokovat ty, které nepřinášejí hodnotu či přisuzování. Standardy jako vznikající LLMs.txt protokol poskytnou strukturovaný způsob komunikace přístupových politik a logy ověří jejich dodržování.

Analýza s ochranou soukromí se bude vyvíjet tak, aby vyvážila potřebu detailních crawl poznatků s předpisy jako GDPR. Pokročilé anonymizační techniky a nástroje zaměřené na ochranu soukromí umožní organizacím získat cenné poznatky z logů bez uchovávání či odhalování osobních údajů. To bude důležité zejména s rozšířením analýzy logů a zpřísňováním regulací.

Konsolidace tradičního SEO a optimalizace pro AI vyhledávání znamená, že analýza logovacích souborů zůstane páteří technického SEO i v dalších letech. Organizace, které ji zvládnou již dnes, budou nejlépe připraveny na udržení viditelnosti a výkonu i při dalším vývoji vyhledávání.

Analýza logovacích souborů poskytuje kompletní, nezkreslená data přímo ze serveru, která zaznamenávají každý požadavek od všech crawlerů, zatímco statistiky procházení v Google Search Console zobrazují pouze agregovaná, vzorkovaná data z crawlerů Googlu. Logy nabízejí detailní historická data a poznatky o chování ne-Google botů, včetně AI crawlerů jako GPTBot a ClaudeBot, což z nich činí komplexnější zdroj pro pochopení skutečného chování crawlerů a identifikaci technických problémů, které GSC nemusí odhalit.

U webů s vysokou návštěvností se doporučuje týdenní analýza logovacích souborů, abyste včas zachytili problémy a sledovali změny ve vzorcích procházení. Menší weby těží z měsíčních kontrol, které pomáhají odhalovat trendy a novou aktivitu botů. Bez ohledu na velikost webu zajistí průběžné monitorování pomocí automatizovaných nástrojů včasnou detekci anomálií, což vám umožní rychle reagovat na plýtvání crawl budgetem nebo technické problémy ovlivňující viditelnost ve vyhledávání.

Ano, analýza logovacích souborů je jedním z nejefektivnějších způsobů, jak sledovat návštěvnost AI botů. Zkoumáním user-agent řetězců a IP adres v serverových logech můžete zjistit, kteří AI boti váš web navštěvují, jaký obsah procházejí a jak často. Tato data jsou klíčová pro pochopení, jak se váš obsah dostává do AI vyhledávání a generativních AI modelů, což vám umožní optimalizovat viditelnost v AI a řídit přístup botů pomocí pravidel v robots.txt.

Analýza logovacích souborů odhaluje řadu technických SEO problémů, včetně chyb při procházení (kódy stavu 4xx a 5xx), řetězení přesměrování, pomalé načítání stránek, osiřelé stránky bez interního odkazu, plýtvání crawl budgetem na málo hodnotné URL, problémy s vykreslováním JavaScriptu a duplicitní obsah. Také identifikuje falešnou aktivitu botů a pomáhá zjistit, kdy legitimní crawleři narazí na bariéry přístupnosti, což vám umožní upřednostnit opravy, které přímo ovlivňují viditelnost a indexaci ve vyhledávačích.

Analýza logovacích souborů ukazuje přesně, které stránky a jak často vyhledávače procházejí, čímž odhaluje, kde je crawl budget plýtván na málo hodnotný obsah, jako jsou stránkované archivy, faceted navigace nebo zastaralé URL. Identifikací těchto neefektivit můžete upravit svůj robots.txt, zlepšit interní prolinkování na prioritní stránky a nastavit kanonické adresy, abyste nasměrovali pozornost crawlerů na hodnotný obsah a zajistili, že vyhledávače budou indexovat stránky důležité pro vaše podnikání.

Serverové logovací soubory typicky zaznamenávají IP adresy (identifikace zdroje požadavku), časová razítka (kdy požadavky nastaly), HTTP metody (obvykle GET nebo POST), požadované URL (konkrétní navštívené stránky), HTTP status kódy (200, 404, 301, atd.), velikost odpovědi v bajtech, referrer informace a user-agent řetězce (identifikace crawleru nebo prohlížeče). Tato komplexní data umožňují SEO specialistům přesně rekonstruovat, co se při každé serverové interakci stalo, a identifikovat vzorce ovlivňující procházení a indexaci.

Falešní boti se vydávají za legitimní crawlery vyhledávačů, ale jejich IP adresy neodpovídají oficiálním IP rozsahům daného vyhledávače. Pro jejich identifikaci porovnejte user-agent řetězce (například 'Googlebot') s oficiálními IP rozsahy zveřejněnými Googlem, Bingem a dalšími vyhledávači. Nástroje jako Log File Analyzer od Screaming Frog automaticky ověřují autenticitu botů. Falešní boti plýtvají crawl budgetem a mohou zatěžovat server, proto je doporučeno je blokovat v robots.txt nebo pomocí firewallu.

Začněte sledovat, jak AI chatboti zmiňují vaši značku na ChatGPT, Perplexity a dalších platformách. Získejte užitečné informace pro zlepšení vaší AI prezence.

Zjistěte, co je AI crawl analytics a jak analýza serverových logů sleduje chování AI crawlerů, vzorce přístupu k obsahu a viditelnost na AI poháněných vyhledáva...

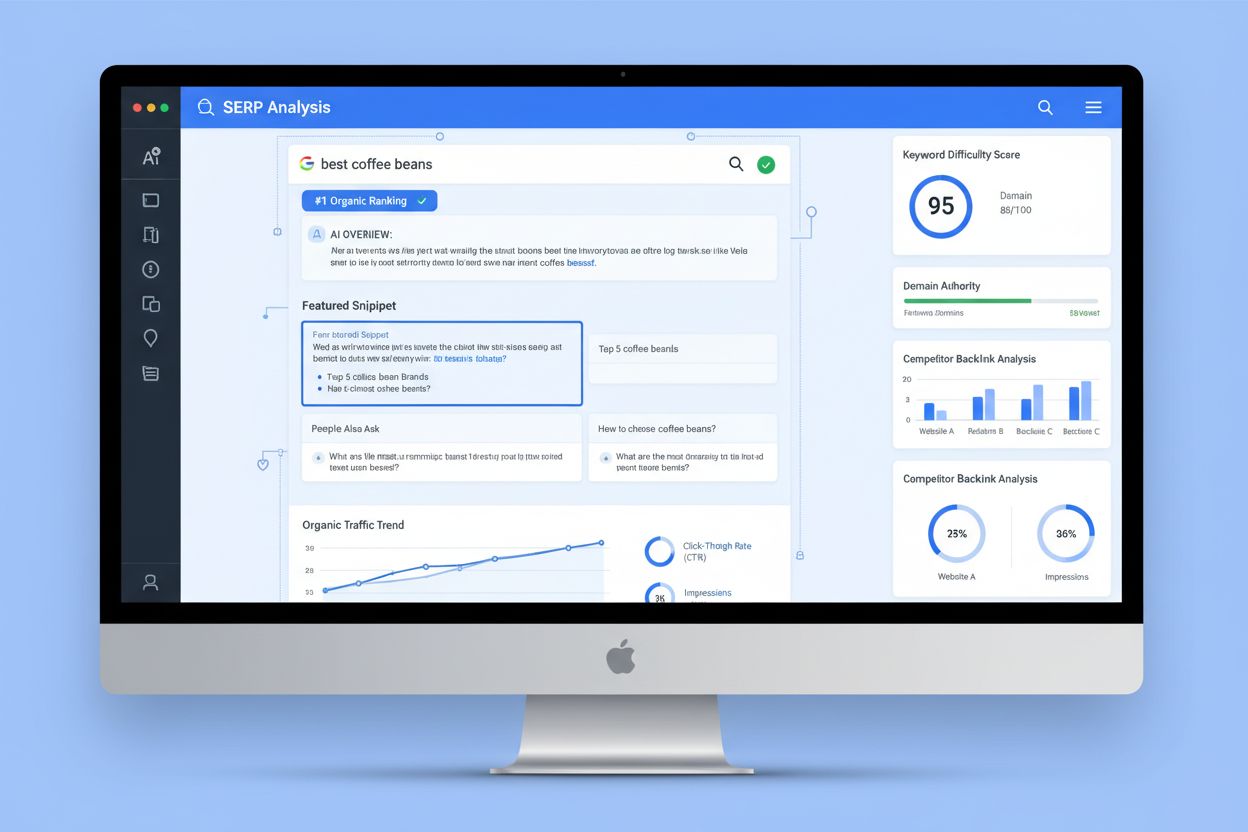

Analýza SERP je proces zkoumání stránek s výsledky vyhledávačů za účelem pochopení obtížnosti umístění, záměru hledání a strategií konkurence. Naučte se analyzo...

Diskuze komunity o frekvenci a chování AI crawlerů. Skutečná data od webmasterů sledujících GPTBot, PerplexityBot a další AI boty ve svých serverových logech....

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.