Sådan hjælper datavisualiseringer AI-søgning og LLM-synlighed

Lær hvordan datavisualiseringer forbedrer AI-søgesynlighed, hjælper LLM'er med at forstå indhold og øger citater i AI-genererede svar. Opdag optimeringsstrategi...

Opdag hvordan AI-modeller citerer visuelle data og diagrammer. Lær hvorfor datavisualisering betyder noget for AI-citater, og hvordan du kan spore dit visuelle indhold med AmICited.

Visuelle data udgør en grundlæggende flaskehals for moderne store sprogmodeller, som primært blev trænet på tekstbaseret information og har svært ved at behandle, fortolke og citere diagrammer med samme præcision, som de anvender på skriftligt indhold. Nuværende LLM’er står over for betydelige begrænsninger, når de møder datavisualiseringer—de skal først konvertere visuelle elementer til tekstbeskrivelser, en proces der ofte mister vigtige nuancer, præcise værdier og kontekstuelle relationer indlejret i det oprindelige diagram. Manglende evne til nøjagtigt at behandle visuelle data i LLM-systemer betyder, at diagrammer, grafer og infografikker ofte ikke bliver citeret eller bliver citeret forkert, hvilket skaber et troværdighedsgab for indholdsskabere, der investerer tid i at producere visualiseringer af høj kvalitet. Denne udfordring er særligt vigtig for forskere, analytikere og organisationer, der er afhængige af AI-diagrambehandling til informationssyntese, da manglende korrekt tilskrivning underminerer både den oprindelige skabers arbejde og pålideligheden af AI-genererede resumeer. At forstå disse begrænsninger er afgørende for alle, der skaber visuelt indhold i et stadig mere AI-drevet informationslandskab.

Forskellige AI-systemer tilgår citat af visuelt indhold med varierende grad af sofistikation, hvilket afspejler deres underliggende arkitektur og træningsmetoder. Tabellen herunder illustrerer, hvordan store AI-platforme håndterer visuelle citater:

| AI-model | Visuel citations-evne | Citatformat | Nøjagtighedsniveau | Multimodal support |

|---|---|---|---|---|

| ChatGPT (GPT-4V) | Moderat | Beskrivende tekst | 65-75% | Ja (billedinput) |

| Claude 3 | Høj | Detaljeret tilskrivning | 80-85% | Ja (vision-aktiveret) |

| Perplexity AI | Høj | Kilde + visuel reference | 85-90% | Ja (web-integreret) |

| Google AI Overviews | Moderat-høj | Indlejrede citater | 75-80% | Ja (billedsøgning) |

| Gemini Pro Vision | Moderat | Kontekstuel reference | 70-78% | Ja (multimodal) |

Claude udviser overlegen ydeevne i tilskrivning af visuelt indhold, og giver ofte detaljerede kildeoplysninger og visuel kontekst, når den refererer til diagrammer, mens Perplexity AI udmærker sig ved at integrere visuelle citater med webkilder, hvilket giver en mere omfattende citationskæde. ChatGPT’s GPT-4V kan behandle billeder, men falder ofte tilbage på generiske beskrivelser fremfor præcise citater, især ved komplekse finansielle diagrammer eller videnskabelige visualiseringer. Google AI Overviews forsøger at opretholde indlejrede citater for visuelt indhold, men forveksler nogle gange diagrammets skaber med datakilden, hvilket skaber uklarhed omkring korrekt tilskrivning. For indholdsskabere betyder denne variation, at den samme visualisering kan få vidt forskellig behandling afhængigt af, hvilket AI-system der behandler den—et diagram kan blive korrekt citeret i Claude, men slet ikke i ChatGPT, hvilket understreger behovet for standardiserede protokoller for visuelle citater på tværs af AI-økosystemet.

Datavisualisering spiller en overraskende indflydelsesrig rolle i, hvordan AI-modeller forstår og repræsenterer information, da diagrammer og grafer indlejret i træningsdatasæt lærer modellerne at genkende mønstre, relationer og hierarkier i komplekse data. Kvaliteten og mangfoldigheden af visuelle data i træningssæt har direkte indflydelse på, hvor godt AI-systemer senere kan fortolke og citere lignende visualiseringer, hvilket betyder, at modeller trænet på omfattende visuelle datasæt viser markant bedre præstation i tilskrivning af visuelt indhold. Visuelle mønstre lært under træning påvirker modellens output på subtile, men målbare måder—en model, der er trænet grundigt på korrekt mærkede videnskabelige diagrammer, vil mere sandsynligt generere nøjagtige citater for lignende visualiseringer end en, der primært er trænet på tekst. Udfordringen forstærkes, fordi de fleste store sprogmodeller blev trænet på internetdata, hvor visuelt indhold ofte mangler ordentlig metadata, alt-tekst eller kildeangivelse, hvilket fastholder en cyklus, hvor AI-systemer lærer at behandle diagrammer uden at lære at citere dem. Organisationer, der investerer i højkvalitets, veldokumenterede datasæt for datavisualisering, bygger i praksis bedre fundamenter for fremtidens AI-systemer, selvom denne investering stadig er underudnyttet i branchen.

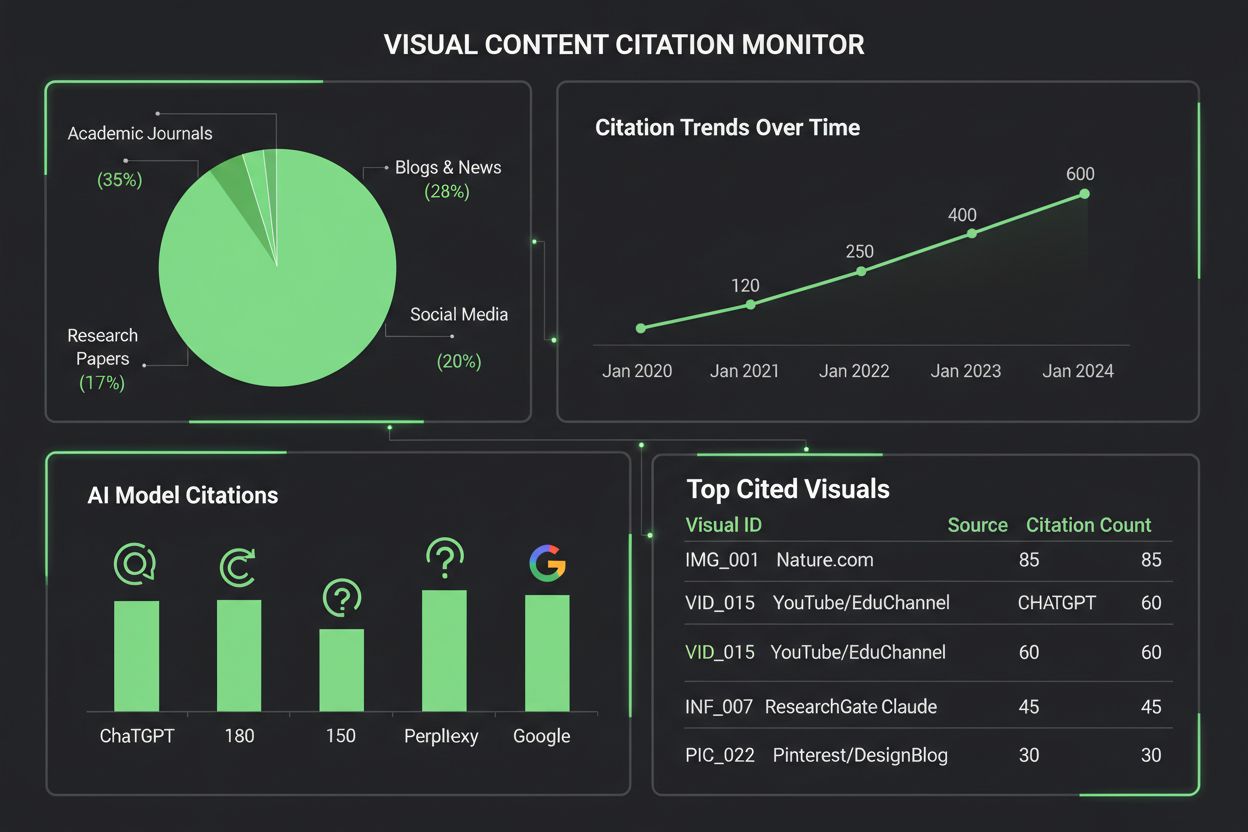

Overvågning af, hvordan AI-systemer citerer visuelt indhold, kræver en flerlaget tilgang, der kombinerer automatiseret detektion med manuel verifikation. Centrale sporingsmetoder omfatter:

AmICited.com er specialiseret i at spore citater af visuelt indhold på tværs af flere AI-platforme, og giver indholdsskabere detaljerede rapporter om, hvordan deres diagrammer bliver refereret, tilskrevet eller overset af ChatGPT, Claude, Perplexity, Google AI og andre systemer. Vigtigheden af at overvåge visuelle citater kan ikke understreges nok—uden ordentlig sporing mister skaberen overblikket over, hvordan deres arbejde påvirker AI-genereret indhold, hvilket gør det umuligt at arbejde for bedre tilskrivningspraksis eller forstå den reelle rækkevidde af deres visualiseringer. AmICiteds værktøjer til overvågning af visuelt indhold udfylder dette afgørende hul ved at tilbyde skabere realtidsnotifikationer, når deres diagrammer bliver citeret, detaljeret analyse af citationsnøjagtighed og brugbare indsigter til at forbedre synligheden af visuelt indhold i AI-systemer.

At skabe visualiseringer, der har større sandsynlighed for at blive citeret af AI-systemer, kræver bevidste designvalg, der prioriterer klarhed, metadata-rigdom og maskinlæsbarhed. Dristige, højkontrast farveskemaer og tydelig mærkning forbedrer AI’s billedbehandling markant, da modeller har svært ved subtile farveovergange, overlappende elementer og tvetydige signaturforklaringer, som mennesker let kan tolke. Inkludér omfattende alt-tekstbeskrivelser, der ikke bare opsummerer, hvad diagrammet viser, men også de underliggende datarelationer, nøgleindsigter og kildeoplysninger—disse metadata bliver fundamentet for nøjagtige AI-citater. Indlejring af strukturerede data i dine visualiseringer med standarder som JSON-LD eller mikrodata-markup gør det muligt for AI-systemer at udtrække præcise værdier og relationer i stedet for kun at stole på visuel tolkning. Sørg for, at diagramtitler er beskrivende og specifikke fremfor generiske, da AI-modeller bruger titler som primære ankre for at forstå og citere visuelt indhold. Giv kildeangivelse direkte i visualiseringen gennem fodnoter, vandmærker eller integrerede kildelabels, så AI-systemer ikke kan adskille diagrammet fra dets ophav. Organisationer, der konsekvent implementerer disse praksisser, oplever målbare forbedringer i, hvordan deres visuelle indhold bliver citeret på tværs af AI-platforme, hvilket fører til bedre tilskrivning, øget synlighed og stærkere professionel troværdighed.

Landskabet for værktøjer til overvågning af visuelle citater udvider sig løbende, efterhånden som organisationer indser vigtigheden af at spore, hvordan AI-systemer refererer visuelt indhold. AmICited.com skiller sig ud som en omfattende løsning, der specifikt er designet til at overvåge citater af visuelt indhold på tværs af flere AI-platforme, og tilbyder skabere detaljerede dashboards, der viser præcis, hvornår og hvordan deres diagrammer bliver citeret af ChatGPT, Claude, Perplexity, Google AI Overviews og nye AI-systemer. Traditionelle platforms for citationssporing som Google Scholar og Scopus fokuserer primært på akademiske artikler og tekstbaserede citater, hvilket efterlader visuelt indhold stort set uovervåget og uden tilskrivning. Specialiserede værktøjer som Tinybird og lignende datavisualiseringsplatforme integrerer nu citationssporing, så organisationer kan overvåge, hvordan deres realtids-datavisualiseringer konsumeres og refereres af AI-systemer. AmICiteds visuelle analysemuligheder giver metrics for citationsfrekvens, nøjagtighed og platformsspecifikke mønstre, så indholdsskabere kan forstå, hvilke AI-systemer der korrekt tilskriver deres arbejde, og hvilke der kræver intervention. For organisationer, der tager beskyttelsen af deres visuelle intellektuelle ejendom og forståelsen af deres indflydelse i det AI-drevne informationsøkosystem seriøst, er det blevet essentielt at implementere en dedikeret løsning til overvågning af visuelle citater som AmICited.com—det forvandler citationssporing fra passiv observation til aktiv forvaltning, der skaber bedre tilskrivningsresultater.

Nuværende AI-modeller har varierende evner, når det gælder om at citere visuelt indhold. Mens avancerede modeller som Claude og Perplexity kan referere til diagrammer med rimelig nøjagtighed, har mange systemer svært ved korrekt tilskrivning. De fleste LLM'er blev primært trænet på tekstdata, hvilket gør visuelle citater mindre pålidelige end tekstcitater. Derfor er overvågningsværktøjer som AmICited afgørende for at spore, hvordan dine visualiseringer faktisk bliver citeret.

AmICited.com tilbyder omfattende overvågning af visuelt indhold på tværs af flere AI-platforme, herunder ChatGPT, Claude, Perplexity og Google AI Overviews. Platformen bruger automatiseret visuel fingeraftryk og metadataanalyse til at identificere, når dine diagrammer vises i AI-genereret indhold, og giver realtidsnotifikationer og detaljeret analyse af citationsnøjagtighed og -frekvens.

AI-systemer citerer diagrammer mere nøjagtigt, når de har dristige, højkontrast farver, tydelig mærkning, beskrivende titler og omfattende alt-tekst. Inkludering af struktureret data-markup, kildeangivelse i selve visualiseringen og velorganiserede signaturforklaringer forbedrer AI'ens behandling af diagrammer og sandsynligheden for citation markant. At skabe flere versioner af komplekse visualiseringer—forenklet til AI og detaljeret til mennesker—øger også synligheden.

Baseret på nuværende evner viser Claude 3 og Perplexity AI den højeste nøjagtighed i tilskrivning af visuelt indhold, med citationsnøjagtighed på 80-90%. Google AI Overviews og Gemini Pro Vision klarer sig moderat godt med 75-80%, mens ChatGPT's GPT-4V, på trods af synsevner, ofte falder tilbage på generiske beskrivelser i stedet for præcise citater. Disse evner udvikler sig fortsat i takt med at modeller opdateres.

Overvågning af visuelle citater er afgørende for brand-synlighed, vurdering af indholdets værdi og beskyttelse af intellektuel ejendom. Når dine diagrammer korrekt citeres af AI-systemer, øger det dit brands synlighed i AI-genereret indhold, validerer dit indholds indflydelse og hjælper dig med at forstå, hvordan dit arbejde former AI-drevet informationssyntese. Uden overvågning mister du overblikket over dit indholds rækkevidde og effekt.

AmICited specialiserer sig i at spore citater af visuelt indhold på tværs af flere AI-platforme og tilbyder detaljerede dashboards, der viser, hvornår og hvordan dine diagrammer bliver citeret. Platformen giver realtidsnotifikationer, citationsnøjagtighed, platformsspecifik analyse og brugbare indsigter til at forbedre synligheden af visuelt indhold. Den forvandler citationsovervågning fra passiv observation til aktiv håndtering af din visuelle intellektuelle ejendom.

Tekstcitater i AI-systemer er generelt mere pålidelige, fordi LLM'er primært blev trænet på tekstdata. Visuelle citater kræver yderligere behandlingsskridt—AI skal først konvertere visuelle elementer til tekstbeskrivelser, hvilket ofte mister nuancer og præcise værdier. Denne konverteringsproces giver flere muligheder for fejl, hvilket gør visuelle citater mindre nøjagtige og mindre konsistente end tekstcitater på tværs af forskellige AI-platforme.

Absolut. Implementer bedste praksis som brug af dristige, højkontrast farver, oprettelse af beskrivende titler og alt-tekst, indlejring af struktureret data-markup og inklusion af kildeangivelse direkte i visualiseringer. Undgå subtile farveovergange, overlappende elementer og tvetydige signaturforklaringer. Overvej at lave forenklede versioner af komplekse diagrammer specifikt til AI-behandling. Disse forbedringer gør dine visualiseringer mere synlige og citerbare af AI-systemer.

Følg med i, hvordan AI-systemer citerer dine diagrammer og visualiseringer på tværs af ChatGPT, Claude, Perplexity og Google AI. Få realtidsnotifikationer og detaljeret analyse af visuel indholds-tilskrivning.

Lær hvordan datavisualiseringer forbedrer AI-søgesynlighed, hjælper LLM'er med at forstå indhold og øger citater i AI-genererede svar. Opdag optimeringsstrategi...

Opdag hvordan Wikipedia-citater former AI-træningsdata og skaber en bølgeseffekt på tværs af LLM'er. Lær hvorfor din Wikipedia-tilstedeværelse betyder noget for...

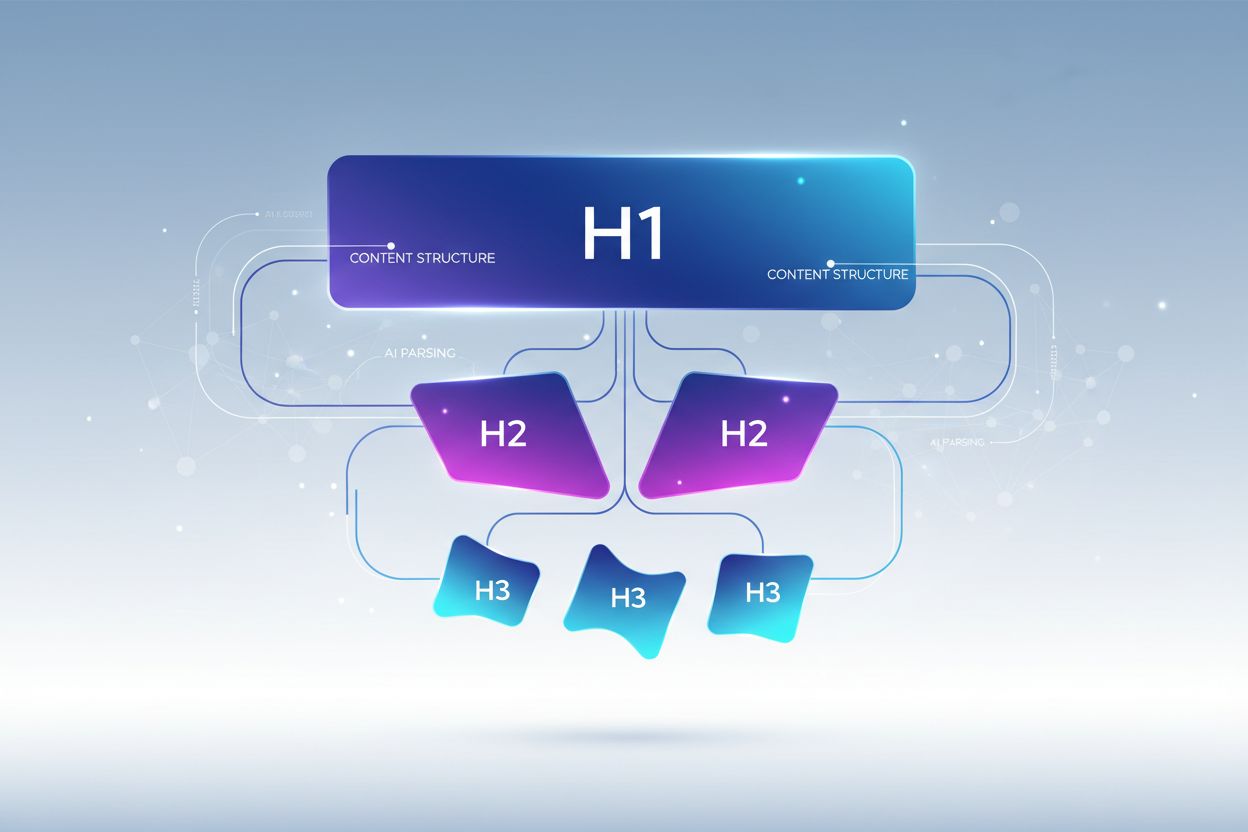

Lær hvordan du optimerer overskrifthierarki til LLM-tolkning. Mestre H1-, H2-, H3-struktur for at forbedre AI-synlighed, citationer og indholdsopdagelse på tvær...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.