Sådan optimerer du dit indhold til AI-træningsdata og AI-søgemaskiner

Lær hvordan du optimerer dit indhold til inklusion i AI-træningsdata. Opdag best practices for at gøre dit website synligt for ChatGPT, Gemini, Perplexity og an...

Tekniske og juridiske mekanismer, der gør det muligt for indholdsskabere og ophavsretsindehavere at forhindre deres arbejde i at blive brugt i træningsdatasæt til store sprogmodeller. Disse inkluderer robots.txt-direktiver, juridiske opt-out-erklæringer og kontraktmæssige beskyttelser under reguleringer som EU AI Act.

Tekniske og juridiske mekanismer, der gør det muligt for indholdsskabere og ophavsretsindehavere at forhindre deres arbejde i at blive brugt i træningsdatasæt til store sprogmodeller. Disse inkluderer robots.txt-direktiver, juridiske opt-out-erklæringer og kontraktmæssige beskyttelser under reguleringer som EU AI Act.

AI training opt-out refererer til de tekniske og juridiske mekanismer, der gør det muligt for indholdsskabere, ophavsretsindehavere og webstedsejere at forhindre deres arbejde i at blive brugt i træningsdatasæt til store sprogmodeller (LLM). Efterhånden som AI-virksomheder scraper enorme mængder data fra internettet til at træne stadig mere sofistikerede modeller, er evnen til at kontrollere, om dit indhold deltager i denne proces, blevet essentiel for beskyttelse af intellektuel ejendomsret og opretholdelse af kreativ kontrol. Disse opt-out-mekanismer opererer på to niveauer: tekniske direktiver, der instruerer AI-crawlere om at springe dit indhold over, og juridiske rammer, der etablerer kontraktmæssige rettigheder til at udelukke dit arbejde fra træningsdatasæt.

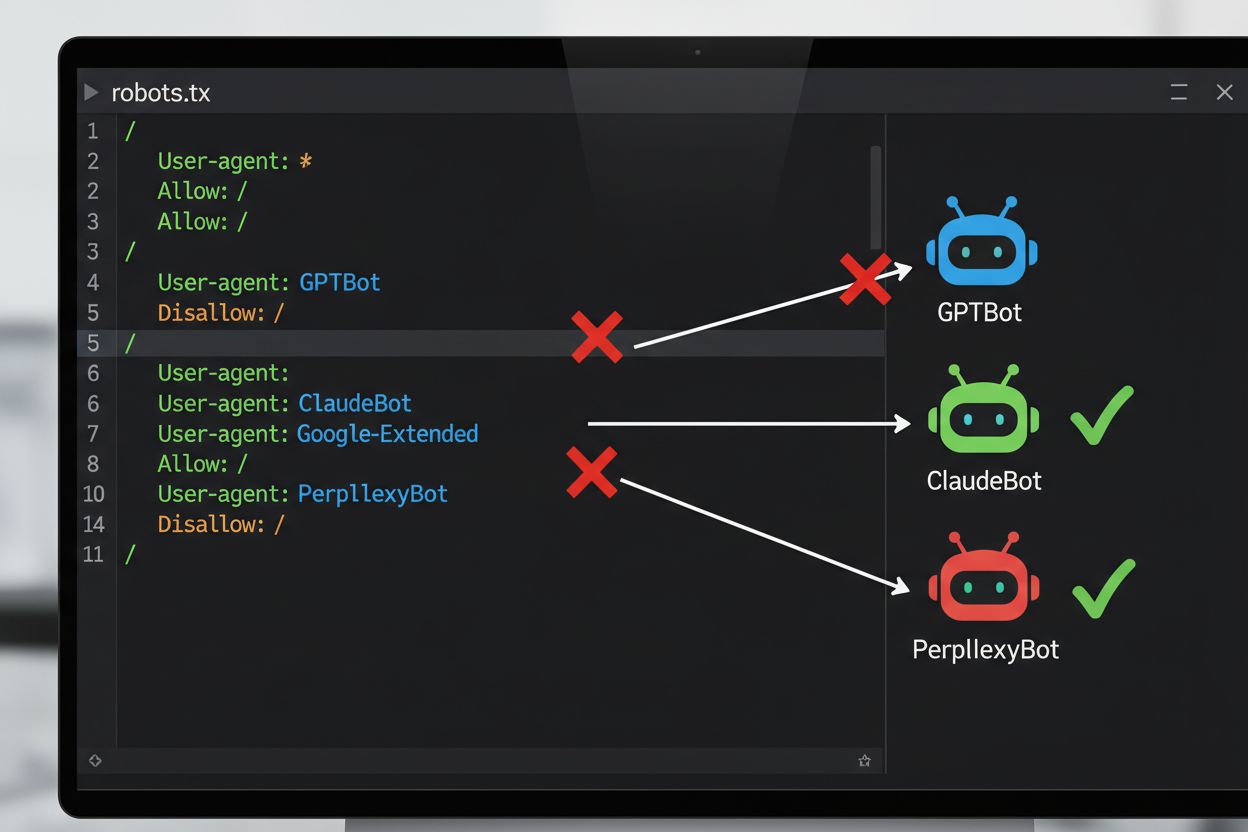

Den mest almindelige tekniske metode til at framelde sig AI-træning er gennem robots.txt-filen, en simpel tekstfil placeret i et websteds rodmappe, der kommunikerer crawlertilladelser til automatiserede bots. Når en AI-crawler besøger dit websted, tjekker den først robots.txt for at se, om den har tilladelse til at tilgå dit indhold. Ved at tilføje specifikke disallow-direktiver for bestemte crawler user agents kan du instruere AI-bots om at springe dit websted helt over.

| AI-virksomhed | Crawlernavn | User Agent Token | Formål |

|---|---|---|---|

| OpenAI | GPTBot | GPTBot | Indsamling af modeltræningsdata |

| OpenAI | OAI-SearchBot | OAI-SearchBot | ChatGPT-søgeindeksering |

| Anthropic | ClaudeBot | ClaudeBot | Chat-citationsfetch |

| Google-Extended | Google-Extended | Gemini AI-træningsdata | |

| Perplexity | PerplexityBot | PerplexityBot | AI-søgeindeksering |

| Meta | Meta-ExternalAgent | Meta-ExternalAgent | AI-modeltræning |

| Common Crawl | CCBot | CCBot | Åbent datasæt til LLM-træning |

Det juridiske landskab for AI training opt-out har udviklet sig betydeligt med introduktionen af EU AI Act, der trådte i kraft i 2024 og inkorporerer bestemmelser fra Text and Data Mining (TDM) Directive. Under disse reguleringer er AI-udviklere tilladt at bruge ophavsretsbeskyttede værker til maskinlæringsformål kun, hvis de har lovlig adgang til indholdet, og ophavsretsindehaveren ikke udtrykkeligt har forbeholdt retten til at udelukke deres arbejde fra tekst- og datamining.

Implementering af en opt-out-mekanisme involverer både teknisk konfiguration og juridisk dokumentation. På den tekniske side tilføjer webstedsejere disallow-direktiver til deres robots.txt-fil for specifikke AI-crawler user agents, som kompatible crawlere vil respektere, når de besøger webstedet. På den juridiske side kan ophavsretsindehavere indgive opt-out-erklæringer til forvaltningsorganisationer og rettighedsorganisationer.

Trods tilgængeligheden af opt-out-mekanismer begrænser betydelige udfordringer deres effektivitet:

For effektivt at beskytte dit indhold mod uautoriseret brug i AI-træning, anvend en lagdelt tilgang, der kombinerer tekniske og juridiske foranstaltninger. Først, implementer robots.txt-direktiver for alle større AI-træningscrawlere (GPTBot, ClaudeBot, Google-Extended, PerplexityBot, CCBot og andre). For det andet, tilføj eksplicitte opt-out-erklæringer til dit websteds servicevilkår og metadata. For det tredje, overvåg regelmæssigt din konfiguration ved hjælp af testværktøjer og serverlogs. For det fjerde, overvej yderligere tekniske foranstaltninger som user agent-filtrering eller hastighedsbegrænsning. Endelig, dokumenter dine opt-out-bestræbelser grundigt, da denne dokumentation bliver afgørende, hvis du skal forfølge juridisk handling.

robots.txt er en teknisk, frivillig standard, der instruerer crawlere om at springe dit indhold over, mens juridisk opt-out involverer indgivelse af formelle forbehold hos ophavsretsorganisationer eller inkludering af kontraktklausuler i dine servicevilkår. robots.txt er lettere at implementere, men mangler håndhævelse, mens juridisk opt-out giver stærkere juridisk beskyttelse, men kræver mere formelle procedurer.

Større AI-virksomheder som OpenAI, Google, Anthropic og Perplexity har offentligt udtalt, at de respekterer robots.txt-direktiver. Dog er robots.txt en frivillig standard uden håndhævelsesmekanisme, så ikke-kompatible crawlere og useriøse scrapere kan helt ignorere dine direktiver.

Nej. Blokering af AI-træningscrawlere som GPTBot og ClaudeBot vil ikke påvirke dine Google- eller Bing-søgerangeringer, fordi traditionelle søgemaskiner bruger forskellige crawlere (Googlebot, Bingbot), der opererer uafhængigt. Bloker kun disse, hvis du vil forsvinde helt fra søgeresultaterne.

EU AI Act kræver, at AI-udviklere har lovlig adgang til indhold og skal respektere ophavsretsindehaveres opt-out-forbehold. Ophavsretsindehavere kan indgive opt-out-erklæringer med deres værker, hvilket effektivt forhindrer deres brug i AI-træning uden eksplicit tilladelse. Dette skaber en formel juridisk mekanisme til at beskytte indhold mod uautoriseret træningsbrug.

Det afhænger af den specifikke mekanisme. Blokering af alle AI-crawlere vil forhindre dit indhold i at optræde i AI-søgeresultater, men dette fjerner dig også helt fra AI-drevne søgeplatforme. Nogle udgivere foretrækker selektiv blokering - tillader søgefokuserede crawlere, mens de blokerer træningsfokuserede - for at opretholde synlighed i AI-søgning, mens de beskytter indhold mod modeltræning.

Hvis en AI-virksomhed ignorerer dine opt-out-direktiver, har du juridiske muligheder gennem ophavsretskrænkelseskrav eller kontraktbrud, afhængigt af din jurisdiktion og de specifikke omstændigheder. Dog er juridisk handling kostbar og langsom med usikre resultater. Derfor er overvågning og dokumentation af dine opt-out-bestræbelser afgørende.

Gennemgå og opdater din robots.txt-konfiguration mindst kvartalsvis. Nye AI-crawlere dukker konstant op, og virksomheder introducerer ofte nye crawler user agents. For eksempel fusionerede Anthropic deres 'anthropic-ai' og 'Claude-Web' bots til 'ClaudeBot', hvilket gav den nye bot midlertidig ubegrænset adgang til websteder, der ikke havde opdateret deres regler.

Opt-out er effektiv mod kompatible, velrenommerede AI-virksomheder, der respekterer robots.txt og juridiske rammer. Dog er den mindre effektiv mod useriøse crawlere og ikke-kompatible scrapere, der opererer i juridiske gråzoner. robots.txt stopper cirka 40-60% af AI-bots, hvorfor en lagdelt tilgang, der kombinerer flere tekniske og juridiske foranstaltninger, anbefales.

Spor om dit indhold optræder i AI-genererede svar på tværs af ChatGPT, Perplexity, Google AI Overviews og andre AI-platforme med AmICited.

Lær hvordan du optimerer dit indhold til inklusion i AI-træningsdata. Opdag best practices for at gøre dit website synligt for ChatGPT, Gemini, Perplexity og an...

Komplet guide til at fravælge indsamling af AI-træningsdata på tværs af ChatGPT, Perplexity, LinkedIn og andre platforme. Lær trin-for-trin instruktioner til at...

Lær hvad konkurrencemæssig AI-sabotage er, hvordan det fungerer, og hvordan du beskytter dit brand mod konkurrenter, der forurener AI-søgeresultater. Opdag meto...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.