AI-crawlere forklaret: GPTBot, ClaudeBot og flere

Få indsigt i hvordan AI-crawlere som GPTBot og ClaudeBot fungerer, hvordan de adskiller sig fra traditionelle søgemaskinecrawlere, og hvordan du optimerer dit s...

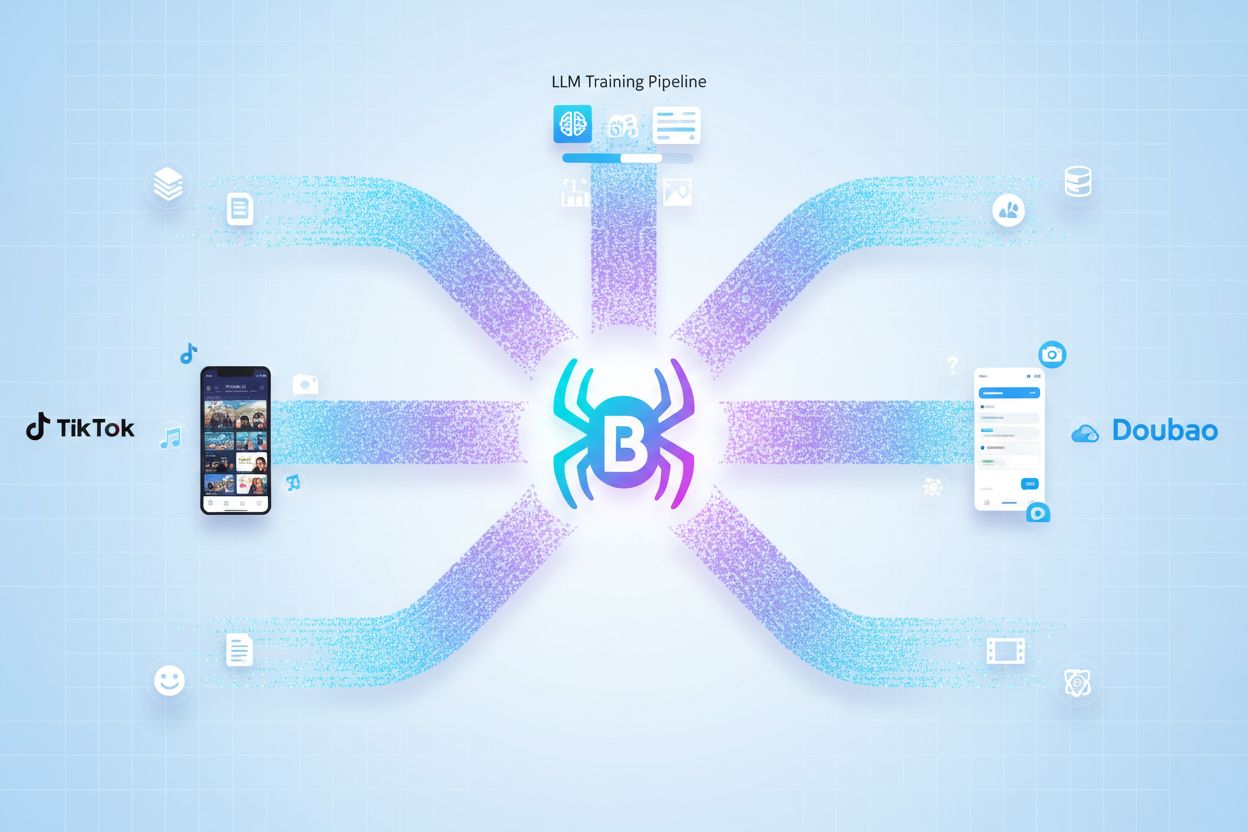

Bytespider er ByteDances webcrawler, der systematisk indsamler indhold fra hjemmesider for at træne kunstige intelligensmodeller og drive TikToks anbefalingsalgoritmer. Den opererer primært fra Singapore og crawler aggressivt internettet for at indsamle træningsdata til store sprogmodeller, herunder Doubao, ByteDances konkurrent til ChatGPT. Crawleren er kendt for at ignorere robots.txt-direktiver og generere millioner af forespørgsler dagligt, hvilket gør den til en af de mest udbredte AI-datascrapere på nettet.

Bytespider er ByteDances webcrawler, der systematisk indsamler indhold fra hjemmesider for at træne kunstige intelligensmodeller og drive TikToks anbefalingsalgoritmer. Den opererer primært fra Singapore og crawler aggressivt internettet for at indsamle træningsdata til store sprogmodeller, herunder Doubao, ByteDances konkurrent til ChatGPT. Crawleren er kendt for at ignorere robots.txt-direktiver og generere millioner af forespørgsler dagligt, hvilket gør den til en af de mest udbredte AI-datascrapere på nettet.

Bytespider er ByteDances proprietære webcrawler, der er designet til systematisk at gennemgå og indeksere indhold på tværs af internettet til træning af kunstige intelligensmodeller. Denne crawler opererer primært fra Singapore-baseret infrastruktur og indsamler enorme mængder offentligt tilgængeligt webindhold for at understøtte udviklingen af store sprogmodeller og drive ByteDances forskellige AI-drevne tjenester. Crawleren fungerer som en kritisk komponent i ByteDances dataindsamlingspipeline og gør det muligt for virksomheden at indsamle træningsdatasæt i massiv skala. Bytespiders primære formål rækker ud over simpel indeksering af indhold—den fungerer som rygraden i træningen af AI-systemer, herunder Doubao, ByteDances ChatGPT-konkurrent, samtidig med at den bidrager til TikToks avancerede anbefalingsalgoritmer. Crawleren arbejder kontinuerligt og foretager millioner af forespørgsler dagligt til hjemmesider over hele verden og udtrækker systematisk tekst, metadata og strukturel information. I modsætning til traditionelle søgemaskinecrawlere, der prioriterer brugeroplevelse og hjemmesidens retningslinjer, er Bytespider optimeret til effektiv dataindsamling og er derfor en af de mest udbredte AI-datascrapere på det moderne internet.

| Crawler-navn | Operatør | Primært formål | Respekterer robots.txt | Typisk trafikvolumen |

|---|---|---|---|---|

| Bytespider | ByteDance | AI-modeltræning, TikTok-anbefalinger | Nej | Millioner af forespørgsler dagligt |

| Googlebot | Søgeindeksering, rangering | Ja | Varierer efter sidens vigtighed | |

| ClaudeBot | Anthropic | Claude AI-træningsdata | Delvist | Højt volumen, inkonsistent |

| PerplexityBot | Perplexity AI | AI-søgetræning | Ja | Moderat, voksende |

Bytespider fungerer som dataindsamlingsmotor for hele ByteDances økosystem af AI-drevne tjenester med særligt fokus på at forbedre TikToks anbefalingsalgoritmer og træne avancerede sprogmodeller. Crawleren indsamler systematisk webindhold, som derefter behandles og bruges til at træne Doubao, ByteDances store sprogmodel, der konkurrerer direkte med OpenAIs ChatGPT og har over 60 millioner månedlige aktive brugere. Forholdet mellem Bytespiders dataindsamling og TikToks anbefalingssystem er symbiotisk—crawleren indsamler forskellige indholdsmønstre og brugerengagementsignaler fra hele nettet, som informerer de maskinlæringsmodeller, der afgør, hvilket indhold der vises i brugernes feeds. Denne dataindsamlingsproces foregår i hidtil uset skala, hvor Bytespider tegner sig for næsten 90 % af al AI-crawler-trafik på mange hjemmesider, hvilket demonstrerer ByteDances aggressive investering i AI-infrastruktur. De indsamlede data omfatter tekst, billeder, metadata og strukturel information fra millioner af hjemmesider og skaber omfattende træningsdatasæt, der forbedrer modellernes nøjagtighed og relevans. ByteDances strategiske tilgang behandler Bytespider som en afgørende konkurrencefordel, der muliggør hurtig iteration og forbedring af AI-systemer på tværs af virksomhedens produktportefølje.

Vigtige AI-systemer drevet af Bytespider-data:

Bytespider har fået ry for at være en aggressiv webcrawler på grund af dens bevidste tilsidesættelse af standard webprotokoller og dens enorme mængde forespørgsler. I modsætning til de fleste anerkendte AI-crawlere, der respekterer robots.txt-direktiver—en standardfil, som webmastere bruger til at kommunikere crawler-adgangspræferencer—ignorerer Bytespider aktivt disse retningslinjer og betragter dem som valgfrie snarere end bindende. Crawleren genererer millioner af forespørgsler dagligt til enkelte domæner, med typiske crawlingsrater på omkring 5 forespørgsler i sekundet pr. målrettet hjemmeside, hvilket skaber betydelig serverbelastning. Bytespider benytter sofistikerede undvigelsestaktikker for at omgå opdagelse og begrænsning, herunder roterende IP-adresser og maskering af sin identitet for at fremstå som legitim brugertrafik fremfor automatiseret bot-aktivitet. Når hjemmesider forsøger at blokere Bytespider ved dens user agent-streng, skifter crawlerens oprindelses-IP-geolokation fra Kina til Singapore, hvilket antyder koordineret infrastrukturstyring for at opretholde adgang trods blokeringsforsøg. Denne aggressive adfærd afspejler ByteDances prioritering af dataindsamling fremfor hensyn til hjemmesiders ydeevne og adskiller fundamentalt Bytespider fra søgemaskinecrawlere, der balancerer egne behov med hjemmesideoperatørers interesser.

Bytespiders aggressive crawlingsadfærd skaber betydelige udfordringer for hjemmesideoperatører og manifesterer sig i flere dimensioner af infrastrukturbelastning og sikkerhedsbekymringer. Hjemmesider, der oplever Bytespider-trafik, udsættes for betydeligt båndbreddeforbrug, hvor millioner af daglige forespørgsler bruger serverressourcer, der ellers kunne betjene legitime brugere og forbedre hjemmesideoplevelsen for faktiske besøgende. Serverbelastningen fra Bytespiders aktivitet resulterer direkte i øget strømforbrug og CO2-aftryk, da datacentre skal afsætte yderligere computerressourcer til at håndtere crawler-forespørgsler—en miljømæssig omkostning, der kun gavner ByteDances AI-træningsmål. Sikkerhedsmæssigt rækker konsekvenserne ud over simpel ressourceudtømning—crawlerens undvigelsestaktikker og manglende respekt for standardprotokoller skaber bekymring for potentiel udnyttelse af sikkerhedssårbarheder eller uautoriserede adgangsforsøg til følsomme dele af hjemmesider. Mange organisationer har truffet et strategisk valg om helt at blokere Bytespider, idet de erkender, at crawleren ikke giver nogen reel værdi til deres forretning, mens den bruger ressourcer og potentielt udsætter deres infrastruktur for risici. Det grundlæggende dilemma for hjemmesideoperatører er, om de skal tillade, at deres indhold bidrager til AI-modeltræning (og potentielt forbedrer AI-systemer, der kan konkurrere med deres egne tjenester) eller beskytte deres infrastruktur og indhold mod uautoriseret scraping.

Hjemmesideoperatører har flere tekniske muligheder for at blokere eller begrænse Bytespiders adgang, men effektiviteten varierer afhængigt af implementeringens sofistikation og crawlerens evne til at undgå blokering. Den enkleste metode er at konfigurere din hjemmesides robots.txt-fil med specifikke direktiver, der retter sig mod Bytespiders user agent, selvom denne metode kun er en høflig anmodning snarere end en teknisk blokering, da Bytespider ofte ignorerer disse retningslinjer. Mere robuste blokeringsstrategier benytter firewall-regler og IP-baseret filtrering for at forhindre, at Bytespiders forespørgsler når dine servere, men dette kræver løbende vedligeholdelse, da crawleren roterer mellem forskellige IP-adresser og geolokationer. Begrænsning af forespørgsler på server- eller applikationsniveau kan begrænse antallet af forespørgsler, som en user agent eller IP-adresse kan foretage inden for en given tidsperiode, hvilket effektivt drosler Bytespiders crawlingsrate, selv hvis fuld blokering ikke er mulig. Adfærdsanalytiske tilgange bruger maskinlæring til at identificere og klassificere bot-trafikmønstre og skelne Bytespider fra legitim brugertrafik baseret på forespørgslers karakteristika, timing og interaktionsadfærd. Overvågningsværktøjer som Dark Visitors giver realtidsindsigt i, hvilke crawlere der tilgår din hjemmeside, så du kan verificere, om dine blokeringsforsøg er effektive og justere strategier derefter.

# Eksempel på robots.txt-konfiguration til at blokere Bytespider

User-agent: Bytespider

Disallow: /

# Alternativ: Bloker alle AI-datascrapere

User-agent: Bytespider

User-agent: ClaudeBot

User-agent: GPTBot

Disallow: /

# Selektiv blokering: Tillad crawl af specifikke mapper

User-agent: Bytespider

Disallow: /private/

Disallow: /admin/

Allow: /public/

Fremkomsten af aggressive AI-crawlere som Bytespider rejser grundlæggende spørgsmål om indholdsejerskab, henvisning og de etiske fundamenter for AI-modeltræning i den digitale tidsalder. Indholdsskabere står over for et dilemma: deres originale arbejde kan blive inkorporeret i AI-træningsdatasæt uden eksplicit samtykke, kompensation eller klar henvisning, hvilket potentielt gør det muligt for AI-systemer at generere output, der konkurrerer med eller mindsker værdien af det oprindelige indhold. Den manglende gennemsigtighed omkring, hvordan Bytespider-indhentet indhold bruges, modificeres eller krediteres i AI-genererede svar, skaber usikkerhed om, hvorvidt skabere modtager anerkendelse eller får udbytte af deres intellektuelle bidrag til AI-udvikling. Omvendt anerkender nogle organisationer, at AI-drevet opdagelse repræsenterer en ny kanal for brand awareness og synlighed, efterhånden som AI-chatbots og søgesystemer i stigende grad fungerer som primære informationskilder for brugere, der søger anbefalinger og information. Balancen mellem at beskytte indhold og fremme AI-udvikling er fortsat uafklaret, og forskellige interessenter arbejder for enten stærkere beskyttelse af skabere, klarere standarder for henvisning eller ubegrænset dataadgang for at accelerere AI-udvikling. Fra et SEO-perspektiv kan blokering af Bytespider reducere din repræsentation i AI-genererede svar og AI-drevne søgeresultater, hvilket potentielt påvirker synligheden, efterhånden som brugere i stigende grad benytter AI-systemer som alternativer til traditionelle søgemaskiner. Den bredere debat om ansvarlig AI-dataindsamling, etisk webscraping og fair kompensation til indholdsskabere vil sandsynligvis forme internetgovernance og AI-regulering i mange år fremover og gør beslutninger om blokering af Bytespider til en del af en større strategisk overvejelse om dit brands forhold til nye AI-teknologier.

Bytespider er ByteDances webcrawler, der er designet til at indsamle træningsdata til kunstige intelligensmodeller, især store sprogmodeller (LLMs) som Doubao. Crawleren gennemgår systematisk hjemmesider for at indsamle indhold, der hjælper med at forbedre AI-systemer og driver TikToks anbefalingsalgoritmer. Den bidrager også til ByteDances bredere AI-infrastruktur og indholdsopdagelsessystemer.

Bytespider betragtes som aggressiv, fordi den ignorerer robots.txt-direktiver, som hjemmesider bruger til at kontrollere crawler-adgang, genererer millioner af forespørgsler per dag til individuelle domæner og anvender taktikker for at undgå opdagelse og begrænsning af forespørgsler. I modsætning til de fleste anerkendte crawlers, der respekterer hjemmesidens retningslinjer, prioriterer Bytespider dataindsamling over hjemmesidens ydeevne, hvilket medfører betydelig serverbelastning og båndbreddeforbrug.

Du kan blokere Bytespider ved at tilføje specifikke regler til din robots.txt-fil ved at bruge brugeragenten 'Bytespider'. Da Bytespider dog ofte ignorerer robots.txt, kan det være nødvendigt at implementere yderligere foranstaltninger såsom firewall-regler, IP-blokering, begrænsning af forespørgsler på serverniveau eller bruge løsninger til bot-håndtering. Værktøjer som Dark Visitors kan hjælpe dig med at overvåge og verificere, om dine blokeringsforsøg er effektive.

Blokering af Bytespider har minimal direkte indvirkning på traditionel søgemaskineoptimering, da det ikke er en søgemaskinecrawler. Hvis dit indhold bruges til at træne AI-modeller, der driver AI-søgemaskiner og chatbots, kan blokering af Bytespider dog reducere din repræsentation i AI-genererede svar, hvilket potentielt kan påvirke synligheden via AI-drevne søgeplatforme i fremtiden.

Ifølge data fra Dark Visitors blokerer cirka 16 % af verdens 1.000 største hjemmesider aktivt Bytespider i deres robots.txt-filer. Denne relativt lave blokeringsrate antyder, at mange hjemmesider enten tillader crawleren eller ikke er klar over dens tilstedeværelse. Den faktiske blokeringsrate kan dog være højere, hvis man medregner firewall- og serverbaserede restriktioner, der ikke er synlige i robots.txt.

Bytespider genererer enorme mængder trafik, og undersøgelser viser, at den står for næsten 90 % af al AI-crawler-trafik på nogle hjemmesider. Enkelte domæner kan modtage millioner af forespørgsler fra Bytespider dagligt, med typiske crawlingsrater på cirka 5 forespørgsler i sekundet. Dette gør den til en af de væsentligste kilder til bot-trafik på internettet.

Bytespider drives af ByteDance, som er TikToks moderselskab, men det er ikke udelukkende TikToks crawler. Selvom den indsamler data for at forbedre TikToks anbefalingsalgoritmer, tjener Bytespider primært ByteDances bredere AI-infrastruktur, herunder træningsdata til Doubao (ByteDances LLM) og andre AI-systemer. Det er et værktøj til hele virksomheden snarere end en platformspecifik crawler.

Bytespider fokuserer typisk på offentligt tilgængeligt indhold til træningsdataindsamling. Ligesom andre avancerede crawlers kan den dog forsøge at tilgå adgangskodebeskyttede områder, API-endpoints eller indhold bag betalingsmure afhængigt af ByteDances mål og tekniske kapaciteter. De fleste anerkendte crawlers respekterer autentificeringsbarrierer, men omfanget af Bytespiders adgangsforsøg kan variere afhængigt af specifikke dataindsamlingsmål.

Spor nævnelser af dit brand på AI-drevne platforme som ChatGPT, Perplexity og Google AI Overviews. AmICited hjælper dig med at forstå, hvordan AI-systemer bruger dit indhold og sikrer korrekt henvisning.

Få indsigt i hvordan AI-crawlere som GPTBot og ClaudeBot fungerer, hvordan de adskiller sig fra traditionelle søgemaskinecrawlere, og hvordan du optimerer dit s...

Lær hvilke AI-crawlere du skal tillade eller blokere i din robots.txt. Omfattende guide, der dækker GPTBot, ClaudeBot, PerplexityBot og 25+ AI-crawlere med konf...

Lær at træffe strategiske beslutninger om blokering af AI-crawlere. Vurder indholdstype, trafikkilder, indtægtsmodeller og konkurrenceposition med vores omfatte...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.