Multimodal AI-søgning: Optimering til billede- og stemmeforespørgsler

Bliv ekspert i optimering af multimodal AI-søgning. Lær, hvordan du optimerer billeder og stemmeforespørgsler til AI-drevne søgeresultater, med strategier til G...

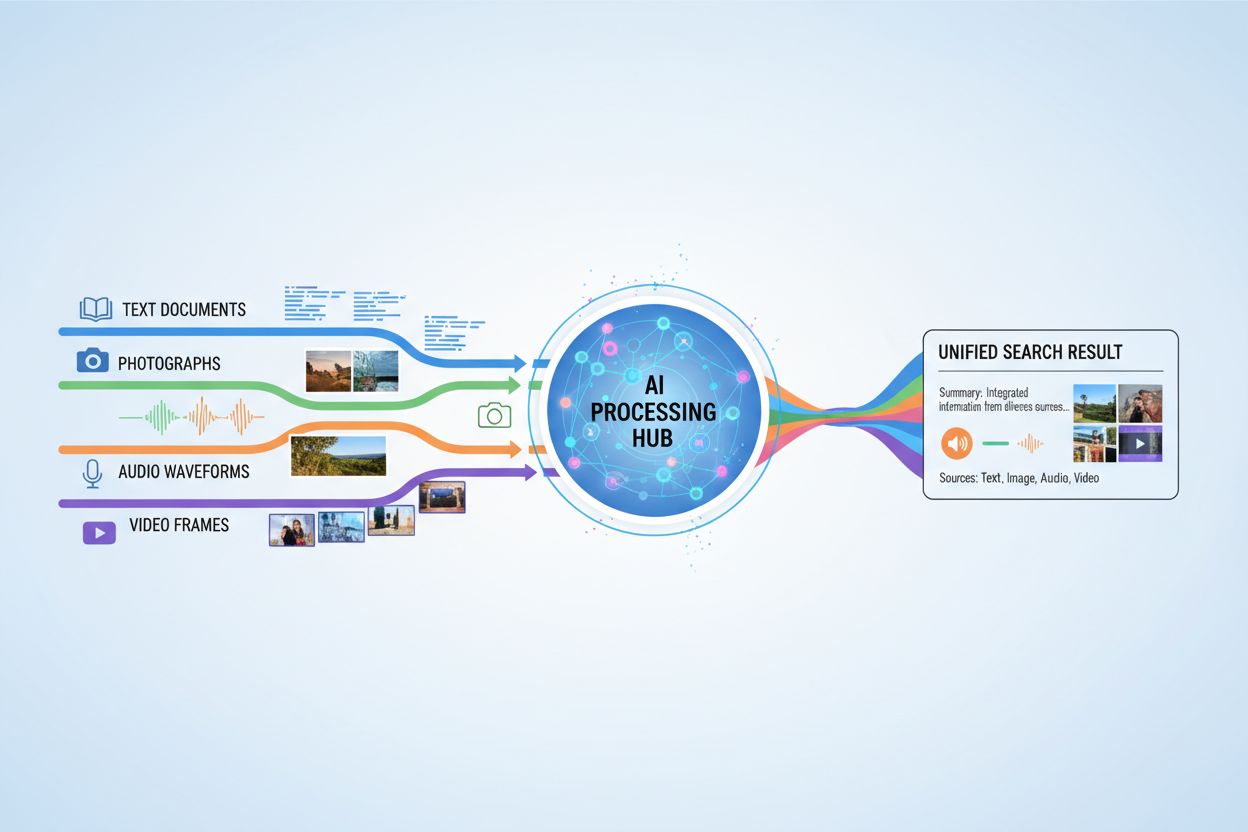

AI-systemer, der behandler og besvarer forespørgsler, der involverer tekst, billeder, lyd og video samtidigt, hvilket muliggør en mere omfattende forståelse og kontekstbevidste svar på tværs af flere datatyper.

AI-systemer, der behandler og besvarer forespørgsler, der involverer tekst, billeder, lyd og video samtidigt, hvilket muliggør en mere omfattende forståelse og kontekstbevidste svar på tværs af flere datatyper.

Multimodal AI-søgning refererer til kunstig intelligens-systemer, der behandler og integrerer information fra flere datatyper eller modaliteter—såsom tekst, billeder, lyd og video—samtidigt for at levere mere omfattende og kontekstuelle relevante resultater. I modsætning til unimodal AI, der er baseret på én type input (for eksempel tekstbaserede søgemaskiner), udnytter multimodale systemer de komplementære styrker fra forskellige dataformater for at opnå dybere forståelse og mere præcise resultater. Denne tilgang afspejler menneskelig kognition, hvor vi naturligt kombinerer visuel, auditiv og tekstuel information for at forstå vores omgivelser. Ved at behandle forskellige inputtyper sammen kan multimodale AI-søgningssystemer opfange nuancer og relationer, som ville være usynlige for enkeltmodale tilgange.

Multimodal AI-søgning fungerer gennem avancerede fusionsteknikker, der kombinerer information fra forskellige modaliteter på forskellige behandlingsstadier. Systemet udtrækker først funktioner fra hver modalitet uafhængigt og sammenfletter derefter strategisk disse repræsentationer for at skabe en samlet forståelse. Tidspunktet og metoden for fusion har stor betydning for ydeevnen, hvilket illustreres i følgende sammenligning:

| Fusionstype | Hvornår anvendt | Fordele | Ulemper |

|---|---|---|---|

| Tidlig fusion | Inputstadie | Opfanger lavniveau-korrelationer | Mindre robust ved ikke-justerede data |

| Mellem fusion | Forbehandlingstrin | Balanceret tilgang | Mere kompleks |

| Sen fusion | Outputniveau | Modulært design | Mindre sammenhængende kontekst |

Tidlig fusion kombinerer rå data med det samme og opfanger fine interaktioner, men har svært ved ikke-justerede input. Mellem-fusion anvender fusion under mellemliggende behandlingstrin og tilbyder et balanceret kompromis mellem kompleksitet og ydeevne. Sen fusion fungerer på outputniveau og muliggør uafhængig modalitetsbehandling, men kan miste vigtig tværmodal kontekst. Valget af fusionstrategi afhænger af de specifikke applikationskrav og datatyperne, der behandles.

Flere nøgleteknologier driver moderne multimodale AI-søgningssystemer og gør det muligt effektivt at behandle og integrere forskellige datatyper:

Disse teknologier arbejder sammen for at skabe systemer, der kan forstå komplekse relationer mellem forskellige informationstyper.

Multimodal AI-søgning har transformerende anvendelser på tværs af adskillige industrier og områder. I sundhedssektoren analyserer systemer medicinske billeder sammen med patientjournaler og kliniske notater for at forbedre diagnosticeringsnøjagtighed og behandlingsanbefalinger. E-handelsplatforme bruger multimodal søgning, så kunder kan finde produkter ved at kombinere tekstbeskrivelser med visuelle referencer eller endda skitser. Autonome køretøjer er afhængige af multimodal fusion af kamerafeeds, radardata og sensorinput for at navigere sikkert og træffe beslutninger i realtid. Indholdsmoderering kombinerer billedgenkendelse, tekstanalyse og lydbehandling for mere effektivt at identificere skadeligt indhold end enkeltmodale tilgange. Derudover forbedrer multimodal søgning tilgængeligheden ved at lade brugere søge med deres foretrukne inputmetode—stemme, billede eller tekst—mens systemet forstår hensigten på tværs af alle formater.

Multimodal AI-søgning giver betydelige fordele, der retfærdiggør den øgede kompleksitet og de større beregningskrav. Forbedret nøjagtighed opnås ved at udnytte komplementære informationskilder og reducere fejl, som enkeltmodale systemer kan begå. Forstærket kontekstforståelse opstår, når visuelle, tekstuelle og auditive informationer kombineres og giver en rigere semantisk mening. Bedre brugeroplevelse opnås gennem mere intuitive søgegrænseflader, der accepterer forskellige inputtyper og leverer mere relevante resultater. Læring på tværs af domæner bliver mulig, da viden fra én modalitet kan informere forståelsen i en anden, hvilket muliggør transferlæring på tværs af datatyper. Øget robusthed betyder, at systemet opretholder ydeevne, selv når én modalitet er forringet eller utilgængelig, da andre modaliteter kan kompensere for manglende information.

På trods af fordelene står multimodal AI-søgning over for betydelige tekniske og praktiske udfordringer. Datajustering og synkronisering er fortsat vanskeligt, da forskellige modaliteter ofte har forskellige tidsmæssige karakteristika og kvalitetsniveauer, der skal håndteres omhyggeligt. Beregningmæssig kompleksitet øges markant ved samtidig behandling af flere datastrømme, hvilket kræver betydelige ressourcer og specialiseret hardware. Bias og retfærdighed bliver et problem, når træningsdata indeholder ubalancer på tværs af modaliteter, eller når visse grupper er underrepræsenterede i specifikke datatyper. Privatliv og sikkerhed bliver mere komplekst med flere datastrømme, hvilket øger chancen for brud og kræver omhyggelig håndtering af følsomme data. Store datakrav betyder, at effektiv træning af multimodale systemer kræver væsentligt større og mere forskelligartede datasæt end unimodale alternativer, hvilket kan være dyrt og tidskrævende at indsamle og annotere.

Multimodal AI-søgning hænger tæt sammen med AI-overvågning og citatsporing, især i takt med at AI-systemer i stigende grad genererer svar, der refererer til eller syntetiserer information fra flere kilder. Platforme som AmICited.com fokuserer på at overvåge, hvordan AI-systemer citerer og tilskriver information til originale kilder og sikrer gennemsigtighed og ansvarlighed i AI-genererede svar. Ligeledes sporer FlowHunt.io AI-indholdsgenerering og hjælper organisationer med at forstå, hvordan deres brandede indhold bliver behandlet og refereret af multimodale AI-systemer. Efterhånden som multimodal AI-søgning bliver mere udbredt, bliver det afgørende for virksomheder at spore, hvordan disse systemer citerer brands, produkter og originale kilder for at forstå deres synlighed i AI-genererede resultater. Denne overvågningsfunktion hjælper organisationer med at verificere, at deres indhold bliver korrekt repræsenteret og tilskrevet, når multimodale AI-systemer syntetiserer information på tværs af tekst, billeder og andre modaliteter.

Fremtiden for multimodal AI-søgning peger mod en stadigt mere samlet og sømløs integration af forskellige datatyper, hvor man bevæger sig ud over nuværende fusionstilgange og mod mere holistiske modeller, der behandler alle modaliteter som indbyrdes forbundne. Realtidsbehandlingsmuligheder vil blive udvidet, så multimodal søgning kan fungere på live videostrømme, kontinuerlig lyd og dynamisk tekst samtidigt uden forsinkelse. Avancerede dataforstærkningsteknikker vil adressere nuværende datamangel ved syntetisk at generere multimodale træningseksempler, der bevarer semantisk konsistens på tværs af modaliteter. Nye udviklinger inkluderer grundmodeller trænet på store multimodale datasæt, som effektivt kan tilpasses specifikke opgaver, neuromorfe beregningstilgange, der i højere grad efterligner biologisk multimodal behandling, og fødereret multimodal læring, der muliggør træning på tværs af distribuerede datakilder under hensyntagen til privatliv. Disse fremskridt vil gøre multimodal AI-søgning mere tilgængelig, effektiv og i stand til at håndtere stadig mere komplekse virkelige scenarier.

Unimodale AI-systemer behandler kun én type dataindgang, såsom tekstbaserede søgemaskiner. Multimodale AI-systemer derimod behandler og integrerer flere datatyper—tekst, billeder, lyd og video—samtidigt, hvilket muliggør dybere forståelse og mere præcise resultater ved at udnytte de komplementære styrker ved forskellige dataformater.

Multimodal AI-søgning forbedrer nøjagtigheden ved at kombinere komplementære informationskilder, der opfanger nuancer og relationer, som enkeltmodale tilgange ikke kan se. Når visuel, tekstuel og auditiv information kombineres, opnår systemet en rigere semantisk forståelse og kan træffe mere informerede beslutninger baseret på flere perspektiver af den samme information.

Væsentlige udfordringer inkluderer datajustering og synkronisering på tværs af forskellige modaliteter, betydelig beregningsmæssig kompleksitet, bias og retfærdighedsproblemer, når træningsdataene er ubalancerede, privatlivs- og sikkerhedsproblemer med flere datastrømme og massive datakrav for effektiv træning. Hver modalitet har forskellige tidsmæssige karakteristika og kvalitetsniveauer, der skal håndteres nøje.

Sundhedssektoren drager fordel af at analysere medicinske billeder sammen med patientjournaler og kliniske notater. E-handel bruger multimodal søgning til visuel produktopdagelse. Autonome køretøjer er afhængige af multimodal fusion af kameraer, radar og sensorer. Indholdsmoderering kombinerer billede-, tekst- og lydanalyse. Kundeservicesystemer udnytter flere inputtyper for bedre support, og tilgængelighedsapps giver brugere mulighed for at søge med deres foretrukne inputmetode.

Embedding-modeller konverterer forskellige modaliteter til numeriske repræsentationer, der fanger semantisk betydning. Vektordatabaser lagrer disse embeddings i et fælles matematisk rum, hvor relationer mellem forskellige datatyper kan måles og sammenlignes. Dette gør det muligt for systemet at finde forbindelser mellem tekst, billeder, lyd og video ved at sammenligne deres positioner i dette fælles semantiske rum.

Multimodale AI-systemer håndterer flere følsomme datatyper—optagede samtaler, ansigtsgenkendelsesdata, skriftlig kommunikation og medicinske billeder—hvilket øger privatlivsrisici. Kombinationen af forskellige modaliteter skaber flere muligheder for databrud og kræver streng overholdelse af regler som GDPR og CCPA. Organisationer skal implementere robuste sikkerhedsforanstaltninger for at beskytte brugeridentitet og følsomme oplysninger på tværs af alle modaliteter.

Platforme som AmICited.com overvåger, hvordan AI-systemer citerer og tilskriver information til originale kilder og sikrer gennemsigtighed i AI-genererede svar. Organisationer kan følge deres synlighed i multimodale AI-søgeresultater, verificere at deres indhold bliver korrekt repræsenteret og bekræfte korrekt tilskrivning, når AI-systemer syntetiserer information på tværs af tekst, billeder og andre modaliteter.

Fremtiden inkluderer samlede modeller, der behandler alle modaliteter som indbyrdes forbundne, realtidsbehandling af live video- og lydstrømme, avancerede dataforstærkningsteknikker til at håndtere datamangel, grundmodeller trænet på store multimodale datasæt, neuromorfe beregningstilgange, der efterligner biologisk behandling, og fødereret læring, der bevarer privatlivets fred, mens der trænes på tværs af distribuerede kilder.

Spor hvordan multimodale AI-søgemaskiner citerer og tilskriver dit indhold på tværs af tekst, billeder og andre modaliteter med AmICiteds omfattende overvågningsplatform.

Bliv ekspert i optimering af multimodal AI-søgning. Lær, hvordan du optimerer billeder og stemmeforespørgsler til AI-drevne søgeresultater, med strategier til G...

Lær hvad multi-modal indhold for AI er, hvordan det fungerer, og hvorfor det er vigtigt. Udforsk eksempler på multi-modale AI-systemer og deres anvendelse på tv...

Lær hvordan du optimerer tekst, billeder og video til multimodale AI-systemer. Opdag strategier til at forbedre AI-citater og synlighed på tværs af ChatGPT, Gem...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.