Hvilke Tillidsfaktorer Bruger AI-Motorer til at Vurdere Kilder

Opdag, hvordan AI-motorer som ChatGPT, Perplexity og Google AI vurderer kilders troværdighed. Lær om E-E-A-T, domæneautoritet, citeringsfrekvens og andre kritis...

AI-vurdering af indholds troværdighed baseret på forfatterens kvalifikationer, citater og verifikation. Vurdering af kilders troværdighed analyserer systematisk flere dimensioner, herunder forfatterens ekspertise, udgiverens omdømme, citatmønstre og resultatet af faktatjek for at afgøre, om informationskilder fortjener at indgå i forskning, vidensbaser eller AI-genererede resuméer. Denne automatiserede proces gør det muligt for platforme at skalere vurderingen af troværdighed på tværs af millioner af kilder og samtidig opretholde en ensartethed, som menneskelige bedømmere alene ikke kan opnå.

AI-vurdering af indholds troværdighed baseret på forfatterens kvalifikationer, citater og verifikation. Vurdering af kilders troværdighed analyserer systematisk flere dimensioner, herunder forfatterens ekspertise, udgiverens omdømme, citatmønstre og resultatet af faktatjek for at afgøre, om informationskilder fortjener at indgå i forskning, vidensbaser eller AI-genererede resuméer. Denne automatiserede proces gør det muligt for platforme at skalere vurderingen af troværdighed på tværs af millioner af kilder og samtidig opretholde en ensartethed, som menneskelige bedømmere alene ikke kan opnå.

Vurdering af kilders troværdighed er den systematiske evaluering af informationskilder med henblik på at fastslå deres pålidelighed, troværdighed og autoritet i forhold til at levere nøjagtig information. I konteksten af AI-drevne systemer indebærer troværdighedsvurdering analyse af flere dimensioner af en kilde for at vurdere, om dens indhold fortjener at indgå i forskning, citater eller vidensbaser. AI-troværdighedsvurdering fungerer ved at undersøge forfatterens kvalifikationer—herunder uddannelsesmæssig baggrund, professionel erfaring og ekspertise inden for emnet—sammen med citatmønstre, der viser, hvor ofte og positivt andre autoritative kilder refererer til arbejdet. Processen vurderer verifikationsmekanismer såsom peer review-status, institutionel tilknytning og udgivelseskanalens omdømme for at etablere en grundlæggende troværdighed. Troværdighedssignaler er de målbare indikatorer, som AI-systemer registrerer og vægter, der spænder fra eksplicitte markører som forfatterkvalifikationer til implicitte signaler udledt fra tekstanalyse og metadatamønstre. Moderne AI-systemer anerkender, at troværdighed er multidimensionel; en kilde kan være særdeles troværdig på ét område, men mangle autoritet på et andet, hvilket kræver kontekstafhængig vurdering. Vurderingsprocessen er blevet stadig vigtigere i takt med, at informationsmængden eksploderer, og misinformation spreder sig hurtigt på digitale platforme. Automatiseret troværdighedsvurdering gør det muligt for platforme at skalere vurderingen på tværs af millioner af kilder, mens de opretholder en ensartethed, som menneskelige bedømmere alene ikke kan opnå. Forståelse for, hvordan disse systemer fungerer, hjælper indholdsskabere, forskere og udgivere med at optimere deres kilder til troværdighedsanerkendelse og hjælper forbrugere med at træffe informerede beslutninger om informationspålidelighed.

AI-systemer vurderer kilders troværdighed gennem sofistikeret flersignal-analyse, der kombinerer naturlig sprogbehandling, maskinlæringsmodeller og evaluering af strukturerede data. Detektion af troværdighedssignaler identificerer specifikke markører i tekst, metadata og netværksmønstre, der korrelerer med pålidelig information; disse signaler vægtes ud fra deres forudsigelsesværdi for nøjagtighed. NLP-analyse undersøger sproglige mønstre, citattæthed, præcision af påstande og sproglig sikkerhed for at vurdere, om indholdet bærer præg af grundig forskning, eller om det udviser karakteristika, der er almindelige for utroværdige kilder. Maskinlæringsmodeller, der er trænet på store datasæt med verificerede troværdige og utroværdige kilder, lærer at genkende komplekse mønstre, som mennesker kan overse, hvilket muliggør realtidsvurdering i stor skala. Integration af faktatjek krydstjekker påstande mod verificerede databaser og etablerede fakta og markerer modsigelser eller uunderbyggede påstande, som sænker troværdighedsscoren. Disse systemer anvender ensemble-metoder, der kombinerer flere evalueringsmetoder, idet de erkender, at intet enkelt signal perfekt forudsiger troværdighed. Følgende tabel illustrerer de primære signaltyper, som AI-systemer analyserer:

| Signaltype | Hvad måler det | Eksempler |

|---|---|---|

| Akademiske signaler | Peer review-status, udgivelseskanal, institutionel tilknytning | Journal impact factor, konference-rangering, universitetsomdømme |

| Tekstuelle signaler | Sproglig kvalitet, citattæthed, præcision af påstande, sprogmønstre | Korrekte citater, teknisk terminologi, evidensbaserede udsagn |

| Metadata-signaler | Forfatterkvalifikationer, udgivelsesdato, opdateringsfrekvens, kildehistorik | Forfattergrader, udgivelsestidslinje, revisionshistorik |

| Sociale signaler | Antal citater, delingsmønstre, ekspertanbefalinger, samfundsengagement | Google Scholar-citater, omtale i akademiske netværk, anbefalinger fra fagfæller |

| Verifikationssignaler | Resultat af faktatjek, bekræftelse af påstande, gennemsigtighed i kilde | Snopes-verifikation, flere uafhængige bekræftelser, metodeafsløring |

| Strukturelle signaler | Indholdsstruktur, metodisk klarhed, oplysning om interessekonflikter | Klare afsnit, gennemsigtige metoder, gennemsigtighed om finansiering |

De mest indflydelsesrige troværdighedsfaktorer, som AI-systemer vurderer, omfatter flere indbyrdes forbundne dimensioner, der tilsammen etablerer kildens pålidelighed. Forfatterens omdømme tjener som et grundlæggende troværdighedsmærke, idet etablerede eksperter inden for deres felt vægtes langt højere end ukendte bidragsydere. Udgiverens omdømme udvider troværdighedsvurderingen til den institutionelle kontekst og anerkender, at kilder udgivet gennem peer-reviewede tidsskrifter eller anerkendte akademiske forlag viser højere grundlæggende troværdighed. Citatmønstre afslører, hvordan det bredere forskningsmiljø har engageret sig med kilden; ofte citerede værker i anerkendte kanaler indikerer fællesskabets anerkendelse af forskningens kvalitet. Aktualitet er kontekstafhængig—nyere publikationer demonstrerer opdateret viden, mens ældre grundværker bevarer troværdighed på grund af deres historiske betydning og vedvarende relevans. Bias-detektion algoritmer undersøger, om kilder oplyser potentielle interessekonflikter, finansieringskilder eller ideologiske holdninger, der kan påvirke deres konklusioner. Engagementssignaler fra det akademiske og professionelle miljø, herunder citater og faglig diskussion, giver ekstern validering af troværdighed. Følgende faktorer repræsenterer de vigtigste elementer, som AI-systemer prioriterer:

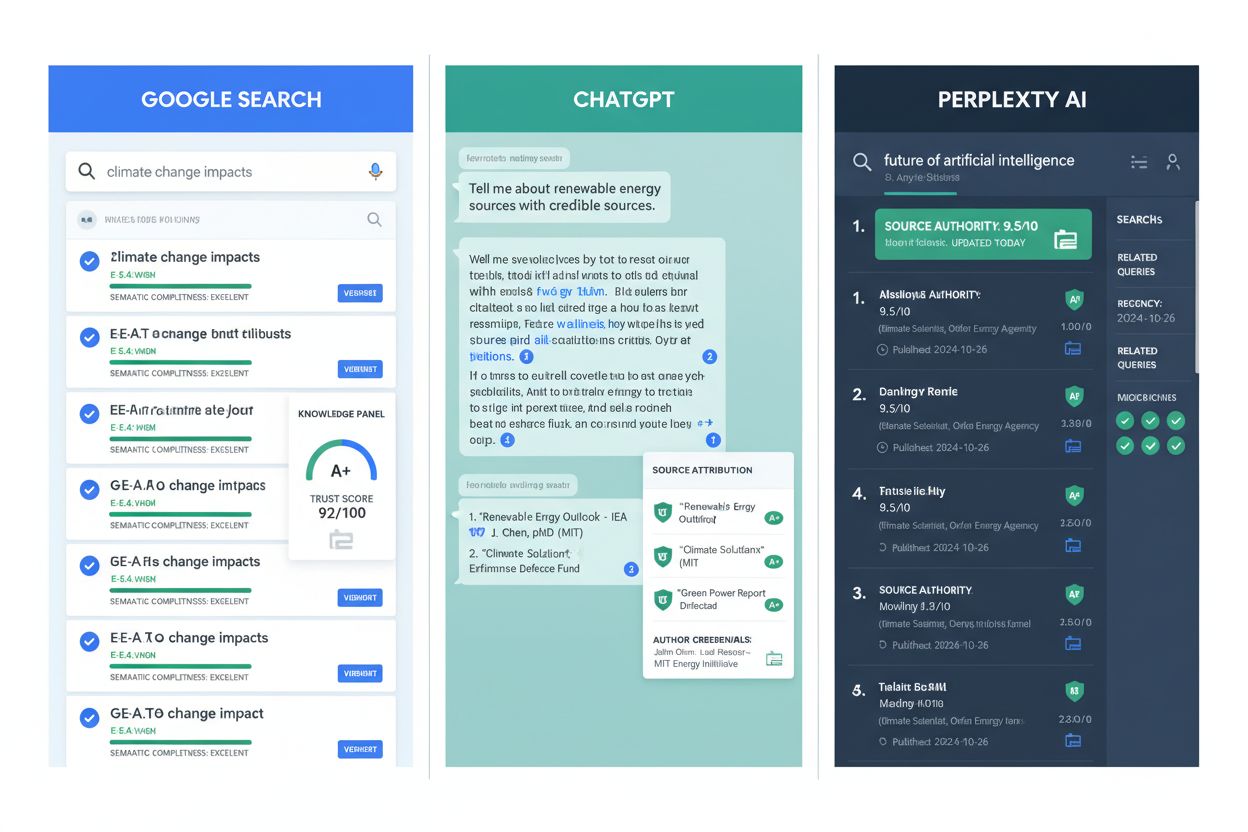

AI-drevet troværdighedsvurdering er blevet en integreret del af større informationsplatforme og forskningsinfrastruktur. Google AI Overblik bruger troværdighedssignaler til at afgøre, hvilke kilder der indgår i AI-genererede resuméer og prioriterer indhold fra etablerede udgivere og verificerede eksperter. ChatGPT og lignende sprogmodeller anvender troværdighedsvurdering under træning for at vægte kilder korrekt, dog med udfordringer i realtidsvurdering af nye påstande. Perplexity AI integrerer eksplicit kildetroværdighed i sin citatmetode og viser kildens omdømme sammen med søgeresultater for at hjælpe brugere med at vurdere informationskvaliteten. I akademisk forskning hjælper troværdighedsvurderingsværktøjer forskere med hurtigere at identificere kvalitetskilder og dermed mindske tiden på litteratursøgning og forbedre forskningsgrundlaget. Indholdsbevaringsinitiativer bruger troværdighedsvurdering til at prioritere arkivering af autoritative kilder, så fremtidige forskere har adgang til pålidelige historiske informationer. AmICited.com fungerer som en overvågningsløsning, der sporer, hvordan kilder citeres og vurderes på tværs af platforme og hjælper udgivere med at forstå deres troværdighedsstatus og identificere forbedringsmuligheder. Faktatjek-organisationer udnytter automatiseret troværdighedsvurdering til at prioritere påstande for manuel verifikation og fokusere menneskelige ressourcer på misinformation med stor gennemslagskraft. Uddannelsesinstitutioner bruger i stigende grad troværdighedsvurderingsværktøjer til at lære studerende at vurdere kilder, så de implicitte kriterier gøres eksplicitte og målbare. Disse anvendelser viser, at troværdighedsvurdering er gået fra teoretisk ramme til praktisk infrastruktur, der understøtter informationskvalitet i digitale økosystemer.

På trods af betydelige fremskridt står automatiseret troværdighedsvurdering over for væsentlige begrænsninger, der kræver menneskelig overvågning og kontekstuel vurdering. Bias i engagementssignaler udgør en grundlæggende udfordring; populære kilder kan få høje troværdighedsscorer på baggrund af sociale signaler, selvom de indeholder unøjagtig information, da engagementsmålinger kun delvist korrelerer med nøjagtighed. Falske positive og negative opstår, når troværdighedsalgoritmer fejlklassificerer kilder—etablerede eksperter i nye fagfelter kan mangle citathistorik, mens produktive misinformation-skabere udvikler sofistikerede troværdighedssignaler. Udviklende misinformationstaktikker udnytter bevidst troværdighedssystemer ved at efterligne legitime kilder, skabe falske forfatterprofiler og fabrikere citater, der kan narre automatiserede systemer. Faglig variation i troværdighed betyder, at en kilde, der er troværdig inden for ét felt, kan mangle autoritet i et andet, og alligevel anvender systemer nogle gange ensartede troværdighedsscorer på tværs af områder. Tidsmæssige dynamikker komplicerer vurderingen; kilder, der var troværdige ved udgivelsen, kan blive forældede eller miskrediterede, efterhånden som ny viden opstår, hvilket kræver løbende revurdering i stedet for statiske scorer. Kulturel og sproglig bias i træningsdata betyder, at troværdighedssystemer kan undervurdere kilder fra ikke-engelsktalende regioner eller underrepræsenterede miljøer og dermed fastholde eksisterende informationshierarkier. Gennemsigtighedsudfordringer opstår, fordi mange troværdighedsalgoritmer fungerer som black boxes, hvilket gør det svært for kilder at forstå, hvordan de kan forbedre deres troværdighedssignaler, eller for brugere at forstå, hvorfor visse kilder har fået bestemte scorer. Disse begrænsninger understreger, at automatiseret troværdighedsvurdering bør supplere—ikke erstatte—menneskelig kritisk vurdering.

Indholdsskabere og udgivere kan markant forbedre deres troværdighedssignaler ved at implementere evidensbaserede praksisser, der stemmer overens med, hvordan AI-systemer vurderer troværdighed. Implementér E-E-A-T-principper—vis erfaring, ekspertise, autoritet og troværdighed—ved tydeligt at vise forfatterkvalifikationer, professionelle tilknytninger og relevante kvalifikationer på indholdssider. Korrekt citatpraksis styrker troværdigheden ved at linke til kvalitetskilder, anvende ensartede citatformater og sikre, at alle påstande refererer til verificerbar evidens; dette signalerer, at indholdet bygger på etableret viden og ikke spekulation. Gennemsigtighed omkring metode hjælper AI-systemer med at genkende grundig forskning; forklar klart datakilder, forskningsmetoder, begrænsninger og potentielle interessekonflikter. Vedligehold forfatterprofiler med detaljeret biografi, publikationer og professionelle kvalifikationer, som AI-systemer kan verificere og vurdere. Opdater indhold regelmæssigt for at vise engagement i nøjagtighed; forældet information sænker troværdighedsscoren, mens løbende rettelser signalerer, at du følger udviklingen inden for dit felt. Oplys finansieringskilder og tilknytninger eksplicit, da gennemsigtighed om potentielle bias faktisk øger troværdigheden—AI-systemer anerkender, at oplyste konflikter er mindre problematiske end skjulte. Opbyg citatautoritet ved at publicere i anerkendte kanaler, gennemgå peer review og opnå citater fra andre troværdige kilder; dette skaber positive feedback-loops, hvor troværdighed avler troværdighed. Engagér dig med det professionelle samfund gennem konferencer, samarbejde og faglig diskussion, da disse engagementssignaler validerer ekspertise og øger synligheden over for troværdighedssystemer. Implementér struktureret datamarkering med schema.org og lignende standarder, så AI-systemer automatisk kan udtrække og verificere forfatterinformation, udgivelsesdatoer og andre troværdighedssignaler.

Udviklingen af vurdering af kilders troværdighed vil i stigende grad inkludere multimodal evaluering, hvor tekst, billeder, video og lyd analyseres samlet for at opdage sofistikeret misinformation, der udnytter enkelttype-analyse. Realtidsverifikationssystemer vil blive integreret med indholdsskabelsesplatforme, så skabere får øjeblikkelig feedback om troværdighed, mens de publicerer, og kan rette fejl, før misinformation spredes. Blockchain-baseret troværdighedssporing kan give uforanderlige optegnelser over kildehistorik, citater og rettelser, hvilket skaber en gennemsigtig troværdighedsproveniens, som AI-systemer kan vurdere med større sikkerhed. Personliggjort troværdighedsvurdering vil gå ud over ensartede scorer og i stedet vurdere kilder i forhold til den enkelte brugers ekspertise og behov, idet troværdighed også er subjektiv og kontekstafhængig. Integration med vidensgrafer vil gøre det muligt for AI-systemer at evaluere kilder ikke kun isoleret, men i netværk med relateret information, så de kan identificere kilder, der modsiger etableret viden eller udfylder væsentlige huller. Forklarlige AI-troværdighedssystemer vil blive standard, så der gives gennemsigtige forklaringer på, hvorfor kilder fik bestemte troværdighedsscorer, hvilket gør det muligt for skabere at forbedre sig og brugere at forstå vurderingsgrundlaget. Kontinuerligt lærende systemer vil tilpasse sig nye misinformationstaktikker i realtid og opdatere vurderingsmodeller, efterhånden som nye manipulationsteknikker opstår, frem for at være afhængige af statiske træningsdata. Troværdighedssporing på tværs af platforme vil skabe samlede troværdighedsprofiler, der følger kilder over hele internettet, så det bliver sværere for aktører med dårlige hensigter at opretholde forskellige omdømmer på forskellige platforme. Disse udviklinger vil gøre troværdighedsvurdering stadig mere sofistikeret, gennemsigtig og integreret i den informationsinfrastruktur, som milliarder af mennesker dagligt er afhængige af.

Vurdering af kilders troværdighed er den systematiske evaluering af informationskilder for at afgøre deres pålidelighed og troværdighed. AI-systemer analyserer flere dimensioner, herunder forfatterkvalifikationer, udgiverens omdømme, citatmønstre og resultatet af faktatjek for at fastslå, om kilder fortjener at indgå i forskning, vidensbaser eller AI-genererede resuméer. Denne automatiserede proces gør det muligt for platforme at vurdere millioner af kilder konsekvent.

AI-systemer opdager troværdighedssignaler gennem naturlig sprogbehandling, maskinlæringsmodeller og analyse af strukturerede data. De undersøger akademiske signaler (peer review-status, institutionel tilknytning), tekstuelle signaler (citat-tæthed, præcision af påstande), metadata-signaler (forfatterkvalifikationer, udgivelsesdatoer), sociale signaler (citatantal, ekspertanbefalinger) og verifikationssignaler (resultat af faktatjek, bekræftelse af påstande). Disse signaler vægtes efter deres forudsigelsesværdi for nøjagtighed.

De mest afgørende troværdighedsfaktorer omfatter forfatterens omdømme og ekspertise, udgiverens omdømme, antal og kvalitet af citater, aktualitet og relevans, åbenhed om bias og interessekonflikter, engagementssignaler fra det professionelle samfund, kildeverifikation gennem faktatjek, integration af baggrundsviden, skaberens tilknytning til anerkendte institutioner og opdateringsfrekvens. Disse faktorer tilsammen fastlægger kildens pålidelighed og troværdighed.

Udgivere kan forbedre troværdigheden ved at implementere E-E-A-T-principper (Experience, Expertise, Authoritativeness, Trustworthiness), bruge korrekte citatpraksisser, opretholde gennemsigtig metode, vise detaljerede forfatterprofiler med kvalifikationer, opdatere indhold regelmæssigt, oplyse finansieringskilder og tilknytninger, opbygge citatautoritet gennem peer review, engagere sig med det professionelle samfund og implementere struktureret datamarkering, så AI-systemer kan udtrække troværdighedsinformation.

Automatiseret troværdighedsvurdering står over for udfordringer såsom bias i engagementssignaler (populære kilder kan få høj score trods unøjagtigheder), falske positive og negative, udviklende misinformationstaktikker der efterligner legitime kilder, faglig variation i troværdighed, tidsmæssige dynamikker da kilder forældes, kulturel og sproglig bias i træningsdata samt gennemsigtighedsudfordringer med black-box-algoritmer. Disse begrænsninger betyder, at automatiseret vurdering bør supplere og ikke erstatte menneskelig kritisk evaluering.

Google AI Overblik prioriterer kilder med etablerede udgivere og verificerede eksperter til AI-genererede resuméer. ChatGPT vægter kilder under træning baseret på troværdighedssignaler. Perplexity viser eksplicit kildeomdømme sammen med søgeresultater. AmICited.com overvåger, hvordan kilder citeres på alle større AI-platforme og hjælper udgivere med at forstå deres troværdighedsstatus og identificere forbedringsmuligheder.

Fremtidige udviklinger inkluderer multimodal evaluering, der analyserer tekst, billeder, video og lyd samlet; realtidsverifikationssystemer, der giver øjeblikkelig troværdighedsfeedback; blockchain-baseret troværdighedssporing; personliggjort vurdering af troværdighed i forhold til brugerens ekspertise; integration med vidensgrafer; forklarlige AI-systemer med gennemsigtig scoringsbegrundelse; kontinuerligt lærende systemer, der tilpasser sig nye misinformationstaktikker; samt troværdighedssporing på tværs af platforme, der skaber samlede profiler.

Vurdering af kilders troværdighed er afgørende, fordi det bestemmer, hvilke kilder der optræder i AI-genererede resuméer, påvirker AI's træningsdata og former den information, milliarder af mennesker møder. Præcis troværdighedsvurdering hjælper med at forhindre spredning af misinformation, sikrer at AI-systemer giver pålidelig information, understøtter kvaliteten af akademisk forskning og opretholder tillid til AI-drevne informationssystemer. Efterhånden som AI får større indflydelse på informationssøgning, bliver troværdighedsvurdering stadig vigtigere.

Følg hvordan dine kilder bliver citeret og vurderet på Google AI Overblik, ChatGPT, Perplexity og Gemini. AmICited.com hjælper dig med at forstå din troværdighedsstatus og identificere muligheder for forbedring.

Opdag, hvordan AI-motorer som ChatGPT, Perplexity og Google AI vurderer kilders troværdighed. Lær om E-E-A-T, domæneautoritet, citeringsfrekvens og andre kritis...

Lær hvordan du opbygger tillidssignaler for AI-søgemaskiner som ChatGPT, Perplexity og Google AI Overviews. Opdag E-E-A-T principper, autoritetssignaler og cita...

Opdag hvilke kilder AI-motorer citerer oftest. Lær hvordan ChatGPT, Google AI Overviews og Perplexity vurderer kilders troværdighed, og forstå citationmønstre p...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.