GPTBot

Erfahren Sie, was GPTBot ist, wie er funktioniert und ob Sie ihn von Ihrer Website blockieren sollten. Verstehen Sie die Auswirkungen auf SEO, Serverlast und Ma...

Erfahren Sie, was GPTBot ist, wie er funktioniert und ob Sie den Webcrawler von OpenAI zulassen oder blockieren sollten. Verstehen Sie die Auswirkungen auf Ihre Markenpräsenz in KI-Suchmaschinen und ChatGPT.

GPTBot ist der Webcrawler von OpenAI, der Daten von öffentlich zugänglichen Websites sammelt, um KI-Modelle wie ChatGPT zu trainieren. Ob Sie ihn zulassen sollten, hängt von Ihren Prioritäten ab: Erlauben Sie ihn für bessere Markenpräsenz in KI-Suchergebnissen und ChatGPT-Antworten, oder blockieren Sie ihn, wenn Sie Bedenken hinsichtlich der Nutzung Ihrer Inhalte, des geistigen Eigentums oder der Serverressourcen haben.

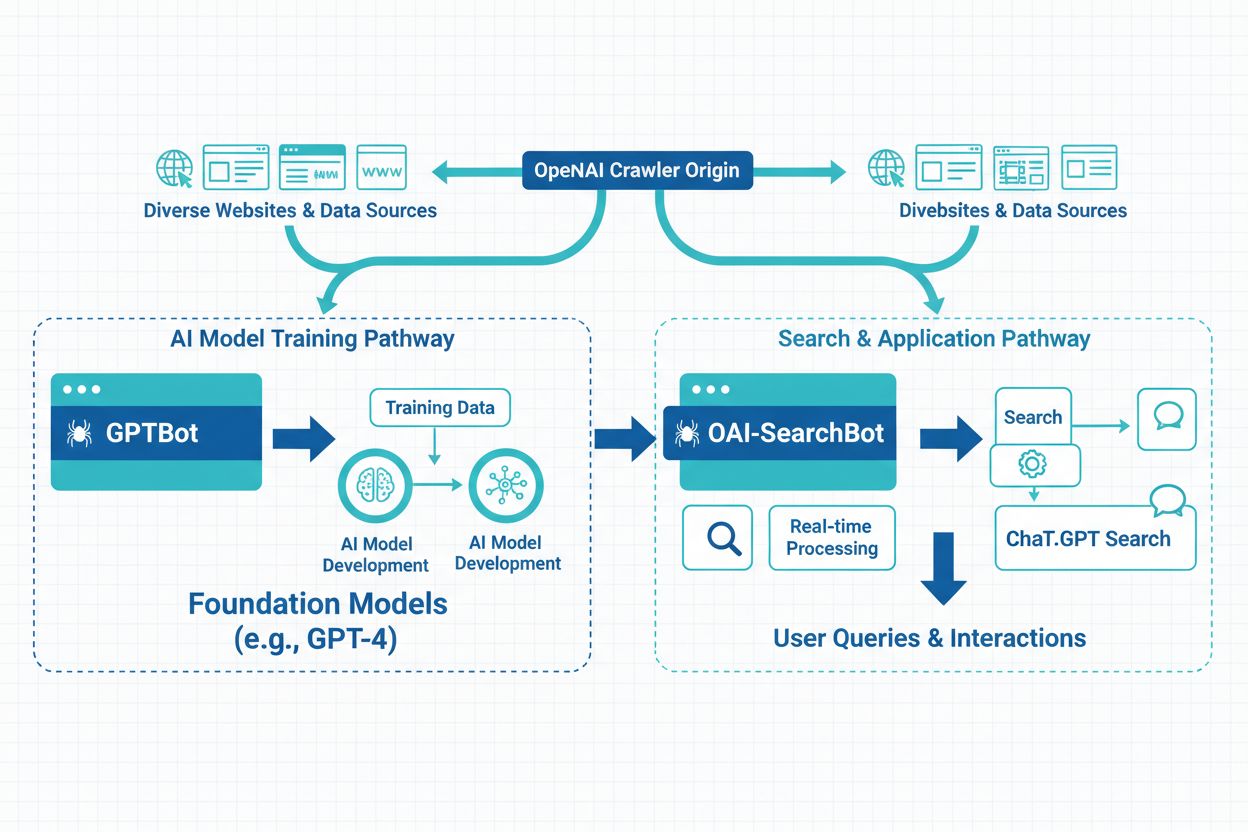

GPTBot ist der offizielle Webcrawler von OpenAI, der entwickelt wurde, um öffentlich zugängliche Websites systematisch zu durchsuchen und Daten zum Training großer Sprachmodelle wie ChatGPT und GPT-4 zu sammeln. Im Gegensatz zu traditionellen Suchmaschinen-Crawlern wie Googlebot, die Inhalte für Suchergebnisse indexieren, verfolgt GPTBot einen grundsätzlich anderen Zweck: Er sammelt Informationen, um das Verständnis der KI für Sprachmuster, aktuelle Ereignisse und Weltwissen zu verbessern. Wenn GPTBot Ihre Website besucht, identifiziert er sich mit einer klaren User-Agent-Zeichenfolge, die in Ihren Server-Logs als Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; GPTBot/1.3; +https://openai.com/gptbot) erscheint, wodurch Webmastern die Erkennung und Überwachung seiner Aktivitäten erleichtert wird.

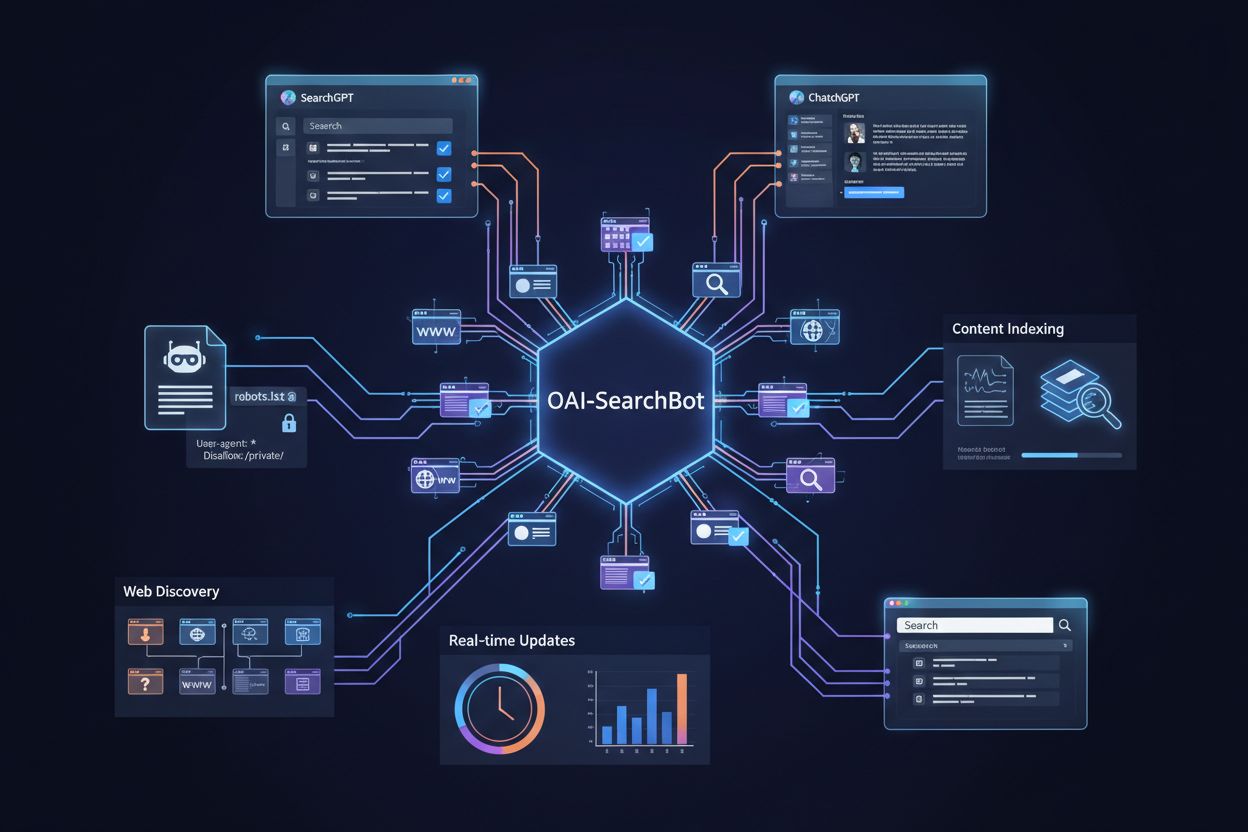

Der Crawler arbeitet transparent und respektiert etablierte Webstandards. Bevor er auf Inhalte Ihrer Seite zugreift, prüft GPTBot Ihre robots.txt-Datei, das Standardtool, mit dem Webmaster automatisierten Bots mitteilen, welche Bereiche ihrer Website zugänglich sind und welche nicht. Wenn Sie eine Disallow-Regel für GPTBot in Ihrer robots.txt-Datei eintragen, respektiert der Crawler Ihre Präferenz und greift nicht auf Ihre Seite zu. Diese freiwillige Befolgung der robots.txt zeigt das Engagement von OpenAI für verantwortungsbewusstes Crawling, wobei die Durchsetzung letztlich von der Integrität des Crawler-Betreibers abhängt.

GPTBot durchsucht ausschließlich öffentlich zugängliche Inhalte und kann keine Paywalls, Login-Seiten oder geschützte Bereiche Ihrer Website umgehen. Der Crawler versucht nicht, auf private Informationen, authentifizierte Bereiche oder als privat markierte Inhalte zuzugreifen. Diese Einschränkung bedeutet, dass sensible Daten, nur für Mitglieder verfügbare Inhalte und abonnementsbasierte Materialien vor dem Zugriff von GPTBot geschützt bleiben. Die von GPTBot gesammelten Informationen werden ausschließlich verwendet, um das Sprachverständnis, den Kontextbezug und das aktuelle Weltwissen der KI zu verbessern, ohne direkte Auswirkungen auf Ihr Ranking in traditionellen Suchmaschinen oder auf die Darstellung Ihrer Seite in den Google-Suchergebnissen.

Aktuelle Daten zeigen den dramatischen Anstieg von GPTBot als dominanter Kraft im Web-Crawling. Zwischen Mai 2024 und Mai 2025 stieg der Anteil von GPTBot am KI-Crawler-Traffic von nur 5 % auf 30 %, was einem enormen Anstieg der Anfragen um 305 % entspricht. Dieses explosive Wachstum spiegelt die massiven Investitionen von OpenAI in die Sammlung von Trainingsdaten und die zunehmende Bedeutung von KI-Modellen im digitalen Ökosystem wider. GPTBot ist heute der zweitmeist blockierte Crawler im Web und der meistblockierte Crawler über robots.txt-Dateien, wobei mehr als 3,5 % aller Websites derzeit Blockierregeln gegen ihn implementieren.

Große Publisher und Content-Ersteller haben diesen Trend erkannt. Die New York Times, CNN und mehr als 30 der Top 100 Websites haben bereits Blockierregeln gegen GPTBot eingerichtet, was wachsende Bedenken hinsichtlich der Nutzung von Inhalten und Urheberrechten signalisiert. Dieser Blockiertrend erzählt jedoch nicht die ganze Geschichte. Während einige Websites GPTBot als Bedrohung für ihr Geschäftsmodell betrachten, sehen andere darin eine Chance, ihre Inhalte den Milliarden von Nutzern zugänglich zu machen, die täglich mit ChatGPT und anderen KI-Systemen interagieren. Die Entscheidung, GPTBot zuzulassen oder zu blockieren, ist zu einer strategischen Wahl geworden, die die Werte, das Geschäftsmodell und die langfristige Vision jeder Organisation für ihre digitale Präsenz widerspiegelt.

| Kennzahl | Wert | Bedeutung |

|---|---|---|

| GPTBot-Wachstum (Mai 2024 - Mai 2025) | +305% | Am schnellsten wachsender KI-Crawler |

| Aktueller Anteil am KI-Crawler-Traffic | 30% | Dominanter KI-Crawler nach Volumen |

| Websites, die GPTBot blockieren | 3,5%+ | Zweitmeist blockierter Crawler |

| Top-100-Websites mit Blockierung | 30+ | Große Publisher blockieren den Zugang |

| Wöchentliche Nutzer von ChatGPT | 800 Millionen | Potenzielle Reichweite des Publikums |

Website-Betreiber entscheiden sich aus mehreren berechtigten und miteinander verbundenen Gründen dafür, GPTBot zu blockieren. Die wichtigste Sorge betrifft die Nutzung von Inhalten ohne Entschädigung. Die Veröffentlichung hochwertiger Inhalte erfordert erhebliche Zeit, Ressourcen und Fachwissen. Wenn KI-Systeme diese Arbeit nutzen, um Modelle zu trainieren, die Benutzerfragen beantworten – oft ohne Verweis auf die ursprüngliche Quelle –, empfinden viele Content-Ersteller dies als grundsätzlich unfair. Besonders betroffen sind Publisher, Journalisten und spezialisierte Content-Ersteller, die auf Traffic und Attribution angewiesen sind, um ihr Geschäft zu betreiben. Sie befürchten, dass Nutzer durch die direkte Beantwortung von Fragen durch KI-Systeme weniger Anreiz haben, die Originalseiten zu besuchen, was den Traffic verringert und die ursprüngliche Investition in Inhalte entwertet.

Sicherheits- und Serverressourcen-Bedenken sind ein weiterer wichtiger Faktor bei Blockier-Entscheidungen. Auch wenn GPTBot wie andere Crawler robots.txt-Regeln beachtet, bleiben Fragen zur kumulativen Belastung, wenn mehrere KI-Crawler Ihre Inhalte gleichzeitig abfragen. Crawler wie GPTBot und ClaudeBot können erhebliche Bandbreite verbrauchen – manche Websites berichten von Trafficspitzen bis zu 30 Terabyte, was besonders für Server in Shared-Hosting-Umgebungen belastend ist. Selbst wenn GPTBot selbst nicht böswillig ist, erhöht jeder zusätzliche automatisierte Zugriff die Komplexität von Überwachung, Firewall-Konfiguration und Bot-Management. Hinzu kommt die Sorge um Datenexponierung durch Pattern Matching, bei dem scheinbar harmlose Inhalte durch maschinelles Lernen kombiniert und analysiert mehr preisgeben, als beabsichtigt war.

Rechtliche Unsicherheit sorgt bei vielen Website-Betreibern für zusätzliche Zurückhaltung. KI-gestützte Tools wie GPTBot bewegen sich in einem Graubereich hinsichtlich Datenschutz, Urheberrecht und geistigem Eigentum. Manche Marketer befürchten, dass das Zulassen von GPTBot beim Scraping von Inhalten unbeabsichtigt gegen Vorschriften wie die DSGVO oder CCPA verstoßen könnte, insbesondere wenn personenbezogene Daten oder nutzergenerierte Inhalte betroffen sind. Auch wenn die Inhalte öffentlich zugänglich sind, ist die rechtliche Bewertung des Fair Use für das KI-Training ungeklärt und umstritten. Die Frage des geistigen Eigentums verschärft die Problematik: Wenn Ihre Originaltexte in einer ChatGPT-Antwort paraphrasiert erscheinen, wem gehört dann dieses Ergebnis? Derzeit gibt es dafür noch keinen eindeutigen rechtlichen Präzedenzfall. Für Unternehmen in regulierten Branchen wie Finanzen, Gesundheitswesen oder Recht ist es daher oft strategisch sinnvoll, den Zugriff zu blockieren, bis sich die Rechtslage weiterentwickelt hat.

Trotz berechtigter Bedenken gibt es überzeugende Gründe, GPTBot den Zugriff auf Ihre Inhalte zu gestatten. Der größte Vorteil ist die Markenpräsenz in ChatGPT und KI-basierten Suchergebnissen. ChatGPT hat etwa 800 Millionen wöchentliche Nutzer und verarbeitet monatlich Milliarden von Anfragen. Viele dieser Nutzer stellen Fragen, die Sie mit Ihren Inhalten beantworten können. Wenn GPTBot Ihre Seite nicht durchsuchen darf, greift das Modell auf zweitrangige Informationen oder veraltete Quellen zurück, um über Ihre Marke, Produkte oder Ihr Fachwissen zu sprechen. Das ist eine verpasste Chance und birgt ein potenzielles Reputationsrisiko. Wenn Sie GPTBot das Crawlen Ihrer Inhalte erlauben, stellen Sie sicher, dass die Antworten von ChatGPT Ihre Botschaften, Angebote und Ihr Know-how korrekt widerspiegeln. Dies ist im Grunde automatisiertes Reputationsmanagement – Ihre Inhalte werden in einem der weltweit am häufigsten genutzten KI-Systeme repräsentiert.

KI-Such-Traffic konvertiert deutlich besser als traditioneller organischer Such-Traffic. Frühere Daten zeigen, dass Besucher von KI-Suchplattformen 23-mal besser konvertieren als herkömmliche organische Besucher. Auch wenn KI-Suche derzeit weniger als 1 % des gesamten Webtraffics ausmacht, spricht die Qualität dieser Besuche für sich. Nutzer der KI-Suche befinden sich oft schon weiter im Entscheidungsprozess, haben bereits Optionen recherchiert, Funktionen verglichen und ihre Auswahl eingegrenzt, bevor sie auf Ihre Website klicken. Sie sind also qualifizierter, besser informiert und wahrscheinlicher zu Kunden zu machen. Da KI-Tools immer mehr zur Hauptsuchmethode werden, könnte das Ignorieren dieses Kanals bedeuten, gegenüber Wettbewerbern ins Hintertreffen zu geraten, die bereits aktiv auf diese Entwicklung setzen.

Die Zukunftssicherung Ihrer digitalen Präsenz ist ein weiterer wichtiger Aspekt. Da KI-Tools immer zentraler für die Informationssuche werden, könnte das vollständige Blockieren von KI-Crawlern bedeuten, sich von der Zukunft der Suche abzukoppeln. Generative Engine Optimization ist die nächste Stufe der Sichtbarkeit, und ChatGPT sorgt für über 80 % des KI-Referral-Traffics – der Crawler von OpenAI ist also besonders wichtig für Ihre langfristige Sichtbarkeit. Das Web und die Suchlandschaft verändern sich rasant, und wer sich jetzt als Teil des KI-Ökosystems positioniert, wird entscheidende Vorteile haben, wenn diese Technologien weiter reifen.

Das Blockieren von GPTBot ist einfach und reversibel über Ihre robots.txt-Datei, das Standardtool zur Kommunikation mit Webcrawlern. Um GPTBot den Zugriff auf Ihre gesamte Website zu verbieten, fügen Sie Ihrer robots.txt-Datei diese Zeilen hinzu:

User-agent: GPTBot

Disallow: /

Damit teilen Sie dem Crawler von OpenAI mit, dass er Ihre gesamte Seite meiden soll. Wenn Sie eine feinere Steuerung wünschen, können Sie den Zugriff gezielt erlauben, indem Sie das / durch bestimmte Verzeichnisse oder Seiten ersetzen, die Sie freigeben möchten. Zum Beispiel, um GPTBot den Zugriff auf Ihr Verzeichnis /private/ zu verweigern, während der Rest der Seite zugänglich bleibt:

User-agent: GPTBot

Disallow: /private/

Wenn Sie alle von OpenAI betriebenen Crawler blockieren möchten, sollten Sie Regeln für die drei verschiedenen Bots hinzufügen:

User-agent: GPTBot

Disallow: /

User-agent: ChatGPT-User

Disallow: /

User-agent: OAI-SearchBot

Disallow: /

Alternative Blockiermethoden bieten mehr Kontrolle, erfordern jedoch mehr technisches Know-how. Mit IP-Blocking können Sie die IP-Adressbereiche von OpenAI über Ihre Server-Firewall oder Ihr Hosting-Control-Panel ausschließen; allerdings müssen Sie die IP-Liste aktuell halten, da sich die Infrastruktur von OpenAI ändern kann. Mit Rate Limiting legen Sie Beschränkungen für die Anzahl der Anfragen pro Minute oder Stunde fest, um eine Serverüberlastung zu verhindern. Web Application Firewalls (WAFs) implementieren serverseitige Blockierregeln anhand von IP-Adressen oder User-Agent-Strings der Bots und bieten so eine noch ausgefeiltere Steuerung über den Bot-Traffic. Sie können die Crawler-Aktivität in Ihren Server-Logs oder mit Tools wie Cloudflare oder der Google Search Console überwachen, um sicherzustellen, dass GPTBot Ihre Anweisungen befolgt.

Bestimmte Branchen haben besonders starke Gründe, Bot-Zugriffe einzuschränken, um Daten, Umsatz und Nutzerinteressen zu schützen. Verlage und Medienunternehmen sehen ihr Geschäftsmodell direkt bedroht, da sie auf Traffic und Werbeeinnahmen angewiesen sind. Publisher möchten, dass Nutzer ihre Seiten direkt besuchen und nicht an KI-generierte Zusammenfassungen weitergeleitet werden. Zu den wichtigsten Beispielen zählen The New York Times, Associated Press und Reuters, die alle Blockierregeln eingeführt haben. E-Commerce-Plattformen schützen einzigartige Produktbeschreibungen und Preise vor Wettbewerbern und Data-Scraping-Tools, um ihre Wettbewerbsvorteile zu erhalten. Plattformen mit nutzergenerierten Inhalten wie Reddit schützen von der Community erstellte Inhalte und lizenzierte Daten vor unbeschränktem Scraping, das ihre Assets entwerten könnte. Hochautoritative Datenwebsites aus sensiblen Branchen wie Recht, Medizin und Finanzen kontrollieren den Zugang zu spezialisierten, forschungsbasierten Inhalten, um Compliance zu gewährleisten und proprietäres Wissen zu schützen.

Sie können feststellen, ob GPTBot Ihre Seite besucht, indem Sie verschiedene Methoden anwenden. Das Überprüfen der Server-Logs ist der direkteste Weg – suchen Sie in Ihren Zugriffsprotokollen nach User-Agent-Strings mit “GPTBot”, um zu sehen, wann und wie häufig der Crawler vorbeischaut. Der Einsatz von Analysetools bietet eine weitere Möglichkeit, denn viele Analyseplattformen zeigen Bot-Traffic an und erlauben das Filtern nach User-Agent, was die Identifikation erleichtert. SEO-Monitoring-Software berichtet über Crawler-Aktivitäten, einschließlich der Bots von OpenAI, und verschafft Ihnen einen Überblick, wie oft GPTBot Ihre Inhalte abruft. Regelmäßige Überwachung hilft Ihnen, die Besuchsfrequenz von GPTBot zu verstehen und festzustellen, ob der Crawler die Performance Ihrer Seite beeinflusst. Wenn Sie GPTBot-Aktivitäten bemerken und den Zugriff steuern möchten, können Sie die Berechtigungen einfach über Ihre robots.txt-Datei verwalten oder fortgeschrittenere Blockiermethoden über Ihren Hosting-Anbieter oder Ihre Web Application Firewall umsetzen.

Die Entscheidung, ob Sie GPTBot zulassen oder blockieren, sollte sich an Ihren geschäftlichen Zielen, Ihrer Content-Strategie und Ihrer langfristigen Vision orientieren. Blockieren Sie GPTBot, wenn Sie proprietäre Inhalte veröffentlichen oder in einem streng regulierten Bereich tätig sind, in dem Datenschutz oberste Priorität hat, Sie nicht bereit sind, die KI-Welt mit Ihren Inhalten zu versorgen und lieber die volle Kontrolle über deren Nutzung behalten, Sie Inhaltsschutz, rechtliche Compliance oder Sicherheit höher gewichten als potenzielle KI-Sichtbarkeit, Ihre Serverressourcen begrenzt sind und Bot-Traffic zu messbaren Performanceproblemen führt oder Sie große Bedenken hinsichtlich geistigen Eigentums und Content-Ownership-Rechten haben. Erlauben Sie GPTBot, wenn Sie Ihre Sichtbarkeit, den Einfluss Ihrer Marke und Ihre Relevanz auf generativen Plattformen im KI-Zeitalter steigern möchten, Sie eine akkurate Markenrepräsentation für die 800 Millionen wöchentlichen ChatGPT-Nutzer wünschen, Sie für die Zukunft bauen und Teil des KI-Suchekosystems werden wollen, Sie die Generative Engine Optimization Ihrer Seite verbessern und hochwertigen KI-Such-Traffic gewinnen möchten oder Sie langfristig Sichtbarkeit und Markenreichweite in einer zunehmend KI-getriebenen digitalen Landschaft anstreben.

Das Web und die Suche verändern sich rasant – Sie müssen entscheiden, welche Rolle Ihre Inhalte in dieser Zukunft spielen sollen, und entsprechend handeln. Die Wahl zwischen Zulassen und Blockieren von GPTBot ist nicht endgültig – Sie können Ihre robots.txt-Datei jederzeit anpassen und Ihre Präferenz ändern. Wichtig ist, dass Sie eine informierte Entscheidung auf Basis Ihrer Unternehmensziele treffen, die Auswirkungen auf Ihre Markenpräsenz in KI-Systemen verstehen und die Ergebnisse Ihrer Wahl über die Zeit beobachten.

Verfolgen Sie, wie Ihre Marke in ChatGPT, Perplexity und anderen KI-Antwortgeneratoren erscheint. Erhalten Sie Echtzeit-Einblicke in Ihre KI-Sichtbarkeit und optimieren Sie Ihre Content-Strategie.

Erfahren Sie, was GPTBot ist, wie er funktioniert und ob Sie ihn von Ihrer Website blockieren sollten. Verstehen Sie die Auswirkungen auf SEO, Serverlast und Ma...

Erfahren Sie die wichtigsten Unterschiede zwischen den Crawlern GPTBot und OAI-SearchBot. Verstehen Sie deren Zwecke, Crawl-Verhalten und wie Sie diese für opti...

Erfahren Sie, was OAI-SearchBot ist, wie er funktioniert und wie Sie Ihre Website für OpenAIs dedizierten Suchcrawler für SearchGPT und ChatGPT optimieren.

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.