Was ist Burstiness in KI-Inhalten und wie beeinflusst sie die Erkennung?

Erfahren Sie, was Burstiness in KI-generierten Inhalten bedeutet, wie sie sich von menschlichen Schreibmustern unterscheidet und warum sie für KI-Erkennung und ...

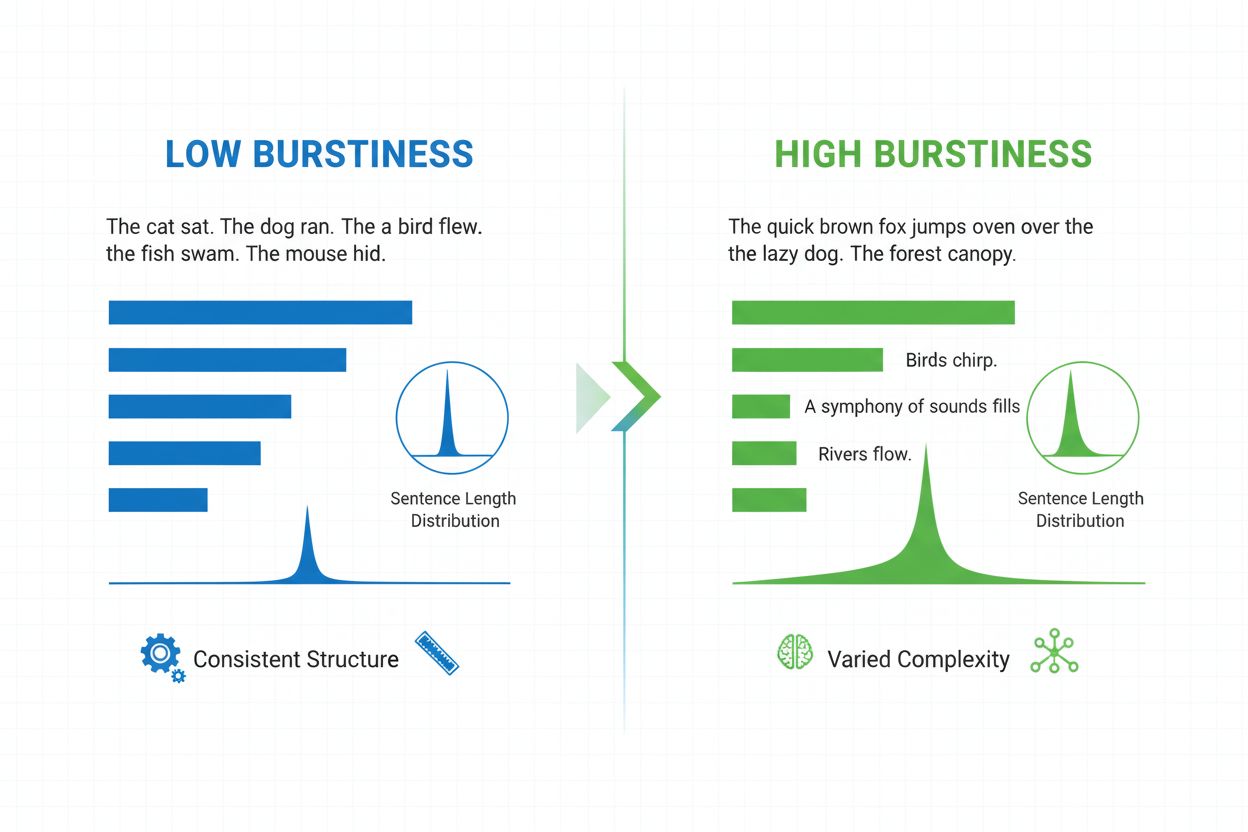

Burstiness ist eine linguistische Metrik, die die Variabilität der Satzlänge, -struktur und -komplexität in einem Dokument misst. Sie quantifiziert, wie stark ein Autor zwischen kurzen, prägnanten Sätzen und längeren, komplexeren Sätzen wechselt, und dient als wichtiger Indikator bei der Erkennung von KI-generierten Inhalten und der Analyse natürlicher Sprache.

Burstiness ist eine linguistische Metrik, die die Variabilität der Satzlänge, -struktur und -komplexität in einem Dokument misst. Sie quantifiziert, wie stark ein Autor zwischen kurzen, prägnanten Sätzen und längeren, komplexeren Sätzen wechselt, und dient als wichtiger Indikator bei der Erkennung von KI-generierten Inhalten und der Analyse natürlicher Sprache.

Burstiness ist eine quantifizierbare linguistische Metrik, die die Variabilität und Schwankung der Satzlänge, -struktur und -komplexität in einem geschriebenen Dokument oder Textabschnitt misst. Der Begriff stammt aus dem Konzept von „Bursts“ unterschiedlicher Satzmuster – dem Wechsel zwischen kurzen, prägnanten und längeren, komplexeren Sätzen. Im Kontext der Verarbeitung natürlicher Sprache und der Erkennung von KI-Inhalten dient Burstiness als entscheidender Indikator dafür, ob ein Text von einem Menschen geschrieben oder von einem KI-System generiert wurde. Menschliche Autoren erzeugen von Natur aus Texte mit hoher Burstiness, da sie ihre Satzkonstruktionen instinktiv je nach Betonung, Tempo und stilistischer Absicht variieren. Im Gegensatz dazu weisen KI-generierte Texte typischerweise eine geringe Burstiness auf, weil Sprachmodelle auf statistischen Mustern trainiert werden, die auf Konsistenz und Vorhersehbarkeit abzielen. Das Verständnis von Burstiness ist für Content-Ersteller, Lehrkräfte, Forschende und Organisationen, die KI-generierte Inhalte auf Plattformen wie ChatGPT, Perplexity, Google AI Overviews und Claude überwachen, essenziell.

Das Konzept der Burstiness entstand aus der Forschung in der Computerlinguistik und Informationstheorie, in der Wissenschaftler versuchten, die statistischen Eigenschaften natürlicher Sprache zu quantifizieren. Frühe Arbeiten in der Stilometrie – der statistischen Analyse von Schreibstilen – zeigten, dass menschliches Schreiben charakteristische Variationsmuster aufweist, die sich grundlegend von maschinell generierten Texten unterscheiden. Mit der zunehmenden Raffinesse von großen Sprachmodellen (LLMs) in den frühen 2020er Jahren erkannten Forscher, dass Burstiness in Kombination mit Perplexity (einem Maß für die Wortvorhersehbarkeit) als zuverlässiger Indikator für KI-generierte Inhalte dienen kann. Laut Forschungsergebnissen von QuillBot und akademischen Einrichtungen nutzen mittlerweile rund 78 % der Unternehmen KI-gestützte Content-Monitoring-Tools, die Burstiness-Analysen in ihre Erkennungsalgorithmen einbinden. Die Stanford-Studie von 2023 zu TOEFL-Aufsätzen zeigte, dass Burstiness-basierte Erkennungsmethoden zwar nützlich sind, aber erhebliche Einschränkungen haben – insbesondere hinsichtlich Fehlalarmen bei nicht-muttersprachlichem Englisch. Diese Forschung trieb die Entwicklung fortschrittlicher, mehrschichtiger KI-Erkennungssysteme voran, die Burstiness zusammen mit anderen sprachlichen Markern, semantischer Kohärenz und Kontextangemessenheit berücksichtigen.

Burstiness wird berechnet, indem die statistische Verteilung von Satzlängen und Strukturmustern innerhalb eines Textes analysiert wird. Die Metrik quantifiziert die Varianz – sie misst also, wie stark einzelne Sätze von der durchschnittlichen Satzlänge in einem Dokument abweichen. Ein Dokument mit hoher Burstiness enthält Sätze, die sich stark in ihrer Länge unterscheiden; ein Autor könnte beispielsweise auf einen Dreiwortsatz („Na?“) einen 25-Wörter-Satz mit mehreren Nebensätzen folgen lassen. Geringe Burstiness bedeutet hingegen, dass die meisten Sätze eine ähnliche Länge haben, typischerweise zwischen zwölf und achtzehn Wörtern, was einen monotonen Rhythmus erzeugt. Die Berechnung erfolgt in mehreren Schritten: Zunächst wird die Länge jedes Satzes in Wörtern gemessen, dann der Mittelwert (Durchschnitt) der Satzlänge berechnet und schließlich die Standardabweichung ermittelt, die anzeigt, wie stark einzelne Sätze vom Mittelwert abweichen. Eine höhere Standardabweichung steht für größere Variation und damit höhere Burstiness. Moderne KI-Detektoren wie Winston AI und Pangram verwenden ausgefeilte Algorithmen, die nicht nur Wörter zählen, sondern auch die syntaktische Komplexität – also die Anordnung von Teilsätzen, Phrasen und grammatischen Elementen – analysieren. Diese tiefergehende Analyse zeigt, dass menschliche Autoren vielfältige Satzstrukturen (einfache, zusammengesetzte, komplexe und zusammengesetzt-komplexe Sätze) in unvorhersehbaren Mustern einsetzen, während KI-Modelle dazu neigen, bestimmte Strukturvorlagen zu bevorzugen, die in ihren Trainingsdaten häufig vorkommen.

| Metrik | Burstiness | Perplexity | Messfokus |

|---|---|---|---|

| Definition | Variation in Satzlänge und -struktur | Vorhersehbarkeit einzelner Wörter | Satzebene vs. Wortebene |

| Menschliches Schreiben | Hoch (abwechslungsreiche Strukturen) | Hoch (unvorhersehbare Wörter) | Natürlicher Rhythmus und Wortschatz |

| KI-generierter Text | Niedrig (einheitliche Strukturen) | Niedrig (vorhersehbare Wörter) | Statistische Konsistenz |

| Erkennungsanwendung | Erkennt strukturelle Monotonie | Erkennt Muster in der Wortwahl | Komplementäre Erkennungsmethoden |

| Fehlalarmrisiko | Höher bei Nicht-Muttersprachlern | Höher bei technischem/akademischem Schreiben | Beide haben Einschränkungen |

| Berechnungsmethode | Standardabweichung der Satzlängen | Analyse von Wahrscheinlichkeitsverteilungen | Verschiedene mathematische Ansätze |

| Verlässlichkeit allein | Nicht ausreichend für eindeutige Erkennung | Nicht ausreichend für eindeutige Erkennung | Am effektivsten in Kombination |

Große Sprachmodelle wie ChatGPT, Claude und Google Gemini werden durch einen Prozess namens Next-Token-Prediction trainiert, bei dem das Modell lernt, das statistisch wahrscheinlichste nächste Wort nach einer bestimmten Sequenz vorherzusagen. Während des Trainings werden diese Modelle explizit darauf optimiert, die Perplexity auf ihren Trainingsdatensätzen zu minimieren, was als Nebenprodukt eine niedrige Burstiness erzeugt. Wenn ein Modell eine bestimmte Satzstruktur in seinen Trainingsdaten wiederholt antrifft, lernt es, diese Struktur mit hoher Wahrscheinlichkeit zu reproduzieren, was zu konsistenten, vorhersehbaren Satzlängen führt. Forschungen von Netus AI und Winston AI zeigen, dass KI-Modelle einen charakteristischen stilometrischen Fingerabdruck aufweisen, der sich durch einheitliche Satzkonstruktionen, Übernutzung von Übergangsphrasen (wie „Außerdem“, „Daher“, „Zusätzlich“) und eine Vorliebe für das Passiv statt des Aktivs auszeichnet. Die Abhängigkeit der Modelle von Wahrscheinlichkeitsverteilungen führt dazu, dass sie zu den häufigsten Mustern in ihren Trainingsdaten tendieren, anstatt das gesamte Spektrum möglicher Satzkonstruktionen auszuschöpfen. Das schafft eine paradoxe Situation: Je mehr Daten ein Modell trainiert, desto mehr lernt es, gängige Muster zu reproduzieren, und desto niedriger wird seine Burstiness. Zudem fehlt KI-Modellen die Spontaneität und emotionale Variation, die menschliches Schreiben kennzeichnet – sie schreiben nicht anders, wenn sie begeistert, verärgert oder einen bestimmten Punkt betonen wollen. Stattdessen behalten sie eine konsistente stilistische Grundlinie bei, die das statistische Zentrum ihrer Trainingsverteilung widerspiegelt.

KI-Erkennungsplattformen haben Burstiness-Analysen als zentralen Bestandteil ihrer Algorithmen integriert, allerdings mit unterschiedlicher Ausgereiftheit. Frühere Erkennungssysteme stützten sich stark auf Burstiness und Perplexity als Hauptmetriken, doch Forschungen zeigten erhebliche Einschränkungen dieses Ansatzes. Nach Pangram Labs erzeugen Detektoren, die auf Perplexity und Burstiness basieren, Fehlalarme, wenn sie Texte aus den Trainingsdatensätzen von Sprachmodellen analysieren – insbesondere wird die Unabhängigkeitserklärung häufig als KI-generiert eingestuft, da sie so oft in den Trainingsdaten erscheint, dass das Modell eine durchgängig niedrige Perplexity zuweist. Moderne Erkennungssysteme wie Winston AI und Pangram nutzen heute hybride Ansätze, die Burstiness-Analysen mit Deep-Learning-Modellen kombinieren, die auf vielfältigen, menschlich und KI-generierten Textproben trainiert wurden. Diese Systeme analysieren mehrere sprachliche Dimensionen gleichzeitig: Variation der Satzstruktur, lexikalische Vielfalt (Wortschatzreichtum), Interpunktionsmuster, Kontextkohärenz und semantische Übereinstimmung. Die Integration von Burstiness in umfassendere Erkennungsframeworks hat die Genauigkeit erheblich gesteigert – Winston AI berichtet über 99,98 % Genauigkeit bei der Unterscheidung von KI-generierten und menschlich geschriebenen Inhalten, indem mehrere Marker analysiert werden statt sich allein auf Burstiness zu verlassen. Dennoch bleibt die Metrik als Bestandteil einer umfassenden Erkennungsstrategie wertvoll, besonders in Kombination mit der Analyse von Perplexity, stilometrischen Mustern und semantischer Konsistenz.

Die Beziehung zwischen Burstiness und Lesbarkeit ist in der linguistischen Forschung gut belegt. Die Flesch Reading Ease- und Flesch-Kincaid Grade Level-Werte, die die Zugänglichkeit von Texten messen, korrelieren stark mit Burstiness-Mustern. Texte mit höherer Burstiness erreichen tendenziell bessere Lesbarkeitswerte, da die Variation der Satzlänge kognitive Ermüdung verhindert und die Aufmerksamkeit der Leser aufrechterhält. Wenn Leser auf einen gleichmäßigen Rhythmus ähnlich langer Sätze treffen, gewöhnt sich das Gehirn an ein vorhersehbares Muster, was zu Desinteresse und vermindertem Verständnis führen kann. Hohe Burstiness erzeugt hingegen einen Wechsel aus Spannung und Entspannung, der die Leser mental durch wechselnde kognitive Belastung aktiviert – kurze Sätze bieten schnell verdauliche Informationen, während längere Sätze komplexe Ideen und Nuancen vermitteln. Untersuchungen von Metrics Masters zeigen, dass hohe Burstiness etwa 15–20 % bessere Gedächtnisleistung im Vergleich zu Texten mit niedriger Burstiness erzeugt, da das abwechslungsreiche Rhythmusgefühl Informationen effektiver im Langzeitgedächtnis verankert. Dieses Prinzip gilt für alle Textsorten: Blogbeiträge, wissenschaftliche Artikel, Werbetexte und technische Dokumentationen profitieren von strategischer Burstiness. Allerdings ist die Beziehung nicht linear – übermäßige Burstiness, die Variation über Klarheit stellt, kann Texte abgehackt und schwer verständlich machen. Der optimale Ansatz besteht in zielgerichteter Variation, bei der die Wahl der Satzstruktur dem Inhalt und der Absicht des Autors dient und nicht allein einer Metrik.

Trotz ihrer weiten Verbreitung in KI-Erkennungssystemen hat die Burstiness-basierte Erkennung erhebliche Einschränkungen, die Forschende und Praktiker kennen sollten. Pangram Labs veröffentlichte umfassende Forschung, die fünf Hauptschwächen zeigt: Erstens werden Texte aus KI-Trainingsdatensätzen fälschlicherweise als KI-generiert klassifiziert, da Modelle darauf optimiert sind, die Perplexity auf Trainingsdaten zu minimieren; zweitens sind Burstiness-Werte modellabhängig, sodass verschiedene Modelle unterschiedliche Perplexity-Profile erzeugen; drittens geben proprietäre Modelle wie ChatGPT keine Token-Wahrscheinlichkeiten preis, wodurch die Berechnung der Perplexity unmöglich wird; viertens werden Nicht-Muttersprachler im Englischen überproportional als KI-generiert eingestuft, da ihre Satzstrukturen gleichförmiger sind; und fünftens können Burstiness-basierte Detektoren sich nicht iterativ mit zusätzlichen Daten selbst verbessern. Die Stanford-Studie 2023 zu TOEFL-Aufsätzen fand heraus, dass etwa 26 % der nicht-muttersprachlichen englischen Texte fälschlicherweise als KI-generiert durch Perplexity- und Burstiness-Detektoren eingestuft wurden, verglichen mit nur 2 % Fehlalarme bei muttersprachlichen Texten. Diese Voreingenommenheit wirft in Bildungskontexten, in denen KI-Erkennung zur Bewertung studentischer Leistungen eingesetzt wird, erhebliche ethische Fragen auf. Darüber hinaus weisen vorlagenbasierte Inhalte im Marketing, wissenschaftlichen Schreiben und in technischer Dokumentation naturgemäß eine geringere Burstiness auf, da Styleguides und Strukturkonventionen Konsistenz verlangen – auch hier entstehen Fehlalarme. Diese Einschränkungen haben zur Entwicklung fortschrittlicher Erkennungsansätze geführt, die Burstiness als ein Signal unter vielen und nicht als endgültigen Indikator für KI-Generierung betrachten.

Burstiness-Muster unterscheiden sich deutlich zwischen Schreibgenres und Kontexten, was die unterschiedlichen kommunikativen Zwecke und Publikumserwartungen jeder Domäne widerspiegelt. Akademisches Schreiben, insbesondere in MINT-Fächern, weist tendenziell eine geringere Burstiness auf, da Autoren strengen Styleguides folgen und einheitliche Strukturvorlagen zur Klarheit und Präzision nutzen. Juristische Dokumente, technische Spezifikationen und wissenschaftliche Arbeiten legen Wert auf Konsistenz und Vorhersehbarkeit statt auf stilistische Variation, was zu von Natur aus geringeren Burstiness-Werten führt. Im Gegensatz dazu zeigen kreatives Schreiben, Journalismus und Marketingtexte meist hohe Burstiness, da diese Genres durch abwechslungsreiches Tempo und Rhythmus das Engagement und die emotionale Wirkung beim Leser steigern wollen. Besonders die literarische Belletristik nutzt dramatische Wechsel in der Satzlänge, um Akzente zu setzen, Spannung aufzubauen und das Erzähltempo zu steuern. Geschäftskommunikation nimmt eine Mittelstellung ein – professionelle E-Mails und Berichte weisen eine moderate Burstiness auf, um Klarheit und Engagement auszubalancieren. Der Flesch-Kincaid Grade Level-Wert zeigt, dass akademische Texte für ein hochgebildetes Publikum oft längere, komplexere Sätze verwenden, was scheinbar die Burstiness reduziert; dennoch erzeugen Variation in Nebensatzstrukturen und Unterordnungsmustern bedeutende Burstiness. Das Verständnis dieser kontextuellen Unterschiede ist für KI-Erkennungssysteme essenziell, um genrespezifische Schreibkonventionen zu berücksichtigen und Fehlalarme zu vermeiden. Ein technisches Handbuch mit durchweg langen Sätzen sollte nicht allein wegen niedriger Burstiness als KI-generiert eingestuft werden – die niedrige Burstiness spiegelt angemessene stilistische Entscheidungen für das Genre wider, nicht maschinelle Generierung.

Die Zukunft der Burstiness-Analyse in der KI-Erkennung entwickelt sich hin zu ausgefeilteren, kontextsensitiven Ansätzen, die die Begrenzungen der Metrik anerkennen und gleichzeitig ihre Erkenntnisse nutzen. Da große Sprachmodelle immer fortschrittlicher werden, beginnen sie, Burstiness-Variation in ihre Ausgaben zu integrieren, wodurch die Erkennung ausschließlich anhand dieser Metrik weniger zuverlässig wird. Forschende entwickeln adaptive Erkennungssysteme, die Burstiness zusammen mit semantischer Kohärenz, Faktengenauigkeit und Kontextangemessenheit analysieren. Das Aufkommen von KI-Humanisierungstools, die gezielt Burstiness und andere menschenähnliche Charakteristika erhöhen, stellt ein fortlaufendes Wettrüsten zwischen Erkennungs- und Umgehungstechnologien dar. Fachleute gehen jedoch davon aus, dass wirklich zuverlässige KI-Erkennung letztlich auf kryptographischen Verifikationsmethoden und Herkunftsnachweisen beruhen wird, statt allein auf linguistischer Analyse. Für Content-Ersteller und Organisationen ist die strategische Konsequenz klar: Statt Burstiness als zu manipulierende Metrik zu betrachten, sollten Autoren authentische, abwechslungsreiche Schreibstile entwickeln, die natürliche menschliche Kommunikationsmuster widerspiegeln. AmICiteds Monitoring-Plattform steht für eine neue Generation in diesem Bereich, indem sie erfasst, wie Marken in KI-generierten Antworten erscheinen und die sprachlichen Charakteristika dieser Nennungen analysiert. Mit der zunehmenden Verbreitung von KI-Systemen in der Inhaltserstellung und -verbreitung wird das Verständnis von Burstiness und verwandten Metriken immer wichtiger, um Marken-Authentizität zu bewahren, akademische Integrität zu gewährleisten und die Unterscheidung zwischen menschlichen und maschinellen Inhalten zu erhalten. Die Entwicklung hin zu multisignalbasierten Erkennungsansätzen deutet darauf hin, dass Burstiness als ein Bestandteil umfassender KI-Monitoringsysteme relevant bleibt, auch wenn seine Rolle nuancierter und kontextabhängiger wird.

Burstiness und Perplexity sind komplementäre Metriken, die bei der KI-Erkennung verwendet werden. Perplexity misst, wie vorhersehbar einzelne Wörter in einem Text sind, während Burstiness die Variation in Satzstruktur und -länge über ein gesamtes Dokument hinweg misst. Menschliches Schreiben weist typischerweise eine höhere Perplexity (unvorhersehbarere Wortwahl) und höhere Burstiness (abwechslungsreichere Satzstrukturen) auf, während KI-generierte Texte aufgrund ihrer Abhängigkeit von statistischen Mustern aus Trainingsdaten tendenziell niedrigere Werte für beide Metriken zeigen.

Hohe Burstiness erzeugt einen rhythmischen Fluss, der das Engagement und das Verständnis der Lesenden erhöht. Wenn Autoren zwischen kurzen, prägnanten und längeren, komplexen Sätzen abwechseln, bleibt das Interesse der Lesenden erhalten und Monotonie wird verhindert. Studien zeigen, dass eine abwechslungsreiche Satzstruktur das Erinnerungsvermögen verbessert und Inhalte authentischer und gesprächiger wirken lässt. Niedrige Burstiness, gekennzeichnet durch einheitliche Satzlängen, kann Texte roboterhaft und schwer verständlich machen, was sowohl die Lesbarkeitswerte als auch das Engagement der Zielgruppe senkt.

Obwohl Burstiness absichtlich durch gezielte Variation der Satzstruktur erhöht werden kann, führt dies oft zu unnatürlich klingendem Text, der möglicherweise andere Erkennungsmechanismen auslöst. Moderne KI-Detektoren analysieren mehrere sprachliche Merkmale über Burstiness hinaus, darunter semantische Kohärenz, kontextuelle Angemessenheit und stilometrische Muster. Authentische Burstiness entsteht natürlich durch echtes menschliches Schreiben und spiegelt die individuelle Stimme des Autors wider, während erzwungene Variation oft die organische Qualität fehlt, die wirklich menschliche Inhalte auszeichnet.

Nicht-muttersprachliche Englischschreibende zeigen häufig niedrigere Burstiness-Werte, da ihre Schreibmuster einen begrenzteren Wortschatz und einfachere Satzbau-Strategien widerspiegeln. Sprachlernende verwenden typischerweise gleichförmige, vorhersehbare Satzstrukturen, während sie ihre Fähigkeiten entwickeln, und vermeiden komplexe Nebensätze sowie abwechslungsreiche syntaktische Muster. Dies erzeugt ein stilometrisches Profil, das KI-generierten Texten ähnelt, was zu Fehlalarmen bei KI-Erkennungssystemen führt. Forschungen der Stanford University aus einer Studie zu TOEFL-Aufsätzen 2023 bestätigten diese Voreingenommenheit und zeigten eine wesentliche Einschränkung von auf Burstiness basierenden Erkennungsmethoden.

Große Sprachmodelle werden mit riesigen Datensätzen trainiert, in denen sie lernen, das nächste Wort anhand statistischer Muster vorherzusagen. Während des Trainings werden diese Modelle darauf optimiert, die Perplexity ihrer Trainingsdaten zu minimieren, was unbeabsichtigt zu einheitlichen Satzstrukturen und vorhersehbaren Wortfolgen führt. Das resultiert in durchgehend niedriger Burstiness, da die Modelle Text durch Auswahl statistisch wahrscheinlicher Wortkombinationen generieren und nicht die abwechslungsreiche, spontane Satzkonstruktion verwenden, die menschliches Schreiben auszeichnet. Die Abhängigkeit der Modelle von Wahrscheinlichkeitsverteilungen erzeugt eine homogene stilistische Signatur.

AmICited verfolgt, wie Marken und Domains in KI-generierten Antworten auf Plattformen wie ChatGPT, Perplexity und Google AI Overviews erscheinen. Das Verständnis von Burstiness hilft dem Monitoring-System von AmICited, zwischen authentisch menschlich geschriebenen Zitaten und KI-generierten Inhalten, die Ihre Marke erwähnen, zu unterscheiden. Durch die Analyse von Burstiness-Mustern zusammen mit anderen sprachlichen Merkmalen kann AmICited genauere Einblicke liefern, ob Ihre Marke in wirklich menschlich verfassten Inhalten oder in KI-generierten Antworten genannt wird, und so ein besseres Reputationsmanagement ermöglichen.

Autoren können Burstiness organisch verbessern, indem sie bewusst ihre Satzkonstruktion variieren und dabei Klarheit und Zielstrebigkeit beibehalten. Techniken hierzu sind das Abwechseln zwischen einfachen Aussagesätzen und komplexen Sätzen mit mehreren Nebensätzen, der Einsatz rhetorischer Mittel wie Fragmenten und Gedankenstrichen zur Betonung sowie das Variieren der Absatzlängen. Entscheidend ist, dass die Variation dem Sinn des Inhalts dient und nicht Selbstzweck ist. Lautes Vorlesen, das Studium unterschiedlicher Schreibstile und Überarbeitungen mit Augenmerk auf den Rhythmus fördern auf natürliche Weise die Fähigkeit, authentisch und ansprechend Texte mit hoher Burstiness zu verfassen.

Beginnen Sie zu verfolgen, wie KI-Chatbots Ihre Marke auf ChatGPT, Perplexity und anderen Plattformen erwähnen. Erhalten Sie umsetzbare Erkenntnisse zur Verbesserung Ihrer KI-Präsenz.

Erfahren Sie, was Burstiness in KI-generierten Inhalten bedeutet, wie sie sich von menschlichen Schreibmustern unterscheidet und warum sie für KI-Erkennung und ...

Community-Diskussion über Burstiness in der KI-Inhaltserkennung – was es bedeutet, wie es die KI-Sichtbarkeit beeinflusst und ob Content-Creator dafür optimiere...

Erfahren Sie, wie die Citation Velocity die Veränderungsrate von KI-Zitierungen im Zeitverlauf misst. Entdecken Sie, warum sie ein Frühindikator für Sichtbarkei...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.