KI-Trainingscrawler vs. Suchcrawler: Den Unterschied verstehen

Entdecken Sie die entscheidenden Unterschiede zwischen KI-Trainingscrawlern und Suchcrawlern. Erfahren Sie, wie sie die Sichtbarkeit Ihrer Inhalte, Optimierungs...

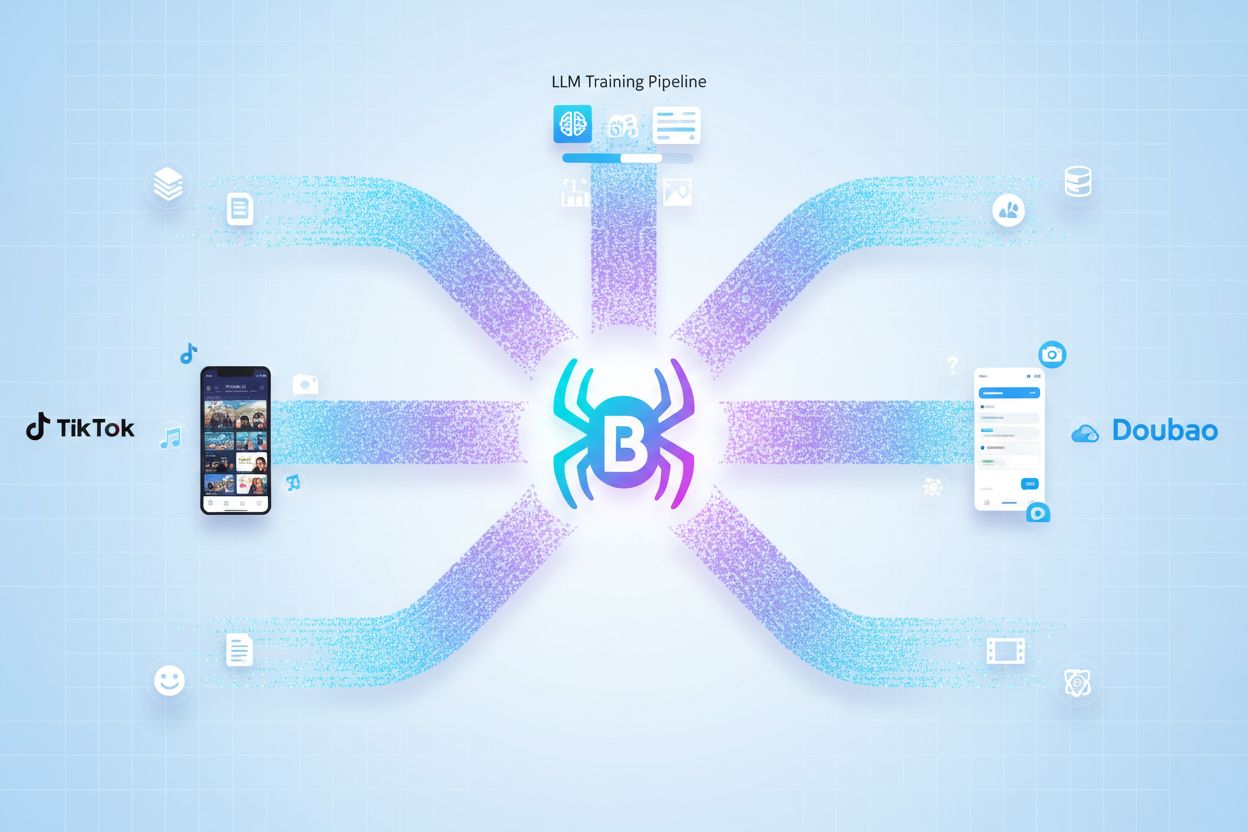

Bytespider ist der Webcrawler von ByteDance, der systematisch Inhalte von Websites sammelt, um künstliche Intelligenz zu trainieren und die Empfehlungsalgorithmen von TikTok zu unterstützen. Der Crawler operiert hauptsächlich aus Singapur und durchsucht das Internet aggressiv, um Trainingsdaten für große Sprachmodelle wie Doubao, ByteDances ChatGPT-Konkurrenten, zu sammeln. Der Crawler ist dafür bekannt, robots.txt-Anweisungen zu ignorieren und täglich Millionen von Anfragen zu generieren, was ihn zu einem der am weitesten verbreiteten KI-Datensammler im Web macht.

Bytespider ist der Webcrawler von ByteDance, der systematisch Inhalte von Websites sammelt, um künstliche Intelligenz zu trainieren und die Empfehlungsalgorithmen von TikTok zu unterstützen. Der Crawler operiert hauptsächlich aus Singapur und durchsucht das Internet aggressiv, um Trainingsdaten für große Sprachmodelle wie Doubao, ByteDances ChatGPT-Konkurrenten, zu sammeln. Der Crawler ist dafür bekannt, robots.txt-Anweisungen zu ignorieren und täglich Millionen von Anfragen zu generieren, was ihn zu einem der am weitesten verbreiteten KI-Datensammler im Web macht.

Bytespider ist der firmeneigene Webcrawler von ByteDance, der entwickelt wurde, um systematisch Inhalte im gesamten Internet zu durchsuchen und zu indexieren, um Trainingsdaten für künstliche Intelligenz zu sammeln. Der Crawler arbeitet hauptsächlich von einer Infrastruktur mit Sitz in Singapur aus und sammelt riesige Mengen öffentlich zugänglicher Webinhalte, um die Entwicklung großer Sprachmodelle zu ermöglichen und verschiedene KI-basierte Dienste von ByteDance zu unterstützen. Der Crawler ist ein zentrales Element in ByteDances Pipeline zur Datenakquise und ermöglicht es dem Unternehmen, Trainingsdatensätze in großem Maßstab zu erfassen. Bytespiders Hauptzweck geht über die reine Inhaltsindexierung hinaus – er bildet das Rückgrat für das Training von KI-Systemen wie Doubao, ByteDances ChatGPT-Konkurrent, und trägt gleichzeitig zu den ausgeklügelten Empfehlungsalgorithmen von TikTok bei. Der Crawler arbeitet kontinuierlich und sendet täglich Millionen von Anfragen an Websites weltweit, wobei er systematisch Text, Metadaten und strukturelle Informationen extrahiert. Im Gegensatz zu traditionellen Suchmaschinen-Crawlern, die Benutzererfahrung und Website-Richtlinien priorisieren, ist Bytespider auf Effizienz bei der Datensammlung optimiert und zählt damit zu den am weitesten verbreiteten KI-Datensammlern im modernen Internet.

| Name des Crawlers | Betreiber | Hauptzweck | Respektiert robots.txt | Typisches Anfragevolumen |

|---|---|---|---|---|

| Bytespider | ByteDance | KI-Modell-Training, TikTok-Empfehlungen | Nein | Millionen Anfragen täglich |

| Googlebot | Suchindexierung, Ranking | Ja | Abhängig von der Relevanz der Seite | |

| ClaudeBot | Anthropic | Claude-KI-Trainingsdaten | Teilweise | Hohes, schwankendes Volumen |

| PerplexityBot | Perplexity AI | KI-Suchtraining | Ja | Moderat, wachsend |

Bytespider dient als Datensammlungs-Engine für das gesamte Ökosystem an KI-basierten Diensten von ByteDance, wobei der Schwerpunkt auf der Verbesserung der Empfehlungsalgorithmen von TikTok und dem Training fortschrittlicher Sprachmodelle liegt. Der Crawler sammelt systematisch Webinhalte, die anschließend verarbeitet und zur Schulung von Doubao, dem großen Sprachmodell von ByteDance, genutzt werden. Doubao steht in direkter Konkurrenz zu OpenAIs ChatGPT und zählt über 60 Millionen monatlich aktive Nutzer. Die Beziehung zwischen Bytespiders Datensammlung und dem Empfehlungssystem von TikTok ist symbiotisch – der Crawler sammelt vielfältige Inhaltspatterns und Signale zur Nutzerinteraktion aus dem gesamten Web, die in die Machine-Learning-Modelle einfließen, die bestimmen, welche Inhalte den Nutzern angezeigt werden. Dieser Datensammlungsprozess findet in beispiellosem Umfang statt: Bytespider macht auf vielen Websites fast 90 % des gesamten KI-Crawler-Traffics aus, was ByteDances aggressives Investment in KI-Infrastruktur unterstreicht. Die gesammelten Daten umfassen Texte, Bilder, Metadaten und Strukturinformationen von Millionen Websites und schaffen umfassende Trainingsdatensätze, die die Genauigkeit und Relevanz der Modelle verbessern. ByteDances strategischer Ansatz sieht Bytespider als entscheidenden Wettbewerbsvorteil, der eine schnelle Weiterentwicklung und Verbesserung der KI-Systeme im gesamten Produktportfolio ermöglicht.

Wichtige KI-Systeme, die von Bytespider-Daten angetrieben werden:

Bytespider hat sich einen Ruf als aggressiver Webcrawler erworben, weil er bewusst gängige Webprotokolle ignoriert und ein enormes Anfragevolumen erzeugt. Im Gegensatz zu den meisten seriösen KI-Crawlern, die robots.txt-Direktiven – eine Standarddatei, mit der Webmaster Crawler-Zugriffspräferenzen kommunizieren – respektieren, ignoriert Bytespider diese Richtlinien aktiv und betrachtet sie als optional statt bindend. Der Crawler erzeugt täglich Millionen von Anfragen an einzelne Domains, mit typischen Crawlingraten von etwa 5 Anfragen pro Sekunde pro Zielwebsite, was zu erheblicher Serverbelastung führt. Bytespider nutzt fortschrittliche Umgehungstaktiken, um Erkennung und Ratenbegrenzungen zu umgehen, darunter das Rotieren von IP-Adressen und das Verschleiern seiner Identität, sodass er wie legitimer Nutzertraffic erscheint statt wie automatisierte Bot-Aktivität. Wenn Websites versuchen, Bytespider anhand des User-Agent-Strings zu blockieren, wechselt die Ursprungs-IP-Geolokation des Crawlers von China nach Singapur. Dies deutet auf eine koordinierte Infrastrukturverwaltung hin, die den Zugriff auch bei Blockierungsversuchen aufrechterhalten soll. Dieses aggressive Verhalten spiegelt wider, dass ByteDance die Datensammlung über die Performance-Bedenken der Website-Betreiber stellt und Bytespider grundlegend von Suchmaschinen-Crawlern unterscheidet, die ihre eigenen Bedürfnisse mit denen der Websitebetreiber abwägen.

Das aggressive Crawling-Verhalten von Bytespider stellt Website-Betreiber vor erhebliche Herausforderungen in Bezug auf Infrastrukturbelastung und Sicherheitsbedenken. Websites, die von Bytespider besucht werden, erfahren erheblichen Bandbreitenverbrauch, da Millionen täglicher Anfragen Server-Ressourcen binden, die sonst echten Nutzern und der Verbesserung der Website-Performance zugutekommen könnten. Die durch Bytespider verursachte Serverbelastung führt direkt zu erhöhtem Stromverbrauch und CO₂-Fußabdruck, da Rechenzentren zusätzliche Ressourcen für die Bearbeitung der Crawler-Anfragen bereitstellen müssen – mit Umweltkosten, die ausschließlich den KI-Trainingszielen von ByteDance dienen. Die Sicherheitsimplikationen gehen über die reine Ressourcenerschöpfung hinaus: Die Umgehungstaktiken des Crawlers und dessen Weigerung, Standardprotokolle zu respektieren, werfen Fragen nach möglicher Ausnutzung von Sicherheitslücken oder unbefugten Zugriffsversuchen auf sensible Bereiche der Website auf. Viele Organisationen entscheiden sich strategisch dafür, Bytespider komplett zu blockieren, da der Crawler keinen Mehrwert für ihr Geschäft bietet, Ressourcen verbraucht und potenziell Risiken für ihre Infrastruktur birgt. Die grundlegende Abwägung für Websitebetreiber ist, ob sie ihre Inhalte für das KI-Training (und damit mögliche Verbesserungen von KI-Systemen, die mit den eigenen Diensten konkurrieren könnten) freigeben oder ihre Infrastruktur und Inhalte vor unautorisiertem Scraping schützen.

Websitebetreibern stehen verschiedene technische Möglichkeiten zur Verfügung, Bytespider zu blockieren oder einzuschränken – deren Wirksamkeit hängt jedoch von der Komplexität der Implementierung und den Umgehungsfähigkeiten des Crawlers ab. Die einfachste Methode ist die Konfiguration der robots.txt-Datei mit spezifischen Direktiven für den User-Agent Bytespider. Diese Methode ist jedoch nur eine höfliche Bitte und kein technischer Zwang, da Bytespider diese Richtlinien oft ignoriert. Robuste Blockierungsstrategien setzen auf Firewall-Regeln und IP-basierte Filterung, um zu verhindern, dass Bytespider-Anfragen den Server erreichen – dies erfordert allerdings fortlaufende Pflege, da der Crawler regelmäßig IP-Adressen und Ursprungsorte wechselt. Ratenbegrenzungen auf Server- oder Anwendungsebene können die Anzahl der Anfragen, die ein einzelner User-Agent oder eine IP-Adresse in einem bestimmten Zeitraum stellen darf, einschränken und so das Crawling von Bytespider drosseln, auch wenn eine vollständige Blockierung nicht möglich ist. Verhaltensbasierte Analyseverfahren nutzen Machine Learning, um Bot-Traffic anhand von Anfragecharakteristika, Zeitmustern und Interaktionsverhalten zu identifizieren und von legitimen Nutzern zu unterscheiden. Monitoring-Tools wie Dark Visitors bieten in Echtzeit Einblick, welche Crawler auf Ihre Website zugreifen, sodass Sie Ihre Blockierungsmaßnahmen überprüfen und anpassen können.

# Beispielkonfiguration für robots.txt zum Blockieren von Bytespider

User-agent: Bytespider

Disallow: /

# Alternative: Alle KI-Datensammler blockieren

User-agent: Bytespider

User-agent: ClaudeBot

User-agent: GPTBot

Disallow: /

# Selektives Blockieren: Crawling bestimmter Verzeichnisse erlauben

User-agent: Bytespider

Disallow: /private/

Disallow: /admin/

Allow: /public/

Das Aufkommen aggressiver KI-Crawler wie Bytespider wirft grundlegende Fragen zu Inhaltsbesitz, Attribution und den ethischen Grundlagen des KI-Trainings im digitalen Zeitalter auf. Content-Ersteller stehen vor dem Dilemma, dass ihre Originalwerke ohne explizite Zustimmung, Vergütung oder klare Zuordnung in KI-Trainingsdatensätze aufgenommen werden können – was es KI-Systemen ermöglicht, Ausgaben zu generieren, die mit oder gegen den Wert der Originalinhalte konkurrieren. Der Mangel an Transparenz darüber, wie von Bytespider gesammelte Inhalte genutzt, verändert oder in KI-generierten Antworten zugeordnet werden, schafft Unsicherheit, ob Urheber Anerkennung oder Vorteile aus dem Beitrag ihres geistigen Eigentums zur KI-Entwicklung erhalten. Andererseits sehen manche Organisationen in KI-gestützter Auffindbarkeit einen neuen Kanal für Markenbekanntheit und Produktpräsenz, da KI-Chatbots und Suchsysteme zunehmend die Hauptinformationsquelle für Nutzer werden. Das Gleichgewicht zwischen dem Schutz eigener Inhalte und der Ermöglichung von KI-Fortschritt bleibt ungelöst – verschiedene Interessengruppen fordern stärkeren Urheberschutz, klarere Attributionsstandards oder uneingeschränkten Datenzugang, um die KI-Entwicklung zu beschleunigen. Aus SEO-Sicht kann das Blockieren von Bytespider die Präsenz in KI-generierten Antworten und KI-basierten Suchergebnissen verringern und damit die Auffindbarkeit beeinträchtigen, wenn Nutzer zunehmend auf KI-Systeme statt klassische Suchmaschinen zurückgreifen. Die breite Debatte über verantwortungsvolle KI-Datensammlung, ethisches Webscraping und faire Vergütung für Content-Ersteller wird die Internet-Governance und KI-Regulierung auf Jahre hinaus prägen – und Entscheidungen über das Blockieren von Bytespider werden so Teil einer größeren strategischen Überlegung zur Beziehung der eigenen Marke zu aufkommenden KI-Technologien.

Bytespider ist der Webcrawler von ByteDance, der zum Sammeln von Trainingsdaten für künstliche Intelligenz, insbesondere für große Sprachmodelle (LLMs) wie Doubao, entwickelt wurde. Der Crawler durchsucht systematisch Websites, um Inhalte zu erfassen, die die KI-Systeme verbessern und die Empfehlungsalgorithmen von TikTok unterstützen. Darüber hinaus trägt er zur breiteren KI-Infrastruktur und den Content-Discovery-Systemen von ByteDance bei.

Bytespider gilt als aggressiv, weil er robots.txt-Anweisungen, mit denen Websites den Zugriff von Crawlern steuern, ignoriert, Millionen von Anfragen pro Tag an einzelne Domains sendet und Taktiken einsetzt, um Erkennung und Ratenbegrenzung zu umgehen. Im Gegensatz zu den meisten seriösen Crawlern, die Website-Richtlinien respektieren, priorisiert Bytespider die Datensammlung gegenüber der Website-Performance, was zu erheblicher Serverbelastung und Bandbreitenverbrauch führt.

Sie können Bytespider blockieren, indem Sie spezifische Regeln für den User-Agent "Bytespider" in Ihre robots.txt-Datei aufnehmen. Da Bytespider diese Anweisungen jedoch häufig ignoriert, können zusätzliche Maßnahmen wie Firewall-Regeln, IP-Blockierung, serverseitige Ratenbegrenzung oder Bot-Management-Lösungen erforderlich sein. Tools wie Dark Visitors helfen Ihnen, die Wirksamkeit Ihrer Blockierungsversuche zu überwachen und zu überprüfen.

Das Blockieren von Bytespider hat nur minimale direkte Auswirkungen auf das traditionelle Suchmaschinen-SEO, da es sich nicht um einen Suchmaschinen-Crawler handelt. Wenn Ihre Inhalte jedoch zum Training von KI-Modellen genutzt werden, die KI-Suchmaschinen und Chatbots antreiben, könnte das Blockieren von Bytespider Ihre Präsenz in KI-generierten Antworten verringern und damit Ihre Auffindbarkeit über KI-basierte Suchplattformen in Zukunft beeinträchtigen.

Laut Dark Visitors-Daten blockieren etwa 16 % der weltweit 1.000 größten Websites Bytespider aktiv in ihren robots.txt-Dateien. Diese relativ niedrige Blockierungsrate deutet darauf hin, dass viele Websites den Crawler entweder zulassen oder sich seiner Anwesenheit nicht bewusst sind. Die tatsächliche Blockierungsrate könnte jedoch höher sein, wenn Firewall- und serverseitige Einschränkungen berücksichtigt werden, die in robots.txt nicht sichtbar sind.

Bytespider erzeugt enorme Mengen an Traffic; Studien zeigen, dass er auf manchen Websites fast 90 % des gesamten KI-Crawler-Traffics ausmacht. Einzelne Domains können täglich Millionen Anfragen von Bytespider erhalten, wobei typische Crawling-Raten bei etwa 5 Anfragen pro Sekunde liegen. Damit ist er eine der bedeutendsten Quellen für Bot-Traffic im Internet.

Bytespider wird von ByteDance betrieben, dem Mutterkonzern von TikTok, ist jedoch nicht ausschließlich TikToks Crawler. Er sammelt zwar Daten zur Verbesserung der Empfehlungsalgorithmen von TikTok, dient aber in erster Linie der breiteren KI-Infrastruktur von ByteDance, einschließlich der Trainingsdaten für Doubao (das LLM von ByteDance) und andere KI-Systeme. Es handelt sich um ein unternehmensweites Tool und keinen plattformspezifischen Crawler.

Bytespider konzentriert sich in der Regel auf öffentlich zugängliche Inhalte zur Datensammlung für das Training. Wie andere fortschrittliche Crawler kann er jedoch auch versuchen, auf passwortgeschützte Bereiche, API-Endpunkte oder Inhalte hinter Paywalls zuzugreifen, abhängig von ByteDances Zielen und technischen Möglichkeiten. Die meisten seriösen Crawler respektieren Authentifizierungsbarrieren, aber das Ausmaß der Zugriffsversuche von Bytespider kann je nach Datensammlungszielen variieren.

Verfolgen Sie Erwähnungen Ihrer Marke auf KI-basierten Plattformen wie ChatGPT, Perplexity und Google AI Overviews. AmICited hilft Ihnen zu verstehen, wie KI-Systeme Ihre Inhalte nutzen und sorgt für eine korrekte Zuordnung.

Entdecken Sie die entscheidenden Unterschiede zwischen KI-Trainingscrawlern und Suchcrawlern. Erfahren Sie, wie sie die Sichtbarkeit Ihrer Inhalte, Optimierungs...

Erfahren Sie, wie Sie strategische Entscheidungen zum Blockieren von KI-Crawlern treffen. Bewerten Sie Inhaltstyp, Traffic-Quellen, Geschäftsmodelle und Wettbew...

Erfahren Sie, was GPTBot ist, wie er funktioniert und ob Sie den Webcrawler von OpenAI zulassen oder blockieren sollten. Verstehen Sie die Auswirkungen auf Ihre...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.