Cloaking

Cloaking ist eine Black-Hat-SEO-Technik, bei der Suchmaschinen anderer Inhalt als Nutzern angezeigt wird. Erfahren Sie, wie es funktioniert, welche Risiken best...

Suchmaschinenspam bezeichnet absichtliche Manipulationstaktiken, die darauf abzielen, das Ranking in Suchmaschinen mithilfe täuschender Techniken künstlich zu beeinflussen, welche gegen die Richtlinien der Suchmaschinen verstoßen. Zu diesen Praktiken gehören Keyword-Stuffing, Cloaking, Linkfarmen und versteckter Text, die darauf ausgelegt sind, Algorithmen zu täuschen, anstatt den Nutzern echten Mehrwert zu bieten.

Suchmaschinenspam bezeichnet absichtliche Manipulationstaktiken, die darauf abzielen, das Ranking in Suchmaschinen mithilfe täuschender Techniken künstlich zu beeinflussen, welche gegen die Richtlinien der Suchmaschinen verstoßen. Zu diesen Praktiken gehören Keyword-Stuffing, Cloaking, Linkfarmen und versteckter Text, die darauf ausgelegt sind, Algorithmen zu täuschen, anstatt den Nutzern echten Mehrwert zu bieten.

Suchmaschinenspam, auch bekannt als Spamdexing, bezeichnet die absichtliche Manipulation von Suchmaschinenindizes durch täuschende Techniken, die darauf ausgelegt sind, die Rankingposition einer Website künstlich zu erhöhen. Der Begriff umfasst eine Vielzahl unethischer Praktiken, die gegen die Richtlinien von Suchmaschinen verstoßen, darunter Keyword-Stuffing, Cloaking, Linkfarmen, versteckter Text und Sneaky Redirects. Diese Taktiken haben das Ziel, Suchalgorithmen zu täuschen, anstatt den Nutzern echten Mehrwert zu bieten, und untergraben dadurch die Integrität der Suchergebnisse grundlegend. Wird auf einer Website Spam entdeckt, verhängen Suchmaschinen in der Regel Strafen, die von Rankingverlusten bis hin zur vollständigen Entfernung aus den Suchindizes reichen – die Website wird so für potenzielle Besucher unsichtbar.

Suchmaschinenspam existiert seit den Anfängen des Internets, als Suchalgorithmen noch weniger ausgereift und leichter zu manipulieren waren. In den 1990er- und frühen 2000er-Jahren verbreiteten sich Spamdexing-Techniken, da Webmaster erkannten, dass sie durch einfache Wiederholung von Schlüsselwörtern und Linkmanipulation Rankings künstlich steigern konnten. Mit der Weiterentwicklung der Suchmaschinen – insbesondere seit Googles Einführung von PageRank und späteren Algorithmus-Updates wie Panda (2011) und Penguin (2012) – wurden die Erkennung und Bestrafung von Spam immer ausgefeilter. Die Einführung von SpamBrain, Googles KI-basiertem System zur Spam-Prävention im Jahr 2022, bedeutete einen Wendepunkt in Richtung maschinellen Lernens bei der Spamerkennung. Heute setzen Suchmaschinen fortschrittliche Algorithmen ein, die Hunderte von Rankingfaktoren analysieren, wodurch herkömmliche Spam-Taktiken größtenteils wirkungslos sind – gleichzeitig entstehen jedoch neue Möglichkeiten für ausgeklügelte Manipulationsversuche.

Keyword-Stuffing bleibt eine der bekanntesten Spam-Taktiken und beinhaltet die unnatürliche Wiederholung von Ziel-Keywords im Seiteninhalt, in Meta-Tags und versteckten Elementen. Diese Praxis erhöht künstlich die Keyword-Dichte, ohne den Lesern zusammenhängende, wertvolle Informationen zu liefern. Cloaking ist ein noch täuschenderer Ansatz, bei dem Suchmaschinen-Crawlern andere Inhalte angezeigt werden als den Nutzern im Browser – meist durch Erkennung per JavaScript oder serverseitige Techniken, um zwischen Bot- und menschlichen Besuchern zu unterscheiden. Linkfarmen und Private Blog Networks (PBNs) stellen eine weitere zentrale Kategorie von Spam dar: Hierbei handelt es sich um Netzwerke minderwertiger Websites, die ausschließlich zur künstlichen Generierung von Backlinks für Zielseiten geschaffen werden. Diese Netzwerke nutzen aus, dass Suchmaschinen Backlinks traditionell als wichtigen Rankingsignal gewertet haben, auch wenn moderne Algorithmen mittlerweile sehr geschickt darin sind, solche künstlichen Linkstrukturen zu erkennen und abzuwerten.

Sneaky Redirects beeinflussen das Nutzerverhalten, indem Besucher nach dem Klick auf ein Suchergebnis auf andere URLs weitergeleitet werden als jene, die Suchmaschinen vorfinden – oft landen Nutzer dadurch auf irrelevanten oder schädlichen Seiten. Versteckter Text und Links werden so platziert, dass sie für menschliche Besucher unsichtbar bleiben (z. B. gleiche Farbe wie der Hintergrund, winzige Schriftgrößen oder außerhalb des sichtbaren Bereichs), für Suchmaschinen-Crawler jedoch sichtbar sind. Kommentar- und Forumspam nutzen Plattformen mit nutzergenerierten Inhalten, indem automatisiert Links und Werbeinhalte in Blogs, Foren und sozialen Netzwerken gepostet werden. Content Scraping bedeutet, Inhalte anderer Websites ohne Erlaubnis oder Änderung zu kopieren und erneut zu veröffentlichen, um das eigene Content-Volumen künstlich zu erhöhen und Suchtraffic abzugreifen. Jede dieser Taktiken ist ein Versuch, Algorithmen auszutricksen, statt durch legitime Maßnahmen an Rankings zu gelangen.

| Aspekt | Suchmaschinenspam (Black Hat) | Legitime SEO (White Hat) | Gray Hat SEO |

|---|---|---|---|

| Hauptziel | Algorithmen durch Täuschung manipulieren | Nutzern Mehrwert bieten und Rankings natürlich verdienen | Grauzonen der Richtlinien ausnutzen |

| Inhaltsqualität | Minderwertig, Keyword-Stuffing, Kopien | Hochwertig, originell, nutzerorientiert | Gemischte Qualität, fragwürdige Taktiken |

| Linkaufbau | Künstliche Links von Farmen, PBNs oder gehackten Seiten | Natürliche Links durch hochwertige Inhalte | Gekaufte Links oder Tauschgeschäfte |

| Technische Methoden | Cloaking, versteckter Text, Sneaky Redirects | Sauberes HTML, korrekte Meta-Tags, strukturierte Daten | JavaScript-Redirects, Doorway Pages |

| Nutzererfahrung | Schlecht; Inhalte für Algorithmen, nicht Nutzer | Exzellent; Inhalte für Nutzerzufriedenheit | Mittelmäßig; Kompromisse bei UX |

| Suchmaschinenstrafen | Manuelle Maßnahmen, Deindexierung, Rankingverluste | Keine; kontinuierliche Verbesserungen | Mögliche Strafen bei Entdeckung |

| Langfristige Tragfähigkeit | Nicht nachhaltig; Strafen unausweichlich | Nachhaltig; baut dauerhafte Autorität auf | Riskant; hängt von Entdeckungswahrscheinlichkeit ab |

| Erholungszeit | Monate bis Jahre; manche Vorteile unwiderruflich | N/A; keine Strafen | Wochen bis Monate bei Entdeckung |

SpamBrain stellt einen grundlegenden Wandel im Kampf der Suchmaschinen gegen Spam mithilfe künstlicher Intelligenz und maschinellen Lernens dar. Eingeführt von Google im Jahr 2022 analysiert SpamBrain Muster auf Milliarden von Websites, um Spam-Merkmale mit bisher unerreichter Genauigkeit zu identifizieren. Das System arbeitet kontinuierlich und untersucht sowohl Onpage-Faktoren (Inhaltsqualität, Keyword-Verteilung, Strukturelemente) als auch Offpage-Signale (Linkprofile, Domainhistorie, Nutzerverhalten). Die Machine-Learning-Modelle von SpamBrain wurden mit umfangreichen Datensätzen aus bekannten Spam- und legitimen Websites trainiert, sodass das System auch neue Spam-Variationen erkennt, bevor sie weit verbreitet sind. Die KI kann komplexe Spamversuche identifizieren, die regelbasierte Systeme umgehen würden – darunter koordinierte Linknetzwerke, Inhaltsmanipulation und die Ausnutzung gehackter Websites. Google berichtet, dass durch Verbesserungen von SpamBrain der Anteil minderwertiger, nicht origineller Inhalte in den Suchergebnissen seit der Einführung um etwa 45 % gesenkt werden konnte – ein Beweis für die Wirksamkeit KI-basierter Spamerkennung.

Die Verbreitung von Suchmaschinenspam verschlechtert direkt die Qualität und Nützlichkeit der Suchergebnisse für Endnutzer. Wenn Spam-Inhalte hoch ranken, stoßen Nutzer auf irrelevante, minderwertige oder irreführende Informationen anstelle von maßgeblichen Quellen, die ihre Anfragen tatsächlich beantworten. Dieser Qualitätsverlust untergräbt das Vertrauen der Nutzer in Suchmaschinen und zwingt die Plattformen zu erheblichen Investitionen in Spamerkennung und -entfernung. Die Präsenz von Spam schafft außerdem ein unfaires Wettbewerbsumfeld, in dem seriöse Unternehmen zumindest vorübergehend gegen unethische Taktiken ankämpfen müssen. Suchmaschinen begegnen der Spam-Verbreitung mit regelmäßigen Spam-Updates – gezielten Verbesserungen ihrer Spamerkennung, die gesondert von grundlegenden Algorithmus-Updates angekündigt und verfolgt werden. Beispielsweise wurde Googles Spam-Update vom Dezember 2024 weltweit in allen Sprachen ausgerollt und dauerte bis zu einer Woche, was das Ausmaß und die Häufigkeit der Maßnahmen verdeutlicht. Das fortwährende Wettrüsten zwischen Spammern und Suchmaschinen verbraucht erhebliche Rechenressourcen und Entwicklungsaufwand, die ansonsten zur Verbesserung der Suchqualität eingesetzt werden könnten.

Websites, die beim Suchmaschinenspam ertappt werden, müssen mit einem breiten Spektrum an Konsequenzen rechnen – von algorithmischen Abstrafungen über manuelle Maßnahmen bis hin zur vollständigen Deindexierung. Manuelle Maßnahmen sind Googles direkteste Antwort: Menschliche Prüfer identifizieren Verstöße und verhängen gezielte Strafen über die Google Search Console. Die Benachrichtigungen enthalten konkrete Hinweise auf Verstöße wie unnatürliche Links, Keyword-Stuffing oder Cloaking und führen meist zu erheblichen Rankingverlusten oder einer Entfernung aus den Suchergebnissen. Algorithmische Strafen greifen, wenn Googles automatisierte Systeme Spam-Muster erkennen und die Sichtbarkeit der Website ohne menschliches Eingreifen verringern. Diese Strafen können temporär sein – bis der Spam entfernt und die Seite neu gecrawlt wurde – oder dauerhaft, falls die Verstöße schwerwiegend oder wiederholt auftreten. In besonders gravierenden Fällen werden Websites vollständig deindexiert, erscheinen also gar nicht mehr in den Google-Suchergebnissen und verlieren so jegliche organische Sichtbarkeit. Die Wiederherstellung nach manuellen Maßnahmen erfordert eine umfassende Bereinigung, detaillierte Dokumentation der Änderungen und einen Antrag auf erneute Überprüfung über die Google Search Console. Selbst nach erfolgreicher Wiederherstellung können jedoch Rankingvorteile, die durch Spam-Links erzielt wurden, nicht zurückgewonnen werden – sie sind dauerhaft verloren.

Das Aufkommen von KI-basierten Suchsystemen wie ChatGPT, Perplexity, Google AI Overviews und Claude eröffnet neue Dimensionen im Kampf gegen Suchmaschinenspam. Diese Systeme verlassen sich auf Webinhalte zur Generierung ihrer Antworten und sind daher anfällig für Spam und minderwertige Inhalte, die ihre Ergebnisse beeinflussen können. Im Gegensatz zu traditionellen Suchmaschinen, die eine Liste von Treffern anzeigen, fassen KI-Systeme Informationen in natürlichsprachlichen Antworten zusammen – was dazu führen kann, dass Spam-Inhalte, wenn sie in Trainingsdaten oder bei der Informationsbeschaffung eine Rolle spielen, verstärkt werden. Organisationen wie AmICited stellen sich dieser Herausforderung, indem sie Monitoring-Plattformen für KI-Prompts anbieten, die verfolgen, wo Marken und Domains in KI-generierten Antworten erscheinen. Diese Überwachung ist entscheidend, da Spam-Inhalte in KI-Antworten den Markenruf und die Sichtbarkeit auf andere Weise schädigen können als in klassischen Suchergebnissen. Mit der wachsenden Bedeutung von KI-Systemen für die Informationssuche steigt die Notwendigkeit, Spam auch in diesen neuen Suchparadigmen zu erkennen und zu verhindern, exponentiell. Die Herausforderung für KI-Systeme besteht darin, bei der Auswahl von Informationen für ihre Antworten zwischen autoritativen Quellen und Spam zu unterscheiden.

Organisationen, die auf nachhaltige Sichtbarkeit in Suchmaschinen setzen, sollten umfassende Strategien zur Vermeidung von Spam-Taktiken und zur Einhaltung der Suchmaschinenrichtlinien etablieren. Die Content-Strategie sollte auf die Erstellung origineller, hochwertiger und nutzerorientierter Inhalte ausgerichtet sein, die relevante Keywords natürlich und ohne künstliche Wiederholung oder Manipulation integrieren. Linkaufbau sollte auf den Erwerb natürlicher Backlinks durch Content-Qualität, Branchenbeziehungen und legitime Outreach-Maßnahmen setzen – statt auf Linkkauf oder die Teilnahme an Linknetzwerken. Die technische SEO sollte sauberes HTML, korrekte Meta-Tags, strukturierte Daten und transparente Redirects sicherstellen, die Suchmaschinen und Nutzer identisch behandeln. Regelmäßige Audits von Website-Inhalten, Links und technischen Elementen helfen, potenzielle Spam-Probleme frühzeitig zu erkennen, bevor Strafen drohen. Monitoring-Tools sollten Keyword-Rankings, Backlink-Profile und Suchsichtbarkeit überwachen, um ungewöhnliche Veränderungen zu erkennen, die auf Spam-Probleme oder Angriffe von Wettbewerbern hindeuten können. Die Optimierung der Nutzererfahrung stellt sicher, dass Inhalte in erster Linie menschlichen Besuchern dienen und Suchmaschinenoptimierung nur eine unterstützende Rolle spielt. Unternehmen sollten außerdem klare interne Richtlinien gegen Spam-Taktiken festlegen und ihre Teams über Risiken und Konsequenzen von Manipulationsversuchen aufklären.

Die Zukunft der Suchmaschinenspam-Erkennung wird zunehmend auf fortgeschrittene künstliche Intelligenz und maschinelles Lernen setzen, um ausgefeilte Manipulationsversuche in Echtzeit zu erkennen. SpamBrain und vergleichbare KI-Systeme werden sich ständig weiterentwickeln, um neue Spam-Variationen schneller zu erkennen, als menschliche Spammer diese entwickeln können – ein sich stetig beschleunigendes Wettrüsten zwischen Erkennung und Ausweichmanövern. Die Integration von KI-gestützten Suchsystemen in das Sucherlebnis der Nutzer erfordert neue Ansätze für die Spamerkennung, die speziell darauf ausgerichtet sind, wie diese Systeme Informationen finden und zusammenfassen. Suchmaschinen werden voraussichtlich verstärkt Nutzerverhaltensanalysen einsetzen, um Spam anhand des tatsächlichen Nutzerverhaltens und nicht nur auf Basis technischer Signale zu erkennen. Plattformübergreifendes Monitoring gewinnt an Bedeutung, da Spam-Taktiken zunehmend darauf abzielen, mehrere Suchsysteme gleichzeitig zu attackieren – von klassischen Suchmaschinen über KI-Chatbots bis hin zu neuen Suchparadigmen. Die Verbreitung von generativer KI-Inhalte schafft neue Spam-Herausforderungen, da automatisierte Systeme in großem Maßstab plausibel klingende, aber minderwertige oder irreführende Inhalte erzeugen können. Unternehmen wie AmICited werden eine immer wichtigere Rolle dabei spielen, Marken bei der Überwachung ihrer Sichtbarkeit in verschiedenen Suchsystemen zu unterstützen und Spam-Bedrohungen frühzeitig zu erkennen. Letztlich wird effektive Spam-Abwehr den Einsatz fortschrittlicher Algorithmen mit menschlicher Expertise, Feedbackmechanismen und branchenspezifischer Zusammenarbeit kombinieren müssen, um Suchqualität und Nutzervertrauen zu sichern.

Suchmaschinenspam verstößt gegen die Richtlinien der Suchmaschinen und nutzt täuschende Taktiken, um Rankings zu manipulieren, während legitime SEO White-Hat-Praktiken befolgt, die den Nutzern echten Mehrwert bieten. Legitime SEO konzentriert sich auf die Erstellung hochwertiger Inhalte, den natürlichen Aufbau von Backlinks und die Verbesserung der Nutzererfahrung, wohingegen Spam-Taktiken wie Keyword-Stuffing und Cloaking versuchen, Algorithmen auszutricksen. Googles Richtlinien verbieten Spam-Taktiken ausdrücklich und Websites, die diese nutzen, riskieren manuelle Maßnahmen oder eine vollständige Entfernung aus den Suchergebnissen.

Google verwendet **SpamBrain**, ein KI-basiertes System zur Spam-Prävention, das Websites kontinuierlich auf Verstöße gegen die Spam-Richtlinien überwacht. SpamBrain nutzt maschinelles Lernen, um Muster zu erkennen, die mit Spam zusammenhängen, einschließlich unnatürlicher Linkprofile, Keyword-Stuffing, Cloaking und anderer täuschender Techniken. Das System analysiert sowohl Onpage- als auch Offpage-Faktoren, Nutzerverhalten und Qualitätsmetriken von Inhalten, um zwischen legitimen Inhalten und Spam zu unterscheiden. Google führt zudem manuelle Überprüfungen durch und erhält Nutzerberichte über die Search Console, um Spam-Websites zu identifizieren und zu bestrafen.

Zu den wichtigsten Suchmaschinenspam-Taktiken gehören **Keyword-Stuffing** (übermäßige Verwendung von Schlüsselwörtern), **Cloaking** (Suchmaschinen und Nutzern wird unterschiedlicher Inhalt angezeigt), **Sneaky Redirects** (Nutzer werden auf andere Seiten weitergeleitet als Suchmaschinen), **Linkfarmen** (Netzwerke aus minderwertigen Sites, die nur für Verlinkungen erstellt wurden), **versteckter Text und Links** (für Nutzer unsichtbarer, aber für Crawler sichtbarer Inhalt) und **Kommentarspam** (automatisierter Spam in Kommentaren und Foren). Jede dieser Taktiken versucht, Suchalgorithmen durch Täuschung zu manipulieren, anstatt echten Mehrwert für Nutzer zu bieten.

Google verhängt verschiedene Strafen für Suchmaschinenspam, die von Rankingverlusten bis zur vollständigen Entfernung aus dem Index reichen. Websites können **manuelle Maßnahmen** über die Google Search Console erhalten, die auf spezifische Verstöße hinweisen, oder sie werden von algorithmischen Spam-Updates betroffen, die die Sichtbarkeit automatisch reduzieren. In schweren Fällen können Websites komplett aus dem Google-Index entfernt werden und erscheinen dann nicht mehr in den Suchergebnissen. Für eine Wiederherstellung müssen alle Spam-Elemente entfernt und über die Search Console eine erneute Überprüfung beantragt werden. Der Prozess kann mehrere Monate dauern und Rankingvorteile, die durch Spam-Links erlangt wurden, können nicht wiederhergestellt werden.

Suchmaschinenspam stellt erhebliche Herausforderungen für KI-basierte Suchsysteme wie **ChatGPT**, **Perplexity** und **Google AI Overviews** dar. Diese Systeme verlassen sich auf Webinhalte zur Generierung von Antworten, und Spam-Inhalte können deren Trainingsdaten verschmutzen oder die Ausgaben beeinflussen. Plattformen wie AmICited überwachen, wo Marken und Domains in KI-Antworten erscheinen und helfen Organisationen dabei, herauszufinden, ob Spam oder minderwertige Inhalte die Sichtbarkeit beeinträchtigen. Da KI-Systeme immer verbreiteter werden, wird die Spam-Erkennung immer wichtiger, um sicherzustellen, dass diese Plattformen Nutzern korrekte und vertrauenswürdige Informationen liefern.

Ja, Websites können sich von Spam-Strafen erholen, aber der Prozess erfordert eine umfassende Bereinigung. Website-Betreiber müssen alle Spam-Elemente – einschließlich Keyword-Stuffing, unnatürlicher Links, Cloaking und versteckter Inhalte – vollständig identifizieren und entfernen. Nach der Bereinigung sollte über die Google Search Console eine erneute Überprüfung mit detaillierter Dokumentation der Änderungen beantragt werden. Die Wiederherstellung dauert in der Regel mehrere Monate, da Googles Systeme die Website erneut crawlen und bewerten müssen. Bereits verlorene Rankingvorteile durch Spam-Links können jedoch nicht wiedererlangt werden; stattdessen muss der Aufbau legitimer Autorität über hochwertige Inhalte und natürlichen Linkaufbau erfolgen.

Die Überwachung von Suchmaschinenspam ist entscheidend, da Spam-Inhalte dem Markenimage und der Sichtbarkeit in Suchplattformen schaden können. Wettbewerber können Spam-Taktiken einsetzen, um Ihre Marke ins Visier zu nehmen, oder Ihre eigene Website kann kompromittiert und für Spam missbraucht werden. Tools wie **AmICited** helfen Organisationen dabei, ihre Marken-Erwähnungen in KI-Suchsystemen und traditionellen Suchmaschinen zu verfolgen und zu ermitteln, ob anstelle legitimer Markeninformationen Spam oder minderwertige Inhalte erscheinen. Diese Überwachung ermöglicht eine proaktive Erkennung von Spam-Problemen und hilft, die Markenintegrität in Suchergebnissen und KI-generierten Antworten zu wahren.

Beginnen Sie zu verfolgen, wie KI-Chatbots Ihre Marke auf ChatGPT, Perplexity und anderen Plattformen erwähnen. Erhalten Sie umsetzbare Erkenntnisse zur Verbesserung Ihrer KI-Präsenz.

Cloaking ist eine Black-Hat-SEO-Technik, bei der Suchmaschinen anderer Inhalt als Nutzern angezeigt wird. Erfahren Sie, wie es funktioniert, welche Risiken best...

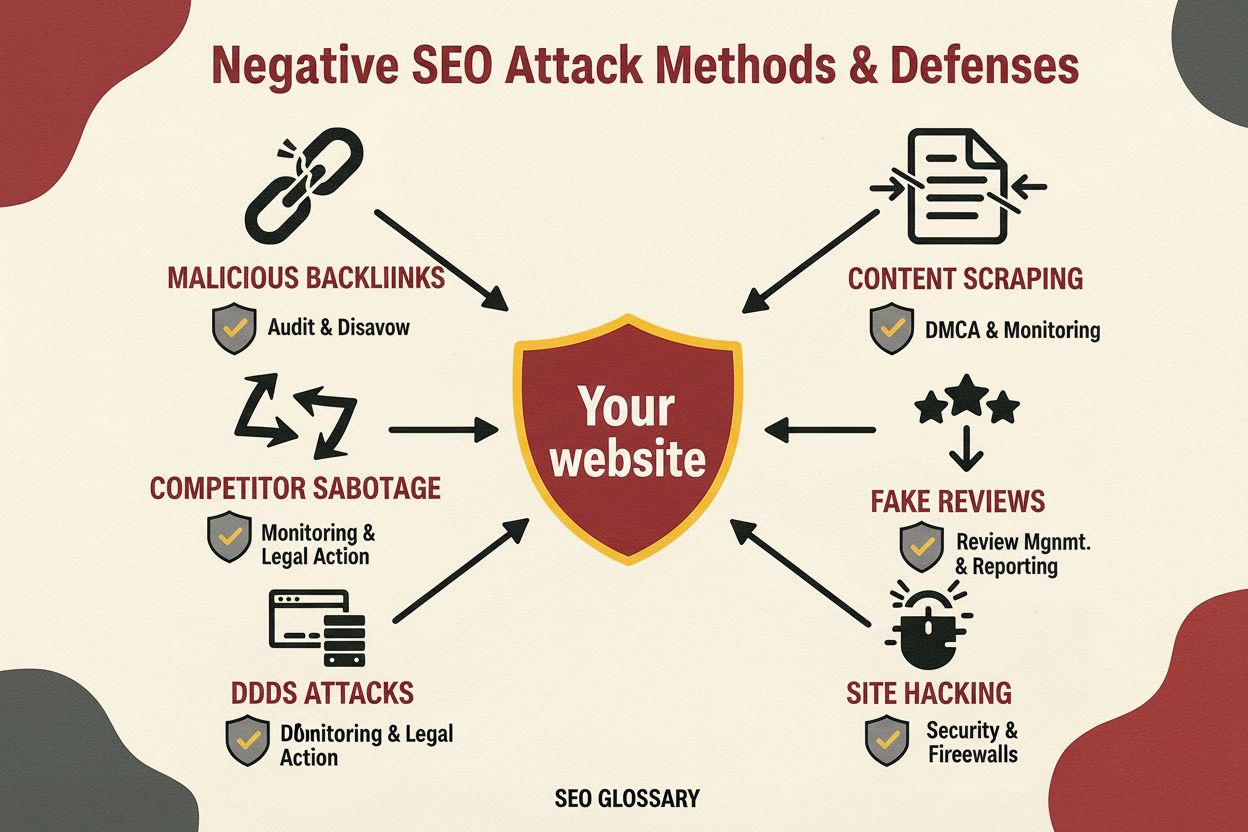

Negative SEO ist die Praxis, unethische Techniken einzusetzen, um Wettbewerber Rankings zu schädigen. Erfahren Sie mehr über Angriffstaktiken, Erkennungsmethode...

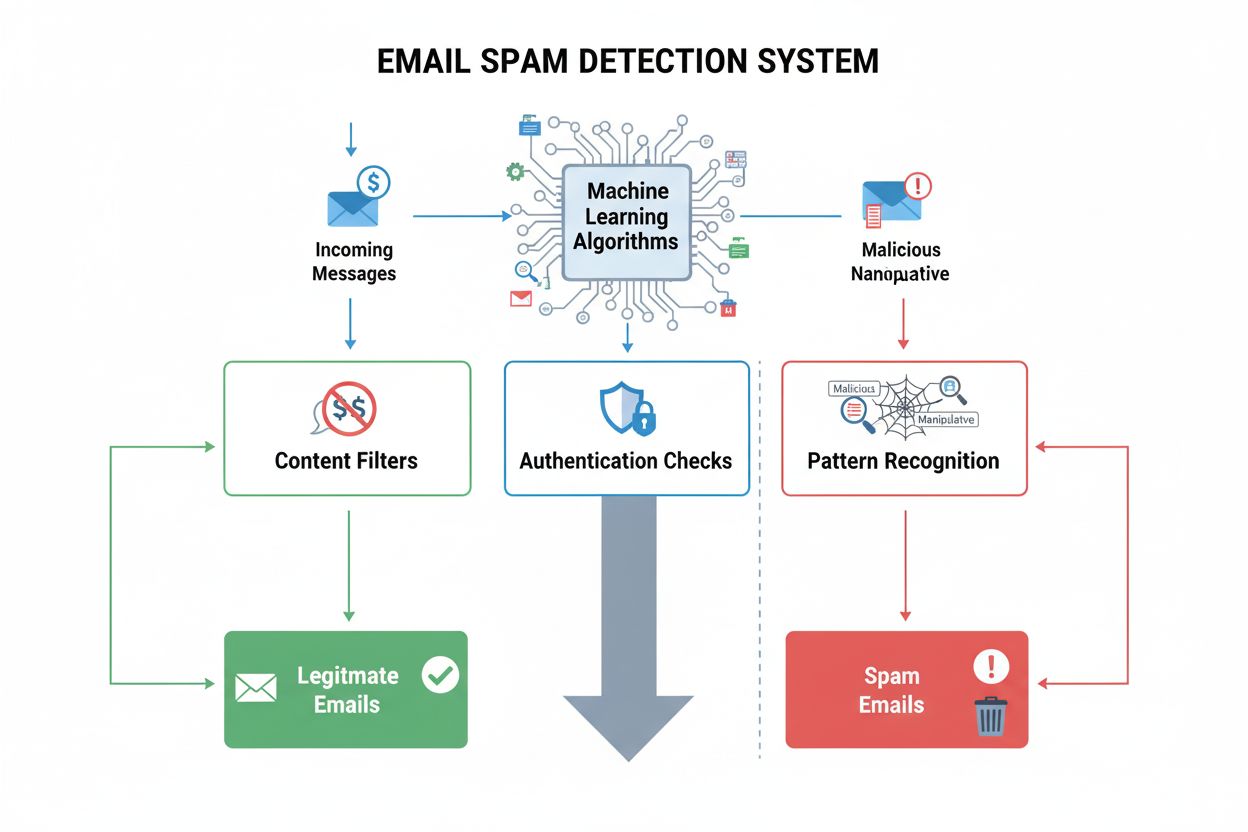

Spam-Erkennung identifiziert unerwünschte, manipulative Inhalte mithilfe von ML-Algorithmen und Verhaltensanalysen. Erfahren Sie, wie KI-Systeme Spam über E-Mai...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.