Les crawlers IA expliqués : GPTBot, ClaudeBot et plus encore

Comprenez comment fonctionnent les crawlers IA comme GPTBot et ClaudeBot, leurs différences avec les crawlers de recherche traditionnels, et comment optimiser v...

Découvrez comment prendre des décisions stratégiques concernant le blocage des crawlers IA. Évaluez le type de contenu, les sources de trafic, les modèles de revenus et la position concurrentielle grâce à notre cadre de décision complet.

Les crawlers IA sont devenus une force majeure de l’écosystème numérique, changeant fondamentalement la manière dont le contenu est découvert, indexé et utilisé sur Internet. Ces systèmes automatisés sont conçus pour parcourir systématiquement les sites web, extraire des données et les injecter dans des modèles d’apprentissage automatique qui alimentent aussi bien les moteurs de recherche que les applications d’IA générative. Le paysage comprend trois types distincts de crawlers : les extracteurs de données qui collectent des informations spécifiques à des fins commerciales, les crawlers de moteurs de recherche comme Googlebot qui indexent le contenu pour les résultats de recherche, et les crawlers d’assistants IA qui réunissent des données d’entraînement pour de grands modèles de langage. Parmi les exemples, on trouve GPTBot d’OpenAI, Claude-Web d’Anthropic et le crawler AI Overviews de Google, chacun ayant des objectifs et des impacts différents. Selon une analyse récente, environ 21% des 1 000 sites les plus visités ont déjà mis en place une forme de blocage des crawlers IA, preuve d’une prise de conscience croissante de la nécessité de gérer ces visiteurs automatisés. Comprendre quels crawlers accèdent à votre site et pourquoi ils le font est la première étape essentielle pour décider s’il faut les bloquer ou les autoriser. L’enjeu est de taille car cette décision impacte directement la visibilité de votre contenu, vos flux de trafic, et in fine, votre modèle de revenus.

Plutôt que de décider globalement de bloquer ou d’autoriser tous les crawlers IA, une approche plus sophistiquée consiste à évaluer votre situation spécifique via le cadre BEDC, pour Modèle Économique (Business Model), Risque d’Exposition, Dépendance au Référencement Naturel (Organic Search), et Position Concurrentielle. Chacun de ces quatre facteurs a un poids différent selon les caractéristiques de votre site, formant ensemble une matrice décisionnelle complète tenant compte de la complexité de la publication numérique moderne. Ce cadre reconnaît qu’il n’existe pas de réponse universelle—ce qui fonctionne pour un média d’information peut être inadapté à une entreprise SaaS, et ce qui profite à une marque établie peut nuire à un nouvel entrant. En évaluant systématiquement chaque facteur, vous dépassez la réaction émotionnelle face à l’IA pour prendre des décisions fondées sur des données, alignées sur vos objectifs business.

| Facteur | Recommandation | Point clé à considérer |

|---|---|---|

| Modèle économique | Les sites financés par la publicité doivent être plus prudents ; les modèles par abonnement peuvent être plus permissifs | Dépendance des revenus à l’engagement direct vs. la licence |

| Risque d’exposition | La recherche originale et le contenu propriétaire justifient un blocage ; le contenu banal peut être plus ouvert | Avantage concurrentiel lié à des données/analyses uniques |

| Dépendance au référencement naturel | Forte dépendance (>40% du trafic) suggère d’autoriser Google mais de bloquer les assistants IA | Équilibre entre visibilité et protection du contenu pour l’entraînement IA |

| Position concurrentielle | Les leaders du marché peuvent se permettre de bloquer ; les nouveaux entrants peuvent profiter de la visibilité IA | Avantage aux premiers partenariats IA vs. protection du contenu |

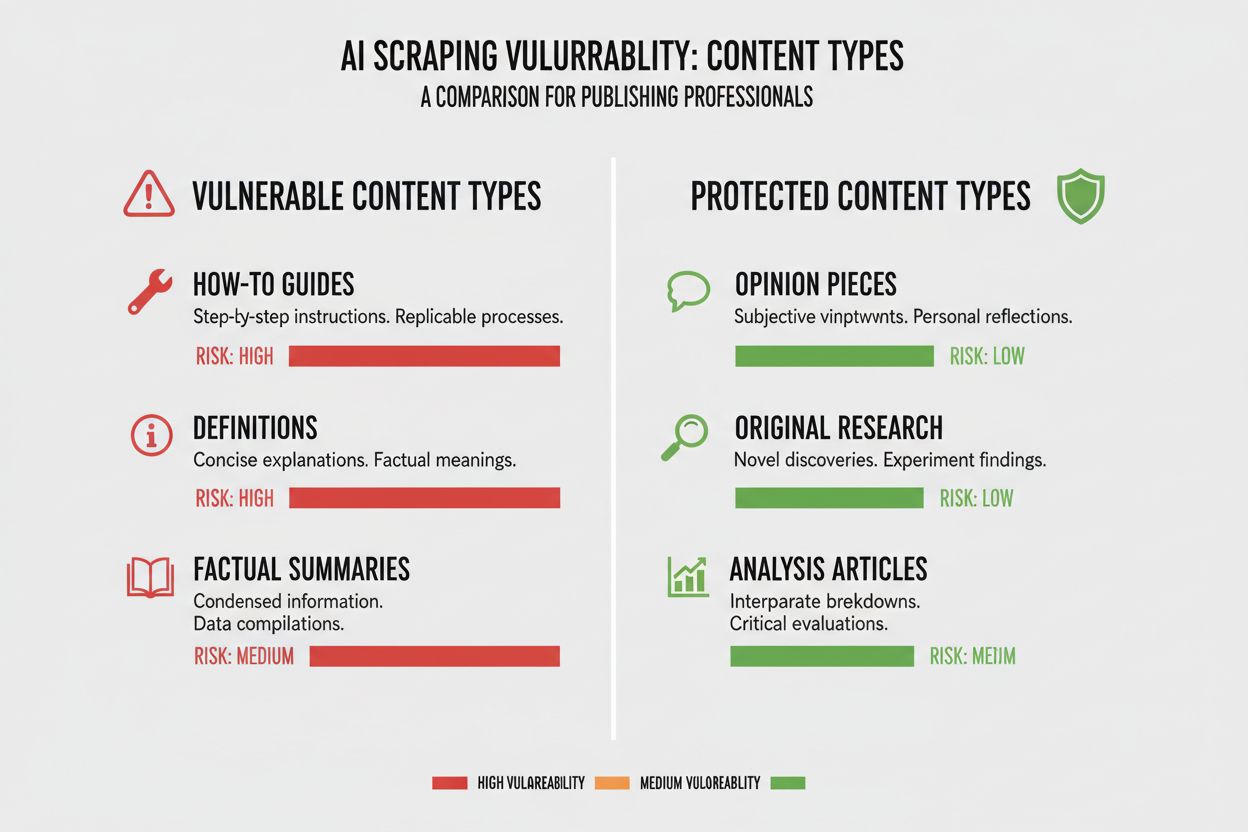

Les différents types de contenu présentent des niveaux de vulnérabilité très variés face aux crawlers IA, et comprendre la position de votre contenu sur ce spectre est essentiel pour décider. Les recherches originales et les données propriétaires sont vos actifs les plus précieux et méritent la protection la plus forte, car des modèles IA entraînés sur ces contenus peuvent concurrencer directement votre stratégie de monétisation. Les actualités et les informations en temps réel occupent une position intermédiaire—leur valeur liée à l’immédiateté diminue vite, mais l’indexation par les moteurs de recherche reste cruciale pour le trafic, ce qui crée une tension entre visibilité et protection contre l’entraînement IA. Le contenu banal comme les tutoriels, guides pratiques et informations générales est beaucoup moins vulnérable car largement disponible sur Internet, et peu susceptible d’être votre principal vecteur de revenus. Le contenu audio, vidéo et interactif bénéficie d’une protection naturelle, car les crawlers IA actuels ont du mal à en extraire une valeur significative, ce qui rend ces formats intrinsèquement plus sûrs face à l’entraînement IA. Le contenu éducatif intemporel et les tribunes/opinions occupent une place intermédiaire : précieux pour le référencement, mais moins directement menacés par la concurrence IA. Ce qu’il faut retenir, c’est que votre stratégie de blocage doit être proportionnelle à l’avantage concurrentiel offert par votre contenu—protégez vos joyaux, tout en restant ouvert pour les contenus qui bénéficient d’une large diffusion.

Votre dépendance au trafic organique issu des moteurs de recherche est probablement le facteur le plus concret de la décision face aux crawlers IA, car elle quantifie directement le compromis entre visibilité et protection du contenu. Les sites qui tirent plus de 40% de leur trafic du référencement naturel font face à une contrainte majeure : bloquer les crawlers IA signifie souvent aussi bloquer ou limiter Googlebot, ce qui ruinerait leur visibilité et leur trafic organique. La distinction entre Google-Extended (pour l’entraînement IA) et Googlebot (pour l’indexation) est cruciale ici, car en théorie vous pouvez autoriser l’un en bloquant l’autre, bien que cela soit techniquement complexe. Une étude de cas du New York Times illustre l’enjeu du trafic : la publication a reçu environ 240 600 visites de crawlers IA sur une période donnée, montrant l’ampleur du trafic généré par l’IA pour les grands éditeurs. Cependant, la réalité révélée par les données Akamai est que le blocage des crawlers entraîne 96% de trafic référent en moins depuis ces sources, ce qui suggère que la contribution réelle des crawlers IA est minime comparée au référencement traditionnel. Le ratio crawl/retour est très faible pour la plupart des crawlers IA—souvent moins de 0,15% du contenu crawlé génère une visite de retour—ce qui signifie que bloquer ces crawlers a peu d’impact sur votre trafic réel. Pour les sites très dépendants du référencement, la décision de bloquer les crawlers IA doit être soupesée face au risque de bloquer accidentellement les crawlers des moteurs de recherche, ce qui serait bien plus préjudiciable.

Votre modèle de revenus façonne fondamentalement votre approche des crawlers IA, car chaque stratégie de monétisation induit des incitations différentes autour de la diffusion ou de la protection du contenu. Les sites financés par la publicité sont les plus en tension avec les crawlers IA, puisque leurs revenus dépendent des visites et des impressions publicitaires, et que des modèles IA capables de résumer leur contenu réduisent la motivation à cliquer. Les modèles par abonnement peuvent se permettre d’être plus ouverts, car leurs revenus proviennent des abonnements directs et une certaine visibilité via l’IA pourrait même générer des inscriptions. Les modèles hybrides (publicité, abonnements, affiliation) nécessitent une réflexion plus fine, car bloquer les crawlers peut protéger la publicité mais nuire aux opportunités d’affiliation ou à la croissance des abonnements. Une opportunité émergente est le modèle de référencement IA, dans lequel les sites pourraient gagner des revenus en autorisant l’accès des crawlers IA contre attribution et trafic référent—un modèle encore en développement qui pourrait transformer l’économie de la diffusion de contenus. Pour les éditeurs souhaitant comprendre l’impact des crawlers IA, des outils comme AmICited.com offrent des fonctionnalités essentielles pour suivre où et comment leur contenu est cité et exploité par les systèmes IA, donnant une visibilité sur la valeur réelle échangée. L’essentiel est de bien cerner son modèle économique pour prévoir l’impact des crawlers IA sur chaque source de revenus, plutôt que de décider par principe.

Une fois la décision prise de bloquer certains crawlers IA, la mise en œuvre technique nécessite de bien comprendre les outils à votre disposition, leurs capacités et limites. L’approche la plus courante consiste à utiliser le fichier robots.txt, placé à la racine de votre site, qui indique aux crawlers les sections autorisées ou interdites. Cependant, robots.txt a une limite majeure : il repose sur la bonne volonté des crawlers, et certains robots malveillants ou agressifs peuvent l’ignorer totalement. Voici un exemple pour bloquer certains crawlers IA dans votre robots.txt :

User-agent: GPTBot

Disallow: /

User-agent: CCBot

Disallow: /

User-agent: anthropic-ai

Disallow: /

User-agent: Claude-Web

Disallow: /

En plus de robots.txt, pensez à bloquer ces principaux crawlers IA :

Pour une protection plus robuste, de nombreuses organisations mettent en œuvre un blocage au niveau CDN via des services comme Cloudflare, qui bloquent le trafic au niveau du réseau avant qu’il n’atteigne vos serveurs, offrant ainsi de meilleures performances et une sécurité accrue. Une approche à double niveau combinant robots.txt et blocage CDN offre la meilleure protection, car elle cible à la fois les crawlers respectueux et ceux qui ignorent vos directives. Notez que le blocage au niveau CDN requiert davantage de compétences techniques et peut avoir des effets secondaires imprévus s’il est mal configuré—il est donc recommandé aux structures disposant de ressources techniques dédiées.

La réalité du blocage des crawlers IA est que l’impact réel sur le trafic est bien plus faible que la réaction émotionnelle que suscite le scraping IA, et les données dressent un tableau plus nuancé que ce que beaucoup d’éditeurs imaginent. Selon une analyse récente, les crawlers IA représentent généralement seulement 0,15% du trafic total de la plupart des sites, un chiffre étonnamment bas au vu de l’attention portée au sujet. Néanmoins, la croissance du trafic des crawlers IA est spectaculaire, avec certains rapports faisant état d’une multiplication par 7 en un an des requêtes IA, ce qui montre que si l’impact actuel est faible, la trajectoire est ascendante. ChatGPT représente environ 78% du trafic crawler IA, faisant du crawler d’OpenAI l’acteur dominant, suivi par d’autres entreprises IA avec des parts beaucoup plus modestes. Le ratio crawl/retour est particulièrement révélateur : alors que les crawlers IA peuvent demander des millions de pages, ils génèrent des visites effectives à des taux souvent inférieurs à 0,15%, ce qui signifie que leur blocage a un impact minime sur votre audience réelle. Bloquer les crawlers IA réduit le trafic référent de 96%, mais comme ce trafic était déjà négligeable (<0,15% du trafic total), l’impact net sur votre activité est généralement insignifiant. Cela crée un paradoxe : bloquer les crawlers IA semble être une prise de position contre le vol de contenu, mais l’effet business réel est souvent si faible qu’il passe inaperçu dans vos statistiques. La vraie question n’est donc pas de savoir si le blocage nuira à votre trafic—c’est rarement le cas—mais si l’autorisation des crawlers crée des opportunités ou des risques stratégiques dépassant le faible apport de trafic concerné.

Votre position sur votre marché conditionne votre stratégie face aux crawlers IA, car la stratégie optimale d’un leader n’est pas celle d’un nouvel entrant. Les acteurs dominants comme le New York Times, le Wall Street Journal ou les grands médias peuvent se permettre de bloquer les crawlers IA, grâce à leur notoriété et à leurs liens directs avec l’audience, qui rendent la découverte via l’IA non essentielle. Les nouveaux entrants ou éditeurs de niche doivent, eux, raisonner différemment : être indexé par les systèmes IA et apparaître dans les résumés générés peut être l’un des rares moyens de gagner en visibilité face aux poids lourds. L’avantage du premier arrivé dans les partenariats IA peut être significatif—ceux qui négocient tôt des accords avec les entreprises IA peuvent obtenir de meilleures conditions (attribution, trafic référent, licences) que ceux qui attendent. Il existe aussi un effet de subvention : quand les leaders bloquent les crawlers IA, cela incite les entreprises IA à s’appuyer davantage sur le contenu des éditeurs ouverts, leur offrant potentiellement une visibilité disproportionnée. Ainsi, le blocage peut se retourner contre vous si vos concurrents autorisent les crawlers et bénéficient ainsi de la visibilité IA. Comprendre votre position dans le paysage concurrentiel est donc essentiel pour anticiper l’impact de votre décision par rapport à vos adversaires.

Décider de bloquer ou non les crawlers IA implique d’évaluer systématiquement votre situation au regard de critères concrets. Utilisez cette checklist pour guider votre réflexion :

Évaluation de l’exposition du contenu

Analyse de la composition du trafic

Évaluation de la position sur le marché

Évaluation du risque sur les revenus

Au-delà de cette évaluation initiale, mettez en place une revue trimestrielle de votre stratégie face aux crawlers IA, car le paysage évolue vite et la meilleure décision aujourd’hui peut ne plus l’être dans quelques mois. Utilisez des outils comme AmICited.com pour suivre où et comment votre contenu est cité et exploité par l’IA, vous donnant des données concrètes sur la valeur réelle de vos contenus. À retenir : cette décision ne doit pas être figée—elle nécessite une évaluation continue au fil de la maturité de l’IA et de l’évolution de votre activité.

Une opportunité émergente susceptible de bouleverser la gestion des crawlers IA est la fonctionnalité pay-per-crawl de Cloudflare, qui introduit un modèle d’Internet basé sur la permission, dans lequel les propriétaires de sites peuvent monétiser l’accès des crawlers IA plutôt que de simplement bloquer ou autoriser. Cette approche reconnaît que les entreprises IA tirent une valeur de l’accès à votre contenu, et plutôt qu’une guerre de blocages, vous pourriez négocier une compensation pour cet accès. Le modèle repose sur une vérification cryptographique pour garantir que seuls les crawlers autorisés accèdent à votre contenu, empêchant le scraping non autorisé tout en permettant aux entreprises IA légitimes de payer pour l’accès. Cela offre un contrôle granulaire sur quels crawlers accèdent à quels contenus, permettant de monétiser les contenus à forte valeur tout en restant ouvert aux moteurs de recherche et aux crawlers bénéfiques. Le modèle pay-per-crawl permet également l’audit IA, pour savoir précisément quel contenu a été crawlé, quand et par qui—une transparence impossible avec les approches de blocage classiques. Pour les éditeurs adoptant ce modèle, les capacités de suivi d’AmICited.com gagnent en importance, car vous pouvez non seulement savoir où votre contenu apparaît dans les IA, mais aussi vérifier que vous êtes rémunéré correctement. Si ce modèle reste naissant et encore peu adopté, il offre une alternative bien plus sophistiquée que le choix binaire blocage/autorisation—une alternative qui reconnaît la valeur mutuelle de la relation éditeurs/IA tout en protégeant vos intérêts par des mécanismes contractuels et techniques.

Bloquer les crawlers IA les empêche d'accéder à votre contenu via robots.txt ou un blocage au niveau du CDN, protégeant ainsi votre contenu contre une utilisation dans l'entraînement IA. Autoriser les crawlers signifie que votre contenu peut être indexé par les systèmes IA, apparaissant potentiellement dans des résumés et réponses générés par l'IA. Le choix dépend du type de contenu, du modèle économique et de la position concurrentielle.

Bloquer les crawlers IA ne nuira pas directement à votre SEO si vous ne bloquez que les crawlers spécifiques à l'IA comme GPTBot tout en autorisant Googlebot. Cependant, si vous bloquez accidentellement Googlebot, votre classement dans les résultats de recherche en pâtira considérablement. L'essentiel est d'utiliser un contrôle granulaire pour ne bloquer que les crawlers d'entraînement IA tout en préservant l'accès des moteurs de recherche.

Oui, vous pouvez utiliser le fichier robots.txt pour bloquer des crawlers spécifiques en fonction de leur user-agent tout en en autorisant d'autres. Par exemple, vous pourriez bloquer GPTBot tout en autorisant Google-Extended, ou inversement. Cette approche granulaire vous permet de protéger votre contenu de certaines entreprises IA tout en restant visible pour d'autres.

robots.txt est une norme volontaire qui repose sur la bonne volonté des crawlers à respecter vos instructions—certaines entreprises IA l'ignorent. Le blocage au niveau CDN (comme celui de Cloudflare) bloque le trafic à l'entrée du réseau avant qu'il n'atteigne vos serveurs, offrant ainsi une protection plus stricte. Une approche à double niveau combinant les deux méthodes offre la meilleure protection.

Vous pouvez consulter les journaux de votre serveur pour repérer les user-agents de crawlers IA connus comme GPTBot, CCBot et Claude-Web. Des outils comme AmICited.com offrent des capacités de surveillance pour suivre où votre contenu apparaît dans les systèmes IA et à quelle fréquence il est consulté par les crawlers IA.

Le modèle pay-per-crawl est en émergence, où des entreprises IA paient pour accéder à votre contenu. Bien qu'il soit encore en phase bêta avec une adoption limitée, cela pourrait constituer une nouvelle source de revenus. La viabilité dépend du volume de trafic des crawlers IA et des tarifs que les entreprises IA sont prêtes à payer.

Si un crawler IA ignore vos directives dans le robots.txt, mettez en place un blocage au niveau CDN via des services comme Cloudflare. Vous pouvez aussi configurer votre serveur pour renvoyer des erreurs 403 aux user-agents de crawlers IA connus. En cas de violations persistantes, envisagez une action légale ou contactez directement l'entreprise IA concernée.

Réexaminez votre stratégie vis-à-vis des crawlers IA chaque trimestre, car le paysage évolue rapidement. Surveillez les changements dans le trafic des crawlers IA, l'arrivée de nouveaux crawlers sur le marché et les évolutions de votre position concurrentielle. Utilisez des outils comme AmICited.com pour suivre comment votre contenu est exploité par les systèmes IA et ajustez votre stratégie en conséquence.

Suivez où votre contenu apparaît dans les réponses générées par l'IA et comprenez l'impact des crawlers IA sur votre activité grâce à la plateforme de surveillance complète d'AmICited.com.

Comprenez comment fonctionnent les crawlers IA comme GPTBot et ClaudeBot, leurs différences avec les crawlers de recherche traditionnels, et comment optimiser v...

Découvrez quels crawlers IA autoriser ou bloquer dans votre robots.txt. Guide complet couvrant GPTBot, ClaudeBot, PerplexityBot et plus de 25 crawlers IA avec e...

Découvrez comment identifier et surveiller les crawlers IA comme GPTBot, PerplexityBot et ClaudeBot dans vos logs serveur. Découvrez les chaînes user-agent, les...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.