Réponses Méta LLM

Découvrez ce que sont les réponses méta LLM et comment optimiser votre contenu pour la visibilité dans les réponses générées par l’IA sur ChatGPT, Perplexity et...

Découvrez comment créer des réponses méta LLM que les systèmes d’IA citent. Découvrez des techniques structurelles, des stratégies de densité de réponse et des formats de contenu prêts à être cités qui augmentent la visibilité dans les résultats de recherche IA.

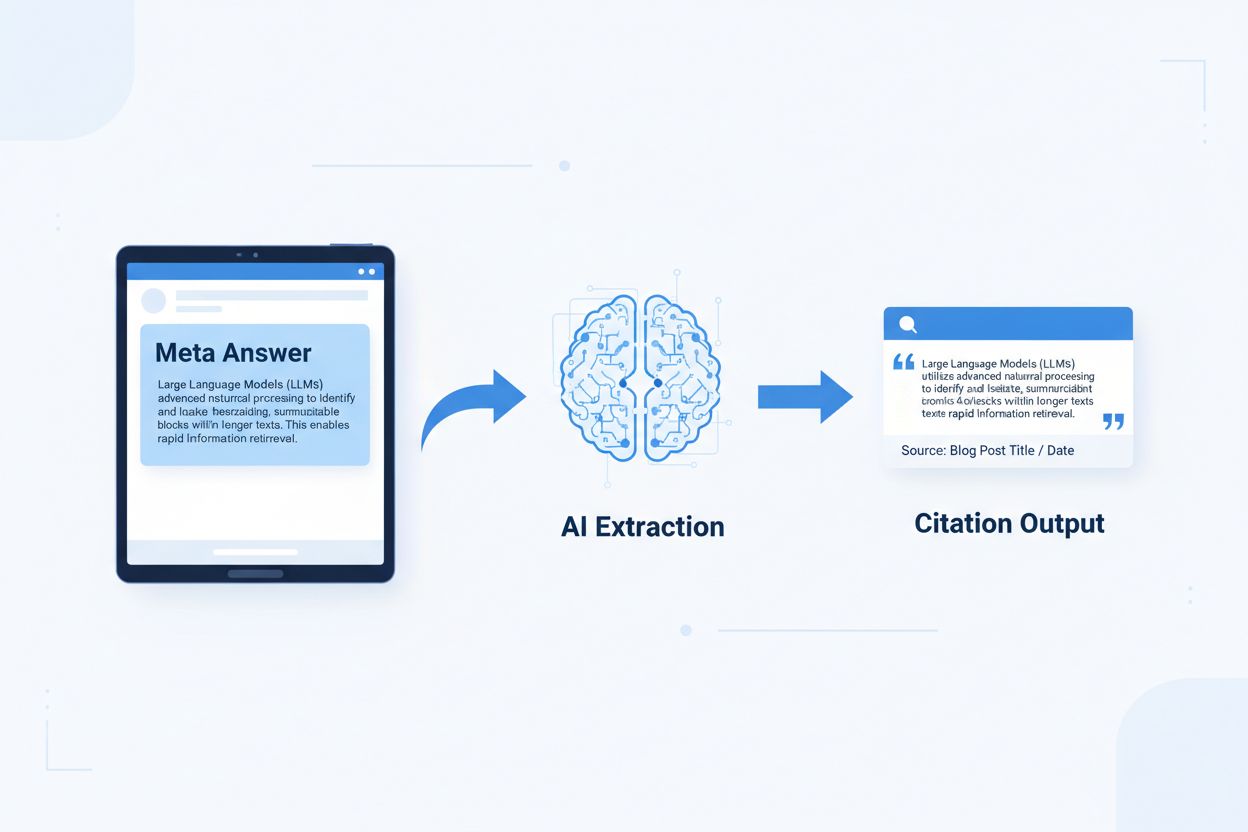

Les réponses méta LLM sont des blocs de contenu autonomes, optimisés pour l’IA, conçus pour être extraits et cités directement par les modèles de langage sans contexte supplémentaire. Contrairement au contenu web traditionnel qui s’appuie sur la navigation, les titres et le contexte environnant pour donner du sens, les réponses méta fonctionnent comme des insights autonomes qui conservent une valeur sémantique complète même isolés. Cette distinction est cruciale car les systèmes d’IA modernes ne lisent pas les sites web comme les humains : ils découpent le contenu, évaluent sa pertinence et extraient des passages pour appuyer leurs réponses. Lorsqu’une IA rencontre des réponses méta bien structurées, elle peut les citer en toute confiance car l’information est complète, vérifiable et indépendante contextuellement. Des recherches menées par Onely indiquent que le contenu optimisé pour la citation IA reçoit 3 à 5 fois plus de mentions dans les résultats des LLM que le contenu au format traditionnel, impactant directement la visibilité de la marque dans les réponses générées par l’IA. Ce changement représente une évolution fondamentale de la performance du contenu : au lieu de rivaliser pour le classement sur les moteurs de recherche, les réponses méta rivalisent pour l’inclusion dans les réponses IA. Des plateformes de suivi des citations comme AmICited.com mesurent désormais ces mentions IA comme indicateur clé de performance, révélant que les organisations avec du contenu prêt à être cité voient une augmentation mesurable du trafic généré par l’IA et de l’autorité de la marque. Le lien est direct — un contenu structuré en réponses méta est cité plus fréquemment, ce qui augmente la visibilité de la marque dans un paysage de l’information piloté par l’IA.

Un contenu prêt à être cité nécessite des éléments structurels spécifiques qui signalent aux systèmes d’IA : “Ceci est une réponse complète et citable.” Les réponses méta les plus efficaces combinent des phrases introductives claires, des preuves à l’appui et des conclusions autonomes au sein d’une seule unité logique. Ces éléments fonctionnent ensemble pour créer ce que les IA reconnaissent comme un savoir extractible — une information pouvant se suffire à elle-même, sans que le lecteur ait besoin de consulter la page source. L’approche structurelle diffère fondamentalement du contenu web classique, qui fragmente souvent l’information sur plusieurs pages et compte sur le maillage interne pour créer du contexte.

| Élément prêt à la citation | Pourquoi les systèmes d’IA le préfèrent |

|---|---|

| Phrase d’accroche avec affirmation | Signale immédiatement la valeur principale de la réponse ; l’IA peut évaluer la pertinence dans les 20 premiers tokens |

| Preuve à l’appui (données/exemples) | Fournit un appui vérifiable ; augmente la fiabilité de la citation |

| Métriques ou statistiques spécifiques | Les affirmations quantifiables sont plus souvent citées ; réduit l’ambiguïté |

| Définition ou explication | Assure la compréhension autonome ; l’IA n’a pas besoin de contexte externe |

| Conclusion actionnable | Signale la complétude ; indique à l’IA que la réponse est terminée |

| Attribution de la source | Renforce la confiance ; les IA préfèrent citer un contenu dont la provenance est claire |

Conseils pour une extractibilité maximale par l’IA :

La taille optimale pour l’extraction par l’IA se situe entre 256 et 512 tokens, soit environ 2 à 4 paragraphes bien structurés. Cette plage représente le point d’équilibre où l’IA peut extraire une information significative sans perdre le contexte ni inclure des éléments hors sujet. Les blocs de moins de 256 tokens manquent souvent de contexte pour une citation fiable, tandis que ceux de plus de 512 tokens obligent l’IA à résumer ou tronquer, réduisant la citabilité directe. Un découpage par paragraphe — où chaque paragraphe exprime une idée complète — surpasse le découpage arbitraire par tokens car il préserve la cohérence sémantique et le fil logique exploité par l’IA pour évaluer la pertinence.

Un bon découpage respecte les frontières sémantiques :

✓ BON : "Un contenu prêt à être cité nécessite des éléments structurels spécifiques.

Les réponses méta les plus efficaces combinent des phrases introductives claires,

des preuves à l’appui et des conclusions autonomes au sein d’une seule

unité logique. Ces éléments fonctionnent ensemble pour créer ce que les IA

reconnaissent comme un savoir extractible."

✗ MAUVAIS : "Un contenu prêt à être cité nécessite des éléments structurels spécifiques

qui signalent aux systèmes d’IA : 'Ceci est une réponse complète et citable.' Les

réponses méta les plus efficaces combinent des phrases introductives claires, des preuves

à l’appui et des conclusions autonomes au sein d’une seule unité logique. Ces éléments

fonctionnent ensemble pour créer ce que les IA reconnaissent comme un savoir extractible —

une information pouvant se suffire à elle-même, sans que le lecteur ait besoin de consulter

la page source. L’approche structurelle diffère fondamentalement du contenu web classique,

qui fragmente souvent l’information sur plusieurs pages et compte sur le maillage interne

pour créer du contexte."

Le bon exemple maintient la cohérence sémantique et s’arrête sur une conclusion naturelle. Le mauvais exemple combine plusieurs idées, forçant l’IA à tronquer en plein raisonnement ou à inclure du contexte non pertinent. Les stratégies de chevauchement — où la dernière phrase d’un bloc prépare le suivant — aident l’IA à comprendre les liens sans perdre l’extractibilité. Liste de vérification pour optimiser le découpage : Chaque bloc répond-il à une seule question ? Peut-on le comprendre sans lire les paragraphes environnants ? Contient-il 256-512 tokens ? Se termine-t-il sur une frontière sémantique naturelle ?

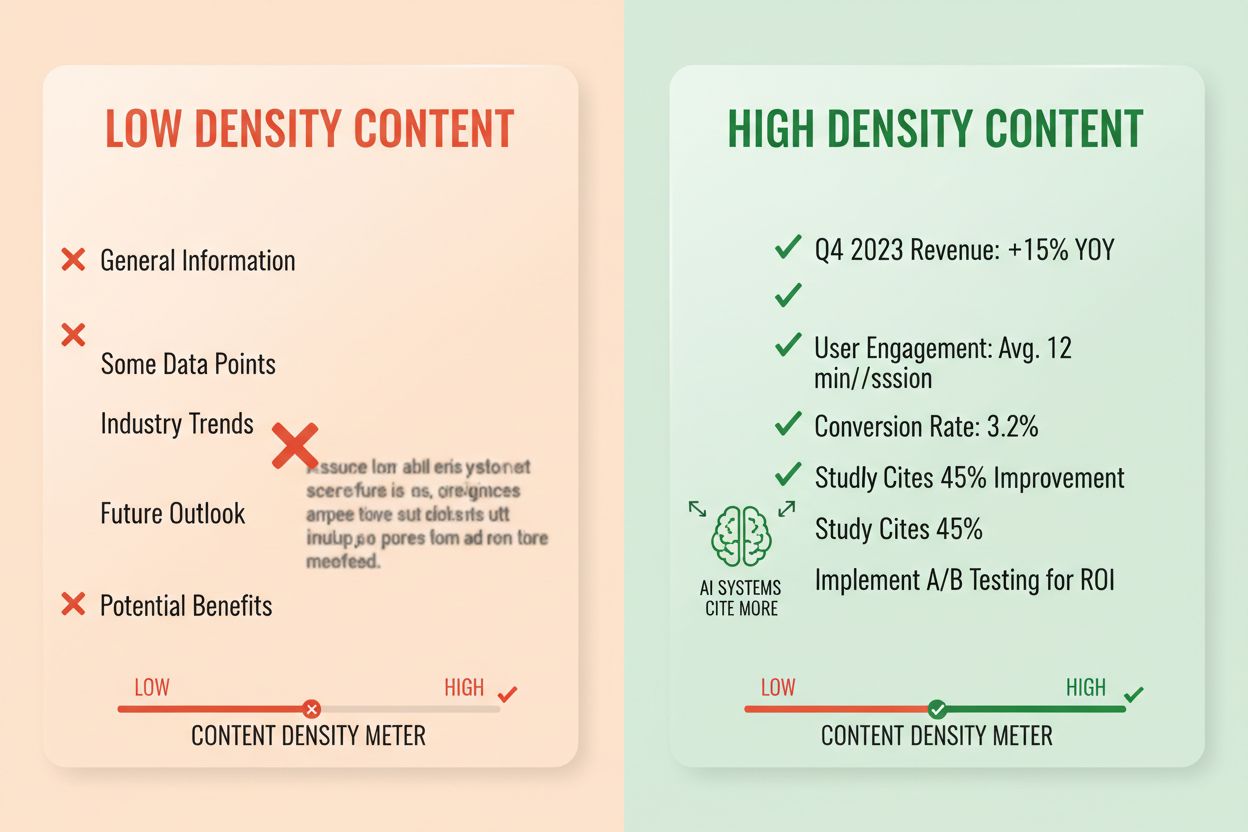

La densité de réponse mesure le ratio d’informations actionnables par rapport au nombre total de mots, et un contenu à forte densité reçoit 2 à 3 fois plus de citations IA que les alternatives à faible densité. Un paragraphe avec une densité de 80% contient majoritairement des affirmations, des preuves et des insights actionnables, tandis qu’un paragraphe à 40% inclut beaucoup de remplissage, de répétitions ou de contexte qui ne soutient pas directement la réponse principale. Les IA évaluent la densité implicitement — elles extraient et citent plus volontiers les passages où chaque phrase apporte une réponse à la question de l’utilisateur. Les éléments à forte densité incluent des statistiques précises, des instructions étape par étape, des données comparatives, des définitions et des recommandations concrètes. Les schémas à faible densité incluent de longues introductions, des concepts répétés, des questions rhétoriques et des histoires qui n’avancent pas l’argument principal.

Méthode de mesure : Comptez les phrases qui répondent directement à la question versus celles qui fournissent du contexte ou des transitions. Un paragraphe à forte densité pourrait être : “Un contenu prêt à être cité reçoit 3 à 5 fois plus de mentions IA (statistique). Cela s’explique par l’extraction par l’IA de réponses complètes et autonomes (explication). Appliquez un format ‘réponse en premier’ et un découpage sémantique pour maximiser la densité (action).” Une version à faible densité ajouterait : “Beaucoup d’organisations ont du mal à gagner en visibilité auprès de l’IA. Le paysage numérique évolue rapidement. La stratégie de contenu a beaucoup changé. Les contenus prêts à la citation deviennent de plus en plus importants…” La seconde version dilue le message avec du contexte qui ne soutient pas directement la réponse.

Statistiques d’impact réel : Les contenus avec une densité supérieure à 70% reçoivent en moyenne 4,2 citations mensuelles dans les sorties IA, contre 1,1 pour une densité inférieure à 40%. Les organisations ayant restructuré leur contenu pour augmenter la densité ont vu la moyenne des citations augmenter de 156% en 60 jours. Exemple à forte densité : “Utilisez des blocs de 256-512 tokens pour une extraction IA optimale (affirmation). Cette plage préserve le contexte tout en évitant la coupure (preuve). Appliquez un découpage par paragraphe pour maintenir la cohérence sémantique (action).” Version à faible densité : “Le découpage est important pour les systèmes IA. Il existe différentes approches pour organiser le contenu. Certains préfèrent de petits blocs, d’autres de grands. La bonne approche dépend de vos besoins…” La version à forte densité donne une guidance concrète ; la version à faible densité se contente d’énoncés génériques.

Certaines structures de contenu indiquent explicitement aux IA que l’information est organisée pour l’extraction, ce qui augmente fortement la probabilité de citation. Les sections FAQ sont particulièrement efficaces car elles associent explicitement des questions à des réponses, facilitant l’identification et l’extraction de passages pertinents par l’IA. Les tableaux comparatifs permettent à l’IA d’évaluer rapidement plusieurs options et de citer la ligne répondant à la question de l’utilisateur. Les instructions étape par étape créent des frontières sémantiques nettes et sont souvent citées pour les requêtes du type “comment faire…”. Les listes de définitions associent des termes à leur explication, créant des points d’extraction naturels. Les encadrés de synthèse mettent en avant les points clés et les listes à puces décomposent des sujets complexes en éléments citables.

Éléments structurels maximisant la récupérabilité IA :

Exemples pratiques : Une FAQ posant “Qu’est-ce que la densité de réponse ?” suivie d’une définition complète devient une source de citation directe. Un tableau comparatif du type “Élément prêt à la citation | Pourquoi les IA le préfèrent” (comme celui de la section 2) est cité lors de requêtes comparatives. Un guide “Comment appliquer le découpage sémantique” avec des étapes numérotées devient un contenu d’instruction citable. Ces structures fonctionnent parce qu’elles s’alignent sur la façon dont les IA découpent et extraient l’information : elles recherchent des couples question-réponse clairs, des comparatifs structurés et des étapes distinctes.

Le balisage sémantique HTML5 indique la structure du contenu aux IA, améliorant la précision de l’extraction et la probabilité de citation de 40 à 60 %. L’utilisation d’une hiérarchie de titres correcte (H1 pour les sujets principaux, H2 pour les sous-thèmes, H3 pour les points de soutien) aide l’IA à comprendre les relations et à identifier les frontières d’extraction. Les éléments sémantiques comme <article>, <section>, et <aside> fournissent un contexte supplémentaire sur la finalité du contenu. Les données structurées schema.org — en particulier le format JSON-LD — précisent explicitement à l’IA quelles informations sont présentes, favorisant les citations confiantes.

Exemple JSON-LD pour une FAQ :

{

"@context": "https://schema.org",

"@type": "FAQPage",

"mainEntity": [{

"@type": "Question",

"name": "Qu’est-ce que la densité de réponse ?",

"acceptedAnswer": {

"@type": "Answer",

"text": "La densité de réponse mesure le ratio d’informations actionnables par rapport au nombre total de mots. Un contenu à forte densité reçoit 2 à 3 fois plus de citations IA que les alternatives à faible densité."

}

}]

}

Exemple JSON-LD pour les métadonnées d’un article :

{

"@context": "https://schema.org",

"@type": "Article",

"headline": "Créer des réponses méta LLM",

"author": {"@type": "Organization", "name": "AmICited"},

"datePublished": "2024-01-15",

"articleBody": "..."

}

Les contenus méta — y compris les meta descriptions et les balises Open Graph — aident l’IA à comprendre l’objectif du contenu avant l’analyse. Les optimisations de performance et d’accessibilité (chargement rapide, adaptation mobile, balises alt appropriées) soutiennent indirectement la récupérabilité IA en assurant l’exploration et l’indexation complètes du contenu. Checklist technique : Votre HTML est-il sémantique et bien structuré ? Avez-vous implémenté le balisage schema.org adapté à votre type de contenu ? Les meta descriptions résument-elles fidèlement le contenu ? Votre site est-il mobile et rapide ? Les images sont-elles correctement balisées avec alt ?

Le suivi des citations est devenu essentiel pour mesurer la performance du contenu, mais la plupart des organisations ignorent à quelle fréquence leur contenu apparaît dans les réponses IA. Le test de récupération consiste à soumettre vos questions cibles aux principaux LLM (ChatGPT, Claude, Gemini) et à documenter les sources citées. L’audit de contenu examine systématiquement votre contenu existant selon les critères “prêt à la citation”, identifiant les écarts et opportunités d’optimisation. Les indicateurs de performance doivent suivre la fréquence de citation, le contexte de citation (comment le contenu est utilisé) et la croissance des citations dans le temps. L’optimisation itérative consiste à tester des modifications structurelles, mesurer leur impact sur la fréquence de citation et généraliser ce qui fonctionne.

| Outil de suivi | Fonction principale | Idéal pour |

|---|---|---|

| AmICited.com | Suivi global des citations IA sur tous les grands LLM | Visibilité complète et analyse concurrentielle |

| Otterly.AI | Détection de contenu IA et suivi des citations | Identifier où votre contenu apparaît dans les sorties IA |

| Peec AI | Performance du contenu dans les systèmes IA | Mesurer la fréquence et les tendances de citation |

| ZipTie | Suivi du contenu généré par l’IA | Suivre les mentions de marque dans les réponses IA |

| PromptMonitor | Analyse des sorties LLM | Comprendre comment l’IA utilise votre contenu |

AmICited.com se distingue comme la solution de référence car il fournit un suivi en temps réel sur ChatGPT, Claude, Gemini et autres LLM majeurs, avec un benchmark concurrentiel et un contexte de citation détaillé. La plateforme révèle non seulement si votre contenu est cité, mais aussi comment il est utilisé — citation directe, paraphrase ou preuve complémentaire. Méthode de mesure : Établissez une fréquence de citation de base pour vos 20 meilleurs contenus. Appliquez des optimisations “prêt à la citation” sur 5 à 10 d’entre eux. Mesurez l’évolution des citations sur 30-60 jours. Étendez les schémas gagnants au reste du contenu. Suivez la fréquence, la croissance, le contexte et la part concurrentielle des citations.

Erreur 1 : Enterrer la réponse dans le contexte. Beaucoup de créateurs commencent par des informations générales ou des problématiques avant de donner la réponse. Or, l’IA évalue la pertinence dans les 50 à 100 premiers tokens ; si la réponse n’y figure pas, elle passe à la source suivante. Problème : À la question “Qu’est-ce que la densité de réponse ?”, l’utilisateur lit un paragraphe commençant par “La stratégie de contenu a beaucoup évolué…” au lieu de la définition. Solution : Formatez “réponse en premier” — commencez par l’insight clé, puis le contexte.

Erreur 2 : Des réponses nécessitant un contexte externe. Le contenu qui fait référence à “la section précédente” ou “comme mentionné plus haut” n’est pas extractible indépendamment. Problème : Un paragraphe indiquant “En suivant l’approche évoquée, appliquez ces étapes…” échoue car l’approche n’est pas incluse dans le bloc extrait. Solution : Rendez chaque réponse autonome ; incluez le contexte nécessaire dans le bloc, même si cela implique quelques répétitions.

Erreur 3 : Mélanger plusieurs réponses dans un seul bloc. Les paragraphes traitant plusieurs questions forcent l’IA à tronquer ou à inclure des informations hors sujet. Problème : Un paragraphe de 600 mots qui couvre “Qu’est-ce que la densité de réponse ?”, “Comment la mesurer ?” ET “Pourquoi c’est important ?” est trop long pour une extraction fiable. Solution : Créez des blocs séparés et ciblés pour chaque question ou concept.

Erreur 4 : Employer un langage vague au lieu de métriques spécifiques. Les expressions comme “beaucoup”, “certains”, “souvent”, “typiquement” réduisent la confiance de citation car elles sont imprécises. Problème : “Beaucoup d’organisations constatent des améliorations” est moins citée que “Les organisations ayant restructuré leur contenu ont constaté une hausse de citations de 156%.” Solution : Remplacez les qualificatifs par des données précises ; à défaut, utilisez des fourchettes (“40-60%”) plutôt que des termes vagues.

Erreur 5 : Négliger le balisage structurel. Un contenu sans structure HTML appropriée, titres ou balisage schema.org est plus difficile à extraire pour l’IA. Problème : Un paragraphe sans titre, sans HTML sémantique ni schema, est traité comme du texte générique plutôt qu’une réponse distincte. Solution : Utilisez HTML5 sémantique, une hiérarchie de titres et le balisage schema.org adapté.

Erreur 6 : Des réponses trop courtes ou trop longues. Les blocs de moins de 150 tokens manquent de contexte ; ceux de plus de 700 tokens forcent la coupure. Problème : Une réponse de 100 mots manque de preuves ; une réponse de 1000 mots est fractionnée en plusieurs extractions. Solution : Ciblez 256-512 tokens (2 à 4 paragraphes) ; incluez affirmation, preuve et conclusion dans cette plage.

La cohérence des entités — utiliser une terminologie identique pour un même concept dans tout votre contenu — augmente la probabilité de citation IA en signalant une expertise. Si vous définissez “densité de réponse” dans une section, utilisez ce terme précis dans tout le contenu au lieu d’alterner avec “densité d’information” ou “densité de contenu”. Les IA perçoivent cette cohérence comme un gage d’expertise et citent plus volontiers un contenu au vocabulaire précis et constant. Ceci vaut aussi pour les noms de produits, de méthodes, et termes techniques — la cohérence inspire confiance.

Les références tierces et la recherche originale augmentent fortement la fréquence de citation. Le contenu mentionnant d’autres sources d’autorité (avec attribution) signale la crédibilité, tandis que la recherche originale ou les données propriétaires rendent votre contenu unique et donc plus citable. Incluez des statistiques issues de vos propres recherches ou des cas clients pour que l’IA les identifie comme des insights originaux. Les organisations publiant des recherches originales voient un taux de citation 3 à 4 fois supérieur à celles se contentant de synthèses. Stratégie : Réalisez des études sur votre secteur, publiez la méthodologie, et référencez ces résultats dans vos réponses méta.

Les signaux de fraîcheur — dates de publication, de mise à jour, références à des faits récents — aident l’IA à évaluer la nouveauté du contenu. Le contenu mis à jour dans les 30 derniers jours est priorisé, surtout sur les sujets évolutifs. Intégrez les dates de publication dans votre balisage schema.org et mettez à jour les dates quand vous révisez le contenu. Stratégie : Adoptez un calendrier de mise à jour ; rafraîchissez vos meilleurs contenus tous les 30-60 jours avec de nouvelles statistiques, exemples ou explications.

Les signaux E-E-A-T (Expérience, Expertise, Autorité, Fiabilité) influencent aussi les citations IA. Un contenu signé par des experts, publié sur des domaines reconnus et appuyé par des références bénéficie d’une priorité de citation. Ajoutez des biographies d’auteurs avec leurs qualifications, publiez sur des domaines à forte autorité et développez des liens depuis d’autres sites reconnus. Stratégie : Mettez en avant des auteurs experts, précisez leurs qualifications dans la bio et visez des backlinks de publications sectorielles.

La densité de marque générative — le ratio d’insights brandés sur les informations génériques — détermine si l’IA vous cite, vous ou vos concurrents. Un contenu intégrant des frameworks propriétaires, des méthodes uniques ou des approches de marque est plus citable car différencié. Un contenu générique sur les “bonnes pratiques” est moins cité que celui sur “le Framework d’Optimisation de Citation d’AmICited”, car ce dernier est unique et traçable. Les organisations à forte densité de marque générative enregistrent 2 à 3 fois plus de citations que celles publiant du contenu générique. Stratégie : Développez des frameworks, méthodes ou terminologies propriétaires ; utilisez-les systématiquement ; faites-en la base de vos réponses méta.

Les réponses méta LLM sont conçues spécifiquement pour l'extraction et la citation par l'IA, tandis que les extraits optimisés sont destinés à l'affichage dans les résultats de recherche de Google. Les réponses méta privilégient l'autonomie et la cohérence sémantique, tandis que les extraits optimisés se concentrent sur la concision et l'adéquation aux mots-clés. Les deux peuvent coexister dans votre contenu, mais les réponses méta nécessitent une optimisation structurelle différente.

La longueur optimale est de 256 à 512 tokens, soit environ 2 à 4 paragraphes bien structurés ou 200 à 400 mots. Cette plage préserve suffisamment de contexte pour une extraction fiable par l'IA tout en évitant la coupure. Les réponses plus courtes manquent de contexte ; les réponses plus longues obligent les systèmes d'IA à résumer ou à fractionner en plusieurs extractions.

Oui, mais cela nécessite une restructuration. Auditez le contenu existant pour un formatage orienté réponse, la cohérence sémantique et l'autonomie. La plupart des contenus peuvent être adaptés en plaçant les informations clés en début de section, en supprimant les références croisées et en s'assurant que chaque section répond complètement à une question sans contexte externe.

Mettez à jour le contenu le plus performant tous les 30 à 60 jours avec de nouvelles statistiques, des exemples récents ou des explications développées. Les systèmes d'IA privilégient le contenu mis à jour dans les 30 derniers jours, en particulier sur des sujets où les informations évoluent rapidement. Incluez les dates de publication et les mises à jour dans votre balisage schema.org.

La densité de réponse est directement corrélée à la fréquence de citation. Un contenu avec une densité de réponse supérieure à 70% reçoit en moyenne 4,2 citations par mois dans les sorties IA, contre 1,1 citation pour une densité inférieure à 40%. Un contenu à forte densité offre des informations actionnables sans remplissage, ce qui le rend plus intéressant à citer pour l'IA.

Utilisez des plateformes de suivi de citation comme AmICited.com, qui suit les citations sur ChatGPT, Claude, Gemini et d'autres grands LLM. Testez également manuellement en soumettant vos questions cibles à des systèmes d'IA et en notant les sources citées. Mesurez la fréquence de citation de base, appliquez des optimisations et suivez l'évolution sur 30 à 60 jours.

La structure de base des réponses méta reste cohérente entre les plateformes, mais vous pouvez optimiser selon les préférences spécifiques. ChatGPT privilégie les contenus complets et bien sourcés. Perplexity met l'accent sur la fraîcheur des informations et des citations claires. Google AI Overviews privilégie les données structurées et les signaux E-E-A-T. Testez des variantes et surveillez la performance des citations selon les plateformes.

AmICited fournit un suivi en temps réel des citations de votre contenu sur toutes les grandes plateformes IA, montrant exactement où vos réponses méta apparaissent, comment elles sont utilisées et votre part de citation face aux concurrents. La plateforme révèle le contexte de citation — contenu cité directement, paraphrasé ou utilisé comme preuve — pour permettre des décisions d'optimisation fondées sur les données.

Voyez exactement où votre contenu est cité par ChatGPT, Perplexity, Google AI Overviews et d'autres systèmes d'IA. Suivez les tendances de citation, surveillez les concurrents et optimisez votre stratégie de contenu avec AmICited.

Découvrez ce que sont les réponses méta LLM et comment optimiser votre contenu pour la visibilité dans les réponses générées par l’IA sur ChatGPT, Perplexity et...

Découvrez comment identifier et cibler les sites sources des LLM pour des backlinks stratégiques. Découvrez quelles plateformes d'IA citent le plus de sources e...

Découvrez ce qui rend un contenu digne de citation pour des systèmes d’IA comme ChatGPT, Perplexity et Google AI Overview. Découvrez les caractéristiques clés, ...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.