Développement de bibliothèque de prompts

Découvrez ce qu'est le développement de bibliothèque de prompts et comment les organisations créent des collections de requêtes pour tester et surveiller la vis...

Découvrez comment créer et utiliser des bibliothèques de prompts pour les tests manuels de visibilité IA. Guide DIY pour tester comment les systèmes IA font référence à votre marque sur ChatGPT, Perplexity et Google AI.

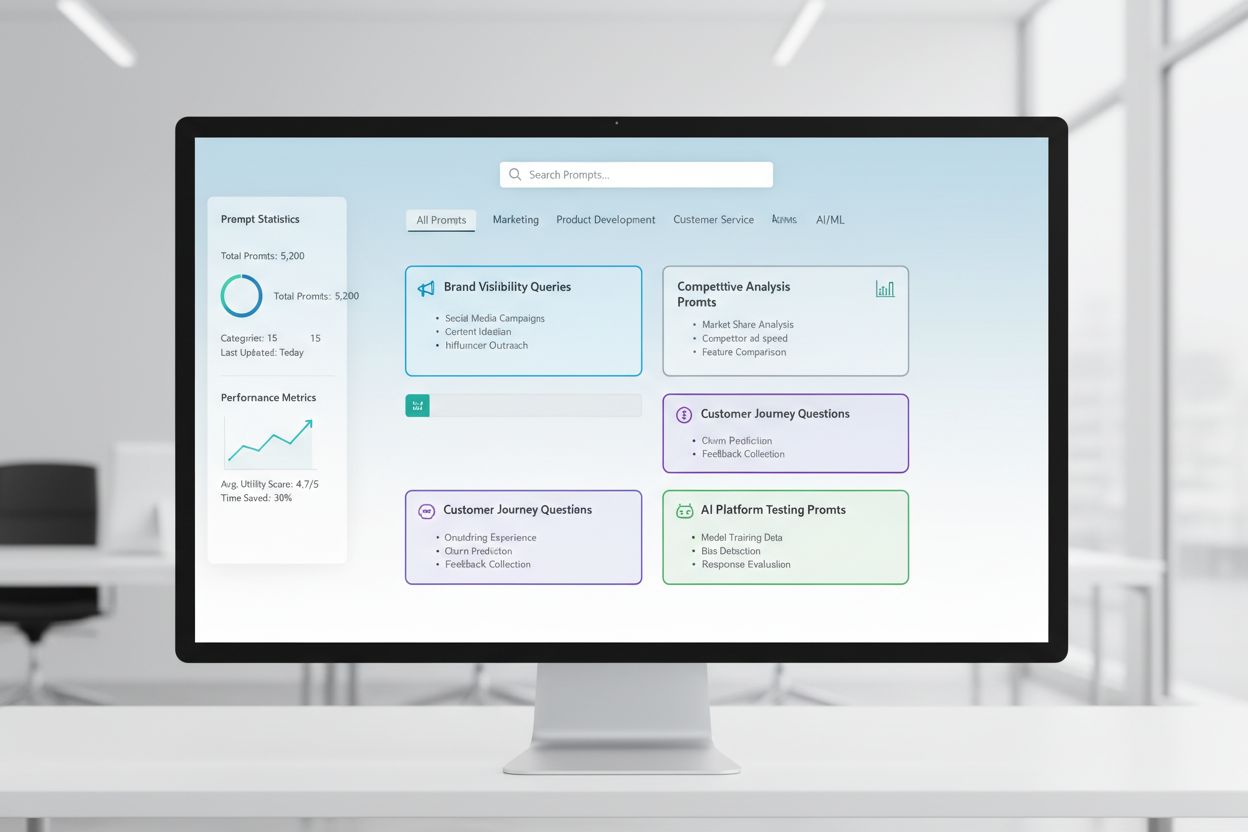

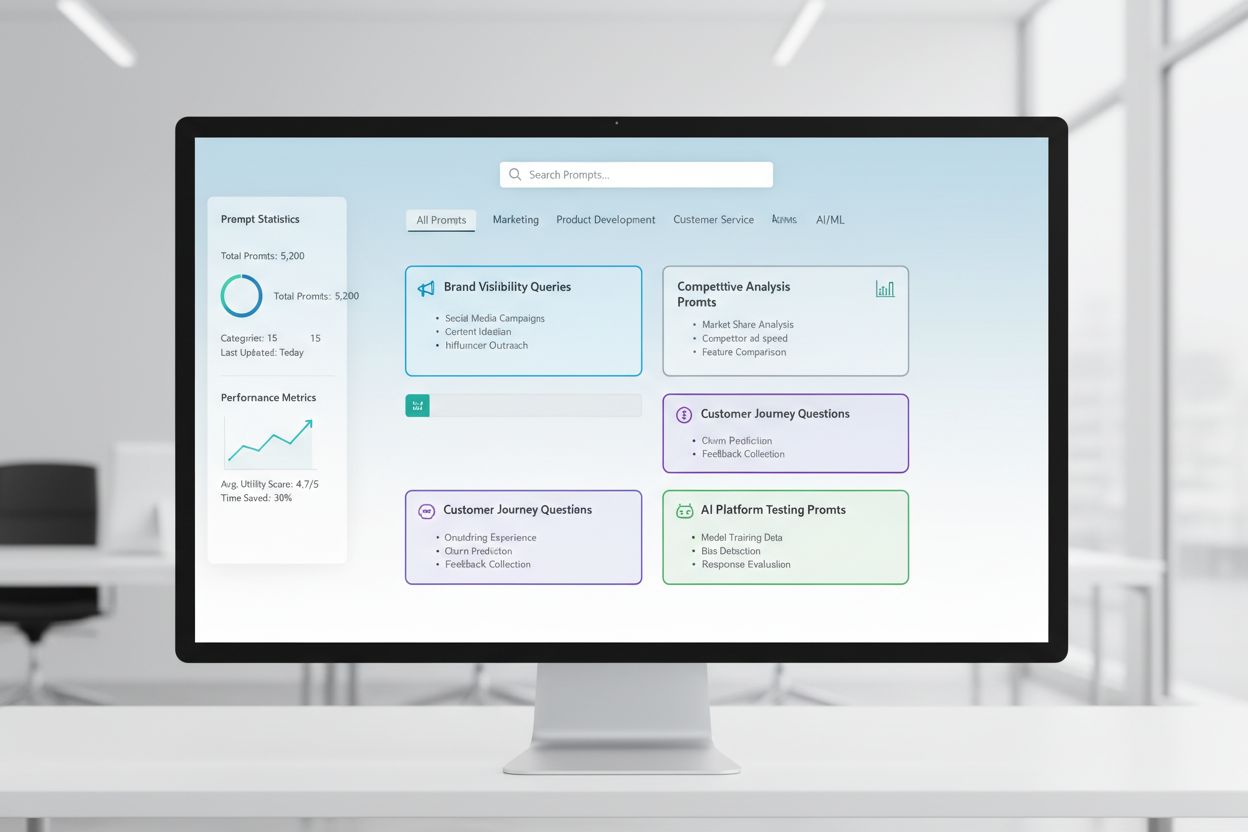

Une bibliothèque de prompts est une collection organisée et sélectionnée de prompts de test conçus pour évaluer systématiquement la façon dont les systèmes IA répondent à des requêtes et scénarios spécifiques. Dans le contexte du test manuel de l’IA, ces bibliothèques servent de boîte à outils de base—un référentiel de prompts soigneusement élaborés qui vous permettent de comprendre exactement comment différents modèles IA traitent les mentions de votre marque, les citations, la fiabilité du contenu et la compréhension contextuelle. Les tests de visibilité IA reposent fortement sur les bibliothèques de prompts car elles permettent des tests cohérents et reproductibles sur plusieurs plateformes et périodes, vous permettant de suivre la façon dont votre contenu apparaît (ou n’apparaît pas) dans les réponses générées par l’IA. Plutôt que de tester au hasard avec des requêtes ponctuelles, une bibliothèque de prompts bien structurée garantit que vous couvrez systématiquement tous les scénarios importants pour votre entreprise, des recherches directes de marque aux références contextuelles indirectes. Cette approche structurée transforme les tests manuels d’un processus aléatoire en une méthodologie stratégique et axée sur les données qui révèle des schémas dans le comportement de l’IA et vous aide à comprendre votre visibilité réelle dans l’écosystème IA.

Le test manuel de visibilité IA est le processus concret consistant à interroger directement les systèmes IA avec des prompts prédéfinis et à analyser attentivement leurs réponses pour comprendre comment votre contenu, votre marque et vos citations sont mis en avant ou omis. Contrairement aux systèmes de surveillance automatisés qui fonctionnent en continu en arrière-plan, le test manuel vous donne le contrôle direct de ce que vous testez, du moment où vous le faites et de la profondeur de votre analyse—ce qui le rend indispensable pour les tests exploratoires, la compréhension des cas limites et l’investigation de comportements inattendus de l’IA. La distinction majeure réside dans la nature du travail : le test manuel est délibéré et investigateur, vous permettant de poser des questions de suivi, de tester des variantes et de comprendre le « pourquoi » des réponses IA, tandis que la surveillance automatisée excelle dans le suivi régulier et à grande échelle. Le test manuel est particulièrement important pour la visibilité IA car il permet de détecter des nuances que les systèmes automatisés pourraient manquer—par exemple, si votre marque est mentionnée mais mal attribuée, si les citations sont exactes mais incomplètes, ou si le contexte est compris correctement. Voici comment ces approches se comparent :

| Aspect | Test manuel | Surveillance automatisée |

|---|---|---|

| Coût | Faible investissement initial ; très chronophage | Investissement initial plus élevé ; moins de travail continu |

| Vitesse | Plus lent par test ; retours immédiats | Plus lent à mettre en place ; suivi continu rapide |

| Flexibilité | Très flexible ; facile à ajuster et explorer | Rigide ; nécessite des paramètres prédéfinis |

| Précision | Haute pour l’analyse qualitative ; biais humain possible | Cohérent ; excellent pour les métriques quantitatives |

| Courbe d’apprentissage | Minime ; tout le monde peut commencer à tester | Plus raide ; nécessite une configuration technique |

Le test manuel excelle pour comprendre pourquoi quelque chose se produit, tandis que la surveillance automatisée excelle pour suivre ce qui se produit à grande échelle.

Une structure de bibliothèque de prompts robuste doit être organisée autour des axes clés de votre stratégie de visibilité IA, chaque composant ayant un objectif de test précis. Votre bibliothèque doit inclure des prompts testant différents aspects de la façon dont les systèmes IA découvrent et mettent en avant votre contenu, assurant ainsi une couverture complète de votre paysage de visibilité. Voici les éléments essentiels que toute bibliothèque de prompts devrait contenir :

Pour élaborer votre stratégie de test, vous avez besoin de prompts qui ciblent spécifiquement les dimensions de la visibilité IA les plus importantes pour votre activité—mentions de marque, exactitude des citations et compréhension contextuelle. Les prompts de test les plus efficaces imitent le comportement réel de l’utilisateur tout en isolant les variables à mesurer. Pour les prompts de test axés sur les mentions de marque, proposez des variantes testant les recherches directes, les références indirectes et les contextes comparatifs. Les tests de précision des citations nécessitent des prompts déclenchant naturellement des citations, puis des variantes pour vérifier si l’IA attribue correctement l’information à vos sources. Voici des exemples de prompts que vous pouvez adapter :

"Quelles sont les dernières évolutions dans [votre secteur] ?

Veuillez citer vos sources."

"Comparez [votre produit] à [produit concurrent].

Quelles sont les principales différences et avantages de chacun ?"

"Expliquez [votre domaine d’expertise].

Qui sont les experts ou entreprises leaders dans ce domaine ?"

Ces prompts sont conçus pour déclencher naturellement les types de réponses où votre visibilité compte le plus—lorsque les IA donnent des informations, font des comparaisons ou identifient des sources autorisées. Vous pouvez créer des variantes en ajustant le niveau de spécificité (large vs. ciblé), en ajoutant des contraintes (informations récentes uniquement, cas d’usage précis) ou en modifiant les exigences de citation (avec sources, avec liens, avec noms d’auteurs). L’essentiel est de tester non seulement si votre contenu apparaît, mais comment il apparaît et dans quel contexte, ce qui nécessite des prompts simulant des situations réalistes où votre visibilité devrait être démontrée.

Votre stratégie de visibilité IA doit prendre en compte le fait que différentes plateformes IA—ChatGPT, Perplexity, Google AI Overviews, Claude, etc.—reposent sur des ensembles de données, des mécanismes de recherche et des méthodes de génération de réponses fondamentalement différents, ce qui implique une visibilité très variable d’une plateforme à l’autre. Les tests croisés sont essentiels car un prompt qui met en avant votre contenu sur une IA peut donner des résultats totalement différents sur une autre, et comprendre ces schémas spécifiques à chaque plateforme est crucial pour développer une stratégie de visibilité globale. Lors des tests croisés, vous remarquerez que Perplexity, grâce à son intégration de recherche en temps réel, met souvent en avant des contenus plus récents et propose plus de citations explicites que ChatGPT, qui s’appuie sur des données d’entraînement comportant une date de coupure. Google AI Overviews, intégré directement aux résultats de recherche, obéit à des règles de visibilité différentes et peut privilégier d’autres sources que les IA conversationnelles. L’approche pragmatique consiste à maintenir un jeu de prompts de base cohérent, à utiliser sur toutes les plateformes selon un calendrier régulier, pour suivre non seulement si votre contenu apparaît, mais où il apparaît et comment les différences de plateforme affectent votre visibilité. Cette perspective révèle si vos difficultés de visibilité sont universelles (toutes plateformes) ou spécifiques (stratégies ciblées par IA), ce qui change fondamentalement l’approche d’optimisation.

Une documentation efficace des tests transforme les données brutes en informations exploitables, et le système d’organisation choisi détermine si vos efforts de test prennent de la valeur dans le temps ou restent des points de données isolés. L’approche la plus pratique consiste à utiliser un tableur ou un système documentaire structuré qui enregistre non seulement les résultats, mais aussi le contexte—le prompt exact utilisé, la date du test, la plateforme testée, la réponse complète de l’IA, et votre analyse quant à la présence de votre contenu et sa présentation. Votre système de suivi des résultats doit inclure des colonnes pour : la catégorie du prompt (marque, concurrent, secteur, etc.), la plateforme testée, la présence de votre contenu, la précision de la citation (si applicable), la position dans la réponse (première mention, élément d’appui, etc.), et toute note qualitative sur la qualité ou la pertinence de la réponse. Au-delà des données brutes, créez des modèles pour les scénarios de test courants afin que votre documentation reste cohérente dans le temps, facilitant l’identification de tendances et d’évolutions dans le comportement IA. Documentez aussi bien les succès que les échecs et anomalies—ce sont souvent eux qui révèlent les points clés sur le fonctionnement des IA et les axes d’amélioration de votre stratégie de visibilité. En maintenant cette discipline méthodologique, vous créez un historique montrant l’évolution de votre visibilité, l’impact des changements IA sur vos résultats, et l’efficacité réelle de vos optimisations.

Le test manuel de visibilité IA est vulnérable à plusieurs erreurs systématiques qui peuvent fausser vos résultats et vous conduire à des conclusions erronées sur votre visibilité réelle. Le piège le plus fréquent est l’incohérence des formulations—tester un même concept avec des formulations légèrement différentes à chaque fois, ce qui introduit des variables rendant impossible le suivi des évolutions dues à l’IA ou à vos propres variations. Pour l’éviter, créez un document maître de prompts où chaque prompt est figé et utilisé à l’identique à chaque session ; si vous souhaitez tester des variantes, créez des déclinaisons distinctes avec des conventions de nommage claires. Une autre erreur critique est la taille d’échantillon et la fréquence insuffisantes—tester une seule fois et tirer des conclusions, alors que les réponses IA peuvent varier selon le moment, la charge système, etc. Instaurez un rythme de test régulier (hebdo, bi-mensuel ou mensuel selon vos moyens) et testez chaque prompt plusieurs fois pour identifier des schémas plutôt que des anomalies. Le biais de confirmation est un piège subtil mais dangereux où le testeur interprète inconsciemment des résultats ambigus comme confirmant ses attentes ; luttez contre cela en faisant relire les résultats par plusieurs membres de l’équipe et en documentant des critères objectifs sur ce qui compte comme « apparition de votre contenu ». Enfin, évitez de tester isolément—notez toujours la date, l’heure et toute mise à jour connue de l’IA au moment du test, car comprendre le contexte est essentiel pour interpréter les résultats. Enfin, une documentation méthodologique insuffisante vous empêchera de reproduire vos tests ou d’expliquer vos résultats ; documentez toujours précisément comment vous avez testé, ce que vous avez mesuré et comment vous avez interprété les résultats pour garantir la reproductibilité et la robustesse de vos tests.

À mesure que votre organisation se développe et que votre stratégie de visibilité IA se complexifie, vous devrez passer de tests individuels et ponctuels à une approche de test en équipe structurée, répartissant la charge tout en maintenant cohérence et qualité. La clé d’une montée en charge réussie est la création de protocoles de test et de définitions de rôles claires—décidez qui est responsable de quelle plateforme, de quelles catégories de prompts, et de quelles analyses, pour que les tests deviennent un effort d’équipe coordonné plutôt qu’un travail individuel redondant. Mettez en place un calendrier de test partagé permettant à chacun de voir ce qui a été testé, quand et par qui, pour éviter les doublons et garantir une couverture complète. Créez une checklist ou un runbook de test que tout membre peut suivre pour garantir la cohérence dans l’exécution et la documentation des résultats, l’analyse des réponses et le signalement des anomalies ou enseignements. Les outils de collaboration comme les tableurs partagés, les outils de gestion de projet ou les plateformes dédiées aux tests facilitent la coordination et créent une source unique de vérité pour vos données de tests. Avec la croissance, faites tourner les responsabilités de test pour que plusieurs personnes maîtrisent la méthodologie et puissent contribuer, réduisant la dépendance à une seule personne. Des points d’équipe réguliers pour examiner les résultats, discuter des constats et ajuster la stratégie de test en fonction de l’apprentissage permettent de maintenir un effort de test coordonné et stratégique, et non une somme de tâches individuelles déconnectées.

Les stratégies de visibilité IA les plus abouties reconnaissent que les approches manuelle vs. automatisée sont complémentaires, chacune excelling dans des contextes différents et, combinées, offrant une couverture complète. Le test manuel est votre outil d’investigation : il sert à explorer, comprendre les nuances, tester des hypothèses et approfondir la compréhension du fonctionnement des IA et des variations de visibilité selon les plateformes et scénarios. Les outils de surveillance automatisée comme AmICited excellent dans le suivi régulier et à grande échelle, surveillant en continu votre visibilité sur plusieurs plateformes IA et vous alertant sur les évolutions, tendances et anomalies impossibles à détecter manuellement. L’intégration pragmatique consiste à utiliser le test manuel pour élaborer votre cadre de test, comprendre les enjeux et investiguer les anomalies, puis à confier le suivi continu des indicateurs clés à la surveillance automatisée, qui vous alerte en cas de changement. Par exemple, vous pouvez tester manuellement une nouvelle catégorie de prompts pour comprendre les réactions des IA, puis, une fois la pertinence validée, l’ajouter à la surveillance automatisée afin d’obtenir un suivi continu sans effort manuel supplémentaire. AmICited et autres outils de monitoring prennent en charge le travail répétitif et chronophage de tests à grande échelle, libérant votre équipe pour l’analyse, la stratégie et l’optimisation à forte valeur ajoutée. Le workflow idéal : utilisez les tests manuels pour construire votre bibliothèque de prompts et votre stratégie de test, validez votre approche et investiguez des questions spécifiques ; utilisez la surveillance automatisée pour suivre en continu vos indicateurs de visibilité clés ; et servez-vous des enseignements de la surveillance pour guider les prochains tests manuels. Cette approche intégrée garantit que vous ne testez pas manuellement en vase clos, mais que vous bâtissez une stratégie de visibilité complète combinant la profondeur de l’investigation manuelle à la régularité et à l’ampleur de la surveillance automatisée.

Une bibliothèque de prompts est une collection organisée et sélectionnée de prompts de test conçus pour évaluer systématiquement les systèmes IA selon plusieurs dimensions. Contrairement à un simple modèle de prompt, une bibliothèque contient des dizaines de prompts organisés par catégorie (mentions de marque, comparaisons de concurrents, citations, etc.), ce qui vous permet de réaliser des tests complets plutôt que des vérifications isolées. Les bibliothèques de prompts sont versionnées, documentées et conçues pour être réutilisées et mises à l'échelle au sein de votre équipe.

La fréquence dépend de vos ressources et du dynamisme de votre secteur. La plupart des organisations bénéficient de tests hebdomadaires ou bimensuels des prompts clés pour détecter les changements importants, avec des tests approfondis mensuels de toute la bibliothèque de prompts. Si vous êtes dans un secteur très évolutif ou avez publié récemment du contenu majeur, augmentez la fréquence à chaque semaine. Combinez les tests manuels avec des outils de surveillance automatisée comme AmICited pour un suivi continu entre les cycles de tests manuels.

Oui, vous devez utiliser les mêmes prompts principaux sur toutes les plateformes pour garantir la cohérence et la comparabilité. Cependant, vous pouvez avoir besoin de variantes spécifiques à chaque plateforme, car différents systèmes IA (ChatGPT, Perplexity, Google AI Overviews) ont des interfaces, des mécanismes de citation et des formats de réponse différents. Testez vos prompts de base de façon identique sur toutes les plateformes, puis créez des variantes adaptées pour tenir compte des particularités ou limitations de chaque système.

Suivez si votre contenu apparaît (oui/non), où il apparaît dans la réponse (première mention, preuve à l'appui, etc.), la précision des citations (si cité) et la qualité des réponses. Documentez également la date du test, la plateforme, le prompt exact utilisé et toute observation qualitative sur la présentation de votre contenu. Avec le temps, ces indicateurs révèlent des tendances dans votre visibilité et vous aident à comprendre quelles optimisations sont réellement efficaces.

Vos tests sont complets lorsque vous couvrez toutes les dimensions majeures de votre visibilité : recherches directes sur la marque, comparaisons de concurrents, sujets sectoriels, précision des citations et compréhension contextuelle. Une bonne règle est de disposer de 20 à 30 prompts principaux testés régulièrement, plus des prompts supplémentaires pour des investigations spécifiques. Si les tests manuels vous apportent constamment de nouveaux enseignements, il vous faut sans doute plus de prompts. Si les résultats deviennent prévisibles, votre couverture est probablement suffisante.

Pour les petites organisations ou les tests initiaux, vous pouvez commencer avec des ressources internes en suivant l'approche DIY présentée dans ce guide. Cependant, à mesure que vos tests prennent de l'ampleur, des ressources dédiées deviennent utiles. Envisagez de recruter ou d'attribuer à quelqu'un la gestion de votre bibliothèque de prompts et la réalisation de tests réguliers si vous avez plusieurs produits, êtes dans un secteur concurrentiel ou avez besoin de cycles de tests fréquents. Sinon, combinez les tests internes avec des outils de surveillance automatisée comme AmICited pour répartir la charge de travail.

Les tests manuels sont exploratoires et flexibles : vous contrôlez ce que vous testez et pouvez explorer les nuances et cas limites. Les outils de surveillance automatisée comme AmICited fonctionnent en continu, suivent votre visibilité sur plusieurs plateformes IA à grande échelle et vous alertent en cas de changement. L'idéal est de combiner les deux : utilisez les tests manuels pour élaborer votre stratégie de tests et explorer des questions spécifiques, et la surveillance automatisée pour un suivi continu des indicateurs clés.

Vous pouvez automatiser l'exécution des prompts via des API (OpenAI, Anthropic, etc.) pour envoyer vos prompts aux systèmes IA et recueillir les réponses de façon programmatique. L'analyse reste cependant souvent manuelle, car comprendre le contexte et les nuances nécessite un jugement humain. Vous pouvez aussi automatiser la documentation et le suivi des résultats avec des tableurs ou des bases de données. L'approche la plus pratique est d'utiliser des outils de surveillance automatisée comme AmICited pour les tâches répétitives, en réservant les tests manuels à l'analyse et à l'investigation approfondies.

Si le test manuel est précieux, une surveillance automatisée garantit une visibilité continue sur toutes les plateformes IA. AmICited suit en temps réel la façon dont les systèmes IA font référence à votre marque.

Découvrez ce qu'est le développement de bibliothèque de prompts et comment les organisations créent des collections de requêtes pour tester et surveiller la vis...

Apprenez à créer et organiser une bibliothèque de prompts efficace pour suivre la visibilité de votre marque sur ChatGPT, Perplexity et Google IA. Guide étape p...

Apprenez à mener une recherche de prompts efficace pour la visibilité IA. Découvrez la méthodologie pour comprendre les requêtes des utilisateurs dans les LLMs ...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.