Comment s'assurer que les crawlers d'IA voient tout votre contenu

Découvrez comment rendre votre contenu visible pour les crawlers d'IA comme ChatGPT, Perplexity et l'IA de Google. Découvrez les exigences techniques, les meill...

Découvrez comment les stratégies de rendu SSR et CSR affectent la visibilité auprès des crawlers IA, les citations de marque dans ChatGPT et Perplexity, et votre présence globale dans la recherche IA.

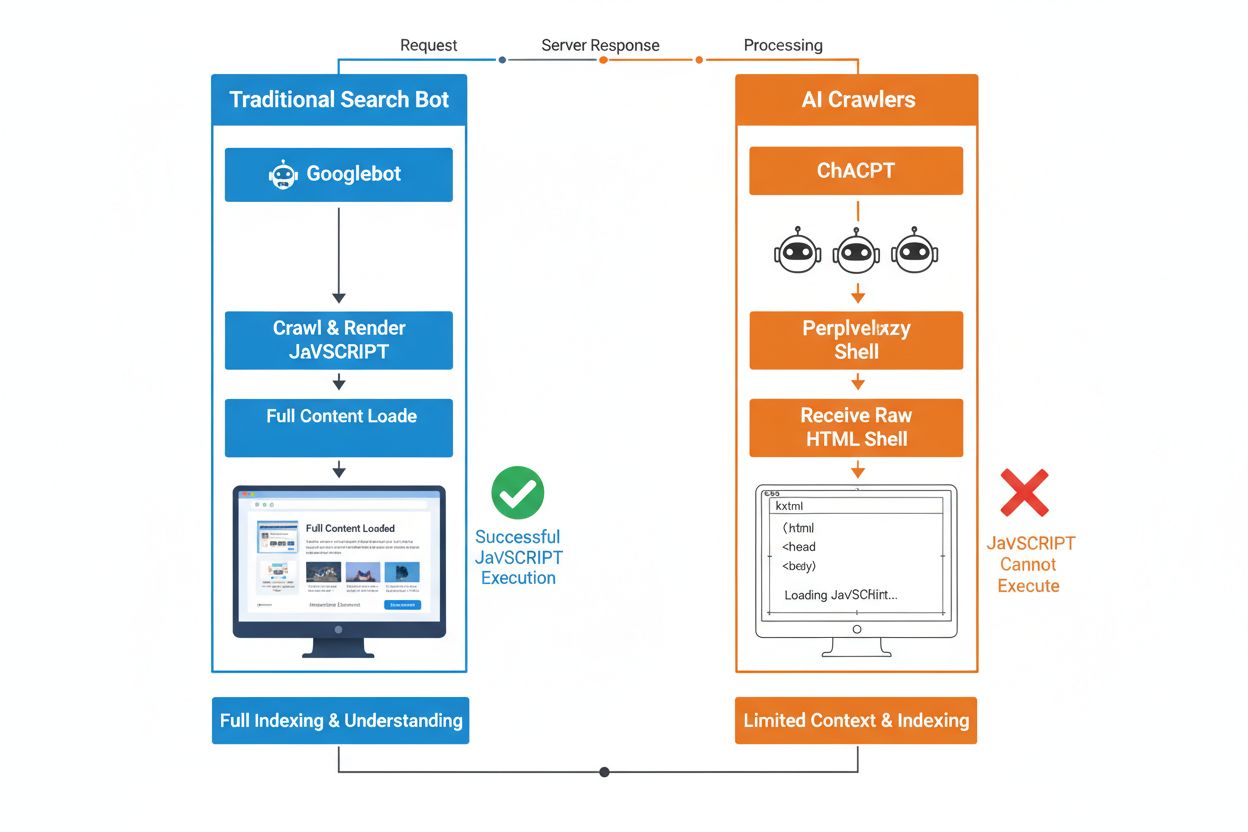

La différence fondamentale entre les robots de recherche traditionnels et les crawlers IA réside dans leur gestion de l’exécution JavaScript. Alors que Googlebot et d’autres moteurs de recherche traditionnels peuvent rendre le JavaScript (avec certaines contraintes de ressources), les crawlers IA comme GPTBot, ChatGPT-User et OAI-SearchBot n’exécutent pas du tout le JavaScript — ils ne voient que le HTML brut livré lors du chargement initial de la page. Cette distinction critique signifie que si le contenu de votre site dépend du JavaScript côté client pour s’afficher, les systèmes IA recevront une page incomplète ou blanche, manquant les détails produits, informations tarifaires, avis et tout autre contenu dynamique que voient les utilisateurs dans leur navigateur. Comprendre ce fossé est essentiel car les résultats de recherche propulsés par l’IA deviennent rapidement un canal majeur de découverte pour les internautes en quête d’information.

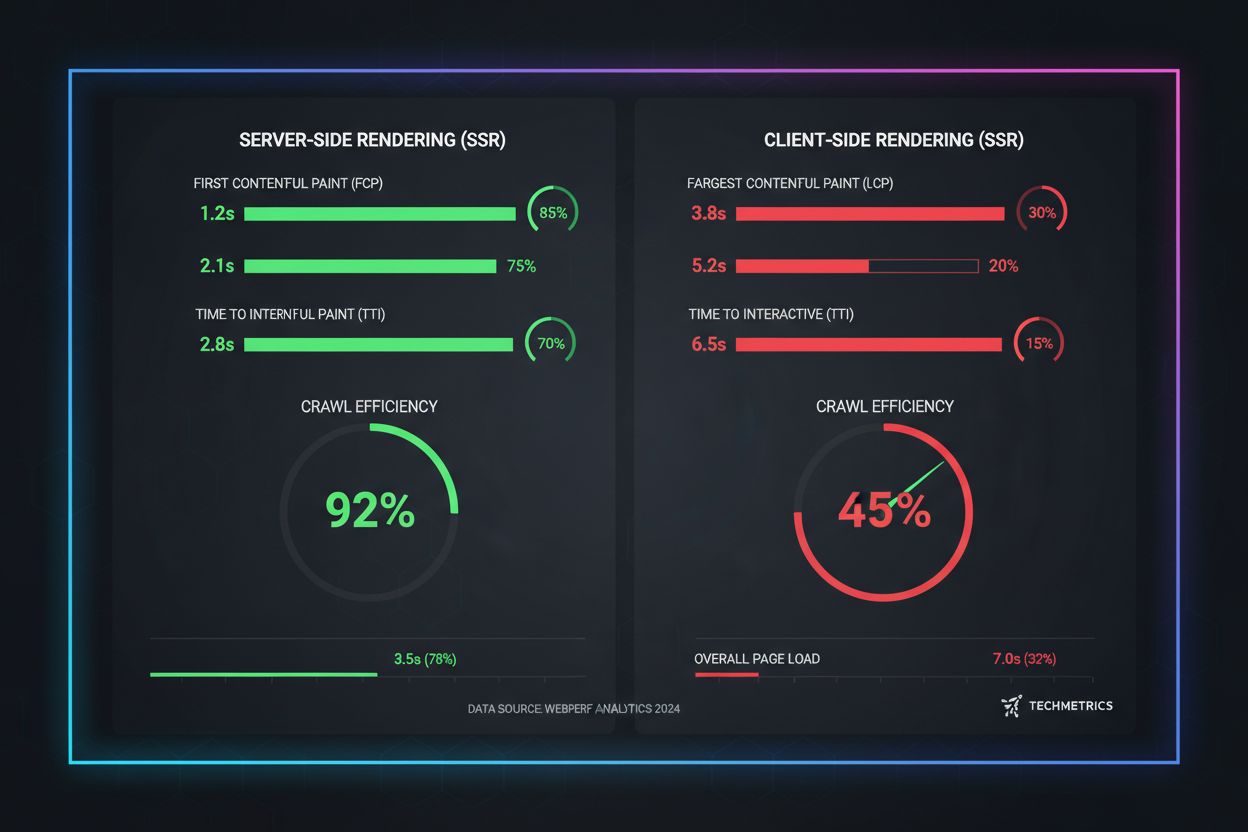

Le rendu côté serveur (SSR) améliore fondamentalement la visibilité auprès de l’IA en livrant un HTML entièrement rendu directement depuis le serveur à la requête initiale, éliminant ainsi le besoin pour les crawlers IA d’exécuter du JavaScript. Avec le SSR, tout le contenu critique — titres, texte principal, informations produit, métadonnées et données structurées — est présent dans le HTML reçu par les bots, le rendant immédiatement accessible pour ingestion dans les corpus d’entraînement IA et les index de recherche. Cette approche garantit une livraison de contenu cohérente pour tous les crawlers, une indexation plus rapide et une visibilité complète des métadonnées sur lesquelles les systèmes IA s’appuient pour comprendre et citer précisément votre contenu. Le tableau suivant illustre l’impact des différentes stratégies de rendu sur la visibilité des crawlers IA :

| Type de rendu | Ce que voient les crawlers IA | Vitesse d’indexation | Complétude du contenu | Visibilité des métadonnées |

|---|---|---|---|---|

| Rendu côté serveur (SSR) | HTML entièrement rendu avec tout le contenu | Rapide (immédiat) | Complet | Excellente |

| Rendu côté client (CSR) | Shell HTML minimal, contenu dynamique manquant | Lent (si rendu) | Incomplet | Faible |

| Génération statique (SSG) | HTML préconstruit, mis en cache | Très rapide | Complet | Excellente |

| Hybride/Incremental | Mix de routes statiques et dynamiques | Modéré à rapide | Bon (si pages critiques pré-rendues) | Bon |

Le rendu côté client (CSR) pose d’importants défis pour la visibilité auprès de l’IA car il oblige les crawlers à attendre l’exécution du JavaScript — ce que les bots IA ne feront tout simplement pas à cause des contraintes de ressources et des délais serrés. Lorsqu’un site en CSR se charge, la réponse HTML initiale contient seulement une coquille minimale avec des spinners de chargement et des éléments de placeholder, tandis que le contenu réel arrive de façon asynchrone via JavaScript. Les crawlers IA imposent des délais stricts de 1 à 5 secondes et n’exécutent pas les scripts, capturant ainsi une page vide ou quasi vide, sans descriptions produits, prix, avis, ni autres informations critiques. Cela entraîne un effet boule de neige : des instantanés incomplets mènent à un mauvais chunking et à une qualité d’indexation moindre, ce qui réduit les chances que vos pages soient incluses dans les réponses générées par l’IA. Pour les sites e-commerce, les plateformes SaaS et les applications riches en contenu utilisant le CSR, cela se traduit directement par une perte de visibilité dans les AI Overviews, les réponses ChatGPT et Perplexity — les canaux moteurs de la découverte à l’ère de l’IA.

La raison technique pour laquelle les bots IA ne peuvent exécuter JavaScript découle de contraintes fondamentales de scalabilité et de ressources inhérentes à leur architecture. Les crawlers IA privilégient la vitesse et l’efficacité à l’exhaustivité, fonctionnant avec des délais stricts car ils doivent traiter des milliards de pages pour entraîner et mettre à jour les modèles de langage. Exécuter du JavaScript nécessite de lancer des navigateurs headless, d’allouer de la mémoire et d’attendre la complétion des opérations asynchrones — des luxes incompatibles avec le volume de crawling exigé pour les LLM. Les systèmes IA se concentrent donc sur l’extraction de HTML propre, sémantiquement structuré, immédiatement disponible, et considèrent le contenu statique comme la version canonique de votre site. Ce choix architectural reflète une vérité fondamentale : les systèmes IA sont optimisés pour la livraison de HTML statique, et non pour le rendu de frameworks JavaScript complexes comme React, Vue ou Angular.

L’impact sur les réponses générées par l’IA et la visibilité de votre marque est profond et touche directement vos résultats business. Lorsque les crawlers IA ne peuvent accéder à votre contenu à cause du rendu JavaScript, votre marque devient invisible dans les AI Overviews, absente des citations, et introuvable dans les résultats de recherche propulsés par des LLM — même si vous êtes bien positionné sur Google. Pour les sites e-commerce, cela signifie que les détails produits, les prix et la disponibilité n’atteignent jamais les systèmes IA, entraînant des recommandations incomplètes ou erronées et des opportunités de vente perdues. Les entreprises SaaS perdent en visibilité sur les pages comparatives et les tarifs, qui pourraient générer des leads qualifiés via des outils de recherche IA. Les sites d’actualité et de contenu voient leurs articles exclus des résumés IA, réduisant le trafic de référence depuis des plateformes comme ChatGPT et Perplexity. L’écart entre ce que voient les humains et ce que voient les systèmes IA crée un problème de visibilité à deux vitesses : votre site peut paraître sain selon les métriques SEO traditionnelles tout en restant invisible pour le canal de découverte à la croissance la plus rapide.

Le pré-rendu et les solutions hybrides offrent des moyens pratiques de combiner les avantages des deux approches de rendu sans devoir revoir toute l’architecture. Plutôt que de choisir entre l’interactivité du CSR et la crawlabilité du SSR, les équipes modernes déploient des combinaisons stratégiques adaptées à chaque cas :

Ces approches permettent de conserver des expériences utilisateur riches et interactives tout en garantissant que les crawlers IA reçoivent un HTML complet et pré-rendu. Des frameworks comme Next.js, Nuxt et SvelteKit rendent le rendu hybride accessible sans développement sur-mesure lourd. L’essentiel est d’identifier les pages qui génèrent de l’acquisition, du chiffre d’affaires ou du support — ces pages critiques doivent toujours être pré-rendues ou rendues côté serveur pour garantir la visibilité IA.

La stratégie de rendu influence directement la façon dont les systèmes IA référencent et citent votre marque, d’où l’importance de surveiller votre visibilité sur les plateformes IA. Des outils comme AmICited.com suivent comment les systèmes IA citent votre marque sur ChatGPT, Perplexity, Google AI Overviews et d’autres plateformes propulsées par des LLM, révélant si votre contenu atteint réellement ces systèmes. Si votre site utilise le CSR sans pré-rendu, les données AmICited montrent souvent un écart flagrant : vous pouvez être bien positionné en recherche traditionnelle mais obtenir zéro citation dans les réponses générées par l’IA. Ce suivi révèle le coût réel des choix de rendu JavaScript — non seulement en efficacité de crawl, mais aussi en visibilité de marque et opportunités de citation perdues. En mettant en place le SSR ou le pré-rendu puis en suivant les résultats avec AmICited, vous pouvez quantifier l’impact direct des décisions de rendu sur la visibilité IA, facilitant la justification des investissements techniques auprès des décideurs business.

Auditer et optimiser la stratégie de rendu pour la visibilité IA demande une approche systématique étape par étape. Commencez par identifier les pages à plus forte valeur : pages produits, tarifs, documentation clé, articles de blog à fort trafic sont prioritaires. Utilisez des outils comme Screaming Frog (mode « Texte uniquement ») ou Chrome DevTools pour comparer ce que voient les bots et les utilisateurs — si du contenu critique est absent du code source, il dépend du JavaScript et est invisible pour les crawlers IA. Ensuite, choisissez la stratégie de rendu selon les besoins de fraîcheur du contenu : les pages statiques peuvent utiliser le SSG, les contenus fréquemment mis à jour bénéficient du SSR ou de l’ISR, et les fonctionnalités interactives peuvent être ajoutées en JavaScript sur du HTML rendu côté serveur. Puis, testez avec de vrais bots IA en soumettant vos pages à ChatGPT, Perplexity et Claude pour vérifier qu’ils accèdent à votre contenu. Enfin, surveillez les logs de crawl pour les user-agents IA (GPTBot, ChatGPT-User, OAI-SearchBot) afin de confirmer que ces bots crawlent bien vos pages pré-rendues ou rendues côté serveur. Cette approche itérative transforme le rendu d’un détail technique en levier mesurable de visibilité.

Les métriques de performance en conditions réelles révèlent les différences marquées entre les approches de rendu pour la crawlabilité IA. Les pages SSR et pré-rendues atteignent un First Contentful Paint (FCP) en 0,5 à 1,5 seconde, tandis que les sites CSR requièrent souvent 2 à 4 secondes ou plus pour télécharger et exécuter le JavaScript. Pour les crawlers IA opérant avec des délais de 1 à 5 secondes, cette différence fait toute la distinction entre visibilité totale et invisibilité complète. L’efficacité de crawl s’améliore considérablement avec le SSR : un site e-commerce pré-rendu peut être entièrement crawlé et indexé en quelques heures, alors qu’un équivalent en CSR peut prendre des semaines à cause de la surcharge de rendu JavaScript. Les gains d’indexation sont tout aussi significatifs — les sites SSR voient leur nouveau contenu indexé en 24 à 48 heures, alors que les sites CSR subissent souvent des retards de 7 à 14 jours. Pour le contenu sensible au temps comme les articles d’actualité, les lancements de produit ou les offres limitées, ce délai se traduit directement par une perte de visibilité pendant la période clé où les utilisateurs recherchent activement.

L’avenir du SEO est indissociable de la visibilité dans la recherche IA, faisant de la stratégie de rendu un investissement critique à long terme plutôt qu’une simple question technique. La recherche propulsée par l’IA connaît une croissance exponentielle — 13,14 % de tous les résultats Google déclenchent désormais des AI Overviews, et des plateformes comme ChatGPT dépassent quatre milliards de visites mensuelles, avec Perplexity et Claude en forte progression. À mesure que les systèmes IA deviennent le canal principal de découverte pour davantage d’utilisateurs, les choix de rendu que vous faites aujourd’hui détermineront votre visibilité demain. La surveillance continue est essentielle car le comportement des crawlers IA, les délais et le support JavaScript évoluent au fil du temps. Les équipes qui considèrent le rendu comme une migration ponctuelle se retrouvent souvent invisibles à nouveau en quelques mois, les plateformes IA adaptant régulièrement leur stratégie de crawl. Intégrez plutôt l’optimisation du rendu à votre cycle de planification trimestriel, incluez des vérifications de visibilité IA dans vos tests de régression et utilisez des outils comme AmICited pour surveiller la visibilité de votre marque à mesure que le paysage IA évolue. Les marques qui gagnent en recherche IA sont celles qui traitent la stratégie de rendu comme un avantage compétitif clé, et non comme une dette technique à traiter plus tard.

Les crawlers IA comme GPTBot et ChatGPT-User fonctionnent sous de fortes contraintes de ressources et des délais très stricts (1 à 5 secondes) car ils doivent traiter des milliards de pages pour entraîner les modèles de langage. L’exécution de JavaScript nécessite de lancer des navigateurs headless et d’attendre les opérations asynchrones — des luxes qui ne sont pas scalables à l’échelle requise pour l’entraînement des LLM. Les systèmes IA se concentrent donc sur l’extraction de HTML propre et statique, immédiatement disponible.

Le rendu côté serveur fournit un HTML entièrement rendu lors de la requête initiale, rendant tout le contenu immédiatement accessible aux crawlers IA sans exécution de JavaScript. Cela garantit que les détails de vos produits, prix, avis et métadonnées atteignent de façon fiable les systèmes IA, augmentant les chances que votre marque soit citée dans les réponses générées par l’IA et apparaisse dans les AI Overviews.

Le rendu côté serveur (SSR) génère les pages à la demande lors de chaque requête, tandis que le pré-rendu génère des fichiers HTML statiques au moment de la construction. Le pré-rendu est idéal pour les contenus peu fréquemment modifiés, alors que le SSR convient mieux au contenu dynamique qui évolue régulièrement. Les deux approches garantissent que les crawlers IA reçoivent un HTML complet sans exécution de JavaScript.

Oui, mais avec des limitations importantes. Vous pouvez utiliser des outils de pré-rendu pour générer des instantanés HTML statiques de vos pages CSR, ou mettre en place un rendu hybride où les pages critiques sont rendues côté serveur tandis que les pages moins importantes restent côté client. Cependant, sans ces optimisations, les sites CSR sont en grande partie invisibles pour les crawlers IA.

Utilisez des outils comme Screaming Frog (mode texte uniquement), Chrome DevTools ou Google Search Console pour comparer ce que voient les bots et les utilisateurs. Si du contenu critique est absent du code source, il dépend du JavaScript et est invisible pour les crawlers IA. Vous pouvez aussi tester directement avec ChatGPT, Perplexity et Claude pour vérifier qu’ils accèdent à votre contenu.

Les pages SSR et pré-rendues atteignent généralement le First Contentful Paint (FCP) en 0,5 à 1,5 seconde, tandis que les sites CSR requièrent souvent 2 à 4+ secondes. Puisque les crawlers IA opèrent avec des délais de 1 à 5 secondes, un rendu plus rapide se traduit directement par une meilleure crawlabilité IA. Des Core Web Vitals améliorés profitent aussi à l’expérience utilisateur et au référencement traditionnel.

AmICited surveille comment les systèmes IA citent votre marque à travers ChatGPT, Perplexity et Google AI Overviews. En suivant votre visibilité IA avant et après la mise en place du SSR ou du pré-rendu, vous pouvez quantifier l’impact direct des décisions de rendu sur les citations de marque et la présence dans la recherche IA.

Cela dépend des besoins en fraîcheur de votre contenu et de vos priorités business. Le contenu statique profite du SSG, le contenu fréquemment mis à jour du SSR, et les fonctionnalités interactives peuvent être ajoutées en JavaScript sur du HTML rendu côté serveur. Identifiez d’abord les pages à forte valeur (produits, tarifs, documentation) et priorisez-les pour le SSR ou le pré-rendu.

Surveillez comment ChatGPT, Perplexity et Google AI Overviews font référence à votre marque. Comprenez l’impact réel de votre stratégie de rendu sur les citations IA.

Découvrez comment rendre votre contenu visible pour les crawlers d'IA comme ChatGPT, Perplexity et l'IA de Google. Découvrez les exigences techniques, les meill...

Guide complet de référence des crawlers IA et bots. Identifiez GPTBot, ClaudeBot, Google-Extended et plus de 20 autres crawlers IA avec leurs user agents, fréqu...

Résolvez les problèmes de crawl IA grâce à l’analyse des journaux serveur, l’identification des user agents et la résolution technique. Surveillez les crawlers ...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.