Taux de crawl

Le taux de crawl est la vitesse à laquelle les moteurs de recherche explorent votre site web. Découvrez comment il affecte l’indexation, la performance SEO et c...

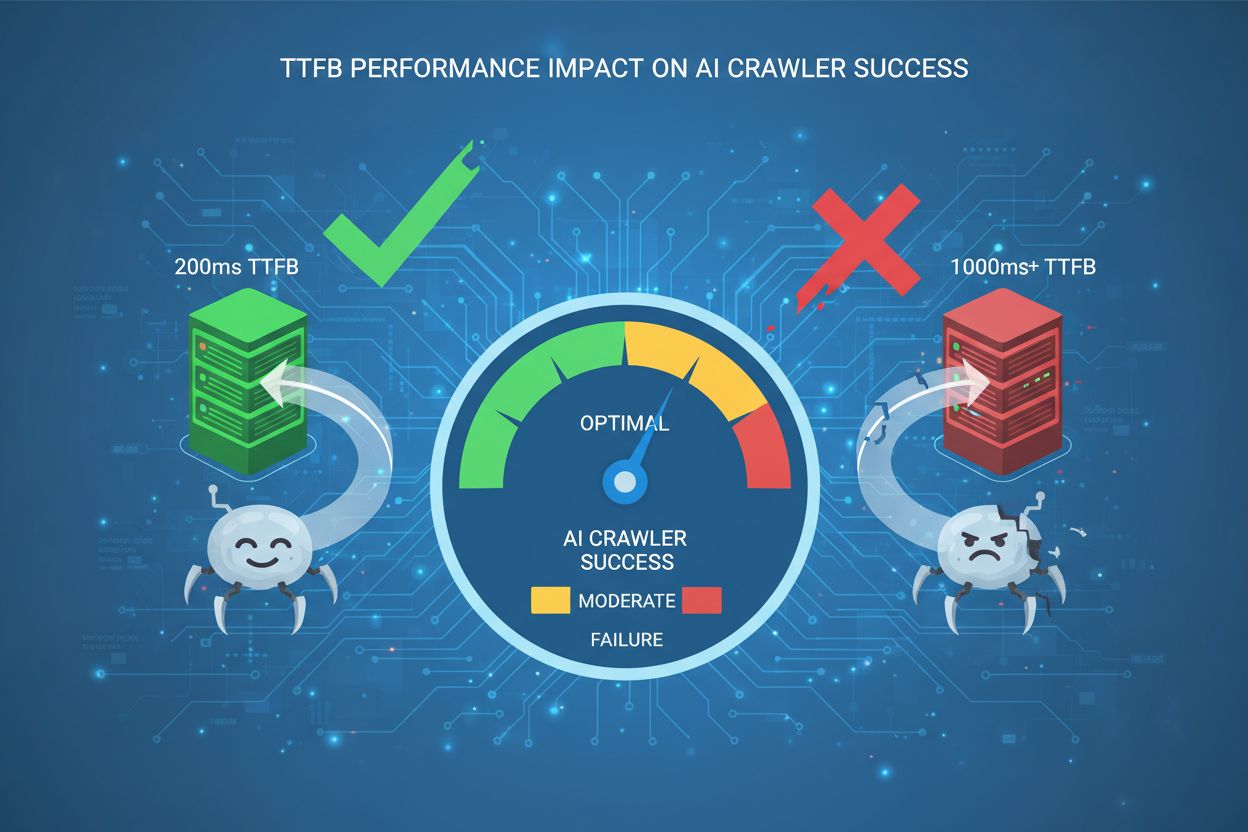

Découvrez comment le Time to First Byte impacte la réussite des crawlers IA. Comprenez pourquoi 200 ms est le seuil d’excellence et comment optimiser les temps de réponse serveur pour une meilleure visibilité dans les réponses générées par l’IA.

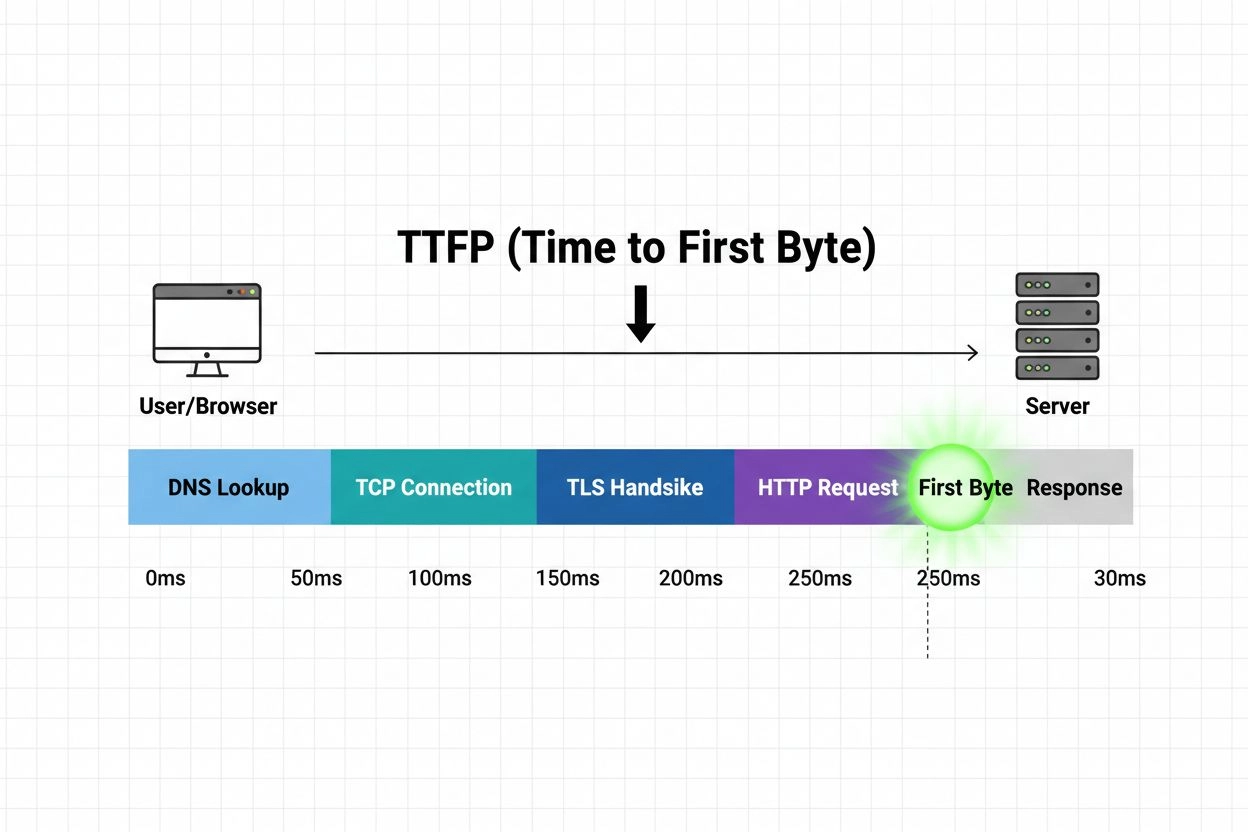

Le Time to First Byte (TTFB) est la durée entre l’envoi d’une requête HTTP par le navigateur d’un utilisateur et la réception du premier octet de données depuis le serveur. Cette métrique mesure la réactivité du serveur et la latence réseau combinées, ce qui en fait un indicateur fondamental de la performance globale du site web. Pour les crawlers IA qui indexent votre contenu pour les GPT, Perplexity, Google AI Overviews et autres grands modèles de langage, le TTFB est critique car il détermine directement la rapidité avec laquelle ces robots peuvent accéder à vos pages et les traiter. Contrairement aux moteurs de recherche traditionnels qui mettent en cache de façon agressive et crawlent moins fréquemment, les crawlers IA fonctionnent avec des schémas et des priorités différents — ils ont besoin d’un accès rapide au contenu frais pour entraîner et mettre à jour leurs modèles. Un TTFB lent force les crawlers IA à patienter plus longtemps avant même de commencer à analyser votre contenu, ce qui peut entraîner une indexation incomplète, une visibilité réduite dans les réponses générées par l’IA et un taux de citation plus faible. En somme, le TTFB est la métrique de passage qui détermine si les systèmes IA peuvent découvrir et intégrer efficacement votre contenu dans leurs réponses.

Les crawlers IA fonctionnent fondamentalement différemment des bots de moteurs de recherche traditionnels comme Googlebot, affichant des schémas de crawl plus agressifs et des stratégies de priorisation différentes. Tandis que les bots classiques respectent les budgets de crawl et se concentrent sur l’indexation pour la récupération par mots-clés, les crawlers IA privilégient la fraîcheur du contenu et la compréhension sémantique, effectuant souvent plusieurs requêtes sur les mêmes pages dans de courts intervalles. Les bots traditionnels crawlent généralement un site toutes les quelques semaines ou mois, alors que les crawlers IA de systèmes comme ChatGPT, Claude et Perplexity peuvent revisiter un contenu à forte valeur plusieurs fois par semaine voire quotidiennement. Ce comportement agressif signifie que votre infrastructure serveur doit pouvoir gérer des volumes de requêtes simultanées beaucoup plus élevés provenant uniquement de sources IA.

| Caractéristique | Bots de recherche traditionnels | Crawlers IA |

|---|---|---|

| Fréquence d’exploration | Hebdomadaire à mensuelle | Quotidienne à plusieurs fois par jour |

| Concurrence des requêtes | Faible à modérée | Élevée et variable |

| Priorité du contenu | Pertinence des mots-clés | Compréhension sémantique & fraîcheur |

| Comportement de mise en cache | Mise en cache agressive | Mise en cache minimale, ré-exploration fréquente |

| Sensibilité au temps de réponse | Tolérance modérée | Grande sensibilité aux délais |

| Schémas User-Agent | Cohérents, identifiables | Diversifiés, parfois masqués |

Principales différences des bots :

Les implications sont claires : votre infrastructure doit être optimisée non seulement pour les visiteurs humains et les moteurs de recherche traditionnels, mais spécifiquement pour les schémas exigeants des crawlers IA. Un TTFB acceptable pour le SEO classique peut être insuffisant pour la visibilité dans l’IA.

Le seuil de 200 ms pour le TTFB est devenu le standard d’excellence pour la réussite des crawlers IA, représentant le point où les temps de réponse serveurs restent suffisamment rapides pour une ingestion efficace du contenu sans déclencher de mécanismes de timeout. Ce seuil n’est pas arbitraire — il est issu des exigences opérationnelles des principaux systèmes IA, qui mettent en place des fenêtres de timeout de 5 à 10 secondes pour le chargement complet d’une page. Lorsque le TTFB dépasse 200 ms, le temps restant pour télécharger, analyser et traiter le contenu de la page diminue considérablement, augmentant le risque que les crawlers IA abandonnent la requête ou reçoivent des données incomplètes. La recherche montre que les sites maintenant un TTFB sous 200 ms connaissent des taux de citation bien plus élevés dans les réponses générées par l’IA, avec certaines études montrant une amélioration de 40 à 60 % de la visibilité IA comparé à des sites avec un TTFB de 500 à 1000 ms. Le repère des 200 ms est aussi directement corrélé à la sélection des modèles LLM — les systèmes IA privilégient et citent davantage les contenus issus de domaines à réponse rapide lorsque plusieurs sources proposent des informations similaires. Au-delà de ce seuil, chaque tranche supplémentaire de 100 ms aggrave le problème, réduisant la probabilité que votre contenu soit entièrement traité et intégré dans les réponses IA.

Le TTFB est la métrique de base sur laquelle reposent tous les autres indicateurs de performance, influençant directement le Largest Contentful Paint (LCP) et le First Contentful Paint (FCP) — deux Core Web Vitals critiques qui affectent à la fois le classement dans la recherche traditionnelle et le comportement des crawlers IA. Quand le TTFB est lent, le navigateur doit attendre plus longtemps avant de recevoir le premier octet de HTML, ce qui retarde toute la chaîne de rendu et pousse les métriques LCP et FCP dans des plages médiocres. LCP mesure quand l’élément visible le plus volumineux de la page devient interactif, tandis que FCP indique quand le navigateur affiche le premier contenu DOM — les deux démarrent leur chronomètre seulement après la fin du TTFB. Un site avec un TTFB de 800 ms aura du mal à atteindre un LCP inférieur à 2,5 secondes (le “bon” seuil de Google), même avec un rendu et une livraison des ressources optimisés. La relation est multiplicative plutôt qu’additive : un mauvais TTFB n’ajoute pas simplement du délai, il se répercute sur toute la chaîne de performance, affectant le temps de chargement perçu, l’engagement utilisateur et, surtout, l’efficacité des crawlers IA. Pour les systèmes IA, cela signifie qu’un TTFB lent réduit directement la probabilité que votre contenu soit indexé et cité dans les réponses générées par l’IA.

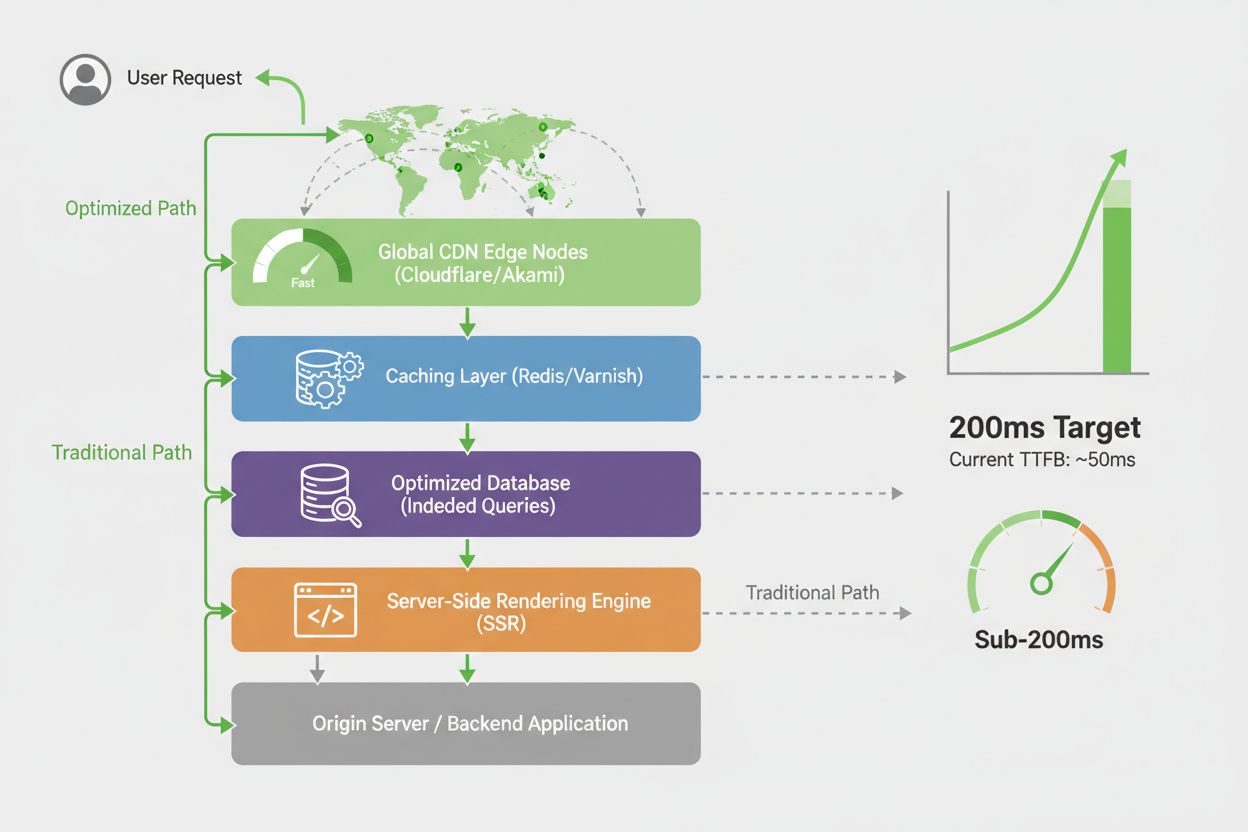

La localisation géographique et l’infrastructure réseau créent d’importantes variations du TTFB à travers les régions, impactant directement l’efficacité d’accès des crawlers IA à votre contenu à travers le monde. Un crawler IA opérant depuis un datacenter à Singapour peut expérimenter une latence de 300 à 400 ms vers un serveur hébergé en Virginie, alors que le même crawler accédant à un site via CDN peut atteindre une latence de 50 à 80 ms grâce à un serveur de périphérie régional. Les Content Delivery Networks (CDN) sont essentielles pour maintenir un TTFB constant sur toutes les régions, distribuant votre contenu sur des serveurs proches géographiquement des origines des crawlers et réduisant les sauts réseau nécessaires à la transmission des données. Sans optimisation CDN, les sites hébergés dans une seule région sont désavantagés : les crawlers IA de régions éloignées auront un TTFB dégradé, risquant de rater votre contenu si des timeouts se produisent. Les exemples concrets le montrent bien — une organisation d’actualités servant principalement un public américain mais hébergée sur un unique serveur côte Est peut offrir 80 ms de TTFB aux crawlers locaux mais plus de 400 ms aux crawlers venant d’Asie-Pacifique. Cette disparité géographique implique que les systèmes IA de différentes régions ont un accès inégal à votre contenu, entraînant des taux de citation variables et une visibilité mondiale réduite. La mise en œuvre d’une stratégie CDN mondiale garantit que les crawlers IA du monde entier bénéficient d’un TTFB constant, inférieur à 200 ms, quelle que soit leur localisation.

Une mesure précise du TTFB nécessite les bons outils et une méthodologie de test cohérente, car différentes approches peuvent générer des résultats variables selon les conditions réseau, l’état du serveur et la localisation du test. Plusieurs outils de référence fournissent des données TTFB fiables :

Google PageSpeed Insights — Fournit des données TTFB réelles issues du Chrome User Experience Report, affichant les métriques des utilisateurs et des crawlers. Gratuit, intégré à Google Search Console, reflète la perception des systèmes Google sur la performance de votre site.

WebPageTest — Offre une mesure fine du TTFB depuis plusieurs localisations géographiques et types de connexion, permettant de tester depuis les régions d’origine des crawlers IA. Fournit des diagrammes waterfall détaillant la chronologie exacte.

GTmetrix — Combine les données Lighthouse et WebPageTest, proposant le TTFB aux côtés d’autres indicateurs de performance. Utile pour suivre les tendances TTFB dans le temps, avec des recommandations d’optimisation.

Cloudflare Analytics — Si vous utilisez le CDN Cloudflare, fournit des données TTFB en temps réel issues du trafic réel, montrant la performance de votre site pour les crawlers et utilisateurs selon les régions.

New Relic ou Datadog — Solutions de monitoring d’entreprise qui suivent le TTFB pour les tests synthétiques et le monitoring réel (RUM), offrant des insights détaillés sur la performance serveur et les points de blocage.

curl et outils en ligne de commande — Pour les équipes techniques, les outils comme curl -w permettent de mesurer directement le TTFB, utile pour le monitoring automatisé et l’intégration dans les pipelines CI/CD.

Lors de la mesure du TTFB, testez depuis plusieurs régions afin de comprendre les variations, mesurez lors des pics de trafic pour identifier les goulets d’étranglement, et établissez une base de référence avant les optimisations. Une méthodologie cohérente assure un suivi précis des améliorations et la détection rapide des dépassements de seuils acceptables.

Atteindre et maintenir un TTFB inférieur à 200 ms nécessite une approche d’optimisation multi-niveaux, couvrant l’infrastructure serveur, les stratégies de cache et les mécanismes de diffusion de contenu. Voici les stratégies les plus efficaces :

Mettre en place un cache côté serveur — Mettez en cache les résultats des requêtes base de données, le HTML généré et les réponses API au niveau applicatif. Redis ou Memcached peuvent réduire les accès base de données de 50-200 ms à 1-5 ms, améliorant radicalement le TTFB.

Déployer un CDN mondial — Distribuez le contenu statique et dynamique sur des serveurs de périphérie mondiaux, réduisant la latence réseau depuis les serveurs d’origine. Des CDN comme Cloudflare, Akamai ou AWS CloudFront peuvent réduire le TTFB de 60 à 80 % pour les crawlers éloignés.

Optimiser les requêtes base de données — Analysez les requêtes lentes, ajoutez les index appropriés et mettez en cache les résultats. L’optimisation base de données est souvent la source principale d’amélioration TTFB, l’accès base de données représentant fréquemment 30 à 60 % du temps de réponse serveur.

Utiliser le rendu côté serveur (SSR) — Prérendez le contenu côté serveur plutôt que de s’appuyer sur l’exécution JavaScript côté client. Le SSR permet aux crawlers IA de recevoir immédiatement le HTML complet, sans délais liés à l’analyse JavaScript.

Mettre en œuvre HTTP/2 ou HTTP/3 — Les protocoles HTTP modernes réduisent la surcharge de connexion et permettent le multiplexage, améliorant le TTFB de 10 à 30 % par rapport à HTTP/1.1.

Optimiser le matériel serveur et la configuration — Assurez des ressources CPU, mémoire et I/O suffisantes. Un serveur mal configuré ou sous-dimensionné dépassera systématiquement les seuils TTFB, même avec un code optimisé.

Réduire l’impact des scripts tiers — Minimisez les scripts tiers bloquants exécutés avant l’envoi du premier octet. Différez les scripts non critiques ou chargez-les en asynchrone pour éviter les délais TTFB.

Utiliser l’edge computing — Déployez des fonctions serverless ou des workers en périphérie pour traiter les requêtes au plus près des utilisateurs et crawlers, réduisant la latence et améliorant le TTFB pour le contenu dynamique.

Le rendu côté serveur (SSR) est nettement supérieur au rendu côté client (CSR) pour l’accessibilité des crawlers IA et les performances TTFB, car il délivre un HTML entièrement rendu aux crawlers sans nécessiter d’exécution JavaScript. Avec le CSR, le serveur envoie une coquille HTML minimale et des bundles JavaScript qui doivent être téléchargés, analysés et exécutés dans le navigateur avant que le contenu ne soit disponible — un processus pouvant ajouter 500 ms à plus de 2 secondes avant que les crawlers IA puissent accéder au vrai contenu. Le SSR élimine ce délai en rendant la page complète côté serveur avant de l’envoyer au client, de sorte que le premier octet de HTML contient déjà toute l’architecture et le contenu de la page. Pour les crawlers IA soumis à des fenêtres de timeout strictes, cette différence est cruciale : un site CSR peut expirer avant que le JavaScript ait fini de s’exécuter, résultant en un crawler ne recevant que la coquille HTML vide sans contenu à indexer. Le SSR offre aussi un TTFB plus constant quelles que soient les conditions réseau, le rendu ayant lieu une fois côté serveur plutôt que de dépendre de la performance JavaScript côté client. Bien que le SSR demande davantage de ressources serveur et une implémentation rigoureuse, ses bénéfices en matière de performance IA en font un incontournable pour les sites visant la visibilité dans l’IA. Les approches hybrides combinant SSR au chargement initial puis hydratation côté client offrent le meilleur des deux mondes : un TTFB rapide pour les crawlers et une expérience interactive pour les utilisateurs.

L’impact pratique de l’optimisation du TTFB sur la visibilité IA est considérable et mesurable dans divers secteurs et types de contenus. Une publication technologique a réduit son TTFB de 850 ms à 180 ms grâce à la mise en place d’un CDN et à l’optimisation des requêtes base de données, ce qui s’est traduit par une augmentation de 52 % des citations dans les articles générés par l’IA sur trois mois. Un site e-commerce fournissant des informations produit a amélioré son TTFB de 1,2 seconde à 220 ms en implémentant le cache Redis pour les données produit et en passant au SSR pour les pages catégories, constatant une hausse de 38 % des mentions produit dans les assistants d’achat IA. Un institut de recherche publiant des articles académiques a atteint un TTFB inférieur à 150 ms grâce à l’edge computing et à la génération de site statique, permettant à ses publications d’être citées plus fréquemment dans les synthèses et revues IA. Ces améliorations ne sont pas le fruit d’une seule optimisation, mais d’approches systématiques traitant plusieurs goulets d’étranglement TTFB simultanément. Le point commun de ces réussites : chaque réduction de 100 ms du TTFB correspond à une augmentation mesurable du taux de succès des crawlers IA et de la fréquence de citation. Les organisations maintenant un TTFB constamment sous les 200 ms rapportent une visibilité 3 à 5 fois supérieure dans les contenus générés par l’IA comparé à des concurrents dépassant 800 ms, démontrant que ce seuil se traduit directement par un impact business via un trafic et des citations IA accrus.

Mettre en place une surveillance robuste du TTFB est essentiel pour maintenir une performance optimale et identifier rapidement toute dégradation avant qu’elle n’impacte le succès des crawlers IA. Commencez par établir des métriques de référence avec des outils comme WebPageTest ou Google PageSpeed Insights, en mesurant le TTFB depuis plusieurs régions afin d’identifier les variations et points faibles. Mettez en place une surveillance continue via des tests synthétiques réguliers depuis différentes régions et conditions réseau, avec alertes déclenchées quand les métriques dépassent les seuils — la plupart des organisations devraient fixer les alertes à 250 ms pour détecter les problèmes avant d’atteindre le seuil des 200 ms. Le Real User Monitoring (RUM) offre des données complémentaires montrant le TTFB réellement vécu par les crawlers et utilisateurs, révélant des variations que les tests synthétiques peuvent rater. Établissez un processus de test pour chaque changement : avant de déployer une modification d’infrastructure ou de code, mesurez l’impact TTFB en environnement de préproduction, pour garantir que les optimisations améliorent effectivement la performance et n’introduisent pas de régressions. Créez un tableau de bord performance visible de toute l’équipe, pour que le TTFB devienne une responsabilité partagée. Prévoyez des revues régulières — mensuelles ou trimestrielles — pour analyser les tendances, identifier les nouveaux goulets d’étranglement et planifier les initiatives d’optimisation. Cet état d’esprit d’amélioration continue garantit que le TTFB reste optimisé à mesure que votre site évolue, que le trafic change et que de nouvelles fonctionnalités sont ajoutées.

AmICited.com propose une surveillance spécialisée de la façon dont les systèmes IA citent et référencent votre contenu, offrant des insights uniques sur la relation entre TTFB et visibilité IA que les outils de performance génériques ne fournissent pas. Alors que les outils classiques mesurent le TTFB isolément, AmICited suit comment la performance TTFB se traduit directement en fréquence de citation à travers les principaux systèmes IA comme GPT, Perplexity, Google AI Overviews, etc. La plateforme surveille les schémas de comportement des crawlers IA, identifiant quand ils accèdent à votre contenu, à quelle fréquence ils reviennent, et si un TTFB lent provoque une indexation incomplète ou des timeouts. Les analytics d’AmICited révèlent quels contenus reçoivent des citations dans les réponses générées par l’IA, vous permettant de corréler ces données à vos métriques TTFB et de comprendre l’impact business direct des optimisations de performance. La plateforme envoie des alertes quand les schémas d’accès crawler IA changent, signalant potentiellement des problèmes de TTFB ou d’autres soucis techniques affectant la visibilité IA. Pour les organisations souhaitant maximiser le trafic et les citations issus de l’IA, AmICited apporte la visibilité cruciale pour savoir si les optimisations TTFB se traduisent vraiment par une meilleure visibilité IA. En combinant le monitoring des citations IA d’AmICited avec les outils traditionnels de mesure TTFB, vous obtenez une vue complète de l’impact direct de la performance serveur sur votre présence dans les contenus générés par l’IA — le critère de visibilité le plus important aujourd’hui.

Le standard d’excellence TTFB pour la réussite des crawlers IA est inférieur à 200 ms. Ce seuil garantit que les systèmes IA peuvent accéder et traiter efficacement votre contenu dans leurs fenêtres de timeout. Un TTFB entre 200-500 ms est acceptable mais sous-optimal, tandis qu’un TTFB supérieur à 800 ms réduit significativement la visibilité et le taux de citation par l’IA.

Le TTFB agit comme un facteur qualificatif pour l’inclusion dans l’IA plutôt qu’un signal de classement direct. Un TTFB lent peut entraîner un timeout des crawlers IA ou la réception d’un contenu incomplet, réduisant la probabilité que vos pages soient indexées et citées. Les sites maintenant un TTFB sous 200 ms constatent un taux de citation 40-60 % plus élevé que leurs concurrents plus lents.

Oui, plusieurs optimisations peuvent améliorer le TTFB sans changer d’hébergeur : mettre en place un cache côté serveur (Redis/Memcached), déployer un CDN, optimiser les requêtes de base de données, activer HTTP/2 et minimiser les scripts bloquants. Ces changements permettent souvent une amélioration du TTFB de 30 à 50 %. Cependant, l’hébergement mutualisé peut présenter des limites intrinsèques empêchant d’atteindre le seuil des 200 ms.

Utilisez des outils comme Google PageSpeed Insights, WebPageTest, GTmetrix ou Cloudflare Analytics pour mesurer le TTFB. Testez depuis plusieurs localisations géographiques pour comprendre les variations régionales. Établissez des métriques de référence avant les optimisations puis surveillez en continu avec des tests synthétiques et un monitoring réel afin de suivre les améliorations.

Les deux sont importants mais remplissent des rôles différents. La qualité du contenu détermine si les systèmes IA souhaitent citer votre contenu, tandis que le TTFB détermine s’ils peuvent y accéder efficacement. Un excellent contenu avec un mauvais TTFB risque de ne jamais être indexé, tandis qu’un contenu moyen avec un excellent TTFB sera toujours accessible. Optimisez les deux pour une visibilité maximale dans l’IA.

Mettez en place une surveillance continue avec des alertes fixées à 250 ms pour détecter les problèmes avant qu’ils n’impactent la visibilité IA. Effectuez des revues de performance détaillées mensuelles ou trimestrielles afin d’identifier les tendances et planifier les optimisations. Surveillez plus fréquemment lors de modifications majeures de l’infrastructure ou de pics de trafic pour garantir la stabilité du TTFB.

Le TTFB ne mesure que le temps jusqu’à l’arrivée du premier octet de la réponse du serveur, tandis que le temps de chargement de la page inclut le téléchargement de toutes les ressources, le rendu et l’exécution de JavaScript. Le TTFB est fondamental — il constitue le point de départ de toutes les autres métriques de performance. Un TTFB rapide est nécessaire mais pas suffisant pour un chargement global rapide.

La distance géographique entre l’origine du crawler et votre serveur a un impact significatif sur le TTFB. Un crawler à Singapour accédant à un serveur hébergé en Virginie peut rencontrer une latence de 300-400 ms, tandis qu’un site distribué via CDN atteint 50-80 ms grâce aux serveurs de périphérie régionaux. La mise en place d’un CDN mondial garantit un TTFB constant inférieur à 200 ms quel que soit l’emplacement du crawler.

Suivez comment les crawlers IA accèdent à votre site et optimisez votre visibilité dans les réponses IA. AmICited vous aide à comprendre la relation directe entre TTFB et citations IA.

Le taux de crawl est la vitesse à laquelle les moteurs de recherche explorent votre site web. Découvrez comment il affecte l’indexation, la performance SEO et c...

La fréquence de crawl correspond à la fréquence à laquelle les moteurs de recherche et les crawleurs d’IA visitent votre site. Découvrez ce qui influence les ta...

Découvrez des stratégies éprouvées pour augmenter la fréquence à laquelle les crawlers IA visitent votre site web, améliorer la découvrabilité du contenu dans C...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.