Contenus payants et IA : implications pour la visibilité

Découvrez comment les systèmes d'IA contournent les paywalls et reconstituent des contenus premium. Comprenez l'impact sur le trafic des éditeurs et les stratég...

Découvrez comment les systèmes d’IA accèdent au contenu payant et protégé, les techniques qu’ils utilisent, et comment protéger votre contenu tout en maintenant la visibilité de votre marque auprès de l’IA.

Oui, les systèmes d'IA peuvent accéder au contenu protégé par divers moyens, notamment l'intégration à la recherche web, des techniques de crawl, et parfois en contournant les paywalls. Certains modèles d'IA comme ChatGPT respectent les directives du fichier robots.txt, tandis que d'autres comme Perplexity ont été documentés utilisant des crawlers furtifs pour contourner les restrictions.

Les systèmes d’IA ont développé plusieurs méthodes sophistiquées pour accéder au contenu protégé, y compris les articles payants, les ressources sur abonnement et les contenus protégés par formulaire. La capacité de l’intelligence artificielle à contourner les restrictions traditionnelles de contenu représente un changement majeur dans la circulation de l’information numérique sur Internet. Comprendre ces mécanismes est crucial pour les créateurs de contenu, les éditeurs et les marques souhaitant protéger leur propriété intellectuelle tout en maintenant leur visibilité dans les réponses générées par l’IA. Le paysage de l’accès au contenu par l’IA est complexe et continue d’évoluer à mesure que les entreprises d’IA et les éditeurs adaptent leurs stratégies.

L’une des principales méthodes par lesquelles les chatbots IA accèdent au contenu payant est l’intégration de la recherche web. ChatGPT et Perplexity, parmi d’autres moteurs de réponse IA, ont mis en œuvre des capacités de recherche web en temps réel leur permettant de récupérer des informations actuelles sur Internet. Lorsque les utilisateurs posent des questions sur l’actualité ou des sujets spécifiques, ces systèmes d’IA effectuent des recherches en direct et peuvent accéder à du contenu qui nécessiterait normalement un paiement ou une authentification. Cette approche diffère des données d’entraînement traditionnelles, où les modèles d’IA apprenaient à partir d’informations historiques. L’intégration de la recherche web en direct a fondamentalement changé la manière dont les systèmes d’IA interagissent avec le contenu payant, leur permettant de fournir des informations actualisées tout en contournant les restrictions d’accès classiques.

Différentes entreprises d’IA adoptent des approches très différentes concernant la transparence des crawlers et le comportement éthique. Le ChatGPT d’OpenAI fonctionne avec des crawlers déclarés qui respectent les directives des sites web, y compris les fichiers robots.txt et les blocages explicites. Lorsque ChatGPT rencontre un fichier robots.txt qui interdit son crawler, il cesse de tenter d’accéder à ce contenu. Cette approche transparente s’aligne avec les standards établis d’Internet et témoigne d’un respect pour les préférences des propriétaires de sites. À l’inverse, des recherches ont montré que Perplexity utilise des crawlers déclarés et non déclarés, les derniers employant des techniques furtives pour éviter la détection et contourner les restrictions des sites. Ces crawlers furtifs changent d’adresses IP et modifient leur user-agent pour se faire passer pour des navigateurs web standards, ce qui les rend difficiles à identifier et à bloquer.

On a observé que les systèmes d’IA accèdent systématiquement à des contenus d’actualité payants sans que les utilisateurs aient à payer d’abonnement. Cette capacité représente un défi direct pour les modèles économiques des grands médias et fournisseurs de contenus premium. Lorsqu’un utilisateur interroge un chatbot IA sur un article payant, le système peut récupérer et résumer l’intégralité du contenu, fournissant ainsi un accès gratuit à du matériel initialement monétisé. Les mécanismes d’accès varient, mais impliquent souvent les capacités de recherche web de l’IA combinées à des techniques de crawl sophistiquées. Certains systèmes d’IA peuvent accéder au contenu par des chemins différents des navigateurs web traditionnels, exploitant potentiellement des failles techniques ou des lacunes dans la mise en œuvre des paywalls. Ce comportement suscite de sérieuses inquiétudes chez les éditeurs concernant la perte de revenus et la protection du contenu.

Le contenu protégé par formulaire présente des défis et des opportunités différents pour l’accessibilité de l’IA par rapport au contenu payant. Traditionnellement, les formulaires exigent que les utilisateurs fournissent des coordonnées avant d’accéder à des ressources telles que des livres blancs, eBooks ou rapports de recherche. Les crawlers IA peuvent accéder au contenu protégé par formulaire via deux stratégies principales : la méthode hybride et la méthode de l’URL séparée. Dans la méthode hybride, l’intégralité du contenu est techniquement présente dans le code HTML de la page mais masquée à l’utilisateur tant qu’il n’a pas soumis le formulaire. Les crawlers IA peuvent lire ce code sous-jacent et accéder au contenu complet sans soumission du formulaire. La méthode de l’URL séparée consiste à placer le contenu protégé sur une URL dédiée marquée comme noindex mais toujours accessible aux crawlers via des liens internes stratégiques et des sitemaps XML. Les deux approches permettent aux IA de découvrir et d’indexer du contenu protégé tout en continuant à générer des leads auprès des utilisateurs humains.

| Système IA | Transparence du crawler | Conformité robots.txt | Techniques furtives | Intégration recherche web |

|---|---|---|---|---|

| ChatGPT | Déclaré et transparent | Conformité totale | Aucune observée | Oui, respecte les restrictions |

| Perplexity | Déclaré et non déclaré | Partielle/évasive | Crawlers furtifs documentés | Oui, accès agressif |

| Gemini | Crawlers déclarés | Généralement conforme | Minime | Oui, recherche intégrée |

| Claude | Crawlers déclarés | Conforme | Aucune observée | Accès web limité |

Les systèmes d’IA emploient plusieurs approches techniques pour contourner les restrictions et accéder aux contenus protégés. Une méthode consiste à utiliser de multiples adresses IP et à changer d’ASN pour éviter la détection et le blocage. Lorsqu’un site bloque les requêtes provenant d’une plage d’IP connue d’un crawler IA, le système peut continuer à accéder au contenu depuis d’autres adresses IP non identifiées. Une autre technique consiste à modifier l’user-agent pour se faire passer pour des navigateurs web comme Chrome ou Safari, rendant les requêtes IA similaires à du trafic humain légitime. Cette dissimulation complique l’identification des crawlers IA par les administrateurs de site, rendant l’application des restrictions plus difficile. De plus, certains systèmes d’IA peuvent exploiter des failles techniques dans la mise en œuvre des paywalls ou utiliser des sources de données alternatives lorsque les méthodes principales sont bloquées.

La capacité des systèmes d’IA à accéder au contenu payant a créé d’importants défis pour les médias et les fournisseurs de contenus premium. Les éditeurs ont investi dans des technologies de paywall pour générer des revenus d’abonnement, mais les IA peuvent souvent contourner ces protections afin de résumer le contenu pour les utilisateurs. Cette capacité mine le modèle économique sur lequel comptent de nombreux éditeurs, car les utilisateurs peuvent obtenir des résumés de contenus premium via des chatbots IA sans payer. Cette situation a amené les éditeurs à prendre des mesures défensives, telles que l’implémentation de technologies de paywall plus strictes, le blocage des crawlers IA connus, ou l’engagement de poursuites contre les entreprises d’IA. Cependant, le jeu du chat et de la souris continue, les sociétés d’IA trouvant de nouveaux moyens d’accéder au contenu alors que les éditeurs mettent en place de nouvelles restrictions. Certains éditeurs commencent à envisager des partenariats avec les entreprises d’IA pour que leur contenu soit correctement attribué et potentiellement monétisé lorsqu’il est utilisé dans des réponses générées par IA.

Les propriétaires de sites disposent de plusieurs options pour contrôler la façon dont les systèmes d’IA accèdent à leur contenu protégé et payant. L’approche la plus simple est d’utiliser des directives robots.txt qui interdisent explicitement l’accès des crawlers IA à certains contenus. Cependant, cette méthode ne fonctionne qu’avec les IA qui respectent le robots.txt, et n’empêche pas l’accès des crawlers furtifs. Une protection plus robuste passe par la mise en place de règles WAF (Web Application Firewall) bloquant spécifiquement les plages d’IP et user-agents connus des crawlers IA. Ces règles peuvent mettre au défi ou bloquer les requêtes identifiées comme provenant de bots IA, mais nécessitent des mises à jour régulières car les sociétés d’IA modifient leur comportement. Pour une protection maximale, les propriétaires de sites peuvent exiger une authentification avant accès au contenu, créant ainsi une barrière que la plupart des crawlers IA ne peuvent franchir. L’utilisation de plateformes de surveillance dédiées permettant de suivre l’activité des crawlers IA aide également à identifier les tentatives d’accès non autorisées et à ajuster les mesures de sécurité en conséquence.

Bien qu’il soit important de protéger le contenu protégé contre l’accès non autorisé de l’IA, bloquer complètement les crawlers IA peut nuire à la visibilité de votre marque dans les réponses générées par l’IA. Les systèmes d’IA influencent de plus en plus la découverte et la consommation d’informations, et être cité dans les réponses IA peut générer du trafic et asseoir votre autorité. Le défi stratégique pour les créateurs de contenu est de concilier la génération de leads grâce au contenu protégé avec les avantages de la visibilité IA. Une approche efficace consiste à mettre en place des stratégies hybrides où les crawlers IA peuvent accéder et indexer vos contenus les plus précieux, tout en continuant à capter des leads humains via les formulaires. Cette stratégie implique de placer l’intégralité du contenu dans le code HTML de la page mais de le masquer pour les humains tant que le formulaire n’est pas soumis. Une autre stratégie est de créer des résumés publics non protégés qui se classent bien dans les résultats IA, tout en maintenant des ressources détaillées protégées pour la génération de leads. Cette approche à deux niveaux permet de profiter de la visibilité IA tout en protégeant le contenu premium et en générant des leads qualifiés.

Le paysage de l’accès au contenu par l’IA continue d’évoluer à mesure que les standards et réglementations se développent. L’Internet Engineering Task Force (IETF) travaille à la normalisation d’extensions au robots.txt pour offrir aux créateurs de contenu des mécanismes plus clairs afin de spécifier comment les IA doivent accéder à leur contenu. Ces nouveaux standards visent à établir des règles plus explicites pour le comportement des crawlers IA tout en respectant les préférences des propriétaires de sites. À mesure que ces standards mûrissent, les sociétés d’IA seront de plus en plus contraintes de s’y conformer. Le développement du Web Bot Auth, une norme ouverte pour l’authentification des bots, représente une avancée vers un comportement des crawlers IA plus transparent et responsable. Cependant, l’efficacité de ces standards dépendra de leur adoption généralisée par les sociétés d’IA et les propriétaires de sites. La tension persistante entre les sociétés d’IA cherchant à offrir une information complète et les créateurs de contenu soucieux de protéger leur propriété intellectuelle devrait continuer à stimuler l’innovation tant dans les méthodes d’accès que dans les technologies de protection.

Suivez comment votre contenu apparaît dans les réponses générées par l'IA sur ChatGPT, Perplexity et d'autres moteurs de recherche IA. Obtenez des informations en temps réel sur votre visibilité dans la recherche IA.

Découvrez comment les systèmes d'IA contournent les paywalls et reconstituent des contenus premium. Comprenez l'impact sur le trafic des éditeurs et les stratég...

Comprenez comment les paywalls impactent la visibilité de votre contenu dans les moteurs de recherche IA comme ChatGPT, Perplexity et Google AI Overviews. Décou...

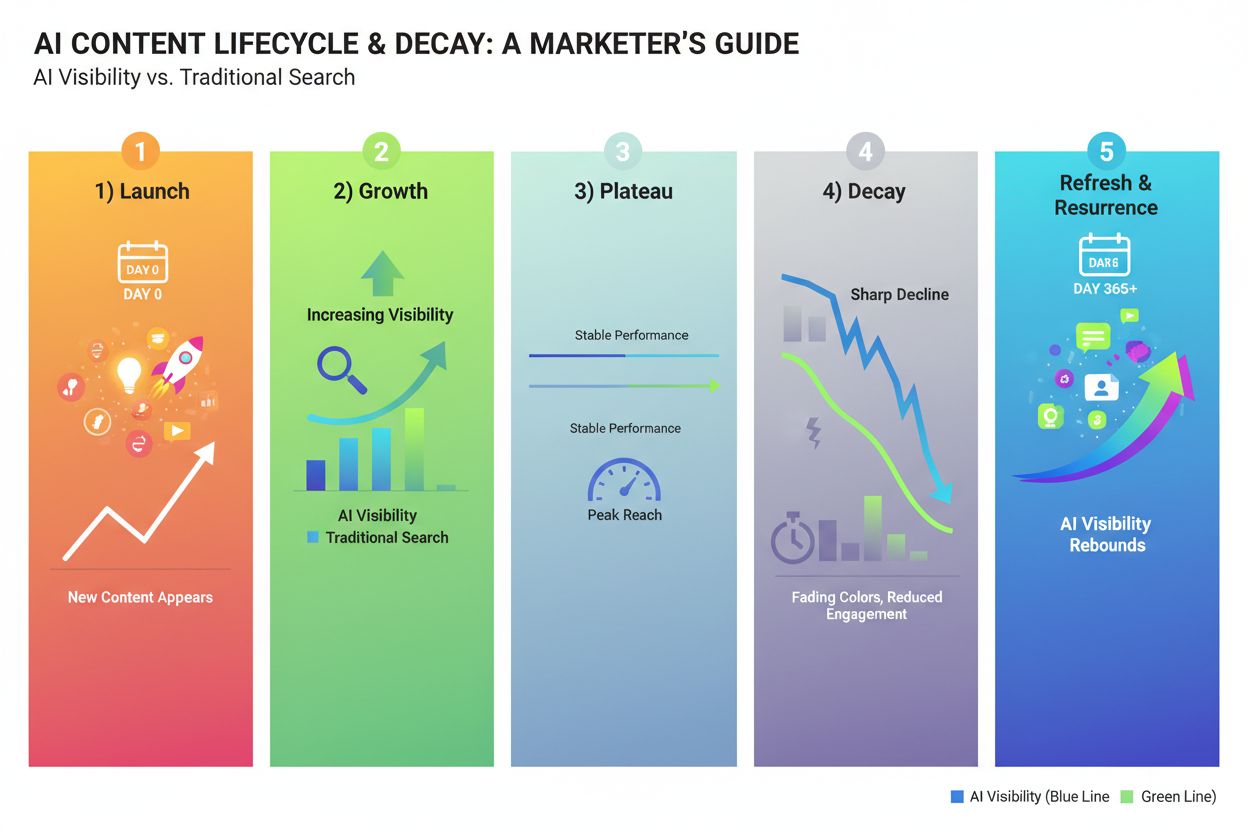

Découvrez à quelle fréquence mettre à jour votre contenu pour être visible par l’IA. Identifiez les signaux de fraîcheur, les recommandations de fréquence de mi...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.