Définition d’un moteur de recherche IA

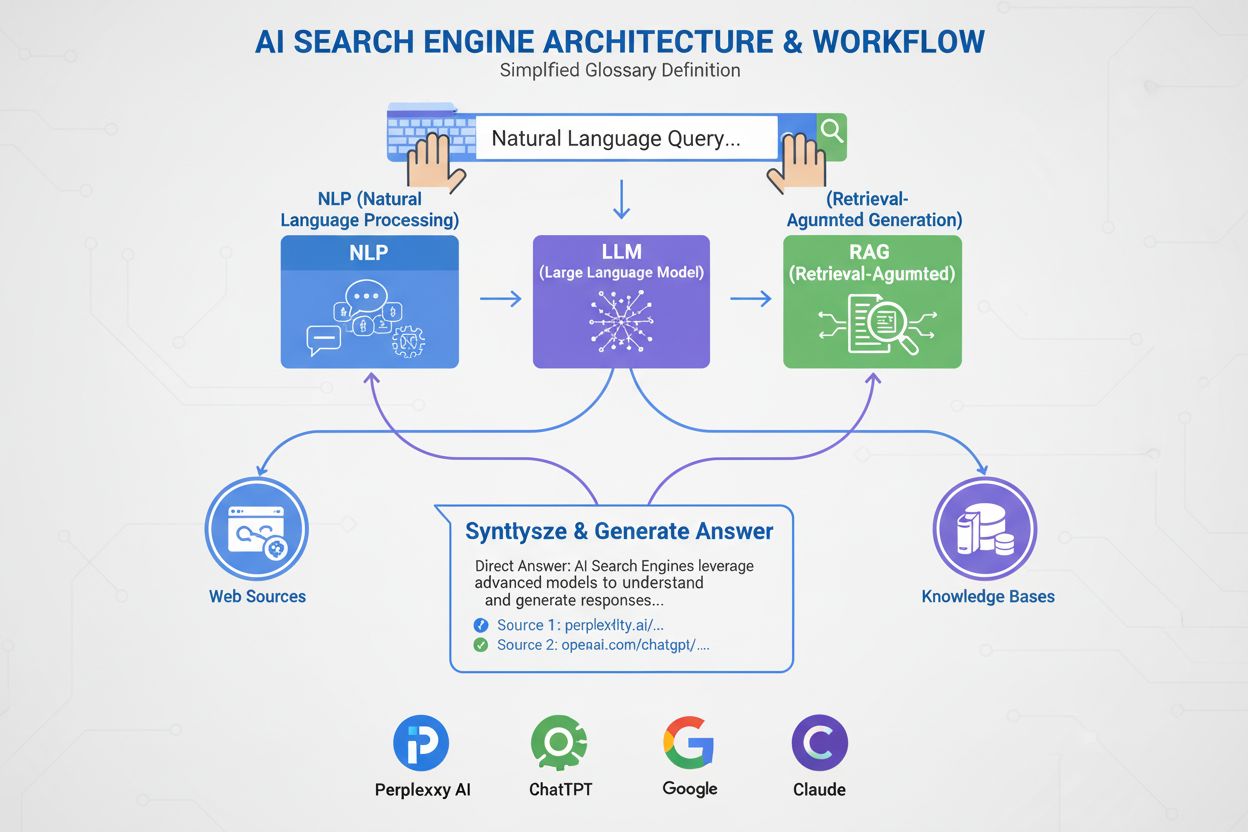

Un moteur de recherche IA est une plateforme qui utilise l’intelligence artificielle, le traitement du langage naturel (NLP) et les grands modèles de langage (LLM) pour interpréter les requêtes utilisateurs et générer des réponses directes et conversationnelles synthétisées à partir de sources web. Contrairement aux moteurs de recherche traditionnels qui affichent des listes de liens, les moteurs IA fournissent des résumés concis en langage courant répondant directement à l’intention de l’utilisateur. Ces plateformes s’appuient sur la génération augmentée par récupération (RAG) pour combiner la récupération web en temps réel à la synthèse IA générative, leur permettant de délivrer des informations actuelles et citées. Les moteurs de recherche IA représentent une évolution fondamentale dans la façon dont les gens découvrent l’information en ligne, passant des listes de liens basées sur des mots-clés à la compréhension sémantique et aux réponses directes. La technologie à la base de ces systèmes intègre plusieurs disciplines de l’IA—recherche sémantique, reconnaissance d’entités et IA conversationnelle—pour créer une expérience de recherche plus intuitive et efficace.

Contexte et historique

L’émergence des moteurs de recherche IA marque une évolution majeure dans la technologie de la recherche d’information. Pendant des décennies, les moteurs de recherche fonctionnaient selon un paradigme de correspondance de mots-clés, où la pertinence était déterminée par la présence et la fréquence des termes recherchés dans les documents indexés. Cependant, la montée des grands modèles de langage et les progrès de la compréhension du langage naturel ont fondamentalement bouleversé ce modèle. Le marché mondial des moteurs de recherche IA a atteint 15,23 milliards USD en 2024 et devrait enregistrer un taux de croissance annuel composé (TCAC) de 16,8 % jusqu’en 2032, selon une étude de marché. Cette croissance explosive reflète à la fois l’adoption par les entreprises et la demande des consommateurs pour des expériences de recherche plus intelligentes et conversationnelles.

L’IA générative a transformé la manière dont les gens découvrent l’information en ligne, faisant évoluer la recherche au-delà de la traditionnelle liste de liens bleus vers des réponses plus directes et conversationnelles. Des leaders du secteur comme Google et Microsoft Bing ont rapidement intégré l’IA à leurs plateformes pour rivaliser avec des étoiles montantes comme Perplexity et You.com. Selon une étude McKinsey, environ 50 % des recherches Google comportent déjà des résumés IA, un chiffre qui devrait dépasser 75 % d’ici 2028. Ce changement ne se limite pas à l’interface utilisateur—il redéfinit la stratégie de contenu et l’optimisation pour les moteurs de recherche dans une nouvelle ère appelée « optimisation pour moteur génératif » (GEO).

Cette transition s’inscrit dans une adoption plus large des technologies IA en entreprise. 78 % des organisations déclaraient utiliser l’IA en 2024, contre 55 % l’année précédente, selon le rapport AI Index de Stanford. Pour les professionnels du search et du marketing, cela signifie que la visibilité dépend désormais de la compréhension de la façon dont les systèmes IA analysent, condensent et reformulent le contenu en résumés clairs. Le défi est que les réponses IA détournent souvent le trafic des sites d’origine, créant des opportunités et des défis pour les créateurs de contenu et les marques qui cherchent à maintenir leur visibilité dans ce nouveau paysage.

Ready to Monitor Your AI Visibility?

Track how AI chatbots mention your brand across ChatGPT, Perplexity, and other platforms.

Fonctionnement des moteurs de recherche IA : l’architecture technique

Les moteurs de recherche IA fonctionnent selon un pipeline sophistiqué en plusieurs étapes combinant récupération, classement et synthèse. Le processus débute par la compréhension de la requête, où le système analyse l’entrée utilisateur via le traitement du langage naturel pour en extraire le sens, l’intention et le contexte. Plutôt que de traiter la requête comme une simple chaîne de mots-clés, le système crée plusieurs représentations : une forme lexicale pour la récupération exacte, un vecteur dense pour la recherche sémantique et une forme entité pour l’appariement avec le graphe de connaissance.

Une fois la requête comprise, la plupart des moteurs IA utilisent la génération augmentée par récupération (RAG), un schéma architectural clé qui pallie les faiblesses fondamentales des grands modèles de langage. RAG effectue une étape de récupération en direct, recherchant dans des index web ou via des API pour extraire des documents et passages pertinents. Ces candidats sont ensuite reclassés à l’aide de modèles sophistiqués qui évaluent conjointement la requête et les candidats pour produire des scores de pertinence affinés. Les meilleurs résultats sont injectés dans un grand modèle de langage comme contexte d’ancrage, qui synthétise une réponse conversationnelle tout en restant fidèle aux sources récupérées.

Les pipelines hybrides de récupération sont la norme sur les principales plateformes. Ils combinent la recherche lexicale (basée sur les mots-clés, via des algorithmes comme BM25) et la recherche sémantique (basée sur les embeddings, utilisant la similarité vectorielle). La recherche lexicale excelle dans la précision pour les correspondances exactes, les termes rares et les entités nommées, tandis que la recherche sémantique excelle dans le rappel pour les contenus conceptuellement proches. En fusionnant les deux approches et en appliquant un reranking croisé, les moteurs IA atteignent une précision supérieure à celle de chaque méthode isolée. La synthèse finale s’effectue via un grand modèle de langage qui compose une réponse cohérente et naturelle intégrant des informations de plusieurs sources, tout en maintenant l’exactitude et en fournissant des citations.

Tableau comparatif : moteurs IA vs moteurs traditionnels

| Aspect | Moteurs de recherche traditionnels | Moteurs de recherche IA |

|---|

| Format des résultats | Listes de liens avec courts extraits | Résumés conversationnels avec réponses directes |

| Traitement des requêtes | Correspondance et classement par mots-clés | Compréhension sémantique et analyse d’intention |

| Mécanisme d’apprentissage | Réinitialisé à chaque requête | Apprentissage continu à partir des interactions utilisateurs |

| Récupération de l’information | Appariement lexical/par mots-clés | Hybride (lexical + sémantique + entité) |

| Formats d’entrée | Texte uniquement | Texte, images, voix et vidéo (multimodal) |

| Mises à jour en temps réel | Indexation, crawl périodique | Accès web en temps réel via RAG |

| Comportement de citation | Pas de citations ; l’utilisateur trouve les sources | Citations intégrées et attribution des sources |

| Interaction utilisateur | Requête unique, résultats statiques | Conversations multi-tours avec relances |

| Gestion des biais | Curateurs organisent l’information | Synthèse IA pouvant introduire un biais développeur |

| Risque d’hallucination | Faible (liens factuels) | Plus élevé (LLM peuvent générer des informations erronées) |

Stay Updated on AI Visibility Trends

Get the latest insights on AI mentions, brand monitoring, and optimization strategies.

Différents moteurs IA adoptent des architectures distinctes, chacune avec ses implications en matière d’optimisation. AI Overviews et le mode IA de Google utilisent une stratégie de propagation de requêtes, où une requête utilisateur est décomposée en sous-questions explorant différentes dimensions d’intention. Ces sous-questions sont exécutées en parallèle sur diverses sources—index web, Knowledge Graph, transcriptions YouTube, flux Google Shopping, et index spécialisés. Les résultats sont agrégés, dédupliqués et classés avant la synthèse finale. Pour les experts GEO, cela signifie que le contenu doit répondre à plusieurs facettes d’une requête de façon extractible pour survivre à ce processus.

Bing Copilot adopte une approche plus traditionnelle, s’appuyant sur l’infrastructure de classement mature de Bing et superposant la synthèse GPT. La plateforme utilise une récupération à double voie, combinant la recherche lexicale BM25 et la recherche sémantique vectorielle dense. Les résultats passent par un reranker croisé centré sur la pertinence des passages plutôt que sur le classement global de page. Cette architecture implique que les signaux SEO classiques—explorabilité, balises canoniques, HTML propre, rapidité du site—restent essentiels pour déterminer quels candidats accèdent au contexte d’ancrage. Bing Copilot met également l’accent sur l’extractabilité : les passages à portée claire, avec listes, tableaux ou définitions explicites, ont plus de chances d’être cités.

Perplexity AI mise sur la transparence, affichant les sources en évidence avant la réponse générée. La plateforme effectue des recherches en temps réel, puis évalue les candidats selon la pertinence lexicale et sémantique, l’autorité thématique et l’extractabilité de la réponse. Des études sur 59 facteurs influençant le classement chez Perplexity montrent une priorité donnée à la structuration en réponse directe—les pages qui reformulent explicitement la requête dans un titre, suivies immédiatement d’une réponse concise et dense en informations, sont surreprésentées parmi les citations. La proéminence des entités et le maillage contextuel jouent aussi un rôle : Perplexity favorise les passages où les entités clés sont clairement nommées et reliées à des concepts associés.

ChatGPT Search adopte une approche opportuniste, générant dynamiquement des requêtes et appelant l’API Bing pour récupérer des URLs spécifiques. Contrairement aux plateformes à index persistant, ChatGPT extrait le contenu en temps réel, l’inclusion dépend donc entièrement de la capacité à être récupéré à l’instant T. Si un site est bloqué par robots.txt, lent à charger, caché derrière du rendu client ou opaque sémantiquement, il ne sera pas utilisé en synthèse. Cette architecture privilégie l’accessibilité et la clarté : les pages doivent être explorables, légères et transparentes sémantiquement pour garantir l’extraction d’un texte propre et analysable à la volée.

Le rôle du traitement du langage naturel et des grands modèles de langage

Le traitement du langage naturel (NLP) est la technologie fondamentale qui permet aux moteurs IA d’aller au-delà de la simple correspondance de mots-clés. Le NLP permet d’analyser la structure, la sémantique et l’intention des requêtes, de comprendre le contexte et de reconnaître synonymes et notions associées. Lorsqu’un utilisateur demande « meilleurs endroits pour manger près de chez moi avec terrasse », un système doté de NLP comprend qu’il s’agit de restaurants avec terrasse, même sans la mention explicite de ces mots. Cette compréhension sémantique permet d’apporter des résultats pertinents même lorsque l’intention est moins explicite ou formulée de façon conversationnelle.

Les grands modèles de langage (LLM) pilotent la phase de synthèse des moteurs IA. Entraînés sur d’énormes volumes de texte, les LLM prédisent le mot le plus logique suivant en fonction du contexte, produisant ainsi une prose cohérente et grammaticale, proche de l’écrit humain. Mais ils comportent aussi des risques, notamment l’hallucination—présenter des contrevérités comme des faits—car ils produisent du texte de façon probabiliste sans forcément citer des sources en direct. D’où le rôle critique de la génération augmentée par récupération (RAG) : en ancrant la synthèse LLM dans des sources fraîchement extraites et faisant autorité, les moteurs IA réduisent le risque d’hallucination et améliorent la fiabilité factuelle. Certaines plateformes intègrent des citations ligne à ligne pour limiter ce risque, même si les articles cités ne sont pas toujours exacts, voire inexistants.

Différences clés entre recherche IA et recherche traditionnelle

Les moteurs de recherche IA se distinguent des moteurs traditionnels sur plusieurs points fondamentaux. Premièrement, ils fournissent des résumés au lieu de liens. Les moteurs classiques affichent des listes de liens accompagnés d’extraits, tandis que les moteurs IA génèrent des résumés concis qui répondent directement à la requête, évitant à l’utilisateur de devoir cliquer sur de multiples sites. Deuxièmement, la recherche IA apprend dans le temps, alors que la recherche traditionnelle repart de zéro à chaque requête. Les moteurs IA sont conçus pour apprendre et s’adapter continuellement aux interactions et aux nouvelles données, améliorant leurs performances au fil du temps. Les moteurs classiques fonctionnent à chaque requête indépendamment, sans tenir compte des précédentes ou des interactions utilisateurs.

Troisièmement, la recherche IA se concentre sur la sémantique, alors que la recherche traditionnelle cible les mots-clés. Les moteurs classiques dépendent principalement de la correspondance de mots-clés pour interpréter les requêtes, alors que les moteurs IA misent sur la sémantique—le sens global des mots dans leur contexte. Cela leur permet de mieux comprendre l’intention utilisateur et de fournir des résultats plus pertinents. Quatrièmement, la recherche IA accepte plusieurs formats d’entrée, là où la recherche classique ne traite que le texte. Certains moteurs IA offrent des capacités multimodales, c’est-à-dire qu’ils peuvent traiter et comprendre des informations issues de formats autres que le texte, comme les images, vidéos ou audio. Cela rend la recherche plus intuitive et flexible que la simple saisie de mots-clés.

Impact sur la visibilité des marques et la stratégie de contenu

L’essor des moteurs IA bouleverse la façon dont les marques abordent la visibilité et la stratégie de contenu. Plutôt que de viser uniquement le classement sur des mots-clés, éditeurs et entreprises doivent désormais anticiper la façon dont les IA analysent, condensent et reformulent leur contenu en résumés clairs. Cette mutation inaugure une nouvelle ère d’« optimisation pour moteur génératif » (GEO), où l’objectif n’est plus seulement d’être classé, mais d’être récupéré, synthétisé et cité par les IA.

Les études montrent que même les leaders du secteur accusent un retard de 20 à 50 % en GEO par rapport au SEO, selon McKinsey. Cet écart reflète l’immaturité des stratégies GEO et la complexité d’optimiser simultanément pour plusieurs plateformes IA. Pour les marques, l’enjeu est majeur : la visibilité dépend désormais du caractère récupérable (présence dans les résultats), extractible (structure permettant une citation aisée par l’IA) et fiable (démonstration d’expertise, d’autorité et de confiance) du contenu. Des outils de suivi comme AmICited surveillent désormais les mentions de marques sur les plateformes IA—Perplexity, ChatGPT, Google AI Overviews, Claude—pour mesurer cette nouvelle visibilité et identifier des opportunités d’optimisation.

Aspects essentiels de l’optimisation pour moteurs IA

- Récupérabilité : Assurer la découvrabilité du contenu par les moteurs IA via un bon indexage, l’explorabilité et une optimisation sémantique avec un langage naturel correspondant à l’intention utilisateur.

- Extractabilité : Structurer le contenu en passages clairs, facilement extraits, avec réponses directes, listes à puces, tableaux et définitions, que l’IA peut facilement analyser et citer.

- Optimisation des entités : Définir et relier les entités clés (personnes, entreprises, produits, lieux) avec un balisage schema et des relations contextuelles pour affiner la compréhension sémantique.

- Autorité thématique : Couvrir un sujet en profondeur sur plusieurs pages pour établir votre site comme source faisant autorité, privilégiée par l’IA pour la synthèse.

- Clarté des citations : Utiliser des biographies d’auteur, des références d’organisation et des sources explicites pour augmenter les chances de citation et construire des signaux de confiance reconnus par l’IA.

- Accessibilité en temps réel : Maintenir des temps de chargement rapides, éviter le rendu côté client, et permettre le crawl via robots.txt pour que l’IA puisse extraire le contenu à la demande.

- Couverture multi-intention : Traiter plusieurs facettes et intentions latentes dans les requêtes pour survivre à la propagation et à la récupération des moteurs IA.

- Valorisation visuelle : Intégrer des images explicatives, schémas et visuels légendés qui augmentent les taux de citation et améliorent la richesse du contenu.

Évolution future et perspectives stratégiques

Le paysage de la recherche IA évolue rapidement, avec des conséquences majeures sur la découverte, la diffusion et la monétisation de l’information. Le marché mondial des moteurs de recherche IA devrait croître de 16,8 % par an jusqu’en 2032, porté par l’adoption croissante en entreprise et la demande des consommateurs pour des expériences conversationnelles et intelligentes. À mesure que les moteurs IA arrivent à maturité, plusieurs tendances clés devraient émerger.

Premièrement, la consolidation et la spécialisation devraient s’accélérer. Tandis que les plateformes généralistes comme Google, Bing et Perplexity continueront de dominer, des moteurs IA spécialisés par secteur—juridique, médical, technique, e-commerce—vont se multiplier. Ces moteurs offriront une expertise plus pointue et des synthèses plus précises sur des requêtes de niche. Deuxièmement, les mécanismes de citation et d’attribution deviendront plus sophistiqués et standardisés. Sous la pression réglementaire et celle des éditeurs, les moteurs IA devraient mettre en place des systèmes de citation plus granulaires, facilitant la traçabilité des affirmations et la mesure de la visibilité pour les éditeurs.

Troisièmement, la définition et la mesure de la « visibilité » vont changer radicalement. À l’ère du SEO, la visibilité signifiait le rang et le taux de clics. À l’ère GEO, elle signifie être récupéré, synthétisé et cité—des métriques nécessitant de nouveaux outils de mesure. AmICited et d’autres plateformes ouvrent la voie en suivant les mentions de marque sur plusieurs IA et en fournissant des insights sur la fréquence et le contexte d’apparition dans les réponses générées.

Quatrièmement, la tension entre recherche IA et recherche traditionnelle va s’intensifier. À mesure que les moteurs IA captent davantage l’attention et le trafic, les moteurs classiques devront évoluer sous peine d’obsolescence. L’intégration de l’IA dans le cœur de la recherche Google est une réponse stratégique à cette menace, mais le vainqueur à long terme reste incertain. Marques et éditeurs doivent donc optimiser à la fois pour la recherche classique et la recherche IA, complexifiant la stratégie de contenu.

Enfin, la confiance et la précision deviendront cruciales. À mesure que les moteurs IA deviennent sources principales d’information, l’exactitude et la gestion des biais seront des enjeux majeurs. Des cadres réglementaires sur la transparence et la responsabilité de l’IA devraient émerger, imposant la divulgation des données d’entraînement, des facteurs de classement et des méthodes de citation. Pour les marques et éditeurs, cela signifie que les signaux E-E-A-T—expertise, expérience, autorité et fiabilité—seront encore plus déterminants pour la visibilité aussi bien en SEO classique qu’en GEO.

+++

showCTA = true

ctaHeading = “Surveillez la visibilité de votre marque sur les moteurs de recherche IA”

ctaDescription = “Comprendre les moteurs de recherche IA n’est qu’un début. Suivez où et comment votre marque apparaît dans ChatGPT, Perplexity, Google AI Overviews et Claude grâce à la plateforme de monitoring IA d’AmICited. Mesurez vos performances GEO, identifiez des opportunités de citation et optimisez votre contenu pour la prochaine génération de la recherche.”

ctaPrimaryText = “Contactez-nous”

ctaPrimaryURL = “/contact/”

ctaSecondaryText = “Essayez maintenant”

ctaSecondaryURL = “https://app.amicited.com

”

+++