Analyse des Crawls par l’IA

Découvrez ce qu’est l’analyse des crawls par l’IA et comment l’analyse des journaux serveur permet de suivre le comportement des crawleurs IA, les schémas d’acc...

L’analyse des fichiers journaux est le processus d’examen des journaux d’accès serveur afin de comprendre comment les robots d’exploration des moteurs de recherche et les bots d’IA interagissent avec un site web, révélant les schémas d’exploration, les problèmes techniques et les opportunités d’optimisation pour la performance SEO.

L'analyse des fichiers journaux est le processus d'examen des journaux d'accès serveur afin de comprendre comment les robots d'exploration des moteurs de recherche et les bots d'IA interagissent avec un site web, révélant les schémas d'exploration, les problèmes techniques et les opportunités d'optimisation pour la performance SEO.

L’analyse des fichiers journaux est l’examen systématique des journaux d’accès serveur pour comprendre comment les robots d’exploration des moteurs de recherche, les bots d’IA et les utilisateurs interagissent avec un site web. Ces journaux sont générés automatiquement par les serveurs web et contiennent des enregistrements détaillés de chaque requête HTTP faite sur votre site, y compris l’adresse IP du demandeur, l’horodatage, l’URL demandée, le code d’état HTTP et la chaîne user-agent. Pour les professionnels du SEO, l’analyse des fichiers journaux constitue la source ultime de vérité sur le comportement des robots, révélant des schémas que des outils comme Google Search Console ou les robots classiques ne peuvent pas détecter. Contrairement aux explorations simulées ou aux données analytiques agrégées, les journaux serveur fournissent des preuves non filtrées et de première main de ce que font exactement les moteurs de recherche et les systèmes d’IA sur votre site en temps réel.

L’importance de l’analyse des fichiers journaux a augmenté de façon exponentielle avec l’évolution du paysage numérique. Avec plus de 51 % du trafic Internet mondial désormais généré par des bots (ACS, 2025), et des robots d’IA comme GPTBot, ClaudeBot et PerplexityBot devenant des visiteurs réguliers des sites web, comprendre le comportement des robots n’est plus optionnel—c’est essentiel pour maintenir la visibilité aussi bien dans la recherche traditionnelle que sur les nouvelles plateformes de recherche alimentées par l’IA. L’analyse des fichiers journaux fait le lien entre ce que vous pensez se passer sur votre site et ce qui se passe réellement, permettant des décisions fondées sur les données qui impactent directement les classements, la vitesse d’indexation et la performance organique globale.

L’analyse des fichiers journaux est un pilier du SEO technique depuis des décennies, mais sa pertinence s’est fortement accrue ces dernières années. Historiquement, les professionnels du SEO s’appuyaient principalement sur Google Search Console et des robots tiers pour comprendre le comportement des moteurs de recherche. Cependant, ces outils présentent des limites importantes : Google Search Console ne fournit que des données agrégées et échantillonnées des robots Google ; les robots tiers simulent le comportement d’exploration au lieu de capturer les interactions réelles ; et aucun des deux ne suit efficacement les bots non-Google ou les bots d’IA.

L’émergence des plateformes de recherche alimentées par l’IA a radicalement changé la donne. Selon une étude de Cloudflare en 2024, Googlebot représente 39 % de tout le trafic des robots d’IA et d’exploration, tandis que les robots IA constituent désormais le segment à la croissance la plus rapide. Les bots IA de Meta génèrent à eux seuls 52 % du trafic des robots IA, soit plus du double de Google (23 %) ou OpenAI (20 %). Ce changement signifie que les sites web reçoivent désormais la visite de dizaines de types de bots différents, dont beaucoup ne suivent pas les protocoles SEO traditionnels ni ne respectent les règles standard du robots.txt. L’analyse des fichiers journaux est la seule méthode qui capture ce tableau complet, la rendant indispensable à une stratégie SEO moderne.

Le marché mondial de la gestion des journaux devrait passer de 3 228,5 millions de dollars en 2025 à des valorisations bien plus élevées d’ici 2029, avec un taux de croissance annuel composé (CAGR) de 14,6 %. Cette croissance reflète la reconnaissance croissante, par les entreprises, que l’analyse des journaux est essentielle pour la sécurité, le monitoring de la performance et l’optimisation SEO. Les organisations investissent massivement dans des outils automatisés d’analyse de journaux et des plateformes alimentées par l’IA capables de traiter des millions d’entrées de journaux en temps réel, transformant les données brutes en insights exploitables qui génèrent des résultats métiers.

Lorsqu’un utilisateur ou un bot demande une page sur votre site web, le serveur web traite cette requête et enregistre des informations détaillées sur l’interaction. Ce processus est automatique et continu, créant une piste d’audit complète de toute l’activité serveur. Comprendre ce fonctionnement est essentiel pour interpréter correctement les données des fichiers journaux.

Le flux typique commence lorsqu’un robot d’exploration (Googlebot, un bot d’IA ou le navigateur d’un utilisateur) envoie une requête HTTP GET à votre serveur, incluant une chaîne user-agent qui l’identifie. Votre serveur reçoit cette requête, la traite, puis retourne un code d’état HTTP (200 pour succès, 404 pour non trouvé, 301 pour redirection permanente, etc.) accompagné du contenu demandé. Chacune de ces interactions est enregistrée dans le fichier d’accès serveur, générant une entrée horodatée qui capture l’adresse IP, l’URL demandée, la méthode HTTP, le code d’état, la taille de la réponse, le référent et la chaîne user-agent.

Les codes d’état HTTP sont particulièrement importants pour l’analyse SEO. Un code 200 indique une livraison réussie de la page ; les codes 3xx signalent des redirections ; les codes 4xx des erreurs client (comme 404 Non Trouvé) ; les codes 5xx des erreurs serveur. En analysant la répartition de ces codes dans vos journaux, vous pouvez identifier des problèmes techniques empêchant les robots d’accéder à votre contenu. Par exemple, si un robot rencontre plusieurs réponses 404 en tentant d’accéder à des pages importantes, cela signale un lien cassé ou un contenu manquant nécessitant une correction immédiate.

Les chaînes user-agent sont tout aussi essentielles pour identifier quels bots visitent votre site. Chaque robot possède une chaîne user-agent unique. Celle de Googlebot inclut “Googlebot/2.1”, celle de GPTBot “GPTBot/1.0” et celle de ClaudeBot “ClaudeBot”. En analysant ces chaînes, vous pouvez segmenter vos données de journaux pour étudier le comportement par type de robot, révélant quels bots priorisent quels contenus et comment leurs schémas d’exploration diffèrent. Cette analyse fine permet des stratégies d’optimisation ciblées pour différentes plateformes de recherche et systèmes d’IA.

| Aspect | Analyse des fichiers journaux | Google Search Console | Robots tiers | Outils analytiques |

|---|---|---|---|---|

| Source de données | Journaux serveur (first-party) | Données d’exploration Google | Explorations simulées | Suivi du comportement utilisateur |

| Exhaustivité | 100 % de toutes les requêtes | Données agrégées, échantillonnées | Simulation uniquement | Trafic humain uniquement |

| Couverture des bots | Tous les robots (Google, Bing, bots IA) | Google uniquement | Robots simulés | Pas de données bots |

| Données historiques | Historique complet (rétention variable) | Période limitée | Instantané d’une exploration | Historique disponible |

| Insights en temps réel | Oui (avec automatisation) | Rapport différé | Non | Rapport différé |

| Visibilité du budget d’exploration | Schémas exacts d’exploration | Résumé haut niveau | Estimé | Non applicable |

| Problèmes techniques | Détail (codes d’état, temps de réponse) | Visibilité limitée | Problèmes simulés | Non applicable |

| Suivi des bots IA | Oui (GPTBot, ClaudeBot, etc.) | Non | Non | Non |

| Coût | Gratuit (journaux serveur) | Gratuit | Outils payants | Gratuit/Payant |

| Complexité de mise en place | Moyenne à élevée | Simple | Simple | Simple |

L’analyse des fichiers journaux est devenue indispensable pour comprendre comment les moteurs de recherche et les systèmes d’IA interagissent avec votre site web. Contrairement à Google Search Console, qui ne transmet que la perspective de Google et des données agrégées, les fichiers journaux capturent le panorama complet de l’activité de tous les robots. Cette vue d’ensemble est essentielle pour identifier le gaspillage de budget d’exploration, c’est-à-dire lorsque les moteurs de recherche dépensent des ressources à explorer des pages à faible valeur plutôt que du contenu important. Les études montrent que les grands sites gaspillent souvent 30 à 50 % de leur budget d’exploration sur des URLs non essentielles comme les archives paginées, la navigation à facettes ou le contenu obsolète.

L’essor de la recherche alimentée par l’IA rend l’analyse des fichiers journaux encore plus cruciale. À mesure que des bots IA comme GPTBot, ClaudeBot et PerplexityBot deviennent des visiteurs réguliers, comprendre leur comportement est essentiel pour optimiser la visibilité dans les réponses générées par l’IA. Ces bots agissent souvent différemment des robots d’exploration traditionnels—ils peuvent ignorer les règles robots.txt, explorer plus agressivement ou cibler des types de contenu spécifiques. L’analyse des journaux est la seule méthode qui révèle ces schémas, vous permettant d’optimiser votre site pour la découverte IA tout en gérant l’accès des bots via des règles ciblées.

Les problèmes techniques SEO qui passeraient inaperçus autrement peuvent être détectés via l’analyse des journaux : chaînes de redirections, erreurs serveur 5xx, lenteurs de chargement, problèmes de rendu JavaScript… En analysant ces schémas, vous pouvez prioriser les corrections qui impactent directement l’accessibilité et la vitesse d’indexation. Par exemple, si vos journaux montrent que Googlebot reçoit systématiquement des erreurs 503 Service Indisponible sur une section précise de votre site, vous savez exactement où concentrer vos efforts techniques.

Obtenir vos journaux serveur est la première étape de l’analyse, mais la procédure varie selon votre environnement d’hébergement. Pour les serveurs auto-hébergés fonctionnant sous Apache ou NGINX, les journaux sont généralement stockés dans /var/log/apache2/access.log ou /var/log/nginx/access.log respectivement. Vous pouvez accéder à ces fichiers directement via SSH ou via le gestionnaire de fichiers de votre serveur. Pour les hébergements WordPress gérés comme WP Engine ou Kinsta, les journaux peuvent être disponibles via le tableau de bord d’hébergement ou en SFTP, bien que certains fournisseurs limitent l’accès pour protéger la performance serveur.

Les CDN (Content Delivery Networks) comme Cloudflare, AWS CloudFront ou Akamai nécessitent une configuration spécifique pour accéder aux journaux. Cloudflare propose Logpush, qui envoie les journaux de requêtes HTTP vers des espaces de stockage désignés (AWS S3, Google Cloud Storage, Azure Blob Storage) pour extraction et analyse. AWS CloudFront propose une journalisation standard pouvant être configurée pour stocker les journaux dans des buckets S3. Ces journaux CDN sont essentiels pour comprendre comment les bots interagissent avec votre site lorsque le contenu est servi via un CDN, car ils capturent les requêtes en périphérie et non à votre serveur d’origine.

Les hébergements mutualisés offrent souvent un accès limité aux journaux. Les fournisseurs comme Bluehost ou GoDaddy proposent parfois des journaux partiels via cPanel, mais ces journaux sont généralement rapidement archivés et peuvent exclure des champs critiques. Si vous êtes en hébergement mutualisé et que vous avez besoin d’une analyse complète, envisagez de passer à un VPS ou à une solution d’hébergement géré offrant un accès complet aux journaux.

Une fois les journaux obtenus, la préparation des données est essentielle. Les fichiers bruts contiennent des requêtes de toutes origines—utilisateurs, bots, scrapers, acteurs malveillants. Pour l’analyse SEO, il convient de filtrer le trafic non pertinent et de se concentrer sur l’activité des robots des moteurs de recherche et d’IA. Cela implique généralement :

L’analyse des fichiers journaux révèle des insights invisibles pour les autres outils SEO, servant de fondation pour des décisions d’optimisation stratégiques. L’un des plus précieux est l’analyse des schémas d’exploration, qui montre exactement quelles pages sont visitées et à quelle fréquence. En suivant la fréquence d’exploration dans le temps, vous pouvez identifier si Google augmente ou réduit son attention sur certaines sections de votre site. Une chute soudaine de la fréquence peut indiquer un problème technique ou une perte d’importance perçue, alors qu’une hausse suggère que Google réagit positivement à vos optimisations.

L’efficacité du budget d’exploration est aussi un insight clé. En analysant le ratio de réponses réussies (2xx) par rapport aux erreurs (4xx, 5xx), vous repérez les sections du site où les robots rencontrent des problèmes. Si un répertoire retourne systématiquement des erreurs 404, il gaspille le budget d’exploration sur des liens cassés. De même, si les robots passent trop de temps sur des URLs paginées ou une navigation à facettes, vous gaspillez du budget sur du contenu à faible valeur. L’analyse des journaux quantifie ce gaspillage, vous permettant d’évaluer l’impact potentiel des optimisations.

La découverte de pages orphelines est un avantage unique de l’analyse des fichiers journaux. Les pages orphelines sont des URLs sans liens internes, hors de la structure du site. Les robots classiques passent souvent à côté, car ils ne les découvrent pas via le maillage interne. Mais les journaux révèlent que les moteurs les explorent quand même—souvent car elles sont liées depuis l’extérieur ou présentes dans de vieux sitemaps. En identifiant ces pages orphelines, vous pouvez choisir de les réintégrer, de les rediriger ou de les supprimer.

L’analyse du comportement des bots IA devient un enjeu croissant. En segmentant les données de journaux par user-agents IA, vous voyez quel contenu ces bots privilégient, à quelle fréquence ils visitent, et s’ils rencontrent des obstacles techniques. Par exemple, si GPTBot explore systématiquement vos pages FAQ mais rarement votre blog, cela suggère que les systèmes IA jugent le contenu FAQ plus utile pour l’entraînement. Ce type d’insight peut guider votre stratégie de contenu et votre optimisation pour la visibilité IA.

Une analyse efficace requiert à la fois de bons outils et une approche stratégique. Le Log File Analyzer de Screaming Frog est l’un des outils dédiés les plus populaires, offrant une interface conviviale pour traiter de gros fichiers journaux, identifier les schémas de bots et visualiser les données d’exploration. Botify propose une analyse de journaux de niveau entreprise intégrée aux métriques SEO, permettant de corréler l’activité des bots avec les classements et le trafic. Bot Clarity de seoClarity intègre l’analyse des journaux directement dans la plateforme SEO, facilitant la connexion entre exploration et autres métriques SEO.

Pour les organisations à fort trafic ou à infrastructure complexe, des plateformes d’analyse de journaux alimentées par l’IA telles que Splunk, Sumo Logic ou Elastic Stack offrent des capacités avancées : reconnaissance automatique de schémas, détection d’anomalies, analyses prédictives. Ces plateformes traitent des millions d’entrées en temps réel, identifiant automatiquement de nouveaux bots et signalant toute activité inhabituelle pouvant révéler des menaces ou des problèmes techniques.

Les bonnes pratiques incluent :

À mesure que la recherche alimentée par l’IA prend de l’ampleur, le suivi des bots IA via l’analyse des fichiers journaux devient une fonction clé du SEO. En suivant quels bots IA visitent votre site, quels contenus ils consultent et à quelle fréquence, vous comprenez comment vos contenus alimentent les outils de recherche et modèles génératifs IA. Ces données permettent de décider d’autoriser, bloquer ou restreindre certains bots IA via robots.txt ou en-têtes HTTP.

L’optimisation du budget d’exploration est sans doute l’application la plus impactante de l’analyse des fichiers journaux. Pour les grands sites avec des milliers ou millions de pages, le budget d’exploration est une ressource limitée. Les journaux permettent d’identifier les pages sur-explorées par rapport à leur importance, et celles qui devraient l’être davantage mais ne le sont pas. Les scénarios courants de gaspillage sont :

En corrigeant ces problèmes—via robots.txt, canoniques, noindex ou correctifs techniques—vous redirigez le budget d’exploration vers le contenu à forte valeur, améliorant la vitesse d’indexation et la visibilité des pages stratégiques.

Le futur de l’analyse des fichiers journaux est façonné par l’évolution rapide de la recherche IA. À mesure que de nouveaux bots IA apparaissent et que leur comportement se complexifie, l’analyse des journaux devient encore plus essentielle pour comprendre comment vos contenus sont découverts, accédés et exploités par ces systèmes. Les tendances émergentes incluent :

L’analyse en temps réel propulsée par le machine learning permettra aux SEO de détecter et corriger des problèmes d’exploration en quelques minutes au lieu de plusieurs jours. Les systèmes automatisés identifieront de nouveaux types de bots, signaleront les schémas inhabituels et suggéreront des optimisations sans intervention humaine. Le passage d’une analyse réactive à proactive permettra de maintenir en continu une explorabilité et une indexation optimales.

L’intégration avec le suivi de visibilité IA reliera les données des fichiers journaux aux métriques de performance sur la recherche IA. Plutôt que d’analyser les journaux isolément, les SEO pourront corréler le comportement des robots avec la visibilité réelle dans les réponses générées par l’IA, comprenant ainsi précisément l’impact des schémas d’exploration sur le classement IA. Cette intégration offrira une vision inédite sur la façon dont le contenu passe de l’exploration à l’entraînement IA, puis aux réponses utilisateurs.

La gestion éthique des bots deviendra un enjeu central à mesure que les organisations devront choisir quels bots IA autoriser à accéder à leur contenu. L’analyse des fichiers journaux permettra un contrôle fin, autorisant les bots bénéfiques tout en bloquant ceux qui n’apportent pas de valeur ou d’attribution. Des standards comme le protocole LLMs.txt émergent pour structurer la communication des politiques d’accès, et l’analyse des journaux permettra d’en vérifier le respect.

L’analyse respectueuse de la vie privée évoluera pour concilier besoin d’insights détaillés et réglementations comme le RGPD. Des techniques avancées d’anonymisation et des outils d’analyse centrés sur la confidentialité permettront d’extraire des insights sans stocker ou exposer de données personnelles. Ce sera particulièrement crucial à mesure que l’analyse des journaux se démocratise et que la protection des données se renforce.

La convergence du SEO traditionnel et de l’optimisation pour la recherche IA fait de l’analyse des fichiers journaux un pilier de la stratégie technique pour les années à venir. Les organisations qui maîtrisent cette compétence aujourd’hui seront les mieux positionnées pour maintenir leur visibilité et leur performance à mesure que la recherche continue d’évoluer.

L'analyse des fichiers journaux fournit des données complètes et non échantillonnées de votre serveur, capturant chaque requête de tous les robots, tandis que les statistiques d'exploration de la Google Search Console n'affichent que des données agrégées et échantillonnées provenant des robots Google. Les fichiers journaux offrent des données historiques granulaires et des informations sur le comportement des bots non-Google, y compris les robots d'IA comme GPTBot et ClaudeBot, ce qui les rend plus complets pour comprendre le véritable comportement des robots et identifier les problèmes techniques que la GSC peut manquer.

Pour les sites à fort trafic, une analyse hebdomadaire des fichiers journaux est recommandée pour détecter rapidement les problèmes et surveiller les changements de schémas d'exploration. Les petits sites bénéficient d'un examen mensuel pour établir des tendances et identifier une nouvelle activité de bots. Quelle que soit la taille du site, la mise en place d'une surveillance continue via des outils automatisés aide à détecter les anomalies en temps réel, vous assurant de pouvoir réagir rapidement à un gaspillage de budget d'exploration ou à des problèmes techniques affectant la visibilité dans la recherche.

Oui, l'analyse des fichiers journaux est l'un des moyens les plus efficaces pour suivre le trafic des bots d'IA. En examinant les chaînes user-agent et les adresses IP dans vos journaux serveur, vous pouvez identifier quels bots d'IA visitent votre site, quels contenus ils consultent et à quelle fréquence ils explorent. Ces données sont cruciales pour comprendre comment votre contenu alimente les outils de recherche alimentés par l'IA et les modèles d'IA générative, vous permettant d'optimiser la visibilité IA et de gérer l'accès des bots via les règles du robots.txt.

L'analyse des fichiers journaux révèle de nombreux problèmes techniques SEO, notamment des erreurs d'exploration (codes d'état 4xx et 5xx), des chaînes de redirections, des temps de chargement de page lents, des pages orphelines non liées en interne, un gaspillage de budget d'exploration sur des URLs à faible valeur, des problèmes de rendu JavaScript et des problèmes de contenu dupliqué. Elle identifie également l'activité de bots usurpés et aide à détecter lorsque les robots légitimes rencontrent des obstacles d'accessibilité, vous permettant de prioriser les corrections ayant un impact direct sur la visibilité et l'indexation dans les moteurs de recherche.

L'analyse des fichiers journaux montre exactement quelles pages sont explorées par les moteurs de recherche et à quelle fréquence, révélant où le budget d'exploration est gaspillé sur du contenu à faible valeur, comme les archives paginées, la navigation à facettes ou des URLs obsolètes. En identifiant ces inefficacités, vous pouvez ajuster votre fichier robots.txt, améliorer le maillage interne vers les pages prioritaires et mettre en place des balises canoniques pour rediriger l'attention d'exploration vers le contenu à forte valeur, garantissant que les moteurs de recherche se concentrent sur les pages les plus importantes pour votre activité.

Les fichiers journaux serveur enregistrent généralement les adresses IP (identifiant la source des requêtes), les horodatages (moment des requêtes), les méthodes HTTP (souvent GET ou POST), les URLs demandées (pages exactes consultées), les codes d'état HTTP (200, 404, 301, etc.), la taille des réponses en octets, les informations de référent et les chaînes user-agent (identifiant le robot ou navigateur). Ces données complètes permettent aux SEO de reconstituer exactement ce qui s'est produit lors de chaque interaction serveur et d'identifier les schémas impactant l'explorabilité et l'indexation.

Les bots usurpés prétendent être des robots légitimes des moteurs de recherche, mais possèdent des adresses IP ne correspondant pas aux plages IP officielles publiées par ces moteurs. Pour les identifier, croisez les chaînes user-agent (comme 'Googlebot') avec les plages IP officielles publiées par Google, Bing et d'autres moteurs de recherche. Des outils comme le Log File Analyzer de Screaming Frog valident automatiquement l'authenticité des bots. Les bots usurpés gaspillent le budget d'exploration et peuvent surcharger votre serveur, il est donc recommandé de les bloquer via le robots.txt ou des règles de pare-feu.

Commencez à suivre comment les chatbots IA mentionnent votre marque sur ChatGPT, Perplexity et d'autres plateformes. Obtenez des informations exploitables pour améliorer votre présence IA.

Découvrez ce qu’est l’analyse des crawls par l’IA et comment l’analyse des journaux serveur permet de suivre le comportement des crawleurs IA, les schémas d’acc...

Découvrez ce qu’est un robots.txt, comment il donne des instructions aux robots d’indexation des moteurs de recherche, et les meilleures pratiques pour gérer l’...

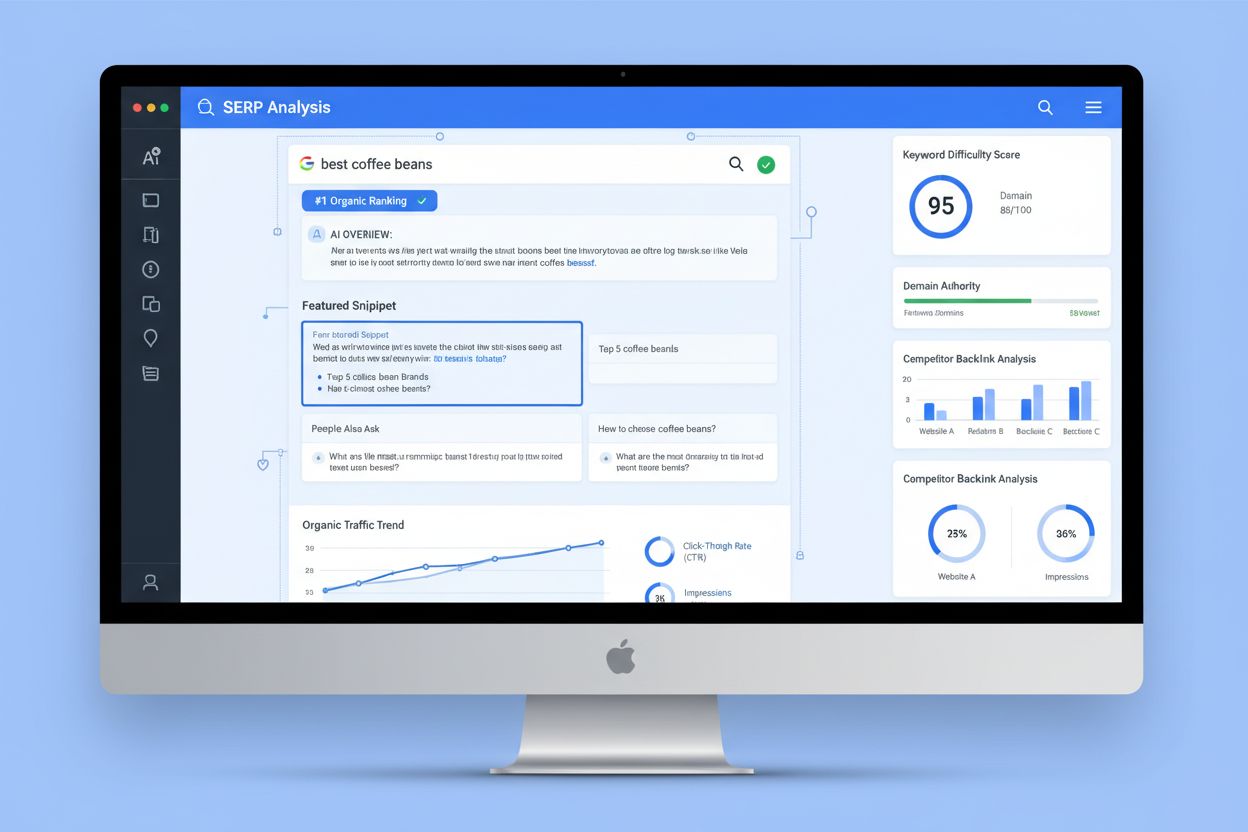

L'analyse SERP est le processus d'examen des pages de résultats des moteurs de recherche pour comprendre la difficulté de classement, l'intention de recherche e...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.