Définition du traitement automatique du langage naturel (TALN)

Le traitement automatique du langage naturel (TALN) est un sous-domaine de l’intelligence artificielle et de l’informatique qui permet aux ordinateurs de comprendre, d’interpréter, de manipuler et de générer le langage humain de manière significative. Le TALN combine la linguistique computationnelle (modélisation du langage humain basée sur des règles), les algorithmes d’apprentissage automatique et les réseaux neuronaux profonds pour traiter aussi bien des données textuelles que vocales. Cette technologie permet aux machines de comprendre la signification sémantique du langage, de reconnaître des schémas dans la communication humaine et de générer des réponses cohérentes qui imitent la compréhension humaine du langage. Le TALN est fondamental pour les applications d’IA modernes, alimentant tout, des moteurs de recherche et chatbots aux assistants vocaux et aux systèmes de surveillance IA qui suivent les mentions de marque sur des plateformes comme ChatGPT, Perplexity et Google AI Overviews.

Contexte historique et évolution du TALN

Le domaine du traitement automatique du langage naturel est apparu dans les années 1950 lorsque les chercheurs ont tenté pour la première fois la traduction automatique, avec l’expérience marquante Georgetown-IBM en 1954 qui a permis de traduire 60 phrases russes en anglais. Cependant, les premiers systèmes de TALN étaient très limités, reposant sur des approches rigides basées sur des règles qui ne pouvaient répondre qu’à des instructions préprogrammées spécifiques. Les années 1990 et le début des années 2000 ont vu des progrès significatifs avec le développement des méthodes statistiques en TALN, introduisant l’apprentissage automatique dans le traitement du langage, ce qui a permis des applications comme le filtrage de spam, la classification de documents et les premiers chatbots. La véritable révolution a eu lieu dans les années 2010 avec l’essor des modèles d’apprentissage profond et des réseaux neuronaux, capables d’analyser de plus grands blocs de texte et de découvrir des schémas complexes dans les données linguistiques. Aujourd’hui, le marché du TALN connaît une croissance explosive, avec des prévisions montrant une expansion mondiale de 59,70 milliards de dollars en 2024 à 439,85 milliards de dollars d’ici 2030, soit un taux de croissance annuel composé (TCAC) de 38,7%. Cette croissance reflète l’importance croissante du TALN dans les solutions d’entreprise, l’automatisation par l’IA et les applications de surveillance de marque.

Ready to Monitor Your AI Visibility?

Track how AI chatbots mention your brand across ChatGPT, Perplexity, and other platforms.

Techniques et méthodes fondamentales du TALN

Le traitement automatique du langage naturel utilise plusieurs techniques fondamentales pour décomposer et analyser le langage humain. La tokenisation consiste à diviser un texte en unités plus petites comme des mots, des phrases ou des groupes de mots, rendant un texte complexe gérable par les modèles d’apprentissage automatique. La racinisation et la lemmatisation réduisent les mots à leur forme racine (par exemple, « courir », « court » et « courait » deviennent « courir »), permettant aux systèmes de reconnaître différentes formes d’un même mot. La reconnaissance d’entités nommées (REN) identifie et extrait des entités spécifiques du texte telles que les noms de personnes, les lieux, les organisations, les dates et les valeurs monétaires—une capacité essentielle pour les systèmes de surveillance de marque qui doivent détecter lorsqu’un nom d’entreprise apparaît dans un contenu généré par IA. L’analyse de sentiment détermine le ton émotionnel ou l’opinion exprimée dans un texte, classant le contenu comme positif, négatif ou neutre, ce qui est essentiel pour comprendre la manière dont les marques sont perçues dans les réponses IA. L’étiquetage grammatical identifie le rôle grammatical de chaque mot dans une phrase (nom, verbe, adjectif, etc.), aidant les systèmes à comprendre la structure et le sens des phrases. La classification de texte permet de catégoriser des documents ou des passages en catégories prédéfinies, donnant la possibilité d’organiser et de filtrer l’information. Ces techniques fonctionnent en synergie dans les chaînes de traitement TALN pour transformer un texte brut et non structuré en données structurées et analysables que les systèmes d’IA peuvent traiter et apprendre.

Comparaison des approches et technologies en TALN

| Approche TALN | Description | Cas d’usage | Avantages | Limites |

|---|

| TALN basé sur des règles | Utilise des arbres de décision si-alors et des règles grammaticales préprogrammées | Chatbots simples, filtrage basique de texte | Prédictible, transparent, pas besoin de données d’entraînement | Non évolutif, ne gère pas les variations linguistiques, flexibilité limitée |

| TALN statistique | Utilise l’apprentissage automatique pour extraire des schémas à partir de données annotées | Détection de spam, classification de documents, étiquetage grammatical | Plus flexible que les règles, apprend à partir des données | Nécessite des données annotées, difficulté avec le contexte et la nuance |

| TALN par apprentissage profond | Utilise des réseaux neuronaux et des modèles de transformeurs sur d’immenses jeux de données non structurées | Chatbots, traduction automatique, génération de contenu, surveillance de marque | Très précis, gère des schémas linguistiques complexes, apprend le contexte | Nécessite d’énormes ressources de calcul, sensible aux biais dans les données d’entraînement |

| Modèles de transformeurs (BERT, GPT) | Utilisent des mécanismes d’auto-attention pour traiter les séquences simultanément | Compréhension du langage, génération de texte, analyse de sentiment, REN | Performance de pointe, entraînement efficace, compréhension du contexte | Coûteux en calcul, nécessite de grands jeux de données, problèmes d’interprétabilité |

| Apprentissage supervisé | Entraîné sur des paires entrée-sortie annotées | Classification de sentiment, reconnaissance d’entités nommées, catégorisation de texte | Grande précision pour des tâches spécifiques, performance prévisible | Besoin de beaucoup de données annotées, annotation chronophage |

| Apprentissage non supervisé | Découvre des schémas dans des données non annotées | Modélisation de sujets, regroupement, détection d’anomalies | Pas besoin d’annotation, découverte de schémas cachés | Moins précis, résultats plus difficiles à interpréter, besoin d’expertise métier |

Stay Updated on AI Visibility Trends

Get the latest insights on AI mentions, brand monitoring, and optimization strategies.

Fonctionnement du TALN : le pipeline complet

Le traitement automatique du langage naturel fonctionne à travers une chaîne systématique qui transforme le langage humain brut en informations exploitables par la machine. Le processus débute par le prétraitement du texte, où l’entrée brute est nettoyée et standardisée. La tokenisation découpe le texte en mots ou groupes de mots, la mise en minuscules convertit tous les caractères afin que « Pomme » et « pomme » soient traités de la même façon, et la suppression des mots vides filtre les mots courants comme « le » ou « est » qui n’apportent pas d’information significative. La racinisation et la lemmatisation ramènent les mots à leur racine, et le nettoyage du texte retire la ponctuation, les caractères spéciaux et les éléments non pertinents. Ensuite, le système effectue l’extraction de caractéristiques, convertissant le texte en représentations numériques exploitables par les modèles d’apprentissage automatique. Des techniques comme le sac de mots et le TF-IDF quantifient l’importance des mots, tandis que les plongements de mots comme Word2Vec et GloVe représentent les mots par des vecteurs denses dans un espace continu, capturant les relations sémantiques. Les plongements contextuels plus avancés tiennent compte des mots environnants pour produire des représentations plus riches. L’étape suivante est l’analyse de texte, où des techniques comme la reconnaissance d’entités nommées identifient des entités spécifiques, l’analyse de sentiment détermine le ton émotionnel, l’analyse de dépendances comprend les relations grammaticales, et la modélisation de sujets identifie les thèmes sous-jacents. Enfin, l’entraînement du modèle utilise les données traitées pour apprendre des schémas et relations, le modèle entraîné étant ensuite déployé pour faire des prédictions sur de nouvelles données. Cette chaîne complète permet à des systèmes comme AmICited de détecter et d’analyser les mentions de marque dans les réponses générées par IA sur ChatGPT, Perplexity et Google AI Overviews.

L’émergence de l’apprentissage profond a fondamentalement transformé le traitement automatique du langage naturel, dépassant les méthodes statistiques grâce à des architectures neuronales capables d’apprendre des schémas linguistiques complexes à partir d’énormes jeux de données. Les réseaux neuronaux récurrents (RNN) et les réseaux LSTM étaient des approches précoces capables de traiter des données séquentielles, mais limitaient la gestion des dépendances à long terme. La percée est venue des modèles de transformeurs, qui ont introduit le mécanisme d’auto-attention—une approche révolutionnaire permettant de considérer simultanément tous les mots d’une séquence et de déterminer les parties les plus importantes pour la compréhension. BERT (Bidirectional Encoder Representations from Transformers), développé par Google, est devenu la base des moteurs de recherche modernes et des tâches de compréhension du langage en traitant le texte de façon bidirectionnelle, saisissant le contexte dans les deux sens. Les modèles GPT (Generative Pre-trained Transformer), dont l’emblématique GPT-4, utilisent une architecture auto-régressive pour prédire le mot suivant, permettant la génération de texte sophistiquée. Ces modèles à base de transformeurs peuvent être entraînés grâce à l’apprentissage auto-supervisé sur d’immenses bases sans annotation manuelle, ce qui les rend très efficaces et évolutifs. Les modèles fondamentaux comme Granite d’IBM sont des modèles préconstruits et sélectionnés, déployables rapidement pour diverses tâches TALN comme la génération de contenu, l’extraction d’insights et la reconnaissance d’entités nommées. Leur puissance réside dans l’aptitude à capturer les nuances sémantiques, comprendre le contexte sur de longs passages et générer des réponses cohérentes et adaptées—des capacités essentielles pour les plateformes de surveillance IA qui suivent les mentions de marque dans le contenu généré par IA.

Applications du TALN dans les secteurs et la surveillance IA

Le traitement automatique du langage naturel est devenu indispensable dans presque tous les secteurs, permettant aux organisations d’extraire des informations actionnables de vastes quantités de données textuelles et vocales non structurées. En finance, le TALN accélère l’analyse des rapports financiers, documents réglementaires et communiqués de presse, aidant les analystes à prendre plus rapidement des décisions éclairées. Les organisations de santé utilisent le TALN pour analyser les dossiers médicaux, les publications scientifiques et les notes cliniques, favorisant un diagnostic plus rapide, une meilleure planification des soins et la recherche médicale. Les assureurs déploient le TALN pour analyser les sinistres, identifier les schémas de fraude ou d’inefficacité et optimiser les flux de traitement. Les cabinets juridiques s’appuient sur le TALN pour la découverte automatisée de documents, l’organisation d’énormes volumes de dossiers et de jurisprudence, réduisant considérablement le temps et les coûts de révision. Les services clients exploitent des chatbots TALN pour gérer les demandes courantes, libérant les agents humains pour des cas complexes. Les équipes marketing et gestion de marque s’appuient de plus en plus sur le TALN pour l’analyse de sentiment et la surveillance de marque, suivant la façon dont leurs marques sont mentionnées et perçues sur les canaux numériques. Particulièrement en phase avec la mission d’AmICited, le TALN permet aux plateformes de surveillance IA de détecter et analyser les mentions de marque dans les réponses générées par IA telles que ChatGPT, Perplexity, Google AI Overviews et Claude. Ces plateformes utilisent la reconnaissance d’entités nommées pour identifier les noms de marque, l’analyse de sentiment pour comprendre le contexte et le ton, et la classification de texte pour catégoriser le type de mention. Cette capacité devient de plus en plus critique à mesure que les organisations reconnaissent que la visibilité de leur marque dans les réponses IA influence directement la découverte client et la réputation à l’ère de l’IA générative.

Tâches et capacités clés du TALN

- Reconnaissance d’entités nommées (REN) : identifie et extrait des entités spécifiques comme des personnes, organisations, lieux, dates et produits à partir du texte, essentiel pour la surveillance de marque et l’extraction d’information

- Analyse de sentiment : détermine le ton émotionnel et l’opinion exprimée dans le texte, classant le contenu comme positif, négatif ou neutre pour comprendre la perception de la marque

- Classification de texte : catégorise des documents ou passages en catégories prédéfinies, permettant l’organisation et le filtrage automatisés de grands volumes de texte

- Traduction automatique : convertit le texte d’une langue à une autre en préservant le sens et le contexte, alimenté par des modèles transformeurs séquence-à-séquence

- Reconnaissance vocale : convertit le langage parlé en texte, permettant les interfaces vocales et la transcription

- Résumé automatique : génère automatiquement des résumés concis de documents longs, faisant gagner du temps d’analyse

- Questions-réponses : permet aux systèmes de comprendre les questions et de retrouver ou générer des réponses précises à partir de bases de connaissances

- Résolution de coréférence : identifie quand différents mots ou expressions désignent la même entité, crucial pour la compréhension du contexte et des relations

- Étiquetage grammatical : identifie le rôle grammatical de chaque mot, aidant à comprendre la structure et le sens des phrases

- Modélisation de sujets : découvre les thèmes et sujets sous-jacents dans des documents ou ensembles de documents, utile pour l’analyse et l’organisation de contenu

Défis et limites du traitement automatique du langage naturel

Malgré des avancées remarquables, le traitement automatique du langage naturel fait face à des défis majeurs qui limitent sa précision et son applicabilité. L’ambiguïté est sans doute le défi principal—les mots et expressions ont souvent plusieurs sens selon le contexte, et les phrases peuvent être interprétées de différentes manières. Par exemple, « J’ai vu l’homme avec le télescope » peut signifier que le locuteur a utilisé un télescope pour voir l’homme, ou que l’homme possédait un télescope. La compréhension contextuelle reste difficile pour les systèmes TALN, notamment lorsque le sens dépend d’informations bien antérieures dans un texte ou requiert une connaissance du monde réel. Le sarcasme, les idiomes et les métaphores posent des défis particuliers car leur sens littéral diffère du sens voulu, et les systèmes entraînés sur des langages standards les interprètent souvent mal. Le ton et la nuance émotionnelle sont difficiles à capter dans le texte seul—les mêmes mots peuvent véhiculer des sens très différents selon l’intonation, l’emphase ou le langage corporel. Le biais dans les données d’entraînement est un problème critique ; les modèles TALN entraînés sur des données du web héritent souvent de biais sociétaux, menant à des résultats discriminatoires ou inexacts. Le nouveau vocabulaire et l’évolution linguistique défient en permanence les systèmes TALN, car de nouveaux mots, argots ou conventions apparaissent plus vite que les données d’entraînement ne peuvent être mises à jour. Les langues rares et dialectes disposent de moins de données, ce qui entraîne de moins bonnes performances pour ces locuteurs. Les erreurs grammaticales, marmonnements, bruits de fond et langage non standard dans l’audio réel compliquent la reconnaissance vocale. Ces limites font que même les meilleurs systèmes TALN peuvent mal interpréter le sens, notamment dans des cas complexes ou avec un langage informel, créatif ou culturellement spécifique.

L’avenir du TALN et tendances émergentes

Le domaine du traitement automatique du langage naturel évolue rapidement, avec de nombreuses tendances émergentes qui dessinent son futur. Le TALN multimodal, qui combine texte, image et audio, permet à des IA plus sophistiquées de comprendre et générer du contenu sur plusieurs modalités à la fois. L’apprentissage few-shot et zero-shot réduit le besoin d’immenses jeux de données annotées, permettant aux modèles TALN de réaliser de nouvelles tâches avec peu d’exemples. La génération augmentée par récupération (RAG) améliore la précision et la fiabilité du contenu généré en connectant les modèles de langage à des sources de connaissance externes, réduisant les hallucinations et améliorant la véracité. Des modèles TALN plus efficients sont développés pour réduire les besoins en calcul, rendant les capacités avancées accessibles aux petites entreprises et aux périphériques. L’IA explicable devient cruciale à mesure que les organisations cherchent à comprendre les décisions des modèles et à se conformer à la réglementation. Les modèles TALN spécialisés sont ajustés pour des domaines comme la santé, le droit, la finance, améliorant la précision sur des langages techniques. L’éthique et la réduction des biais prennent de l’importance alors que les organisations reconnaissent la nécessité de systèmes TALN équitables. Enfin, pour la surveillance de marque, l’intégration du TALN avec les plateformes de monitoring IA devient essentielle, car la visibilité et la perception de la marque dans les réponses IA influencent directement la découverte client et le positionnement concurrentiel. À mesure que des systèmes comme ChatGPT, Perplexity et Google AI Overviews deviennent des sources d’information majeures, la capacité à surveiller et comprendre comment les marques apparaissent dans ces systèmes—grâce à des techniques TALN avancées—sera un pilier du marketing et de la gestion de marque modernes.

Le rôle du TALN dans la surveillance IA et la visibilité de marque

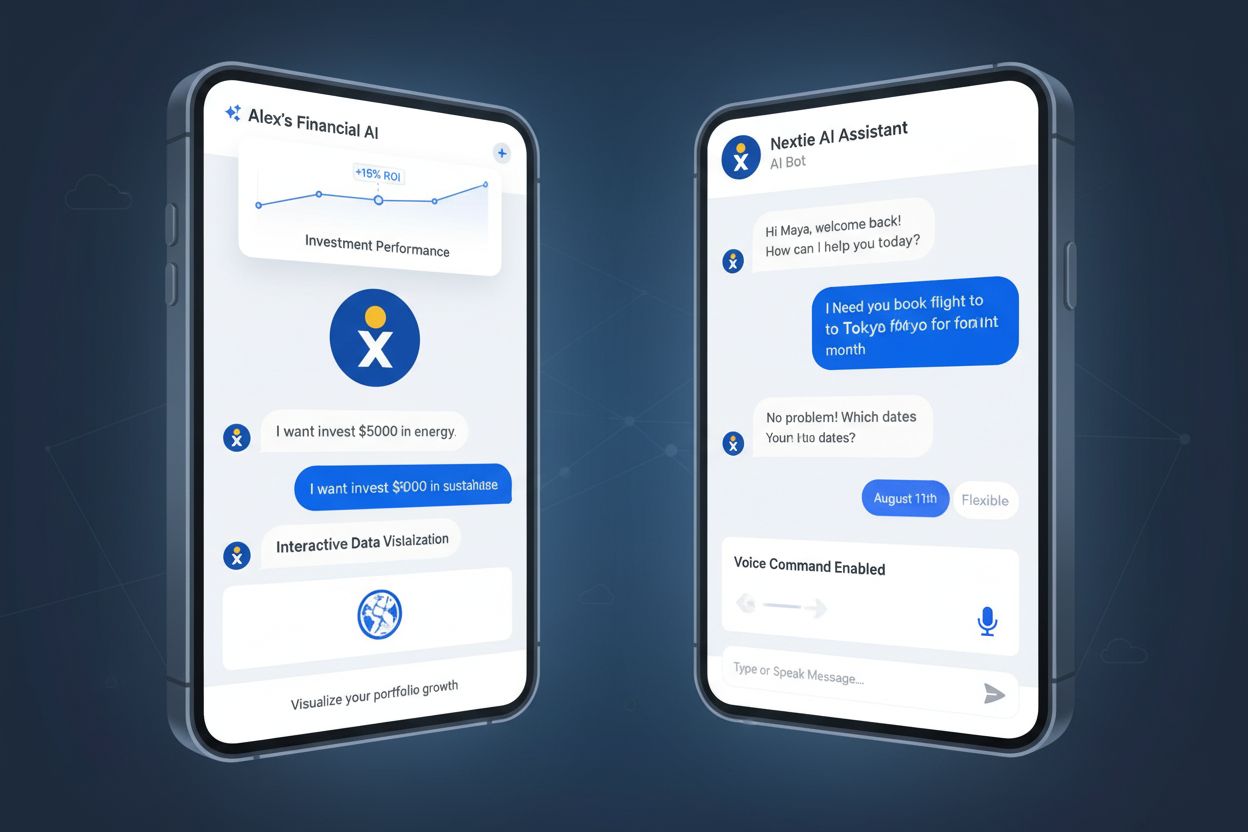

Le traitement automatique du langage naturel constitue le socle technologique qui permet à des plateformes comme AmICited de suivre les mentions de marque à travers les systèmes d’IA. Lorsque les utilisateurs interrogent ChatGPT, Perplexity, Google AI Overviews ou Claude, ces systèmes génèrent des réponses grâce à des grands modèles de langage propulsés par des techniques TALN avancées. AmICited utilise des algorithmes TALN pour analyser ces réponses générées par l’IA, détectant les mentions de marque, extrayant le contexte et analysant le sentiment exprimé. La reconnaissance d’entités nommées identifie les noms de marque et entités associées, l’analyse de sentiment détermine si les mentions sont positives, négatives ou neutres, et la classification de texte catégorise le type de mention (recommandation de produit, comparaison, critique…). Cette capacité offre aux organisations une visibilité cruciale sur leur présence IA—c’est-à-dire la façon dont leur marque est découverte et discutée dans des systèmes d’IA qui deviennent les sources d’information principales pour les consommateurs. Alors que le marché du TALN poursuit sa croissance fulgurante, avec des projections atteignant 439,85 milliards de dollars d’ici 2030, l’importance de la surveillance de marque basée sur le TALN ne fera qu’augmenter, rendant essentiel pour les organisations de comprendre et exploiter ces technologies afin de protéger et renforcer leur réputation à l’ère de l’IA.