Reformulation de requête

Découvrez comment la reformulation de requête aide les systèmes d’IA à interpréter et enrichir les requêtes utilisateur pour une meilleure recherche d’informati...

L’affinage de requête est le processus d’amélioration et d’optimisation des requêtes de recherche par des ajustements itératifs, des clarifications et des expansions pour générer des résultats plus précis, pertinents et exhaustifs à partir des moteurs de recherche IA et des systèmes de recherche d’informations. Il implique de décomposer des requêtes complexes d’utilisateurs en sous-requêtes, d’ajouter des détails contextuels et d’exploiter des boucles de rétroaction pour améliorer progressivement la performance de la recherche et la qualité des résultats.

L’affinage de requête est le processus d’amélioration et d’optimisation des requêtes de recherche par des ajustements itératifs, des clarifications et des expansions pour générer des résultats plus précis, pertinents et exhaustifs à partir des moteurs de recherche IA et des systèmes de recherche d’informations. Il implique de décomposer des requêtes complexes d’utilisateurs en sous-requêtes, d’ajouter des détails contextuels et d’exploiter des boucles de rétroaction pour améliorer progressivement la performance de la recherche et la qualité des résultats.

L’affinage de requête est le processus itératif d’amélioration et d’optimisation des requêtes de recherche par des ajustements, clarifications et expansions systématiques pour générer des résultats plus précis, pertinents et exhaustifs à partir des systèmes de recherche d’informations et des moteurs de recherche IA. Plutôt que de considérer la recherche initiale de l’utilisateur comme définitive, l’affinage de requête reconnaît que les utilisateurs doivent souvent modifier, étoffer ou clarifier leurs requêtes pour trouver exactement ce qu’ils recherchent. Ce processus implique d’analyser la façon dont les utilisateurs modifient leurs recherches, de suggérer des formulations améliorées, et d’exploiter des boucles de rétroaction pour améliorer progressivement les performances de recherche. Dans le contexte des plateformes de recherche IA modernes comme ChatGPT, Perplexity, Google AI Overviews et Claude, l’affinage de requête est devenu un mécanisme fondamental pour fournir des réponses exhaustives et multi-sources aux questions complexes des utilisateurs. La technique transforme la recherche d’une interaction unique et statique en une conversation dynamique et multi-étapes où chaque affinage rapproche les utilisateurs de l’information désirée.

L’affinage de requête n’est pas un concept nouveau dans la recherche d’informations, mais son application a fortement évolué avec l’essor de l’intelligence artificielle et des grands modèles de langage. Historiquement, les moteurs de recherche s’appuyaient principalement sur la correspondance de mots-clés, où la requête de l’utilisateur était comparée directement aux documents indexés. Si vous cherchiez « chaussures de course », le moteur retournait des documents contenant exactement ces mots, sans tenir compte du contexte ou de l’intention utilisateur. Cette approche était rigide et produisait souvent des résultats non pertinents, car elle ignorait la subtilité du langage humain et la complexité des besoins utilisateurs.

L’évolution vers l’affinage de requête a débuté avec l’introduction des systèmes de suggestion de requêtes au début des années 2000, où les moteurs de recherche ont commencé à analyser les comportements utilisateurs pour suggérer des requêtes associées ou affinées. La fonctionnalité « Vouliez-vous dire ? » de Google et les suggestions automatiques ont été parmi les premières implémentations de ce concept. Cependant, ces systèmes restaient relativement simples, principalement basés sur les historiques de requêtes et l’analyse de fréquence. Ils manquaient de la compréhension sémantique nécessaire pour réellement saisir l’intention de l’utilisateur ou les relations entre différentes formulations de requêtes.

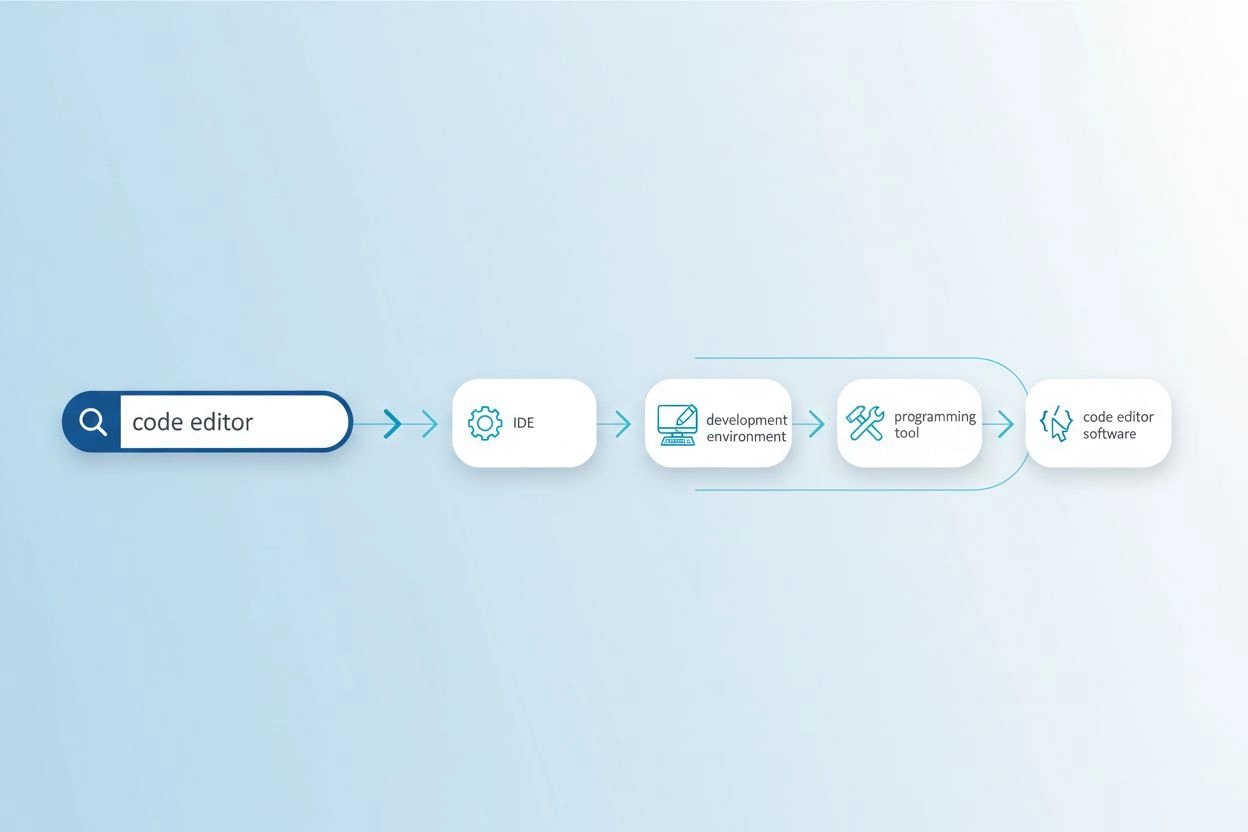

L’introduction du traitement du langage naturel (NLP) et de l’apprentissage automatique a profondément transformé l’affinage de requête. Les systèmes modernes comprennent désormais que « meilleures chaussures de course imperméables » et « chaussures de sport résistantes à la pluie les mieux notées » expriment essentiellement la même requête, malgré une terminologie différente. Cette compréhension sémantique permet de reconnaître les variations de requête, d’identifier les besoins implicites et de suggérer des raffinements qui améliorent réellement les résultats. Selon des recherches de la Kopp Online Marketing SEO Research Suite, les méthodologies d’affinage de requête sont devenues de plus en plus sophistiquées, les systèmes étant désormais capables de générer des requêtes synthétiques (requêtes artificielles simulant les recherches réelles des utilisateurs) pour enrichir les données d’entraînement et améliorer la précision de la recherche.

L’arrivée de l’IA générative et des grands modèles de langage a encore accéléré cette évolution. Les moteurs de recherche IA modernes ne se contentent plus d’affiner les requêtes : ils les décomposent en sous-requêtes multiples, les exécutent en parallèle sur différentes sources de données, puis synthétisent les résultats pour fournir des réponses complètes. Cela marque un changement fondamental, l’affinage de requête passant d’une fonctionnalité visible de suggestion à un composant architectural central des systèmes de recherche IA.

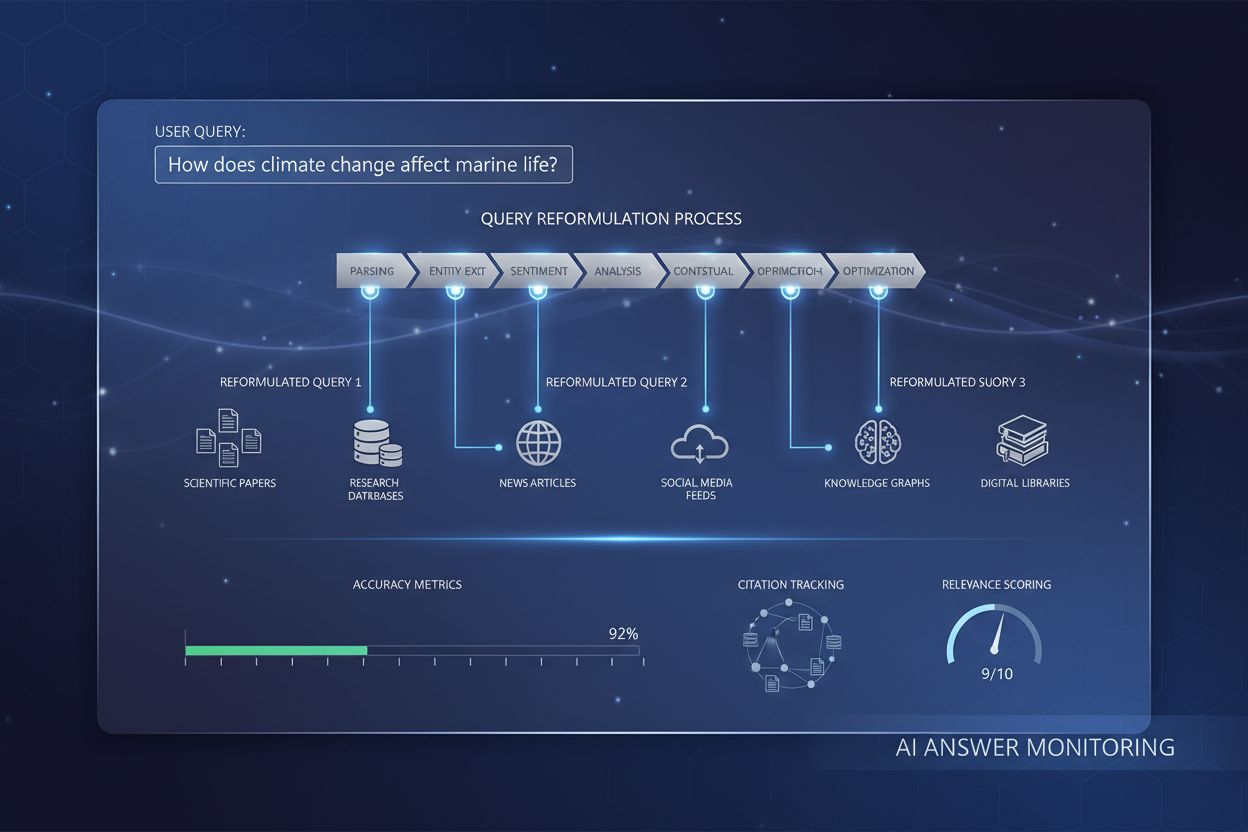

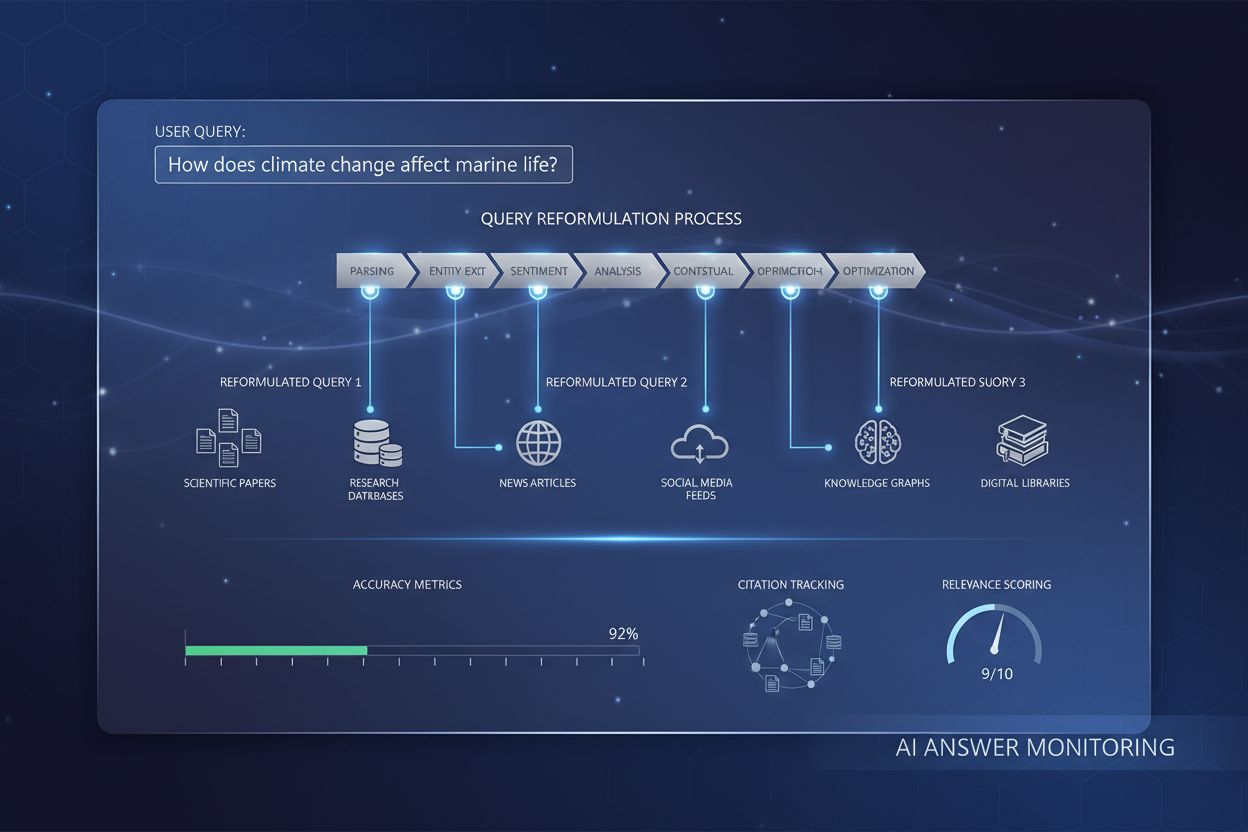

L’affinage de requête s’appuie sur plusieurs mécanismes techniques interconnectés visant à améliorer la qualité de la recherche. Le premier mécanisme est l’analyse de la requête et la détection de l’intention, où le système traite la requête initiale de l’utilisateur pour identifier l’intention sous-jacente, le niveau de complexité et le type de réponse attendu. Les modèles NLP avancés analysent la longueur de la requête, la spécificité du vocabulaire et les signaux contextuels pour déterminer si une simple correspondance de mots-clés suffit ou si un affinage plus sophistiqué est nécessaire. Par exemple, une requête factuelle comme « capitale de l’Allemagne » peut ne pas déclencher d’affinage poussé, tandis qu’une requête complexe comme « meilleures pratiques pour optimiser le contenu pour les moteurs IA » active des processus d’affinage complets.

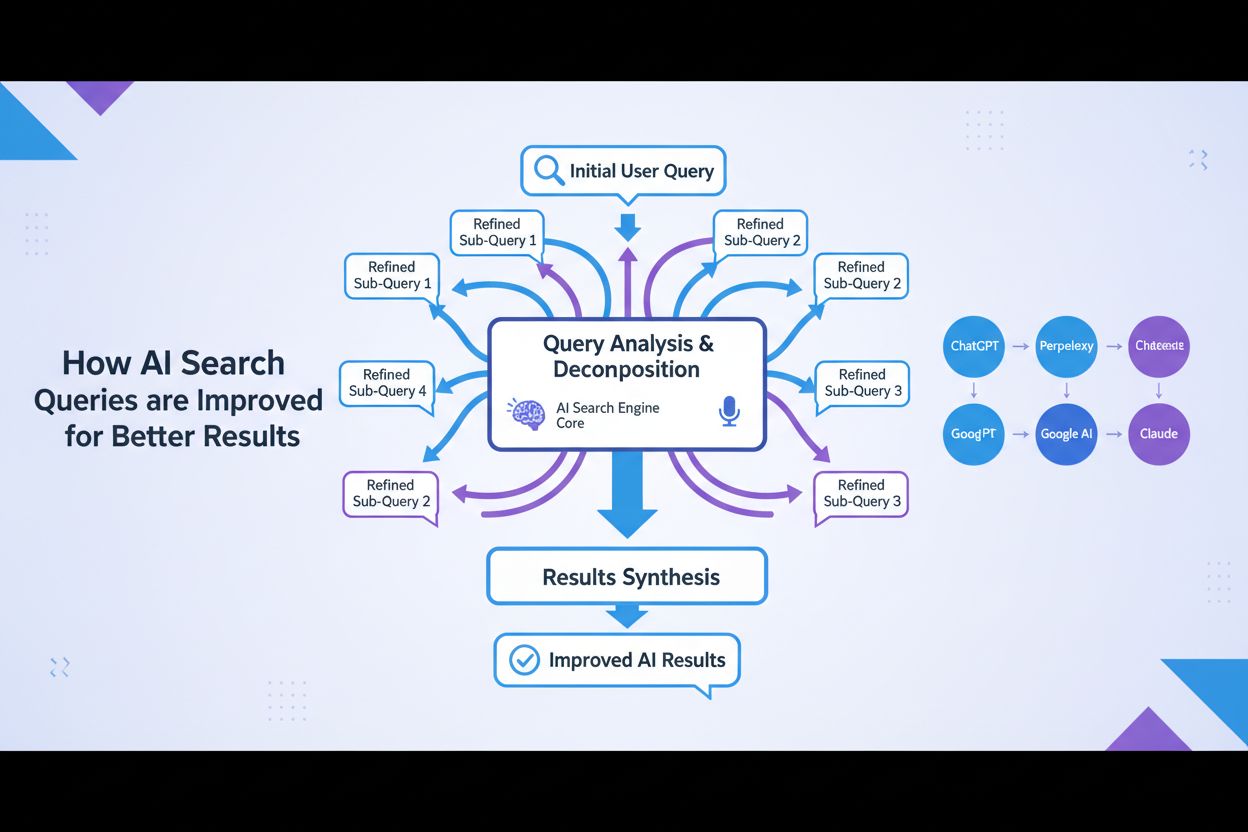

Le deuxième mécanisme est la décomposition et le fan-out de la requête, une technique où les requêtes complexes sont divisées en sous-requêtes constitutives. Ce processus, appelé fan-out de requête, est particulièrement important dans les systèmes de recherche IA. Lorsqu’un utilisateur demande « Quelles sont les meilleures chaussures de course imperméables pour une personne avec des pieds plats qui court sur sentiers ? », le système décompose cela en plusieurs sous-requêtes : exploration des listes de produits, analyse des avis d’experts, étude des expériences utilisateurs, examen des caractéristiques techniques. Ces sous-requêtes sont ensuite exécutées simultanément sur différentes sources (web, graphes de connaissances, bases spécialisées). Cette exécution parallèle élargit considérablement le réservoir d’informations pour la synthèse, permettant à l’IA de fournir des réponses plus nuancées et complètes.

Le troisième mécanisme est l’augmentation de requête, qui consiste à générer des requêtes supplémentaires pour améliorer la performance de la recherche. Selon la Kopp Online Marketing SEO Research Suite, l’augmentation s’appuie sur plusieurs méthodes : analyse historique (examen des affinages précédents), substitution n-gram (modification des requêtes en remplaçant des séquences de termes), association d’entités (identification d’entités dans les résultats et combinaison avec la requête d’origine), et identification de requêtes sœurs (trouver des requêtes associées partageant un parent commun). Ces techniques garantissent que le système explore plusieurs angles sur le besoin d’information de l’utilisateur.

Le quatrième mécanisme repose sur les boucles de rétroaction et l’amélioration continue, où les interactions des utilisateurs avec les résultats servent à affiner ultérieurement le processus. Les clics, le temps passé sur une page, la reformulation de la requête : autant de signaux qui alimentent le système pour améliorer les affinages futurs. Des techniques d’apprentissage par renforcement peuvent optimiser les modèles génératifs, rehaussant la qualité des variantes de requête au fil du temps selon les réponses satisfaisantes. Cela crée un cercle vertueux où chaque interaction rend le système plus performant.

| Aspect | Google AI Overviews | ChatGPT | Perplexity | Claude |

|---|---|---|---|---|

| Méthode principale d’affinage | Fan-out par recherche thématique | Affinage conversationnel multi-tours | Suggestions interactives avec suivi | Clarification contextuelle par le dialogue |

| Génération de sous-requêtes | Décomposition automatique selon l’intention | Guidée par l’utilisateur via la conversation | Affinements suggérés affichés sous forme de « pills » | Implicite via la compréhension du contexte |

| Sources de données | Web en direct, graphes de connaissances, graphes shopping | Données d’entraînement + recherche web (plugins) | Recherche web en temps réel multi-sources | Données d’entraînement avec recherche web |

| Mécanisme de citation | Attribution directe dans l’overview | Liens dans les réponses | Cartes sources avec attribution détaillée | Citations en ligne avec liens sources |

| Contrôle utilisateur | Limité (affinage piloté par le système) | Fort (l’utilisateur dirige la conversation) | Moyen (suggestions + saisie personnalisée) | Fort (l’utilisateur peut demander des affinages) |

| Visibilité de l’affinage | Implicite (l’utilisateur voit la réponse synthétisée) | Explicite (l’utilisateur voit l’historique) | Explicite (suggestions visibles) | Implicite (via le dialogue) |

| Vitesse d’affinage | Immédiate (traitement parallèle) | Séquentielle (tour par tour) | Immédiate (recherche en temps réel) | Séquentielle (basée sur la conversation) |

| Personnalisation | Forte (historique & localisation) | Moyenne (contexte conversationnel) | Moyenne (données de session) | Moyenne (contexte conversationnel) |

Le processus d’affinage de requête dans les moteurs de recherche IA contemporains suit un flux multi-étapes sophistiqué très différent de la recherche traditionnelle. Quand un utilisateur soumet une requête à un système comme Google AI Mode ou ChatGPT, le système n’effectue pas immédiatement la recherche. Il commence par analyser la requête grâce au NLP avancé pour comprendre la demande réelle de l’utilisateur. Cette analyse tient compte de l’historique de recherche, la localisation, le type d’appareil et la complexité de la requête. Le système détermine si la requête est simple (correspondance de mots-clés) ou complexe (décomposition et synthèse multi-sources).

Pour les requêtes complexes, le système active le processus de fan-out. Cela consiste à décomposer la requête initiale en sous-requêtes couvrant différentes facettes du besoin d’information. Par exemple, si un utilisateur demande « Comment optimiser mon site web pour les moteurs IA ? », le système peut générer des sous-requêtes telles que : « Quels sont les facteurs de classement clés pour les moteurs IA ? », « Comment les IA évaluent-elles la qualité du contenu ? », « Qu’est-ce que E-E-A-T et pourquoi c’est important pour l’IA ? », « Comment structurer le contenu pour la citation IA ? », « Quelles sont les bonnes pratiques de formatage pour l’IA ? ». Chacune de ces sous-requêtes est exécutée en parallèle sur différentes sources, afin de récupérer des informations variées répondant à tous les aspects de la question initiale.

Le système évalue ensuite les informations obtenues à l’aide de signaux de qualité comme l’autorité du domaine, la fraîcheur du contenu, la pertinence thématique et les schémas de citation. Les données issues de plusieurs sources sont combinées et synthétisées en une réponse cohérente et exhaustive qui répond directement à la requête de départ. Durant tout ce processus, le système identifie les sources les plus pertinentes et fiables, qui sont ensuite présentées comme citations ou références dans la réponse finale. C’est pourquoi la compréhension de l’affinage de requête est cruciale pour les utilisateurs AmICited : les sources citées dans les réponses IA sont principalement celles qui correspondent le mieux aux sous-requêtes affinées générées par le système IA.

Le lien entre l’affinage de requête et la visibilité dans les AI Overviews est direct et mesurable. Les recherches montrent que plus de 88 % des recherches déclenchant les AI Overviews ont une intention informationnelle, c’est-à-dire que les utilisateurs cherchent à s’informer plutôt qu’à acheter ou à naviguer vers un site précis. Ce sont précisément ces requêtes informationnelles qui font l’objet des affinages les plus poussés, car elles nécessitent souvent une synthèse multi-sources pour une réponse complète. Lorsque votre contenu est aligné avec les sous-requêtes générées par l’IA, votre site a une probabilité bien plus élevée d’être cité comme source.

Les chiffres sont parlants : être cité dans un AI Overview augmente le taux de clic de 0,6 % à 1,08 %, soit un doublement par rapport à une apparition classique dans les résultats sous l’overview. Cela rend l’affinage de requête indispensable à la stratégie SEO moderne. Plutôt que d’optimiser pour un seul mot-clé, les créateurs de contenu doivent penser à la façon dont leur contenu répond aux diverses requêtes affinées que l’IA pourrait générer. Par exemple, si vous écrivez sur la « mode durable », prévoyez que l’IA affinera en sous-requêtes comme « impact environnemental de la fast fashion », « pratiques de fabrication éthiques », « matériaux durables », « certifications équitables », « marques durables abordables ». Votre contenu doit couvrir ces angles pour maximiser la citation.

De plus, les données indiquent que environ 70 % des utilisateurs ne lisent que le premier tiers des AI Overviews, ce qui signifie qu’être cité dès le début vaut bien plus qu’une citation tardive. Les créateurs de contenu doivent donc structurer leurs informations avec les réponses clés et résumées en haut, dans un format clair et facilement citables. L’objectif est de devenir la source que l’IA « doit » citer pour une réponse crédible et complète à ses sous-requêtes affinées.

Un affinage efficace de requête nécessite la maîtrise de plusieurs techniques clés. La première est l’ajout de détails contextuels, où utilisateurs ou systèmes ajoutent du contexte pour rendre la requête plus précise. Au lieu de « chaussures de course », une requête affinée sera « meilleures chaussures de course imperméables pour femme avec voûte plantaire haute à moins de 150 € ». Ce contexte supplémentaire aide les IA à comprendre les contraintes et préférences qui comptent, pour une recherche mieux ciblée. Pour les créateurs de contenu, cela implique d’anticiper ces raffinements contextuels et de concevoir des contenus adaptés à des cas d’usage, publics ou contraintes spécifiques.

La deuxième technique est la spécification de contraintes, où l’utilisateur définit des limites de prix, de géographie, de temporalité, de qualité… Les IA reconnaissent ces contraintes et affinent la recherche en conséquence. Par exemple, une requête sur « meilleur logiciel de gestion de projet pour équipes à distance de moins de 50 personnes » comporte plusieurs contraintes que le contenu doit adresser explicitement pour être cité.

La troisième technique est le questionnement de suivi, où l’utilisateur pose des questions de clarification. Sur des IA conversationnelles comme ChatGPT, il peut demander « Peux-tu l’expliquer plus simplement ? » ou « Comment cela s’applique-t-il aux PME ? ». Ces questions déclenchent un affinage, l’IA adaptant sa réponse selon le feedback. D’où l’importance de la profondeur conversationnelle et de la capacité à traiter plusieurs angles pour la visibilité.

La quatrième technique est la décomposition de la requête, qui segmente une question complexe en sous-questions. C’est crucial pour les IA, qui l’utilisent pour garantir une couverture complète du sujet. Par exemple, pour « meilleures pratiques pour optimiser un site e-commerce pour les moteurs IA », l’IA peut décomposer en : « Qu’est-ce qu’un moteur IA ? », « Comment les IA classent-elles le contenu e-commerce ? », « Quelles optimisations techniques ? », « Comment structurer les fiches produit ? », « Quel rôle du contenu utilisateur ? ». Le contenu qui répond à ces sous-questions sera plus souvent cité lors des affinages.

L’optimisation pour les moteurs génératifs (GEO), ou Large Language Model Optimization (LLMO), consiste essentiellement à comprendre et à optimiser les processus d’affinage de requête. Le SEO traditionnel visait le classement sur des mots-clés précis ; le GEO vise à être cité sur l’ensemble des sous-requêtes affinées générées par les IA. C’est un changement de paradigme pour les créateurs de contenu.

Dans le contexte GEO, l’affinage de requête n’est pas une action subie sur votre contenu : c’est une anticipation à intégrer dès la création. Quand vous produisez un contenu, pensez à toutes les façons dont une IA pourrait affiner ou décomposer votre sujet en sous-requêtes. Pour un article sur la « mode durable », il faut traiter l’impact environnemental de la mode traditionnelle, les matériaux durables, les pratiques éthiques, les certifications, les coûts, les recommandations de marques, et la transition vers la mode durable. Plus vous couvrez ces angles, plus vous serez cité dans les réponses générées par l’IA.

Selon les statistiques 2026 d’Elementor sur le SEO IA, le trafic IA a progressé de 527 % en un an, certains sites atteignant plus de 1 % de leurs sessions via ChatGPT, Perplexity ou Copilot. Cette croissance rapide montre l’importance de l’affinage de requête. Ce trafic IA est aussi bien plus qualitatif : un visiteur référé par l’IA vaut 4,4 fois plus qu’un visiteur organique classique, avec 27 % de taux de rebond en moins et des sessions 38 % plus longues sur les sites retail. Optimiser pour l’affinage, ce n’est donc pas juste pour la visibilité : c’est pour attirer un trafic à fort potentiel de conversion.

L’avenir de l’affinage de requête s’oriente vers des systèmes toujours plus sophistiqués, personnalisés et autonomes. La génération de requêtes synthétiques devient plus avancée, avec des IA capables de créer des requêtes variées et adaptées au contexte, simulant de vrais comportements de recherche. Ces requêtes synthétiques sont essentielles pour entraîner les IA à gérer des recherches inédites ou rares en exploitant des schémas appris et le contexte. Plus les IA progressent, plus elles généreront des sous-requêtes fines et spécifiques, poussant les créateurs à explorer tous les angles de leurs thématiques.

Autre tendance émergente : l’affinage de requête « stateful », où l’IA conserve le contexte sur plusieurs tours de conversation, ce qui permet un affinage sophistiqué selon l’évolution des besoins de l’utilisateur. Au lieu de traiter chaque requête isolément, ces systèmes comprennent les liens avec les interactions précédentes, pour des raffinements vraiment personnalisés. Cela a des conséquences sur la stratégie de contenu : structurez vos contenus pour des conversations multi-tours où l’utilisateur affine progressivement sa compréhension.

L’intégration de l’apprentissage par renforcement dans l’affinage est aussi majeure. Les systèmes apprennent du feedback utilisateur pour améliorer continuellement la qualité des affinages. Si certains contenus sont systématiquement cliqués ou consultés plus longtemps, le système apprend à les privilégier lors des affinages suivants. Cela crée un avantage compétitif pour les créateurs qui fournissent un contenu fiable et de qualité : ils deviennent la « référence » que l’IA apprend à citer.

Enfin, l’essor des agents IA et des systèmes de recherche autonomes laisse présager un affinage encore plus poussé. Les agents généreront et exécuteront eux-mêmes des requêtes affinées pour l’utilisateur, explorant l’information de façon exhaustive pour répondre à des questions complexes. Les créateurs doivent donc rendre leur contenu accessible non seulement aux humains, mais aussi aux IA autonomes qui affineront systématiquement les requêtes sur le web.

Le paysage concurrentiel évolue aussi. Plus les plateformes intègrent l’affinage, plus la capacité à apparaître sur les requêtes affinées devient un facteur différenciateur. Les utilisateurs AmICited qui surveillent leur présence sur les requêtes affinées des différentes IA auront une longueur d’avance sur ceux qui se concentrent uniquement sur les classements classiques. L’avenir appartient aux créateurs et marques qui voient l’affinage de requête comme un pilier de la visibilité et adaptent leur stratégie en conséquence.

L’affinage de requête vise à améliorer la pertinence et la précision des résultats de recherche en ajustant ou en suggérant des requêtes en fonction du contexte utilisateur et des données historiques, dans le but de fournir une information plus précise. L’expansion de requête, en revanche, consiste à générer des requêtes supplémentaires pour améliorer la performance du moteur de recherche en traitant des problèmes comme des requêtes initiales mal formulées ou des résultats non pertinents. Alors que l’affinage améliore une requête existante, l’expansion crée plusieurs requêtes connexes pour élargir le champ de la recherche. Les deux techniques fonctionnent ensemble dans les systèmes de recherche IA modernes pour améliorer la qualité de la récupération d’informations.

Les moteurs de recherche IA utilisent l’affinage de requête via un processus appelé fan-out de requête, où une seule requête utilisateur est décomposée en plusieurs sous-requêtes exécutées simultanément sur diverses sources de données. Par exemple, une question complexe sur « meilleures chaussures de course imperméables pour pieds plats » peut être divisée en sous-requêtes explorant les listes de produits, les avis d’experts, les expériences utilisateurs et les spécifications techniques. Cette extraction parallèle d’informations depuis différentes sources élargit considérablement le réservoir d’informations disponible pour la synthèse de réponses, permettant à l’IA de fournir des réponses plus complètes et précises.

Le traitement du langage naturel est fondamental pour l’affinage de requête car il permet aux systèmes IA d’interpréter le sens au-delà d’une simple correspondance de mots-clés. Le NLP utilise des schémas et relations contextuelles entre les mots pour décoder la façon dont les humains s’expriment, rendant les recherches plus intuitives et précises. Par exemple, le NLP permet au système de comprendre que « cafés ouverts » signifie des établissements actuellement en activité et situés à proximité, et non simplement des documents contenant ces mots exacts. Cette compréhension contextuelle permet aux systèmes IA modernes d’affiner intelligemment les requêtes et de fournir des résultats correspondant à l’intention de l’utilisateur et non juste à la correspondance littérale des mots-clés.

L’affinage de requête améliore la visibilité dans les AI Overviews en aidant les créateurs de contenu à comprendre comment les utilisateurs modifient leurs recherches pour obtenir de meilleurs résultats. En ciblant à la fois les requêtes initiales et affinées avec un contenu complet qui anticipe les besoins et les questions de suivi des utilisateurs, les sites web peuvent augmenter leurs chances d’être cités comme sources. Les recherches montrent qu’être référencé comme source dans un AI Overview augmente le taux de clics de 0,6 % à 1,08 %, ce qui rend la compréhension de l’affinage de requête essentielle pour la stratégie SEO moderne et pour la visibilité des citations IA.

Les requêtes synthétiques sont des requêtes générées artificiellement par des modèles de langage afin de simuler les recherches réelles des utilisateurs. Elles sont cruciales pour l’affinage de requête car elles élargissent les jeux de données annotés, améliorent le rappel et permettent à la recherche générative de s’adapter à de grands ensembles de données en comblant les lacunes. Les requêtes synthétiques sont générées par l’extraction de données structurées, l’analyse de titres de documents et de textes d’ancrage, ainsi qu’à l’aide de règles structurées. Elles aident les systèmes IA à comprendre et affiner les requêtes en fournissant des exemples variés de la façon dont les utilisateurs pourraient formuler des besoins similaires, ce qui améliore la capacité du système à affiner et élargir efficacement les requêtes des utilisateurs.

Les entreprises peuvent optimiser pour l’affinage de requête en analysant les données de la Google Search Console pour identifier les mots-clés connexes et les variations de requêtes recherchées séquentiellement par les utilisateurs. Elles doivent créer un contenu complet qui couvre à la fois les requêtes larges initiales et les variantes affinées et spécifiques. En utilisant des outils comme seoClarity ou des plateformes similaires, les entreprises peuvent analyser les affinages de requêtes et les données d’autosuggestion afin de trouver des variations pertinentes pour la recherche de mots-clés. De plus, surveiller le classement par affinage de requête et suivre la performance des différentes pages à facettes aide à orienter les décisions stratégiques et techniques sur le contenu.

L’affinage de requête est étroitement lié à l’intention utilisateur car il révèle comment les besoins d’information évoluent tout au long du parcours de recherche. En analysant les schémas d’affinage de requête, les entreprises peuvent comprendre ce que recherchent réellement les utilisateurs à chaque étape de leur processus décisionnel. Par exemple, un utilisateur peut commencer avec une intention large (« chaussures de course ») et affiner progressivement vers une intention plus spécifique (« meilleures chaussures de course imperméables pour pieds plats »). Comprendre ces schémas d’affinage permet aux créateurs de contenu de développer des contenus ciblés pour chaque étape du parcours utilisateur, ce qui améliore la visibilité et les taux de conversion.

Commencez à suivre comment les chatbots IA mentionnent votre marque sur ChatGPT, Perplexity et d'autres plateformes. Obtenez des informations exploitables pour améliorer votre présence IA.

Découvrez comment la reformulation de requête aide les systèmes d’IA à interpréter et enrichir les requêtes utilisateur pour une meilleure recherche d’informati...

Découvrez comment l'optimisation de l'expansion de requête améliore les résultats de recherche IA en comblant les écarts de vocabulaire. Découvrez les technique...

Découvrez comment l’anticipation de requête aide votre contenu à capter les conversations IA étendues en répondant aux questions de suivi. Découvrez des stratég...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.