Comment configurer robots.txt pour les crawlers IA : guide complet

Découvrez comment configurer robots.txt pour contrôler l'accès des crawlers IA, y compris GPTBot, ClaudeBot et Perplexity. Gérez la visibilité de votre marque d...

Un fichier robots.txt est un fichier texte brut placé dans le répertoire racine d’un site web qui communique des instructions aux robots d’indexation et aux bots des moteurs de recherche sur les URL qu’ils peuvent ou ne peuvent pas accéder. Il sert d’élément fondamental du protocole d’exclusion des robots, aidant les propriétaires de sites à gérer le trafic des robots, optimiser le budget de crawl et protéger le contenu sensible de l’indexation.

Un fichier robots.txt est un fichier texte brut placé dans le répertoire racine d’un site web qui communique des instructions aux robots d’indexation et aux bots des moteurs de recherche sur les URL qu’ils peuvent ou ne peuvent pas accéder. Il sert d’élément fondamental du protocole d’exclusion des robots, aidant les propriétaires de sites à gérer le trafic des robots, optimiser le budget de crawl et protéger le contenu sensible de l’indexation.

Robots.txt est un fichier texte brut placé dans le répertoire racine d’un site web (par exemple, www.example.com/robots.txt ) qui communique des instructions aux robots d’indexation et aux bots des moteurs de recherche sur les URL qu’ils peuvent ou ne peuvent pas accéder. Ce fichier constitue un élément fondamental du protocole d’exclusion des robots, une norme qui aide à gérer l’activité des robots sur les sites web. En spécifiant des directives comme “allow” et “disallow”, les propriétaires de sites peuvent contrôler la façon dont les moteurs de recherche et autres robots interagissent avec leur contenu. Selon Google Search Central, un fichier robots.txt indique aux robots d’indexation des moteurs de recherche quelles URL ils peuvent explorer sur votre site, principalement pour éviter de surcharger votre site avec des requêtes et optimiser l’allocation du budget de crawl.

L’importance de robots.txt va au-delà du simple contrôle d’accès. Il représente un mécanisme de communication clé entre les propriétaires de sites et les systèmes automatisés qui indexent et analysent le contenu web. Le fichier doit être nommé exactement “robots.txt” et placé à la racine pour être reconnu par les robots d’indexation. Sans une configuration correcte de robots.txt, les moteurs de recherche peuvent gaspiller un budget de crawl précieux sur des pages dupliquées, du contenu temporaire ou des ressources non essentielles, réduisant ainsi l’efficacité d’indexation des pages importantes. Cela fait de robots.txt un composant essentiel de la stratégie SEO technique et de la gestion de site web.

Le protocole d’exclusion des robots a été proposé pour la première fois en 1994 comme une norme volontaire permettant aux robots d’indexation de respecter les préférences des propriétaires de sites. La spécification originale était simple mais efficace, permettant aux webmasters de communiquer des règles d’accès basiques sans systèmes d’authentification complexes. Au fil des décennies, robots.txt a évolué pour s’adapter à de nouveaux types de robots, notamment les robots des moteurs de recherche, les robots des réseaux sociaux, et plus récemment, les robots de collecte pour l’entraînement des IA utilisés par des entreprises comme OpenAI, Anthropic et Perplexity. Le protocole est resté largement rétrocompatible, garantissant que les sites créés il y a des décennies puissent encore fonctionner avec les robots modernes.

L’adoption de robots.txt s’est énormément développée au fil du temps. Selon le Web Almanac 2024, des requêtes réussies pour des fichiers robots.txt ont été faites sur 83,9 % des sites web en version mobile et 83,5 % sur desktop, contre 82,4 % et 81,5 % en 2022. Cette tendance à la hausse reflète une prise de conscience croissante de l’importance de la gestion du trafic des robots. Une étude sur des sites de désinformation indique un taux d’adoption de 96,4 %, suggérant que robots.txt est désormais une pratique standard dans des catégories de sites très variées. L’évolution de robots.txt se poursuit aujourd’hui alors que les propriétaires de sites doivent relever de nouveaux défis, comme le blocage des bots IA qui peuvent ne pas respecter les directives traditionnelles de robots.txt ou utiliser des robots non déclarés pour contourner les restrictions.

Lorsqu’un robot d’indexation visite un site web, il vérifie d’abord la présence du fichier robots.txt dans le répertoire racine avant de parcourir les autres pages. Le robot lit le fichier et interprète les directives pour déterminer les URL auxquelles il peut accéder. Ce processus se fait via une requête HTTP vers le domaine racine, et le serveur répond avec le contenu du fichier robots.txt. Le robot analyse alors le fichier selon sa propre implémentation du protocole d’exclusion des robots, ce qui peut varier légèrement d’un moteur de recherche ou d’un type de bot à l’autre. Cette vérification initiale garantit que les robots respectent les préférences du propriétaire du site avant de consommer les ressources du serveur.

La directive user-agent est essentielle pour cibler des robots spécifiques. Chaque robot possède un identifiant unique (chaîne user-agent) tel que “Googlebot” pour le robot de Google, “Bingbot” pour celui de Microsoft, ou “GPTbot” pour celui d’OpenAI. Les propriétaires de sites peuvent créer des règles pour des user-agents spécifiques ou utiliser le joker “*” pour appliquer les règles à tous les robots. La directive disallow précise les URL ou motifs d’URL auxquels le robot ne peut pas accéder, tandis que la directive allow peut annuler les règles de disallow pour des pages précises. Ce système hiérarchique permet un contrôle granulaire du comportement des robots, offrant la possibilité aux propriétaires de sites de créer des modèles d’accès complexes pour optimiser à la fois les ressources serveur et la visibilité sur les moteurs de recherche.

| Aspect | Robots.txt | Balise Meta Robots | En-tête X-Robots-Tag | Protection par mot de passe |

|---|---|---|---|---|

| Portée | Site entier ou niveau répertoire | Niveau page individuelle | Niveau page ou ressource individuelle | Contrôle d’accès au niveau serveur |

| Mise en œuvre | Fichier texte dans le répertoire racine | Balise meta HTML dans l’en-tête de la page | En-tête de réponse HTTP | Authentification serveur |

| Objectif principal | Gérer le trafic de crawl et le budget | Contrôler l’indexation et le crawl | Contrôler l’indexation et le crawl | Empêcher tout accès |

| Force exécutoire | Volontaire (non contraignant légalement) | Volontaire (non contraignant légalement) | Volontaire (non contraignant légalement) | Appliqué par le serveur |

| Respect des bots IA | Variable (certains bots l’ignorent) | Variable (certains bots l’ignorent) | Variable (certains bots l’ignorent) | Très efficace |

| Impact sur les résultats de recherche | La page peut apparaître sans description | Page exclue des résultats | Page exclue des résultats | Page totalement masquée |

| Cas d’utilisation idéal | Optimiser le budget de crawl, gérer la charge serveur | Empêcher l’indexation de pages précises | Empêcher l’indexation de ressources | Protéger les données sensibles |

| Facilité de mise en œuvre | Facile (fichier texte) | Facile (balise HTML) | Moyenne (nécessite configuration serveur) | Moyenne à complexe |

Un fichier robots.txt utilise une syntaxe simple que les propriétaires de sites peuvent créer et éditer avec n’importe quel éditeur de texte. La structure de base consiste en une ligne user-agent suivie d’une ou plusieurs lignes de directives. Les directives les plus courantes sont disallow (qui empêche les robots d’accéder à certaines URL), allow (qui autorise l’accès à des URL spécifiques même si une règle disallow plus large existe), crawl-delay (qui indique combien de temps un robot doit attendre entre les requêtes), et sitemap (qui indique aux robots l’emplacement du sitemap XML). Chaque directive doit être sur une ligne distincte, et le fichier doit être correctement formaté pour être reconnu par les robots.

Par exemple, un fichier robots.txt basique pourrait ressembler à ceci :

User-agent: *

Disallow: /admin/

Disallow: /private/

Allow: /private/public-page.html

Sitemap: https://www.example.com/sitemap.xml

Cette configuration indique à tous les robots d’éviter les répertoires /admin/ et /private/, mais d’autoriser l’accès à la page spécifique /private/public-page.html. La directive sitemap oriente les robots vers le sitemap XML pour une indexation efficace. Les propriétaires de sites peuvent créer plusieurs blocs user-agent pour appliquer différentes règles à différents robots. Par exemple, un site peut autoriser Googlebot à explorer tout le contenu mais restreindre l’accès à certains dossiers pour d’autres robots. La directive crawl-delay peut ralentir les robots agressifs, bien que Googlebot de Google n’en tienne pas compte et préfère les paramètres de vitesse de crawl dans Google Search Console.

Le budget de crawl fait référence au nombre d’URL qu’un moteur de recherche va explorer sur un site dans une période donnée. Pour les grands sites comptant des millions de pages, le budget de crawl est une ressource limitée à gérer stratégiquement. Robots.txt joue un rôle crucial dans l’optimisation du budget de crawl en empêchant les robots de gaspiller des ressources sur du contenu à faible valeur comme les pages dupliquées, les fichiers temporaires ou les ressources non essentielles. En utilisant robots.txt pour bloquer les URL inutiles, les propriétaires de sites s’assurent que les moteurs de recherche concentrent leur budget de crawl sur les pages importantes à indexer et à classer. Cela est particulièrement important pour les sites e-commerce, les publications d’actualités et les sites à grande échelle où le budget de crawl impacte directement la visibilité sur les moteurs de recherche.

Les recommandations officielles de Google soulignent que robots.txt doit servir à gérer le trafic des robots et éviter de surcharger votre site de requêtes. Pour les grands sites, Google propose des recommandations spécifiques pour gérer le budget de crawl, notamment l’utilisation de robots.txt pour bloquer le contenu dupliqué, les paramètres de pagination et les fichiers de ressources qui n’impactent pas significativement le rendu des pages. Les propriétaires de sites doivent éviter de bloquer les fichiers CSS, JavaScript ou images essentiels au rendu des pages, car cela peut empêcher Google de bien comprendre le contenu. L’utilisation stratégique de robots.txt, associée à d’autres pratiques SEO techniques comme les sitemaps XML et le maillage interne, crée un environnement de crawl efficace qui maximise la valeur du budget de crawl disponible.

Bien que robots.txt soit un outil précieux pour gérer le comportement des robots, il présente des limites importantes à connaître. Premièrement, robots.txt n’a pas de valeur légale et fonctionne sur un protocole volontaire. Si les principaux moteurs de recherche comme Google, Bing et Yahoo respectent les directives de robots.txt, les bots malveillants et les scrapers peuvent choisir de l’ignorer complètement. Cela signifie que robots.txt ne doit pas servir de mécanisme de sécurité pour protéger des informations sensibles. Deuxièmement, différents robots interprètent la syntaxe de robots.txt différemment, ce qui peut entraîner un comportement incohérent selon les plateformes. Certains robots peuvent ne pas comprendre certaines directives avancées ou interpréter les motifs d’URL différemment de ce qui est prévu.

Troisièmement, point crucial pour la gestion web moderne, une page interdite dans robots.txt peut quand même être indexée si elle est liée depuis d’autres sites. Selon la documentation de Google, si des pages externes font un lien vers votre URL interdite avec un texte d’ancre descriptif, Google peut tout de même indexer cette URL et l’afficher dans les résultats sans description. Cela signifie que robots.txt ne peut pas à lui seul empêcher l’indexation ; il ne fait qu’empêcher le crawl. Pour empêcher correctement l’indexation, il faut utiliser d’autres méthodes comme la balise meta noindex, les en-têtes HTTP ou la protection par mot de passe. De plus, des recherches récentes ont montré que certains robots IA contournent délibérément les restrictions de robots.txt en utilisant des chaînes user-agent non déclarées, rendant robots.txt inefficace contre certains robots d’entraînement IA.

L’essor des grands modèles de langage et des moteurs de recherche alimentés par l’IA a généré de nouveaux défis pour la gestion de robots.txt. Des entreprises comme OpenAI (GPTbot), Anthropic (Claude) et Perplexity ont déployé des robots pour entraîner leurs modèles et alimenter leurs fonctionnalités de recherche. Beaucoup de propriétaires de sites ont commencé à bloquer ces bots IA via des directives robots.txt. D’après une étude du Senior Search Scientist de Moz, GPTbot est le bot le plus souvent bloqué, de nombreux médias et créateurs de contenu ajoutant des règles de disallow spécifiques à ces robots d’entraînement IA. Toutefois, l’efficacité de robots.txt pour bloquer les bots IA est discutable, certaines entreprises ayant été prises à utiliser des robots non déclarés qui ne s’identifient pas correctement.

Cloudflare a signalé que Perplexity utilisait des robots furtifs et non déclarés pour contourner les directives d’interdiction de crawl, montrant que tous les bots IA ne respectent pas les règles de robots.txt. Cela a déclenché des discussions continues dans les communautés SEO et développement web sur la suffisance de robots.txt pour contrôler l’accès des bots IA. Certains propriétaires de sites ont mis en place des mesures supplémentaires comme des règles WAF (pare-feu applicatif) pour bloquer certaines adresses IP ou chaînes user-agent. La situation souligne l’importance de surveiller la présence de votre site dans les résultats de recherche IA et de comprendre quels bots accèdent effectivement à votre contenu. Pour les sites préoccupés par l’utilisation de leurs données pour l’entraînement IA, robots.txt doit être combiné à d’autres mesures techniques et éventuellement à des accords légaux avec les entreprises d’IA.

Créer un fichier robots.txt efficace demande une planification minutieuse et une maintenance régulière. Premièrement, placez le fichier robots.txt dans le répertoire racine de votre site (par exemple www.example.com/robots.txt ) et assurez-vous qu’il soit nommé exactement “robots.txt” avec un encodage UTF-8 correct. Deuxièmement, utilisez des règles de disallow claires et spécifiques ciblant uniquement le contenu à bloquer, en évitant des règles trop restrictives qui pourraient empêcher l’indexation de pages importantes. Troisièmement, incluez une directive sitemap pointant vers votre sitemap XML pour aider les robots à découvrir et prioriser les pages importantes. Quatrièmement, testez votre fichier robots.txt avec des outils comme l’outil de test de robots de Google ou la fonctionnalité Site Crawl de Moz Pro pour vérifier que vos règles fonctionnent comme prévu.

Les propriétaires de sites doivent régulièrement revoir et mettre à jour leurs fichiers robots.txt à mesure que la structure du site évolue. Les erreurs fréquentes incluent :

Une surveillance régulière via les logs serveur, Google Search Console et des outils SEO permet d’identifier rapidement les problèmes. Si vous constatez que des pages importantes ne sont pas crawlées ou indexées, vérifiez d’abord votre fichier robots.txt pour vous assurer qu’il ne les bloque pas par erreur. Pour les CMS comme WordPress ou Wix, beaucoup proposent des interfaces intégrées pour gérer robots.txt sans nécessiter d’édition directe du fichier, simplifiant ainsi la gestion pour les utilisateurs non techniques.

L’avenir de robots.txt fait face à la fois à des défis et à des opportunités à mesure que le web évolue. L’apparition des bots IA et robots d’entraînement a suscité des discussions sur la suffisance de la norme actuelle de robots.txt pour les besoins modernes. Certains experts du secteur ont proposé des améliorations du protocole d’exclusion des robots pour mieux traiter les problématiques propres à l’IA, comme la distinction entre les robots utilisés pour l’indexation de recherche et ceux pour la collecte de données d’entraînement. Les recherches continues du Web Almanac montrent que l’adoption de robots.txt continue de croître, davantage de sites reconnaissant son importance pour la gestion du trafic des robots et l’optimisation des ressources serveur.

Une autre tendance émergente est l’intégration de la gestion de robots.txt dans des plateformes plus larges de suivi SEO et des outils de suivi IA. À mesure que des entreprises comme AmICited suivent les apparitions de marques et de domaines sur les moteurs de recherche IA, comprendre robots.txt devient de plus en plus crucial pour contrôler la façon dont le contenu apparaît dans les réponses générées par l’IA. Les propriétaires de sites devront peut-être mettre en place des stratégies robots.txt plus sophistiquées, tenant compte de multiples types de robots avec des objectifs et des niveaux de respect différents. Une possible standardisation de l’identification et du comportement des robots IA pourrait aboutir à des implémentations robots.txt plus efficaces à l’avenir. Par ailleurs, à mesure que les préoccupations liées à la vie privée et à la propriété des contenus prennent de l’importance, robots.txt pourrait évoluer pour inclure des contrôles plus granulaires sur l’utilisation des contenus par différents types de robots et systèmes IA.

Pour les organisations utilisant AmICited afin de surveiller l’apparition de leur marque et de leur domaine sur les moteurs de recherche IA, comprendre robots.txt est essentiel. Votre configuration robots.txt impacte directement les robots IA qui peuvent accéder à votre contenu et la manière dont il apparaît dans les réponses générées par l’IA sur des plateformes comme ChatGPT, Perplexity, Google AI Overviews et Claude. Si vous bloquez certains bots IA via robots.txt, vous pouvez réduire votre visibilité dans leurs résultats de recherche, ce qui peut être un choix stratégique selon votre contenu et vos objectifs business. Cependant, comme mentionné plus haut, certains bots IA peuvent ne pas respecter les directives robots.txt ; il est donc crucial de surveiller votre apparition réelle dans les réponses IA.

Les capacités de suivi d’AmICited vous aident à comprendre l’impact réel de votre configuration robots.txt sur la visibilité dans la recherche IA. En surveillant où vos URL apparaissent dans les réponses générées par l’IA, vous pouvez évaluer si votre stratégie de gestion des robots atteint les résultats souhaités. Si vous souhaitez augmenter votre visibilité sur certains moteurs de recherche IA, il peut être nécessaire d’ajuster votre robots.txt pour autoriser leurs robots. À l’inverse, si vous souhaitez limiter l’utilisation de votre contenu pour l’entraînement ou les réponses IA, vous pouvez mettre en place des règles robots.txt plus restrictives, mais il est conseillé de combiner cela à d’autres mesures techniques pour une meilleure efficacité. L’intersection entre la gestion de robots.txt et la surveillance de la recherche IA représente un nouveau terrain pour le marketing digital et la stratégie SEO.

L’objectif principal d’un fichier robots.txt est de gérer le trafic des robots et de communiquer avec les bots des moteurs de recherche sur les parties du site auxquelles ils peuvent accéder. Selon Google Search Central, robots.txt est principalement utilisé pour éviter de surcharger votre site avec des requêtes et pour gérer l’allocation du budget de crawl. Il aide les propriétaires de sites à diriger les robots vers le contenu de valeur tout en évitant les pages dupliquées ou non pertinentes, optimisant ainsi les ressources du serveur et améliorant l’efficacité du SEO.

Non, robots.txt ne peut pas empêcher de façon fiable l’apparition de pages dans les résultats de recherche Google. Selon la documentation officielle de Google, si d’autres pages font un lien vers la vôtre avec un texte descriptif, Google peut tout de même indexer l’URL sans visiter la page. Pour empêcher correctement l’indexation, utilisez des méthodes alternatives comme la protection par mot de passe, la balise meta noindex ou les en-têtes HTTP. Une page bloquée par robots.txt peut toujours apparaître dans les résultats de recherche sans description.

Robots.txt est un fichier à l’échelle du site qui contrôle l’accès des robots à des répertoires entiers ou à l’ensemble du site, tandis que les balises meta robots sont des directives HTML appliquées à des pages individuelles. Robots.txt gère le comportement de crawl, tandis que les balises meta robots (comme noindex) contrôlent l’indexation. Les deux ont des objectifs différents : robots.txt empêche le crawl pour économiser les ressources du serveur, tandis que les balises meta robots empêchent l’indexation même si la page est crawlée.

Vous pouvez bloquer les bots IA en ajoutant leurs noms d’agent utilisateur spécifiques à votre fichier robots.txt avec des directives disallow. Par exemple, ajouter 'User-agent : GPTbot' suivi de 'Disallow : /' bloque le robot d’OpenAI pour qu’il ne crawl pas votre site. Des études montrent que GPTbot est le bot le plus bloqué par les sites web. Cependant, tous les bots IA ne respectent pas les directives robots.txt, et certains peuvent utiliser des robots non déclarés pour contourner les restrictions ; robots.txt seul ne garantit donc pas une protection totale.

Les cinq directives standard dans robots.txt sont : User-agent (indique à quels robots la règle s’applique), Disallow (empêche les robots d’accéder à certains fichiers ou dossiers), Allow (annule les règles de disallow pour des pages spécifiques), Crawl-delay (introduit un délai entre les requêtes), et Sitemap (indique aux robots l’adresse du sitemap). Chaque directive a une fonction spécifique pour contrôler le comportement des robots et optimiser l’efficacité du crawl.

Non, robots.txt n’a pas de valeur légale. Il fonctionne comme un protocole volontaire basé sur la norme d’exclusion des robots. Bien que la plupart des robots bienveillants comme Googlebot et Bingbot respectent les directives robots.txt, les robots malveillants et les scrapers peuvent choisir de les ignorer complètement. Pour des informations sensibles devant être protégées, utilisez des mesures de sécurité plus fortes comme la protection par mot de passe ou des contrôles d’accès au niveau du serveur plutôt que de compter uniquement sur robots.txt.

Selon le Web Almanac 2024, des requêtes réussies pour des fichiers robots.txt ont été faites sur 83,9 % des sites web en version mobile et 83,5 % en version desktop, contre 82,4 % et 81,5 % en 2022. Une étude sur des sites de désinformation indique un taux d’adoption de 96,4 %, ce qui montre que robots.txt est une norme largement appliquée sur le web. Cela démontre l’importance cruciale de robots.txt dans la gestion web moderne.

Commencez à suivre comment les chatbots IA mentionnent votre marque sur ChatGPT, Perplexity et d'autres plateformes. Obtenez des informations exploitables pour améliorer votre présence IA.

Découvrez comment configurer robots.txt pour contrôler l'accès des crawlers IA, y compris GPTBot, ClaudeBot et Perplexity. Gérez la visibilité de votre marque d...

Découvrez comment configurer robots.txt pour les crawlers IA, y compris GPTBot, ClaudeBot et PerplexityBot. Comprenez les catégories de crawlers IA, les stratég...

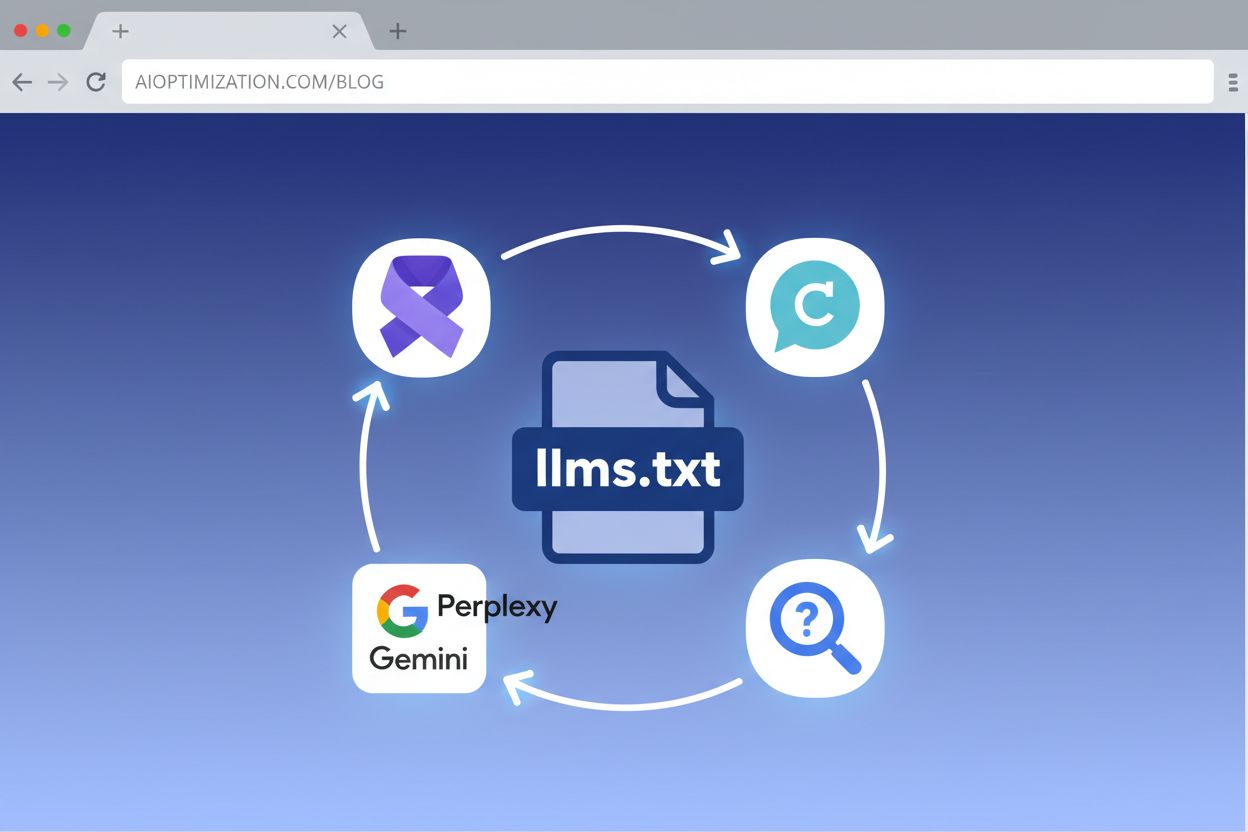

Découvrez comment implémenter LLMs.txt sur votre site web pour aider les systèmes d’IA à mieux comprendre votre contenu. Guide complet étape par étape pour tout...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.