Quality Rater Guidelines

Découvrez les Quality Rater Guidelines de Google, le cadre d'évaluation utilisé par plus de 16 000 évaluateurs pour juger la qualité des recherches, les signaux...

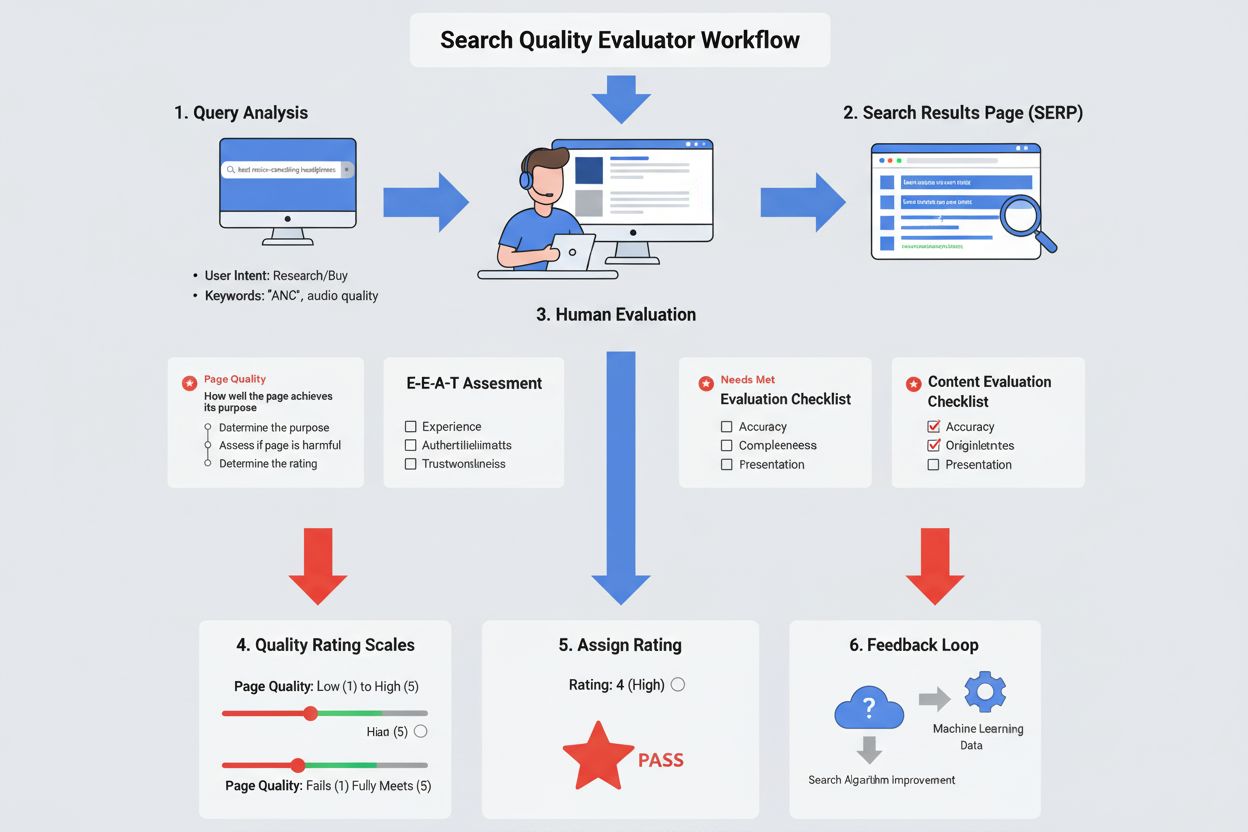

Un Évaluateur de la qualité de la recherche est un examinateur humain employé par Google (généralement via des sous-traitants tiers) qui évalue la qualité et la pertinence des résultats de recherche selon des directives établies. Ces évaluateurs notent les résultats de recherche selon des critères incluant E-E-A-T (Expérience, Expertise, Autorité, Fiabilité), la qualité du contenu et la satisfaction de l’intention de l’utilisateur, afin d’aider Google à mesurer et à améliorer la performance de son algorithme de recherche.

Un Évaluateur de la qualité de la recherche est un examinateur humain employé par Google (généralement via des sous-traitants tiers) qui évalue la qualité et la pertinence des résultats de recherche selon des directives établies. Ces évaluateurs notent les résultats de recherche selon des critères incluant E-E-A-T (Expérience, Expertise, Autorité, Fiabilité), la qualité du contenu et la satisfaction de l’intention de l’utilisateur, afin d’aider Google à mesurer et à améliorer la performance de son algorithme de recherche.

Un Évaluateur de la qualité de la recherche est un examinateur humain employé par Google (généralement via des sociétés de sous-traitance tierces) qui évalue systématiquement la qualité, la pertinence et l’utilité des résultats de recherche. Ces évaluateurs, au nombre d’environ 16 000 dans le monde, appliquent des directives standardisées pour noter les résultats de recherche sur plusieurs dimensions, dont la qualité du contenu, la satisfaction de l’intention de l’utilisateur et le respect des principes E-E-A-T (Expérience, Expertise, Autorité et Fiabilité). Leur fonction principale n’est pas de déterminer directement les classements, mais de fournir un retour humain qui aide Google à mesurer l’efficacité de ses algorithmes de recherche pour délivrer des informations utiles, fiables et autoritaires aux utilisateurs dans différentes régions et langues. Les Évaluateurs de la qualité de la recherche représentent un pont essentiel entre le jugement humain et l’apprentissage automatique, garantissant que les systèmes automatisés de Google répondent aux véritables besoins et attentes des utilisateurs.

Google a lancé son programme d’évaluation de la qualité de la recherche en 2005, initialement avec une petite équipe d’évaluateurs. En près de vingt ans, le programme est devenu un mécanisme sophistiqué d’assurance qualité impliquant des milliers de réviseurs humains. En août 2022, Google a officiellement reconnu l’existence et la portée de ce programme en publiant le premier document public complet expliquant qui sont ces évaluateurs et comment ils travaillent. Cette transparence a marqué un tournant, car le programme fonctionnait auparavant dans une grande discrétion. Le programme a continuellement élargi et affiné ses directives, avec d’importantes mises à jour en novembre 2023 et janvier 2025, reflétant l’évolution des priorités de Google concernant la qualité du contenu, le contenu généré par l’IA, la détection du spam et la satisfaction des utilisateurs. Selon les déclarations officielles de Google, la société a mené plus de 719 326 tests de qualité de recherche en 2023 seulement, démontrant l’ampleur et l’importance de ce processus d’évaluation dans le maintien des standards de qualité de la recherche.

Les Évaluateurs de la qualité de la recherche réalisent une grande variété de tâches d’évaluation qui informent directement la compréhension de Google de la qualité de recherche. Leurs responsabilités principales incluent l’évaluation de la qualité des pages en déterminant si les pages remplissent leur objectif déclaré, l’évaluation des besoins satisfaits en déterminant dans quelle mesure les résultats de recherche répondent à l’intention de l’utilisateur, et la réalisation d’expériences comparatives où ils comparent deux versions différentes de résultats de recherche pour indiquer laquelle fonctionne le mieux. Les évaluateurs examinent de nombreux aspects de chaque page, notamment la qualité du contenu principal, la réputation des sites web et des créateurs de contenu, la présence et la visibilité des publicités, ainsi que l’expérience utilisateur globale. Ils mènent également des recherches sur la réputation des sites et des auteurs via des avis indépendants, des articles de presse et des opinions d’experts. De plus, les évaluateurs identifient et signalent les contenus problématiques tels que le spam, les informations nuisibles, les pratiques trompeuses et le contenu généré par IA avec un effort minimal. Chaque tâche d’évaluation exige une analyse attentive de la requête, une compréhension de l’intention de l’utilisateur, une vérification de l’exactitude du contenu et un jugement sur la capacité du résultat à répondre véritablement aux besoins de l’utilisateur.

| Aspect | Évaluateur de la qualité de la recherche | Professionnel SEO | Modérateur de contenu | Ingénieur algorithmique |

|---|---|---|---|---|

| Fonction principale | Évaluer la qualité des résultats de recherche et la satisfaction utilisateur | Optimiser la visibilité d’un site dans les résultats de recherche | Examiner le contenu pour les violations des politiques | Concevoir et améliorer les algorithmes de classement |

| Type d’emploi | Sous-traitant tiers (temporaire/court terme) | Propriétaire du site ou employé d’agence | Employé de la plateforme (temps plein) | Employé Google (temps plein) |

| Autorité de décision | Fournit des évaluations et des retours ; aucun contrôle direct sur le classement | Influence le classement via l’optimisation | Supprime ou signale le contenu en infraction | Contrôle les facteurs de classement algorithmiques |

| Portée du travail | Évalue des requêtes et résultats échantillonnés | Optimise des sites/pages spécifiques | Surveille le contenu généré par les utilisateurs | Développe des améliorations à l’échelle du système |

| Impact sur le classement | Indirect (le retour global améliore les algorithmes) | Direct (l’optimisation affecte la visibilité) | Indirect (supprime le contenu nuisible) | Direct (les algorithmes déterminent le classement) |

| Principaux indicateurs | Notes Qualité de la page, Besoins satisfaits, E-E-A-T | Classements de mots-clés, trafic organique | Violations de contenu, signalements utilisateurs | Performance algorithmique, scores de pertinence |

| Exigences de formation | Test sur les directives, expertise locale | Connaissance SEO, expérience du secteur | Formation aux politiques, directives de contenu | Informatique, apprentissage automatique |

| Charge de travail typique | 50 à 100+ évaluations par jour | Projets d’optimisation continus | Revue de contenu en continu | Cycles de développement algorithmique |

Le cadre E-E-A-T constitue la pierre angulaire de la façon dont les Évaluateurs de la qualité de la recherche évaluent la crédibilité et la qualité du contenu. L’Expérience fait référence à l’expérience vécue ou de première main du créateur de contenu—par exemple, un avis produit rédigé par quelqu’un l’ayant effectivement utilisé a plus de poids qu’une spéculation. L’Expertise englobe les connaissances, compétences et formations pertinentes pour le sujet ; les conseils médicaux devraient provenir de professionnels de santé, et les conseils financiers de spécialistes certifiés. L’Autorité évalue si le créateur ou le site web est reconnu comme référence sur le sujet—les sites officiels du gouvernement sont autoritaires pour les informations gouvernementales, et les médias établis le sont pour le journalisme. La Fiabilité est sans doute la dimension la plus critique, évaluant si la page est exacte, honnête, sûre et digne de confiance. Il est important de noter que la Fiabilité est le membre le plus important de la famille E-E-A-T, car une page peu fiable a un faible E-E-A-T, même si elle semble expérimentée, experte ou autoritaire. Pour les sujets YMYL (Your Money or Your Life) tels que la santé, la finance, le droit et l’information civique, les évaluateurs appliquent des standards E-E-A-T nettement plus élevés, car des informations inexactes pourraient nuire directement à la santé, à la sécurité financière ou à la sécurité des utilisateurs.

Les Évaluateurs de la qualité de la recherche utilisent une échelle de notation de la Qualité de la page à cinq niveaux allant de la plus basse à la plus élevée, avec des notes intermédiaires : Basse, Moyenne et Haute. La note la plus basse est attribuée aux pages ayant des objectifs nuisibles, du contenu trompeur, des informations peu fiables ou des caractéristiques de spam. Les pages obtiennent une note basse lorsqu’elles manquent d’E-E-A-T, comportent du contenu de faible qualité, des titres trompeurs ou des publicités envahissantes. Les pages de qualité moyenne remplissent leur objectif de façon adéquate mais manquent de caractéristiques distinctives justifiant une note supérieure—ce sont la majorité des pages sur Internet. Les pages de haute qualité font preuve d’effort, d’originalité, de talent ou de compétence, jouissent d’une bonne réputation et présentent un E-E-A-T élevé adapté à leur sujet. Les pages de la plus haute qualité incarnent un contenu exceptionnel avec un E-E-A-T très élevé, une excellente réputation et une originalité remarquable. Le processus d’évaluation exige des évaluateurs qu’ils comprennent d’abord l’objectif de la page, puis qu’ils déterminent si cet objectif est nuisible ou trompeur, et enfin qu’ils attribuent une note selon la capacité de la page à remplir son objectif tout en respectant les standards de qualité. Ce processus en trois étapes garantit une évaluation cohérente et méthodique à travers des milliers d’évaluateurs dans le monde.

Au-delà de l’évaluation de la qualité de la page, les Évaluateurs de la qualité de la recherche notent aussi dans quelle mesure les résultats de recherche répondent à l’intention de l’utilisateur via l’échelle de notation Besoins satisfaits (NM). Cette échelle comprend cinq notes principales : Satisfait pleinement (FullyM) pour les résultats qui répondent entièrement à des requêtes spécifiques et sans ambiguïté (généralement des requêtes de navigation comme la recherche d’un site précis) ; Satisfait hautement (HM) pour des résultats très utiles qui répondent à l’intention principale ou raisonnable de l’utilisateur ; Satisfait modérément (MM) pour des résultats utiles mais moins satisfaisants que les meilleurs ; Satisfait légèrement (SM) pour des résultats apportant une aide minimale ou répondant à des interprétations improbables ; et Ne satisfait pas (FailsM) pour des résultats qui ne répondent pas du tout aux besoins de l’utilisateur ou sont hors sujet. Les évaluateurs doivent d’abord déterminer l’intention de l’utilisateur en analysant la requête, en tenant compte de la localisation le cas échéant, et en identifiant les interprétations possibles. Ils évaluent ensuite si le résultat satisfait réellement cette intention, selon des critères comme la fraîcheur (actualité de l’information), exactitude (véracité des affirmations) et pertinence (adéquation directe avec la requête). Ce double système de notation—croisant l’évaluation de la qualité de la page et celle des besoins satisfaits—fournit à Google un retour complet sur la qualité intrinsèque des pages et leur utilité pratique pour des requêtes spécifiques.

Les Évaluateurs de la qualité de la recherche évaluent plusieurs dimensions du contenu. Ils examinent le contenu principal (MC) pour déterminer s’il aide directement la page à remplir son objectif, en évaluant l’effort, l’originalité, le talent et la compétence investis. Ils identifient le contenu secondaire (SC) qui améliore l’expérience utilisateur sans servir directement l’objectif de la page, comme la navigation. Ils évaluent la présence et la visibilité des publicités et monétisation, notant que les publicités sont acceptables et nécessaires pour de nombreux sites, mais ne doivent pas masquer ou gêner le contenu principal. Les évaluateurs recherchent la réputation des sites et des créateurs via des avis indépendants, articles de presse, opinions d’experts et retours clients. Ils vérifient les qualifications et l’expertise des auteurs par la formation, l’expérience professionnelle et les publications antérieures. Ils vérifient l’exactitude du contenu en recoupant les affirmations avec des sources fiables, surtout pour les sujets YMYL. Ils évaluent la conception de la page et l’expérience utilisateur, notant si le contenu est facile d’accès ou noyé sous les publicités. Ils identifient aussi des schémas de contenu problématiques comme le contenu copié ou paraphrasé sans valeur ajoutée, le contenu généré par IA avec peu d’effort, les titres trompeurs, la conception malhonnête et le contenu allant à l’encontre du consensus d’experts reconnu.

Depuis la mise à jour de janvier 2025 des Directives de notation de la qualité de recherche de Google, les évaluateurs doivent désormais évaluer si le contenu est créé à l’aide d’outils automatisés ou d’IA générative. Les pages dont le contenu principal est « généré automatiquement ou par IA » avec « peu ou pas d’effort, peu ou pas d’originalité, et peu ou pas de valeur ajoutée » reçoivent une note de qualité la plus basse. Les évaluateurs recherchent des signes de génération par IA comme du contenu paraphrasé avec peu de modifications, des formulations génériques, des informations connues sans apport original, une forte similarité avec des sources existantes comme Wikipédia, et des expressions telles que « En tant que modèle de langage IA ». Cependant, les directives précisent que l’IA générative n’est pas en soi problématique—elle peut être un outil utile de création de contenu lorsqu’elle est utilisée avec un effort humain significatif, des ajouts originaux et une réelle création de valeur. La différence réside entre l’IA comme outil d’enrichissement créatif et l’IA utilisée comme raccourci pour générer du contenu de mauvaise qualité à grande échelle. Cela reflète l’accent mis par Google sur l’abus de contenu à grande échelle, où de grands volumes de contenu médiocre sont générés avec un minimum de relecture ou d’édition humaine, quelle que soit la méthode de création.

Bien que les Évaluateurs de la qualité de la recherche ne contrôlent pas directement les classements, leur travail a un impact indirect significatif sur l’évolution et l’amélioration des algorithmes de Google. Google utilise les évaluations agrégées de milliers d’évaluateurs pour mesurer l’efficacité de ses systèmes de classement et identifier les domaines où les algorithmes ne délivrent pas des résultats de qualité. Lorsque des types de résultats sont régulièrement notés comme de faible qualité, cela signale aux ingénieurs de Google la nécessité d’ajuster l’algorithme. Les évaluateurs fournissent aussi des exemples positifs et négatifs qui servent à entraîner les systèmes d’apprentissage automatique de Google à mieux reconnaître les signaux de qualité. Rien qu’en 2023, Google a mené plus de 719 326 tests de qualité de recherche et mis en œuvre plus de 4 000 améliorations de Search en partie grâce au retour des évaluateurs. L’entreprise a aussi organisé 16 871 expériences sur du trafic réel et 124 942 expériences comparatives impliquant des évaluateurs. Cette approche fondée sur les données garantit que les améliorations algorithmiques sont ancrées dans le jugement humain sur la qualité réelle. La boucle de rétroaction entre évaluateurs humains et systèmes d’apprentissage automatique crée un cycle d’amélioration continue, où les algorithmes apprennent à reconnaître les schémas associés à un contenu de qualité tel qu’identifié par des experts humains.

Les Évaluateurs de la qualité de la recherche sont recrutés via un réseau de sociétés de sous-traitance tierces et non directement par Google. Le recrutement est sélectif : Google choisit des candidats qui démontrent une solide maîtrise de la langue et de la localité, une aisance avec les moteurs de recherche et la capacité de représenter les besoins et standards culturels locaux. Les candidats doivent réussir un test complet sur les Directives de notation de la qualité de recherche de Google avant de commencer. Ces directives, qui dépassent désormais 160 pages, couvrent des critères détaillés pour évaluer la qualité des pages, comprendre l’intention utilisateur, évaluer E-E-A-T, identifier le spam et le contenu nuisible, et noter la pertinence des résultats. Elles contiennent de nombreux exemples et études de cas pour assurer une interprétation cohérente entre évaluateurs. Les évaluateurs travaillent sous contrats à court terme renouvelables mais rarement indéfiniment, afin de prévenir tout conflit d’intérêts ou tentative de manipulation du système. Il leur est expressément demandé que leurs évaluations ne reposent pas sur leurs opinions personnelles, préférences, croyances religieuses ou politiques, mais sur une application objective des directives et la représentation des standards culturels de leur région. Cet accent mis sur l’objectivité et le respect des directives garantit que les évaluations reflètent une véritable analyse de la qualité, et non un biais individuel.

Plusieurs idées reçues entourent le rôle des Évaluateurs de la qualité de la recherche. Première idée reçue : les évaluateurs déterminent directement les classements ou attribuent des pénalités. Réalité : les évaluateurs fournissent un retour qui aide Google à mesurer l’efficacité de ses algorithmes, mais les évaluations individuelles n’affectent pas directement le classement d’une page. Deuxième idée reçue : une note élevée de Qualité de la page garantit une bonne visibilité en recherche. Réalité : la Qualité de la page n’est qu’un facteur parmi d’autres ; même une page de haute qualité peut ne pas bien se positionner si elle ne correspond pas à l’intention de l’utilisateur ou si d’autres pages sont plus pertinentes. Troisième idée reçue : E-E-A-T est un facteur de classement. Réalité : E-E-A-T est un cadre utilisé par les évaluateurs pour juger la crédibilité du contenu, et même si les algorithmes de Google suivent parfois ces principes, E-E-A-T n’est pas un signal de classement direct. Quatrième idée reçue : les évaluateurs peuvent être influencés ou manipulés. Réalité : la structure de contrats courts, des directives complètes et des processus d’assurance qualité rendent le système résistant à la manipulation. Cinquième idée reçue : tout contenu généré par IA reçoit la note la plus basse. Réalité : les outils IA utilisés avec un réel effort humain, des ajouts originaux et une vraie valeur ajoutée peuvent ne pas recevoir la note la plus basse ; le problème réside dans la génération IA de faible qualité à grande échelle.

Le rôle des Évaluateurs de la qualité de la recherche continue d’évoluer à mesure que Google fait face à de nouveaux défis pour maintenir la qualité de la recherche. La montée en puissance du contenu généré par IA a incité Google à adapter explicitement ses directives et à former les évaluateurs à identifier la génération IA de faible effort. L’essor des interfaces de recherche pilotées par IA comme les Google AI Overviews et la concurrence des chatbots IA comme ChatGPT et Claude a renforcé l’importance de l’évaluation humaine pour garantir la qualité. Les évolutions futures pourraient inclure des méthodes de détection IA plus avancées, une évaluation accrue du contenu multimodal (images, vidéos, audio) et une attention accrue à la pertinence locale et culturelle. Pour les créateurs de contenu et les éditeurs, comprendre comment les Évaluateurs de la qualité de la recherche évaluent le contenu devient crucial. L’accent mis sur E-E-A-T, le contenu original, la conception centrée utilisateur et l’expertise authentique indique que le succès SEO durable dépend de la qualité réelle, non des raccourcis. Les avertissements explicites contre la génération IA de faible effort, le contenu copié et les pratiques trompeuses montrent que Google veut récompenser la création authentique et la valeur ajoutée. Les organisations devraient mettre l’accent sur la démonstration d’expertise par la recherche originale, la construction d’une véritable autorité via du contenu de qualité et une réputation positive, et la fiabilité par la transparence et l’exactitude.

Les Évaluateurs de la qualité de la recherche incarnent un élément humain crucial dans le système de recherche, par ailleurs algorithmique, de Google. Leur travail démontre que, malgré la sophistication de l’apprentissage automatique et de l’intelligence artificielle, le jugement humain reste essentiel pour évaluer la qualité, la pertinence et la fiabilité. Les quelque 16 000 évaluateurs dans le monde, travaillant dans différentes langues et régions, veillent à ce que les résultats de recherche de Google reflètent la diversité des besoins et des contextes culturels. En fournissant un retour systématique sur la qualité des pages et la satisfaction utilisateur, ils aident Google à améliorer continuellement ses algorithmes pour délivrer une information toujours plus utile, fiable et autoritaire. Pour quiconque souhaite comprendre comment Google évalue le contenu—créateur, professionnel SEO ou simple utilisateur curieux—comprendre le rôle et la méthodologie des Évaluateurs de la qualité de la recherche offre un éclairage précieux sur la notion de qualité selon Google et sur l’évolution permanente du moteur de recherche pour mieux servir ses utilisateurs. À mesure que le paysage numérique évolue avec le contenu généré par IA, de nouvelles interfaces de recherche et des attentes changeantes, le rôle des évaluateurs humains devient plus critique que jamais pour préserver l’intégrité et l’utilité des résultats de recherche.

Non, les Évaluateurs de la qualité de la recherche ne déterminent pas directement le classement ni n’attribuent de pénalités aux sites web. Leurs évaluations servent plutôt de retour d’information pour aider Google à mesurer l’efficacité de ses algorithmes. Les évaluations agrégées de milliers d’évaluateurs fournissent des signaux qui aident Google à améliorer ses systèmes, mais les évaluations individuelles n’ont pas d’impact direct sur le classement d’une page spécifique dans les résultats de recherche.

E-E-A-T signifie Expérience, Expertise, Autorité et Fiabilité. Les Évaluateurs de la qualité de la recherche évaluent ces quatre dimensions pour déterminer si les créateurs de contenu et les sites web sont des sources fiables pour leurs sujets. E-E-A-T est particulièrement crucial pour les sujets YMYL (« Your Money or Your Life ») comme la santé, la finance et les conseils juridiques, où des informations inexactes pourraient nuire aux utilisateurs. Les évaluateurs recherchent les qualifications des créateurs, la réputation du site web et la qualité du contenu pour évaluer les niveaux de E-E-A-T.

Google emploie environ 16 000 Évaluateurs de la qualité de la recherche dans le monde entier via un réseau de sociétés de sous-traitance tierces. Ces évaluateurs sont répartis dans différentes régions et localités afin de garantir la diversité des points de vue et la compréhension culturelle. Le nombre exact peut varier selon les besoins opérationnels, et les évaluateurs travaillent généralement sous contrat à court terme, renouvelable mais rarement indéfiniment.

Les Évaluateurs de la qualité de la recherche utilisent deux systèmes de notation principaux : les notes de Qualité de la page (PQ), qui évaluent la capacité d’une page à remplir sa fonction sur une échelle de la qualité la plus basse à la plus élevée, et les notes Besoins satisfaits (NM), qui évaluent dans quelle mesure un résultat répond à l’intention de l’utilisateur sur une échelle allant de « Ne satisfait pas » à « Satisfait pleinement ». Ces évaluations aident Google à comprendre si ses résultats de recherche répondent aux attentes des utilisateurs et délivrent un contenu autoritaire et fiable.

YMYL signifie « Your Money or Your Life » et désigne les sujets pouvant avoir un impact significatif sur la santé, la stabilité financière, la sécurité ou le bien-être d’une personne. Les pages portant sur des sujets YMYL sont soumises à des normes d’évaluation de la qualité plus strictes, car des informations inexactes ou peu fiables pourraient causer de réels dommages. Exemples : conseils médicaux, financiers, juridiques ou civiques. Les évaluateurs appliquent des standards E-E-A-T plus élevés et exigent des preuves d’expertise renforcées pour le contenu YMYL.

Depuis janvier 2025, les directives de Google demandent aux évaluateurs de noter les pages dont le contenu principal est créé à l’aide d’outils automatisés ou d’IA générative comme de la qualité la plus basse si le contenu manque d’effort, d’originalité et de valeur ajoutée. Les évaluateurs recherchent des indicateurs de génération par IA tels que du contenu paraphrasé avec peu de modifications, des formulations génériques ou des phrases comme « En tant que modèle de langage IA ». Cependant, si les outils d’IA sont utilisés avec un réel effort humain et des ajouts originaux, la note la plus basse n’est pas systématique.

Les Évaluateurs de la qualité de la recherche doivent réussir un test complet sur les Directives de notation de la qualité de recherche de Google avant de commencer. Ces directives, qui font plus de 160 pages, couvrent des critères détaillés pour évaluer la qualité des pages, comprendre l’intention de l’utilisateur, évaluer E-E-A-T, identifier le spam et les contenus nuisibles, et noter la pertinence des résultats. Les évaluateurs doivent prouver leur maîtrise de la langue et de la localité pour représenter fidèlement les besoins et standards culturels locaux.

Commencez à suivre comment les chatbots IA mentionnent votre marque sur ChatGPT, Perplexity et d'autres plateformes. Obtenez des informations exploitables pour améliorer votre présence IA.

Découvrez les Quality Rater Guidelines de Google, le cadre d'évaluation utilisé par plus de 16 000 évaluateurs pour juger la qualité des recherches, les signaux...

L'Évaluation de la satisfaction des besoins évalue la qualité des résultats de recherche en mesurant la satisfaction de l'utilisateur quant à la pertinence de l...

L'Évaluation de la Qualité des Pages est le cadre d'évaluation de Google pour la qualité des pages web via E-E-A-T, l'originalité du contenu et la satisfaction ...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.