Qu'est-ce que la recherche vectorielle et comment fonctionne-t-elle ?

Découvrez comment la recherche vectorielle utilise des embeddings de machine learning pour trouver des éléments similaires en se basant sur la signification plu...

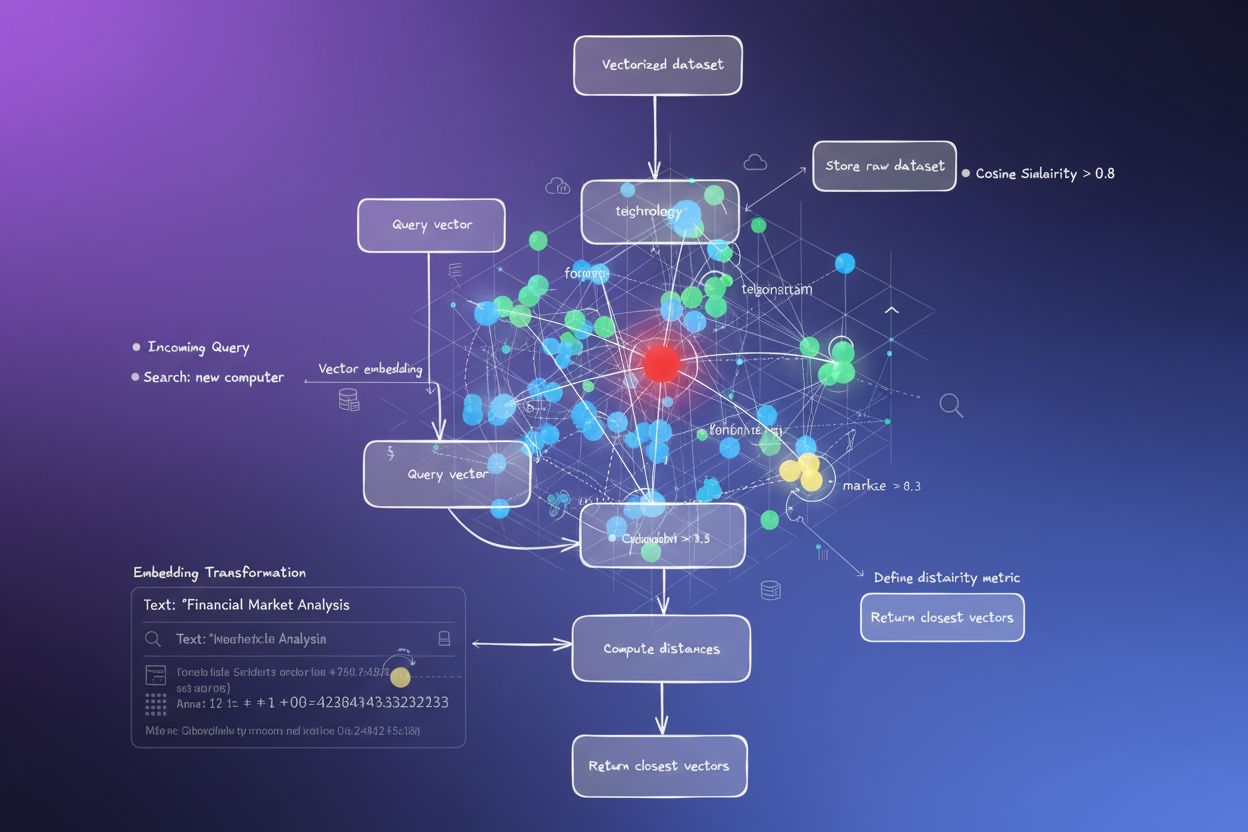

La recherche vectorielle est une méthode permettant de trouver des éléments similaires dans un ensemble de données en représentant les données sous forme de vecteurs mathématiques et en les comparant à l’aide de métriques de distance telles que la similarité cosinus ou la distance euclidienne. Cette approche permet une compréhension sémantique au-delà de la simple correspondance de mots-clés, permettant aux systèmes de découvrir des relations et des similitudes basées sur le sens plutôt que sur l’exactitude des correspondances textuelles.

La recherche vectorielle est une méthode permettant de trouver des éléments similaires dans un ensemble de données en représentant les données sous forme de vecteurs mathématiques et en les comparant à l'aide de métriques de distance telles que la similarité cosinus ou la distance euclidienne. Cette approche permet une compréhension sémantique au-delà de la simple correspondance de mots-clés, permettant aux systèmes de découvrir des relations et des similitudes basées sur le sens plutôt que sur l'exactitude des correspondances textuelles.

La recherche vectorielle est une méthode permettant de trouver des éléments similaires dans un ensemble de données en représentant les données sous forme de vecteurs mathématiques et en les comparant à l’aide de métriques de distance pour mesurer la similarité sémantique. Contrairement à la recherche traditionnelle basée sur les mots-clés qui repose sur des correspondances textuelles exactes, la recherche vectorielle comprend le sens et le contexte des données en les convertissant en représentations numériques de grande dimension appelées embeddings vectoriels. Cette approche permet aux systèmes de découvrir des relations et des similitudes fondées sur le contenu sémantique plutôt que sur les caractéristiques superficielles, ce qui la rend particulièrement puissante pour les applications nécessitant une compréhension contextuelle. La recherche vectorielle est devenue fondamentale pour les systèmes d’IA modernes, permettant la recherche sémantique, les moteurs de recommandation, la détection d’anomalies et la génération augmentée par la recherche (RAG) sur des plateformes comme ChatGPT, Perplexity, Google AI Overviews et Claude.

Au cœur de la recherche vectorielle, les données sont transformées en représentations numériques où la proximité dans l’espace indique une similarité sémantique. Chaque élément de données — qu’il s’agisse de texte, d’image ou d’audio — est converti en un vecteur, c’est-à-dire un tableau de nombres représentant des caractéristiques ou un sens. Par exemple, le mot « restaurant » peut être représenté par [0.2, -0.5, 0.8, 0.1], où chaque nombre capture différents aspects de la signification sémantique du mot. Le principe fondamental est que des éléments sémantiquement similaires auront des vecteurs rapprochés dans cet espace de grande dimension, tandis que les éléments différents seront éloignés. Cette structure mathématique permet aux ordinateurs de comparer des concepts sur la base du sens, plutôt que sur la correspondance exacte de mots-clés, permettant ainsi qu’une recherche de « meilleures adresses pour dîner » retourne des résultats pour « restaurants les mieux notés » même sans recouvrement exact de mots.

Le processus de conversion des données en vecteurs s’appelle embedding, réalisé par des modèles d’apprentissage automatique entraînés sur de grands ensembles de données. Ces modèles apprennent à placer des concepts similaires à proximité dans l’espace vectoriel grâce à l’exposition à des milliards d’exemples. Les modèles d’embedding courants incluent Word2Vec, qui apprend les relations entre les mots à partir du contexte ; BERT (Bidirectional Encoder Representations from Transformers), qui capture le sens contextuel ; et CLIP (Contrastive Language-Image Pre-training), qui gère les données multimodales. Les embeddings résultants vont généralement de 100 à plus de 1 000 dimensions, créant une représentation mathématique riche des relations sémantiques. Lorsqu’un utilisateur effectue une recherche, sa requête est convertie en vecteur à l’aide du même modèle d’embedding, puis le système calcule les distances entre le vecteur de requête et tous les vecteurs stockés pour identifier les éléments les plus similaires.

La recherche vectorielle repose sur les métriques de distance pour quantifier la similarité entre deux vecteurs. Les trois principales métriques sont la similarité cosinus, la distance euclidienne et la similarité par produit scalaire, chacune ayant des propriétés mathématiques et des cas d’utilisation distincts. La similarité cosinus mesure l’angle entre deux vecteurs, variant de -1 à 1, où 1 indique une direction identique (similarité maximale) et 0 indique des vecteurs orthogonaux (aucune relation). Cette métrique est particulièrement précieuse pour les applications NLP car elle privilégie la direction sémantique indépendamment de la magnitude du vecteur, ce qui la rend idéale pour comparer des documents de longueurs différentes. La distance euclidienne calcule la distance en ligne droite entre les vecteurs dans un espace multidimensionnel, prenant en compte la magnitude et la direction. Cette métrique est sensible à l’échelle et utile lorsque la magnitude des vecteurs porte une signification, comme dans les systèmes de recommandation où la fréquence d’achat est importante.

La similarité par produit scalaire combine des aspects des deux métriques, prenant en compte la magnitude et la direction tout en offrant une efficacité de calcul. De nombreux grands modèles de langage utilisent le produit scalaire pour l’entraînement, ce qui en fait le choix approprié pour ces applications. Le choix de la bonne métrique de distance est essentiel — les recherches montrent que l’utilisation de la même métrique que celle utilisée pour entraîner votre modèle d’embedding produit les meilleurs résultats. Par exemple, le modèle all-MiniLM-L6-v2 a été entraîné avec la similarité cosinus, donc l’utilisation de la similarité cosinus dans votre index donnera les résultats les plus précis. Les organisations qui mettent en place une recherche vectorielle doivent donc soigneusement aligner la métrique choisie sur leur modèle d’embedding et leur cas d’usage pour garantir précision et performance.

| Aspect | Recherche vectorielle | Recherche par mots-clés | Recherche hybride |

|---|---|---|---|

| Méthode de correspondance | Similarité sémantique basée sur le sens | Correspondance exacte de mots ou d’expressions | Combine la correspondance sémantique et par mots-clés |

| Compréhension de la requête | Comprend l’intention et le contexte | Nécessite la présence exacte des mots-clés | S’appuie sur les deux approches pour des résultats complets |

| Gestion des synonymes | Trouve automatiquement synonymes et termes liés | Ignore les synonymes sauf s’ils sont indexés explicitement | Capture les synonymes par les deux méthodes |

| Performance sur requêtes vagues | Excellente — comprend l’intention | Faible — nécessite des mots-clés précis | Très bonne — couvre les deux interprétations |

| Coût computationnel | Plus élevé — nécessite embeddings et calculs de similarité | Plus faible — simple correspondance de chaînes | Modéré — exécute les deux recherches en parallèle |

| Scalabilité | Nécessite des bases de données vectorielles spécialisées | Fonctionne avec des bases de données traditionnelles | Nécessite des systèmes compatibles hybrides |

| Cas d’usage | Recherche sémantique, recommandations, RAG, détection d’anomalies | Recherche d’expressions exactes, données structurées | Recherche d’entreprise, surveillance IA, suivi de marque |

| Exemple | Rechercher « idées de dîners sains » trouve « préparation de repas nutritifs » | Ne trouve que les résultats contenant exactement « sain » et « dîner » | Trouve à la fois les correspondances exactes et le contenu sémantiquement lié |

La mise en œuvre de la recherche vectorielle comprend plusieurs étapes interconnectées transformant les données brutes en représentations sémantiques interrogeables. La première étape est l’ingestion et le prétraitement des données, où les documents bruts, images ou autres données sont nettoyés et normalisés. Vient ensuite la transformation vectorielle, où un modèle d’embedding convertit chaque élément en un vecteur numérique, généralement de 100 à plus de 1 000 dimensions. Ces vecteurs sont ensuite stockés dans une base de données vectorielle ou une structure d’index optimisée pour les données de grande dimension. Lorsqu’une requête arrive, elle subit le même processus d’embedding pour créer un vecteur de requête. Le système utilise alors des métriques de distance pour calculer les scores de similarité entre le vecteur de requête et tous les vecteurs stockés, classant les résultats selon leur proximité avec la requête.

Pour rendre ce processus efficace à grande échelle, les systèmes emploient des algorithmes de plus proche voisin approximatif (ANN) comme HNSW (Hierarchical Navigable Small World), IVF (Inverted File Index) ou ScaNN (Scalable Nearest Neighbors). Ces algorithmes échangent une précision parfaite contre la rapidité, permettant des recherches sur des millions voire des milliards de vecteurs en quelques millisecondes plutôt qu’en secondes. HNSW, par exemple, organise les vecteurs dans une structure de graphe multicouche où les couches supérieures contiennent des connexions longue distance pour une traversée rapide, et les couches inférieures des connexions courtes pour la précision. Cette approche hiérarchique réduit la complexité de recherche de O(n) à O(log n), rendant la recherche vectorielle à grande échelle praticable. Le choix de l’algorithme dépend de facteurs tels que la taille du jeu de données, le volume des requêtes, les exigences de latence et les ressources informatiques disponibles.

La recherche vectorielle est devenue essentielle pour les plateformes de surveillance de l’IA comme AmICited qui suivent les mentions de marque à travers les systèmes d’IA. La surveillance traditionnelle par mots-clés manquerait les mentions paraphrasées, les références contextuelles et les variations sémantiques des noms de marque ou des URLs de domaine. La recherche vectorielle permet à ces plateformes de détecter quand votre marque est mentionnée dans des réponses générées par l’IA même lorsque la formulation exacte diffère. Par exemple, si votre domaine est « amicited.com », la recherche vectorielle peut identifier des mentions de « plateforme de surveillance de prompts IA » ou « visibilité de marque dans l’IA générative » comme contextuellement liées à votre activité, même sans mention explicite de l’URL. Cette compréhension sémantique est cruciale pour un suivi complet des citations IA sur ChatGPT, Perplexity, Google AI Overviews et Claude.

Le marché de la technologie de recherche vectorielle connaît une croissance explosive, reflet de la reconnaissance de sa valeur par les entreprises. Selon des études de marché, le marché des bases de données vectorielles était évalué à 1,97 milliard de dollars en 2024 et devrait atteindre 10,60 milliards de dollars d’ici 2032, avec un taux de croissance annuel composé (CAGR) de 23,38 %. De plus, Databricks a signalé une croissance de 186 % de l’adoption des bases de données vectorielles dès la première année suivant leur preview publique en décembre 2023. Cette adoption rapide montre que les entreprises considèrent de plus en plus la recherche vectorielle comme une infrastructure critique pour les applications IA. Pour les organisations qui surveillent leur présence dans les systèmes d’IA, la recherche vectorielle fournit la compréhension sémantique nécessaire pour capturer toutes les mentions pertinentes, et pas seulement les correspondances exactes de mots-clés.

La performance de la recherche vectorielle à grande échelle dépend de techniques d’indexation sophistiquées qui équilibrent vitesse, précision et utilisation de la mémoire. HNSW (Hierarchical Navigable Small World) s’est imposé comme l’une des approches les plus populaires, organisant les vecteurs dans un graphe multicouche où chaque couche contient des connexions de portée progressivement plus courte. L’algorithme démarre les recherches dans la couche supérieure avec des connexions longue distance pour une traversée rapide, puis descend vers les couches inférieures pour plus de précision. Les recherches montrent que HNSW atteint des performances de pointe avec des taux de rappel supérieurs à 99 % tout en maintenant des latences de requête inférieures à la milliseconde. Cependant, HNSW requiert une mémoire importante — les benchmarks montrent qu’indexer 1 million de vecteurs avec HNSW peut nécessiter de 0,5 Go à 5 Go selon les paramètres, ce qui rend l’optimisation mémoire importante pour les déploiements à grande échelle.

IVF (Inverted File Index) offre une approche alternative en regroupant les vecteurs et en les indexant par centroïdes de clusters. Cette technique réduit l’espace de recherche en se concentrant sur les clusters pertinents plutôt qu’en recherchant dans tous les vecteurs. ScaNN (Scalable Nearest Neighbors), développé par Google Research, est optimisé spécifiquement pour la recherche par produit scalaire et offre d’excellentes performances pour les systèmes de recommandation. Product Quantization (PQ) compresse les vecteurs en les divisant en sous-vecteurs et en quantifiant chacun indépendamment, réduisant les besoins mémoire par un facteur de 10 à 100 au prix d’une légère perte de précision. Les organisations qui mettent en place la recherche vectorielle doivent donc choisir avec soin les techniques d’indexation en fonction de leurs besoins spécifiques — qu’elles privilégient la précision du rappel, la rapidité de recherche, l’efficacité mémoire ou une combinaison de ces critères. Le domaine évolue rapidement, de nouveaux algorithmes et techniques d’optimisation apparaissant régulièrement pour répondre aux défis computationnels des opérations vectorielles de grande dimension.

La définition et l’application de la recherche vectorielle continuent d’évoluer à mesure que les systèmes d’IA deviennent plus sophistiqués et que l’adoption en entreprise s’accélère. La tendance future va vers des systèmes de recherche hybride combinant la recherche vectorielle avec la recherche par mots-clés traditionnelle et des capacités de filtrage avancées. Ces approches hybrides tirent parti de la compréhension sémantique de la recherche vectorielle tout en conservant la précision et la familiarité de la correspondance par mots-clés, offrant ainsi de meilleurs résultats pour des requêtes complexes. De plus, la recherche vectorielle multimodale devient une capacité essentielle, permettant aux systèmes de rechercher simultanément dans des textes, images, audios et vidéos via des espaces d’embedding unifiés. Cette évolution permettra des expériences de recherche plus intuitives et complètes sur des données variées.

Pour les organisations qui surveillent leur présence dans les systèmes d’IA, l’évolution de la recherche vectorielle a des implications majeures. À mesure que des plateformes IA comme ChatGPT, Perplexity, Google AI Overviews et Claude s’appuient de plus en plus sur la recherche vectorielle pour la récupération et la hiérarchisation de contenu, comprendre comment votre marque apparaît sémantiquement devient aussi important que la visibilité par mots-clés. Le passage à la compréhension sémantique implique que la surveillance de marque et le suivi des citations IA doivent évoluer au-delà de la simple détection de mots-clés pour capturer les mentions contextuelles et les relations sémantiques. Les organisations qui investissent dans la compréhension de la recherche vectorielle et de ses applications seront mieux placées pour optimiser leur visibilité dans les systèmes d’IA générative. La convergence de la technologie de recherche vectorielle avec les plateformes de surveillance IA marque un tournant fondamental dans la façon dont les marques comprennent et gèrent leur présence dans le paysage informationnel piloté par l’IA.

La recherche par mots-clés traditionnelle recherche des correspondances exactes de mots dans les documents, tandis que la recherche vectorielle comprend la signification sémantique et le contexte. La recherche vectorielle convertit le texte en représentations numériques appelées embeddings, ce qui lui permet de trouver des résultats pertinents même lorsque les mots-clés exacts ne correspondent pas. Par exemple, rechercher « écouteurs sans fil » avec la recherche vectorielle retournera également des résultats pour « écouteurs Bluetooth » car ils partagent une signification sémantique similaire, alors que la recherche par mots-clés manquerait cette connexion.

Les embeddings vectoriels sont des représentations numériques de données (texte, images, audio) converties en tableaux de nombres qui capturent la signification sémantique. Ils sont créés à l'aide de modèles d'apprentissage automatique tels que Word2Vec, BERT ou des modèles basés sur les transformers qui apprennent à rapprocher des concepts similaires dans un espace de grande dimension. Par exemple, le mot « roi » et « reine » auraient des embeddings placés l'un près de l'autre car ils partagent des relations sémantiques, tandis que « roi » et « banane » seraient éloignés.

Les trois principales métriques de distance sont la similarité cosinus (mesure l'angle entre les vecteurs), la distance euclidienne (mesure la distance en ligne droite) et la similarité par produit scalaire (prend en compte l'amplitude et la direction). La similarité cosinus est la plus courante pour les applications NLP car elle se concentre sur la direction sémantique indépendamment de l'amplitude du vecteur. Le choix de la métrique doit correspondre à celle utilisée pour entraîner votre modèle d'embedding pour une précision optimale.

La recherche vectorielle permet aux plateformes de surveillance de l'IA comme AmICited de suivre les mentions de marques à travers les systèmes d'IA (ChatGPT, Perplexity, Google AI Overviews, Claude) en comprenant le contexte sémantique plutôt qu'en se basant sur des correspondances exactes de mots-clés. Cela permet de détecter les mentions paraphrasées, les concepts liés et les références contextuelles à votre marque, offrant une visibilité complète sur la façon dont votre domaine apparaît dans les réponses générées par l'IA sur plusieurs plateformes.

Les algorithmes ANN comme HNSW (Hierarchical Navigable Small World) permettent des recherches de similarité rapides sur des millions de vecteurs en trouvant des voisins approximatifs plutôt qu'exacts. Ces algorithmes utilisent des structures de graphe hiérarchiques pour réduire la complexité de la recherche de linéaire à logarithmique, rendant la recherche vectorielle pratique pour des applications à grande échelle. HNSW organise les vecteurs dans des graphes multicouches où les connexions longue distance existent dans les couches supérieures pour une traversée plus rapide.

Les entreprises génèrent d’énormes quantités de données non structurées (e-mails, documents, tickets de support) que la recherche par mots-clés traditionnelle peine à organiser efficacement. La recherche vectorielle permet la compréhension sémantique de ces données, alimentant des applications telles que la recherche intelligente, les systèmes de recommandation, la détection d'anomalies et la génération augmentée par la recherche (RAG). Selon les études de marché, le marché des bases de données vectorielles devrait passer de 2,65 milliards de dollars en 2025 à 8,95 milliards de dollars d’ici 2030, ce qui reflète l'adoption en entreprise.

Les bases de données vectorielles sont des systèmes spécialisés optimisés pour le stockage, l’indexation et l’interrogation de données vectorielles de grande dimension. Elles implémentent des techniques d'indexation efficaces comme HNSW, IVF (Inverted File Index) et ScaNN pour permettre des recherches de similarité rapides à grande échelle. Parmi les exemples, on trouve Milvus, Pinecone, Weaviate et Zilliz Cloud. Ces bases de données gèrent la complexité computationnelle des opérations vectorielles, permettant aux organisations de créer des applications de recherche sémantique et d'IA prêtes pour la production sans avoir à gérer la complexité de l’infrastructure.

Commencez à suivre comment les chatbots IA mentionnent votre marque sur ChatGPT, Perplexity et d'autres plateformes. Obtenez des informations exploitables pour améliorer votre présence IA.

Découvrez comment la recherche vectorielle utilise des embeddings de machine learning pour trouver des éléments similaires en se basant sur la signification plu...

La recherche sémantique interprète le sens et le contexte des requêtes à l’aide du NLP et de l’apprentissage automatique. Découvrez comment elle diffère de la r...

Découvrez comment la recherche sémantique utilise l'IA pour comprendre l'intention de l'utilisateur et le contexte. Apprenez en quoi elle diffère de la recherch...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.