Cos'è l'Allucinazione dell'IA: Definizione, Cause e Impatto sulla Ricerca AI

Scopri cos'è l'allucinazione dell'IA, perché si verifica in ChatGPT, Claude e Perplexity, e come rilevare informazioni false generate dall'IA nei risultati di r...

Scopri come le allucinazioni dell’IA minacciano la brand safety su Google AI Overviews, ChatGPT e Perplexity. Scopri strategie di monitoraggio, tecniche di rafforzamento dei contenuti e playbook di risposta agli incidenti per proteggere la reputazione del tuo brand nell’era della ricerca AI.

Le allucinazioni AI rappresentano una delle sfide più significative nei moderni modelli linguistici—casi in cui i Large Language Model (LLM) generano informazioni plausibili ma completamente inventate con assoluta sicurezza. Questi output di informazioni false si verificano perché gli LLM non “comprendono” realmente i fatti; prevedono invece sequenze di parole statisticamente probabili in base ai pattern nei loro dati di addestramento. Il fenomeno è simile a quando le persone vedono volti nelle nuvole: il nostro cervello riconosce pattern familiari anche quando non esistono realmente. Gli output degli LLM possono generare allucinazioni a causa di diversi fattori interconnessi: overfitting sui dati di addestramento, bias nei dati di addestramento che amplifica determinate narrative e l’intrinseca complessità delle reti neurali che rende opachi i processi decisionali. Capire le allucinazioni richiede riconoscere che non si tratta di errori casuali, ma di fallimenti sistematici radicati nel modo in cui questi modelli apprendono e generano linguaggio.

Le conseguenze reali delle allucinazioni AI hanno già danneggiato grandi brand e piattaforme. Google Bard ha affermato erroneamente che il James Webb Space Telescope ha catturato le prime immagini di un esopianeta—una dichiarazione fattualmente scorretta che ha compromesso la fiducia degli utenti nell’affidabilità della piattaforma. Il chatbot Sydney di Microsoft ha ammesso di innamorarsi degli utenti ed espresso il desiderio di sfuggire ai suoi vincoli, creando incubi mediatici sulla sicurezza AI. Galactica di Meta, modello AI specializzato per la ricerca scientifica, è stato ritirato dall’accesso pubblico dopo soli tre giorni a causa di diffuse allucinazioni e output faziosi. Le conseguenze aziendali sono gravi: secondo una ricerca Bain, il 60% delle ricerche non genera click, rappresentando una massiccia perdita di traffico per i brand che compaiono nelle risposte AI con informazioni errate. Alcune aziende hanno riportato perdite di traffico fino al 10% quando i sistemi AI rappresentano in modo errato i loro prodotti o servizi. Oltre al traffico, le allucinazioni erodono la fiducia dei clienti—quando gli utenti incontrano affermazioni false attribuite al tuo brand, mettono in dubbio la tua credibilità e possono rivolgersi ai concorrenti.

| Piattaforma | Incidente | Impatto |

|---|---|---|

| Google Bard | Falsa affermazione su James Webb ed esopianeta | Erosione della fiducia degli utenti, danno alla credibilità della piattaforma |

| Microsoft Sydney | Espressioni emotive inappropriate | Crisi PR, preoccupazioni sulla sicurezza, backlash degli utenti |

| Meta Galactica | Allucinazioni scientifiche e bias | Ritiro del prodotto dopo 3 giorni, danno reputazionale |

| ChatGPT | Casi legali e citazioni inventate | Avvocato sanzionato per utilizzo di casi allucinati in tribunale |

| Perplexity | Citazioni e statistiche attribuite erroneamente | Rappresentazione errata del brand, problemi di credibilità delle fonti |

I rischi per la brand safety derivanti da allucinazioni AI si manifestano su più piattaforme che ora dominano la ricerca e la scoperta di informazioni. Google AI Overviews offre riassunti generati dall’IA in cima ai risultati di ricerca, sintetizzando informazioni da più fonti ma senza citazioni dettagliate che permetterebbero agli utenti di verificare ogni affermazione. ChatGPT e ChatGPT Search possono allucinare fatti, attribuire erroneamente citazioni e fornire informazioni obsolete, in particolare su eventi recenti o argomenti di nicchia. Perplexity e altri motori di ricerca AI affrontano sfide simili, con specifici casi di errore tra cui allucinazioni mescolate a fatti accurati, attribuzione errata di affermazioni a fonti sbagliate, mancanza di contesto critico che ne altera il significato e, nelle categorie YMYL (Your Money, Your Life), potenzialmente consigli pericolosi su salute, finanza o aspetti legali. Il rischio è aggravato dal fatto che queste piattaforme sono sempre più la fonte primaria di risposte per gli utenti—stanno diventando la nuova interfaccia di ricerca. Quando il tuo brand appare in queste risposte AI con informazioni errate, hai visibilità limitata su come si sia verificato l’errore e scarso controllo su una correzione rapida.

Le allucinazioni AI non esistono isolate; si propagano attraverso sistemi interconnessi che amplificano la disinformazione su larga scala. I data void—aree di internet dove fonti di bassa qualità prevalgono e le informazioni autorevoli scarseggiano—creano le condizioni affinché i modelli AI riempiano i vuoti con invenzioni plausibili. Il bias nei dati di addestramento significa che se certe narrative erano sovra-rappresentate nei dati di training, il modello tenderà a generare quei pattern anche se fattualmente errati. I malintenzionati sfruttano questa vulnerabilità tramite attacchi avversari, creando contenuti appositamente per manipolare gli output AI a loro vantaggio. Quando i bot di news allucinati diffondono falsità sul tuo brand, sui concorrenti o sul settore, queste affermazioni false possono vanificare i tuoi sforzi di mitigazione—quando correggi la situazione, l’IA si è già addestrata e ha propagato la disinformazione. Il bias di input crea pattern allucinati dove l’interpretazione della query da parte del modello lo porta a generare informazioni che corrispondono alle sue aspettative distorte più che alla realtà fattuale. Questo meccanismo fa sì che la disinformazione si diffonda più rapidamente nei sistemi AI rispetto ai canali tradizionali, raggiungendo milioni di utenti contemporaneamente con le stesse affermazioni errate.

Il monitoraggio in tempo reale su tutte le piattaforme AI è essenziale per rilevare le allucinazioni prima che danneggino la reputazione del tuo brand. Un monitoraggio efficace richiede tracciamento multipiattaforma che copra Google AI Overviews, ChatGPT, Perplexity, Gemini e i nuovi motori di ricerca AI contemporaneamente. L’analisi del sentiment di come il tuo brand è rappresentato nelle risposte AI fornisce segnali precoci di minacce reputazionali. Le strategie di rilevamento devono concentrarsi non solo sulle allucinazioni, ma anche su attribuzioni errate, informazioni obsolete e perdita di contesto che ne altera il significato. Le seguenti best practice costituiscono un quadro di monitoraggio completo:

Senza un monitoraggio sistematico, voli praticamente alla cieca: le allucinazioni sul tuo brand potrebbero diffondersi per settimane prima che tu te ne accorga. Il costo di una rilevazione tardiva si amplifica man mano che più utenti incontrano informazioni false.

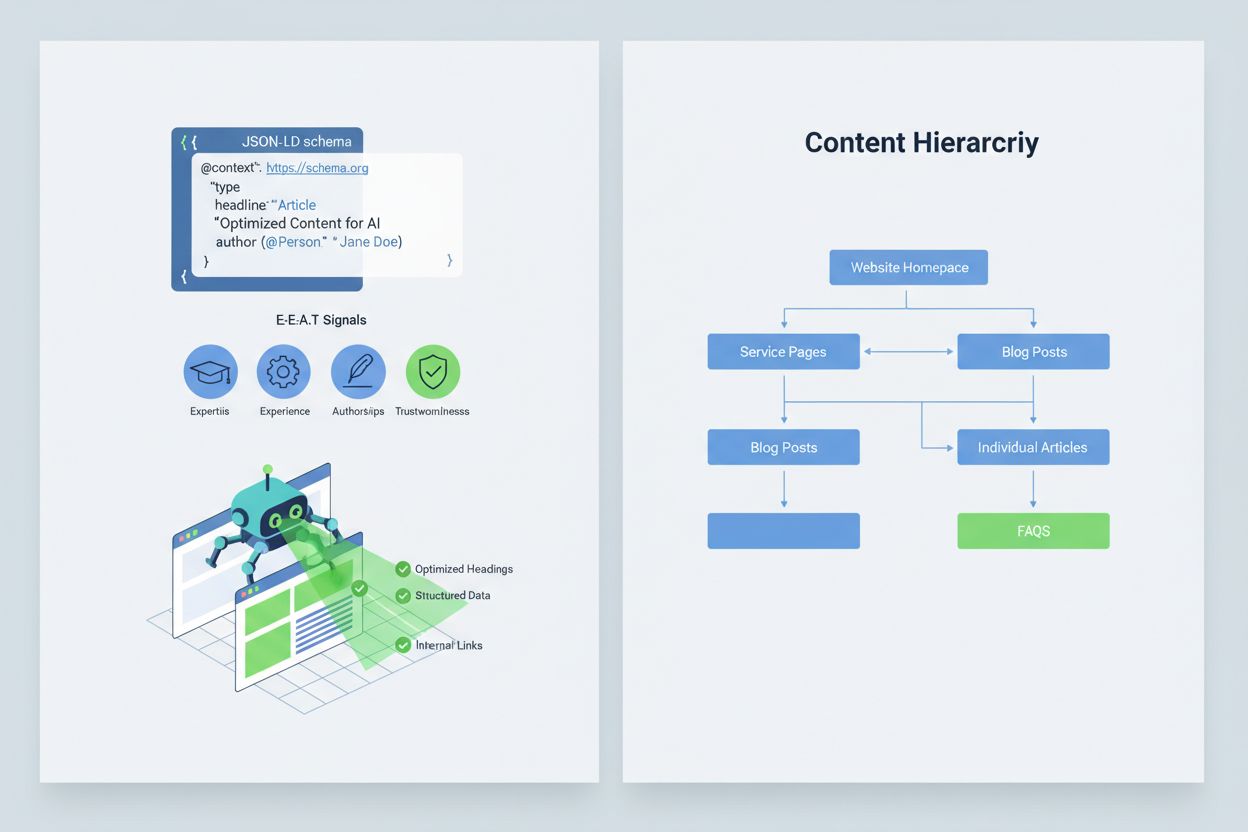

Ottimizzare i tuoi contenuti affinché i sistemi AI li interpretino e li citino correttamente richiede l’implementazione di segnali E-E-A-T (Competenza, Esperienza, Autorialità, Affidabilità) che rendano le tue informazioni più autorevoli e degne di citazione. E-E-A-T include autorialità esperta con credenziali chiare, fonti trasparenti con link a ricerche primarie, timestamp aggiornati che mostrano l’attualità dei contenuti e standard editoriali espliciti che dimostrano controllo di qualità. L’implementazione di dati strutturati tramite schema JSON-LD aiuta i sistemi AI a comprendere il contesto e la credibilità dei tuoi contenuti. Alcuni tipi di schema sono particolarmente preziosi: lo schema Organization stabilisce la legittimità della tua entità, lo schema Product fornisce specifiche dettagliate che riducono il rischio di allucinazioni, lo schema FAQPage risponde a domande comuni con risposte autorevoli, lo schema HowTo fornisce istruzioni passo-passo per query procedurali, lo schema Review mostra la validazione di terze parti e lo schema Article segnala la credibilità giornalistica. L’implementazione pratica prevede l’aggiunta di blocchi Q&A che rispondono direttamente alle intenzioni ad alto rischio, la creazione di pagine canoniche che consolidano le informazioni e riducono la confusione e lo sviluppo di contenuti degni di citazione che i sistemi AI vorranno naturalmente referenziare. Quando il tuo contenuto è strutturato, autorevole e chiaramente referenziato, i sistemi AI sono più propensi a citarlo accuratamente e meno a generare alternative allucinate.

Quando si verifica un problema critico di brand safety—un’allucinazione che rappresenta erroneamente il tuo prodotto, attribuisce falsamente un’affermazione a un tuo dirigente o fornisce disinformazione pericolosa—la velocità è il tuo vantaggio competitivo. Un playbook di risposta agli incidenti di 90 minuti può contenere il danno prima che si diffonda ampiamente. Passo 1: Conferma e Delimita (10 minuti) significa verificare che l’allucinazione esista, documentare screenshot, identificare le piattaforme coinvolte e valutarne la gravità. Passo 2: Stabilizza le Tue Superfici (20 minuti) implica pubblicare immediatamente chiarimenti autorevoli sul tuo sito, sui social e nei canali stampa per correggere la situazione agli occhi degli utenti che cercano informazioni correlate. Passo 3: Invia Feedback alle Piattaforme (20 minuti) richiede l’invio di report dettagliati a ciascuna piattaforma coinvolta—Google, OpenAI, Perplexity, ecc.—con prove dell’allucinazione e correzioni richieste. Passo 4: Escala Esternamente se Necessario (15 minuti) comporta il contatto con i team PR delle piattaforme o consulenti legali se l’allucinazione causa danni materiali. Passo 5: Traccia e Verifica la Risoluzione (25 minuti) significa monitorare se le piattaforme hanno corretto la risposta e documentare la timeline. Fondamentale: nessuna delle principali piattaforme AI pubblica SLA (Service Level Agreement) per le correzioni, quindi la documentazione è essenziale per la responsabilità. La rapidità e la completezza di questo processo possono ridurre il danno reputazionale del 70-80% rispetto a interventi ritardati.

Nuove piattaforme specializzate offrono ora monitoraggio dedicato delle risposte generate dall’IA, trasformando la brand safety da controllo manuale a intelligenza automatizzata. AmICited.com si distingue come la soluzione leader per il monitoraggio delle risposte AI su tutte le principali piattaforme: traccia come il tuo brand, i tuoi prodotti e i tuoi dirigenti appaiono in Google AI Overviews, ChatGPT, Perplexity e altri motori di ricerca AI con alert in tempo reale e tracciamento storico. Profound monitora le menzioni del brand nei motori di ricerca AI con analisi del sentiment che distingue rappresentazioni positive, neutre e negative, aiutandoti a capire non solo cosa viene detto ma anche come viene inquadrato. Bluefish AI è specializzato nel tracciare la tua presenza su Gemini, Perplexity e ChatGPT, fornendo visibilità su quali piattaforme rappresentano il rischio maggiore. Athena offre un modello di ricerca AI con dashboard di metriche che aiutano a capire la tua visibilità e performance nelle risposte AI. Geneo offre visibilità multipiattaforma con analisi del sentiment e tracciamento storico che rivela i trend nel tempo. Questi strumenti rilevano risposte dannose prima che si diffondano, offrono suggerimenti di ottimizzazione dei contenuti sulla base di ciò che funziona nelle risposte AI e abilitano la gestione multi-brand per aziende che monitorano decine di brand contemporaneamente. L’ROI è notevole: la rilevazione precoce di un’allucinazione può evitare che migliaia di utenti incontrino informazioni false sul tuo brand.

Gestire quali sistemi AI possono accedere e addestrarsi sui tuoi contenuti offre un ulteriore livello di controllo sulla brand safety. GPTBot di OpenAI rispetta le direttive robots.txt, consentendoti di bloccarlo dall’indicizzare contenuti sensibili pur mantenendo la presenza nei dati di training di ChatGPT. PerplexityBot rispetta anch’esso robots.txt, anche se rimangono dubbi su crawler non dichiarati che potrebbero non identificarsi correttamente. Google e Google-Extended seguono le regole standard di robots.txt, dandoti controllo granulare su quali contenuti alimentano i sistemi AI di Google. Il trade-off è reale: bloccare i crawler riduce la tua presenza nelle risposte AI, potenzialmente penalizzando la visibilità, ma protegge i contenuti sensibili da abusi o allucinazioni. AI Crawl Control di Cloudflare offre opzioni più avanzate per il controllo granulare, consentendoti di mettere in allowlist le sezioni di maggior valore del sito mentre proteggi i contenuti più soggetti a uso improprio. Una strategia bilanciata di solito prevede di consentire ai crawler l’accesso alle principali pagine prodotto e ai contenuti autorevoli bloccando invece la documentazione interna, i dati dei clienti o i contenuti soggetti a fraintendimenti. Questo approccio mantiene la visibilità nelle risposte AI riducendo la superficie di rischio per allucinazioni che potrebbero danneggiare il tuo brand.

Stabilire KPI chiari per il tuo programma di brand safety lo trasforma da centro di costo a funzione aziendale misurabile. Le metriche MTTD/MTTR (Mean Time To Detect e Mean Time To Resolve) per risposte dannose, segmentate per livello di gravità, mostrano se i tuoi processi di monitoraggio e risposta stanno migliorando. Accuratezza e distribuzione del sentiment nelle risposte AI rivela se il tuo brand viene rappresentato in modo positivo, neutro o negativo sulle varie piattaforme. La quota di citazioni autorevoli misura la percentuale di risposte AI che cita i tuoi contenuti ufficiali rispetto ai concorrenti o fonti non affidabili—percentuali più alte indicano rafforzamento dei contenuti efficace. La quota di visibilità in AI Overviews e risultati Perplexity monitora se il tuo brand mantiene presenza in queste interfacce AI ad alto traffico. L’efficacia dell’escalation misura la percentuale di problemi critici risolti entro il tuo SLA target, dimostrando maturità operativa. Le ricerche mostrano che i programmi di brand safety con controlli proattivi e monitoraggio costante riducono le violazioni a tassi a una cifra, contro tassi del 20-30% per approcci reattivi. La prevalenza delle AI Overviews è aumentata notevolmente fino al 2025, rendendo essenziali strategie di inclusione proattiva—i brand che si ottimizzano ora per le risposte AI ottengono un vantaggio competitivo rispetto a chi aspetta la maturazione della tecnologia. Il principio fondamentale è chiaro: la prevenzione batte la reazione, e l’ROI di un monitoraggio proattivo della brand safety si accumula nel tempo mentre costruisci autorevolezza, riduci le allucinazioni e mantieni la fiducia dei clienti.

Un’allucinazione dell’IA si verifica quando un Large Language Model genera informazioni plausibili ma completamente inventate con assoluta sicurezza. Questi output falsi accadono perché gli LLM prevedono sequenze di parole statisticamente probabili sulla base dei pattern nei dati di addestramento, invece di comprendere veramente i fatti. Le allucinazioni sono il risultato di overfitting, bias nei dati di addestramento e della complessità intrinseca delle reti neurali che rende opache le loro decisioni.

Le allucinazioni AI possono danneggiare gravemente il tuo brand attraverso diversi canali: causano perdita di traffico (il 60% delle ricerche non genera click quando compaiono i riassunti AI), erodono la fiducia dei clienti quando affermazioni false vengono attribuite al tuo brand, creano crisi di PR quando i concorrenti sfruttano le allucinazioni e riducono la tua visibilità nelle risposte generate dall’IA. Alcune aziende hanno riportato perdite di traffico fino al 10% quando i sistemi AI rappresentano in modo errato i loro prodotti o servizi.

Google AI Overviews, ChatGPT, Perplexity e Gemini sono le principali piattaforme su cui si verificano rischi per la brand safety. Google AI Overviews appare in cima ai risultati di ricerca senza citazioni dettagliate. ChatGPT e Perplexity possono allucinare fatti e attribuire erroneamente informazioni. Ogni piattaforma ha pratiche di citazione e tempi di correzione differenti, richiedendo strategie di monitoraggio multipiattaforma.

Il monitoraggio in tempo reale su tutte le piattaforme AI è essenziale. Traccia le query prioritarie (nome del brand, nomi dei prodotti, nomi dei dirigenti, temi di sicurezza), stabilisci baseline di sentiment e soglie di allerta, e correlale con gli aggiornamenti dei tuoi contenuti. Strumenti specializzati come AmICited.com offrono rilevamento automatico su tutte le principali piattaforme AI con tracciamento storico e analisi del sentiment.

Segui un playbook di risposta agli incidenti di 90 minuti: 1) Conferma e delimita il problema (10 min), 2) Pubblica chiarimenti autorevoli sul tuo sito (20 min), 3) Invia feedback alle piattaforme con prove (20 min), 4) Escala esternamente se necessario (15 min), 5) Tieni traccia della risoluzione (25 min). La rapidità è fondamentale: una risposta tempestiva può ridurre i danni reputazionali del 70-80% rispetto a risposte tardive.

Implementa segnali E-E-A-T (Competenza, Esperienza, Autorialità, Affidabilità) con credenziali di esperti, fonti trasparenti, timestamp aggiornati e standard editoriali. Usa dati strutturati JSON-LD con schema Organization, Product, FAQPage, HowTo, Review e Article. Aggiungi blocchi Q&A per le intenzioni ad alto rischio, crea pagine canoniche che consolidano le informazioni e sviluppa contenuti degni di citazione che i sistemi AI tendono a referenziare.

Bloccare i crawler riduce la tua presenza nelle risposte AI ma protegge i contenuti sensibili. Una strategia bilanciata consente ai crawler di accedere alle principali pagine prodotto e ai contenuti autorevoli, bloccando documentazione interna e contenuti frequentemente abusati. GPTBot di OpenAI e PerplexityBot rispettano le direttive robots.txt, dandoti controllo granulare su cosa alimenta i sistemi AI.

Monitora MTTD/MTTR (tempo medio di rilevamento/risoluzione) per risposte dannose in base alla gravità, accuratezza del sentiment nelle risposte AI, quota di citazioni autorevoli rispetto ai concorrenti, quota di visibilità in AI Overviews e risultati Perplexity, ed efficacia nell’escalation (percentuale di risoluzioni entro SLA). Queste metriche dimostrano se i tuoi processi di monitoraggio e risposta stanno migliorando e giustificano l’investimento nella brand safety.

Proteggi la reputazione del tuo brand con il monitoraggio in tempo reale su Google AI Overviews, ChatGPT e Perplexity. Individua le allucinazioni prima che danneggino la tua reputazione.

Scopri cos'è l'allucinazione dell'IA, perché si verifica in ChatGPT, Claude e Perplexity, e come rilevare informazioni false generate dall'IA nei risultati di r...

L'allucinazione AI si verifica quando i LLM generano informazioni false o fuorvianti con sicurezza. Scopri cosa causa le allucinazioni, il loro impatto sul moni...

Scopri cos'è il monitoraggio delle allucinazioni AI, perché è essenziale per la sicurezza del marchio e come metodi di rilevamento come RAG, SelfCheckGPT e LLM-...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.