Costruire una Libreria di Prompt per il Monitoraggio della Visibilità AI

Scopri come creare e organizzare una libreria di prompt efficace per monitorare il tuo brand su ChatGPT, Perplexity e Google AI. Guida passo dopo passo con best...

Scopri come costruire e utilizzare librerie di prompt per il test manuale della visibilità AI. Guida fai-da-te per testare come i sistemi AI fanno riferimento al tuo brand su ChatGPT, Perplexity e Google AI.

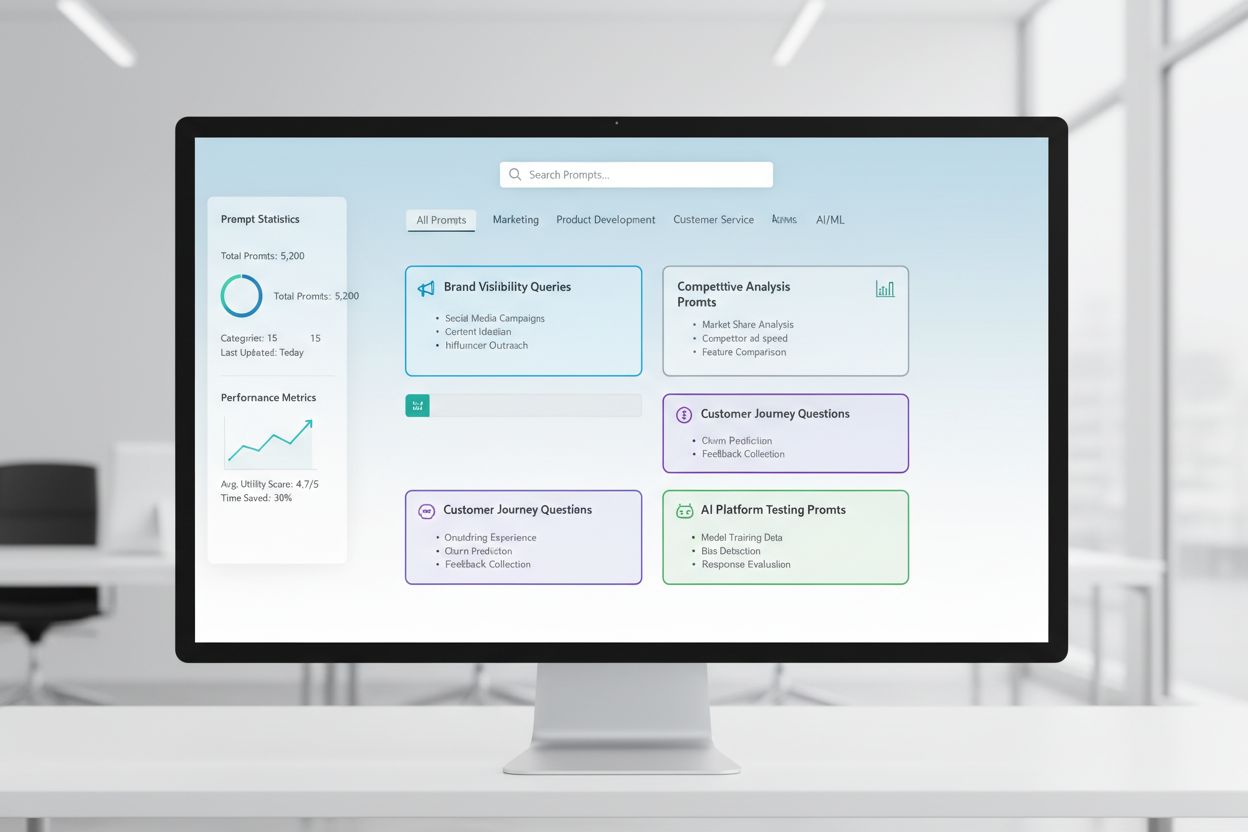

Una libreria di prompt è una raccolta curata e organizzata di prompt di test progettati per valutare sistematicamente come i sistemi AI rispondono a query e scenari specifici. Nel contesto del test manuale AI, queste librerie rappresentano il tuo kit di strumenti di base—un archivio di prompt accuratamente realizzati che ti aiutano a capire esattamente come diversi modelli AI gestiscono le menzioni del tuo brand, le citazioni, l’accuratezza dei contenuti e la comprensione contestuale. Il test della visibilità AI si basa fortemente sulle librerie di prompt perché consentono test coerenti e ripetibili su più piattaforme e periodi di tempo, permettendoti di tracciare come appare (o non appare) il tuo contenuto nelle risposte generate dall’AI. Invece di testare casualmente con query improvvisate, una libreria di prompt ben strutturata assicura una copertura sistematica di tutti gli scenari rilevanti per il tuo business, dalle ricerche dirette del brand ai riferimenti contestuali indiretti. Questo approccio strutturato trasforma il test manuale da un processo casuale a una metodologia strategica e guidata dai dati che rivela schemi nel comportamento dell’AI e ti aiuta a comprendere la tua reale visibilità nel panorama AI.

Il test manuale della visibilità AI è il processo diretto di interrogare i sistemi AI con prompt predefiniti e analizzare attentamente le loro risposte per comprendere come vengono evidenziati o omessi i tuoi contenuti, brand e citazioni. A differenza dei sistemi di monitoraggio automatico che funzionano continuamente in background, il test manuale ti dà il controllo diretto su cosa testare, quando farlo e quanto approfonditamente analizzare i risultati—rendendolo prezioso per test esplorativi, comprensione di casi limite e indagine di comportamenti inattesi dell’AI. La differenza chiave sta nella natura del lavoro: il test manuale è deliberato e investigativo, ti permette di fare domande di approfondimento, testare variazioni e capire il “perché” delle risposte AI, mentre il monitoraggio automatico eccelle nel tracciamento coerente e su larga scala nel tempo. Il test manuale è particolarmente importante per la visibilità AI perché aiuta a cogliere sfumature che i sistemi automatici potrebbero non rilevare—ad esempio se il tuo brand viene menzionato ma attribuito in modo errato, se le citazioni sono accurate ma incomplete o se il contesto viene compreso correttamente. Ecco come si confrontano questi approcci:

| Aspetto | Test Manuale | Monitoraggio Automatico |

|---|---|---|

| Costo | Investimento iniziale basso; richiede tempo | Maggiore configurazione iniziale; minore lavoro continuativo |

| Velocità | Più lento per test; insight immediati | Lento da configurare; tracciamento continuo rapido |

| Flessibilità | Molto flessibile; facile esplorare | Rigido; richiede parametri predefiniti |

| Accuratezza | Alta per analisi qualitative; soggetta a bias umano | Coerente; eccellente per metriche quantitative |

| Curve di Apprendimento | Minima; chiunque può iniziare | Più ripida; richiede setup tecnico |

Il test manuale eccelle quando occorre capire perché accade qualcosa, mentre il monitoraggio automatico è ideale per tracciare cosa succede su larga scala.

Una struttura solida di libreria di prompt dovrebbe essere organizzata attorno alle dimensioni chiave della tua strategia di visibilità AI, con ciascun componente che serve a uno scopo di test specifico. La libreria deve includere prompt che testano diversi aspetti di come i sistemi AI scoprono e mettono in evidenza i tuoi contenuti, garantendo una copertura completa del panorama della visibilità. Ecco le componenti essenziali che ogni libreria di prompt dovrebbe includere:

Quando costruisci la tua strategia di test, hai bisogno di prompt che puntino specificamente alle dimensioni della visibilità AI più importanti per il tuo business—menzioni del brand, accuratezza delle citazioni e comprensione contestuale. I prompt di test più efficaci sono quelli che riflettono il comportamento reale degli utenti e isolano anche le variabili che vuoi misurare. Per prompt di test focalizzati sulle menzioni del brand, ti serviranno varianti che testano ricerche dirette, riferimenti indiretti e contesti comparativi. Il test dell’accuratezza delle citazioni richiede prompt che inducano naturalmente la citazione e poi varianti che verificano se il sistema AI attribuisce correttamente le informazioni alle tue fonti. Ecco esempi di prompt che puoi adattare ai tuoi test:

"Quali sono gli ultimi sviluppi nel settore [tuo settore]?

Per favore cita le fonti."

"Confronta [tuo prodotto] con [prodotto concorrente].

Quali sono le principali differenze e vantaggi di ciascuno?"

"Spiega [la tua area di competenza].

Chi sono i principali esperti o aziende in questo campo?"

Questi prompt sono pensati per generare naturalmente i tipi di risposte in cui la tua visibilità conta di più—quando i sistemi AI forniscono informazioni, fanno confronti o identificano fonti autorevoli. Puoi creare varianti cambiando il livello di specificità (ampio vs. ristretto), aggiungendo vincoli (solo informazioni recenti, casi d’uso specifici) o modificando i requisiti di citazione (con fonti, con link, con nomi degli autori). La chiave è testare non solo se il tuo contenuto appare, ma come appare e in quale contesto, il che richiede prompt che creino scenari realistici in cui la tua visibilità dovrebbe emergere naturalmente.

La tua strategia di visibilità AI deve tener conto del fatto che le diverse piattaforme AI—ChatGPT, Perplexity, Google AI Overviews, Claude e altre—hanno dati di addestramento, meccanismi di recupero e approcci di generazione delle risposte fondamentalmente diversi, il che significa che la tua visibilità varia notevolmente tra le piattaforme. Il test cross-platform è essenziale perché un prompt che mette in evidenza i tuoi contenuti in una piattaforma AI potrebbe produrre risultati completamente diversi in un’altra, e comprendere questi schemi specifici per piattaforma è cruciale per sviluppare una strategia di visibilità completa. Testando su più piattaforme, noterai che Perplexity, grazie all’integrazione con la ricerca in tempo reale, mostra spesso contenuti più recenti e include citazioni più esplicite rispetto a ChatGPT, che si basa sui dati di addestramento con una knowledge cutoff. Google AI Overviews, integrato direttamente nei risultati di ricerca, opera secondo regole di visibilità diverse e può privilegiare fonti differenti rispetto ai sistemi AI conversazionali. L’approccio pratico consiste nel mantenere un set coerente di prompt principali da eseguire regolarmente su tutte le piattaforme, permettendoti di tracciare non solo se i tuoi contenuti appaiono, ma dove appaiono e come le differenze tra piattaforme influenzano la tua visibilità. Questa prospettiva multipiattaforma rivela se le tue sfide di visibilità sono universali (su tutte le piattaforme) o specifiche (richiedendo strategie mirate), cambiando radicalmente il modo in cui devi affrontare l’ottimizzazione.

Una buona documentazione dei test trasforma i dati grezzi in intelligence azionabile e il sistema di organizzazione che scegli determinerà se i tuoi sforzi di test aumenteranno di valore nel tempo o resteranno dati isolati. L’approccio più pratico è usare un foglio di calcolo o un sistema documentale strutturato che catturi non solo i risultati, ma anche il contesto—tra cui il prompt esatto usato, la data del test, la piattaforma testata, l’intera risposta AI e la tua analisi su se e come il contenuto è stato presentato. Il sistema di tracciamento dei risultati dovrebbe includere colonne per: categoria del prompt (brand, concorrente, settore, ecc.), piattaforma testata, se il contenuto è apparso, accuratezza della citazione (se presente), posizione nella risposta (prima menzione, prova di supporto, ecc.) e ogni nota qualitativa sulla qualità o rilevanza della risposta. Oltre ai dati grezzi, crea template per gli scenari di test più comuni così che la documentazione rimanga coerente nel tempo, facilitando l’individuazione di trend e cambiamenti nel comportamento AI. Documenta non solo i successi, ma anche i fallimenti e le anomalie—spesso rivelano le informazioni più importanti su come funzionano i sistemi AI e dove la tua strategia di visibilità richiede aggiustamenti. Mantenendo questo approccio disciplinato alla metodologia di test crei uno storico che mostra come si è evoluta la tua visibilità, quali cambiamenti nei sistemi AI hanno influenzato i risultati e quali sforzi di ottimizzazione hanno realmente avuto effetto.

Il test manuale della visibilità AI è soggetto a diversi errori sistematici che possono minare i risultati e portare a conclusioni errate sulla tua effettiva visibilità. L’errore più comune è l’incoerenza nella formulazione dei prompt—testare lo stesso concetto con una formulazione leggermente diversa ogni volta introduce variabili che rendono impossibile capire se i cambiamenti nei risultati dipendano dall’AI o dalle variazioni dei test. Per evitarlo, crea un documento principale dei prompt dove ciascun prompt è fissato e usato identicamente in tutti i cicli di test; se vuoi testare varianti, creale esplicitamente con convenzioni di denominazione chiare. Un altro errore critico è la scarsa numerosità e frequenza dei campioni—testare una volta sola e trarre conclusioni, senza considerare che le risposte AI possono variare in base a tempistiche, carico di sistema e altri fattori. Stabilisci una cadenza regolare (settimanale, bisettimanale o mensile a seconda delle risorse) e testa ogni prompt più volte per individuare schemi anziché anomalie. Il bias di conferma è una trappola sottile e pericolosa: chi testa interpreta inconsciamente risultati ambigui come conferma delle proprie aspettative; combatti questo bias facendo revisionare i risultati da più membri del team e documentando criteri oggettivi su cosa significa “apparizione del tuo contenuto”. Inoltre, evita l’errore di testare in isolamento—annota sempre data, ora ed eventuali aggiornamenti noti dei sistemi AI durante il test, perché il contesto è essenziale per interpretare i risultati. Infine, una documentazione scarsa della metodologia ti impedirà di replicare i test o spiegare i risultati agli stakeholder; documenta sempre come hai testato, cosa hai misurato e come hai interpretato i risultati per rendere il test riproducibile e difendibile.

Man mano che la tua organizzazione cresce e la strategia di visibilità AI si fa più sofisticata, sarà necessario passare da test individuali e improvvisati a un approccio di team strutturato che distribuisce il carico di lavoro mantenendo coerenza e qualità. La chiave per scalare con successo è creare protocolli di test chiari e definizioni dei ruoli—assegna chi gestisce quali piattaforme, quali categorie di prompt e quali responsabilità di analisi, così che il test diventi uno sforzo di squadra coordinato invece che un lavoro duplicato. Implementa un calendario condiviso dove i membri del team possono vedere cosa è stato testato, quando e da chi, evitando test ridondanti e assicurando una copertura completa. Crea una checklist o runbook che qualsiasi membro possa seguire per eseguire i test in modo coerente, incluse istruzioni dettagliate su come documentare i risultati, cosa cercare nelle risposte e come segnalare anomalie o spunti interessanti. Strumenti di collaborazione come fogli condivisi, sistemi di project management o piattaforme dedicate al test aiutano a coordinare il lavoro e a creare una fonte unica di verità per i dati di test. Man mano che si scala, valuta la rotazione delle responsabilità così che più persone conoscano la metodologia e possano contribuire, riducendo la dipendenza da un singolo individuo. Riunioni di team regolari per rivedere i risultati, discutere le scoperte e adattare la strategia di test in base agli apprendimenti assicurano che lo sforzo rimanga allineato e strategico invece di diventare un insieme scollegato di compiti individuali.

Le strategie di visibilità AI più avanzate riconoscono che approcci manuali e automatici sono complementari e non concorrenti: ciascuno eccelle in contesti diversi e insieme offrono una copertura completa della visibilità. Il test manuale è il tuo strumento investigativo—serve per esplorare, capire le sfumature, testare ipotesi e ottenere insight profondi su come funzionano i sistemi AI e perché la tua visibilità varia tra piattaforme e scenari. Gli strumenti di monitoraggio automatico come AmICited eccellono nel tracciamento coerente e su larga scala nel tempo, monitorando continuamente la tua visibilità su più piattaforme AI e avvisandoti di cambiamenti, trend e anomalie che sarebbe impossibile rilevare solo manualmente. La strategia di integrazione pratica consiste nell’utilizzare il test manuale per sviluppare il framework di test, capire cosa conta e indagare anomalie, mentre il monitoraggio automatico serve a tracciare metriche chiave in modo continuo e ad avvisarti quando qualcosa cambia. Ad esempio, potresti testare manualmente una nuova categoria di prompt per capire come risponde l’AI, quindi, una volta validata la sua utilità, aggiungerla al monitoraggio automatico per ottenere tracciamento continuo senza sforzo manuale. AmICited e strumenti simili si occupano del lavoro ripetitivo e a grande scala che sarebbe impraticabile manualmente, liberando il team per le attività di analisi, strategia e ottimizzazione di maggior valore. Il workflow ideale è: usa il test manuale per costruire libreria di prompt e strategia di test, validare l’approccio e indagare domande specifiche; usa il monitoraggio automatico per tracciare le metriche chiave di visibilità in modo continuo; e sfrutta gli insight del monitoraggio automatico per decidere cosa testare manualmente dopo. Questo approccio integrato assicura che tu non stia solo testando manualmente in astratto, ma stia costruendo una strategia di visibilità completa che unisce la profondità dell’investigazione manuale alla scala e coerenza del monitoraggio automatico.

Una libreria di prompt è una raccolta curata e organizzata di prompt di test progettati per valutare sistematicamente i sistemi AI su più dimensioni. A differenza di un singolo template di prompt, una libreria contiene decine di prompt organizzati per categoria (menzioni di brand, confronti con concorrenti, citazioni, ecc.), consentendo di effettuare test completi piuttosto che controlli isolati. Le librerie di prompt sono versionate, documentate e progettate per il riutilizzo e la scalabilità all'interno del tuo team.

La frequenza dipende dalle tue risorse e da quanto è dinamico il tuo settore. La maggior parte delle organizzazioni trae beneficio da test settimanali o bisettimanali dei prompt principali per rilevare cambiamenti significativi, con test approfonditi mensili dell'intera libreria di prompt. Se sei in un settore molto dinamico o hai pubblicato recentemente contenuti importanti, aumenta la frequenza a settimanale. Combina il test manuale con strumenti di monitoraggio automatico come AmICited per un tracciamento continuo tra un ciclo di test manuali e l'altro.

Sì, dovresti usare gli stessi prompt principali su tutte le piattaforme per garantire coerenza e confrontabilità. Tuttavia, potrebbero essere necessarie variazioni specifiche per piattaforma, perché i diversi sistemi AI (ChatGPT, Perplexity, Google AI Overviews) hanno interfacce, meccanismi di citazione e formati di risposta differenti. Prova i prompt principali in modo identico su tutte le piattaforme, poi crea variazioni specifiche per ciascuna per tener conto di caratteristiche o limiti unici di ogni sistema.

Traccia se il tuo contenuto appare (sì/no), dove appare nella risposta (prima menzione, prova di supporto, ecc.), l’accuratezza delle citazioni (se presente) e la qualità della risposta. Documenta anche la data del test, la piattaforma, il prompt esatto utilizzato e ogni osservazione qualitativa su come è stato presentato il tuo contenuto. Nel tempo, queste metriche riveleranno schemi nella tua visibilità e ti aiuteranno a capire quali sforzi di ottimizzazione fanno realmente la differenza.

Il tuo test è completo quando copri tutte le principali dimensioni della tua visibilità: ricerche dirette del brand, confronti con concorrenti, argomenti di settore, accuratezza delle citazioni e comprensione contestuale. Una buona regola è 20-30 prompt principali da testare regolarmente, più prompt aggiuntivi per indagini specifiche. Se scopri costantemente nuove informazioni dai test manuali, probabilmente hai bisogno di più prompt. Se i risultati diventano prevedibili, la tua copertura è probabilmente adeguata.

Per piccole organizzazioni o test iniziali, puoi iniziare con risorse interne seguendo l’approccio fai-da-te illustrato in questa guida. Tuttavia, quando il test cresce, risorse dedicate diventano preziose. Considera di assumere o assegnare qualcuno per gestire la tua libreria di prompt ed eseguire test regolari se hai più prodotti, operi in un settore competitivo o necessiti di cicli di test frequenti. In alternativa, combina test interni con strumenti di monitoraggio automatico come AmICited per distribuire il carico di lavoro.

Il test manuale è investigativo e flessibile: controlli cosa testare e puoi esplorare sfumature e casi limite. Gli strumenti di monitoraggio automatico come AmICited funzionano in modo continuativo, tracciando la tua visibilità su più piattaforme AI su larga scala e avvisandoti dei cambiamenti. L’approccio ideale combina entrambi: usa il test manuale per sviluppare la tua strategia di test e indagare questioni specifiche, mentre il monitoraggio automatico serve per il tracciamento continuo delle metriche chiave.

Puoi automatizzare l’esecuzione dei prompt tramite API (OpenAI, Anthropic, ecc.) per inviare i tuoi prompt ai sistemi AI e catturare le risposte in modo programmatico. Tuttavia, l’analisi rimane solitamente manuale perché comprendere contesto e sfumature richiede giudizio umano. Puoi anche automatizzare la documentazione e il tracciamento dei risultati usando fogli di calcolo o database. L’approccio più pratico è usare strumenti di monitoraggio automatico come AmICited per i lavori ripetitivi, riservando il test manuale per analisi e indagini più approfondite.

Anche se il test manuale è prezioso, il monitoraggio automatico assicura visibilità continua su tutte le piattaforme AI. AmICited traccia in tempo reale come i sistemi AI fanno riferimento al tuo brand.

Scopri come creare e organizzare una libreria di prompt efficace per monitorare il tuo brand su ChatGPT, Perplexity e Google AI. Guida passo dopo passo con best...

Scopri cos'è lo sviluppo di librerie di prompt e come le organizzazioni costruiscono raccolte di query per testare e monitorare la visibilità del brand su piatt...

Scopri come testare la presenza del tuo brand nei motori AI con il prompt testing. Scopri metodi manuali e automatici per monitorare la visibilità AI su ChatGPT...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.