Scheda di Riferimento AI Crawler: Tutti i Bot a Colpo d'Occhio

Guida di riferimento completa ai crawler e bot AI. Identifica GPTBot, ClaudeBot, Google-Extended e oltre 20 altri crawler AI con user agent, frequenze di scansi...

Scopri come ottimizzare le sitemap XML per i crawler AI come GPTBot e ClaudeBot. Apprendi le best practice per migliorare la visibilità nelle risposte AI e l’indicizzazione da parte dei LLM.

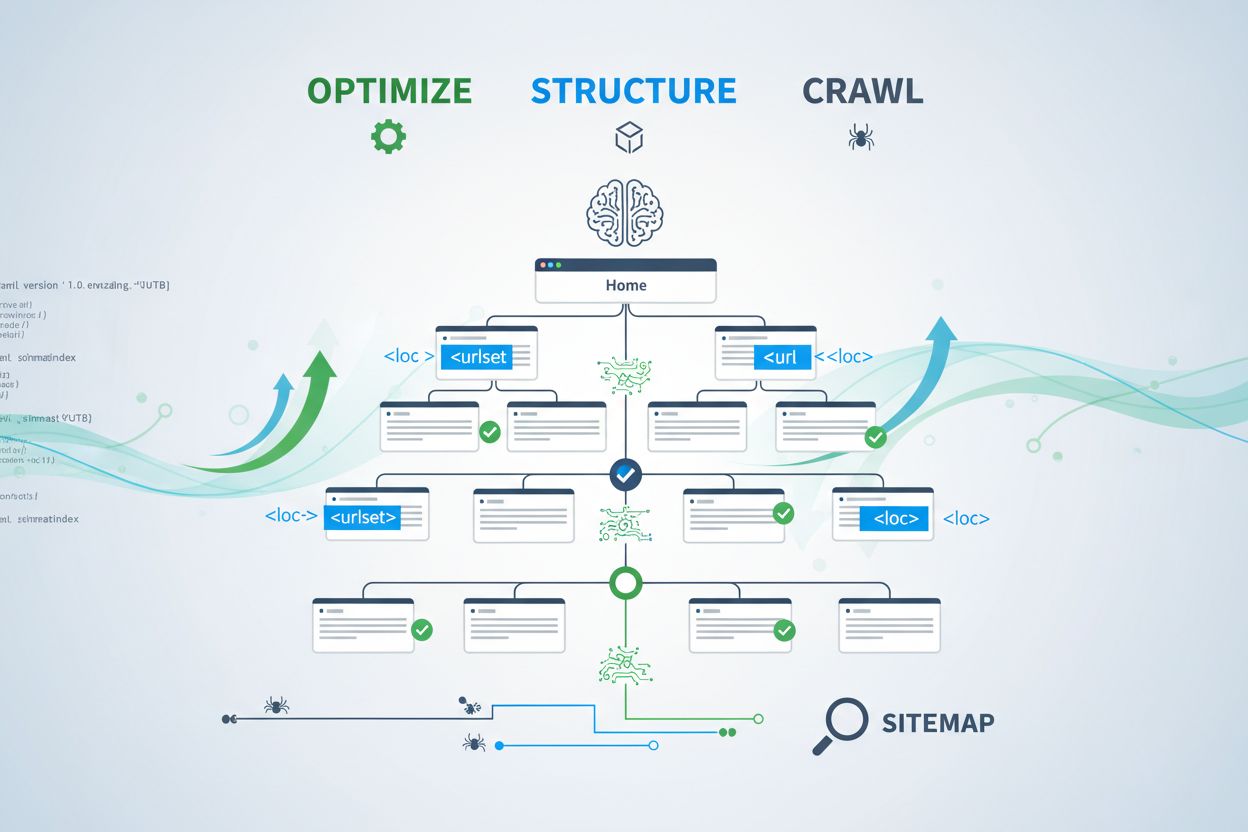

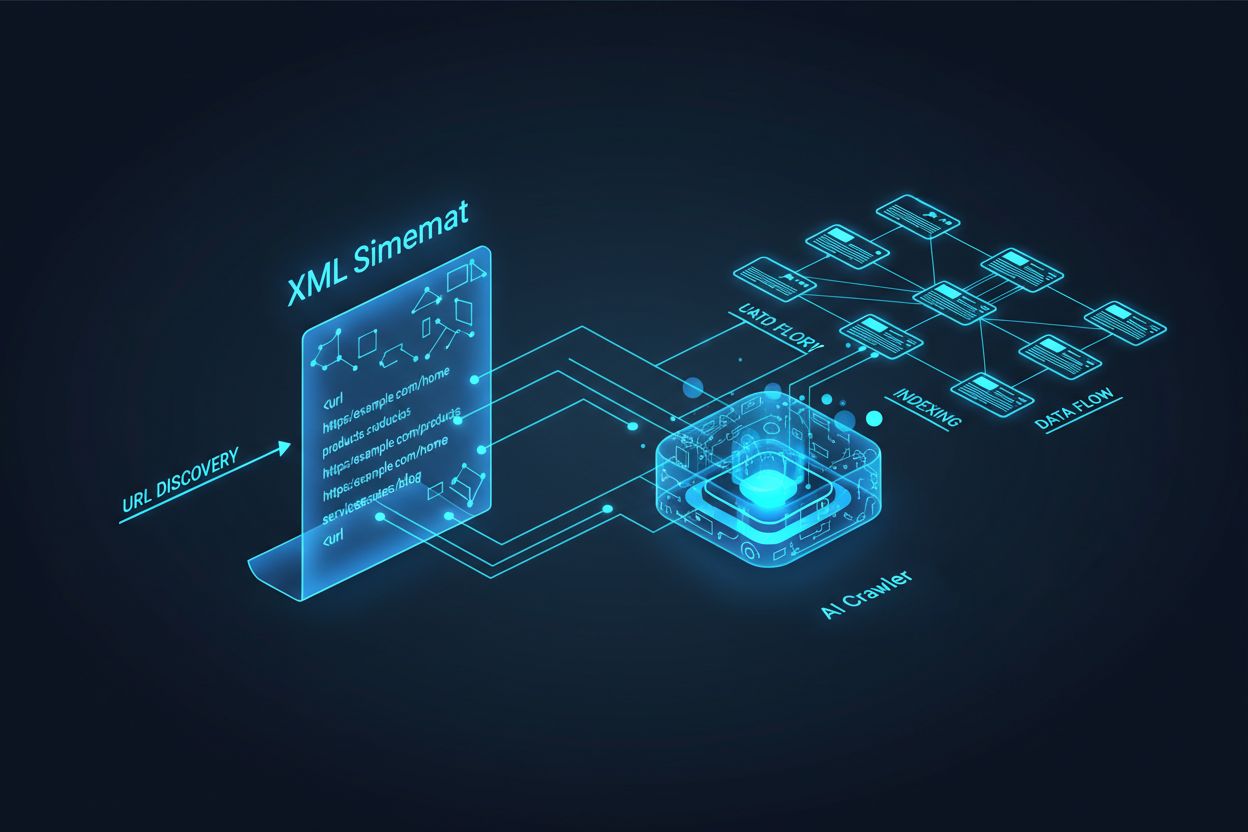

I crawler AI come GPTBot, ClaudeBot e PerplexityBot operano in modo fondamentalmente diverso rispetto ai bot dei motori di ricerca tradizionali. Mentre Googlebot indicizza le pagine per posizionarle nei risultati di ricerca, i crawler AI estraggono conoscenza per addestrare e informare i modelli linguistici di grandi dimensioni che alimentano la ricerca conversazionale e le risposte generate dall’intelligenza artificiale. Senza una sitemap XML adeguatamente ottimizzata, i tuoi contenuti restano invisibili a questi sistemi cruciali, a prescindere dalla qualità o autorevolezza del testo. Considera la sitemap come una mappa che indica ai sistemi AI dove si trovano i contenuti più preziosi e come sono organizzati.

La distinzione tra i crawler di ricerca tradizionali e quelli AI è essenziale per capire perché oggi l’ottimizzazione della sitemap è più importante che mai. I motori di ricerca tradizionali come Google si concentrano sul posizionamento delle singole pagine per determinate keyword, mentre i crawler AI danno priorità alla raccolta della conoscenza e alla comprensione semantica. Ecco le differenze:

| Aspetto | Crawler tradizionali (Googlebot) | Crawler AI (GPTBot, ClaudeBot) |

|---|---|---|

| Scopo principale | Posizionare le pagine nei risultati di ricerca | Estrarre conoscenza per l’addestramento LLM e risposte in tempo reale |

| Focus | Metadata, link interni, segnali di ranking | Struttura dei contenuti, significato semantico, densità informativa |

| Priorità di scansione | Basata su PageRank e freschezza | Basata su autorevolezza, rilevanza tematica e valore conoscitivo |

| Impatto delle citazioni | Porta traffico tramite link blu | Determina se i tuoi contenuti appaiono nelle risposte AI |

| Gestione JavaScript | Esegue e renderizza JavaScript | Spesso ignora JavaScript; dà priorità all’HTML lato server |

Questa differenza fondamentale significa che ottimizzare solo per la SEO tradizionale non è più sufficiente. La tua sitemap ora deve assolvere a una doppia funzione: aiutare i motori di ricerca tradizionali a comprendere la struttura del sito e allo stesso tempo guidare i sistemi AI verso i tuoi asset di conoscenza più preziosi.

Una sitemap XML funziona come il progetto del tuo sito web, indicando esplicitamente ai crawler quali pagine esistono e come sono collegate alla tua strategia di contenuti. Per i sistemi AI, le sitemap hanno un ruolo ancora più critico rispetto alla ricerca tradizionale. I crawler AI utilizzano le sitemap per comprendere l’architettura tematica del sito, identificare i contenuti prioritari e stabilire quali pagine meritano un’analisi approfondita. Quando la sitemap è completa e ben organizzata, i sistemi AI possono scoprire ed esaminare in modo più efficiente i tuoi contenuti per includerli nelle risposte generative. Al contrario, una sitemap incompleta o obsoleta crea zone d’ombra che impediscono ai sistemi AI di individuare le pagine più importanti. L’impatto è diretto: le pagine non presenti nella sitemap hanno molte meno probabilità di essere citate dai sistemi AI, indipendentemente dalla loro qualità o rilevanza.

Creare una sitemap efficace per i crawler AI richiede più che elencare semplicemente tutti gli URL del sito. La sitemap deve essere curata strategicamente per includere solo le pagine che offrono reale valore agli utenti e ai sistemi AI. Ecco le best practice essenziali:

Una sitemap ben strutturata funge da filtro di qualità, segnalando ai sistemi AI che i tuoi contenuti sono stati selezionati con cura e che ogni URL incluso merita attenzione. Questo approccio strategico aumenta sensibilmente le probabilità di essere selezionati per le citazioni nelle risposte AI.

La recentezza è uno dei fattori di ranking più forti nei sistemi di ricerca AI. Quando i crawler AI valutano quali fonti citare nelle risposte generate, danno grande peso alla freschezza dei contenuti. Il timestamp lastmod nella sitemap XML è il segnale principale che comunica ai sistemi AI quando i tuoi contenuti sono stati aggiornati. Timestamp obsoleti o mancanti possono portare persino contenuti autorevoli a essere declassati in favore di fonti più recenti. Se la tua sitemap mostra che una pagina non viene aggiornata da anni, i sistemi AI possono considerare le informazioni obsolete e preferire i contenuti dei concorrenti. Al contrario, timestamp lastmod accurati che riflettono aggiornamenti reali segnalano ai crawler AI che le tue informazioni sono attuali e affidabili. Per argomenti sensibili al tempo come prezzi, normative o tendenze di settore, mantenere timestamp accurati diventa ancora più fondamentale. L’aggiornamento automatico tramite il CMS garantisce che ogni modifica ai contenuti sia subito riflessa nella sitemap, massimizzando la visibilità nelle risposte AI.

Se le sitemap invitano i crawler a indicizzare i tuoi contenuti, i file robots.txt controllano quali parti del sito possono essere scansionate. Questi due file devono lavorare in armonia per massimizzare la visibilità AI. Un errore comune è creare una sitemap completa mentre si bloccano i crawler AI nel robots.txt, generando una contraddizione che confonde i crawler e riduce la visibilità. Il tuo robots.txt dovrebbe consentire esplicitamente l’accesso ai principali crawler AI come GPTBot, ClaudeBot e PerplexityBot. Puoi usare robots.txt in modo strategico per bloccare solo le pagine che non devono essere indicizzate, come le dashboard amministrative, le pagine di login o le versioni duplicate dei contenuti. La chiave è assicurarsi che le regole del robots.txt siano allineate con la strategia sitemap—se una pagina è nella sitemap, dovrebbe essere accessibile anche secondo le regole robots.txt. Revisioni regolari di entrambi i file aiutano a individuare configurazioni errate che potrebbero limitare silenziosamente la visibilità AI.

Le strategie di ottimizzazione AI più efficaci trattano sitemap e dati strutturati come sistemi complementari che si rafforzano a vicenda. Quando la sitemap evidenzia una pagina come importante e quella pagina include schema markup rilevante, invii segnali coerenti ai crawler AI circa lo scopo e il valore della pagina. Ad esempio, se la sitemap dà priorità a una guida how-to, quella pagina dovrebbe includere il markup HowTo che fornisce informazioni strutturate sui passaggi. Allo stesso modo, le pagine prodotto nella sitemap dovrebbero includere Product schema con prezzo, disponibilità e recensioni. Questo allineamento crea un quadro dati coerente che i sistemi AI possono facilmente interpretare e di cui si possono fidare. Quando sitemap e dati strutturati sono in conflitto o divergono, i crawler AI diventano incerti sul vero scopo della pagina, riducendo la probabilità di citazione. Assicurando che la strategia sitemap sia allineata con l’implementazione dello schema, crei un segnale unificato che migliora drasticamente le possibilità di essere selezionati per le risposte AI.

Tipi di contenuti diversi richiedono strategie sitemap differenti per massimizzare la visibilità AI. Post del blog, pagine prodotto, descrizioni di servizi e contenuti FAQ hanno scopi diversi e vanno ottimizzati di conseguenza:

| Tipo di contenuto | Strategia sitemap | Schema markup consigliato | Considerazioni di priorità |

|---|---|---|---|

| Post & articoli blog | Includi con date di pubblicazione e aggiornamento accurate | Article, NewsArticle, BlogPosting | Dai priorità ai contenuti recenti e evergreen; aggiorna regolarmente lastmod |

| Pagine prodotto | Includi con aggiornamenti inventario; valuta sitemap prodotto separata | Product, Offer, AggregateRating | Evidenzia i bestseller e i nuovi prodotti; aggiorna spesso i prezzi |

| Pagine servizi | Includi con date aggiornamento dei servizi | Service, LocalBusiness, ProfessionalService | Dai priorità ai servizi principali; aggiorna disponibilità e prezzi |

| Pagine FAQ | Includi con date aggiornamento contenuti | FAQPage, Question, Answer | Dai priorità alle FAQ complete; aggiorna le risposte quando cambiano le informazioni |

| Contenuti video | Includi nella video sitemap con thumbnail e durata | VideoObject, Video | Includi trascrizioni; aggiorna visualizzazioni e metriche di coinvolgimento |

| Contenuti immagine | Includi nella image sitemap con didascalie | ImageObject, Product (per immagini prodotto) | Ottimizza alt text; includi didascalie descrittive |

Questo approccio differenziato assicura che ogni tipo di contenuto riceva l’ottimizzazione adeguata per la scoperta AI. Personalizzando la strategia sitemap in base al mix di contenuti, massimizzi la probabilità che i sistemi AI trovino e citino i tuoi asset più preziosi.

Lo standard llms.txt, proposto a fine 2024, rappresenta un approccio sperimentale per aiutare i sistemi AI a comprendere la struttura dei siti. A differenza delle sitemap XML, llms.txt è un file in formato Markdown che fornisce un indice leggibile dall’uomo per il tuo sito. Elenca le pagine e le risorse più importanti in un formato più facilmente interpretabile dai modelli linguistici. Sebbene il concetto sia promettente, le evidenze attuali suggeriscono che llms.txt abbia un impatto minimo sulla visibilità AI rispetto alle sitemap XML tradizionali. I principali crawler AI come GPTBot e ClaudeBot continuano a basarsi soprattutto sulle sitemap XML per la scoperta degli URL e i segnali di recentezza. Invece di sostituire la sitemap XML, llms.txt dovrebbe essere visto come uno strumento supplementare che può fornire contesto aggiuntivo ai sistemi AI. Se implementi llms.txt, assicurati che integri e non sostituisca la strategia sitemap principale, e concentrati prima di tutto sulla perfezione della sitemap XML con timestamp accurati e cura strategica dei contenuti.

Anche i siti più attenti commettono spesso errori critici nella gestione delle sitemap che limitano silenziosamente la visibilità AI. Comprendere ed evitare questi errori è essenziale per massimizzare la presenza nelle risposte AI:

Affrontare questi errori comuni può migliorare immediatamente la visibilità AI. Inizia controllando la tua sitemap attuale con questa checklist e correggendo eventuali problemi riscontrati.

Mantenere una sitemap ottimizzata richiede monitoraggio e validazione continui. Diversi strumenti possono aiutarti a garantire che la sitemap resti efficace per i crawler AI. Google Search Console offre la validazione integrata della sitemap e mostra quanti URL sono stati indicizzati da Google. Screaming Frog SEO Spider permette di scansionare l’intero sito e confrontare i risultati con la sitemap, identificando URL mancanti o interrotti. I validator di sitemap XML controllano la sintassi e la conformità al protocollo. Per le grandi aziende, piattaforme SEO come Semrush e Ahrefs includono funzioni di analisi della sitemap che tracciano i cambiamenti nel tempo. Revisioni regolari—idealmente mensili—aiutano a individuare i problemi prima che impattino la visibilità AI. Imposta promemoria per controllare la sitemap ogni volta che apporti modifiche significative ai contenuti, lanci nuove sezioni o aggiorni l’architettura del sito.

Comprendere come i crawler AI interagiscono con la tua sitemap richiede monitoraggio e analisi attivi. I log del server contengono dati preziosi su quali crawler AI visitano il sito, con quale frequenza scansionano e quali pagine danno priorità. Analizzando questi log puoi individuare pattern e ottimizzare di conseguenza la sitemap. Strumenti come AmICited.com aiutano a monitorare quante volte i tuoi contenuti vengono citati da sistemi AI come ChatGPT, Claude, Perplexity e Google AI Overviews, fornendo un feedback diretto sull’efficacia della sitemap. Google Analytics può essere configurato per tracciare referral dai sistemi AI, mostrandoti quali pagine generano più visibilità AI. Correlando questi dati con la struttura sitemap puoi identificare i tipi di contenuto e gli argomenti più apprezzati dai sistemi AI. Questo approccio data-driven ti permette di perfezionare continuamente la strategia sitemap, dando priorità ai contenuti che generano più citazioni e visibilità AI.

Oltre all’ottimizzazione di base, strategie avanzate possono migliorare sensibilmente la visibilità AI. Creare sitemap separate per diversi tipi di contenuti—come sitemap dedicate per blog, prodotti e video—permette di applicare strategie di ottimizzazione specifiche per ciascun tipo. La generazione dinamica della sitemap, con aggiornamenti in tempo reale quando i contenuti cambiano, assicura che i crawler AI vedano sempre i contenuti più aggiornati. Per siti aziendali di grandi dimensioni, implementare gerarchie di sitemap e priorità strategiche aiuta i crawler AI a concentrarsi sui contenuti più preziosi. Alcune organizzazioni creano sitemap specifiche per l’AI che evidenziano solo i contenuti più autorevoli e meritevoli di citazione, segnalando ai sistemi AI quali pagine meritano maggiore attenzione. Integrare la strategia sitemap con il CMS garantisce che l’ottimizzazione avvenga automaticamente invece che richiedere aggiornamenti manuali. Questi approcci avanzati richiedono maggiore competenza tecnica ma possono portare notevoli vantaggi in termini di visibilità AI per chi gestisce ecosistemi di contenuti complessi.

Il panorama dei crawler AI evolve rapidamente, con nuovi crawler che emergono regolarmente e standard come llms.txt in fase di adozione. Rendere a prova di futuro la strategia sitemap significa costruire flessibilità nei sistemi e restare aggiornati sulle novità del settore. Implementa sistemi di generazione sitemap che possano facilmente adattarsi ai requisiti dei nuovi crawler senza necessità di riconfigurazione manuale. Monitora gli annunci delle principali aziende AI su nuovi crawler e aggiorna di conseguenza robots.txt e le strategie sitemap. Considera il valore a lungo termine della visibilità AI rispetto al controllo sui contenuti—sebbene alcune organizzazioni scelgano di bloccare i crawler AI, la tendenza suggerisce che le citazioni AI diventeranno sempre più importanti per la visibilità del brand. Sviluppa policy chiare su come la tua organizzazione gestirà l’accesso dei crawler AI e l’utilizzo dei contenuti. Trattando la sitemap come un documento “vivo” che evolve insieme al panorama AI, garantisci che i tuoi contenuti restino sempre scopribili e citabili man mano che i meccanismi di ricerca e discovery si trasformano.

Dovresti aggiornare la sitemap ogni volta che pubblichi nuovi contenuti o apporti modifiche significative alle pagine esistenti. L'ideale è implementare la generazione automatica della sitemap affinché gli aggiornamenti siano immediati. Per i siti con frequenti cambiamenti, sono consigliati aggiornamenti giornalieri. Per i siti statici sono sufficienti revisioni mensili.

La maggior parte dei principali crawler AI come GPTBot e ClaudeBot rispetta le direttive robots.txt, ma non tutti lo fanno. La best practice è consentire esplicitamente i crawler AI nel tuo file robots.txt invece di affidarsi al comportamento predefinito. Monitora i log del server per verificare che i crawler si comportino come previsto.

Le sitemap XML sono file leggibili dalle macchine che elencano tutti i tuoi URL con metadati come i timestamp lastmod. llms.txt è uno standard più recente basato su Markdown pensato per fornire ai sistemi AI un indice leggibile dall'uomo. Al momento, le sitemap XML sono più importanti per la visibilità AI, mentre llms.txt va considerato supplementare.

Controlla i log del server per user agent come 'GPTBot', 'ClaudeBot', 'PerplexityBot' e 'Google-Extended'. Puoi anche utilizzare strumenti come AmICited.com per monitorare la frequenza con cui i tuoi contenuti vengono citati dai sistemi AI, un chiaro indicatore di scansione e indicizzazione avvenuta.

Sì, creare sitemap separate per blog, prodotti, video e immagini ti permette di applicare strategie di ottimizzazione specifiche per tipo. Questo aiuta anche i crawler AI a comprendere meglio la struttura dei tuoi contenuti e può migliorare l'efficienza della scansione per siti di grandi dimensioni.

Le sitemap XML dovrebbero contenere non più di 50.000 URL per file. Per siti più grandi, utilizza indici sitemap per organizzare più file. I crawler AI gestiscono sitemap grandi, ma suddividerle in sezioni logiche migliora l'efficienza della scansione e facilita la gestione.

I timestamp lastmod segnalano la freschezza dei contenuti ai crawler AI. La recentezza è un forte fattore di ranking nei sistemi AI, quindi timestamp accurati aiutano i tuoi contenuti a competere per le citazioni. Usa sempre sistemi automatici che aggiornino i timestamp solo quando i contenuti cambiano realmente—mai impostare manualmente timestamp falsi.

Sì, una sitemap mal gestita può compromettere sensibilmente la tua visibilità AI. Link interrotti, URL obsoleti, timestamp inaccurati e copertura incompleta riducono le possibilità di essere citati dai sistemi AI. Revisioni e manutenzione regolari sono essenziali per proteggere la tua visibilità AI.

Tieni traccia di quante volte i tuoi contenuti vengono citati da ChatGPT, Claude, Perplexity e Google AI Overviews. Ottimizza la tua strategia sitemap basandoti su dati reali di citazioni AI.

Guida di riferimento completa ai crawler e bot AI. Identifica GPTBot, ClaudeBot, Google-Extended e oltre 20 altri crawler AI con user agent, frequenze di scansi...

Scopri quali crawler AI autorizzare o bloccare nel tuo robots.txt. Guida completa che copre GPTBot, ClaudeBot, PerplexityBot e oltre 25 crawler AI con esempi di...

Scopri come strutturare il tuo sito web per una indicizzazione ottimale da parte dei crawler AI, inclusi HTML semantico, architettura del sito, organizzazione d...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.