Prevenire le crisi di visibilità AI: Strategie proattive

Scopri come prevenire le crisi di visibilità AI con monitoraggio proattivo, sistemi di allerta precoce e protocolli di risposta strategici. Proteggi il tuo marc...

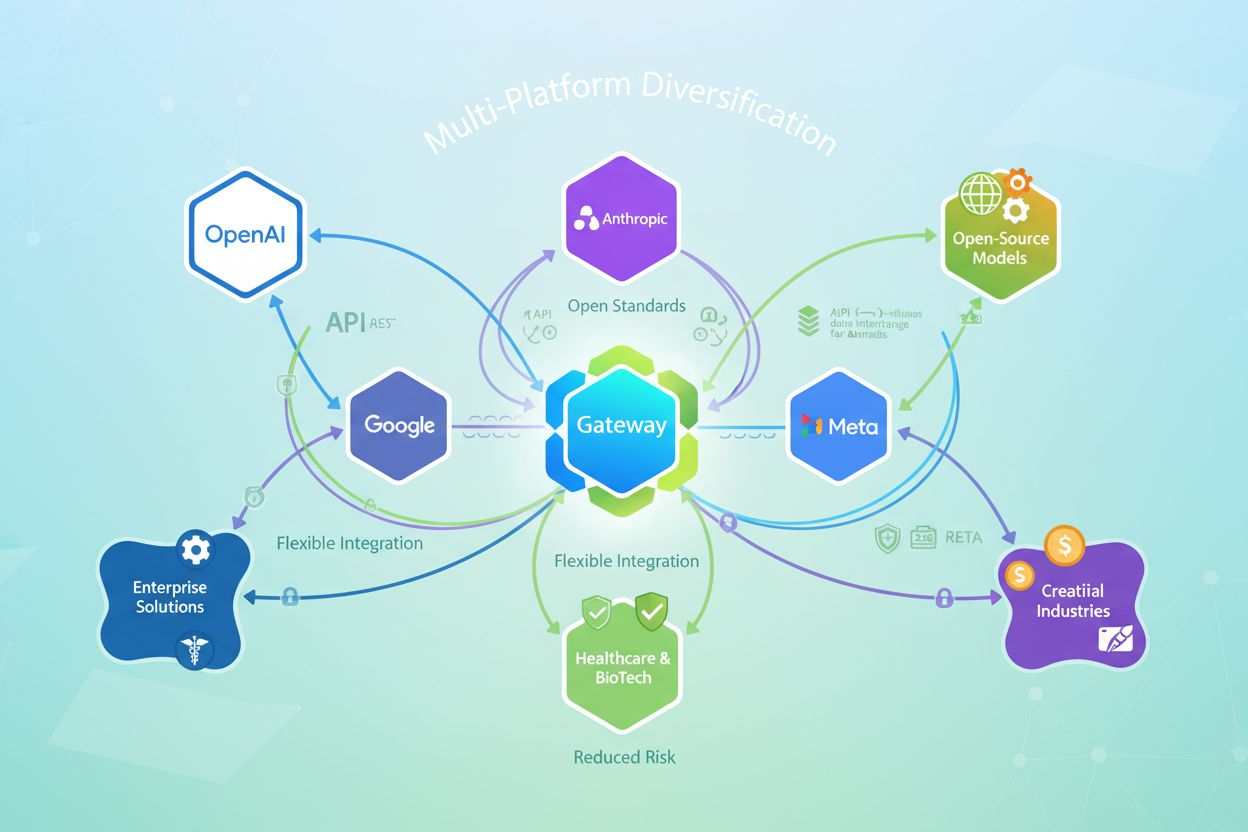

Strategia per costruire visibilità e accesso su più piattaforme AI al fine di ridurre il rischio di dipendenza, ottimizzare i costi e mantenere flessibilità strategica. Le organizzazioni distribuiscono i loro carichi di lavoro AI tra diversi fornitori invece di affidarsi a un unico vendor, ottenendo così maggiore potere negoziale, resilienza migliorata e la possibilità di adottare le soluzioni migliori man mano che emergono.

Strategia per costruire visibilità e accesso su più piattaforme AI al fine di ridurre il rischio di dipendenza, ottimizzare i costi e mantenere flessibilità strategica. Le organizzazioni distribuiscono i loro carichi di lavoro AI tra diversi fornitori invece di affidarsi a un unico vendor, ottenendo così maggiore potere negoziale, resilienza migliorata e la possibilità di adottare le soluzioni migliori man mano che emergono.

Il vendor lock-in si verifica quando un’organizzazione diventa così dipendente da un unico fornitore AI che passare ad alternative diventa impraticabile o proibitivamente costoso. Questa dipendenza si sviluppa gradualmente tramite integrazioni strette, API proprietarie e implementazioni personalizzate che vincolano le applicazioni direttamente all’ecosistema di un vendor. Le conseguenze sono gravi: le organizzazioni perdono potere negoziale, affrontano costi in crescita e non possono adottare modelli o tecnologie superiori man mano che emergono. Una volta bloccati, il cambio di fornitore richiede un’estesa reingegnerizzazione, riaddestramento e spesso ingenti penali finanziarie.

Affidarsi a un’unica piattaforma AI crea molteplici vulnerabilità strategiche che vanno ben oltre la comodità iniziale:

Le piattaforme multi-modello risolvono queste sfide creando uno strato di astrazione tra applicazioni e fornitori AI. Invece che le applicazioni chiamino direttamente le API dei vendor, interagiscono con un’interfaccia unificata gestita dalla piattaforma. Questa architettura abilita routing intelligente, indirizzando le richieste verso i modelli ottimali secondo costi, performance, requisiti di conformità o disponibilità. La piattaforma traduce le richieste nei formati specifici dei fornitori, gestisce autenticazione e sicurezza, e mantiene audit trail completi. Le piattaforme multi-modello enterprise aggiungono capacità critiche di governance: applicazione centralizzata delle policy, protezione dei dati sensibili, controllo accessi basato sui ruoli e osservabilità in tempo reale sull’uso dell’AI in tutta l’organizzazione.

| Dimensione | Single-Provider | Piattaforma Multi-Modello |

|---|---|---|

| Flessibilità Vendor | Legati a un fornitore | Accesso a 100+ modelli da più fornitori |

| Costo | Accordi enterprise: $50K-$500K+ annui | 40-60% di costo inferiore a parità di capacità |

| Governance | Limitata ai controlli del vendor | Policy centralizzate su tutti i fornitori |

| Sicurezza dati | Esposizione diretta al vendor | Strato di protezione dei dati sensibili |

| Costo di switching | Estremamente alto (mesi, milioni) | Minimo (modifica di configurazione) |

| Latenza aggiuntiva | Nessuna | 3-5ms (trascurabile) |

| Conformità | Dipende dal vendor | Personalizzabile sui requisiti |

Le piattaforme multi-modello offrono vantaggi significativi in termini di costo grazie a prezzi competitivi tra fornitori e selezione intelligente dei modelli. Le organizzazioni che adottano piattaforme multi-modello enterprise riportano risparmi del 40-60% rispetto agli accordi single-provider, ottenendo al contempo accesso a modelli superiori e a una governance completa. La piattaforma consente la selezione dinamica del modello: le query semplici vengono indirizzate ai modelli più economici, mentre quelle complesse ai modelli più avanzati e costosi. Il monitoraggio dei costi in tempo reale e la gestione dei budget prevengono spese fuori controllo, mentre la pressione competitiva tra fornitori mantiene condizioni favorevoli. Le organizzazioni possono inoltre negoziare tariffe migliori dimostrando di poter cambiare facilmente vendor, invertendo la dinamica di potere nelle relazioni commerciali.

Le piattaforme multi-modello enterprise implementano livelli protettivi che le soluzioni single-provider non possono eguagliare. I meccanismi di protezione dei dati sensibili rilevano e impediscono che informazioni riservate raggiungano fornitori esterni, mantenendo i dati proprietari all’interno dei confini organizzativi. Audit log completi creano tracciabilità trasparente di ogni interazione AI, supportando la conformità a regolamenti come GDPR, HIPAA e SOC 2. Le organizzazioni possono applicare policy coerenti su tutti i fornitori—regole di uso accettabile, requisiti di trattamento dati e vincoli di conformità—senza dipendere dalle capacità di governance di ogni vendor. Un report del Business Digital Index del 2025 ha rilevato che il 50% dei fornitori AI non soddisfa gli standard base di sicurezza dei dati, rendendo indispensabili strati intermedi di governance per i settori regolamentati. Le piattaforme multi-modello diventano il confine di sicurezza, offrendo una protezione superiore rispetto all’accesso diretto ai fornitori.

La diversificazione delle piattaforme crea resilienza operativa grazie a ridondanza e capacità di failover. Se un fornitore AI subisce outage o degrado delle performance, la piattaforma indirizza automaticamente i carichi di lavoro su fornitori alternativi senza interruzione del servizio. Questa ridondanza è impossibile con approcci single-provider, dove le interruzioni impattano direttamente tutte le applicazioni dipendenti. Le piattaforme multi-modello consentono anche ottimizzazione delle performance monitorando latenza e qualità in tempo reale, selezionando automaticamente il fornitore più veloce o affidabile per ogni richiesta. Le organizzazioni possono testare nuovi modelli in produzione con rischio minimo, spostando gradualmente il traffico su alternative superiori man mano che cresce la fiducia. Il risultato è un’infrastruttura AI affidabile e performante anche in caso di problemi con singoli fornitori.

Una diversificazione sostenibile delle piattaforme dipende dagli standard aperti che prevengono nuove forme di lock-in. Le organizzazioni dovrebbero privilegiare piattaforme che utilizzano API standard (REST, GraphQL) invece di SDK proprietari, garantendo che le applicazioni restino indipendenti dal fornitore. I formati di interscambio dei modelli come ONNX (Open Neural Network Exchange) consentono di spostare modelli addestrati tra framework e piattaforme senza riaddestramento. La portabilità dei dati richiede di archiviare log e metriche in formati aperti—Parquet, JSON, OpenTelemetry—sotto il controllo dell’organizzazione invece di database vincolati ai vendor. Gli standard aperti offrono reale libertà strategica: le organizzazioni possono migrare verso nuove piattaforme, adottare modelli emergenti o gestire infrastrutture in autonomia senza riscrivere le applicazioni. Questo approccio rende le strategie AI a prova di futuro contro cambi di vendor, variazioni di prezzo o discontinuità di mercato.

Una diversificazione efficace delle piattaforme richiede valutazione e governance sistematiche. Le organizzazioni devono valutare le piattaforme rispetto al supporto multi-vendor (si integrano con i principali fornitori e consentono modelli personalizzati?), API e formati dati aperti (è possibile esportare i dati e usare librerie standard?), e flessibilità di deploy (può essere eseguita on-premise o su più cloud?). L’implementazione parte dalla scelta di una piattaforma multi-modello che risponda ai requisiti dell’organizzazione, poi dalla migrazione graduale delle applicazioni verso l’interfaccia unificata della piattaforma. È essenziale definire un framework di governance che stabilisca uso accettabile dell’AI, policy sui dati e requisiti di compliance—la piattaforma applicherà queste policy in modo coerente su tutti i fornitori. La formazione del team assicura che gli sviluppatori comprendano la nuova architettura e possano sfruttare appieno le capacità della piattaforma. Monitoraggio e ottimizzazione continui consentono di individuare opportunità di risparmio, miglioramenti delle performance e nuovi casi d’uso.

Man mano che le organizzazioni si diversificano su più piattaforme AI, mantenere visibilità e controllo diventa fondamentale. AmICited.com rappresenta una soluzione di monitoraggio essenziale pensata per questa sfida, tracciando come i sistemi AI citano il tuo brand e i tuoi contenuti su più piattaforme AI, tra cui ChatGPT, Perplexity, Google AI Overviews e altri. Questa visibilità è cruciale per comprendere la tua presenza AI, garantire la conformità e individuare opportunità di ottimizzazione. FlowHunt.io integra questo approccio offrendo capacità di generazione e automazione di contenuti AI su più piattaforme, permettendo di mantenere qualità e governance costanti mentre si scala l’uso dell’AI. Insieme, queste soluzioni aiutano le organizzazioni a mantenere visibilità completa sull’uso delle piattaforme AI, controllare i costi, garantire la conformità e ottimizzare le performance su tutta l’infrastruttura AI diversificata. Unendo monitoraggio multi-piattaforma e automazione intelligente, le organizzazioni possono scalare l’adozione dell’AI con fiducia, mantenendo il controllo e la visibilità necessari per le operazioni enterprise.

Il vendor lock-in si verifica quando un’organizzazione diventa così dipendente da un unico fornitore AI che il passaggio ad alternative diventa impraticabile o proibitivamente costoso. Questa dipendenza si sviluppa tramite integrazioni strette e API proprietarie, portando a perdita di potere negoziale, impossibilità di adottare modelli superiori e aumento dei costi. Le organizzazioni dovrebbero preoccuparsene perché il lock-in limita la flessibilità strategica e crea vulnerabilità a lungo termine rispetto a cambiamenti di prezzo e interruzioni di servizio.

Le organizzazioni che utilizzano piattaforme multi-modello aziendali riportano risparmi del 40-60% rispetto ad accordi aziendali con un unico fornitore, ottenendo al contempo accesso a modelli superiori e una governance completa. Questi risparmi derivano da prezzi competitivi tra fornitori, selezione intelligente del modello che indirizza le query semplici verso modelli più economici e maggiore potere negoziale sapendo che è possibile cambiare facilmente vendor.

Le piattaforme single-provider vincolano le organizzazioni all’ecosistema di un solo fornitore, con governance limitata e costi di switching elevati. Le piattaforme multi-modello creano uno strato di astrazione che consente l’accesso a oltre 100 modelli da più fornitori, governance centralizzata, protezione dei dati sensibili e costi di switching minimi. Le piattaforme multi-modello aggiungono solo 3-5 ms di latenza aggiuntiva offrendo al contempo sicurezza e conformità di livello enterprise.

Le piattaforme multi-modello aziendali implementano meccanismi di protezione che rilevano e impediscono la trasmissione di informazioni riservate a fornitori esterni, mantenendo i dati proprietari all’interno dei confini organizzativi. Mantengono audit log completi di ogni interazione AI, applicano policy coerenti su tutti i fornitori e diventano il confine di sicurezza invece di esporre i dati direttamente ai vendor. Questo approccio è essenziale perché il 50% dei fornitori AI non soddisfa gli standard base di sicurezza dei dati.

Gli standard aperti (REST API, GraphQL, ONNX, OpenTelemetry) prevengono nuove forme di vendor lock-in assicurando che le applicazioni restino indipendenti dal fornitore e i dati rimangano portabili. Le organizzazioni dovrebbero privilegiare piattaforme che usano API standard invece di SDK proprietari, archiviare i dati in formati aperti sotto il controllo dell’organizzazione e utilizzare formati di interscambio dei modelli che consentono di spostare i modelli tra piattaforme senza riaddestramento. Questo approccio rende le strategie AI a prova di futuro contro cambiamenti dei vendor e interruzioni di mercato.

Valuta le piattaforme in base al supporto multi-vendor (integrazione con fornitori principali e modelli personalizzati), API e formati dati aperti (possibilità di esportare dati e usare librerie standard), flessibilità di deploy (on-premise o multi-cloud), e capacità di governance (applicazione di policy, audit logging, supporto alla conformità). Dai priorità a piattaforme con meccanismi di distribuzione organica sostenibile invece che incentivi promozionali temporanei, e valuta la loro esperienza con clienti enterprise nel tuo settore.

Le sfide principali includono la scelta della piattaforma multi-modello più adatta ai requisiti organizzativi, la migrazione delle applicazioni esistenti verso l’interfaccia unificata della piattaforma, la definizione di un framework di governance che stabilisca requisiti di conformità e utilizzo accettabile dell’AI, e la formazione dei team sulla nuova architettura. Le organizzazioni dovrebbero anche pianificare monitoraggio e ottimizzazione continui per identificare opportunità di risparmio e nuovi casi d’uso. Il successo richiede impegno nel nuovo approccio invece di mantenere in parallelo vecchie integrazioni single-provider.

AmICited.com offre monitoraggio completo di come il tuo brand e i tuoi contenuti vengono visualizzati su più piattaforme AI, inclusi ChatGPT, Perplexity, Google AI Overviews e altri. Questa visibilità è fondamentale per comprendere la tua presenza AI, garantire la conformità, identificare opportunità di ottimizzazione e mantenere il controllo su come il brand viene citato nelle risposte generate dall’AI. AmICited aiuta le organizzazioni a tracciare la propria presenza nell’ecosistema AI diversificato che hanno costruito.

Traccia come il tuo brand appare su più piattaforme AI con AmICited. Ottieni una visibilità completa della tua presenza AI su ChatGPT, Perplexity, Google AI Overviews e altro ancora.

Scopri come prevenire le crisi di visibilità AI con monitoraggio proattivo, sistemi di allerta precoce e protocolli di risposta strategici. Proteggi il tuo marc...

Scopri come ottimizzare i feed di prodotti per motori di shopping AI come Google AI Overviews, Perplexity e ChatGPT. Padroneggia attributi del feed, qualità dei...

Scopri strategie comprovate per proteggere il tuo marchio dalle allucinazioni dell'IA su ChatGPT, Perplexity e altri sistemi. Scopri tecniche di monitoraggio, v...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.