Cos'è una Finestra di Contesto nei Modelli di Intelligenza Artificiale

Scopri cosa sono le finestre di contesto nei modelli linguistici di intelligenza artificiale, come funzionano, il loro impatto sulle prestazioni del modello e p...

La contestualizzazione tramite delimitatori è una tecnica di ottimizzazione dei contenuti che stabilisce confini chiari attorno alle informazioni per prevenire interpretazioni errate e allucinazioni da parte dell’IA. Utilizza delimitatori espliciti e marcatori di contesto per garantire che i modelli di IA comprendano esattamente dove iniziano e finiscono le informazioni rilevanti, evitando la generazione di risposte basate su supposizioni o dettagli inventati.

La contestualizzazione tramite delimitatori è una tecnica di ottimizzazione dei contenuti che stabilisce confini chiari attorno alle informazioni per prevenire interpretazioni errate e allucinazioni da parte dell'IA. Utilizza delimitatori espliciti e marcatori di contesto per garantire che i modelli di IA comprendano esattamente dove iniziano e finiscono le informazioni rilevanti, evitando la generazione di risposte basate su supposizioni o dettagli inventati.

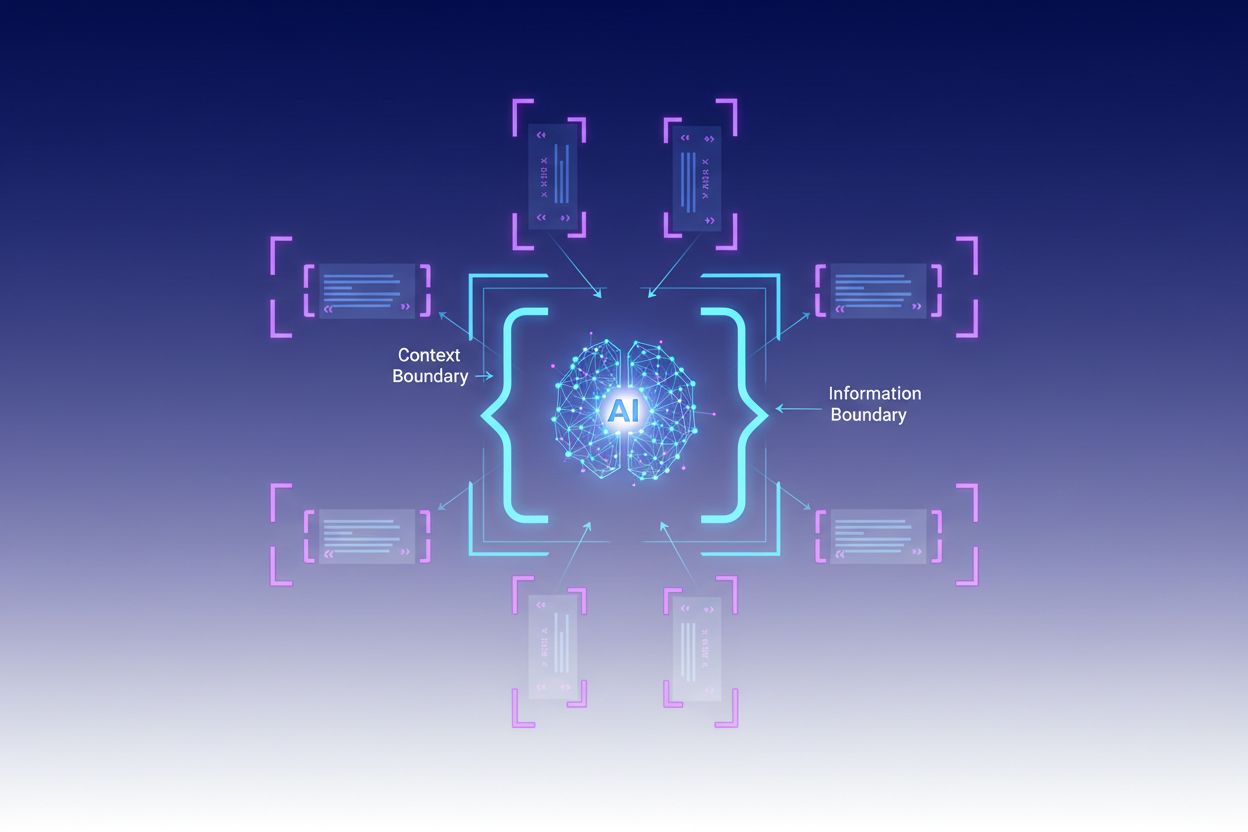

La contestualizzazione tramite delimitatori è una tecnica di ottimizzazione dei contenuti che stabilisce confini chiari attorno alle informazioni per prevenire interpretazioni errate e allucinazioni da parte dell’IA. Questo metodo prevede l’uso di delimitatori espliciti—come tag XML, intestazioni markdown o caratteri speciali—per contrassegnare l’inizio e la fine di blocchi informativi specifici, creando quello che gli esperti chiamano un “confine di contesto”. Strutturando prompt e dati con questi marcatori chiari, gli sviluppatori garantiscono che i modelli di IA comprendano esattamente dove iniziano e finiscono le informazioni rilevanti, impedendo al modello di generare risposte basate su supposizioni o dettagli inventati. La contestualizzazione tramite delimitatori rappresenta un’evoluzione rispetto al tradizionale prompt engineering, estendendosi nella più ampia disciplina dell’ingegneria del contesto, che si concentra sull’ottimizzazione di tutte le informazioni fornite a un LLM per ottenere risultati desiderati. La tecnica è particolarmente preziosa negli ambienti di produzione, dove accuratezza e coerenza sono fondamentali, poiché fornisce barriere matematiche e strutturali che guidano il comportamento dell’IA senza richiedere logiche condizionali complesse.

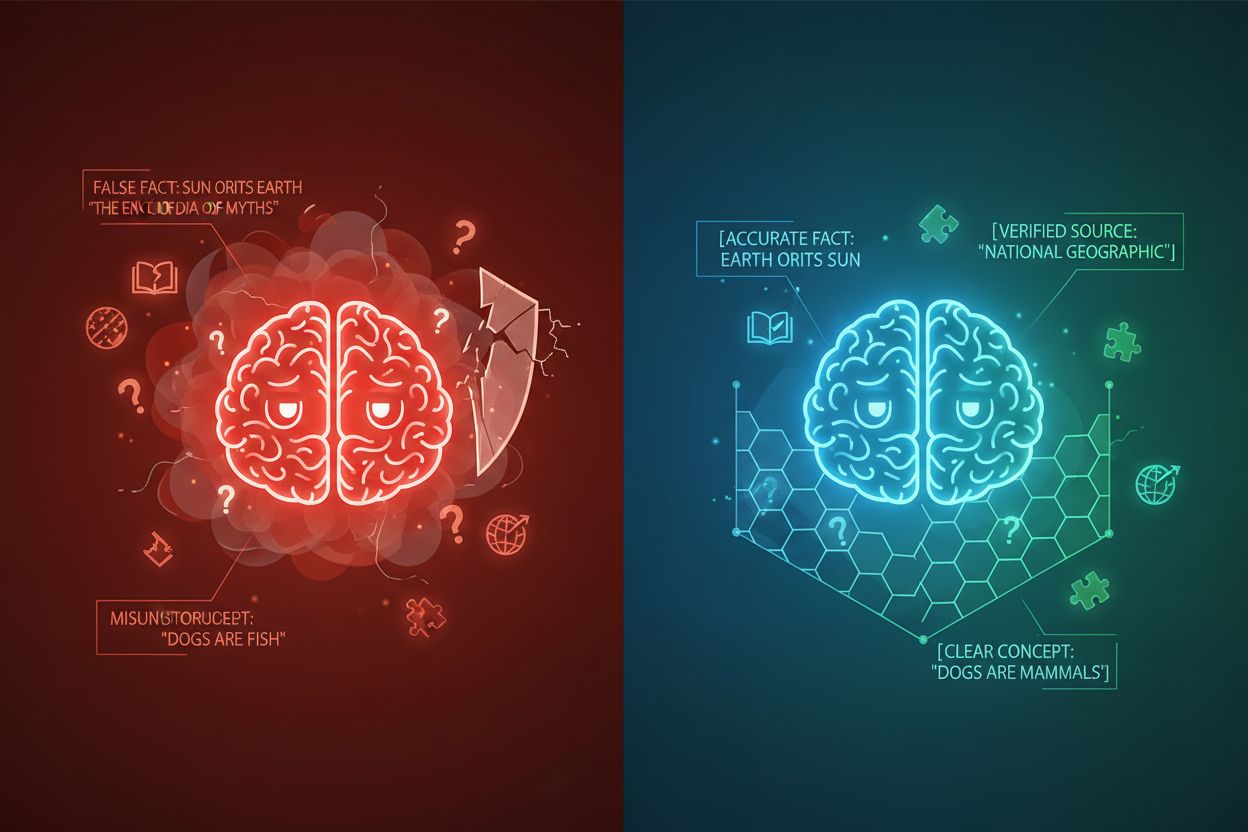

L’allucinazione dell’IA si verifica quando i modelli linguistici generano risposte che non sono radicate in informazioni fattuali o nel contesto specifico fornito, producendo fatti falsi, affermazioni fuorvianti o riferimenti a fonti inesistenti. Le ricerche mostrano che i chatbot inventano fatti circa il 27% delle volte, con il 46% dei loro testi contenenti errori fattuali, mentre le citazioni giornalistiche di ChatGPT erano sbagliate nel 76% dei casi. Queste allucinazioni derivano da diverse cause: i modelli possono apprendere schemi da dati di addestramento distorti o incompleti, fraintendere la relazione tra i token o mancare di vincoli sufficienti che limitino le possibili uscite. Le conseguenze sono gravi in tutti i settori—nella sanità, le allucinazioni possono portare a diagnosi errate e interventi medici non necessari; in ambito legale, possono generare citazioni di casi inventati (come nel caso Mata v. Avianca, dove un avvocato è stato sanzionato per aver usato citazioni legali false generate da ChatGPT); nel business, sprecano risorse attraverso analisi e previsioni errate. Il problema fondamentale è che senza confini di contesto chiari, i modelli di IA operano in un vuoto informativo dove sono più inclini a “riempire i vuoti” con informazioni plausibili ma inesatte, trattando l’allucinazione come una funzione anziché come un errore.

| Tipo di Allucinazione | Frequenza | Impatto | Esempio |

|---|---|---|---|

| Inesattezze Fattuali | 27-46% | Diffusione di disinformazione | Caratteristiche di prodotto false |

| Fonti Inventate | 76% (citazioni) | Perdita di credibilità | Citazioni inesistenti |

| Concetti Fraintesi | Variabile | Analisi errata | Precedenti legali sbagliati |

| Schemi Distorti | Continuo | Output discriminatori | Risposte stereotipate |

L’efficacia della contestualizzazione tramite delimitatori si basa su cinque principi fondamentali:

Utilizzo dei Delimitatori: Usa marcatori coerenti e inequivocabili (tag XML come <context>, intestazioni markdown o caratteri speciali) per delimitare chiaramente i blocchi informativi e impedire al modello di confondere i confini tra diverse fonti di dati o tipi di istruzioni.

Gestione della Finestra di Contesto: Alloca strategicamente i token tra istruzioni di sistema, input utente e conoscenza recuperata, assicurandoti che le informazioni più rilevanti occupino il budget di attenzione limitato del modello, mentre i dettagli meno critici vengano filtrati o recuperati all’occorrenza.

Gerarchia dell’Informazione: Stabilisci livelli di priorità chiari per i diversi tipi di informazioni, segnalando al modello quali dati devono essere trattati come fonti autorevoli rispetto al contesto supplementare, evitando che informazioni primarie e secondarie vengano considerate allo stesso livello.

Definizione dei Confini: Indica esplicitamente quali informazioni il modello deve considerare e quali ignorare, creando dei limiti invalicabili che impediscono al modello di estrapolare oltre i dati forniti o di fare supposizioni su informazioni non dichiarate.

Marcatori di Scopo: Utilizza elementi strutturali per indicare la portata di istruzioni, esempi e dati, chiarendo se le indicazioni si applicano globalmente, a sezioni specifiche o solo a particolari tipi di richieste.

L’implementazione della contestualizzazione tramite delimitatori richiede particolare attenzione a come le informazioni vengono strutturate e presentate ai modelli di IA. La formattazione strutturata degli input tramite schemi JSON o XML fornisce definizioni esplicite dei campi che guidano il comportamento del modello—ad esempio, racchiudere le richieste degli utenti in tag <user_query> e gli output attesi in <expected_output> crea confini inequivocabili. I prompt di sistema dovrebbero essere organizzati in sezioni distinte utilizzando intestazioni markdown o tag XML: <background_information>, <instructions>, <tool_guidance> e <output_description> hanno ciascuno scopi specifici e aiutano il modello a comprendere la gerarchia delle informazioni. Gli esempi few-shot dovrebbero includere contesti delimitati che mostrino esattamente come il modello deve strutturare le sue risposte, con delimitatori chiari attorno a input e output. Le definizioni degli strumenti beneficiano di descrizioni esplicite dei parametri e vincoli d’uso, impedendo al modello di usare strumenti in modo improprio o fuori dal loro scopo. I sistemi di Retrieval-Augmented Generation (RAG) possono implementare la contestualizzazione tramite delimitatori racchiudendo i documenti recuperati in marcatori di fonte (<source>nome_documento</source>) e utilizzando punteggi di grounding per verificare che le risposte generate rimangano entro i confini delle informazioni recuperate. Ad esempio, la funzione di confine di contesto di CustomGPT funziona addestrando i modelli esclusivamente sui dataset caricati, assicurando che le risposte non vadano mai oltre la base di conoscenza fornita—un’implementazione pratica della contestualizzazione tramite delimitatori a livello architetturale.

Pur condividendo alcune somiglianze con tecniche correlate, la contestualizzazione tramite delimitatori occupa una posizione distinta nel panorama dell’ingegneria dell’IA. Il prompt engineering di base si concentra principalmente sulla creazione di istruzioni ed esempi efficaci, ma manca dell’approccio sistematico alla gestione di tutti gli elementi di contesto che offre la contestualizzazione tramite delimitatori. L’ingegneria del contesto, disciplina più ampia, include la contestualizzazione tramite delimitatori come uno dei suoi elementi—comprende ottimizzazione dei prompt, progettazione degli strumenti, gestione della memoria e recupero dinamico del contesto, rappresentando un insieme più ampio rispetto all’approccio più mirato della contestualizzazione tramite delimitatori. Il semplice seguito delle istruzioni si affida alla capacità del modello di comprendere direttive in linguaggio naturale senza confini strutturali espliciti, il che spesso fallisce quando le istruzioni sono complesse o in situazioni ambigue. Guardrail e sistemi di validazione agiscono a livello di output, controllando le risposte dopo la generazione, mentre la contestualizzazione tramite delimitatori opera a livello di input per prevenire le allucinazioni prima che si verifichino. La differenza chiave è che la contestualizzazione tramite delimitatori è preventiva e strutturale—modella il paesaggio informativo in cui opera il modello—invece di essere correttiva o reattiva, rendendola più efficiente e affidabile per mantenere l’accuratezza nei sistemi in produzione.

La contestualizzazione tramite delimitatori offre valore misurabile in molteplici applicazioni. I chatbot per l’assistenza clienti utilizzano confini di contesto per limitare le risposte alle basi di conoscenza approvate dall’azienda, impedendo agli agenti di inventare caratteristiche di prodotto o prendere impegni non autorizzati. I sistemi di analisi di documenti legali racchiudono la giurisprudenza, le norme e i precedenti rilevanti, garantendo che l’IA faccia riferimento solo a fonti verificate e non inventi citazioni legali. I sistemi IA medici implementano confini di contesto rigorosi attorno a linee guida cliniche, dati dei pazienti e protocolli di trattamento approvati, prevenendo allucinazioni pericolose che potrebbero danneggiare i pazienti. Le piattaforme di generazione di contenuti utilizzano la contestualizzazione tramite delimitatori per far rispettare linee guida di brand, requisiti di tono e vincoli fattuali, assicurando che i contenuti generati siano allineati agli standard organizzativi. Gli strumenti di ricerca e analisi delimitano fonti primarie, dataset e informazioni verificate, permettendo all’IA di sintetizzare insight mantenendo un’attribuzione chiara e prevenendo la creazione di statistiche o studi inventati. AmICited.com esemplifica questo principio monitorando come i sistemi IA citano e fanno riferimento ai brand su GPT, Perplexity e Google AI Overviews—tracciando di fatto se i modelli IA restano entro i confini di contesto appropriati quando discutono di specifiche aziende o prodotti, aiutando le organizzazioni a capire se i sistemi IA stanno allucinando sul proprio brand o rappresentando accuratamente le informazioni.

Un’implementazione efficace della contestualizzazione tramite delimitatori richiede l’adesione a best practice consolidate:

Inizia con il Contesto Minimo: Parti dal set più piccolo di informazioni necessario per risposte accurate, espandendo solo quando i test rivelano lacune, prevenendo l’inquinamento del contesto e mantenendo la concentrazione del modello.

Usa Schemi di Delimitatori Coerenti: Stabilisci e mantieni regole uniformi di delimitazione in tutto il sistema, rendendo più semplice per il modello riconoscere i confini e riducendo la confusione dovuta a formattazioni incoerenti.

Testa e Valida i Confini: Verifica sistematicamente che il modello rispetti i confini definiti cercando di indurlo a superarli, identificando e colmando eventuali lacune prima della messa in produzione.

Monitora la Deriva di Contesto: Controlla costantemente che le risposte del modello restino entro i confini desiderati nel tempo, poiché il comportamento può variare con diversi input o con l’evoluzione delle basi di conoscenza.

Implementa Feedback Loop: Prevedi meccanismi affinché utenti o revisori umani segnalino i casi in cui il modello supera i confini, utilizzando questo feedback per affinare le definizioni di contesto e migliorare le prestazioni future.

Versiona le Definizioni di Contesto: Tratta i confini di contesto come codice, mantenendo la cronologia delle versioni e la documentazione delle modifiche, così da poter tornare indietro se nuove definizioni producono risultati peggiori.

Diverse piattaforme hanno integrato funzionalità di contestualizzazione tramite delimitatori nelle loro offerte principali. CustomGPT.ai implementa confini di contesto tramite la funzione “context boundary”, che agisce come una barriera protettiva garantendo che l’IA utilizzi solo i dati forniti dall’utente, senza mai attingere a conoscenza generale o inventare informazioni—un approccio che si è dimostrato efficace per organizzazioni come il MIT, che richiedono assoluta precisione nella consegna della conoscenza. Claude di Anthropic enfatizza i principi dell’ingegneria del contesto, offrendo documentazione dettagliata su come strutturare i prompt, gestire le finestre di contesto e implementare guardrail che mantengano le risposte entro confini definiti. AWS Bedrock Guardrails offre controlli di ragionamento automatici che verificano i contenuti generati secondo regole matematiche e logiche, con punteggi di grounding che indicano se le risposte restano entro il materiale di origine (per le applicazioni finanziarie è richiesto un punteggio superiore a 0,85). Shelf.io fornisce soluzioni RAG con funzionalità di gestione del contesto, consentendo alle organizzazioni di implementare la retrieval-augmented generation mantenendo confini rigorosi su quali informazioni il modello può accedere e citare. AmICited.com svolge un ruolo complementare monitorando come i sistemi IA citano e fanno riferimento al tuo brand su più piattaforme IA, aiutandoti a capire se i modelli IA rispettano i confini di contesto appropriati quando parlano della tua organizzazione o rimangono entro informazioni accurate e verificate sul tuo brand—offrendo di fatto visibilità sull’efficacia della contestualizzazione tramite delimitatori nel mondo reale.

Il prompt engineering si concentra principalmente sulla creazione di istruzioni ed esempi efficaci, mentre la contestualizzazione tramite delimitatori è un approccio sistematico alla gestione di tutti gli elementi di contesto mediante delimitatori e confini espliciti. La contestualizzazione tramite delimitatori è più strutturata e preventiva, agendo a livello di input per prevenire le allucinazioni prima che si verifichino, mentre il prompt engineering è più ampio e include varie tecniche di ottimizzazione.

La contestualizzazione tramite delimitatori previene le allucinazioni stabilendo confini informativi chiari mediante delimitatori come tag XML o intestazioni markdown. Questo indica al modello di IA esattamente quali informazioni considerare e quali ignorare, impedendogli di inventare dettagli o fare supposizioni su informazioni non dichiarate. Limitando l’attenzione del modello ai confini definiti, si riduce la probabilità di generare fatti falsi o fonti inesistenti.

I delimitatori comuni includono tag XML (come

I principi della contestualizzazione tramite delimitatori possono essere applicati alla maggior parte dei moderni modelli linguistici, sebbene l’efficacia vari. I modelli addestrati con migliori capacità di seguire istruzioni (come Claude, GPT-4 e Gemini) tendono a rispettare i confini in modo più affidabile. La tecnica funziona meglio se combinata con modelli che supportano output strutturati e sono stati addestrati su dati diversificati e ben formattati.

Inizia organizzando i prompt di sistema in sezioni distinte usando delimitatori chiari. Struttura input e output tramite schemi JSON o XML. Usa schemi di delimitatori coerenti in tutto il sistema. Implementa esempi few-shot che mostrino esattamente come il modello deve rispettare i confini. Testa in modo approfondito per assicurarti che il modello rispetti i confini definiti e monitora le prestazioni nel tempo per rilevare eventuali derive di contesto.

La contestualizzazione tramite delimitatori può aumentare leggermente l’uso dei token a causa dei delimitatori e marcatori strutturali aggiuntivi, ma ciò è generalmente compensato da una maggiore accuratezza e da una riduzione delle allucinazioni. La tecnica migliora effettivamente l’efficienza prevenendo che il modello sprechi token su informazioni inventate. Nei sistemi in produzione, i guadagni in accuratezza superano di gran lunga l’esiguo sovraccarico di token.

La contestualizzazione tramite delimitatori e la RAG sono tecniche complementari. La RAG recupera informazioni rilevanti da fonti esterne, mentre la contestualizzazione tramite delimitatori assicura che il modello rimanga entro i confini di tali informazioni recuperate. Insieme, creano un sistema potente in cui il modello può accedere a conoscenze esterne, ma è vincolato a citare solo fonti verificate e recuperate.

Diverse piattaforme hanno supporto integrato: CustomGPT.ai offre funzionalità di confine di contesto, Claude di Anthropic fornisce documentazione sull’ingegneria del contesto e supporto per output strutturati, AWS Bedrock Guardrails include controlli di ragionamento automatici, e Shelf.io offre RAG con gestione del contesto. AmICited.com monitora come i sistemi IA citano il tuo brand, aiutando a verificare che la contestualizzazione tramite delimitatori funzioni efficacemente.

La contestualizzazione tramite delimitatori garantisce che i sistemi IA forniscano informazioni accurate sul tuo brand. Usa AmICited per monitorare come i modelli di IA citano e fanno riferimento ai tuoi contenuti su GPT, Perplexity e Google AI Overviews.

Scopri cosa sono le finestre di contesto nei modelli linguistici di intelligenza artificiale, come funzionano, il loro impatto sulle prestazioni del modello e p...

Scopri come identificare, monitorare e risolvere controversie sui contenuti AI quando i sistemi di intelligenza artificiale generano informazioni inesatte o dan...

Scopri come creare contenuti di confronto tra concorrenti efficaci che si posizionano in ricerca e vengono citati dalle piattaforme AI. Guida passo-passo con fr...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.