Che cos'è la ricerca vettoriale e come funziona?

Scopri come la ricerca vettoriale utilizza gli embedding di machine learning per trovare elementi simili basandosi sul significato piuttosto che sulle parole ch...

La ricerca vettoriale è un metodo per trovare elementi simili in un dataset rappresentando i dati come vettori matematici e confrontandoli utilizzando metriche di distanza come la similarità coseno o la distanza euclidea. Questo approccio consente una comprensione semantica oltre la corrispondenza delle parole chiave, permettendo ai sistemi di scoprire relazioni e somiglianze basate sul significato piuttosto che su corrispondenze testuali esatte.

La ricerca vettoriale è un metodo per trovare elementi simili in un dataset rappresentando i dati come vettori matematici e confrontandoli utilizzando metriche di distanza come la similarità coseno o la distanza euclidea. Questo approccio consente una comprensione semantica oltre la corrispondenza delle parole chiave, permettendo ai sistemi di scoprire relazioni e somiglianze basate sul significato piuttosto che su corrispondenze testuali esatte.

La ricerca vettoriale è un metodo per trovare elementi simili in un dataset rappresentando i dati come vettori matematici e confrontandoli mediante metriche di distanza per misurare la similarità semantica. A differenza della ricerca tradizionale basata su parole chiave, che si basa su corrispondenze testuali esatte, la ricerca vettoriale comprende il significato e il contesto dei dati convertendoli in rappresentazioni numeriche ad alta dimensionalità chiamate embedding vettoriali. Questo approccio consente ai sistemi di scoprire relazioni e somiglianze basate sul contenuto semantico piuttosto che su caratteristiche superficiali, rendendola particolarmente potente per applicazioni che richiedono comprensione contestuale. La ricerca vettoriale è diventata fondamentale nei sistemi di intelligenza artificiale moderni, abilitando ricerca semantica, motori di raccomandazione, rilevamento anomalie e retrieval-augmented generation (RAG) su piattaforme come ChatGPT, Perplexity, Google AI Overviews e Claude.

Alla base, la ricerca vettoriale trasforma i dati in rappresentazioni numeriche dove la vicinanza nello spazio indica similarità semantica. Ogni elemento di dato—che sia testo, immagine o audio—viene convertito in un vettore, cioè un array di numeri che rappresentano caratteristiche o significati. Ad esempio, la parola “ristorante” può essere rappresentata come [0.2, -0.5, 0.8, 0.1], dove ogni numero cattura un aspetto diverso del significato semantico della parola. Il principio fondamentale è che elementi semanticamente simili avranno vettori posizionati vicini nello spazio ad alta dimensionalità, mentre gli elementi dissimili saranno distanti. Questa struttura matematica consente ai computer di confrontare concetti basati sul significato piuttosto che su corrispondenze esatte di parole chiave, permettendo ad esempio che la ricerca di “migliori locali dove mangiare” restituisca risultati per “ristoranti top” anche senza sovrapposizione esatta delle parole.

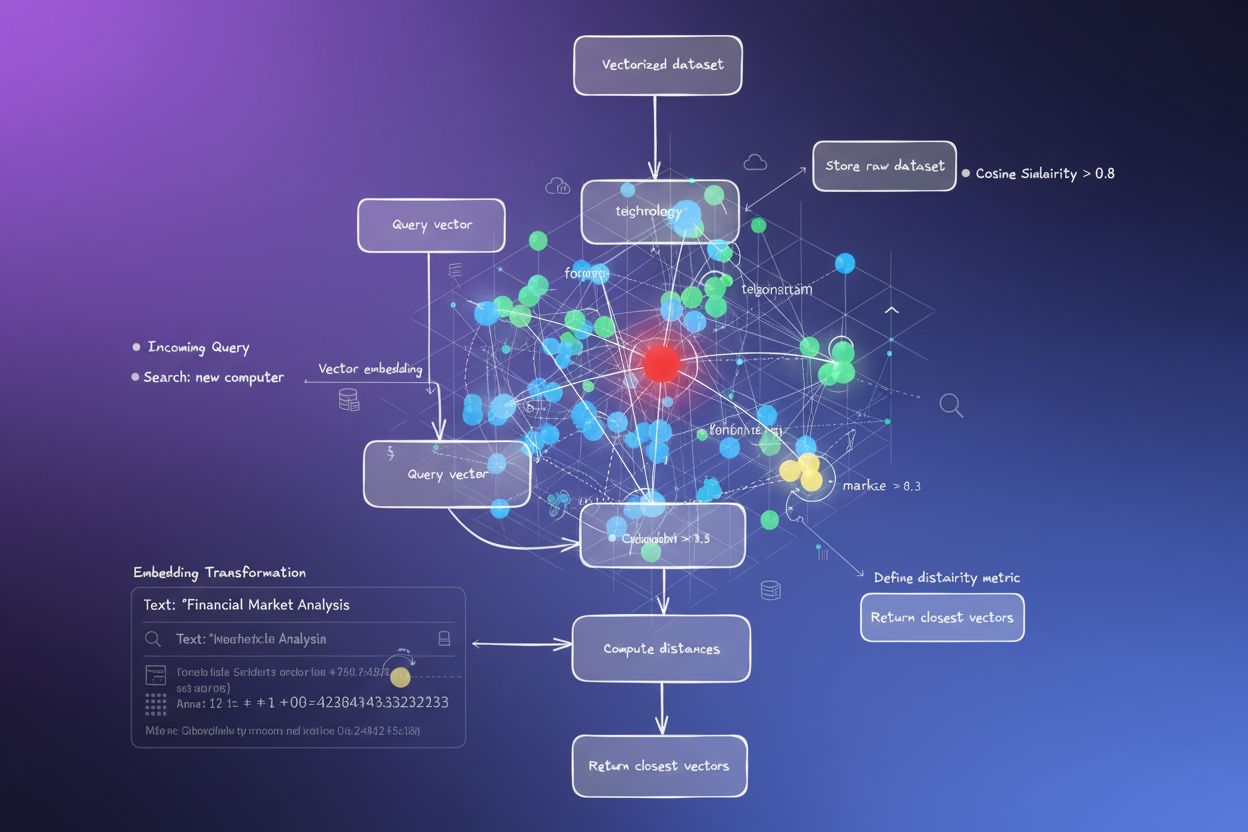

Il processo di conversione dei dati in vettori si chiama embedding, ed è svolto da modelli di machine learning addestrati su grandi dataset. Questi modelli imparano a mappare concetti simili in posizioni vicine nello spazio vettoriale grazie all’esposizione a miliardi di esempi. I modelli di embedding più comuni includono Word2Vec, che apprende le relazioni tra parole dal contesto; BERT (Bidirectional Encoder Representations from Transformers), che cattura il significato contestuale; e CLIP (Contrastive Language-Image Pre-training), che gestisce dati multimodali. Gli embedding risultanti hanno tipicamente da 100 a oltre 1.000 dimensioni, creando una ricca rappresentazione matematica delle relazioni semantiche. Quando un utente effettua una ricerca, anche la sua query viene convertita in un vettore tramite lo stesso modello di embedding, e il sistema calcola poi le distanze tra il vettore della query e tutti i vettori archiviati per identificare gli elementi più simili.

La ricerca vettoriale si basa su metriche di distanza per quantificare quanto due vettori siano simili. Le tre metriche principali sono similarità coseno, distanza euclidea e similarità tramite prodotto scalare, ognuna con proprietà matematiche e casi d’uso distinti. La similarità coseno misura l’angolo tra due vettori, variando da -1 a 1, dove 1 indica direzione identica (massima similarità) e 0 indica vettori ortogonali (nessuna relazione). Questa metrica è particolarmente preziosa per le applicazioni NLP perché si concentra sulla direzione semantica indipendentemente dalla magnitudine del vettore, ideale per confrontare documenti di lunghezze diverse. La distanza euclidea calcola la distanza in linea retta tra i vettori nello spazio multidimensionale, considerando sia la magnitudine che la direzione. Questa metrica è sensibile alla scala, risultando utile quando la magnitudine dei vettori porta informazioni significative, ad esempio nei sistemi di raccomandazione dove conta la frequenza di acquisto.

La similarità tramite prodotto scalare combina aspetti di entrambe le metriche, considerando magnitudine e direzione e offrendo efficienza computazionale. Molti grandi modelli linguistici utilizzano il prodotto scalare durante l’addestramento, rendendolo la scelta appropriata per tali applicazioni. La selezione della metrica corretta è cruciale—le ricerche dimostrano che usare la stessa metrica con cui è stato addestrato il modello di embedding produce risultati ottimali. Ad esempio, il modello all-MiniLM-L6-v2 è stato addestrato usando la similarità coseno, quindi utilizzando la similarità coseno nell’indice si otterranno i risultati più accurati. Le organizzazioni che implementano la ricerca vettoriale devono abbinare attentamente la metrica scelta al loro modello di embedding e al caso d’uso per garantire sia accuratezza che prestazioni.

| Aspetto | Ricerca Vettoriale | Ricerca per Parola Chiave | Ricerca Ibrida |

|---|---|---|---|

| Metodo di Corrispondenza | Similarità semantica basata sul significato | Corrispondenza esatta di parole o frasi | Combina corrispondenza semantica e per parola chiave |

| Comprensione della Query | Comprende intento e contesto | Richiede la presenza di parole chiave esatte | Sfrutta entrambi gli approcci per risultati completi |

| Gestione dei Sinonimi | Trova automaticamente sinonimi e termini correlati | Ignora sinonimi a meno che non siano indicizzati | Cattura i sinonimi con entrambi i metodi |

| Prestazioni su Query Vaghe | Eccellente—comprende l’intento | Scarsa—richiede parole chiave precise | Molto buona—copre entrambe le interpretazioni |

| Costo Computazionale | Più elevato—richiede embedding e calcoli di similarità | Inferiore—semplice confronto di stringhe | Moderato—esegue entrambe le ricerche in parallelo |

| Scalabilità | Richiede database vettoriali specializzati | Funziona con database tradizionali | Richiede sistemi in grado di gestire ricerca ibrida |

| Casi d’Uso | Ricerca semantica, raccomandazioni, RAG, rilevamento anomalie | Ricerca di frasi esatte, dati strutturati | Ricerca aziendale, monitoraggio AI, tracking del brand |

| Esempio | Cercando “idee per cena salutare” trova “preparazione pasti nutrienti” | Trova solo risultati con le parole esatte “salutare” e “cena” | Trova sia corrispondenze esatte che contenuti semanticamente correlati |

Implementare la ricerca vettoriale implica diversi passaggi interconnessi che trasformano dati grezzi in rappresentazioni semantiche ricercabili. Il primo passo è ingestione e pre-processing dei dati, dove documenti grezzi, immagini o altri dati vengono puliti e normalizzati. Segue la trasformazione vettoriale, in cui un modello di embedding converte ogni elemento in un vettore numerico, tipicamente da 100 a oltre 1.000 dimensioni. Questi vettori vengono poi archiviati in un database vettoriale o in una struttura di indice ottimizzata per dati ad alta dimensionalità. Quando arriva una query di ricerca, subisce lo stesso processo di embedding per creare un vettore query. Il sistema poi utilizza metriche di distanza per calcolare i punteggi di similarità tra il vettore della query e tutti i vettori archiviati, ordinando i risultati in base alla vicinanza alla query.

Per rendere efficiente questo processo su larga scala, i sistemi impiegano algoritmi Approximate Nearest Neighbor (ANN) come HNSW (Hierarchical Navigable Small World), IVF (Inverted File Index) o ScaNN (Scalable Nearest Neighbors). Questi algoritmi sacrificano la precisione perfetta per la velocità, consentendo ricerche tra milioni o miliardi di vettori in millisecondi anziché secondi. HNSW, ad esempio, organizza i vettori in una struttura a grafo multilivello dove i livelli superiori contengono connessioni a lungo raggio per una traversata veloce, mentre quelli inferiori hanno connessioni a corto raggio per la precisione. Questo approccio gerarchico riduce la complessità della ricerca da lineare O(n) a logaritmica O(log n), rendendo praticabile la ricerca vettoriale su larga scala. La scelta dell’algoritmo dipende da fattori come dimensione del dataset, volume di query, requisiti di latenza e risorse computazionali disponibili.

La ricerca vettoriale è diventata essenziale per le piattaforme di monitoraggio AI come AmICited che tracciano le menzioni del brand attraverso i sistemi AI. Il monitoraggio tradizionale basato su parole chiave perderebbe menzioni parafrasate, riferimenti contestuali e variazioni semantiche di nomi di brand o URL di dominio. La ricerca vettoriale consente a queste piattaforme di rilevare quando il tuo brand viene menzionato nelle risposte generate dall’AI anche se la formulazione esatta differisce. Ad esempio, se il tuo dominio è “amicited.com”, la ricerca vettoriale può identificare menzioni come “piattaforma di monitoraggio AI prompt” o “visibilità del brand nell’AI generativa” come concettualmente correlate al tuo business, anche senza menzioni esplicite dell’URL. Questa comprensione semantica è cruciale per un tracking completo delle citazioni AI su ChatGPT, Perplexity, Google AI Overviews e Claude.

Il mercato delle tecnologie di ricerca vettoriale sta vivendo una crescita esplosiva, riflettendo il riconoscimento del suo valore da parte delle aziende. Secondo le ricerche di mercato, il mercato dei database vettoriali è stato valutato 1,97 miliardi di dollari nel 2024 e si prevede raggiungerà 10,60 miliardi di dollari entro il 2032, con un CAGR del 23,38%. Inoltre, Databricks ha riportato una crescita del 186% nell’adozione di database vettoriali solo nel primo anno dal lancio in public preview della ricerca vettoriale a dicembre 2023. Questa rapida adozione dimostra che le aziende riconoscono sempre più la ricerca vettoriale come infrastruttura critica per le applicazioni AI. Per le organizzazioni che monitorano la propria presenza nei sistemi AI, la ricerca vettoriale offre la comprensione semantica necessaria a catturare tutte le menzioni significative, non solo le corrispondenze esatte delle parole chiave.

Le prestazioni della ricerca vettoriale su larga scala dipendono in modo critico da tecniche di indicizzazione sofisticate che bilanciano velocità, accuratezza e uso della memoria. HNSW (Hierarchical Navigable Small World) è emerso come uno degli approcci più popolari, organizzando i vettori in un grafo multilivello in cui ogni livello contiene connessioni via via più corte. L’algoritmo avvia la ricerca al livello superiore con connessioni a lungo raggio per una traversata rapida, quindi scende attraverso i livelli con connessioni sempre più precise. Le ricerche dimostrano che HNSW raggiunge prestazioni allo stato dell’arte con tassi di recall superiori al 99% mantenendo latenze di query inferiori al millisecondo. Tuttavia, HNSW richiede molta memoria—i benchmark mostrano che indicizzare 1 milione di vettori con HNSW può richiedere da 0,5GB a 5GB a seconda dei parametri, rendendo l’ottimizzazione della memoria importante per grandi deployment.

IVF (Inverted File Index) offre un approccio alternativo raggruppando i vettori e indicizzandoli tramite i centroidi dei cluster. Questa tecnica riduce lo spazio di ricerca concentrandosi sui cluster rilevanti invece che su tutti i vettori. ScaNN (Scalable Nearest Neighbors), sviluppato da Google Research, è ottimizzato specificamente per la ricerca tramite prodotto interno e offre prestazioni eccellenti per i sistemi di raccomandazione. Product Quantization (PQ) comprime i vettori suddividendoli in sottovettori e quantizzando ciascuno indipendentemente, riducendo i requisiti di memoria di 10-100x a scapito di una certa accuratezza. Le organizzazioni che implementano la ricerca vettoriale devono selezionare attentamente le tecniche di indicizzazione in base ai propri requisiti specifici—se privilegiano accuratezza del recall, velocità di ricerca, efficienza della memoria o una combinazione di questi fattori. Il settore continua a evolvere rapidamente, con nuovi algoritmi e tecniche di ottimizzazione che emergono regolarmente per affrontare le sfide computazionali delle operazioni vettoriali ad alta dimensionalità.

La definizione e l’applicazione della ricerca vettoriale continuano a evolversi man mano che i sistemi di intelligenza artificiale diventano più sofisticati e l’adozione aziendale accelera. La direzione futura punta verso sistemi di ricerca ibrida che combinano la ricerca vettoriale con la ricerca tradizionale per parola chiave e avanzate capacità di filtraggio. Questi approcci ibridi sfruttano la comprensione semantica della ricerca vettoriale mantenendo la precisione e la familiarità della ricerca per parola chiave, offrendo risultati superiori per query complesse. Inoltre, sta emergendo la ricerca vettoriale multimodale come capacità fondamentale, consentendo ai sistemi di cercare simultaneamente tra testo, immagini, audio e video utilizzando spazi di embedding unificati. Questo sviluppo permetterà esperienze di ricerca più intuitive e complete su diversi tipi di dati.

Per le organizzazioni che monitorano la propria presenza nei sistemi AI, l’evoluzione della ricerca vettoriale ha profonde implicazioni. Poiché piattaforme AI come ChatGPT, Perplexity, Google AI Overviews e Claude si affidano sempre più alla ricerca vettoriale per il recupero e il ranking dei contenuti, capire come il proprio brand appare semanticamente diventa importante quanto la visibilità tradizionale per parola chiave. Il passaggio verso la comprensione semantica significa che il monitoraggio del brand e il tracking delle citazioni AI devono evolversi oltre la semplice rilevazione di parole chiave per captare menzioni contestuali e relazioni semantiche. Le organizzazioni che investono nella comprensione della ricerca vettoriale e delle sue applicazioni saranno meglio posizionate per ottimizzare la propria visibilità nei sistemi di intelligenza artificiale generativa. La convergenza della tecnologia di ricerca vettoriale con le piattaforme di monitoraggio AI rappresenta un cambiamento fondamentale nel modo in cui i brand comprendono e gestiscono la propria presenza nel panorama informativo guidato dall’AI.

La ricerca tradizionale per parola chiave cerca corrispondenze esatte delle parole nei documenti, mentre la ricerca vettoriale comprende il significato semantico e il contesto. La ricerca vettoriale converte il testo in rappresentazioni numeriche chiamate embedding, consentendo di trovare risultati pertinenti anche quando le parole chiave esatte non corrispondono. Ad esempio, cercando 'cuffie wireless' con la ricerca vettoriale verranno restituiti anche risultati per 'auricolari Bluetooth' perché condividono un significato semantico simile, mentre la ricerca per parola chiave non coglierebbe questa connessione.

Gli embedding vettoriali sono rappresentazioni numeriche di dati (testo, immagini, audio) convertite in array di numeri che catturano il significato semantico. Vengono creati utilizzando modelli di machine learning come Word2Vec, BERT o modelli basati su transformer che imparano a mappare concetti simili vicini tra loro in uno spazio ad alta dimensionalità. Ad esempio, la parola 're' e 'regina' avranno embedding posizionati vicini perché condividono relazioni semantiche, mentre 're' e 'banana' saranno lontani tra loro.

Le tre principali metriche di distanza sono la similarità coseno (misura l'angolo tra i vettori), la distanza euclidea (misura la distanza in linea retta) e la similarità tramite prodotto scalare (considera sia la magnitudine che la direzione). La similarità coseno è la più comune per le applicazioni NLP perché si concentra sulla direzione semantica indipendentemente dalla magnitudine del vettore. La scelta della metrica dovrebbe corrispondere a quella utilizzata per addestrare il modello di embedding per ottenere la massima accuratezza.

La ricerca vettoriale consente alle piattaforme di monitoraggio AI come AmICited di tracciare le menzioni del brand attraverso i sistemi AI (ChatGPT, Perplexity, Google AI Overviews, Claude) comprendendo il contesto semantico invece delle sole corrispondenze esatte delle parole chiave. Questo permette di rilevare menzioni parafrasate, concetti correlati e riferimenti contestuali al tuo brand, offrendo una visibilità completa su come il tuo dominio appare nelle risposte generate dall'AI su più piattaforme.

Gli algoritmi ANN come HNSW (Hierarchical Navigable Small World) consentono ricerche di similarità rapide tra milioni di vettori trovando vicini approssimati invece che esatti. Questi algoritmi utilizzano strutture a grafo gerarchiche per ridurre la complessità della ricerca da lineare a logaritmica, rendendo la ricerca vettoriale praticabile per applicazioni su larga scala. HNSW organizza i vettori in grafi multilivello dove le connessioni a lungo raggio esistono nei livelli superiori per una traversata più veloce.

Le aziende generano enormi quantità di dati non strutturati (email, documenti, ticket di supporto) che la ricerca tradizionale per parola chiave fatica a organizzare efficacemente. La ricerca vettoriale consente una comprensione semantica di questi dati, alimentando applicazioni come ricerca intelligente, sistemi di raccomandazione, rilevamento anomalie e retrieval-augmented generation (RAG). Secondo le ricerche di mercato, il mercato dei database vettoriali dovrebbe crescere da 2,65 miliardi di dollari nel 2025 a 8,95 miliardi di dollari entro il 2030, riflettendo l'adozione aziendale.

I database vettoriali sono sistemi specializzati ottimizzati per l'archiviazione, l'indicizzazione e le interrogazioni di dati vettoriali ad alta dimensionalità. Implementano tecniche di indicizzazione efficienti come HNSW, IVF (Inverted File Index) e ScaNN per consentire ricerche di similarità rapide su larga scala. Esempi includono Milvus, Pinecone, Weaviate e Zilliz Cloud. Questi database gestiscono la complessità computazionale delle operazioni vettoriali, permettendo alle organizzazioni di costruire applicazioni AI e di ricerca semantica pronte per la produzione senza gestire la complessità dell'infrastruttura.

Inizia a tracciare come i chatbot AI menzionano il tuo brand su ChatGPT, Perplexity e altre piattaforme. Ottieni informazioni utili per migliorare la tua presenza AI.

Scopri come la ricerca vettoriale utilizza gli embedding di machine learning per trovare elementi simili basandosi sul significato piuttosto che sulle parole ch...

Scopri come gli embedding vettoriali permettono ai sistemi di IA di comprendere il significato semantico e abbinare i contenuti alle query. Esplora la tecnologi...

La ricerca semantica interpreta il significato e il contesto delle query usando NLP e machine learning. Scopri come si differenzia dalla ricerca a parole chiave...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.