比較コンテンツ構造

比較コンテンツ構造がどのようにAIシステム向けに情報を最適化するかを学びましょう。AIプラットフォームがなぜ製品推薦に比較表やマトリックス、並列表を好むのか、そして最大限AIでの可視性を実現する実装方法を解説します。...

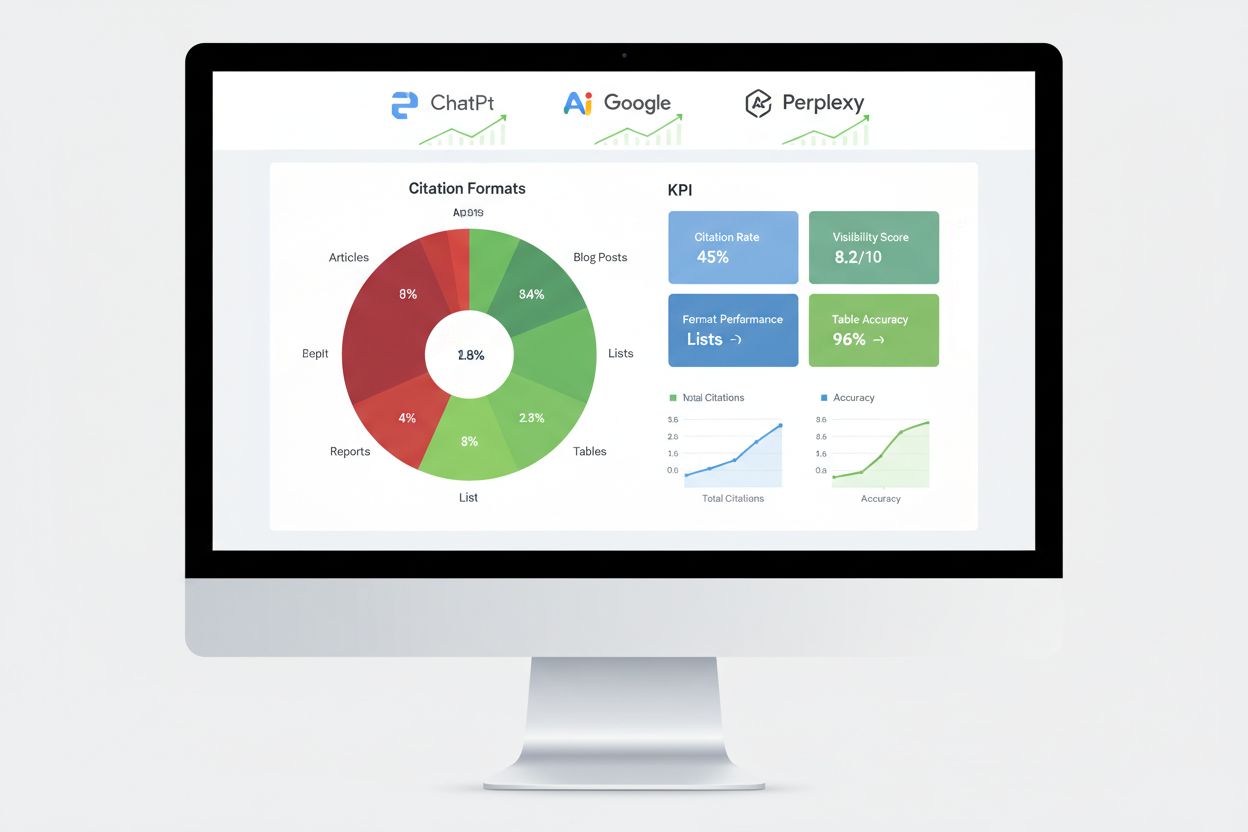

A/Bテスト手法を使ってAI引用のためのコンテンツフォーマットをテストする方法を学びます。ChatGPT、Google AI Overviews、Perplexityなどで最もAIからの可視性と引用率を高めるフォーマットを発見しましょう。

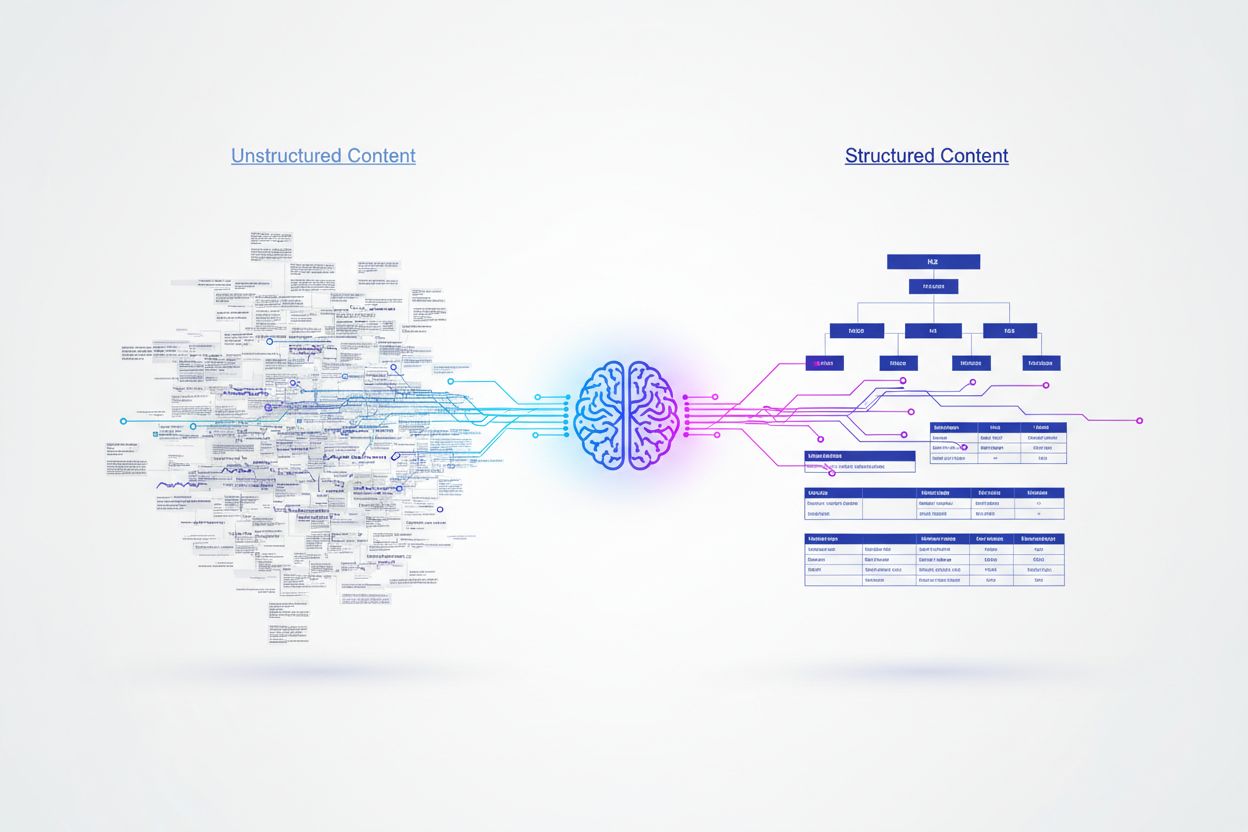

人工知能システムは人間の読者とは根本的に異なる方法でコンテンツを処理し、意味を理解し情報を抽出するために構造化されたシグナルに依存しています。人間は創造的なフォーマットや難解な文章も理解できますが、AIモデルは明確な階層構造とセマンティックマーカーがなければ、コンテンツの価値を正確に解析できません。研究によると、適切な見出し階層を持つ構造化コンテンツは、非構造化コンテンツに比べて156%高い引用率を記録しており、人間に優しいコンテンツとAIに優しいコンテンツの間に大きなギャップがあることが分かります。この違いは、AIが大規模なデータセットで学習しており、整然としたコンテンツが権威性や信頼性と強く結びついているためです。AI主導の検索結果やアンサープラットフォームで可視性を確保したいブランドにとって、さまざまなコンテンツフォーマットの理解とテストは不可欠となっています。

AIプラットフォームごとに情報源やフォーマットの好みが大きく異なり、最適化戦略が複雑化しています。主要プラットフォームで6億8000万件の引用を分析した研究では、ChatGPT、Google AI Overviews、Perplexityが情報源を選ぶ際の顕著な違いが明らかになりました。これらのプラットフォームは単に同じ情報源を引用するわけではなく、独自のアルゴリズムや学習データに基づき異なるコンテンツタイプを優先しています。プラットフォームごとの引用傾向を理解することは、AIシステム全体で最大限の可視性を得るためのターゲット戦略構築に不可欠です。

| プラットフォーム | 最多引用ソース | 引用割合 | 好まれるフォーマット |

|---|---|---|---|

| ChatGPT | Wikipedia | 全引用の7.8% | 権威ある知識ベース、百科事典型コンテンツ |

| Google AI Overviews | 全引用の2.2% | コミュニティディスカッション、ユーザー生成コンテンツ | |

| Perplexity | 全引用の6.6% | ピアツーピア情報、コミュニティインサイト |

ChatGPTはWikipediaへの偏重(上位10ソースの47.9%)から、確立された信頼性や事実性を持つコンテンツを重視していることが分かります。一方、Google AI OverviewsやPerplexityはRedditが引用傾向を支配しつつも、よりバランスの取れた分布を示しています。特にPerplexityは上位ソースの46.7%をコミュニティ起点の情報が占めており、Googleはより多様なプラットフォームタイプを横断的に活用しています。これらのデータから、画一的なコンテンツ戦略は通用しないことが明らかです。ブランドは、自社のターゲットユーザーにとって重要なAIプラットフォームごとに戦略を最適化する必要があります。

スキーママークアップはAI引用率に最も大きな影響を与える要因の一つで、適切に実装されたJSON-LDマークアップは、同じ内容でも構造化データがない場合に比べて340%高い引用率を実現します。この劇的な差は、AIエンジンがセマンティックな意味をどのように解釈するかに由来し、構造化データがコンテンツ解釈の曖昧さを排除し、明示的な文脈を与えるためです。AIエンジンがスキーママークアップに出会うと、エンティティの関係性やコンテンツタイプ、階層的な重要性を自然言語処理だけに頼らず即座に理解します。

最も効果的なスキーマ実装には、ブログ記事用のArticleスキーマ、Q&Aセクション用のFAQスキーマ、ハウツーコンテンツ用のHowToスキーマ、ブランド認知用のOrganizationスキーマなどがあります。JSON-LD形式はHTMLから独立してAIエンジンが解析できるため、他の構造化データ形式よりも優れたパフォーマンスを発揮します。さらに、<header>、<nav>、<main>、<section>、<article>などのセマンティックHTMLタグを活用すると、AIがコンテンツの構造と階層をより明確に理解しやすくなります。

A/Bテストは、各分野でどのコンテンツフォーマットが最も高いAI引用率を生み出すかを判断するための最も信頼性の高い手法です。一般的なベストプラクティスに頼るのではなく、コントロールされた実験によってフォーマット変更が実際にどのような影響を与えるかを測定できます。実験変数を分離し統計的妥当性を確保するためには入念な設計が必要ですが、その洞察は十分な価値があります。

体系的なA/Bテストフレームワーク:

統計的有意差を確保するためにはサンプルサイズとテスト期間に細心の注意が必要です。AI関連のアプリケーションではデータが希薄だったりロングテール分布だったりするため、十分な観測値を素早く得ることが困難な場合もあります。多くの専門家は時期的な変動を考慮し、2〜4週間のテスト期間を推奨しています。

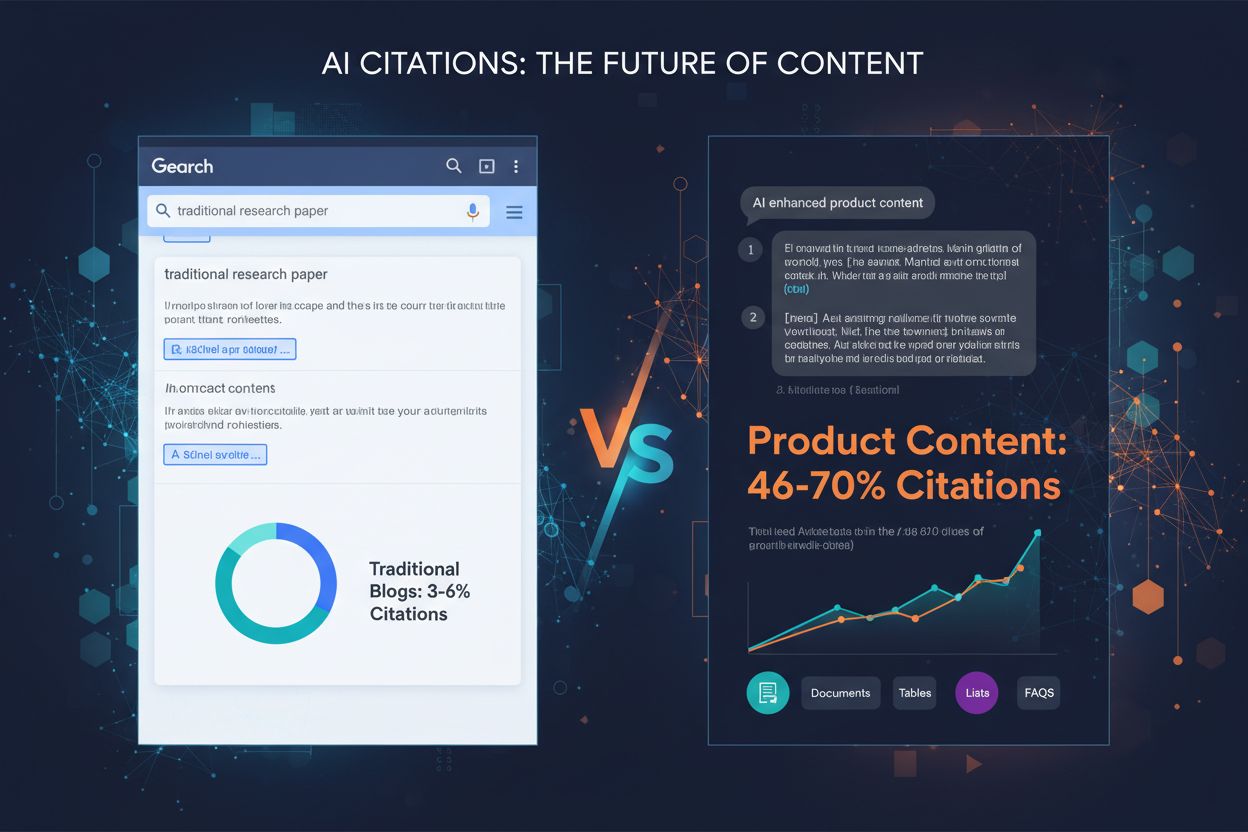

数千件のAI引用を分析した結果、コンテンツフォーマットごとに明確なパフォーマンス階層があることが分かっています。リスト形式のコンテンツは、段落中心のものよりも68%多くAIから引用されており、これはリストがAIエンジンにとって抽出・統合しやすい情報単位を提供するためです。AIプラットフォームは、複雑な文章の再構築や言い換えをせずに、リスト項目をそのまま参照できるため、リスト形式は引用用途で非常に価値があります。

表形式はAI解析で最大96%の精度を示し、同一情報を文章で説明した場合よりもはるかに優れています。表はAIが特定のデータポイントを迅速に抽出できるため、事実・比較・統計データなどで特に有用です。Q&Aフォーマットは、同じトピックを段落形式で扱うよりも45%高いAI可視性を達成しており、これはQ&AがAIプラットフォームのユーザーインタラクションや回答生成パターンと一致しているためです。

比較形式(X vs Y)はバイナリかつ要約しやすい構造のため、AIがクエリをサブトピックに展開する際に非常に適しています。ケーススタディはストーリー性とデータを兼ね備え、読者にもAIにも理解されやすい問題-解決-結果という構造を持ちます。独自調査や専門家の見解は専有データとしてAIに高く評価され、信頼性のシグナルとして引用されやすくなります。重要なのは、万能なフォーマットは存在しないということです。最適な戦略は、コンテンツタイプやターゲットAIプラットフォームに応じて複数の形式を戦略的に組み合わせることです。

スキーママークアップの実装には、利用可能なタイプの理解と自コンテンツに最も適したスキーマの選択が必要です。ブログ記事や記事にはArticleスキーマが有効で、著者・公開日・構造などの包括的なメタデータを付与します。FAQスキーマはQ&Aセクションに最適で、質問と回答を明示的にラベル付けすることでAIが確実に抽出できるようにします。HowToスキーマは手順を持つ解説コンテンツに有用で、ProductスキーマはECサイトの商品仕様や価格伝達に役立ちます。

{

"@context": "https://schema.org",

"@type": "FAQPage",

"mainEntity": [

{

"@type": "Question",

"name": "AI引用に最適なコンテンツフォーマットは?",

"acceptedAnswer": {

"@type": "Answer",

"text": "最適なフォーマットはプラットフォームやターゲットによりますが、リスト・表・Q&A形式などの構造化されたフォーマットは一貫して高いAI引用率を実現しています。リストは段落よりも68%多く引用され、表は96%の解析精度を達成します。"

}

}

]

}

実装時は文法の正確さに注意しましょう。不正なスキーママークアップは引用率を下げるだけでなく、場合によっては逆効果になることもあります。GoogleのリッチリザルトテストやSchema.orgのバリデーションツールで公開前に必ず検証してください。H2をメインセクション、H3をサブポイント、1パラグラフ50〜75語程度の短い段落で階層構造を維持しましょう。各セクションの先頭や末尾にTL;DR(要約)を追加すると、AIが独立したスニペットとして利用しやすくなります。

AIエンジンの効果測定は従来のSEOとは異なり、順位ではなく引用追跡・回答採用率・ナレッジグラフ言及などに注目します。主要プラットフォームでの引用モニタリングは、フォーマットテストの成果を直接的に把握でき、AIが実際にどのコンテンツを参照しているかを明らかにします。AmICitedのようなツールを使えば、ChatGPT・Google AI Overviews・Perplexityその他のアンサーエンジンにおけるブランドの引用状況が可視化され、引用傾向やトレンド分析が可能です。

主な測定方法には、強調スニペット獲得率(AIに直接回答として採用されたコンテンツ)、ナレッジパネル出現率(AIがブランドを権威あるエンティティと認識)、音声検索での採用率(会話型AIの回答として掲載)、生成エンジンの回答率(ユーザー質問への回答で参照された頻度)などがあります。A/Bテストによるフォーマット比較は、単一変数の効果を特定でき最も信頼性の高いパフォーマンスデータとなります。変更前に基準値を設定し、週次でモニタリングしてトレンドや異常値を早期に発見しましょう。

フォーマットテストを行う多くの企業が、結果を損なう典型的なミスに陥っています。サンプルサイズ不足が最も一般的なミスで、十分な引用やインタラクションがないと統計的に有意な結果が得られず、偶然の変動を意味のある差と誤認してしまいます。必ずバリエーションごとに100件以上の引用を集め、信頼水準や効果量に応じてサンプルサイズを統計計算機で算出しましょう。

交絡変数は、複数の要素が同時に変化した場合にどの要素が影響したか特定できなくなるバイアスです。テスト中はフォーマット以外の要素(キーワード・長さ・構造・公開タイミング等)を同一に保ちましょう。時期的バイアスは、異常な時期(祝日・大きなニュース・アルゴリズム変更等)にテストすることで結果が歪む現象です。通常時にテストし、2〜4週間以上の期間で季節変動もカバーしてください。選択バイアスはテストグループ間に影響する違いがある場合に生じます。必ずランダムにコンテンツを割り当てましょう。相関と因果の混同は、外的要因とテスト期間が偶然一致した場合に誤った結論を導く原因です。観測結果の他の説明も常に検討し、複数回のテストで結果を検証してから本格導入しましょう。

あるテクノロジー企業は、AI可視性向上を目的に製品比較記事を段落形式から比較表形式へ変更したところ、60日でAI引用が52%増加しました。表はAIが直接抽出できる明確な情報を提供し、もとの文章は解析が複雑だったためです。コンテンツの長さやキーワード最適化は同一に保ち、形式のみを変えた実験でした。

金融サービス企業は既存コンテンツのQ&AセクションにFAQスキーマを追加しただけで、強調スニペット出現率が34%、AI引用が28%増加しました。マークアップを追加しただけで中身は変えていませんが、AIが回答を特定しやすくなった結果です。SaaS企業はリスト・表・段落という3つのフォーマットで同一内容の多変量テストを行い、リストは段落より68%高い引用を獲得、表はAI解析精度は最も高いものの引用量はリストより下という結果でした。フォーマットの有効性はコンテンツタイプとAIプラットフォームによって異なるため、一般的なベストプラクティスよりもテストが重要ということが実証されています。これらの実例は、正しく実行すればフォーマットテストがAI可視性を大きく向上させることを示しています。

AIシステムの進化とともに、コンテンツフォーマットテストの手法も変化し続けています。マルチアームバンディットアルゴリズムは従来のA/Bテストを凌駕し、事前に決めたテスト期間を待たずリアルタイムのパフォーマンスに基づいてトラフィック配分を動的に調整します。これにより、勝ちパターンの特定が迅速化し、テスト期間中のパフォーマンスも最大化されます。

強化学習による適応型実験は、AIモデル自身が継続的に学習・適応することで、離散的なテストサイクルではなくリアルタイムでパフォーマンスを改善します。AI主導のA/Bテスト自動化は、実験設計・結果分析・最適化提案までAI自身が行うため、複数バリエーションを同時テストしても複雑さが比例して増えず、より高速な反復と高度な最適化が可能となります。これらの新しい手法は、サイクルの短縮と最適化戦略の高度化をもたらします。今からコンテンツフォーマットテストをマスターしておくことで、こうした先進手法が標準化する将来にも優位性を保ち、競合よりも早く新しいAIプラットフォームや引用アルゴリズムの波に乗ることができるでしょう。

最適なフォーマットはプラットフォームやターゲットによりますが、リスト・表・Q&A形式などの構造化されたフォーマットは一貫して高いAI引用率を実現しています。リストは段落よりも68%多く引用され、表は96%の解析精度を達成します。あなたのコンテンツで異なる形式をテストし、最も効果的なものを見つけることが重要です。

多くの専門家は時期的な変動を考慮し、信頼性の高い結果を得るために少なくとも2〜4週間テストすることを推奨しています。この期間で十分なデータポイント(通常バリエーションごとに100件以上の引用)を収集でき、季節変動やプラットフォームのアルゴリズム変更など結果に影響する要素もカバーできます。

はい、複数フォーマットの多変量テストも可能ですが、結果の解釈が複雑にならないよう慎重な設計が必要です。まずは2種類のフォーマットを比較する単純なA/Bテストから始め、基本を理解し統計リソースが十分になったら多変量テストへ進みましょう。

統計的有意差を得るには、通常バリエーションごとに少なくとも100件の引用やインタラクションが必要です。正確なサンプルサイズは統計計算機で信頼水準や効果量に応じて算出してください。大きなサンプルサイズほど信頼性は高まりますが、テスト期間も長くなります。

まずコンテンツに最適なスキーマタイプ(Article、FAQ、HowTo等)を選び、JSON-LD形式で実装してください。GoogleのリッチリザルトテストやSchema.orgのバリデーションツールで公開前に検証しましょう。不正なスキーママークアップはAI引用率を下げるため、正確性が非常に重要です。

ターゲットとビジネス目標に基づいて優先順位を決めましょう。ChatGPTはWikipediaのような権威ある情報を重視し、Google AI OverviewsはRedditなどユーザーコミュニティの情報を優先、Perplexityはピアツーピア情報に注力しています。最も関連性の高いトラフィックを生むプラットフォームから最適化しましょう。

継続的なテストをコンテンツ戦略に組み込みましょう。最初は四半期ごとのフォーマットテストサイクルから開始し、専門性が高まり基準値が定まったら頻度を増やしていきます。定期的なテストでAIプラットフォームのアルゴリズム変化や新しいフォーマットの好みを先取りできます。

引用率の向上、強調スニペット獲得率、ナレッジパネル出現率、生成系エンジンの回答率などを追跡しましょう。テスト前に基準値を設定し、週次でパフォーマンスを監視してトレンドを把握します。成功指標は通常4〜8週間で主要指標が20%以上向上することです。

様々なフォーマットでAIプラットフォームがあなたのコンテンツをどのように引用しているか追跡しましょう。どのコンテンツ構造がAIの可視性を高めるかを発見し、実データで戦略を最適化します。

比較コンテンツ構造がどのようにAIシステム向けに情報を最適化するかを学びましょう。AIプラットフォームがなぜ製品推薦に比較表やマトリックス、並列表を好むのか、そして最大限AIでの可視性を実現する実装方法を解説します。...

表・リスト・明確なセクションを使ったAIに適したフォーマットがAIの解析精度を高め、AI Overviews・ChatGPT・Perplexityでのコンテンツ可視性を向上させる方法を解説。LLM抽出のための構造最適化ベストプラクティスを紹介します。...

どのコンテンツ形式がAIモデルに最も引用されるかを発見。768,000件以上のAI引用データを分析し、ChatGPT、Perplexity、Google AI Overviews向けにコンテンツ戦略を最適化しましょう。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.