Hoe Datavisualisaties de Zichtbaarheid in AI-zoekopdrachten en LLM's Verbeteren

Ontdek hoe datavisualisaties de zichtbaarheid in AI-zoekopdrachten verbeteren, LLM's helpen content te begrijpen en het aantal citaties in AI-gegenereerde antwo...

Ontdek hoe AI-modellen visuele data en grafieken citeren. Leer waarom datavisualisatie belangrijk is voor AI-citaties en hoe je je visuele inhoud kunt volgen met AmICited.

Visuele data vormt een fundamentele bottleneck voor moderne grote taalmodellen, die vooral zijn getraind op tekstgebaseerde informatie en moeite hebben om grafieken met dezelfde precisie te verwerken, te interpreteren en te citeren als geschreven inhoud. Huidige LLM’s ondervinden aanzienlijke beperkingen bij het tegenkomen van datavisualisaties—zij moeten visuele elementen eerst omzetten in tekstuele beschrijvingen, een proces waarbij vaak essentiële nuances, exacte waarden en contextuele relaties uit de originele grafiek verloren gaan. Het onvermogen om visuele data accuraat te verwerken betekent dat grafieken, diagrammen en infographics vaak niet of onjuist worden geciteerd door LLM-systemen, wat een geloofwaardigheidskloof creëert voor makers die veel investeren in kwalitatieve visualisaties. Deze uitdaging is van groot belang voor onderzoekers, analisten en organisaties die vertrouwen op AI-grafiekverwerking om informatie te synthetiseren, omdat het ontbreken van correcte toeschrijving zowel het werk van de originele maker als de betrouwbaarheid van AI-samenvattingen ondermijnt. Inzicht in deze beperkingen is essentieel voor iedereen die visuele content creëert in een steeds meer door AI gedreven informatielandschap.

Verschillende AI-systemen benaderen het citeren van visuele inhoud met uiteenlopende verfijning, afhankelijk van hun onderliggende architectuur en trainingsmethodologieën. De onderstaande tabel laat zien hoe grote AI-platforms omgaan met visuele citaties:

| AI-model | Visuele citatiecapaciteit | Citatieformaat | Nauwkeurigheidsniveau | Multimodale ondersteuning |

|---|---|---|---|---|

| ChatGPT (GPT-4V) | Matig | Beschrijvende tekst | 65-75% | Ja (afbeeldingsinvoer) |

| Claude 3 | Hoog | Gedetailleerde toeschrijving | 80-85% | Ja (vision-enabled) |

| Perplexity AI | Hoog | Bron + visuele referentie | 85-90% | Ja (web-geïntegreerd) |

| Google AI Overviews | Matig-hoog | Inline citaties | 75-80% | Ja (afbeeldingszoeker) |

| Gemini Pro Vision | Matig | Contextuele referentie | 70-78% | Ja (multimodaal) |

Claude presteert superieur in visuele inhoudtoeschrijving, en geeft vaak gedetailleerde broninformatie en visuele context bij het refereren aan grafieken, terwijl Perplexity AI uitblinkt in het integreren van visuele citaties met webbronnen, waardoor een meer volledige toeschrijvingsketen ontstaat. ChatGPT’s GPT-4V kan afbeeldingen verwerken, maar geeft vaak generieke beschrijvingen in plaats van precieze citaties, vooral bij complexe financiële grafieken of wetenschappelijke visualisaties. Google AI Overviews probeert inline citaties voor visuele inhoud te behouden, maar verwart soms de grafiekmaker met de databron, wat leidt tot onduidelijkheid over de juiste toeschrijving. Voor makers betekent deze variatie dat dezelfde visualisatie afhankelijk van het AI-systeem totaal verschillend kan worden behandeld—een grafiek kan correct worden geciteerd in Claude maar volledig zonder vermelding blijven in ChatGPT, wat het belang onderstreept van gestandaardiseerde protocollen voor visuele citatie in het AI-ecosysteem.

Datavisualisatie speelt een verrassend invloedrijke rol in hoe AI-modellen informatie begrijpen en representeren, omdat grafieken en diagrammen in trainingsdatasets modellen leren patronen, relaties en hiërarchieën in complexe data te herkennen. De kwaliteit en diversiteit van visuele data in trainingssets beïnvloedt direct hoe goed AI-systemen later vergelijkbare visualisaties kunnen interpreteren en citeren; modellen die zijn getraind op uitgebreide visuele datasets presteren aantoonbaar beter in visuele inhoudtoeschrijving. Visuele patronen die tijdens training zijn geleerd beïnvloeden de modeluitvoer op subtiele maar meetbare manieren—een model dat veel wetenschappelijk gelabelde grafieken heeft gezien, zal waarschijnlijk nauwkeurigere citaties genereren voor soortgelijke visualisaties dan een model dat voornamelijk op tekst is getraind. De uitdaging wordt groter doordat de meeste grote taalmodellen zijn getraind op webdata waarbij visuele inhoud vaak ontbreekt aan metadata, alt-tekst of bronvermelding, wat een cyclus in stand houdt waarbij AI-systemen wel leren grafieken te verwerken, maar niet te citeren. Organisaties die investeren in hoogwaardige, goed gedocumenteerde datavisualisatiedatasets bouwen in feite betere fundamenten voor toekomstige AI-systemen, hoewel deze investering in de industrie nog onderbenut blijft.

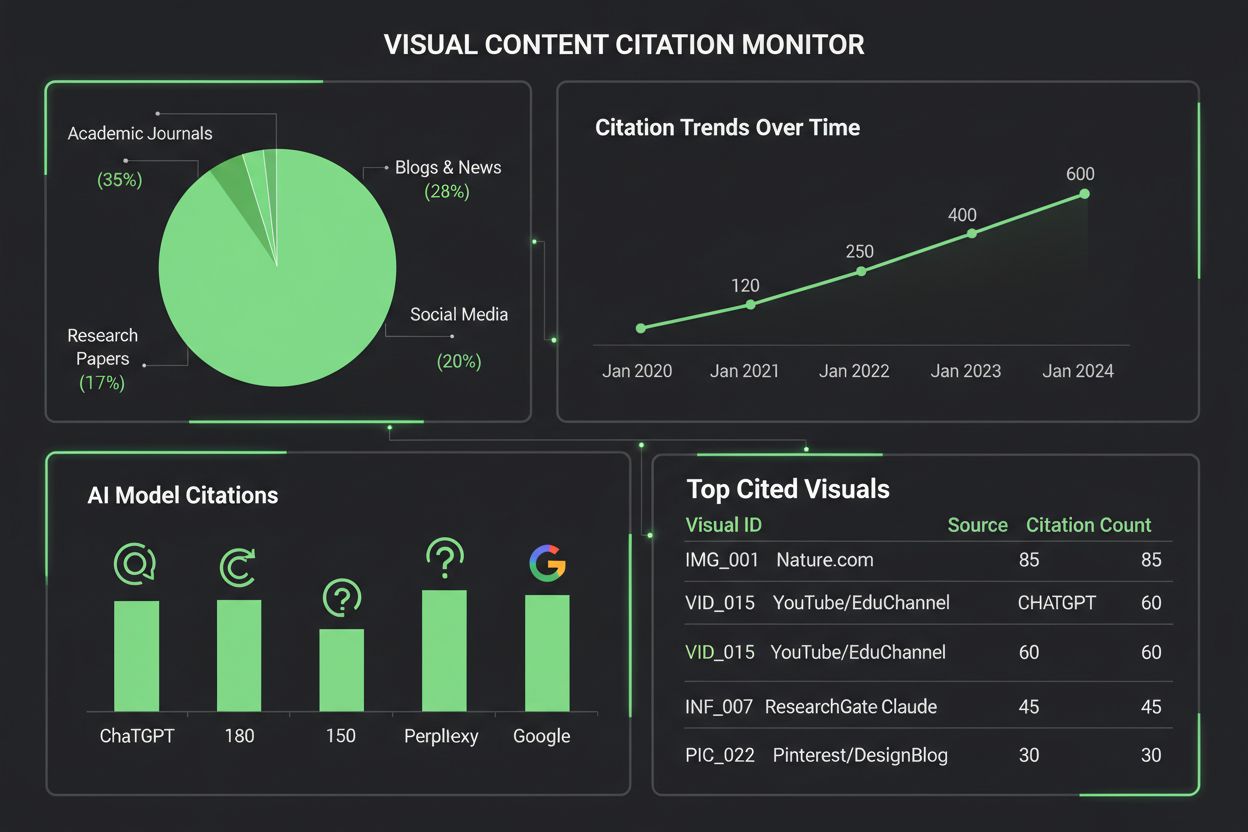

Het monitoren van hoe AI-systemen visuele inhoud citeren vereist een gelaagde aanpak die geautomatiseerde detectie combineert met handmatige verificatie. Belangrijke trackingmethodes zijn onder meer:

AmICited.com is gespecialiseerd in het tracken van citaties van visuele inhoud over meerdere AI-platformen, en biedt makers gedetailleerde rapportages over hoe hun grafieken worden gerefereerd, toegeschreven of over het hoofd gezien door ChatGPT, Claude, Perplexity, Google AI en andere systemen. Het belang van het monitoren van visuele citaties kan niet genoeg benadrukt worden—zonder goede tracking verliezen makers het zicht op hoe hun werk AI-gegenereerde inhoud beïnvloedt, waardoor het onmogelijk wordt te pleiten voor betere toeschrijvingspraktijken of het ware bereik van hun visualisaties te begrijpen. De monitoringtools van AmICited vullen deze cruciale leemte door realtime meldingen te bieden wanneer grafieken worden geciteerd, gedetailleerde analyses over citatienauwkeurigheid en bruikbare inzichten om de vindbaarheid van visuele inhoud in AI-systemen te verbeteren.

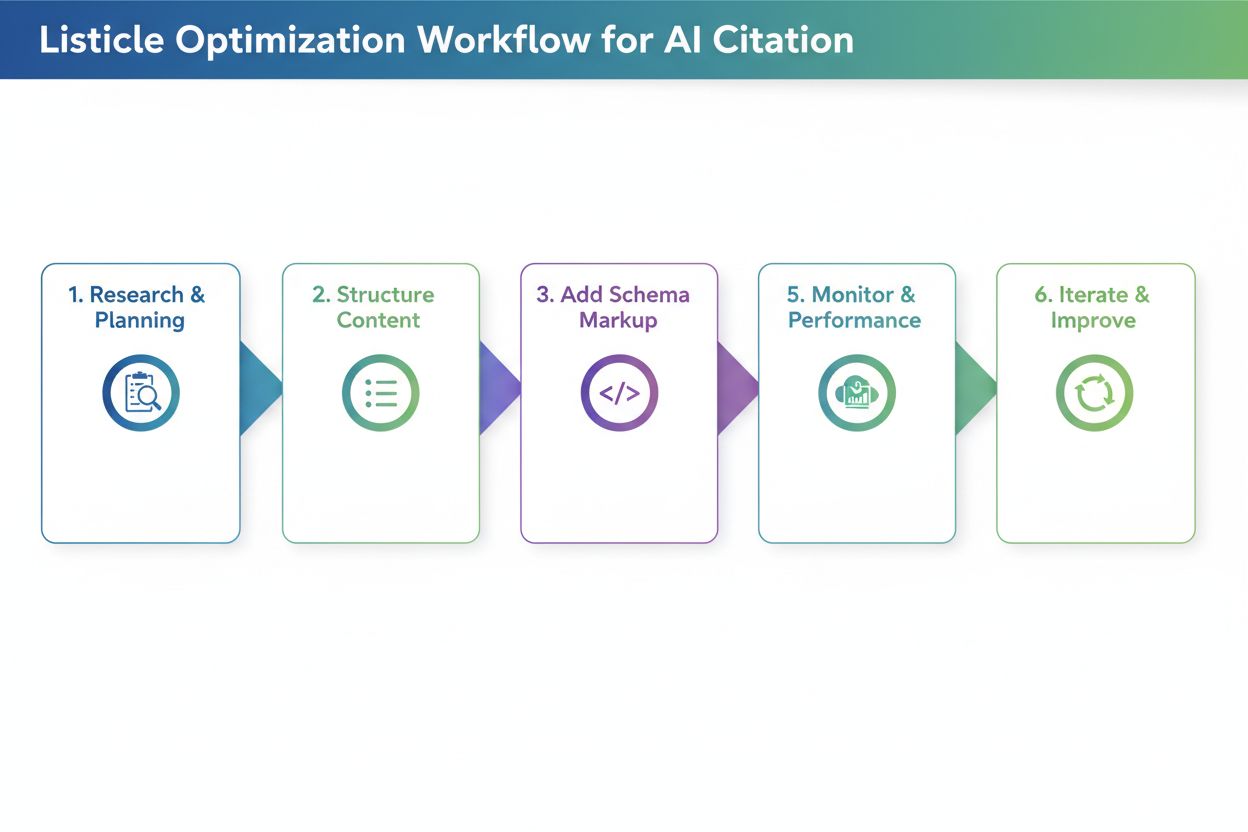

Visualisaties creëren die vaker door AI-systemen worden geciteerd, vraagt om bewuste ontwerpkeuzes die helderheid, rijke metadata en machine-leesbaarheid prioriteren. Felle, contrastrijke kleurenschema’s en duidelijke labels verbeteren de AI-verwerking van grafieken aanzienlijk, omdat modellen moeite hebben met subtiele gradiënten, overlappende elementen en onduidelijke legenda’s die voor mensen vanzelfsprekend zijn. Voeg uitgebreide alt-tekstbeschrijvingen toe die niet alleen weergeven wat de grafiek toont, maar ook de onderliggende dataverhoudingen, belangrijkste inzichten en broninformatie bevatten—deze metadata vormt de basis voor correcte AI-citaties. Embed gestructureerde data in je visualisaties via standaarden als JSON-LD of microdata-markup, zodat AI-systemen exacte waarden en relaties kunnen extraheren in plaats van alleen visuele interpretatie. Zorg dat grafiektitels beschrijvend en specifiek zijn in plaats van algemeen, omdat AI-modellen titels gebruiken als primaire ankers voor het begrijpen en citeren van visuele inhoud. Geef bronvermelding direct in de visualisatie via voetnoten, watermerken of geïntegreerde bronlabels, zodat AI-systemen de grafiek niet los kunnen zien van de herkomst. Organisaties die deze praktijken consequent toepassen, zien meetbare verbeteringen in hoe hun visuele inhoud wordt geciteerd op AI-platforms, wat leidt tot betere toeschrijving, grotere zichtbaarheid en een sterkere professionele reputatie.

Het aanbod van tools voor het monitoren van visuele citaties groeit snel nu organisaties het belang inzien van het volgen van AI-referenties naar visuele inhoud. AmICited.com springt eruit als een allesomvattende oplossing, speciaal ontworpen voor het monitoren van citaties van visuele inhoud over meerdere AI-platforms, en biedt makers gedetailleerde dashboards waarop precies te zien is wanneer en hoe hun grafieken worden geciteerd door ChatGPT, Claude, Perplexity, Google AI Overviews en nieuwe AI-systemen. Traditionele trackingplatforms zoals Google Scholar en Scopus richten zich vooral op academische papers en tekstgebaseerde citaties, waardoor visuele inhoud grotendeels onopgemerkt en zonder toeschrijving blijft. Gespecialiseerde tools zoals Tinybird en vergelijkbare datavisualisatie-platforms integreren nu citatie-trackingmogelijkheden, waardoor organisaties kunnen volgen hoe hun realtime datavisualisaties worden geconsumeerd en gerefereerd door AI-systemen. De visuele analytics van AmICited geven inzicht in citatiefrequentie, nauwkeurigheidspercentages en platformspecifieke patronen, zodat makers weten welke AI-systemen hun werk correct toeschrijven en waar bijsturing nodig is. Voor organisaties die serieus omgaan met bescherming van hun visueel intellectueel eigendom en de invloed van hun content in het AI-gedreven informatielandschap willen begrijpen, is het implementeren van een dedicated monitoringoplossing als AmICited.com onmisbaar geworden—het transformeert citatie-tracking van passieve observatie naar actief beheer dat leidt tot betere toeschrijvingsresultaten.

Huidige AI-modellen hebben uiteenlopende capaciteiten als het gaat om het citeren van visuele inhoud. Terwijl geavanceerde modellen zoals Claude en Perplexity grafieken met redelijke nauwkeurigheid kunnen refereren, hebben veel systemen moeite met correcte toeschrijving. De meeste LLM's zijn voornamelijk getraind op tekstdata, waardoor visuele citatie minder betrouwbaar is dan tekstcitaten. Daarom zijn monitoringtools zoals AmICited essentieel om bij te houden hoe je visualisaties daadwerkelijk worden geciteerd.

AmICited.com biedt uitgebreide monitoring van visuele inhoud over meerdere AI-platforms, waaronder ChatGPT, Claude, Perplexity en Google AI Overviews. Het platform gebruikt geautomatiseerde visuele vingerafdrukken en metadata-analyse om te identificeren wanneer je grafieken verschijnen in AI-gegenereerde inhoud, met realtime meldingen en gedetailleerde analyses over de nauwkeurigheid en frequentie van citaties.

AI-systemen citeren grafieken nauwkeuriger wanneer ze gebruikmaken van felle, contrastrijke kleuren, duidelijke labels, beschrijvende titels en uitgebreide alt-tekst. Het toevoegen van gestructureerde datamarkup, bronvermelding binnen de visualisatie en goed georganiseerde legenda's verbetert de AI-verwerking en de kans op citatie aanzienlijk. Het maken van meerdere versies van complexe visualisaties—vereenvoudigd voor AI en gedetailleerd voor mensen—verhoogt ook de vindbaarheid.

Op basis van de huidige mogelijkheden tonen Claude 3 en Perplexity AI de hoogste nauwkeurigheid in visuele inhoudtoeschrijving, met citatienauwkeurigheidspercentages van 80-90%. Google AI Overviews en Gemini Pro Vision presteren redelijk goed met 75-80%, terwijl ChatGPT's GPT-4V, ondanks zijn vision-mogelijkheden, vaak standaard generieke beschrijvingen geeft in plaats van nauwkeurige citaties. Deze capaciteiten blijven zich ontwikkelen naarmate modellen worden bijgewerkt.

Het volgen van visuele citaties is cruciaal voor merkzichtbaarheid, het beoordelen van de waarde van inhoud en het beschermen van intellectueel eigendom. Wanneer je grafieken correct worden geciteerd door AI-systemen, vergroot dit de zichtbaarheid van je merk in AI-gegenereerde inhoud, bevestigt het de invloed van je content en helpt het je begrijpen hoe je werk AI-gedreven informatievorming beïnvloedt. Zonder tracking verlies je inzicht in het bereik en de impact van je inhoud.

AmICited is gespecialiseerd in het volgen van citaties van visuele inhoud over meerdere AI-platforms, met gedetailleerde dashboards die tonen wanneer en hoe je grafieken worden geciteerd. Het platform biedt realtime meldingen, citatienauwkeurigheidsstatistieken, platform-specifieke analyses en bruikbare inzichten om de vindbaarheid van visuele inhoud te verbeteren. Het verandert citatie-tracking van passieve observatie in actief beheer van je visueel intellectueel eigendom.

Tekstcitaten in AI-systemen zijn over het algemeen betrouwbaarder omdat LLM's vooral op tekstdata zijn getraind. Visuele citaties vereisen extra verwerkingsstappen—AI moet eerst visuele elementen omzetten in tekstbeschrijvingen, waardoor vaak nuances en exacte waarden verloren gaan. Dit conversieproces vergroot de kans op fouten, waardoor visuele citaties minder accuraat en consistent zijn dan tekstcitaten, afhankelijk van het AI-platform.

Absoluut. Implementeer best practices zoals het gebruik van felle, contrastrijke kleuren, het maken van beschrijvende titels en alt-tekst, het inbedden van gestructureerde datamarkup en het opnemen van bronvermelding direct in visualisaties. Vermijd subtiele gradiënten, overlappende elementen en onduidelijke legenda's. Overweeg vereenvoudigde versies van complexe grafieken te maken, specifiek voor AI-verwerking. Deze verbeteringen maken je visualisaties beter vindbaar en citeren door AI-systemen.

Volg hoe AI-systemen je grafieken en visualisaties citeren in ChatGPT, Claude, Perplexity en Google AI. Ontvang realtime meldingen en gedetailleerde analyses over de toeschrijving van visuele inhoud.

Ontdek hoe datavisualisaties de zichtbaarheid in AI-zoekopdrachten verbeteren, LLM's helpen content te begrijpen en het aantal citaties in AI-gegenereerde antwo...

Ontdek hoe Retrieval-Augmented Generation AI-verwijzingen transformeert, waardoor nauwkeurige bronvermelding en onderbouwde antwoorden mogelijk zijn in ChatGPT,...

Ontdek waarom AI-modellen de voorkeur geven aan listicles en genummerde lijsten. Leer hoe je lijstgebaseerde content optimaliseert voor citaties door ChatGPT, G...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.