Promptbibliotheken voor handmatige AI-zichtbaarheidstesten

Leer hoe je promptbibliotheken bouwt en gebruikt voor handmatige AI-zichtbaarheidstesten. Doe-het-zelfgids voor het testen hoe AI-systemen jouw merk noemen op C...

Leer hoe je de aanwezigheid van je merk in AI-engines test met prompt testing. Ontdek handmatige en geautomatiseerde methoden om AI-zichtbaarheid te monitoren op ChatGPT, Perplexity en Google AI.

Prompt testing is het proces van het systematisch indienen van vragen bij AI-engines om te meten of je content verschijnt in hun antwoorden. In tegenstelling tot traditionele SEO-tests, die zich richten op zoekposities en doorklikratio’s, beoordeelt AI-zichtbaarheid testen je aanwezigheid op generatieve AI-platforms zoals ChatGPT, Perplexity en Google AI Overviews. Dit onderscheid is cruciaal omdat AI-engines andere rangschikkingmechanismen, ophaalsystemen en citaatpatronen gebruiken dan traditionele zoekmachines. Je aanwezigheid testen in AI-antwoorden vereist een fundamenteel andere aanpak—een die rekening houdt met hoe grote taalmodellen informatie van het web ophalen, samenvoegen en toeschrijven.

Handmatige prompt testing blijft het meest toegankelijke startpunt om je AI-zichtbaarheid te begrijpen, al vereist het discipline en documentatie. Zo werkt testen op de belangrijkste AI-platforms:

| AI-engine | Teststappen | Voordelen | Nadelen |

|---|---|---|---|

| ChatGPT | Prompts indienen, antwoorden bekijken, vermeldingen/citaties noteren, resultaten documenteren | Directe toegang, gedetailleerde antwoorden, citaat-tracking | Tijdrovend, inconsistente resultaten, beperkte historische data |

| Perplexity | Vragen invoeren, bronvermelding analyseren, positie van citaties bijhouden | Duidelijke bronvermelding, realtime data, gebruiksvriendelijk | Handmatige documentatie vereist, beperkte querycapaciteit |

| Google AI Overviews | Zoekopdrachten in Google, AI-gegenereerde samenvattingen bekijken, bronvermelding noteren | Geïntegreerd met zoekopdrachten, hoog verkeerpotentieel, natuurlijk gebruikersgedrag | Beperkte controle over zoekvariaties, inconsistente weergave |

| Google AI Mode | Toegang via Google Labs, specifieke vragen testen, featured snippets bijhouden | Opkomend platform, directe testtoegang | Vroeg stadium platform, beperkte beschikbaarheid |

ChatGPT testen en Perplexity testen vormen de basis van de meeste handmatige teststrategieën, aangezien deze platforms de grootste gebruikersbasis en de meest transparante citaatmechanismen bieden.

Hoewel handmatig testen waardevolle inzichten biedt, wordt het al snel onpraktisch op schaal. Zelfs 50 prompts handmatig testen op vier AI-engines betekent meer dan 200 afzonderlijke zoekopdrachten, elk met handmatige documentatie, screenshot-captures en resultaatanalyse—een proces dat 10-15 uur per testcyclus kost. Beperkingen van handmatig testen gaan verder dan tijdsinvestering: menselijke testers zorgen voor inconsistentie in documentatie, hebben moeite om de testfrequentie vol te houden die nodig is om trends te volgen, en kunnen geen data over honderden prompts samenvoegen om patronen te herkennen. Het schaalprobleem wordt nijpend als je branded variaties, unbranded variaties, long-tail zoekopdrachten en concurrerende benchmarking tegelijk wilt testen. Bovendien biedt handmatig testen alleen momentopnamen; zonder geautomatiseerde systemen kun je niet volgen hoe je zichtbaarheid week-op-week verandert of welke contentupdates daadwerkelijk je AI-aanwezigheid verbeteren.

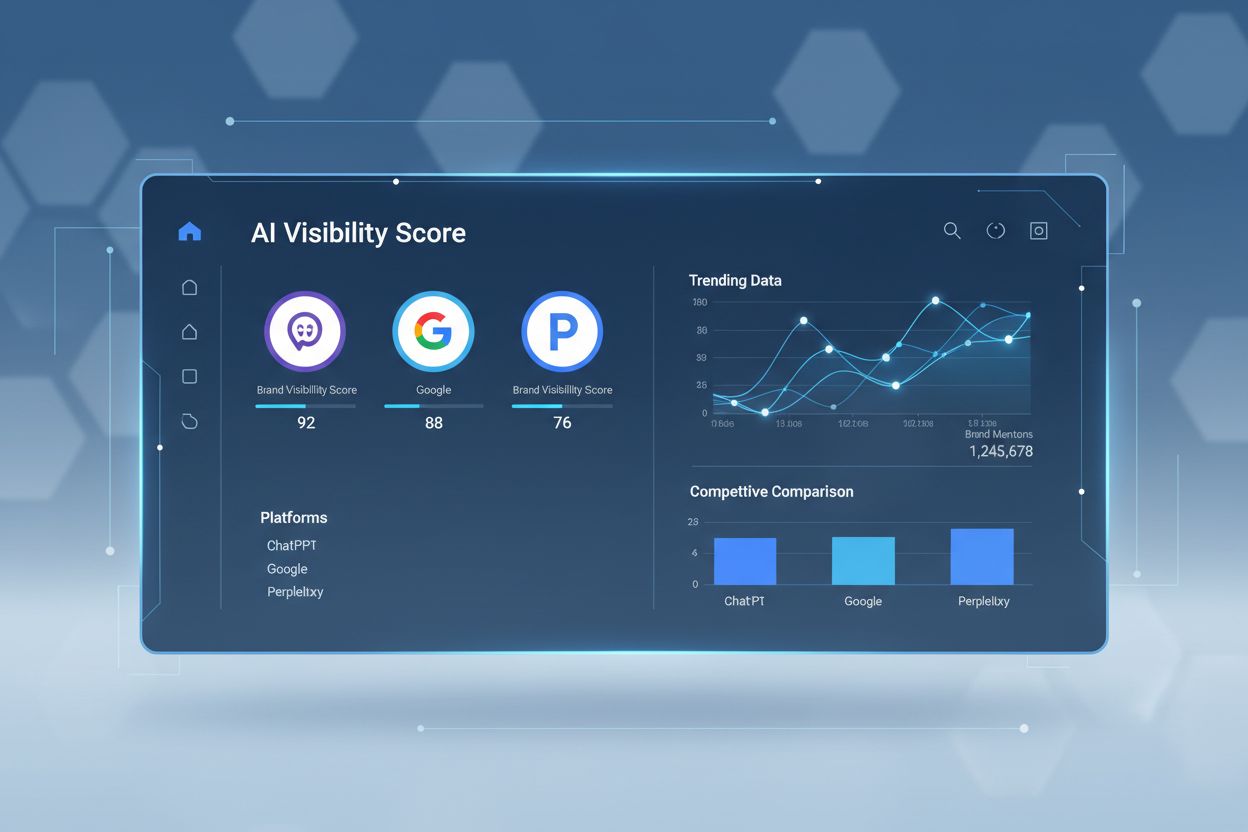

Geautomatiseerde AI-zichtbaarheid tools nemen de handmatige last weg door continu prompts in te dienen bij AI-engines, antwoorden vast te leggen en resultaten te verzamelen in dashboards. Deze platforms gebruiken API’s en geautomatiseerde workflows om honderden of duizenden prompts te testen op schema’s die je zelf bepaalt—dagelijks, wekelijks of maandelijks—zonder menselijke tussenkomst. Geautomatiseerd testen legt gestructureerde data vast over vermeldingen, citaties, attributienauwkeurigheid en sentiment bij alle grote AI-engines tegelijk. Met realtime monitoring kun je zichtbaarheidsveranderingen direct ontdekken, deze correleren met contentupdates of algoritmewijzigingen en strategisch reageren. De data-aggregatiecapaciteiten van deze platforms onthullen patronen die onzichtbaar zijn bij handmatig testen: welke onderwerpen de meeste citaties opleveren, welke contentvormen AI-engines prefereren, hoe je share of voice zich verhoudt tot concurrenten en of je citaties correcte attributie en links bevatten. Deze systematische aanpak transformeert AI-zichtbaarheid van een incidentele audit naar een continue informatiestroom die contentstrategie en concurrentiepositie aanstuurt.

Succesvolle prompt testing best practices vragen om doordachte promptselectie en een uitgebalanceerde testportefeuille. Overweeg deze essentiële elementen:

AI-zichtbaarheid metrics bieden een multidimensionaal beeld van je aanwezigheid op generatieve AI-platforms. Citaat-tracking laat niet alleen zien óf je verschijnt, maar ook hoe prominent—ben je de primaire bron, één van meerdere, of slechts terloops genoemd? Share of voice vergelijkt je citaatfrequentie met concurrenten binnen hetzelfde onderwerp, wat je positie en autoriteit aangeeft. Sentimentanalyse, geïntroduceerd door platforms als Profound, beoordeelt of je citaties positief, neutraal of negatief worden gepresenteerd in AI-antwoorden—cruciale context die ruwe aantallen missen. Attributienauwkeurigheid is even belangrijk: kent de AI-engine je content toe met een link, of parafraseert het zonder bronvermelding? Deze metrics vragen om contextuele analyse—één vermelding in een drukbezochte zoekopdracht kan zwaarder wegen dan tien vermeldingen in weinig geraadpleegde queries. Competitieve benchmarking voegt belangrijk perspectief toe: als je in 40% van de relevante prompts verschijnt maar concurrenten in 60%, heb je een zichtbaarheidsgat om aan te pakken.

De markt voor AI-zichtbaarheid platforms omvat diverse gespecialiseerde tools, elk met hun eigen sterke punten. AmICited biedt uitgebreide citaattracking op ChatGPT, Perplexity en Google AI Overviews met gedetailleerde attributieanalyse en competitieve benchmarking. Conductor richt zich op promptniveau tracking en het in kaart brengen van onderwerpautoriteit, zodat teams begrijpen welke onderwerpen de meeste AI-zichtbaarheid genereren. Profound legt nadruk op sentimentanalyse en bronvermelding-nauwkeurigheid, cruciaal om te begrijpen hoe AI-engines je content presenteren. LLM Pulse biedt handmatige testbegeleiding en dekking van opkomende platforms—waardevol voor teams die testprocessen vanaf nul opbouwen. De keuze hangt af van je prioriteiten: als volledige automatisering en competitieve analyse het belangrijkst zijn, blinkt AmICited uit; als onderwerpautoriteit centraal staat, past de aanpak van Conductor beter; als inzicht in de framing van je content cruciaal is, springen de sentimentmogelijkheden van Profound eruit. De meeste geavanceerde teams gebruiken meerdere platforms voor aanvullende inzichten.

Organisaties ondermijnen hun testinspanningen vaak door te voorkomen fouten. Overmatige focus op branded prompts creëert een vals gevoel van zichtbaarheid—je scoort misschien goed op “Bedrijfsnaam” zoekopdrachten, terwijl je onzichtbaar blijft voor de industrie-onderwerpen die echt voor verkeer zorgen. Inconsistente testschema’s leveren onbetrouwbare data op; sporadisch testen maakt het onmogelijk om echte trends te onderscheiden van normale fluctuatie. Het negeren van sentimentanalyse leidt tot verkeerde interpretatie—verschijnen in een AI-antwoord dat je content negatief framet of concurrenten positief positioneert, kan je positie zelfs schaden. Het missen van pagina-niveau data belemmert optimalisatie: weten dat je verschijnt voor een onderwerp is waardevol, maar weten wélke pagina’s verschijnen en hoe die worden toegeschreven maakt gerichte verbetering mogelijk. Een andere fout is alleen huidige content testen; historische content testen onthult of oudere pagina’s nog AI-zichtbaarheid genereren of zijn verdrongen door nieuwere bronnen. Ten slotte, als je resultaten niet koppelt aan contentwijzigingen, kun je niet leren welke updates daadwerkelijk je AI-zichtbaarheid verbeteren en blijft continue optimalisatie uit.

Prompt testing resultaten moeten direct je contentstrategie en AI-optimalisatie sturen. Als testen aantoont dat concurrenten een belangrijk onderwerp domineren waar jij nauwelijks zichtbaar bent, wordt dat onderwerp een contentprioriteit—door nieuwe content te maken of bestaande pagina’s te optimaliseren. Testresultaten laten zien welke contentvormen AI-engines prefereren: als de lijstartikelen van je concurrent vaker verschijnen dan jouw longform gidsen, kan een formatwijziging je zichtbaarheid verbeteren. Topic authority blijkt uit testdata—onderwerpen waar je consequent verschijnt in meerdere promptvariaties duiden op gevestigde autoriteit, waar sporadische aanwezigheid wijst op contentgaten of zwakke positionering. Gebruik testen om contentstrategie vooraf te valideren: als je een nieuw onderwerp wilt aanvallen, test eerst de huidige zichtbaarheid om concurrentiekracht en potentiële zichtbaarheid realistisch in te schatten. Testen onthult ook attributiepatronen: als AI-engines je content citeren zonder links, moet je contentstrategie zich richten op unieke data, origineel onderzoek en onderscheidende inzichten die AI-engines móéten vermelden. Integreer ten slotte testen in je contentkalender—plan testcycli rond grote contentlanceringen om impact te meten en strategie bij te stellen op basis van echte AI-zichtbaarheid in plaats van aannames.

Handmatig testen houdt in dat je afzonderlijk prompts indient bij AI-engines en de resultaten handmatig documenteert, wat tijdrovend is en moeilijk op te schalen. Geautomatiseerd testen gebruikt platforms om continu honderden prompts volgens schema in te dienen bij meerdere AI-engines, waarbij gestructureerde data wordt vastgelegd en resultaten worden samengevoegd in dashboards voor trendanalyse en competitieve benchmarking.

Stel een consistente testfrequentie in van minimaal wekelijks of tweewekelijks om betekenisvolle trends te volgen en zichtbaarheidsveranderingen te correleren met contentupdates of algoritmewijzigingen. Vaker testen (dagelijks) is nuttig voor prioriteitsonderwerpen of competitieve markten, terwijl minder vaak (maandelijks) voldoende kan zijn voor stabiele, volwassen contentgebieden.

Volg de 75/25-regel: ongeveer 75% unbranded prompts (industrie-onderwerpen, probleemstellingen, informatieve vragen) en 25% branded prompts (je bedrijfsnaam, productnamen, branded zoekwoorden). Deze balans helpt om zowel ontdekking als merkgebonden zichtbaarheid te begrijpen zonder resultaten te vertekenen met zoekopdrachten waarin je waarschijnlijk al domineert.

Je zult de eerste signalen binnen de eerste paar testcycli zien, maar betekenisvolle patronen ontstaan meestal na 4-6 weken consequent volgen. Deze periode stelt je in staat om een basislijn vast te stellen, natuurlijke fluctuaties in AI-antwoorden te verwerken en zichtbaarheid te correleren met specifieke contentupdates of optimalisatie-inspanningen.

Ja, je kunt handmatig gratis testen uitvoeren door direct toegang te krijgen tot ChatGPT, Perplexity, Google AI Overviews en Google AI Mode. Gratis handmatig testen is echter beperkt in schaal en consistentie. Geautomatiseerde platforms zoals AmICited bieden gratis proefperiodes of freemium-opties om de aanpak te testen voordat je overstapt op betaalde abonnementen.

De belangrijkste meetwaarden zijn citaties (wanneer AI-engines naar je content linken), vermeldingen (wanneer je merk genoemd wordt), share of voice (je zichtbaarheid ten opzichte van concurrenten) en sentiment (of je citaties positief worden weergegeven). Attributienauwkeurigheid—of AI-engines je content correct toeschrijven—is net zo essentieel om de werkelijke impact van zichtbaarheid te begrijpen.

Effectieve prompts leveren consistente, bruikbare data op die overeenkomt met je bedrijfsdoelen. Test of je prompts het echte gebruikersgedrag weerspiegelen door ze te vergelijken met zoekquery-data, klantinterviews en verkoopgesprekken. Prompts die zichtbaarheid veranderen na contentupdates zijn bijzonder waardevol om je teststrategie te valideren.

Begin met de belangrijkste engines (ChatGPT, Perplexity, Google AI Overviews) die de grootste gebruikersbasis en verkeerpotentieel vertegenwoordigen. Naarmate je programma volwassener wordt, breid je uit naar opkomende engines zoals Gemini, Claude en andere die relevant zijn voor je doelgroep. De keuze hangt af van waar je doelklanten daadwerkelijk actief zijn en welke engines het meeste verkeer naar je site sturen.

Test de aanwezigheid van je merk in ChatGPT, Perplexity, Google AI Overviews en meer met de uitgebreide AI-zichtbaarheid monitoring van AmICited.

Leer hoe je promptbibliotheken bouwt en gebruikt voor handmatige AI-zichtbaarheidstesten. Doe-het-zelfgids voor het testen hoe AI-systemen jouw merk noemen op C...

Leer hoe je effectief promptonderzoek uitvoert voor AI-zichtbaarheid. Ontdek de methodologie voor het begrijpen van gebruikersvragen in LLM's en het volgen van ...

Beheers de Semrush AI Visibility Toolkit met onze uitgebreide gids. Leer hoe je merkzichtbaarheid in AI-zoekopdrachten monitort, concurrenten analyseert en opti...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.