Wanneer SEO-rankings niet gelijk staan aan AI-zichtbaarheid: de kloof

Ontdek waarom hoge Google-rankings geen garantie zijn voor AI-zichtbaarheid. Leer het verschil tussen SEO en AI-vermeldingen, en hoe je voor beide zoekkanalen o...

De mate waarin AI-platforms openheid geven over hoe zij bronnen selecteren en rangschikken bij het genereren van antwoorden. AI-rankingtransparantie verwijst naar de zichtbaarheid van algoritmen en criteria die bepalen welke bronnen verschijnen in AI-gegenereerde antwoorden, wat het onderscheidt van traditionele zoekmachineranking. Deze transparantie is essentieel voor contentmakers, uitgevers en gebruikers die moeten begrijpen hoe informatie wordt geselecteerd en geprioriteerd. Zonder transparantie kunnen gebruikers de geloofwaardigheid van bronnen niet verifiëren of mogelijke vooringenomenheid in AI-content begrijpen.

De mate waarin AI-platforms openheid geven over hoe zij bronnen selecteren en rangschikken bij het genereren van antwoorden. AI-rankingtransparantie verwijst naar de zichtbaarheid van algoritmen en criteria die bepalen welke bronnen verschijnen in AI-gegenereerde antwoorden, wat het onderscheidt van traditionele zoekmachineranking. Deze transparantie is essentieel voor contentmakers, uitgevers en gebruikers die moeten begrijpen hoe informatie wordt geselecteerd en geprioriteerd. Zonder transparantie kunnen gebruikers de geloofwaardigheid van bronnen niet verifiëren of mogelijke vooringenomenheid in AI-content begrijpen.

AI-rankingtransparantie verwijst naar de openheid over hoe artificiële intelligentiesystemen bronnen selecteren, prioriteren en presenteren bij het genereren van antwoorden op gebruikersvragen. In tegenstelling tot traditionele zoekmachines, die gerangschikte lijsten met links tonen, integreren moderne AI-platforms zoals Perplexity, ChatGPT en Google’s AI Overviews de bronselectie in hun antwoordgeneratieproces, waardoor de rankingcriteria grotendeels onzichtbaar zijn voor gebruikers. Deze ondoorzichtigheid creëert een kritieke kloof tussen wat gebruikers zien (een gesynthetiseerd antwoord) en hoe dat antwoord is opgebouwd (welke bronnen zijn gekozen, gewogen en geciteerd). Voor contentmakers en uitgevers betekent dit gebrek aan transparantie dat hun zichtbaarheid afhangt van algoritmen die zij niet kunnen begrijpen of beïnvloeden via traditionele optimalisatiemethoden. Het verschil met transparantie bij traditionele zoekmachines is groot: waar Google algemene rankingfactoren en kwaliteitsrichtlijnen publiceert, behandelen AI-platforms hun bronselectiemechanismen vaak als bedrijfsgeheim. Belangrijke belanghebbenden zijn onder meer contentmakers die zichtbaarheid zoeken, uitgevers die zich zorgen maken over traffic-attributie, merkmanagers die reputatie monitoren, onderzoekers die informatiebronnen willen verifiëren en gebruikers die de geloofwaardigheid van AI-antwoorden moeten inschatten. Inzicht in AI-rankingtransparantie is essentieel geworden voor iedereen die digitale content produceert, verspreidt of vertrouwt in een steeds meer door AI beïnvloede informatielandschap.

AI-platforms gebruiken Retrieval-Augmented Generation (RAG)-systemen die taalmodellen combineren met realtime informatie-opzoeking om antwoorden te onderbouwen met daadwerkelijke bronnen in plaats van uitsluitend trainingsdata. Het RAG-proces bestaat uit drie hoofdfasen: retrieval (vinden van relevante documenten), ranking (rangschikken van bronnen op relevantie) en generatie (samenvoegen van informatie met behoud van bronvermeldingen). Verschillende platforms hanteren verschillende rankingmethoden—Perplexity geeft prioriteit aan bronautoriteit en actualiteit, Google’s AI Overviews leggen de nadruk op relevantie en E-E-A-T-signalen (Ervaring, Expertise, Autoriteit, Betrouwbaarheid), terwijl ChatGPT Search bronkwaliteit afweegt met volledigheid van het antwoord. Factoren die bronselectie beïnvloeden zijn onder andere domeinautoriteit (reputatie en backlinkprofiel), actualiteit van de content (versheid van informatie), thematische relevantie (semantische afstemming op de vraag), betrokkenheidssignalen (gebruikersinteractie) en citatiefrequentie (hoe vaak bronnen door andere gezaghebbende sites worden genoemd). AI-systemen wegen deze signalen anders afhankelijk van de bedoeling van de vraag—feitelijke vragen geven meer gewicht aan autoriteit en actualiteit, terwijl meningsvragen juist diverse perspectieven en betrokkenheid benadrukken. De rankingalgoritmen blijven grotendeels onbekend, al geven platformdocumentaties beperkt inzicht in hun weging.

| Platform | Citatietransparantie | Criteria Bronselectie | Openheid Rankingalgoritme | Gebruikerscontrole |

|---|---|---|---|---|

| Perplexity | Hoog - inline citaties met links | Autoriteit, actualiteit, relevantie, expertise | Matig - enige documentatie | Medium - bronfilters |

| Google AI Overviews | Medium - geciteerde bronnen vermeld | E-E-A-T, relevantie, recentheid, betrokkenheid | Laag - minimale openheid | Laag - beperkte opties |

| ChatGPT Search | Medium - bronnen los vermeld | Kwaliteit, relevantie, volledigheid, autoriteit | Laag - eigendom algoritme | Laag - geen opties |

| Brave Leo | Medium - bronvermelding | Privacyvriendelijke bronnen, relevantie, autoriteit | Laag - privacygericht ondoorzichtig | Medium - bronselectieopties |

| Consensus | Zeer hoog - academische focus met maatstaven | Citatieaantal, peer-reviewstatus, recentheid, vakrelevantie | Hoog - academische normen transparant | Hoog - filter op type en kwaliteit studie |

De AI-sector mist gestandaardiseerde transparantiepraktijken voor hoe rankingsystemen werken, wat resulteert in een versnipperd landschap waarin elk platform zelf bepaalt hoeveel het openbaart. OpenAI’s ChatGPT Search biedt minimale uitleg over bronselectie, Meta’s AI-systemen hebben beperkte documentatie en Google’s AI Overviews geven meer prijs dan concurrenten maar onthullen nog steeds cruciale details niet. Platforms onthouden volledige openheid vanwege concurrentievoordeel, bedrijfseigendom en de complexiteit van het uitleggen van machine learning aan een breed publiek—maar deze ondoorzichtigheid verhindert externe controle en verantwoording. Het “bron-was”-probleem ontstaat wanneer AI-systemen bronnen citeren die zelf oorspronkelijk werk aggregeren of herschrijven, waardoor de ware oorsprong van informatie vertroebeld raakt en desinformatie zich via meerdere lagen van synthese kan verspreiden. De EU AI Act vereist documentatie van trainingsdata en besluitvorming voor AI-systemen met hoog risico, terwijl het NTIA AI Accountability Policy bedrijven vraagt AI-mogelijkheden, beperkingen en gepast gebruik bekend te maken. Voorbeelden van gebrekkige openheid zijn Perplexity’s initiële problemen met bronvermelding (inmiddels verbeterd), Google’s vage uitleg over bronselectie in AI Overviews en ChatGPT’s beperkte transparantie over waarom bepaalde bronnen verschijnen. Het ontbreken van gestandaardiseerde meetmethoden voor transparantie maakt het moeilijk voor gebruikers en toezichthouders om platforms objectief te vergelijken.

De ondoorzichtigheid van AI-rankingsystemen zorgt voor aanzienlijke zichtbaarheidsuitdagingen voor contentmakers, omdat traditionele SEO-strategieën niet één-op-één toepasbaar zijn op AI-platformoptimalisatie. Uitgevers kunnen niet eenvoudig begrijpen waarom hun content soms wel en soms niet in AI-antwoorden verschijnt, waardoor het onmogelijk is gerichte strategieën te ontwikkelen voor meer zichtbaarheid in AI-antwoorden. Citatiebias ontstaat wanneer AI-systemen bepaalde bronnen—gevestigde nieuwsmedia, academische instellingen of drukbezochte websites—voorkeur geven, terwijl kleinere uitgevers, onafhankelijke makers en niche-experts met even waardevolle informatie worden gemarginaliseerd. Vooral kleinere uitgevers zijn benadeeld omdat AI-rankingsystemen vaak zwaar leunen op domeinautoriteit, en jongere of gespecialiseerde sites missen de backlinks en bekendheid van gevestigde namen. Onderzoek van Search Engine Land wijst uit dat AI Overviews de doorklikratio naar traditionele zoekresultaten met 18-64% heeft verminderd, met verkeer geconcentreerd bij de weinige bronnen die in AI-antwoorden worden vermeld. Het verschil tussen SEO (Search Engine Optimization) en GEO (Generative Engine Optimization) wordt steeds belangrijker—waar SEO focust op ranking in traditionele zoekmachines, vereist GEO inzicht in en optimalisatie voor AI-selectiecriteria, die grotendeels onduidelijk blijven. Contentmakers hebben tools zoals AmICited.com nodig om te monitoren waar hun content in AI-antwoorden verschijnt, citatiefrequentie bij te houden en hun zichtbaarheid op verschillende AI-platforms te begrijpen.

De AI-sector heeft diverse raamwerken ontwikkeld voor het documenteren en openbaar maken van systeemgedrag, al is de adoptie ervan wisselend. Modelkaarten bieden gestandaardiseerde documentatie van modelprestaties, beoogd gebruik, beperkingen en biasanalyse—vergelijkbaar met een voedingswaardelabel voor AI-systemen. Datasheets voor datasets documenteren samenstelling, verzamelmethode en mogelijke vooroordelen in trainingsdata, vanuit het principe dat AI slechts zo goed is als zijn trainingsgegevens. Systemkaarten pakken het breder aan en documenteren het gedrag van het hele systeem, inclusief interactie tussen componenten, potentiële faalpunten en prestaties in de praktijk bij verschillende gebruikersgroepen. Het NTIA AI Accountability Policy beveelt aan dat bedrijven gedetailleerde documentatie bijhouden van AI-ontwikkeling, testen en uitrol, met nadruk op toepassingen met maatschappelijk belang. De EU AI Act verplicht AI-systemen met hoog risico tot technische documentatie, trainingsdatalogs en prestatierapporten, alsmede transparantierapporten en gebruikerswaarschuwingen. Steeds vaker gelden deze best practices in de sector:

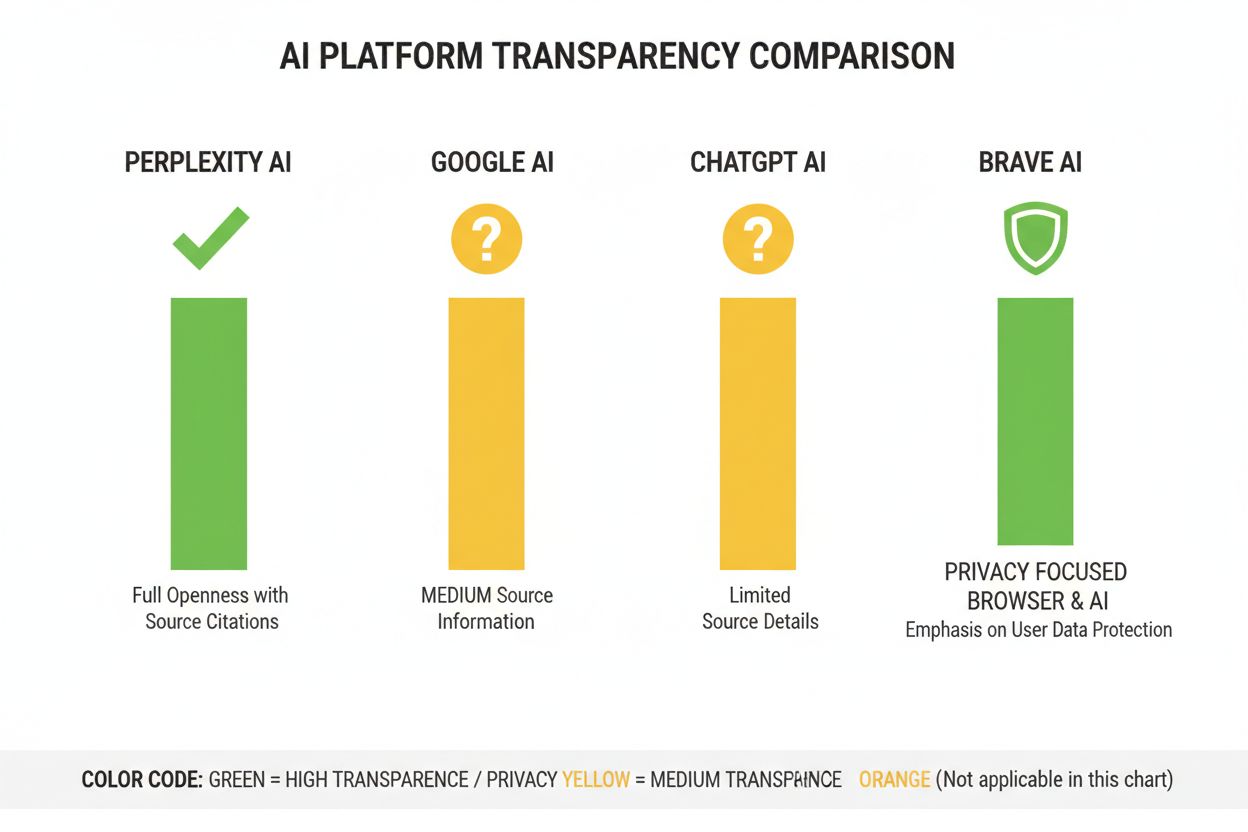

Perplexity positioneert zich als het meest transparante AI-platform qua bronvermelding, met inline bronlinks in antwoorden zodat gebruikers precies zien welke bronnen aan elke uitspraak bijdragen. Het platform documenteert zijn rankingaanpak redelijk duidelijk en benadrukt bronautoriteit, expertise en actualiteit, al blijft de exacte weging eigendom. Google’s AI Overviews bieden gematigde transparantie door geciteerde bronnen te vermelden, maar geven beperkt uitleg over waarom bepaalde bronnen zijn geselecteerd en hoe het algoritme signalen weegt. Google’s documentatie benadrukt E-E-A-T-principes maar maakt de meting en weging hiervan in het AI-proces niet volledig duidelijk. OpenAI’s ChatGPT Search zit daar tussenin, toont bronnen apart van het antwoord en laat gebruikers doorklikken naar originele content, maar biedt nauwelijks uitleg over selectiecriteria of rankingmethode. Brave Leo legt de nadruk op privacygerichte transparantie, geeft aan privacyvriendelijke bronnen te gebruiken en geen zoekopdrachten op te slaan, maar dit gaat ten koste van uitleg over de rankingmechanismen. Consensus onderscheidt zich door exclusief academisch onderzoek te behandelen, met hoge transparantie via citatiemaatstaven, peer-reviewstatus en kwaliteit van studies—en is daarmee het meest transparante platform voor onderzoeksgerichte vragen. Gebruikerscontrole varieert sterk: Perplexity laat bronfiltering toe, Consensus biedt filtering op type en kwaliteit van studies, terwijl Google en ChatGPT nauwelijks opties bieden. De variatie in transparantie weerspiegelt verschillende businessmodellen en doelgroepen, waarbij academische platforms disclosure prioriteren en consumentenplatforms balans zoeken tussen openheid en bedrijfsgeheim.

Vertrouwen en geloofwaardigheid zijn fundamenteel afhankelijk van het begrip van gebruikers over hoe informatie hen bereikt—als AI-systemen bronnen of logica verbergen, kunnen gebruikers claims niet onafhankelijk verifiëren of bronbetrouwbaarheid inschatten. Transparantie maakt verificatie en factchecking mogelijk, zodat onderzoekers, journalisten en kritische gebruikers uitspraken kunnen herleiden tot originele bronnen en deze op juistheid en context beoordelen. Voorkómen van desinformatie en bias is een groot voordeel: als rankingalgoritmen zichtbaar zijn, kunnen onderzoekers systematische vooroordelen signaleren (zoals politieke voorkeur of commerciële belangen) en kunnen platforms worden aangesproken op het versterken van onjuiste informatie. Algoritmische verantwoording is een fundamenteel gebruikersrecht in democratische samenlevingen—mensen verdienen inzicht in de werking van systemen die hun informatiesfeer vormen, zeker als deze invloed hebben op publieke opinie, aankopen en kennis. Voor onderzoek en wetenschap is transparantie cruciaal omdat academici bronselectie moeten begrijpen om AI-samenvattingen te kunnen duiden en te voorkomen dat ze steunen op eenzijdige of onvolledige bronnen. Zakelijke gevolgen voor contentmakers zijn groot: zonder inzicht in rankingfactoren kunnen uitgevers hun strategie niet optimaliseren, maken kleinere makers geen eerlijke kans tegen gevestigde partijen en wordt het hele ecosysteem minder meritocratisch. Transparantie beschermt gebruikers ook tegen manipulatie—als rankingcriteria verborgen zijn, kunnen kwaadwillenden onbekende zwaktes uitbuiten om misleidende content te promoten, terwijl transparante systemen kunnen worden gecontroleerd en verbeterd.

Regelgeving stuurt aan op verplichte transparantie: de implementatie van de EU AI Act in 2025-2026 vereist gedetailleerde documentatie en openbaarmaking voor AI-systemen met hoog risico, en soortgelijke regels ontstaan in het VK, Californië en elders. De sector beweegt richting standaardisatie van transparantie, met organisaties zoals Partnership on AI en academische instellingen die raamwerken ontwikkelen voor documentatie en disclosure van AI-gedrag. Gebruikersvraag naar transparantie neemt toe naarmate het bewustzijn groeit over de rol van AI in informatiedistributie—uit enquêtes blijkt dat meer dan 70% van de gebruikers wil weten hoe AI-systemen bronnen selecteren en informatie rangschikken. Technische innovaties in explainable AI (XAI) maken het steeds beter mogelijk om uitleg te geven over rankingbeslissingen zonder bedrijfsgeheimen prijs te geven, bijvoorbeeld met technieken als LIME en SHAP. Monitoringtools zoals AmICited.com worden steeds belangrijker naarmate platforms transparantiemaatregelen invoeren, zodat contentmakers en uitgevers hun zichtbaarheid op meerdere AI-systemen kunnen volgen en de effecten van rankingwijzigingen begrijpen. De samenkomst van regelgeving, gebruikersverwachting en techniek maakt dat 2025-2026 bepalende jaren worden voor AI-rankingtransparantie, met platforms die waarschijnlijk meer gestandaardiseerde disclosure invoeren, betere gebruikerscontrole over bronselectie bieden en duidelijkere uitleg geven over rankinglogica. De toekomstige situatie zal waarschijnlijk bestaan uit gelaagde transparantie—academische platforms voorop met hoge disclosure, consumentenplatforms met matige transparantie en gebruikersopties, en wettelijke compliance als minimumnorm voor de hele sector.

AI-rankingtransparantie verwijst naar hoe open AI-platforms hun algoritmen voor het selecteren en rangschikken van bronnen in gegenereerde antwoorden bekendmaken. Het is belangrijk omdat gebruikers de geloofwaardigheid van bronnen moeten kunnen inschatten, contentmakers hun zichtbaarheid voor AI moeten optimaliseren en onderzoekers informatiebronnen moeten kunnen verifiëren. Zonder transparantie kunnen AI-systemen desinformatie versterken en oneerlijke voordelen creëren voor gevestigde organisaties ten koste van kleinere uitgevers.

AI-platforms gebruiken Retrieval-Augmented Generation (RAG)-systemen die taalmodellen combineren met realtime informatie-opzoeking. Ze rangschikken bronnen op basis van factoren zoals domeinautoriteit, actualiteit van de content, relevantie voor het onderwerp, betrokkenheidssignalen en citatiefrequentie. De exacte weging van deze factoren blijft echter grotendeels eigendom en wordt door de meeste platforms niet bekendgemaakt.

Traditionele SEO richt zich op het ranken in zoekmachinelijsten, waarbij Google algemene rankingfactoren publiceert. AI-rankingtransparantie betreft hoe AI-platforms bronnen selecteren voor gesynthetiseerde antwoorden, wat andere criteria omvat en grotendeels niet bekendgemaakt wordt. Terwijl SEO-strategieën goed zijn gedocumenteerd, blijven AI-rankingfactoren meestal ondoorzichtig.

U kunt doorklikken naar originele bronnen om claims in hun volledige context te verifiëren, controleren of bronnen afkomstig zijn van gezaghebbende domeinen, zoeken naar peer-reviewstatus (vooral bij academische content), en informatie kruisverwijzen met meerdere bronnen. Tools zoals AmICited helpen bij het volgen van welke bronnen in AI-antwoorden verschijnen en hoe vaak uw content wordt geciteerd.

Consensus loopt voorop in transparantie door zich exclusief te richten op peer-reviewed academisch onderzoek met duidelijke citatiemaatstaven. Perplexity biedt inline bronvermeldingen en matige documentatie van rankingfactoren. Google AI Overviews bieden middelmatige transparantie, terwijl ChatGPT Search en Brave Leo beperkte openheid geven over hun rankingalgoritmen.

Modelkaarten zijn gestandaardiseerde documentatie van de prestaties van AI-systemen, beoogde toepassingen, beperkingen en biasanalyse. Datasheets documenteren de samenstelling van trainingsdata, verzamelmethoden en mogelijke vooroordelen. Systemkaarten beschrijven het gedrag van het hele systeem. Deze hulpmiddelen maken AI-systemen transparanter en vergelijkbaar, vergelijkbaar met voedingswaardelabels voor voedsel.

De EU AI Act vereist dat AI-systemen met hoog risico gedetailleerde technische documentatie, trainingsdataregisters en prestatielogs bijhouden. Het schrijft transparantierapporten en gebruikersmelding over AI-gebruik voor. Deze vereisten dwingen AI-platforms tot meer openheid over rankingmechanismen en criteria voor bronselectie.

AmICited.com is een AI-citatiemonitoringplatform dat bijhoudt hoe AI-systemen zoals Perplexity, Google AI Overviews en ChatGPT uw merk en content citeren. Het biedt inzicht in welke bronnen in AI-antwoorden verschijnen, hoe vaak uw content wordt geciteerd en hoe uw rankingtransparantie zich verhoudt tot verschillende AI-platforms.

Volg hoe AI-platforms zoals Perplexity, Google AI Overviews en ChatGPT uw content citeren. Begrijp uw rankingtransparantie en optimaliseer uw zichtbaarheid op AI-zoekmachines met AmICited.

Ontdek waarom hoge Google-rankings geen garantie zijn voor AI-zichtbaarheid. Leer het verschil tussen SEO en AI-vermeldingen, en hoe je voor beide zoekkanalen o...

Ontdek kritieke AI-zichtbaarheidsblinde vlekken waar concurrenten voordeel behalen. Leer een raamwerk voor gap-analyse en tools om AI-aanwezigheid te monitoren ...

Vergelijk AmICited AI-monitoring met Writesonic GEO. Begrijp de verschillen tussen pure monitoring en geïntegreerde optimalisatie voor AI-zoekzichtbaarheid.

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.