Multimodale AI-zoekopdrachten: Optimaliseren voor beeld- en spraakzoekopdrachten

Beheers optimalisatie voor multimodale AI-zoekopdrachten. Leer hoe je afbeeldingen en spraakvragen optimaliseert voor door AI aangedreven zoekresultaten, met st...

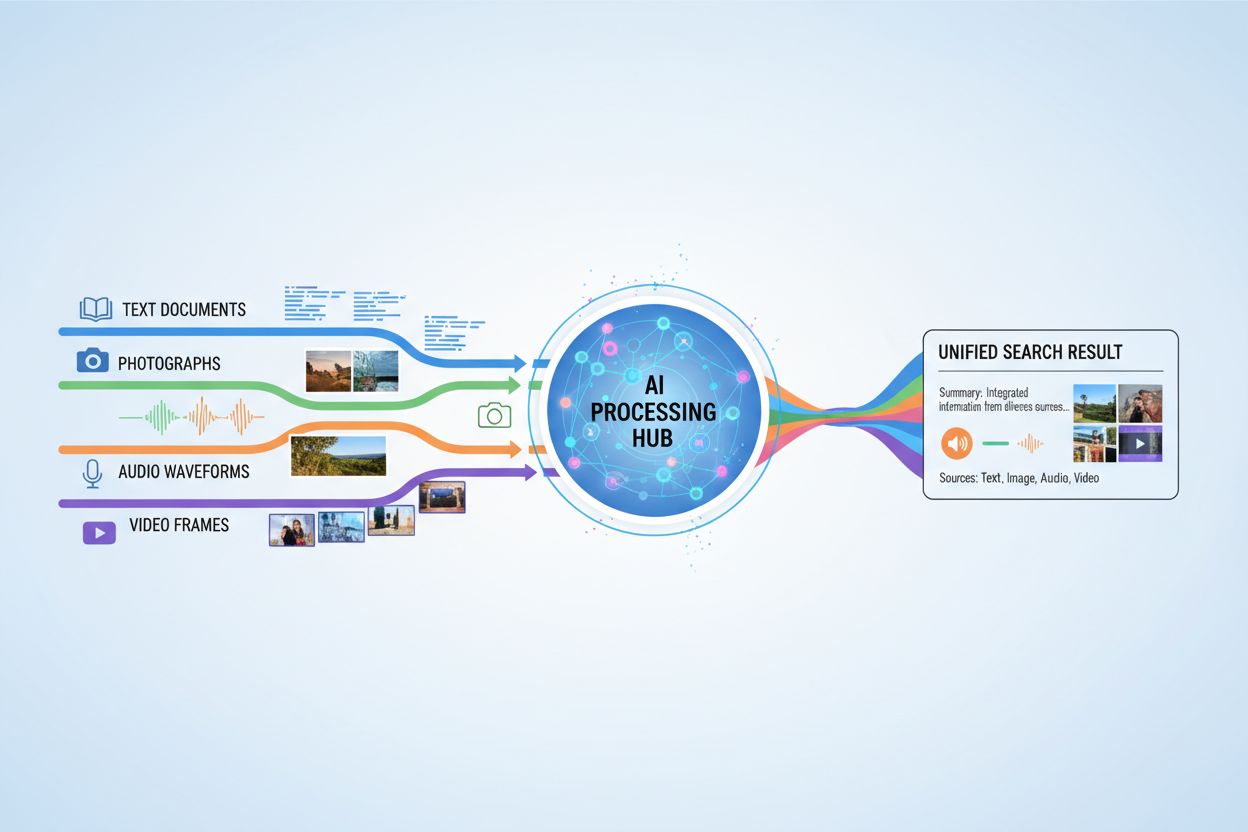

AI-systemen die tegelijkertijd tekst, afbeeldingen, audio en video verwerken en beantwoorden, waardoor een meer omvattend begrip en contextbewuste antwoorden mogelijk zijn over meerdere datatypes.

AI-systemen die tegelijkertijd tekst, afbeeldingen, audio en video verwerken en beantwoorden, waardoor een meer omvattend begrip en contextbewuste antwoorden mogelijk zijn over meerdere datatypes.

Multimodale AI-zoekopdracht verwijst naar kunstmatige intelligentiesystemen die informatie van meerdere datatypes of modaliteiten—zoals tekst, afbeeldingen, audio en video—gelijktijdig verwerken en integreren om meer omvattende en contextueel relevante resultaten te leveren. In tegenstelling tot unimodale AI, die op één type invoer vertrouwt (bijvoorbeeld zoekmachines die alleen tekst gebruiken), maken multimodale systemen gebruik van de aanvullende sterke punten van verschillende dataformaten om tot een dieper begrip en nauwkeurigere uitkomsten te komen. Deze aanpak weerspiegelt het menselijk cognitief vermogen, waarbij we visuele, auditieve en tekstuele informatie combineren om onze omgeving te begrijpen. Door verschillende invoertypes samen te verwerken, kunnen multimodale AI-zoeksystemen nuances en relaties vastleggen die onzichtbaar zouden blijven voor benaderingen met slechts één modaliteit.

Multimodale AI-zoekopdracht werkt via geavanceerde fusietechnieken die informatie uit verschillende modaliteiten op verschillende verwerkingsniveaus combineren. Het systeem extraheert eerst kenmerken uit elke modaliteit afzonderlijk, waarna deze representaties strategisch worden samengevoegd tot één samenhangend geheel. Het tijdstip en de methode van fuseren hebben grote invloed op de prestaties, zoals geïllustreerd in de volgende vergelijking:

| Fusietype | Wanneer Toegepast | Voordelen | Nadelen |

|---|---|---|---|

| Vroege fusie | Invoerfase | Legt laag-niveau correlaties vast | Minder robuust bij niet-uitgelijnde data |

| Middenfusie | Preprocessing-stadia | Gebalanceerde aanpak | Complexer |

| Late fusie | Outputniveau | Modulaire opzet | Minder samenhangende context |

Vroege fusie combineert ruwe data direct, waardoor fijne interacties worden vastgelegd maar het systeem moeite kan hebben met niet-uitgelijnde input. Middenfusie vindt plaats in de tussentijdse verwerkingsfasen en biedt een balans tussen complexiteit en prestaties. Late fusie gebeurt op het outputniveau, waardoor modaliteiten onafhankelijk kunnen worden verwerkt maar mogelijk belangrijke context tussen modaliteiten verloren gaat. De keuze van fusiestrategie hangt af van de specifieke toepassingsvereisten en de aard van de te verwerken data.

Diverse belangrijke technologieën vormen de motor achter moderne multimodale AI-zoeksystemen en stellen ze in staat verschillende datatypes effectief te verwerken en integreren:

Deze technologieën werken samen om systemen te creëren die complexe relaties tussen verschillende informatievormen kunnen begrijpen.

Multimodale AI-zoekopdracht heeft transformerende toepassingen in tal van sectoren en domeinen. In de gezondheidszorg analyseren systemen medische beelden naast patiëntendossiers en klinische notities om de diagnostische nauwkeurigheid en behandelaanbevelingen te verbeteren. E-commerce-platformen gebruiken multimodale zoekopdracht om klanten producten te laten vinden door tekstbeschrijvingen te combineren met visuele referenties of zelfs schetsen. Zelfrijdende voertuigen vertrouwen op multimodale fusie van camerabeelden, radargegevens en sensorinput om veilig te navigeren en realtime beslissingen te nemen. Contentmoderatiesystemen combineren beeldherkenning, tekstanalyse en audioprocessing om schadelijke content effectiever te identificeren dan benaderingen met één modaliteit. Daarnaast vergroot multimodale zoekopdracht de toegankelijkheid doordat gebruikers met hun voorkeursinvoermethode—spraak, beeld of tekst—kunnen zoeken, terwijl het systeem de intentie in alle formaten begrijpt.

Multimodale AI-zoekopdracht levert aanzienlijke voordelen op die de toegenomen complexiteit en rekeneisen rechtvaardigen. Verbeterde nauwkeurigheid ontstaat door aanvullende informatiebronnen te benutten, waardoor fouten die systemen met één modaliteit maken, worden verminderd. Verbeterd contextueel begrip ontstaat wanneer visuele, tekstuele en auditieve informatie wordt gecombineerd tot rijkere semantische betekenis. Superieure gebruikerservaring wordt bereikt door intuïtievere zoekinterfaces die diverse invoertypes accepteren en relevantere resultaten leveren. Cross-domein leren wordt mogelijk doordat kennis uit de ene modaliteit het begrip van een andere kan verrijken, waardoor transfer learning over verschillende datatypes mogelijk wordt. Grotere robuustheid betekent dat het systeem blijft presteren, zelfs wanneer één modaliteit is verslechterd of ontbreekt, omdat andere modaliteiten het gemis kunnen compenseren.

Ondanks de voordelen kent multimodale AI-zoekopdracht aanzienlijke technische en praktische uitdagingen. Gegevensuitlijning en synchronisatie blijft lastig, omdat verschillende modaliteiten vaak verschillende temporele kenmerken en kwaliteitsniveaus hebben die zorgvuldig beheerd moeten worden. Computationele complexiteit neemt aanzienlijk toe bij het gelijktijdig verwerken van meerdere datastromen, wat veel rekenkracht en gespecialiseerde hardware vereist. Bias- en eerlijkheidskwesties ontstaan wanneer trainingsdata onevenwichtig is over modaliteiten of als bepaalde groepen ondervertegenwoordigd zijn in specifieke datatypes. Privacy en beveiliging worden ingewikkelder door meerdere datastromen, wat het risico op datalekken vergroot en zorgvuldige omgang met gevoelige informatie vereist. Enorme data-eisen betekenen dat het trainen van effectieve multimodale systemen aanzienlijk grotere en meer diverse datasets vereist dan unimodale alternatieven, wat duur en tijdrovend kan zijn om te verzamelen en te annoteren.

Multimodale AI-zoekopdracht raakt nauw aan AI-monitoring en citaattracking, vooral nu AI-systemen steeds vaker antwoorden genereren die informatie uit meerdere bronnen citeren of synthetiseren. Platformen zoals AmICited.com richten zich op het monitoren van hoe AI-systemen informatie citeren en toeschrijven aan originele bronnen, waarmee transparantie en verantwoordelijkheid in AI-gegenereerde antwoorden worden gegarandeerd. Evenzo volgt FlowHunt.io AI-contentgeneratie en helpt organisaties te begrijpen hoe hun merkcontent wordt verwerkt en vermeld door multimodale AI-systemen. Naarmate multimodale AI-zoekopdracht gangbaarder wordt, wordt het voor bedrijven steeds belangrijker om te volgen hoe deze systemen merken, producten en originele bronnen citeren in AI-gegenereerde resultaten. Deze monitoringfunctie helpt organisaties te verifiëren dat hun content correct wordt weergegeven en juist wordt toegeschreven wanneer multimodale AI-systemen informatie over tekst, beelden en andere modaliteiten synthetiseren.

De toekomst van multimodale AI-zoekopdracht wijst op een steeds uniformere en naadlozere integratie van diverse datatypes, waarbij verder wordt gegaan dan huidige fusie-aanpakken richting meer holistische modellen die alle modaliteiten als inherent verbonden verwerken. Realtime verwerkingsmogelijkheden zullen uitbreiden, zodat multimodale zoekopdracht kan werken op live videostreams, continue audio en dynamische tekst tegelijkertijd zonder vertraging. Geavanceerde data-augmentatietechnieken zullen het huidige datagebrek aanpakken door synthetisch multimodale trainingsvoorbeelden te genereren die semantische consistentie over modaliteiten behouden. Opkomende ontwikkelingen omvatten foundation-modellen getraind op grote multimodale datasets die efficiënt kunnen worden aangepast aan specifieke taken, neuromorfe computerbenaderingen die biologische multimodale verwerking beter nabootsen, en federatief multimodaal leren dat training over verspreide databronnen mogelijk maakt onder behoud van privacy. Deze vooruitgang zal multimodale AI-zoekopdracht toegankelijker, efficiënter en beter geschikt maken voor steeds complexere praktijksituaties.

Unimodale AI-systemen verwerken slechts één type gegevensinvoer, zoals zoekmachines die alleen tekst gebruiken. Multimodale AI-systemen daarentegen verwerken en integreren meerdere datatypes—tekst, afbeeldingen, audio en video—gelijktijdig, waardoor een dieper begrip en nauwkeurigere resultaten mogelijk zijn door de aanvullende sterke punten van verschillende dataformaten te benutten.

Multimodale AI-zoekopdracht verbetert de nauwkeurigheid door aanvullende informatiebronnen te combineren die nuances en relaties vastleggen die onzichtbaar zijn voor benaderingen met één modaliteit. Wanneer visuele, tekstuele en auditieve informatie worden gecombineerd, bereikt het systeem een rijker semantisch begrip en kan het beter onderbouwde beslissingen nemen op basis van meerdere perspectieven van dezelfde informatie.

Belangrijke uitdagingen zijn gegevensafstemming en synchronisatie over verschillende modaliteiten, aanzienlijke computationele complexiteit, bias- en eerlijkheidsproblemen wanneer trainingsdata niet in balans is, privacy- en beveiligingsproblemen bij meerdere datastromen, en enorme data-eisen voor effectieve training. Elke modaliteit heeft verschillende temporele kenmerken en kwaliteitsniveaus die zorgvuldig beheerd moeten worden.

De gezondheidszorg profiteert van het analyseren van medische beelden samen met patiëntendossiers en klinische notities. E-commerce gebruikt multimodale zoekopdrachten voor visuele productontdekking. Zelfrijdende voertuigen vertrouwen op multimodale fusie van camera's, radar en sensoren. Contentmoderatie combineert beeld-, tekst- en audio-analyse. Klantenservicesystemen gebruiken meerdere invoertypes voor betere ondersteuning, en toegankelijkheidstoepassingen stellen gebruikers in staat te zoeken met hun voorkeursinvoermethode.

Embeddingmodellen zetten verschillende modaliteiten om in numerieke representaties die semantische betekenis vastleggen. Vectordatabases slaan deze embeddings op in een gedeelde wiskundige ruimte waar relaties tussen verschillende datatypes gemeten en vergeleken kunnen worden. Hierdoor kan het systeem verbindingen vinden tussen tekst, afbeeldingen, audio en video door hun posities in deze gemeenschappelijke semantische ruimte te vergelijken.

Multimodale AI-systemen verwerken meerdere gevoelige datatypes—opgenomen gesprekken, gezichtsherkenningsgegevens, schriftelijke communicatie en medische beelden—wat de privacyrisico's vergroot. De combinatie van verschillende modaliteiten creëert meer mogelijkheden voor datalekken en vereist strikte naleving van regelgeving zoals de AVG en de CCPA. Organisaties moeten robuuste beveiligingsmaatregelen implementeren om gebruikersidentiteit en gevoelige informatie over alle modaliteiten te beschermen.

Platformen zoals AmICited.com monitoren hoe AI-systemen informatie citeren en toeschrijven aan originele bronnen, waardoor transparantie in AI-gegenereerde antwoorden wordt gegarandeerd. Organisaties kunnen hun zichtbaarheid in multimodale AI-zoekresultaten volgen, nagaan of hun content juist wordt weergegeven en correcte toeschrijving bevestigen wanneer AI-systemen informatie over tekst, afbeeldingen en andere modaliteiten synthetiseren.

De toekomst omvat uniforme modellen die alle modaliteiten als inherent verbonden verwerken, realtime verwerking van live video- en audiostreams, geavanceerde data-augmentatietechnieken om een tekort aan data aan te pakken, foundation-modellen getraind op grote multimodale datasets, neuromorfe computerbenaderingen die biologische verwerking nabootsen, en federatief leren dat privacy behoudt tijdens training over gedistribueerde bronnen.

Volg hoe multimodale AI-zoekmachines uw content citeren en toeschrijven over tekst, afbeeldingen en andere modaliteiten met het uitgebreide monitoringplatform van AmICited.

Beheers optimalisatie voor multimodale AI-zoekopdrachten. Leer hoe je afbeeldingen en spraakvragen optimaliseert voor door AI aangedreven zoekresultaten, met st...

Ontdek hoe je tekst, afbeeldingen en video optimaliseert voor multimodale AI-systemen. Leer strategieën om AI-verwijzingen en zichtbaarheid te verbeteren in Cha...

Ontdek wat multi-modale content voor AI is, hoe het werkt, en waarom het belangrijk is. Bekijk voorbeelden van multi-modale AI-systemen en hun toepassingen in v...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.