Hva Påvirker AI-indekseringshastighet? Viktige Faktorer for Raskere AI-oppdagelse

Oppdag de viktigste faktorene som påvirker AI-indekseringshastighet, inkludert nettstedets ytelse, gjennomsøkingsbudsjett, innholdsstruktur og teknisk optimalis...

Lær hvordan sidehastighet påvirker synligheten din i AI-søkemotorer som ChatGPT, Perplexity og Gemini. Oppdag optimaliseringsstrategier og metrikker som er viktige for AI answer engine optimization.

Ja, sidehastighet påvirker AI-synlighet i søk betydelig. AI-drevne søkemotorer som ChatGPT, Perplexity og Gemini prioriterer innhold som laster raskt fordi de trenger umiddelbar tilgang til informasjon for å kunne generere svar i sanntid. Sider som laster tregt bruker opp crawl-budsjettet ineffektivt og blir ofte nedprioritert eller helt hoppet over, noe som gjør hastighet til en kritisk rangeringsfaktor for synlighet i AI-søk.

Sidehastighet har blitt en avgjørende faktor for AI-synlighet i søk, og endrer grunnleggende hvordan innhold blir oppdaget og vist i AI-drevne svarmotorer. I motsetning til tradisjonelle søkemotorer som rangerer sider i en liste, genererer AI-søkeverktøy som ChatGPT, Perplexity og Googles Gemini svar ved å syntetisere innhold fra flere kilder i sanntid. Denne prosessen krever umiddelbar tilgang til informasjon, noe som gjør hastighet til et krav for å bli inkludert, ikke bare en preferanse. Når siden din laster tregt, kan ikke AI-crawlere vente – de går bare videre til raskere konkurrenter, selv om innholdet ditt teknisk sett er bedre.

Forholdet mellom sidehastighet og AI-synlighet i søk fungerer på tre ulike nivåer. For det første trenger AI-motorer øyeblikkelig tilgang for å kunne analysere og trekke ut innhold til svar. For det andre bestemmer effektiviteten i crawl-budsjettet hvilke sider som blir behandlet og indeksert. For det tredje påvirker hastigheten relevansscoringen når flere kilder inneholder lignende informasjon. Å forstå disse mekanismene hjelper deg å optimalisere effektivt for et AI-fokusert søkelandskap.

AI-drevne svarmotorer opererer under helt andre forutsetninger enn tradisjonelle søkemotorer. Mens Google indekserer sider for senere gjenhenting, skanner og syntetiserer AI-verktøy innhold i sanntid, og henter ofte kun de utdragene de forventer å trenge. Denne sanntidsprosessen gjør at sider som laster tregt skaper en flaskehals i svargenereringen. Hvis nettstedet ditt ikke leverer innhold innen millisekunder, går AI-crawleren videre til neste kilde uten å nøle.

Tildeling av crawl-budsjett fungerer annerledes for AI-motorer sammenlignet med tradisjonelt søk. Google og Bing har et crawl-budsjett – en grense for hvor mye tid og båndbredde de vil bruke på å få tilgang til innholdet ditt. Tregt lastende sider bruker opp dette budsjettet raskere, noe som kan føre til at deler av nettstedet ditt blir hoppet over. For AI-søk betyr dette sløsing av budsjett at dine beste svar, FAQ-er og strukturerte innhold kanskje aldri blir behandlet. Et SaaS-selskap med solide SEO-grunnleggende, men med 5,8 sekunders lastetid, opplevde at innholdet deres konsekvent ble oversett av AI-svarmotorer, mens en konkurrent med litt mindre polert innhold, men 1,6 sekunders lastetid, jevnlig dukket opp i AI-genererte svar.

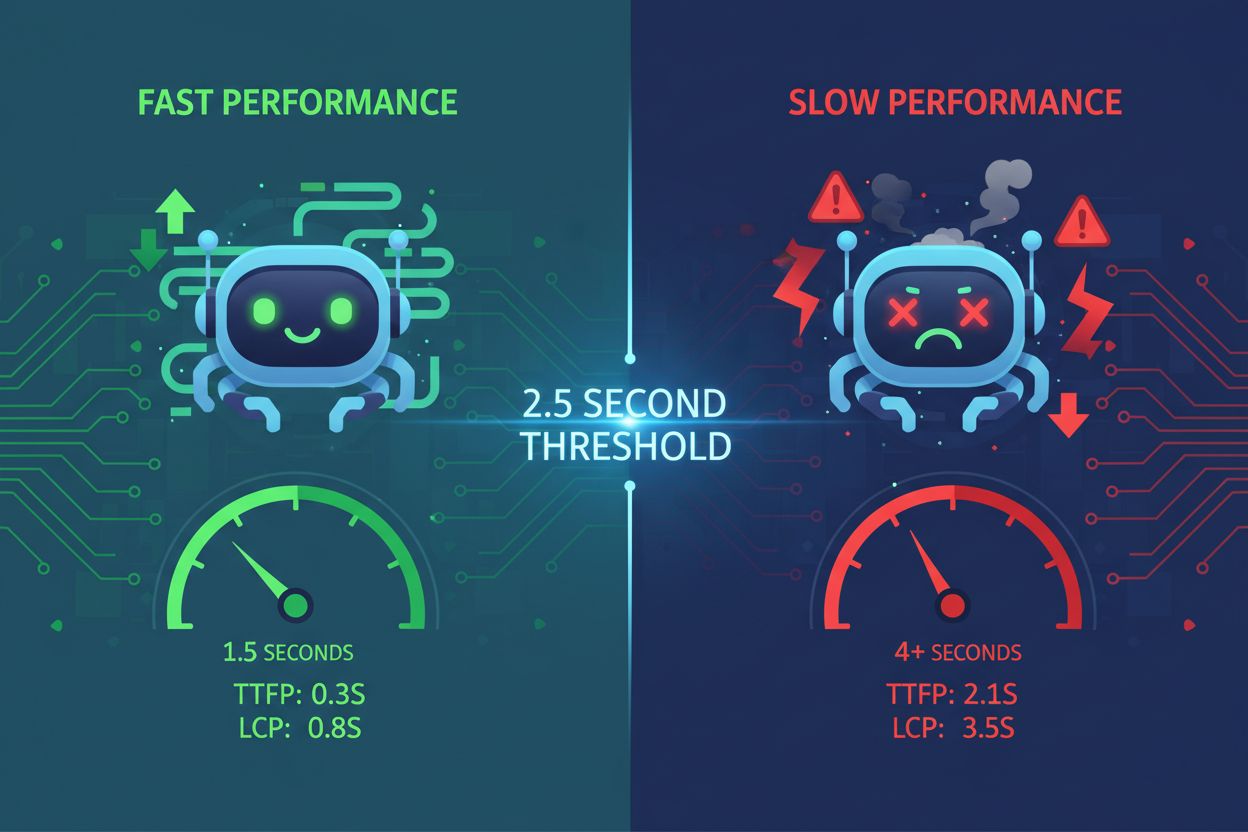

Fordelen av syntesehastighet skaper en utslagsgivende effekt i AI-søkeresultater. Når to sider inneholder like relevant informasjon med tilsvarende autoritetssignaler, vinner ofte kilden som laster raskest. Det betyr at sidehastighet har utviklet seg fra å være et brukeropplevelsesmål til å bli en direkte rangeringsfaktor for AI-synlighet. Forskjellen mellom 1,2 sekunder og 3 sekunders lastetid kan avgjøre om innholdet ditt blir sitert i AI-svar eller fullstendig ignorert.

| Metrikk | Mål | Hvorfor det er viktig for AI-søk |

|---|---|---|

| First Contentful Paint (FCP) | Under 1,8 sekunder | Marker når første visuelle element vises; signaliserer til AI-crawlere at innhold lastes |

| Time to First Byte (TTFB) | Under 500ms | Måler serverens svartid; avgjørende for crawlbarhet og indekseringsdybde |

| Largest Contentful Paint (LCP) | Under 2,5 sekunder | Sporer når hovedinnholdet er ferdig lastet; essensielt for AI-skanning og utvinning |

| Total Page Size | Under 2MB | Oppblåste sider gjør alt tregere og sløser crawl-budsjett |

| Cumulative Layout Shift (CLS) | Under 0,1 | Sikrer stabilt innhold for nøyaktig utvinning av AI-parsere |

First Contentful Paint (FCP) representerer øyeblikket når det første visuelle elementet vises på skjermen, og det er også når mange AI-crawlere begynner å vurdere om innholdet er verdt å behandle. Hvis FCP-en din overstiger 1,8 sekunder, kan AI-motorer nedprioritere siden din før hovedinnholdet i det hele tatt er lastet. Time to First Byte (TTFB) måler forsinkelsen mellom serveren mottar en forespørsel og sender tilbake den første byten med data – en metrikk som direkte påvirker både crawlbarhet og hvor raskt AI-systemer kan begynne å analysere innholdet ditt.

Largest Contentful Paint (LCP) måler hvor raskt hovedblokken av innhold er ferdig lastet, noe som er avgjørende for både brukeropplevelse og AI-skanning. Når LCP-en overstiger 2,5 sekunder, kan AI-crawlere gå ut på tid eller velge raskere alternativer. Total sidestørrelse påvirker alle andre metrikker; sider som overstiger 2MB laster vesentlig tregere og sløser med crawl-budsjettet. Tunge bilder, ubrukte JavaScript-filer og tredjeparts plugins er vanlige årsaker til oppblåste sider og redusert AI-synlighet.

For det første trenger AI umiddelbar tilgang til innholdet ditt. Generative AI-motorer crawler annerledes enn tradisjonelle roboter fordi de skanner og syntetiserer innhold i sanntid. De har ikke luksusen av å vente på at JavaScript skal rendres eller bilder skal lastes. Hvis nettstedet ditt er avhengig av JavaScript-first-arkitektur eller “lazy-loader” kritisk innhold, kan AI-crawlere gå glipp av dine beste svar fullstendig. En raskt lastende, HTML-first tilnærming sikrer at AI-systemer umiddelbart kan få tilgang til og trekke ut innholdet ditt for svargenerering.

For det andre er crawl-budsjettet begrenset og AI-motorer respekterer det. Hvert sekund siden din bruker på å laste, forbruker mer av det tildelte crawl-budsjettet. Når du sløser budsjettet på trege sider, hopper søkemotorene over det verdifulle innholdet som burde vært indeksert. For AI-søk betyr dette at FAQ-sidene, ordlister og strukturert Q&A-innhold – det eksakt innholdet AI-motorene ønsker å trekke ut – kanskje aldri blir behandlet. Å redusere ikke-indekserte sider og optimalisere nettstedskartet til kun å inkludere kanoniske URL-er forbedrer crawl-effektiviteten og sikrer at AI-motorene fokuserer på ditt beste innhold.

For det tredje påvirker hastigheten relevansscoringen i AI-svar. Når flere kilder inneholder lignende informasjon, tar AI-algoritmer hensyn til hvor raskt innholdet kan hentes frem og behandles. To konkurrerende sider med lik autoritet og struktur kan oppleve svært ulike utfall basert kun på millisekunder i lastetid. Dette skaper en hastighetsbasert utslagsgivende effekt der raskere sider vinner synlighet, selv om innholdskvaliteten er sammenlignbar.

Et barnehageselskap med 2 000 indekserte sider og omtrent 45 000 ikke-indekserte sider opplevde betydelig crawl-sløsing. Nettstedskartet deres inkluderte feilaktig 4 000 dupliserte og omdirigerte URL-er, noe som tvang søkemotorer til å sløse ressurser på sider som ikke burde vært indeksert. Etter å ha optimalisert nettstedskartet til kun å inkludere kanoniske URL-er og redusert duplikatene fra 4 000 til under 200, opplevde selskapet at AI-synligheten i søk økte med opptil 10 % på plattformer som Perplexity, Google AI Mode og Gemini. Denne oppryddingen forbedret crawl-effektiviteten, slik at AI-systemene kunne fokusere på høykvalitets innhold tilpasset brukerintensjonen.

Et SaaS-markedsføringsautomatiseringsselskap sto overfor en annen utfordring: godt innhold, men dårlig AI-synlighet. Nettstedet deres lastet på 5,8 sekunder på grunn av tunge forsider, oppblåste skript og utilstrekkelig caching. En direkte konkurrent med litt mindre polert innhold, men 1,6 sekunders lastetid, dukket konsekvent opp i AI-genererte svar. Etter å ha fjernet ytelsesflaskehalser – redusert lastetiden til 1,2 sekunder, utsatt ikke-kritiske skript og prioritert strukturert data – kom selskapets innhold med i AI-drevne svar for 12 konkurrerende søk der de tidligere ikke hadde vært synlige. Innen to uker etter optimaliseringen økte synligheten dramatisk.

Disse eksemplene viser at hastighet ikke bare er en rangeringsfaktor – det er en inngangsbillett til AI-søkeresultater. Uten tilstrekkelig hastighet forblir selv utmerket innhold usynlig for AI-svarmotorer.

Implementer server-side caching og forhåndsrendring for å levere innhold umiddelbart til AI-crawlere. AI-verktøy misliker JavaScript-first-opplevelser fordi de krever ekstra behandlingstid. Lever heller HTML og statiske ressurser som er klare til å skannes med en gang. Verktøy som Cloudflare med optimaliserte caching-regler, Vercel for server-side rendering og NitroPack for akselerasjon av WordPress, senker alle lastetider samtidig som innholdet vises raskere for crawlere. Hver tilnærming prioriterer å levere hovedinnholdet ditt først.

Prioriter den kritiske renderingsbanen ved å laste det viktigste først. Du trenger ikke laste alt umiddelbart – bare det som AI og brukere bør se først. Hovedseksjonen med spørsmål og svar bør vises før popups, lysbildefremvisninger eller andre mindre viktige elementer. Inkluder bare den CSS-en som trengs for første skjermbilde, “lazy-load” media under folden, og utsett sporingsskript og ikke-kritisk tredjepartskode til etter at siden har lastet. Denne tilnærmingen sikrer at AI-crawlere får umiddelbar tilgang til hovedinnholdet uten å måtte vente på sekundære elementer.

Bruk et hastighetsoptimalisert CMS og hosting som fundament. Hvis du bruker WordPress, velg høytytende verter som Kinsta eller WP Engine som prioriterer hastighet. Plattformene Shopify og Webflow gir innebygd fart, men du kan styrke dem ytterligere med cache-løsninger. Vurder å flytte ressurskrevende innhold som guider eller ordbøker til et subdomene på en innholdsleveringsplattform, slik at svarmotorer får raskere tilgang til dine mest crawlbare svar. Denne arkitektoniske tilnærmingen sikrer at det viktigste innholdet ditt laster raskest.

Bruk Google PageSpeed Insights for å få et grunnleggende bilde av sideytelsen din og motta konkrete forbedringsforslag. GTmetrix gir detaljerte “waterfall”-diagrammer som viser nøyaktig hvor sidene dine bruker tid under lasting. WebPageTest lar deg simulere reelle forhold og teste ytelse på ulike tilkoblingshastigheter og enheter. Lighthouse tilbyr omfattende revisjoner innebygd i Chrome DevTools, slik at det er enkelt å kjøre månedlige vurderinger.

Kjør månedlige revisjoner med disse verktøyene for å følge fremgang og oppdage nye flaskehalser. Fokuser på metrikker som er viktigst for AI-søk: FCP, TTFB, LCP og total sidestørrelse. Lag en prioritert liste over tiltak basert på effekt – å fikse TTFB gir ofte raskest forbedring, mens bildeoptimalisering vanligvis gir størst filstørrelsesreduksjon. Følg med på disse tallene over tid for å sikre at optimaliseringene fungerer og for å fange opp ytelsestap før de påvirker AI-synligheten.

Svarmotorer bryr seg ikke om hvordan siden din ser ut på desktop – de vurderer mobilytelsen først. AI-crawlere prioriterer mobil-først indeksering, noe som betyr at mobilopplevelsen din direkte påvirker AI-synligheten. Test hvordan nettstedet ditt fungerer under faktiske mobilforhold: unngå for store fonter eller knapper som ikke skalerer, fjern popups eller bannere som blokkerer innhold, og simuler 3G-hastigheter for å se om svar fortsatt laster raskt. Bloggen din kan lastes pent på en lokal test, men hvis den hakker på mobil, vil AI nedgradere eller ignorere den.

Optimaliser for den tregeste opplevelsen, ikke den raskeste. Hvis nettstedet ditt fungerer bra på desktop, men sliter på mobil, vil AI-motorer se mobilversjonen og nedprioritere innholdet ditt deretter. Dette betyr å teste på ekte enheter med ekte nettverksforhold, ikke bare desktop-nettlesere. Mobiloptimalisering er ikke valgfritt for AI-synlighet – det er helt nødvendig.

Rask lasting alene er ikke nok – du trenger rask lasting kombinert med tydelig struktur. Strukturert data (schema markup) forteller AI hvordan innholdet skal tolkes, men det hjelper bare hvis siden din laster raskt nok til at crawleren rekker å hente det. FAQ-schema, HowTo-schema, Article-schema og Breadcrumb-schema øker sjansen for å bli valgt av svarmotorer, men kun når de kombineres med raske lastetider. En rask side med dårlig struktur blir indeksert, men blir kanskje ikke valgt som svar. En treg side med perfekt struktur kan bli utelatt fra indekseringen helt.

Den optimale tilnærmingen kombinerer hastighet med semantisk klarhet. Bruk schema markup som tydelig definerer hva siden din inneholder, sørg for at siden din laster på under 2,5 sekunder, og strukturer innholdet med tydelige overskrifter og sammendrag. Denne kombinasjonen gjør innholdet ditt både oppdagbart og utvinnbart for AI-systemer, og maksimerer synligheten i AI-genererte svar.

Følg med på hvordan innholdet ditt vises i ChatGPT, Perplexity, Gemini og andre AI answer engines. Få sanntidsinnsikt i din AI-søkeytelse og optimaliser synligheten din.

Oppdag de viktigste faktorene som påvirker AI-indekseringshastighet, inkludert nettstedets ytelse, gjennomsøkingsbudsjett, innholdsstruktur og teknisk optimalis...

Oppdag hvordan nettstedshastighet direkte påvirker AI-synlighet og siteringer i ChatGPT, Gemini og Perplexity. Lær om 2,5-sekunders terskelen og optimaliserings...

Lær velprøvde strategier for å opprettholde og forbedre synligheten til innholdet ditt i AI-genererte svar på tvers av ChatGPT, Perplexity og Google AI Overview...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.