Indekseringsdekning

Indekseringsdekning måler hvilke nettsidesider som er indeksert av søkemotorer. Lær hva det betyr, hvorfor det er viktig for SEO, og hvordan du overvåker og løs...

Prosentandelen av nettstedets innhold som er vellykket indeksert og tilgjengelig for AI-systemer som ChatGPT, Google AI Overviews og Perplexity. Sterk AI-indeksdekning sikrer at innholdet ditt er synlig i AI-genererte svar og kan siteres som kilde. I motsetning til tradisjonell søkeindeksering avgjør AI-indeksdekning synlighet på tvers av flere AI-plattformer og LLM-drevne systemer.

Prosentandelen av nettstedets innhold som er vellykket indeksert og tilgjengelig for AI-systemer som ChatGPT, Google AI Overviews og Perplexity. Sterk AI-indeksdekning sikrer at innholdet ditt er synlig i AI-genererte svar og kan siteres som kilde. I motsetning til tradisjonell søkeindeksering avgjør AI-indeksdekning synlighet på tvers av flere AI-plattformer og LLM-drevne systemer.

AI-indeksdekning refererer til prosentandelen av nettstedets innhold som oppdages, crawles og indekseres av kunstige intelligenssystemer som ChatGPT, Google AI Overviews, Perplexity og andre store språkmodeller (LLMs). I motsetning til tradisjonell søkemotorindeksering, som fokuserer på å gjøre innhold synlig i søkeresultater, avgjør AI-indeksdekning om innholdet ditt er tilgjengelig for AI-systemer til trening, sitering og inkludering i AI-genererte svar. Når innholdet ditt har sterk AI-indeksdekning, blir det synlig på tvers av flere AI-plattformer, og sannsynligheten øker for at merkevaren, produktene eller informasjonen din blir nevnt når brukere søker i disse systemene. Dårlig AI-indeksdekning betyr at verdifullt innhold forblir usynlig for AI-systemer, og du går glipp av viktige muligheter for merkevaresynlighet i det raskt voksende AI-drevne søkelandskapet.

AI-indeksdekning har direkte innvirkning på merkevarens synlighet i et stadig mer AI-drevet digitalt økosystem. Med AI-drevne resultater som nå vises i over 91 % av produktsøk og AI-plattformer som ChatGPT som håndterer over 1 milliard søk ukentlig, er det avgjørende for moderne digital strategi å sikre at innholdet ditt indekseres av disse systemene. Forretningsmessig er konsekvensene store: innhold med sterk AI-indeksdekning kan bli sitert i AI-svar, drive kvalifisert trafikk og øke merkevarebevisstheten, mens innhold som blokkeres eller indekseres dårlig forblir fullstendig usynlig i disse kraftige oppdagelseskanalene. I tillegg siterer AI-systemer ofte kilder som ikke rangerer i tradisjonelle søkeresultater – faktisk vises bare rundt 20 % av sidene som siteres i AI-svar i Googles topp 10 organiske resultater, noe som betyr at AI-indeksering skaper helt nye synlighetsmuligheter.

| Scenario | Innvirkning på AI-synlighet | Forretningsutfall |

|---|---|---|

| Riktig indeksert, innhold av høy kvalitet | Ofte sitert i AI-svar | Økt merkevareomtale, kvalifisert trafikk, autoritetsbygging |

| Indeksert, men sjelden sitert | Få omtaler i AI-resultater | Begrenset synlighet til tross for teknisk tilgjengelighet |

| Blokkert eller ikke indeksert | Null synlighet i AI-systemer | Tapte muligheter, konkurrenter får større andel |

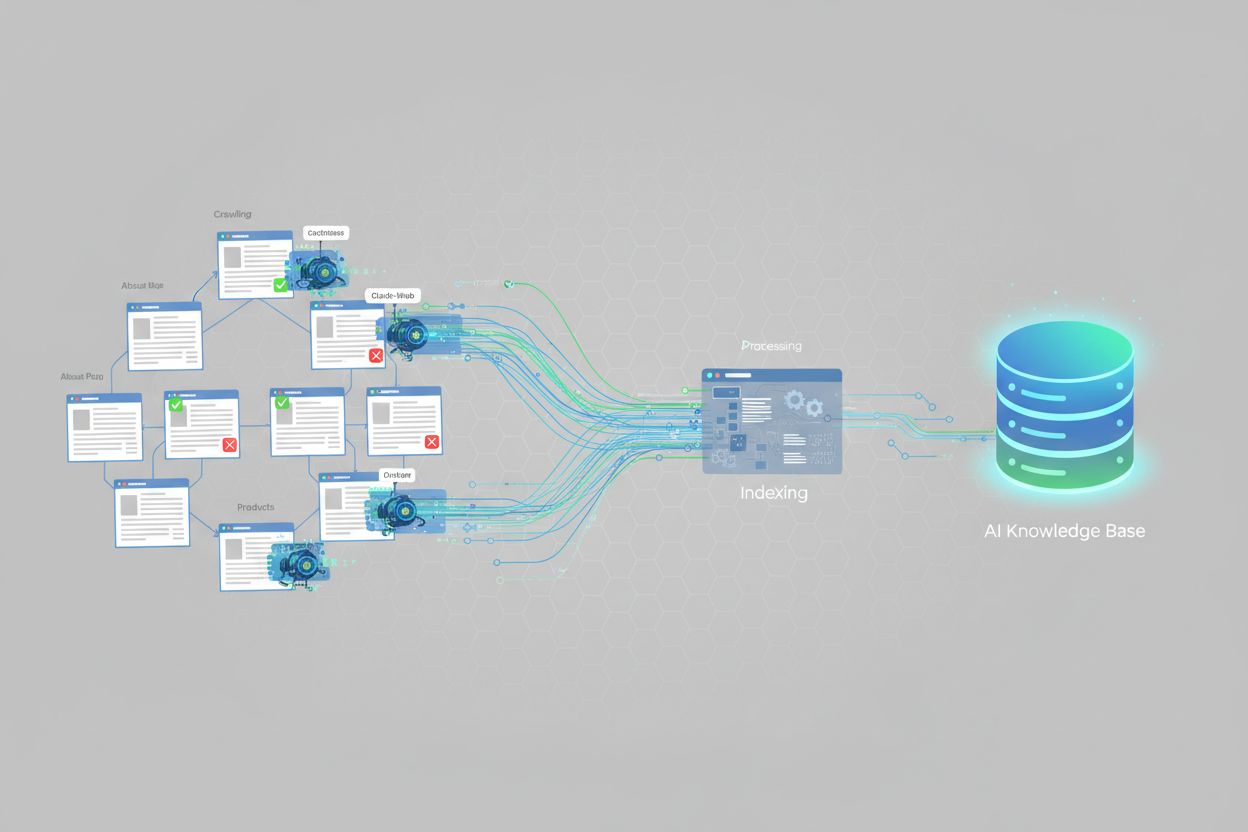

AI-systemer indekserer innhold gjennom spesialiserte crawlere designet for å forstå og prosessere informasjon til store språkmodeller. ChatGPT bruker crawlere som GPTBot for å skanne nettet kontinuerlig og samle inn treningsdata, men benytter også sanntidssøk for oppdatert informasjon. Google AI Overviews bruker Googles eksisterende crawl-infrastruktur, men utfører ekstra behandling for å forstå innholdsstruktur, relevans og autoritet for AI-genererte sammendrag. Perplexity AI har en annen tilnærming og vektlegger sanntidssøk, med over 20 kilder per søk, og har en tydelig preferanse for plattformer som Reddit og brukerdrevet innhold. Hver AI-plattform har ulike preferanser: noen prioriterer strukturert data og skjemaoppmerking, andre foretrekker omfattende, godt skrevet innhold, mens noen vektlegger tredjepartsomtaler og anmeldelser. Å forstå disse forskjellene er avgjørende, fordi optimalisering for ett AI-system ikke automatisk gir optimalisering for alle – din innholdsstrategi må ta hensyn til indekseringsatferden til de plattformene som er mest relevante for ditt publikum.

Flere tekniske faktorer avgjør om AI-systemer kan indeksere innholdet ditt. De viktigste er:

<meta name="robots" content="noindex"> er eksplisitt utelukket fra AI-indeksering. Disse taggene blir noen ganger ved en feil liggende igjen på produksjonssider etter utvikling.Å ta tak i disse tekniske faktorene er grunnleggende for å forbedre AI-indeksdekningen. Verktøy som AmICited.com kan hjelpe deg å overvåke hvor effektivt innholdet ditt indekseres på tvers av ulike AI-plattformer, og gi innsikt i hvilke tekniske problemer som kan begrense dekningen din.

Å spore AI-indeksdekningen din krever en kombinasjon av tradisjonelle SEO-verktøy og AI-spesifikke overvåkingsløsninger. Google Search Console gir rapporter om indeksdekning som viser hvilke sider som er indeksert av Google, selv om dette gjenspeiler tradisjonell søkeindeksering, ikke AI-systemindeksering. Bing Webmaster Tools tilbyr lignende funksjonalitet for Bings indeks. For AI-spesifikk overvåking spesialiserer AmICited.com seg på å spore hvordan merkevaren din vises på tvers av ChatGPT, Google AI Overviews, Perplexity og andre AI-systemer, inkludert siteringsfrekvens, sentiment og andel stemme. Tredjeparts SEO-plattformer som Semrush, Ahrefs og Moz inkluderer i økende grad AI-synlighetsmålinger sammen med tradisjonelle SEO-data. Nøkkelindikatorer å følge med på er: andel av nettstedets sider som vises i AI-svar, hvor ofte merkevaren din siteres sammenlignet med konkurrenter, sentimentet i AI-omtaler, og hvilke innholdstyper som genererer flest AI-siteringer. Regelmessig overvåking hjelper deg å identifisere tekniske problemer, innholdshull og muligheter til å forbedre AI-indeksdekningen over tid.

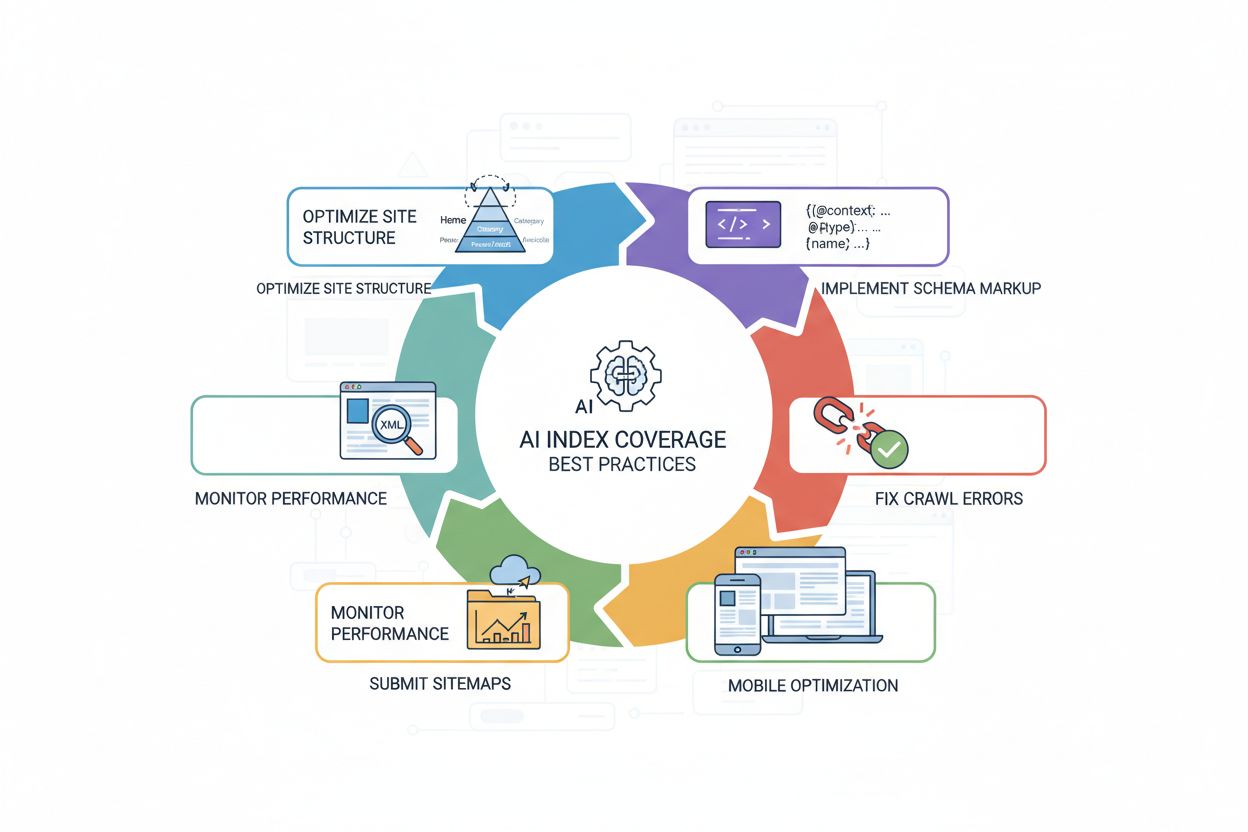

For å forbedre AI-indeksdekningen må du kombinere teknisk optimalisering med kvalitetsinnhold. De mest effektive tiltakene er:

<article>, <section>, <header>, <nav>) for å tydeliggjøre innholdsstruktur og mening for AI-systemer.Disse tiltakene gir til sammen et AI-vennlig nettsted som er enkelt for crawlere å få tilgang til, forstå og sitere. Resultatet er sterkere AI-indeksdekning og økt synlighet på AI-drevne plattformer.

Selv om AI-indeksdekning og tradisjonell søkeindeksdekning henger sammen, er de ikke identiske. Tradisjonell søkeindeksering fokuserer på å gjøre innhold synlig i søkeresultatsider (SERPs), med rangering bestemt av faktorer som lenker, nøkkelordrelevans og brukerengasjement. AI-indeksdekning, derimot, avgjør om innholdet er tilgjengelig for AI-systemer til trening og sanntidssitering, med helt andre rangeringsfaktorer. AI-systemer siterer ofte kilder som ikke rangerer høyt i tradisjonelt søk – 20 % overlapp mellom AI-siterte sider og topp 10 organiske resultater viser denne grunnleggende forskjellen. I tillegg kan AI-systemer prioritere andre innholdstyper: mens tradisjonelt søk favoriserer autoritet på domenenivå, vektlegger AI-systemer ofte spesifikke formater (FAQs, lister, sammenligninger, anmeldelser) sterkere. En side kan rangere godt i Google, men sjelden siteres av AI-systemer, eller omvendt. Det betyr at optimaliseringsstrategien må dekke begge kanaler: tradisjonell SEO gir synlighet i søk, mens AI-spesifikke tiltak (skjemaoppmerking, innholdsstruktur, tilgjengelighet) forbedrer AI-indeksdekning og siteringssannsynlighet.

Flere vanlige problemer hindrer nettsteder i å oppnå sterk AI-indeksdekning. For restriktive robots.txt-filer er blant de vanligste årsakene – mange nettsteder blokkerer AI-crawlere ved et uhell når de egentlig bare vil blokkere tradisjonelle søkeboter, og hindrer dermed fullstendig AI-indeksering. Feilplasserte noindex-tagger som blir liggende på produksjonssider etter utvikling eller migrering kan gjøre hele seksjoner usynlige for AI-systemer. Dårlig innholdsstruktur gjør det vanskelig for AI-crawlere å forstå og trekke ut informasjon; sider uten tydelige overskrifter, semantisk HTML eller logisk organisering blir sjeldnere indeksert og sitert. Manglende eller ufullstendig skjemaoppmerking fratar AI-systemer eksplisitt kontekst om innholdet ditt, og reduserer effektiviteten av indeksering og sannsynligheten for sitering. JavaScript-tunge nettsteder uten server-side rendering er en stor utfordring fordi mange AI-crawlere ikke kan kjøre JavaScript, og dermed forblir viktig innhold skjult. Duplisert innhold uten korrekt kanonisering forvirrer AI-systemer om hvilken versjon som er autoritativ, og kan redusere dekningen. Til slutt vil treg lasting og dårlig mobiloptimalisering redusere crawler-effektiviteten og hvor mye av nettstedet som blir indeksert. Å jobbe systematisk med disse utfordringene – fra robots.txt-verifisering, skjemaoppmerking og forbedret struktur til raske, mobilvennlige sider – kan dramatisk forbedre AI-indeksdekning og synlighet på tvers av AI-plattformer.

Det finnes foreløpig ingen standardisert måling for AI-indeksdekning på tvers av alle nettsteder, men forskning viser at AI-drevne resultater dukker opp i over 91 % av produktsøk. Mange nettsteder har imidlertid dårlig AI-indeksdekning på grunn av tekniske problemer som robots.txt-blokkeringer, manglende skjemaoppmerking eller problemer med JavaScript-rendering. Nettsteder med sterk teknisk SEO og strukturert data oppnår vanligvis bedre AI-indeksdekning.

Tradisjonell Google-indeksdekning fokuserer på å gjøre innhold synlig i søkeresultater, mens AI-indeksdekning avgjør om innholdet er tilgjengelig for AI-systemer for trening og sitering. AI-systemer siterer ofte kilder som ikke rangerer blant Googles topp 10-resultater – bare rundt 20 % av AI-siterte sider vises i tradisjonelle topp 10 organiske resultater. Ulike AI-plattformer har også ulike preferanser for indeksering og vekter kilder forskjellig.

Ja, du kan blokkere spesifikke AI-crawlere ved å bruke robots.txt-filen din. For eksempel kan du nekte tilgang for GPTBot (OpenAI), CCBot (Common Crawl) eller Claude-Web (Anthropic). Å blokkere AI-crawlere betyr imidlertid at innholdet ditt ikke blir indeksert av disse systemene og ikke vises i AI-genererte svar. De fleste virksomheter har fordel av å tillate AI-crawlere for å øke synligheten på tvers av AI-plattformer.

Tidslinjer for indeksering varierer mellom AI-plattformer. ChatGPTs GPTBot crawler kontinuerlig, men kan bruke dager eller uker på å oppdage nytt innhold. Google AI Overviews bruker Googles eksisterende crawl-infrastruktur, så indeksering kan skje innen timer til dager. Perplexity legger vekt på sanntidssøk på nettet, så nytt innhold kan vises raskt i svar. Bruk av XML-sitemaps og forespørsler om indeksering gjennom webmaster-verktøy kan fremskynde prosessen.

AI-indeksdekning og tradisjonelle søkerangeringer er beslektet, men forskjellige. Optimalisering for AI-indeksdekning (via skjemaoppmerking, nettstedstruktur og tilgjengelighet) forbedrer også tradisjonell SEO. Imidlertid kan en side rangere godt i Google, men sjelden bli sitert av AI-systemer, eller omvendt. Den beste strategien er å optimalisere for begge: tradisjonell SEO gir synlighet i søk, mens AI-spesifikke tiltak forbedrer AI-indeksdekning.

De vanligste årsakene er: 1) For restriktive robots.txt-filer som ved et uhell blokkerer AI-crawlere, 2) Manglende eller ufullstendig skjemaoppmerking som hindrer AI-systemer i å forstå innholdet, 3) JavaScript-tunge nettsteder uten server-side rendering som AI-crawlere ikke kan prosessere, og 4) Dårlig nettstedstruktur som gjør det vanskelig for crawlere å navigere i innholdet. Å løse disse tekniske problemene forbedrer vanligvis AI-indeksdekningen betydelig.

Du kan overvåke AI-indeksdekning med verktøy som AmICited.com, som sporer hvordan merkevaren din vises på tvers av ChatGPT, Google AI Overviews, Perplexity og andre AI-systemer. Se etter måleparametre som siteringsfrekvens, andel stemme sammenlignet med konkurrenter og omtale-sentiment. Du kan også teste manuelt ved å søke etter merkevaren og viktige temaer i AI-systemer og merke deg om innholdet ditt vises i svarene.

Selv om det ikke er strengt påkrevd, forbedrer skjemaoppmerking AI-indeksdekningen betydelig. Strukturert data (JSON-LD) hjelper AI-systemer å forstå innholdet, trekke ut informasjon nøyaktig og vurdere relevans. Sider med riktig skjemaoppmerking for produkter, artikler, FAQs og organisasjoner er mer sannsynlig å bli indeksert og sitert av AI-systemer. Det regnes som beste praksis for å optimalisere AI-indeksdekning.

Følg med på hvordan AI-systemer oppdager og siterer merkevaren din på tvers av ChatGPT, Google AI Overviews, Perplexity og mer. Få sanntidsinnsikt i din AI-synlighet, siteringsfrekvens og andel stemme i AI-genererte svar.

Indekseringsdekning måler hvilke nettsidesider som er indeksert av søkemotorer. Lær hva det betyr, hvorfor det er viktig for SEO, og hvordan du overvåker og løs...

Lær hvordan AI-motorer som ChatGPT, Perplexity og Gemini indekserer og prosesserer nettinnhold ved hjelp av avanserte crawlere, NLP og maskinlæring for å trene ...

Lær hvordan AI-søkindekser fungerer, forskjellene mellom ChatGPT, Perplexity og SearchGPTs indekseringsmetoder, og hvordan du kan optimalisere innholdet ditt fo...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.