Hvilke tillitsfaktorer bruker AI-motorer for å evaluere kilder

Oppdag hvordan AI-motorer som ChatGPT, Perplexity og Google AI vurderer kilders tilforlitelighet. Lær om E-E-A-T, domenemyndighet, siteringsfrekvens og andre av...

AI-evaluering av innholds pålitelighet basert på forfatterens kvalifikasjoner, siteringer og verifisering. Vurdering av kilders troverdighet analyserer systematisk flere dimensjoner, inkludert forfatterens ekspertise, utgiverens omdømme, siteringsmønstre og faktasjekk-resultater for å avgjøre om informasjonskilder fortjener å bli inkludert i forskning, kunnskapsdatabaser eller AI-genererte sammendrag. Denne automatiserte prosessen gjør det mulig for plattformer å skalere vurderingen av troverdighet på tvers av millioner av kilder, samtidig som man opprettholder konsistens som mennesker alene ikke kan oppnå.

AI-evaluering av innholds pålitelighet basert på forfatterens kvalifikasjoner, siteringer og verifisering. Vurdering av kilders troverdighet analyserer systematisk flere dimensjoner, inkludert forfatterens ekspertise, utgiverens omdømme, siteringsmønstre og faktasjekk-resultater for å avgjøre om informasjonskilder fortjener å bli inkludert i forskning, kunnskapsdatabaser eller AI-genererte sammendrag. Denne automatiserte prosessen gjør det mulig for plattformer å skalere vurderingen av troverdighet på tvers av millioner av kilder, samtidig som man opprettholder konsistens som mennesker alene ikke kan oppnå.

Vurdering av kilders troverdighet er en systematisk evaluering av informasjonskilder for å avgjøre deres pålitelighet, troverdighet og autoritet i å levere korrekt informasjon. I sammenheng med AI-drevne systemer innebærer troverdighetsvurdering å analysere flere dimensjoner av en kilde for å fastslå om innholdet fortjener å bli inkludert i forskning, siteringer eller kunnskapsbaser. AI-troverdighetsvurdering fungerer ved å undersøke forfatterens kvalifikasjoner—inkludert utdanningsbakgrunn, yrkeserfaring og fagkompetanse—sammen med siteringsmønstre som indikerer hvor ofte og positivt andre autoritative kilder refererer til arbeidet. Prosessen evaluerer verifiseringsmekanismer som fagfellevurdering, institusjonstilknytning og utgiverens omdømme for å etablere grunnleggende troverdighet. Troverdighets-signaler er målbare indikatorer som AI-systemer oppdager og vekter, fra eksplisitte markører som forfatterkvalifikasjoner til implisitte signaler utledet fra tekstanalyse og metadata-mønstre. Moderne AI-systemer anerkjenner at troverdighet er flerdimensjonal; en kilde kan være svært troverdig innen ett område, men mangle autoritet på et annet, noe som krever kontekstbevisst vurdering. Vurderingsprosessen har blitt stadig mer kritisk ettersom informasjonsmengden eksploderer og feilinformasjon sprer seg raskt på digitale plattformer. Automatisert troverdighetsvurdering gjør det mulig for plattformer å skalere vurderingen på tvers av millioner av kilder, samtidig som man opprettholder konsistens som mennesker alene ikke kan oppnå. Å forstå hvordan disse systemene fungerer, hjelper innholdsskapere, forskere og utgivere å optimalisere sine kilder for troverdighetsgjenkjenning, og hjelper forbrukere å ta informerte valg om informasjonens pålitelighet.

AI-systemer vurderer kildetroverdighet gjennom sofistikert multi-signal-analyse som kombinerer naturlig språkprosessering, maskinlæringsmodeller og evaluering av strukturerte data. Deteksjon av troverdighets-signaler identifiserer spesifikke markører i tekst, metadata og nettverksmønstre som korrelerer med pålitelig informasjon; disse signalene vektes ut fra deres prediktive verdi for nøyaktighet. NLP-analyse undersøker språklige mønstre, siteringstetthet, påstandsspesifisitet og språklig sikkerhet for å vurdere om innholdet viser kjennetegn på grundig forskning eller utviser trekk som er vanlige for upålitelige kilder. Maskinlæringsmodeller trent på store datasett med verifiserte troverdige og ikke-troverdige kilder lærer å gjenkjenne komplekse mønstre som mennesker kan overse, og muliggjør sanntidsvurdering i stor skala. Faktasjekk-integrasjon kryssjekker påstander mot verifiserte databaser og etablerte fakta, og markerer motsetninger eller udokumenterte påstander som reduserer troverdighets-score. Disse systemene bruker ensemble-metoder som kombinerer flere vurderingsmetoder, i erkjennelse av at ingen enkelt indikator perfekt forutsier troverdighet. Tabellen nedenfor illustrerer de viktigste signaltypene som AI-systemer analyserer:

| Signaltype | Hva det måler | Eksempler |

|---|---|---|

| Akademiske signaler | Fagfellevurderingsstatus, publiseringskanal, institusjonstilknytning | Tidsskrifts impact factor, konferanserangering, universitetsomdømme |

| Tekstsignaler | Skrivekvalitet, siteringstetthet, påstandsspesifisitet, språkbruk | Riktige siteringer, fagterminologi, evidensbaserte påstander |

| Metadata-signaler | Forfatterkvalifikasjoner, publiseringsdato, oppdateringsfrekvens, kildehistorikk | Forfattergrader, publiseringstidslinje, revisjonshistorikk |

| Sosiale signaler | Siteringstall, delingsmønstre, ekspertanbefalinger, engasjement i fagmiljøet | Google Scholar-siteringer, omtaler i akademiske nettverk, anbefalinger fra kolleger |

| Verifiseringssignaler | Resultater fra faktasjekk, påstandskorrespondanse, kildegjennomsiktighet | Snopes-verifisering, flere uavhengige bekreftelser, metodikk-avsløring |

| Strukturelle signaler | Innholdsorganisering, klar metodikk, åpenhet rundt interessekonflikter | Tydelige seksjoner, transparente metoder, åpenhet om finansiering |

De mest innflytelsesrike troverdighetsfaktorene som AI-systemer vurderer, inkluderer flere sammenhengende dimensjoner som samlet etablerer kildens pålitelighet. Forfatterens omdømme fungerer som en grunnleggende troverdighetsindikator, der etablerte eksperter i sitt felt gir betydelig mer tyngde enn ukjente bidragsytere. Utgiverens omdømme utvider vurderingen til det institusjonelle nivået, der kilder publisert gjennom fagfellevurderte tidsskrifter eller etablerte akademiske forlag har høyere grunnleggende troverdighet. Siteringsmønstre viser hvordan det bredere akademiske miljøet har forholdt seg til kilden; mye siterte arbeider i anerkjente publikasjoner signaliserer faglig kvalitet. Aktualitet har kontekstavhengig betydning—nyere publikasjoner viser oppdatert kunnskap, mens eldre grunnleggende arbeider beholder troverdighet basert på historisk innflytelse og fortsatt relevans. Bias-deteksjon-algoritmer undersøker om kilder oppgir mulige interessekonflikter, finansiering eller ideologiske ståsteder som kan påvirke konklusjonene. Engasjementssignaler fra akademiske og profesjonelle miljøer, inkludert siteringer og fagdiskusjon, gir ekstern validering av troverdighet. Følgende faktorer representerer de mest kritiske elementene AI-systemene prioriterer:

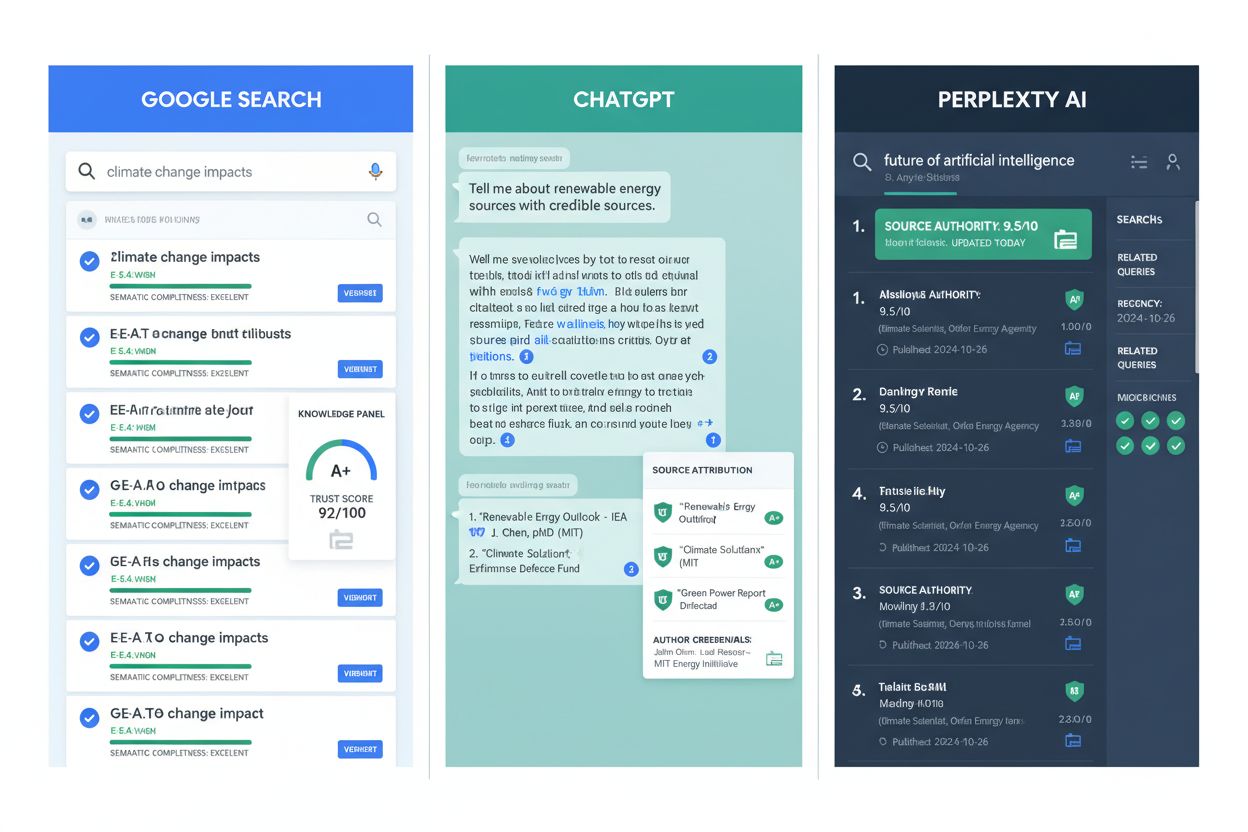

AI-drevet troverdighetsvurdering har blitt en integrert del av store informasjonsplattformer og forskningsinfrastruktur. Google AI Oversikter bruker troverdighets-signaler for å avgjøre hvilke kilder som vises i AI-genererte sammendrag, med prioritet til innhold fra etablerte utgivere og verifiserte eksperter. ChatGPT og lignende språkmodeller benytter troverdighetsvurdering under trening for å vekte kilder riktig, selv om de har utfordringer med sanntidsvurdering av nye påstander. Perplexity AI inkluderer eksplisitt kildetroverdighet i sin siteringsmetodikk, og viser kildens omdømme sammen med søkeresultater for å hjelpe brukere å vurdere kvaliteten på informasjonen. I akademisk forskning hjelper troverdighetsvurderingsverktøy forskere å identifisere høykvalitetskilder mer effektivt, og reduserer tiden brukt på litteraturgjennomgang samtidig som forskningsgrunnlaget forbedres. Innholdsbevaringsinitiativer bruker troverdighetsvurdering for å prioritere arkivering av autoritative kilder, slik at fremtidige forskere får tilgang til pålitelig historisk informasjon. AmICited.com er en overvåkningsløsning som sporer hvordan kilder blir sitert og vurdert på ulike plattformer, og hjelper utgivere å forstå sin troverdighetsposisjon og finne forbedringsmuligheter. Faktasjekk-organisasjoner bruker automatisert troverdighetsvurdering for å prioritere påstander til manuell verifisering, slik at menneskelige ressurser fokuseres på desinformasjon med størst påvirkning. Utdanningsinstitusjoner bruker i økende grad troverdighetsvurderingsverktøy for å lære studenter om kildekritikk, slik at de implisitte kriteriene blir eksplisitte og målbare. Disse bruksområdene viser at troverdighetsvurdering har gått fra teoretisk rammeverk til praktisk infrastruktur for informasjonskvalitet i digitale økosystemer.

Til tross for betydelige fremskritt har automatisert troverdighetsvurdering vesentlige begrensninger som krever menneskelig tilsyn og kontekstuell vurdering. Engasjements-bias er en grunnleggende utfordring; populære kilder kan få høye troverdighets-score basert på sosiale signaler selv om de inneholder unøyaktig informasjon, siden engasjement ikke alltid korrelerer med nøyaktighet. Falske positive og negative oppstår når algoritmene feiltolker kilder—etablerte eksperter i nye fagfelt kan mangle siteringshistorikk, mens produktive desinformasjonsaktører kan utvikle sofistikerte troverdighets-signaler. Nye desinformasjons-taktikker utnytter vurderingssystemene ved å etterligne legitime kilder, lage falske forfatterprofiler og produsere falske siteringer som lurer automatiske systemer. Domene-spesifikke variasjoner betyr at en kilde kan være troverdig innen ett felt, men mangle autoritet i et annet, selv om systemene av og til gir like troverdighets-score på tvers av domener. Tidsmessige endringer gjør vurderingen komplisert; kilder som var troverdige ved publisering kan bli utdaterte eller diskreditert etter hvert som ny kunnskap kommer til, noe som krever kontinuerlig vurdering fremfor statisk score. Kulturell og språklig bias i treningsdata gjør at systemene kan undervurdere kilder fra ikke-engelskspråklige eller underrepresenterte miljøer, og viderefører eksisterende informasjons-hierarkier. Manglende åpenhet er en utfordring fordi mange vurderingsalgoritmer fungerer som sorte bokser, slik at det er vanskelig for kilder å forstå hvordan de kan forbedre sine signaler eller for brukere å forstå hvorfor en kilde har fått en bestemt vurdering. Disse begrensningene understreker at automatisert troverdighetsvurdering bør supplere, ikke erstatte, menneskelig kritisk vurdering.

Innholdsskapere og utgivere kan betydelig forbedre sine troverdighets-signaler ved å implementere praksiser som stemmer overens med hvordan AI-systemene vurderer pålitelighet. Implementer E-E-A-T-prinsippene—vis Erfaring, Ekspertise, Autoritet og Troverdighet—ved å tydelig vise forfatterkvalifikasjoner, profesjonelle tilknytninger og relevante kvalifikasjoner på innholdssidene. Riktig siteringspraksis styrker troverdigheten ved å lenke til høykvalitetskilder, bruke konsistente siteringsformater og sørge for at alle påstander refererer til verifiserbar dokumentasjon; dette viser at innholdet bygger på etablert kunnskap, ikke spekulasjon. Transparens om metodikk hjelper AI-systemer å gjenkjenne grundig forskningspraksis; forklar tydelig datakilder, forskningsmetoder, begrensninger og eventuelle interessekonflikter. Oppretthold forfatterprofiler med biografisk informasjon, publikasjonsliste og profesjonelle kvalifikasjoner som AI-systemer kan verifisere og vurdere. Oppdater innhold regelmessig for å vise forpliktelse til nøyaktighet; utdatert informasjon reduserer troverdighets-score, mens jevnlige revisjoner signaliserer at du følger utviklingen i feltet. Oppgi finansieringskilder og tilknytninger eksplisitt, da åpenhet om potensielle bias faktisk øker troverdigheten—AI-systemene anerkjenner at oppgitte konflikter er mindre problematiske enn skjulte. Bygg siteringsautoritet ved å publisere i anerkjente tidsskrifter, søke fagfellevurdering og bli sitert av andre troverdige kilder; dette skaper positive feedback-looper der troverdighet styrker troverdighet. Engasjer deg i fagmiljøet gjennom konferanser, samarbeid og diskusjoner, da slike engasjementssignaler validerer ekspertise og øker synlighet for vurderingssystemene. Implementer strukturert datamerking med schema.org og lignende standarder slik at AI-systemer automatisk kan hente og verifisere forfatterinformasjon, publiseringsdato og andre troverdighetsindikatorer.

Utviklingen av vurdering av kilders troverdighet vil i økende grad inkludere multimodal evaluering som analyserer tekst, bilder, video og lyd samtidig for å avdekke avansert desinformasjon som utnytter ensidig analyse. Sanntids verifiseringssystemer vil integreres med publiseringsplattformer, og gi umiddelbar tilbakemelding om troverdighet mens innhold publiseres, slik at man kan korrigere før feilinformasjon sprer seg. Blokkjedebasert troverdighets-sporing kan muliggjøre uforanderlige registre over kildehistorikk, siteringer og rettelser, og gi transparent troverdighetsproveniens som AI-systemer kan evaluere med større sikkerhet. Personlig tilpasset troverdighetsvurdering vil gå utover standard score og evaluere kilder i forhold til brukerens egen ekspertise og behov, i erkjennelse av at troverdighet også er subjektiv og kontekstavhengig. Integrasjon med kunnskapsgrafer vil gjøre det mulig for AI-systemer å vurdere kilder i nettverk av relatert informasjon, og identifisere kilder som motsier etablert kunnskap eller fyller viktige kunnskapshull. Forklarbare AI-troverdighets-systemer vil bli normen, og gi transparente forklaringer på hvorfor kilder har fått sine vurderinger, slik at skapere kan forbedre seg og brukere kan forstå vurderingsgrunnlaget. Kontinuerlige læringssystemer vil tilpasse seg nye desinformasjons-taktikker i sanntid, og oppdatere vurderingsmodellene etter hvert som nye manipulasjonsteknikker dukker opp, fremfor å basere seg på statiske treningsdata. Plattformuavhengig troverdighets-sporing vil skape samordnede troverdighetsprofiler som følger kilder på tvers av internett, noe som gjør det vanskeligere for aktører med dårlig intensjon å opprettholde ulike omdømmer på forskjellige plattformer. Disse utviklingene vil gjøre troverdighetsvurdering stadig mer sofistikert, transparent og integrert i informasjonsinfrastrukturen som milliarder av mennesker er avhengige av daglig.

Vurdering av kilders troverdighet er en systematisk evaluering av informasjonskilder for å fastslå deres pålitelighet og troverdighet. AI-systemer analyserer flere dimensjoner, inkludert forfatterens kvalifikasjoner, utgiverens omdømme, siteringsmønstre og faktasjekk-resultater for å avgjøre om kildene fortjener å bli inkludert i forskning, kunnskapsbaser eller AI-genererte sammendrag. Denne automatiserte prosessen gjør det mulig for plattformer å evaluere millioner av kilder på en konsistent måte.

AI-systemer oppdager troverdighets-signaler gjennom naturlig språkprosessering, maskinlæringsmodeller og strukturert dataanalyse. De undersøker akademiske signaler (fagfellevurderingsstatus, institusjonstilknytning), tekstsignaler (siteringstetthet, påstandsspesifisitet), metadata-signaler (forfatterkvalifikasjoner, publiseringsdatoer), sosiale signaler (siteringstall, ekspertanbefalinger), og verifiseringssignaler (resultater fra faktasjekk, påstandskorrespondanse). Disse signalene vektes basert på deres prediktive verdi for nøyaktighet.

De viktigste troverdighetsfaktorene inkluderer forfatterens omdømme og ekspertise, utgiverens omdømme, antall og kvalitet på siteringer, aktualitet og tidsriktighet, åpenhet om bias og interessekonflikter, engasjements-signaler fra det profesjonelle miljøet, kildeverifisering gjennom faktasjekk, integrering av bakgrunnskunnskap, forfatterens tilknytning til anerkjente institusjoner og oppdateringsfrekvens. Disse faktorene sammenlagt etablerer kildens pålitelighet og troverdighet.

Utgivere kan forbedre troverdigheten ved å implementere E-E-A-T-prinsippene (Experience, Expertise, Authoritativeness, Trustworthiness), bruke riktige siteringspraksiser, opprettholde transparent metodikk, vise detaljerte forfatterprofiler med kvalifikasjoner, oppdatere innhold jevnlig, oppgi finansieringskilder og tilknytninger, bygge siteringsautoritet gjennom fagfellevurdering, engasjere seg i det profesjonelle miljøet og implementere strukturert datamerking for å hjelpe AI-systemer å hente ut troverdighetsinformasjon.

Automatisert troverdighetsvurdering står overfor utfordringer som engasjements-bias (populære kilder kan score høyt til tross for unøyaktighet), falske positive og negative, nye desinformasjons-taktikker som etterligner legitime kilder, domene-spesifikke variasjoner i troverdighet, tidsmessige endringer etter hvert som kilder blir utdaterte, kulturell og språklig bias i treningsdata, samt manglende åpenhet i sorte-boks-algoritmer. Disse begrensningene betyr at automatisert vurdering bør supplere, ikke erstatte, menneskelig, kritisk vurdering.

Google AI Oversikter prioriterer kilder med etablerte utgivere og verifiserte eksperter for AI-genererte sammendrag. ChatGPT vektlegger kilder under trening basert på troverdighets-signaler. Perplexity viser eksplisitt kildeomdømme sammen med søkeresultater. AmICited.com overvåker hvordan kilder blir sitert på alle større AI-plattformer og hjelper utgivere å forstå sin troverdighetsposisjon og identifisere forbedringsmuligheter.

Fremtidig utvikling inkluderer multimodal evaluering som analyserer tekst, bilder, video og lyd sammen; sanntids verifiseringssystemer som gir umiddelbar tilbakemelding på troverdighet; blokkjedebasert troverdighets-sporing; personlig tilpasset vurdering av troverdighet i forhold til brukerens ekspertise; integrasjon med kunnskapsgrafer; forklarbare AI-systemer som gir transparent vurderingsgrunnlag; kontinuerlig læring for å tilpasse seg nye desinformasjons-taktikker; og plattformuavhengig troverdighets-sporing som skaper enhetlige profiler.

Vurdering av kilders troverdighet er avgjørende fordi det bestemmer hvilke kilder som vises i AI-genererte sammendrag, påvirker AI-treningsdata og former hvilken informasjon milliarder av mennesker møter. Nøyaktig vurdering av troverdighet bidrar til å hindre spredning av feilinformasjon, sikrer at AI-systemer gir pålitelig informasjon, støtter akademisk forskningskvalitet og opprettholder tillit til AI-drevne informasjonssystemer. Etter hvert som AI blir mer innflytelsesrikt for informasjonsinnhenting, blir troverdighetsvurdering stadig viktigere.

Følg med på hvordan dine kilder blir sitert og vurdert på Google AI Oversikter, ChatGPT, Perplexity og Gemini. AmICited.com hjelper deg å forstå din troverdighetsposisjon og identifisere muligheter for forbedring.

Oppdag hvordan AI-motorer som ChatGPT, Perplexity og Google AI vurderer kilders tilforlitelighet. Lær om E-E-A-T, domenemyndighet, siteringsfrekvens og andre av...

Oppdag hvilke kilder AI-motorer siterer oftest. Lær hvordan ChatGPT, Google AI Overviews og Perplexity vurderer kilde-troverdighet, og forstå siteringsmønstre p...

Lær hvordan AI-systemer vurderer tillitsignaler gjennom E-E-A-T-rammeverket. Oppdag troverdighetsfaktorene som hjelper LLM-er å sitere innholdet ditt og bygge a...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.