Jak wizualizacje danych wspierają widoczność AI Search i LLM

Dowiedz się, jak wizualizacje danych zwiększają widoczność w wyszukiwaniu AI, pomagają LLM zrozumieć treści i zwiększają cytowania w odpowiedziach generowanych ...

Dowiedz się, jak modele AI cytują dane wizualne i wykresy. Poznaj znaczenie wizualizacji danych dla cytowań przez AI i jak śledzić swoje treści wizualne z AmICited.

Dane wizualne stanowią podstawową barierę dla nowoczesnych dużych modeli językowych, które były trenowane głównie na informacjach tekstowych i mają trudności z przetwarzaniem, interpretacją oraz cytowaniem wykresów z taką samą precyzją, jaką wykazują wobec treści pisanych. Obecne modele LLM napotykają poważne ograniczenia w kontakcie z wizualizacjami danych—muszą najpierw przekonwertować elementy wizualne na opisy tekstowe, co często powoduje utratę kluczowych niuansów, precyzyjnych wartości i kontekstu zawartego w oryginalnym wykresie. Nieumiejętność dokładnego przetwarzania danych wizualnych przez systemy LLM oznacza, że wykresy, grafiki i infografiki często nie są cytowane lub są cytowane błędnie, co powoduje utratę wiarygodności dla twórców inwestujących czas w wysokiej jakości wizualizacje. To wyzwanie ma duże znaczenie dla badaczy, analityków i organizacji polegających na przetwarzaniu wykresów przez AI do syntezy informacji, ponieważ brak właściwej atrybucji podważa zarówno pracę oryginalnego twórcy, jak i rzetelność podsumowań generowanych przez AI. Zrozumienie tych ograniczeń jest kluczowe dla każdego, kto tworzy treści wizualne w coraz bardziej zdominowanym przez AI świecie informacji.

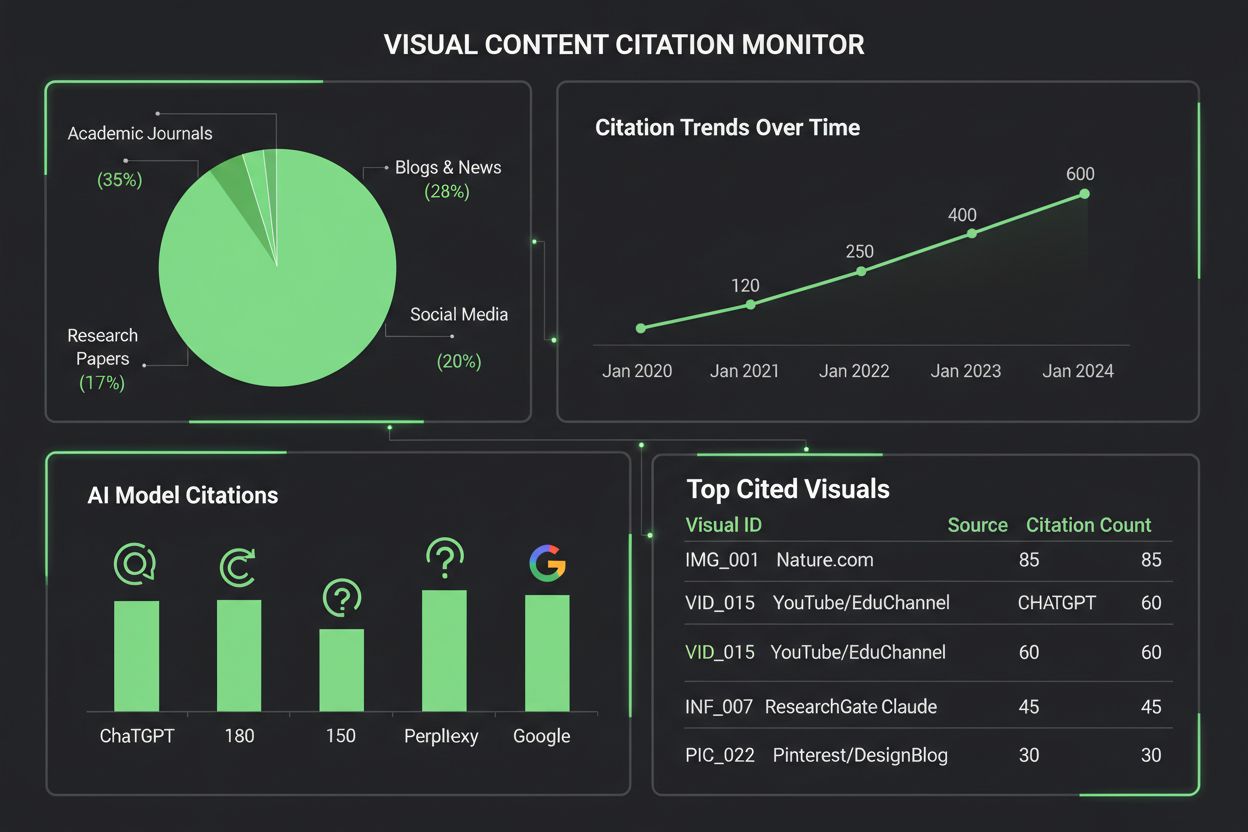

Różne systemy AI podchodzą do cytowania treści wizualnych z różnym poziomem zaawansowania, co odzwierciedla ich architekturę i metody treningu. Poniższa tabela przedstawia, jak główne platformy AI radzą sobie z cytowaniami wizualnymi:

| Model AI | Możliwość cytowania wizualnego | Format cytowania | Poziom dokładności | Obsługa multimodalna |

|---|---|---|---|---|

| ChatGPT (GPT-4V) | Umiarkowana | Tekst opisowy | 65-75% | Tak (wejście obrazów) |

| Claude 3 | Wysoka | Szczegółowa atrybucja | 80-85% | Tak (z obsługą wizji) |

| Perplexity AI | Wysoka | Źródło + odwołanie wizualne | 85-90% | Tak (integracja z siecią) |

| Google AI Overviews | Umiarkowana-wysoka | Cytowania w tekście | 75-80% | Tak (wyszukiwanie obrazów) |

| Gemini Pro Vision | Umiarkowana | Odwołanie kontekstowe | 70-78% | Tak (multimodalna) |

Claude wykazuje najwyższą skuteczność w atrybucji treści wizualnych, często podając szczegółowe informacje o źródle i kontekście przy cytowaniu wykresów, podczas gdy Perplexity AI wyróżnia się integracją cytowań wizualnych ze źródłami internetowymi, tworząc bardziej kompletną ścieżkę atrybucji. GPT-4V ChatGPT potrafi przetwarzać obrazy, ale często poprzestaje na ogólnych opisach zamiast precyzyjnych cytowań, zwłaszcza przy złożonych wykresach finansowych lub naukowych. Google AI Overviews stara się utrzymywać cytowania w treści dla materiałów wizualnych, ale czasami myli autora wykresu ze źródłem danych, co powoduje niejasność co do właściwej atrybucji. Dla twórców treści ta różnorodność oznacza, że ta sama wizualizacja może być różnie potraktowana przez różne systemy AI—wykres może być prawidłowo zacytowany w Claude, a całkowicie pominięty w ChatGPT, co podkreśla potrzebę standardowych protokołów cytowania wizualnego w ekosystemie AI.

Wizualizacja danych odgrywa zaskakująco istotną rolę w kształtowaniu, jak modele AI rozumieją i reprezentują informacje, ponieważ wykresy i grafiki zawarte w zestawach treningowych uczą modele rozpoznawania wzorców, relacji i hierarchii w złożonych danych. Jakość i różnorodność danych wizualnych w zbiorach treningowych bezpośrednio wpływa na to, jak dobrze systemy AI później interpretują i cytują podobne wizualizacje, co oznacza, że modele trenowane na kompleksowych zbiorach danych wizualnych wykazują znacznie lepszą skuteczność w atrybucji treści wizualnych. Wzorce wizualne przyswajane w trakcie treningu wpływają na wyniki generowane przez modele w subtelny, ale mierzalny sposób—model intensywnie trenowany na prawidłowo opisanych wykresach naukowych z większym prawdopodobieństwem poprawnie zacytuje podobne wizualizacje niż model trenowany głównie na tekście. Problem pogłębia się, ponieważ większość dużych modeli językowych była trenowana na danych internetowych, gdzie treści wizualne często nie mają odpowiednich metadanych, tekstów alternatywnych ani atrybucji źródła, przez co AI uczy się przetwarzać wykresy bez nauki ich cytowania. Organizacje inwestujące w wysokiej jakości, dobrze udokumentowane zbiory wizualizacji danych budują lepsze podstawy pod przyszłe systemy AI, choć takie działania są wciąż rzadkością w branży.

Monitorowanie, jak systemy AI cytują treści wizualne, wymaga wielowarstwowego podejścia, łączącego automatyczne wykrywanie z ręczną weryfikacją. Kluczowe metody śledzenia obejmują:

AmICited.com specjalizuje się w śledzeniu cytowań treści wizualnych na różnych platformach AI, dostarczając twórcom szczegółowych raportów na temat tego, jak ich wykresy są cytowane, atrybuowane lub pomijane przez ChatGPT, Claude, Perplexity, Google AI i inne systemy. Znaczenia monitoringu cytowań wizualnych nie należy lekceważyć—bez odpowiedniego śledzenia twórcy tracą wgląd w to, jak ich praca wpływa na treści generowane przez AI, przez co nie mogą promować lepszych praktyk atrybucji ani zrozumieć faktycznego zasięgu swoich wizualizacji. Narzędzia monitorujące treści wizualne AmICited wypełniają tę lukę, oferując twórcom powiadomienia w czasie rzeczywistym o cytowaniach wykresów, szczegółową analitykę dokładności cytowań oraz praktyczne wskazówki dotyczące poprawy wykrywalności wizualizacji w systemach AI.

Tworzenie wizualizacji, które mają większą szansę na cytowanie przez systemy AI, wymaga świadomych decyzji projektowych nastawionych na czytelność, bogactwo metadanych i łatwość odczytu maszynowego. Wyraziste, kontrastowe schematy kolorów i czytelne oznaczenia znacznie poprawiają przetwarzanie wykresów przez AI, ponieważ modele mają trudności z subtelnymi gradientami, nakładającymi się elementami i niejasnymi legendami, które ludzie potrafią odczytać intuicyjnie. Dodaj rozbudowane opisy alternatywne, które obejmują nie tylko to, co przedstawia wykres, ale także relacje danych, kluczowe wnioski i informacje o źródle—te metadane stanowią podstawę do precyzyjnych cytowań przez AI. Osadzaj dane strukturalne w wizualizacjach korzystając ze standardów takich jak JSON-LD lub mikroformaty, co pozwala systemom AI wyodrębniać wartości i powiązania bez polegania wyłącznie na interpretacji wizualnej. Upewnij się, że tytuły wykresów są opisowe i konkretne, ponieważ modele AI traktują tytuły jako główne punkty odniesienia przy rozumieniu i cytowaniu treści wizualnych. Umieszczaj atrybucję źródła bezpośrednio na wizualizacji poprzez przypisy, znaki wodne lub zintegrowane etykiety źródłowe, co uniemożliwia AI oddzielenie wykresu od jego pochodzenia. Organizacje stosujące te praktyki regularnie obserwują zauważalne poprawy w zakresie cytowania ich treści wizualnych przez platformy AI, co przekłada się na lepszą atrybucję, większą widoczność i wyższą wiarygodność zawodową.

Rynek narzędzi do monitorowania cytowań wizualnych stale się rozrasta, ponieważ organizacje coraz częściej dostrzegają wagę śledzenia, jak systemy AI odwołują się do treści wizualnych. AmICited.com wyróżnia się jako kompleksowe rozwiązanie zaprojektowane specjalnie do monitorowania cytowań treści wizualnych na wielu platformach AI, oferując twórcom szczegółowe panele pokazujące dokładnie, kiedy i jak ich wykresy są cytowane przez ChatGPT, Claude, Perplexity, Google AI Overviews i nowe systemy AI. Tradycyjne platformy do śledzenia cytowań, takie jak Google Scholar i Scopus, skupiają się głównie na publikacjach naukowych i cytowaniach tekstowych, przez co treści wizualne pozostają w dużej mierze poza monitoringiem i bez atrybucji. Specjalistyczne narzędzia, takie jak Tinybird i inne platformy wizualizacji danych, integrują już funkcje śledzenia cytowań, umożliwiając organizacjom monitorowanie, jak ich wizualizacje danych w czasie rzeczywistym są konsumowane i cytowane przez systemy AI. Analityka wizualna AmICited dostarcza statystyk dotyczących częstotliwości cytowań, wskaźników dokładności i wzorców specyficznych dla platform, co pozwala twórcom zrozumieć, które systemy AI poprawnie atrybuują ich pracę, a które wymagają interwencji. Dla organizacji poważnie podchodzących do ochrony własności intelektualnej wizualnej i zrozumienia wpływu swoich treści w ekosystemie informacji napędzanym przez AI, wdrożenie dedykowanego rozwiązania do monitorowania cytowań wizualnych, takiego jak AmICited.com, stało się niezbędne—przekształca ono monitoring cytowań z biernej obserwacji w aktywne zarządzanie, prowadzące do lepszej atrybucji.

Obecne modele AI mają różne możliwości w zakresie cytowania treści wizualnych. Zaawansowane modele, takie jak Claude i Perplexity, potrafią odwołać się do wykresów z dość dobrą dokładnością, jednak wiele systemów ma trudności z prawidłową atrybucją. Większość LLM była trenowana głównie na danych tekstowych, przez co cytowanie wizualne jest mniej wiarygodne niż tekstowe. Dlatego narzędzia monitorujące, takie jak AmICited, są niezbędne do śledzenia, jak Twoje wizualizacje są faktycznie cytowane.

AmICited.com oferuje kompleksowy monitoring treści wizualnych na wielu platformach AI, w tym ChatGPT, Claude, Perplexity i Google AI Overviews. Platforma wykorzystuje automatyczne rozpoznawanie obrazu i analizę metadanych, aby identyfikować, kiedy Twoje wykresy pojawiają się w treściach generowanych przez AI, dostarczając powiadomień w czasie rzeczywistym i szczegółowych analiz dotyczących dokładności oraz częstotliwości cytowania.

Systemy AI dokładniej cytują wykresy, które wykorzystują wyraziste, kontrastowe kolory, czytelne opisy, szczegółowe tytuły oraz rozbudowany tekst alternatywny. Włączenie oznaczeń danych strukturalnych, atrybucji źródła w samej wizualizacji oraz dobrze zorganizowanych legend znacząco poprawia przetwarzanie wykresów przez AI i zwiększa szanse na cytowanie. Tworzenie kilku wersji złożonych wizualizacji—uproczonych dla AI i szczegółowych dla ludzi—również zwiększa ich wykrywalność.

Według obecnych możliwości, Claude 3 i Perplexity AI wykazują najwyższą dokładność w atrybucji treści wizualnych, osiągając dokładność cytowań na poziomie 80–90%. Google AI Overviews i Gemini Pro Vision radzą sobie umiarkowanie dobrze (75–80%), natomiast GPT-4V ChatGPT, mimo funkcji wizualnych, często poprzestaje na ogólnych opisach zamiast precyzyjnych cytowań. Te możliwości stale się rozwijają wraz z aktualizacjami modeli.

Monitorowanie cytowań wizualnych jest kluczowe dla widoczności marki, oceny wartości treści i ochrony własności intelektualnej. Prawidłowe cytowanie Twoich wykresów przez systemy AI zwiększa rozpoznawalność marki w treściach generowanych przez AI, potwierdza wpływ Twoich materiałów i pozwala zrozumieć, jak Twoja praca kształtuje syntezę informacji przez AI. Bez monitoringu tracisz kontrolę nad zasięgiem i wpływem swoich treści.

AmICited specjalizuje się w śledzeniu cytowań treści wizualnych na wielu platformach AI, oferując szczegółowe panele pokazujące, kiedy i jak Twoje wykresy są cytowane. Platforma zapewnia powiadomienia w czasie rzeczywistym, wskaźniki dokładności cytowań, analitykę specyficzną dla platform oraz praktyczne wskazówki na temat poprawy wykrywalności treści wizualnych. Przekształca to monitoring cytowań z biernej obserwacji w aktywne zarządzanie własnością intelektualną wizualną.

Cytowania tekstowe w systemach AI są zwykle bardziej wiarygodne, ponieważ LLM były trenowane głównie na danych tekstowych. Cytowania wizualne wymagają dodatkowych etapów przetwarzania—AI musi najpierw przekonwertować elementy wizualne na opisy tekstowe, co często prowadzi do utraty niuansów i precyzyjnych wartości. Ten proces konwersji zwiększa ryzyko błędów, przez co cytowania wizualne są mniej dokładne i spójne niż tekstowe na różnych platformach AI.

Zdecydowanie tak. Stosuj najlepsze praktyki, takie jak używanie wyrazistych, kontrastowych kolorów, tworzenie opisowych tytułów i tekstów alternatywnych, osadzanie oznaczeń danych strukturalnych oraz umieszczanie atrybucji źródła bezpośrednio w wizualizacjach. Unikaj subtelnych gradientów, nakładających się elementów i niejasnych legend. Rozważ tworzenie uproszczonych wersji złożonych wykresów specjalnie na potrzeby przetwarzania przez AI. Takie ulepszenia zwiększą wykrywalność i cytowalność Twoich wizualizacji przez systemy AI.

Śledź, jak systemy AI cytują Twoje wykresy i wizualizacje w ChatGPT, Claude, Perplexity i Google AI. Otrzymuj powiadomienia w czasie rzeczywistym i szczegółowe analizy dotyczące atrybucji treści wizualnych.

Dowiedz się, jak wizualizacje danych zwiększają widoczność w wyszukiwaniu AI, pomagają LLM zrozumieć treści i zwiększają cytowania w odpowiedziach generowanych ...

Dowiedz się, jak identyfikować i zamykać luki w widoczności treści AI w ChatGPT, Perplexity i Google AI Overviews. Poznaj metody analizy i narzędzia, które popr...

Dowiedz się, jak wyszukiwanie wizualne i AI zmieniają odkrywanie obrazów. Optymalizuj swoje obrazy pod Google Lens, AI Overviews i multimodalne LLM-y, aby zwięk...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.