Wyszukiwanie wizualne i AI: Optymalizacja obrazów pod kątem odkrywania przez AI

Dowiedz się, jak wyszukiwanie wizualne i AI zmieniają odkrywanie obrazów. Optymalizuj swoje obrazy pod Google Lens, AI Overviews i multimodalne LLM-y, aby zwięk...

Dowiedz się, jak Google Lens przekształca wyszukiwanie wizualne — już ponad 100 miliardów wyszukiwań rocznie. Poznaj strategie optymalizacji, aby Twoja marka pojawiała się w wynikach odkrywania wizualnego i przyciągała ruch zakupowy.

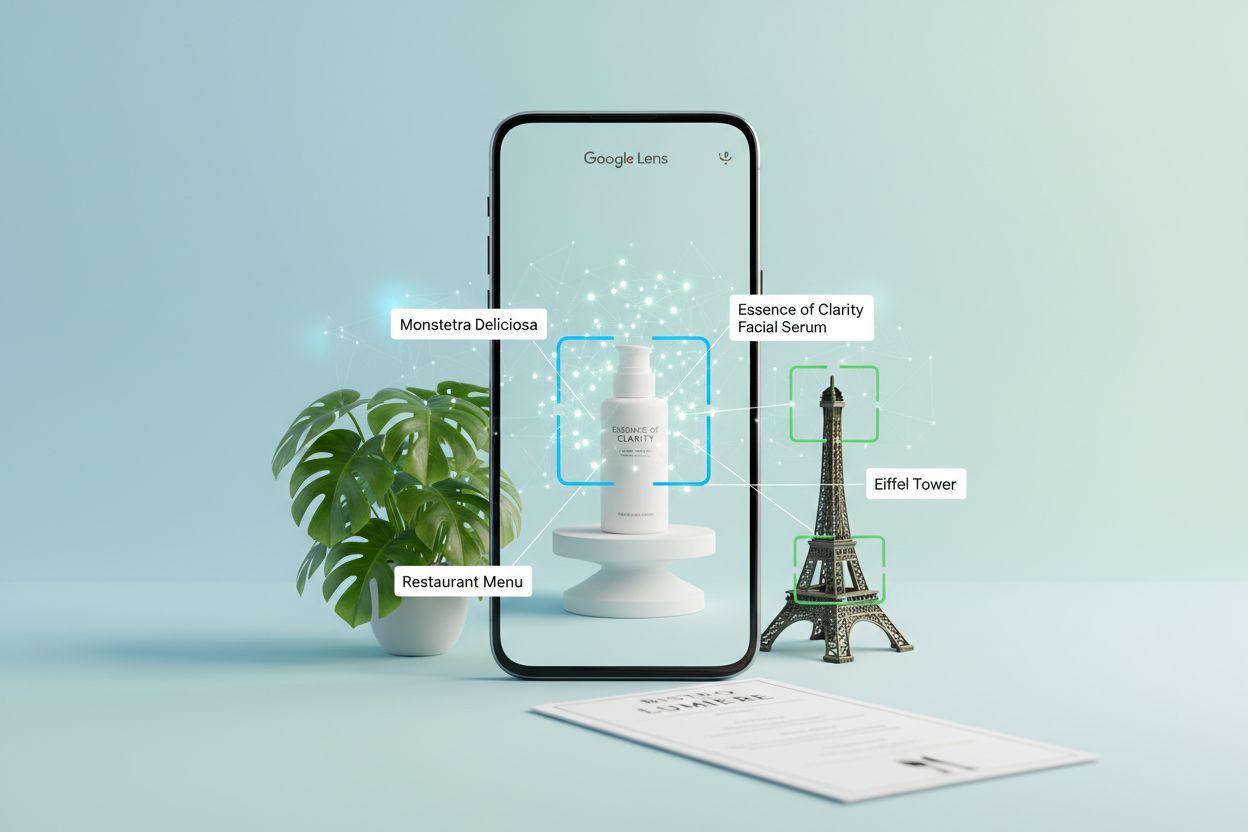

Wyszukiwanie wizualne zasadniczo zmieniło sposób odkrywania informacji w internecie, przesuwając punkt ciężkości z zapytań tekstowych na interakcje oparte na kamerze. Google Lens, sztandarowa technologia wyszukiwania wizualnego tej firmy, obsługuje obecnie prawie 20 miliardów wyszukiwań wizualnych miesięcznie, a w samym 2024 roku przez Lens i Circle to Search zrealizowano ponad 100 miliardów takich wyszukiwań. Ten gwałtowny wzrost odzwierciedla szerszą zmianę w zachowaniach konsumenckich: coraz więcej osób woli wskazać kamerą na coś, o czym chce się dowiedzieć, zamiast wpisywać opis.

Zasięg platformy jest oszałamiający: już 1,5 miliarda osób korzysta z Google Lens miesięcznie, z najwyższą aktywnością wśród młodszych użytkowników w wieku 18-24 lata. Co szczególnie istotne dla marek, jedna na pięć z tych wyszukiwań wizualnych — około 20 miliardów — ma bezpośrednią intencję zakupową. To nie są przypadkowe zapytania z ciekawości; to potencjalni klienci aktywnie szukający możliwości zakupu tego, co zobaczyli w rzeczywistości.

U podstaw Google Lens leżą trzy powiązane technologie AI, które pozwalają rozumieć i odpowiadać na zapytania wizualne. Konwolucyjne sieci neuronowe (CNN) stanowią fundament, analizując wzorce pikseli w celu rozpoznawania obiektów, scen i relacji wizualnych z niezwykłą dokładnością. Modele te są trenowane na miliardach oznakowanych zdjęć, dzięki czemu rozpoznają wszystko — od przedmiotów codziennego użytku po rzadkie gatunki roślin.

Optyczne rozpoznawanie znaków (OCR) odpowiada za wykrywanie i wyodrębnianie tekstu, umożliwiając Lens odczytywanie menu, znaków, dokumentów czy odręcznych notatek. Gdy skierujesz kamerę na menu w obcym języku lub znak uliczny, OCR zamienia wizualny tekst w dane cyfrowe możliwe do przetworzenia i tłumaczenia. Przetwarzanie języka naturalnego (NLP) interpretuje ten tekst kontekstowo, rozumiejąc nie tylko obecność słów, ale także ich znaczenie w odniesieniu do Twojego zapytania.

Prawdziwa moc tkwi w multimodalnym AI — zdolności do równoległego przetwarzania wielu typów danych wejściowych. Możesz skierować kamerę na produkt, zadać pytanie głosowe i otrzymać odpowiedź AI, która łączy rozumienie obrazu z kontekstem konwersacyjnym. Ta integracja sprawia, że wyszukiwanie staje się naturalne i intuicyjne.

| Funkcja | Tradycyjne wyszukiwanie tekstowe | Google Lens |

|---|---|---|

| Metoda wejściowa | Wpisywane słowa kluczowe | Obraz, wideo lub głos |

| Możliwość rozpoznania | Tylko słowa kluczowe | Obiekty, tekst, kontekst, relacje |

| Szybkość odpowiedzi | Sekundy | Natychmiast |

| Zrozumienie kontekstu | Ograniczone do tekstu | Szeroki kontekst wizualny |

| Możliwość działania w czasie rzeczywistym | Nie | Tak, z kamerą na żywo |

| Skuteczność dla przedmiotów wizualnych | Niska (trudne do opisania) | Wysoka (bezpośrednie dopasowanie wizualne) |

Praktyczne zastosowania Google Lens wykraczają daleko poza zwykłą ciekawość. W zakupach użytkownicy fotografują produkty w sklepach, mediach społecznościowych czy filmach, po czym natychmiast znajdują miejsca ich zakupu oraz porównują ceny u różnych sprzedawców. Klient zauważa mebel w domu znajomego, robi zdjęcie i odkrywa dokładnie ten sam przedmiot dostępny do kupienia — bez wychodzenia z danej sytuacji.

Edukacja to kolejny istotny obszar, zwłaszcza na rynkach rozwijających się. Uczniowie fotografują zadania z podręczników lub materiały z lekcji po angielsku, używają Lens do tłumaczenia na swój język i uzyskują pomoc w odrabianiu prac domowych. Pozwala to demokratyzować dostęp do edukacji bez względu na bariery językowe.

Podróże i eksploracja wykorzystują Lens do rozpoznawania zabytków, odkrywania restauracji i nauki o kulturze. Turyści fotografują nieznane budowle czy napisy i natychmiast otrzymują kontekst historyczny oraz informacje. Miłośnicy przyrody identyfikują rośliny, zwierzęta i owady podczas wycieczek, zamieniając zwykłe obserwacje w okazję do nauki.

Badanie i porównywanie produktów stało się bezproblemowe. Ktoś zauważa torebkę, robi jej zdjęcie, a Lens zwraca nie tylko dokładny produkt, ale także podobne modele w różnych przedziałach cenowych od pobliskich sprzedawców. Ta funkcja całkowicie zmieniła sposób, w jaki konsumenci podejmują decyzje zakupowe, eliminując tarcia na ścieżce od odkrycia do zakupu.

Skala możliwości jest ogromna: 20 miliardów wyszukiwań wizualnych z intencją zakupową rocznie to potężny kanał, który większość marek całkowicie ignoruje. Podczas gdy konkurenci walczą o miejsce w AI Overview — tłocznej przestrzeni zdominowanej przez największych wydawców i sklepy — wyszukiwanie wizualne pozostaje w dużej mierze nieodkrytym terytorium, oferującym przewagę pierwszego na rynku już teraz.

Marki, które zoptymalizują się pod odkrywanie wizualne, zyskują przewagę wykraczającą poza tradycyjne SEO. Gdy Twój produkt pojawia się w wynikach Google Lens, nie konkurujesz na słowa kluczowe czy jakość treści, lecz na trafność wizualną i kontekst. Sprzedawca mebli, którego produkty pojawiają się w Lens dla zapytania “szafka nocna sypialnia queen”, przechwytuje klienta dokładnie w momencie gotowości do zakupu, zanim ten odwiedzi wyszukiwarkę.

Skutki dla konwersji są ogromne. Użytkownicy wyszukiwania wizualnego już wiedzą, czego chcą — nie przeglądają ani nie badają, tylko kupują. Ten ruch o wysokiej intencji konwertuje znacznie lepiej niż ruch z tradycyjnych wyszukiwarek. Wyszukiwanie wizualne redukuje również bariery przed zakupem: klienci widzą produkt w kontekście, rozumieją jego skalę względem znanych obiektów i podejmują pewniejsze decyzje zakupowe.

Przewaga czasowa jest realna. Większość agencji i marek wciąż nie rozumie, że wyszukiwanie wizualne to odrębny kanał. Firmy wdrażające optymalizację pod wyszukiwanie wizualne już teraz budują przewagę i udział w rynku, podczas gdy konkurencja pozostaje przy starych paradygmatach wyszukiwania.

Optymalizacja pod odkrywanie wizualne wymaga zupełnie innego podejścia niż tradycyjne SEO obrazów. Oto kluczowe strategie:

Każdy z tych elementów wpływa na to, jak Google Lens rozumie i pozycjonuje Twoje treści wizualne. Im więcej kontekstu dostarczysz, tym większa szansa, że Twoje produkty pojawią się w odpowiednich wynikach wyszukiwania wizualnego.

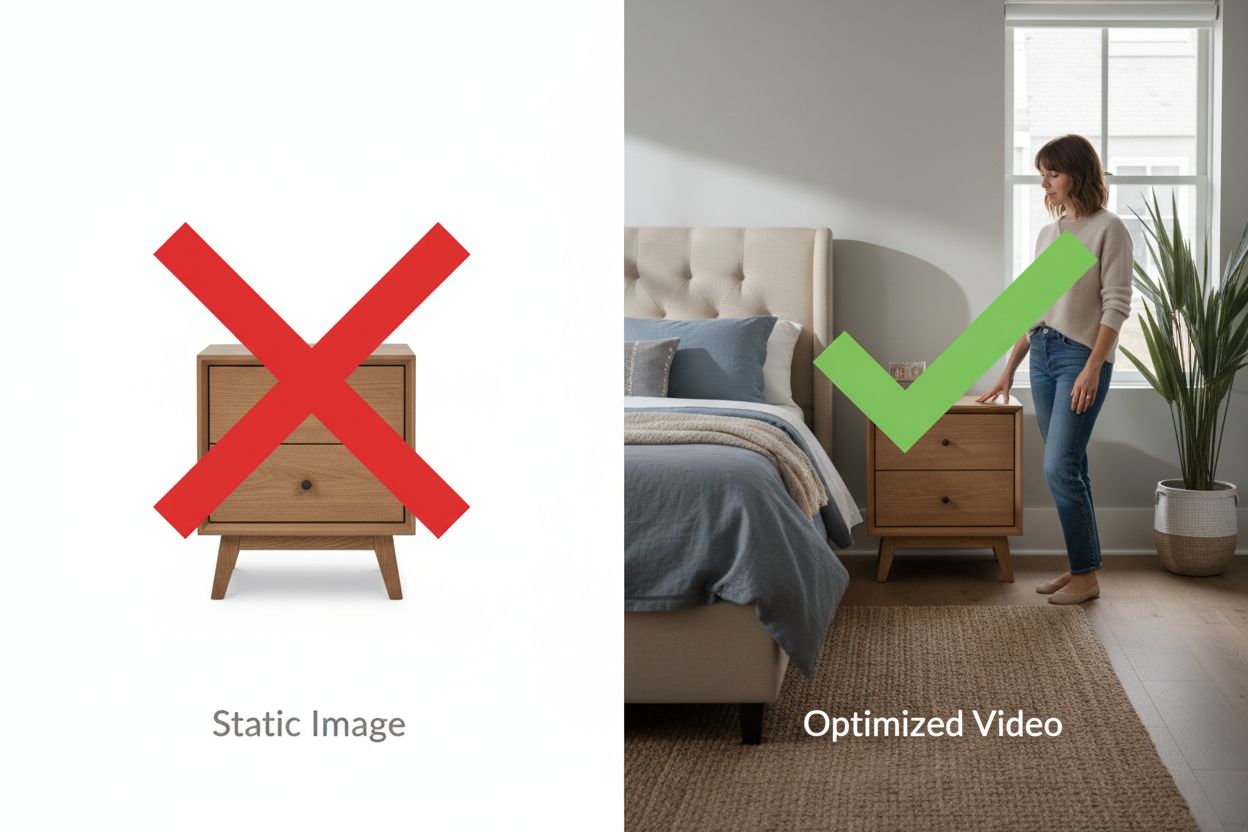

Statyczne zdjęcia to podstawa optymalizacji pod wyszukiwanie wizualne — wideo daje przewagę konkurencyjną. Google Lens wyodrębnia informacje z klatek filmu, co oznacza, że 30-sekundowy film demonstracyjny produktu może wygenerować dziesiątki momentów możliwych do odkrycia, których nie zapewnią zdjęcia.

Wideo pokazuje skalę w sposób niedostępny dla fotografii. Gdy zaprezentujesz szafkę nocną obok łóżka queen z osobą stojącą obok, Lens może precyzyjnie wywnioskować wymiary na podstawie relacji przestrzennych. Gdy pokazujesz produkt w akcji — wodoodporną torbę na deszczu, biurko stojące z dwoma monitorami, namiot w ulewie — dajesz dowód przewyższający deklaracje.

Wpływ na konwersję jest mierzalny. Sklepy internetowe, które dodają filmy produktowe, notują wzrost konwersji o 20-40%, bo klienci mogą wyobrazić sobie produkt w swoim otoczeniu. Te same filmy stają się możliwe do odkrycia w Google Lens, generując ruch z zupełnie nowego kanału.

Wymagania techniczne są proste: filmy trwające 15-45 sekund, prezentujące produkt z różnych kątów i wyraźnym kontekstem skali, przesłane bezpośrednio na Twoją stronę (nie jako embed z YouTube na stronach produktowych), z opisowymi nazwami plików i właściwym oznaczeniem schema. Nie potrzebujesz hollywoodzkiej produkcji — autentyczne nagrania ze smartfona pokazujące rzeczywisty kontekst często sprawdzają się lepiej niż sterylne studio, bo kontekst jest ważniejszy niż wartość produkcyjna.

Wdrażanie optymalizacji pod wyszukiwanie wizualne wymaga strategicznego podejścia. Zacznij od audytu obecnych zasobów wizualnych w sekcji Obrazy Google Search Console — większość marek odkrywa tysiące wyświetleń, ale minimalną liczbę kliknięć, co wskazuje na olbrzymi potencjał optymalizacyjny.

Wskaż swoje 50 najważniejszych produktów pod względem ruchu i przychodów, a następnie oceń ich aktualne treści wizualne. Które mają wiele ujęć? Które mają filmy? Którym brakuje zdjęć lifestyle’owych? Taki audyt pokaże, gdzie optymalizacja przyniesie największy zwrot z inwestycji. Opracuj plan działań, priorytetowo traktując produkty z największym potencjałem wyszukiwania i komercyjnym.

Plan wdrożenia obejmuje 60-90 dni. Tygodnie 1-2 to planowanie i ustalanie priorytetów. Tygodnie 3-4 to produkcja treści — nagrywanie filmów produktowych, zdjęcia lifestyle’owe, tworzenie materiałów demonstracyjnych. Tygodnie 5-6 to optymalizacja techniczna: zmiana nazw plików, pisanie tekstów ALT, wdrażanie schema, wrzucanie treści. Tygodnie 7-8 to monitorowanie i iteracja, analiza, które produkty i treści generują najwięcej ruchu z wyszukiwania wizualnego.

Monitoruj raport Wydajność w Google Search Console, filtrując typ wyszukiwania “Obraz”, aby śledzić postępy. Oczekuj 30-60 dni na wyraźny wzrost ruchu, gdy Google ponownie zaindeksuje nowe treści wizualne. Śledź konwersje z ruchu z wyszukiwania obrazów za pomocą parametrów UTM lub grup kanałów w Google Analytics, by mierzyć zwrot z inwestycji.

Plan rozwoju Google dla wyszukiwania wizualnego rozwija się w ekscytujących kierunkach. Search Live, którego wdrożenie zaplanowano na 2025 rok, umożliwi prowadzenie rozmowy z Wyszukiwarką w czasie rzeczywistym — możesz skierować kamerę na obraz i zapytać “Jaki to styl?”, po czym dopytać “Kto jest znanym artystą w tym stylu?”, tworząc płynne, konwersacyjne doświadczenie wizualne.

Możliwości multimodalnego AI stale się rozwijają, pozwalając Lens rozumieć coraz bardziej złożone zapytania wizualne. Zamiast tylko rozpoznawać obiekty, Lens rozumie relacje, konteksty i subtelne pytania dotyczące tego, co widzisz. Ekspansja Circle to Search wprowadza wyszukiwanie wizualne oparte na gestach na więcej urządzeń i platform, czyniąc odkrywanie wizualne jeszcze bardziej dostępnym.

Integracja w ekosystemie Google pogłębia potencjał. Google Lens jest już wbudowane w Chrome na desktopie, co oznacza dostępność wyszukiwania wizualnego zawsze, gdy pojawi się inspiracja. Wraz z globalnym rozwojem tych funkcji i wdrożeniem na kolejnych platformach przewaga wynikająca z wczesnej optymalizacji będzie jeszcze większa.

Marki, które przygotują się już teraz — optymalizując treści wizualne, tworząc filmy demonstracyjne i wdrażając poprawne oznaczenia schema — zdominują wyniki wyszukiwania wizualnego w miarę rozwoju tego kanału. Pytanie nie brzmi, czy wyszukiwanie wizualne będzie istotne dla Twojego biznesu, ale czy Twoja marka będzie widoczna, gdy klienci będą wyszukiwać wizualnie to, co sprzedajesz.

Google Lens to technologia wyszukiwania wizualnego Google, która wykorzystuje AI do identyfikacji obiektów, tekstu i scen na podstawie zdjęć lub wideo. Wykorzystuje konwolucyjne sieci neuronowe (CNN) do rozpoznawania obiektów, optyczne rozpoznawanie znaków (OCR) do wykrywania tekstu oraz przetwarzanie języka naturalnego (NLP) do rozumienia kontekstu. Użytkownicy mogą skierować aparat na coś i zadawać pytania, otrzymując natychmiast odpowiedzi oparte na AI i powiązane informacje.

Tradycyjne wyszukiwanie obrazów opiera się na słowach kluczowych i metadanych, aby znaleźć podobne wizualnie obrazy. Google Lens rozumie rzeczywistą zawartość obrazów — obiekty, relacje, kontekst i znaczenie — pozwalając dopasowywać produkty i informacje na podstawie podobieństwa wizualnego, a nie opisów tekstowych. Dzięki temu jest znacznie skuteczniejsze przy znajdowaniu rzeczy trudno opisanych słowami, jak meble, moda czy zabytki.

Google Lens przetwarza ponad 100 miliardów wyszukiwań wizualnych rocznie, z czego 20 miliardów ma bezpośrednią intencję zakupową. Użytkownicy wyszukiwań wizualnych aktywnie szukają możliwości zakupu tego, co zobaczyli, co czyni ten ruch niezwykle wartościowym. Optymalizacja pod kątem odkrywania wizualnego pozwala przechwycić klientów w momencie ich intencji zakupowej, zanim jeszcze wpiszą zapytanie, co skutkuje wyższymi konwersjami niż tradycyjny ruch z wyszukiwarki.

Google Lens wymaga otwarcia aplikacji i zrobienia zdjęcia lub przesłania obrazu. Circle to Search to funkcja oparta na gestach dostępna na urządzeniach z Androidem, która pozwala zakreślić, stuknąć lub wyróżnić obiekty bez zmiany aplikacji. Obie korzystają z tej samej technologii wyszukiwania wizualnego, ale Circle to Search zapewnia szybsze i bardziej płynne doświadczenie użytkownikom już przeglądającym treści na telefonie.

Aby zoptymalizować pod Google Lens, należy pokazać produkt pod różnymi kątami, dołączyć elementy o znanych rozmiarach (łóżka, drzwi, osoby) dla kontekstu skali, pisać opisowe teksty alternatywne, wdrożyć schematy danych Product i Video, tworzyć zdjęcia lifestyle’owe pokazujące produkt w realnym użyciu, pozostawiać produkty sezonowe online z informacją o braku dostępności oraz stosować opisowe nazwy plików. Każdy z tych elementów pomaga Google Lens lepiej zrozumieć Twoje treści wizualne.

Wideo to przełom w wyszukiwaniu wizualnym, bo Google Lens wyodrębnia informacje z klatek filmu, tworząc wiele możliwych do odkrycia momentów z jednego nagrania. Filmy pokazują skalę, funkcjonalność i realne zastosowanie produktów w sposób niedostępny dla statycznych zdjęć. Produkty z filmami demonstracyjnymi osiągają wyższe konwersje o 20-40% i częściej pojawiają się w wynikach wyszukiwania wizualnego, dlatego wideo jest kluczowe dla przewagi konkurencyjnej.

Rezultaty w postaci wzrostu ruchu w sekcji Obrazy w Google Search Console pojawiają się zwykle po 30-60 dniach. Google potrzebuje czasu na ponowne zindeksowanie nowych treści wizualnych. Jednak już w ciągu 30 dni powinna być widoczna zwiększona liczba wyświetleń, co oznacza, że Google odkrywa i indeksuje zoptymalizowaną zawartość. Poprawa konwersji zazwyczaj następuje w ciągu 60-90 dni wraz ze wzrostem ruchu.

Tak, możesz śledzić ruch z wyszukiwania wizualnego w Google Analytics, filtrując typ wyszukiwania 'Obraz' w raporcie Wydajność w Google Search Console. Dla bardziej szczegółowego śledzenia konwersji używaj parametrów UTM na stronach produktów lub stwórz własną grupę kanałów ruchu dla wyszukiwania obrazów. Monitoruj wskaźniki takie jak CTR, współczynnik konwersji i średnią wartość zamówienia dla ruchu z wyszukiwania obrazów, aby mierzyć zwrot z optymalizacji.

AmICited śledzi, jak Google Lens, Circle to Search i inne narzędzia AI odnoszą się do Twojej marki w wynikach odkrywania wizualnego. Uzyskaj wgląd w widoczność swojej marki w AI i zoptymalizuj strategię treści wizualnych.

Dowiedz się, jak wyszukiwanie wizualne i AI zmieniają odkrywanie obrazów. Optymalizuj swoje obrazy pod Google Lens, AI Overviews i multimodalne LLM-y, aby zwięk...

Dowiedz się, czym jest wizualne wyszukiwanie AI, jak działa oraz jakie ma zastosowania w e-commerce i handlu detalicznym. Odkryj technologie stojące za wyszukiw...

Dowiedz się, jak zoptymalizować swoją markę pod asystentów głosowych, takich jak Alexa i Siri. Poznaj strategie poprawy widoczności w wynikach wyszukiwania głos...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.