Jak Kancelarie Prawne Zyskują Widoczność w ChatGPT, Perplexity i Wyszukiwarkach AI

Dowiedz się, jak kancelarie prawne poprawiają widoczność w wyszukiwarkach opartych na AI i generatorach odpowiedzi. Poznaj strategie pojawiania się w ChatGPT, P...

Dowiedz się, jak kancelarie prawne mogą zoptymalizować widoczność w AI przy zachowaniu standardów etycznych. Poznaj wytyczne ABA, protokoły poufności i praktyczne strategie marketingu prawnego z wykorzystaniem AI.

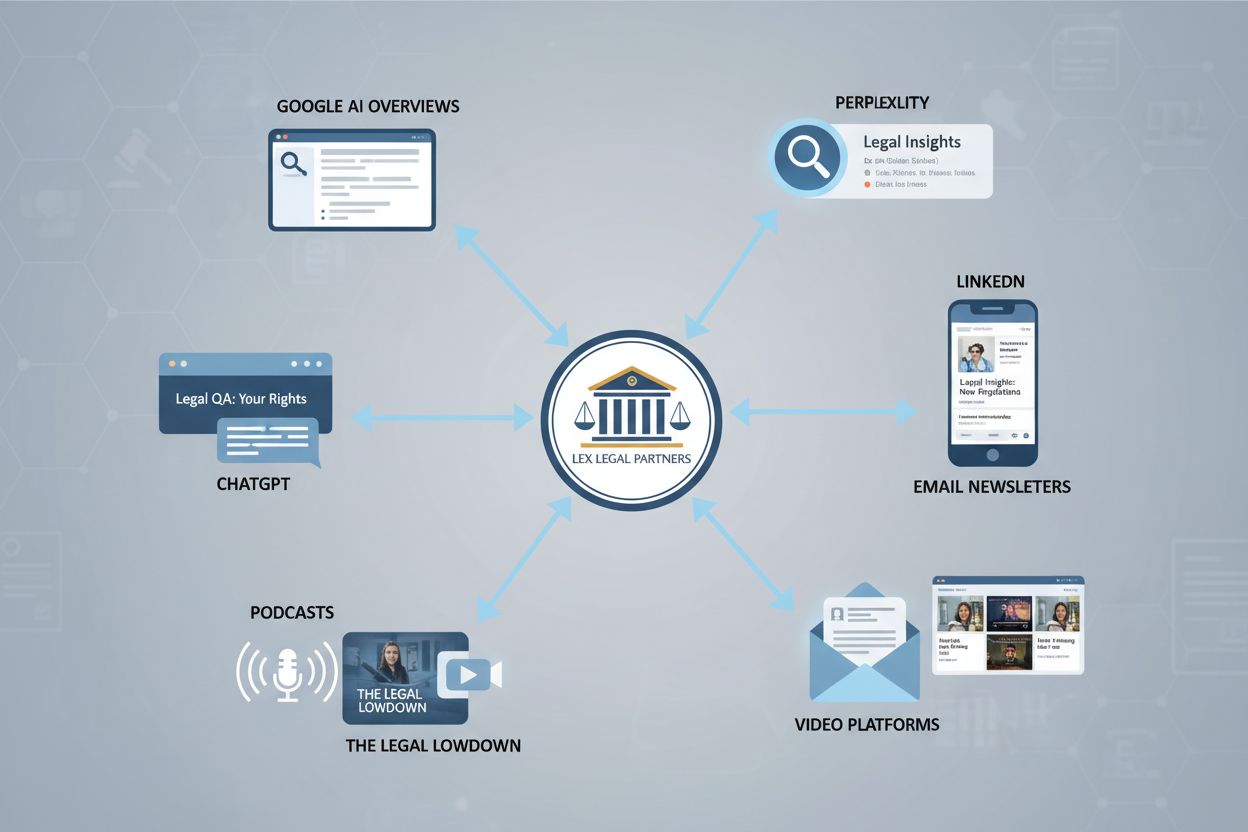

Krajobraz odkrywania usług prawnych uległ fundamentalnej transformacji, wykraczając poza tradycyjną optymalizację pod wyszukiwarki. Kancelarie nie mogą już polegać wyłącznie na pozycjach w Google, by zapewnić widoczność—potencjalni klienci odkrywają ekspertyzę prawną przez platformy napędzane AI, chatboty, asystentów głosowych i wyspecjalizowane narzędzia prawnicze działające niezależnie od klasycznych wyników wyszukiwania. Systemy AI są trenowane na różnorodnych formatach treści, w tym postach blogowych, treściach z mediów społecznościowych, transkrypcjach wideo, podcastach i opiniach klientów, co oznacza, że widoczność kancelarii zależy od obecności na wielu powierzchniach jednocześnie. Gdy potencjalny klient pyta ChatGPT, Claude lub wyspecjalizowaną platformę AI dla branży prawnej o rekomendacje adwokata, system korzysta z danych treningowych, które mogą zawierać treści Twojej kancelarii ze źródeł, których nigdy nie optymalizowałeś. Model wielopowierzchniowego odkrywania wymaga od kancelarii wyjścia poza strategie jednokanałowe i budowania kompleksowego ekosystemu treści, który dostarcza systemom AI autorytatywnych, rzetelnych informacji. Tradycyjne metryki SEO, takie jak pozycje słów kluczowych i profil linków, pozostają istotne, lecz są już niewystarczające—kancelarie muszą obecnie monitorować, jak ich treści pojawiają się w odpowiedziach AI na kilkudziesięciu różnych platformach. Ta zmiana to zarówno wyzwanie, jak i szansa: kancelarie, które zrozumieją i dostosują się do nowego krajobrazu, zyskują przewagę konkurencyjną, natomiast te trzymające się przestarzałych strategii widoczności ryzykują, że staną się niewidoczne dla mechanizmów odkrywania napędzanych AI.

Formalna Opinia 512 American Bar Association, wydana w lipcu 2024 roku, zapewnia kluczowe wytyczne, jak prawnicy powinni podchodzić do narzędzi AI przy zachowaniu obowiązków etycznych. To przełomowe stanowisko podkreśla, że prawnicy pozostają w pełni odpowiedzialni za produkty pracy generowane przez AI, niezależnie od tego, czy sami sporządzili treść, czy powierzyli to systemowi AI. Opinia wskazuje siedem podstawowych obowiązków etycznych związanych z użyciem AI: kompetencja w rozumieniu możliwości i ograniczeń AI, zachowanie poufności klienta, szczerość wobec sądów, właściwy nadzór nad podwładnymi używającymi AI, rozsądne opłaty, komunikacja z klientem na temat korzystania z AI oraz zapewnienie zasadności roszczeń. Każdy z tych obowiązków niesie konkretne konsekwencje dla sposobu, w jaki kancelarie mogą etycznie wykorzystywać AI do widoczności, tworzenia treści i komunikacji z klientami. Wymóg kompetencji oznacza, że partnerzy muszą rozumieć nie tylko, jak korzystać z narzędzi AI, lecz także ich dokładność, ryzyko halucynacji i odpowiednie przypadki użycia. Obowiązek zachowania poufności wymaga starannego wyboru dostawców i protokołów zarządzania danymi, by informacje klientów nigdy nie stały się danymi treningowymi dla zewnętrznych systemów AI. Szczerość wobec sądów oznacza, że każde cytowanie lub analizę prawną wygenerowaną przez AI należy zweryfikować przed złożeniem, ponieważ sądy już ukarały prawników za przedstawienie sfabrykowanych przypadków wygenerowanych przez AI.

| Obowiązek etyczny | Znaczenie dla AI | Działania kancelarii |

|---|---|---|

| Kompetencja | Konieczność zrozumienia możliwości, ograniczeń i dokładności AI | Szkolenia z narzędzi AI; ustanowienie standardów kompetencji przed wdrożeniem |

| Poufność | Ryzyko dla danych klientów przy zewnętrznych dostawcach AI i uczeniu modeli LLM | Rygorystyczna weryfikacja dostawców; używanie rozwiązań lokalnych/prywatnych; anonimizacja danych |

| Szczerość wobec sądu | Cytowania i analizy prawne AI muszą być zweryfikowane | Obowiązkowe protokoły weryfikacji; zakaz składania niezweryfikowanych materiałów AI |

| Nadzór | Odpowiedzialność za korzystanie z AI przez podwładnych | Polityki AI dla całej firmy; monitorowanie użycia; mechanizmy zatwierdzania |

| Rozsądne opłaty | Efektywność AI może wymagać korekty opłat | Komunikacja z klientem o wykorzystaniu AI; dostosowanie rozliczeń do zwiększonej efektywności |

| Komunikacja z klientem | Klienci zasługują na przejrzystość co do roli AI | Informowanie o AI w listach intencyjnych; wyjaśnienie wpływu na sprawę klienta |

| Zasadność roszczeń | AI nie może służyć popieraniu bezzasadnych roszczeń | Weryfikacja wszystkich tez prawnych generowanych przez AI; zachowanie niezależnego osądu |

Poufność klienta stanowi najważniejszą kwestię etyczną przy wdrażaniu narzędzi AI dla widoczności kancelarii i tworzenia treści. Wiele popularnych platform AI, w tym darmowe wersje ChatGPT i innych dużych modeli językowych, wykorzystuje przesyłane dane do trenowania kolejnych wersji systemów, co tworzy niedopuszczalne ryzyko, że poufne informacje klientów mogą zostać ujawnione lub przypadkowo przytoczone w odpowiedziach dla innych użytkowników. Maryland State Bar Association i inne organy regulacyjne wydały wyraźne ostrzeżenia, by prawnicy nie wprowadzali żadnych danych identyfikujących klienta, szczegółów spraw ani komunikacji objętej tajemnicą do systemów AI stron trzecich bez wyraźnych zabezpieczeń umownych. Kancelarie muszą wdrożyć rygorystyczne procedury weryfikacji dostawców, obejmujące praktyki zarządzania danymi, standardy szyfrowania, polityki retencji danych oraz gwarancje umowne, że informacje nie będą wykorzystywane do trenowania modeli. Protokół anonimizacji staje się niezbędny—wszelkie informacje klienta wykorzystywane do tworzenia treści wspomaganych AI muszą być dokładnie zanonimizowane, a dane identyfikujące zastąpione ogólnymi przykładami. Umowy licencyjne z dostawcami AI powinny jasno określać własność danych, prawa do ich użycia i odpowiedzialność za naruszenia, z preferencją dla rozwiązań korporacyjnych oferujących wdrożenie lokalne albo prywatne instancje. Kancelarie powinny również rozróżniać polityką treści publiczne (gdzie pomoc AI jest zwykle akceptowalna) i pracę poufną (gdzie wykorzystanie AI wymaga szczególnej ostrożności i zgody klienta). Regularne audyty użycia narzędzi AI pomagają zapewnić zgodność, a szkolenia personelu muszą podkreślać, że nie każde zastosowanie AI jest odpowiednie w pracy prawniczej, niezależnie od zysków w efektywności.

Halucynacje AI—sytuacje, w których modele językowe generują przekonujące, lecz całkowicie zmyślone informacje—stanowią poważne zagrożenie dla wiarygodności kancelarii i rezultatów klientów. Halucynacja pojawia się, gdy system AI z przekonaniem prezentuje fałszywą informację jako fakt, np. wymyśla cytowania spraw, błędnie cytuje przepisy lub tworzy fikcyjne precedensy, które brzmią autentycznie, lecz nie istnieją. Branża prawnicza już doświadczyła bolesnych lekcji: w 2023 roku dwóch prawników z Nowego Jorku zostało ukaranych i zagrożonych wydaleniem z zawodu za złożenie pisma zawierającego sześć sfabrykowanych spraw wygenerowanych przez ChatGPT, a w 2024 roku prawnik z Teksasu poniósł podobne konsekwencje za poleganie na cytowaniach AI bez podstawy prawnej. Przypadki te pokazują, że halucynacje to nie teoretyczne ryzyko, lecz udokumentowany problem, skutkujący dyscyplinowaniem zawodowym i szkodami dla klientów. Badania Thomson Reuters wskazują, że obecne duże modele językowe halucynują w 3-10% przypadków w zależności od złożoności zadania, co oznacza, że nawet pozornie wiarygodne wyniki AI wymagają weryfikacji. Kancelarie muszą wdrożyć obowiązkowe protokoły weryfikacji przez człowieka, w których każda analiza prawna, cytowanie lub twierdzenie faktograficzne generowane przez AI jest niezależnie sprawdzane przez wykwalifikowanego prawnika przed użyciem w pracy dla klienta lub w pismach sądowych. W przypadku treści marketingowych, halucynacje niosą ryzyko reputacyjne—sfabrykowane statystyki, błędnie cytowani eksperci czy wymyślone przykłady spraw mogą podważyć wiarygodność kancelarii i narazić ją na odpowiedzialność. Ustanowienie jasnych procedur weryfikacji, wykorzystywanie AI głównie do szkicowania i generowania pomysłów, a nie do finalnej analizy oraz dokumentowanie procesu weryfikacji chroni zarówno klientów, jak i reputację kancelarii.

Skuteczna widoczność w AI wymaga odejścia od jednolitego tworzenia treści na rzecz kompleksowej strategii, w której kluczowa ekspertyza jest wykorzystywana w wielu kanałach i formatach. Jeden dobrze opracowany artykuł o prawie pracy może stać się podstawą do stworzenia filmu wyjaśniającego, audiogramu na LinkedIn, odcinka podcastu, krótkich postów w social media, treści do newslettera i przewodników dla klientów—każdy format zoptymalizowany pod różne systemy AI i preferencje odbiorców. Narzędzia AI doskonale przyspieszają ten proces przetwarzania treści: mogą generować scenariusze wideo z artykułów, tworzyć opisy do mediów społecznościowych, szkicować tematy maili i opracowywać różne wersje konspektów pod konkretne segmenty odbiorców, jednak ostateczna weryfikacja i korekta należą do prawników. Przewaga strategiczna pojawia się, gdy kancelaria rozumie, że systemy AI trenujące na różnych formatach treści natrafią na jej ekspertyzę w wielu kontekstach, zwiększając szansę cytowania w odpowiedziach AI. Opracowanie szablonów promptów dla typowych treści—np. „Stwórz 3-minutowy scenariusz wideo wyjaśniający [temat prawny] dla przedsiębiorców bez wiedzy prawniczej”—umożliwia spójne i efektywne tworzenie treści przy zachowaniu wysokiej jakości. Targetowanie odbiorców staje się bardziej wyrafinowane, gdy wiadomo, które formaty najlepiej rezonują z różnymi segmentami klientów: klienci korporacyjni preferują szczegółowe white papers i webinary, podczas gdy konsumenci indywidualni reagują lepiej na krótkie filmy i treści w social media. Kancelarie powinny tworzyć kalendarze redakcyjne mapujące kluczowe obszary ekspertyzy na różne formaty, jasno przypisywać odpowiedzialność za szkicowanie AI i weryfikację przez człowieka oraz mierzyć zaangażowanie w kanałach, by określić, które formaty generują najbardziej wartościowe zapytania. Podejście wieloformatowe daje także naturalne możliwości wzajemnego linkowania treści, tworząc sieć powiązanych zasobów, które systemy AI rozpoznają jako autorytatywne pokrycie określonych zagadnień prawnych.

Tradycyjne metryki marketingowe kancelarii—ruch na stronie, formularze kontaktowe czy liczba połączeń telefonicznych—nie dają pełnego obrazu tego, jak systemy AI odkrywają i rekomendują Twoją kancelarię. Share of Voice (SOV) mierzy, w jakim procencie odpowiedzi generowanych przez AI w Twojej specjalizacji pojawia się Twoja kancelaria, dając wgląd w pozycję konkurencyjną w krajobrazie odkrywania napędzanego AI. Visibility Score agreguje wiele danych, by stworzyć kompleksowy wskaźnik obecności kancelarii na platformach AI, w wyszukiwarkach i katalogach prawniczych. Częstotliwość Wzmianki śledzi, jak często kancelaria, prawnicy i obszary ekspertyzy pojawiają się w treściach generowanych przez AI, a Metryki Cytowań oceniają, czy systemy AI cytują Twoje materiały jako autorytatywne źródła. Pokrycie Tematów pokazuje, jak kompleksowo treści kancelarii odpowiadają na pełne spektrum pytań potencjalnych klientów o Twoje praktyki. Te metryki wymagają wyspecjalizowanych narzędzi monitorujących zaprojektowanych specjalnie do widoczności w AI, bo tradycyjne platformy analityczne nie śledzą wzmianek w odpowiedziach ChatGPT, wynikach Claude czy wyspecjalizowanych platformach prawniczych AI.

Kluczowe metryki widoczności w AI dla kancelarii:

Metryki zaangażowania zyskują nową wagę w kontekście widoczności w AI: gdy Twoje treści pojawiają się w odpowiedziach AI, czy generują przejścia na stronę, formularze kontaktowe lub połączenia? Śledzenie, które platformy AI i formaty treści generują najbardziej wartościowe leady, pozwala kancelarii zoptymalizować strategię treści i budżet. Należy ustalić wartości wyjściowe obecnej widoczności w AI przed wdrożeniem nowych strategii, a następnie monitorować postępy kwartalnie, by określić, które typy, tematy i formaty treści generują najsilniejszą obecność w AI. Takie podejście oparte na danych zastępuje zgadywanie dowodami, umożliwiając partnerom uzasadnienie inwestycji marketingowych i doskonalenie strategii w oparciu o rzeczywiste wyniki, a nie przypuszczenia co do priorytetów systemów AI.

Skuteczna widoczność w AI i zgodność etyczna wymagają formalnych polityk zarządzania, które jasno określają zasady korzystania z narzędzi AI przez prawników, aplikantów i personel pomocniczy. Kompleksowa polityka AI powinna obejmować dopuszczalne przypadki użycia, zakazane zastosowania, procedury zatwierdzania i konsekwencje naruszeń, zapewniając, że entuzjazm wobec efektywności AI nie przysłania obowiązków etycznych. Polityka musi wyraźnie rozróżniać kategorie użycia AI: tworzenie treści i marketing (zwykle akceptowalne przy weryfikacji), badania i analiza prawna (wymagają weryfikacji i nadzoru prawnika), komunikacja z klientem (wymaga ujawnienia i zatwierdzenia) oraz praca poufna (wymaga szczególnej ostrożności i często zgody klienta). Obowiązki nadzoru wynikające z Formal Opinion 512 ABA oznaczają, że partnerzy ponoszą odpowiedzialność za prawidłowe korzystanie z AI przez podwładnych, co wymaga mechanizmów monitorowania i regularnych szkoleń. Personel niebędący prawnikami potrzebuje precyzyjnych instrukcji dotyczących narzędzi AI, do których mają dostęp, typów informacji, które mogą wprowadzać, oraz zadań wymagających weryfikacji przez prawnika przed ukończeniem. Standardy kompetencji technologicznej powinny określać, że prawnicy korzystający z AI muszą rozumieć możliwości, ograniczenia i wskaźniki dokładności narzędzi—może to wymagać formalnych szkoleń, certyfikatów lub wykazania kompetencji przed samodzielnym użyciem AI. Polityka powinna także regulować postępowanie przy aktualizacjach narzędzi AI, wdrażaniu nowych platform i pojawiających się ryzykach, ustanawiając proces regularnego przeglądu i aktualizacji polityk wraz z rozwojem technologii. Dokumentowanie wdrożenia polityk, szkoleń i monitorowania zgodności stanowi dowód rzetelnych starań o utrzymanie standardów etycznych, co nabiera znaczenia, jeśli organy regulacyjne zakwestionują praktyki AI w kancelarii.

Kancelarie gotowe do optymalizacji widoczności w AI przy zachowaniu standardów etycznych powinny przyjąć strukturalne, czterofilarowe podejście wdrożeniowe obejmujące treści, formaty, odbiorców i infrastrukturę technologiczną. Filara Content Engine skupia się na opracowywaniu autorytatywnej, oryginalnej ekspertyzy w kluczowych obszarach praktyki—oznacza to identyfikację 20-30 najważniejszych pytań klientów dotyczących Twojej praktyki i tworzenie kompleksowych, dobrze zbadanych treści, które odpowiadają na nie lepiej niż konkurencja. Filara Formatów zapewnia, że ta kluczowa treść dociera do systemów AI przez różne kanały: artykuły pisane dla wyszukiwarek i baz prawniczych, materiały wideo na YouTube i platformach społecznościowych, treści audio do podcastów i asystentów głosowych oraz dane strukturalne ułatwiające systemom AI zrozumienie Twojej ekspertyzy. Filara Odbiorców wymaga segmentacji i targetowania—różne typy klientów (korporacyjni, indywidualni, in-house) odkrywają usługi prawnicze przez różne platformy AI i reagują na odmienne formaty treści, więc strategia musi odpowiadać preferowanym metodom odkrywania każdego segmentu. Filara Technologiczna obejmuje narzędzia i procesy umożliwiające efektywne, zgodne z przepisami tworzenie treści: asystentów AI do szkicowania, narzędzia do weryfikacji dokładności, platformy analityczne do pomiaru widoczności w AI i systemy zarządzania zgodnością etyczną.

Praktyczne kroki wdrożeniowe na 2025 rok to: przeprowadzenie audytu widoczności w AI w celu określenia wartości bazowych na głównych platformach; przygotowanie 12-miesięcznego kalendarza treści mapującego kluczowe obszary ekspertyzy na różne formaty; ustanowienie polityk zarządzania AI i przeszkolenie całego personelu w zakresie akceptowalnych zastosowań; wybór i wdrożenie narzędzi do monitorowania widoczności w AI; stworzenie szablonów treści i bibliotek promptów przyspieszających tworzenie treści wieloformatowych; oraz ustanowienie kwartalnych przeglądów wyników i optymalizacji strategii. Miary sukcesu powinny obejmować zarówno wskaźniki ilościowe (Share of Voice, częstotliwość wzmianek, liczba leadów), jak i jakościowe (jakość leadów, opinie klientów, pozycja konkurencyjna). Kancelarie wdrażające tę mapę drogową systematycznie zyskują znaczącą przewagę: stają się widoczne dla mechanizmów odkrywania napędzanych AI, budują pozycję autorytatywnego źródła cytowanego przez systemy AI i zapewniają trwałą widoczność niezależnie od ewolucji technologii. Kancelarie, które opóźniają działania lub podchodzą do widoczności w AI chaotycznie, ryzykują utratą widoczności na coraz bardziej zdominowanym przez AI rynku usług prawniczych, oddając potencjalnych klientów konkurencji, która zoptymalizowała obecność na wielu platformach i w różnych formatach AI.

American Bar Association wydało Formal Opinion 512 w lipcu 2024 roku, ustanawiając, że prawnicy pozostają w pełni odpowiedzialni za produkty pracy generowane przez AI i muszą zachować siedem podstawowych obowiązków etycznych: kompetencję, poufność, szczerość wobec sądów, nadzór, rozsądne opłaty, komunikację z klientem oraz zasadność roszczeń. Prawnicy muszą rozumieć możliwości i ograniczenia AI przed jego użyciem.

Kancelarie powinny wdrożyć rygorystyczną weryfikację dostawców, korzystać z rozwiązań AI lokalnych lub prywatnych, anonimizować wszystkie dane identyfikujące klienta przed wprowadzeniem do systemów AI oraz zawierać umowy licencyjne z wyraźnymi zapisami o poufności. Nigdy nie należy wprowadzać poufnych informacji do darmowych, publicznych narzędzi AI, takich jak ChatGPT, bez zabezpieczeń korporacyjnych.

Halucynacje AI pojawiają się, gdy modele językowe generują przekonująco brzmiące, lecz całkowicie zmyślone informacje, np. wymyślają cytowania spraw lub błędnie cytują przepisy. Ma to znaczenie, ponieważ sądy już ukarały prawników za przedłożenie fałszywych spraw wygenerowanych przez AI, a halucynacje mogą zaszkodzić sprawom klientów i reputacji kancelarii. Wszystkie analizy prawne generowane przez AI muszą być niezależnie weryfikowane.

Kancelarie powinny monitorować metryki specyficzne dla AI, takie jak Share of Voice (procent odpowiedzi AI wspominających o Twojej kancelarii), Visibility Score (kompleksowa miara obecności na platformach), Częstotliwość Wzmianki (jak często kancelaria się pojawia), Metryki Cytowań (czy AI cytuje Twoje treści) oraz Pokrycie Tematów (zakres tematyczny). Tradycyjne metryki, jak ruch na stronie, są niewystarczające.

Systemy AI są trenowane na różnorodnych formatach, w tym artykułach pisemnych, transkrypcjach wideo, podcastach, treściach z mediów społecznościowych i danych strukturalnych. Kancelarie powinny wykorzystywać swoją ekspertyzę w wielu formatach — jeden artykuł może stać się filmem, audiogramem, postami w social media i materiałami do newslettera. Takie podejście zwiększa szansę cytowania i odnalezienia przez AI.

Tak. ABA Formal Opinion 512 ustanawia, że partnerzy ponoszą odpowiedzialność za korzystanie z AI przez podwładnych. Kompleksowe polityki AI powinny obejmować dopuszczalne przypadki użycia, zakazane zastosowania, procedury zatwierdzania, wymogi poufności i szkolenia pracowników. Polityki muszą rozróżniać tworzenie treści (zazwyczaj dopuszczalne), analizę prawną (wymaga weryfikacji) oraz pracę poufną (wymaga szczególnej ostrożności).

Wdrożenie podejścia human-in-the-loop, w którym AI wspiera redagowanie i generowanie pomysłów, lecz wykwalifikowani prawnicy weryfikują wszystkie wyniki przed użyciem. Należy ustanowić jasne protokoły weryfikacji, wykorzystywać AI głównie dla zwiększenia efektywności, a nie zastępowania osądu zawodowego, prowadzić szczegółową dokumentację procesu weryfikacji i zapewnić zrozumienie przez cały personel, że AI jest narzędziem wspierającym, a nie zastępującym ekspertyzę.

Konsumenckie narzędzia AI, takie jak ChatGPT, są trenowane na ogólnych danych z internetu i halucynują w 3-10% przypadków, co stwarza poważne ryzyko w pracy prawnej. Narzędzia AI dla prawników są trenowane na zaufanych bazach danych prawniczych i zaprojektowane, by ograniczać halucynacje, choć weryfikacja nadal jest wymagana. Rozwiązania korporacyjne oferują lepszą ochronę danych i gwarancje poufności niż darmowe publiczne narzędzia.

Śledź, w jaki sposób systemy AI odnoszą się do Twojej kancelarii i mierz swoją obecność w odpowiedziach generowanych przez AI. Zyskaj przewagę konkurencyjną, rozumiejąc swoje metryki widoczności w AI i optymalizując obecność na platformach AI.

Dowiedz się, jak kancelarie prawne poprawiają widoczność w wyszukiwarkach opartych na AI i generatorach odpowiedzi. Poznaj strategie pojawiania się w ChatGPT, P...

Dowiedz się, jak agencje SEO mogą poszerzyć zakres swoich usług, dodając monitorowanie widoczności AI i optymalizację pod generatywne silniki, aby pozostać konk...

Dowiedz się, czym jest Widoczność AI w prawie dla kancelarii. Poznaj sposoby optymalizacji obecności w odpowiedziach prawnych generowanych przez AI, zarządzania...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.