Błędy indeksowania AI

Dowiedz się, czym są błędy indeksowania AI – problemy techniczne uniemożliwiające botom AI dostęp do treści. Poznaj zagadnienia renderowania JavaScript, robots....

Dowiedz się, czym jest błąd doboru źródeł w AI, jak wpływa na modele uczenia maszynowego, zobacz przykłady z życia oraz poznaj strategie wykrywania i ograniczania tego kluczowego problemu sprawiedliwości.

Błąd doboru źródeł występuje, gdy dane treningowe nie odzwierciedlają ogólnej populacji lub rzeczywistego rozkładu, przez co modele AI dokonują niedokładnych predykcji względem niedostatecznie reprezentowanych grup lub scenariuszy.

Błąd doboru źródeł to podstawowy problem w sztucznej inteligencji, który pojawia się, gdy dane wykorzystywane do trenowania modeli uczenia maszynowego nie odzwierciedlają rzeczywistej populacji lub rozkładu, dla którego są przeznaczone. Tego typu błąd powstaje, gdy zbiory danych są wybierane w sposób systematycznie wykluczający lub niedoreprezentujący pewne grupy, scenariusze czy cechy. W efekcie modele AI uczą się wzorców na niepełnych lub zniekształconych danych, co prowadzi do predykcji niedokładnych, niesprawiedliwych lub dyskryminujących wobec niedostatecznie reprezentowanych populacji. Zrozumienie tego błędu jest kluczowe dla wszystkich, którzy rozwijają, wdrażają lub polegają na systemach AI, ponieważ bezpośrednio wpływa on na sprawiedliwość, dokładność i niezawodność zautomatyzowanego podejmowania decyzji w różnych branżach.

Błąd doboru źródeł różni się od innych rodzajów uprzedzeń tym, że jego źródło leży już na etapie zbierania danych. Zamiast wynikać z wyborów algorytmicznych lub ludzkich założeń podczas tworzenia modelu, błąd doboru źródeł jest wbudowany w fundament zbioru treningowego. Sprawia to, że jest szczególnie podstępny, ponieważ modele trenowane na stronniczych danych źródłowych będą utrwalać i wzmacniać te uprzedzenia w swoich predykcjach, niezależnie od wyrafinowania algorytmu. Problem staje się jeszcze bardziej poważny, gdy systemy AI są wdrażane w obszarach o wysokiej stawce, takich jak opieka zdrowotna, finanse, wymiar sprawiedliwości czy rekrutacja, gdzie stronnicze predykcje mogą mieć poważne konsekwencje dla jednostek i społeczności.

Błąd doboru źródeł powstaje na kilka różnych sposobów podczas procesu zbierania i przygotowania danych. Najczęstszą drogą jest błąd pokrycia (coverage bias), gdy pewne populacje lub scenariusze są systematycznie wykluczane ze zbioru treningowego. Na przykład, jeśli system rozpoznawania twarzy jest trenowany głównie na zdjęciach osób o jasnej karnacji, będzie on słabo radził sobie z rozpoznawaniem twarzy o ciemniejszej skórze, co prowadzi do wyższego poziomu błędów w tej populacji. Dzieje się tak, ponieważ osoby zbierające dane mogą mieć ograniczony dostęp do różnorodnych populacji albo nieświadomie faworyzować określone grupy podczas zbierania danych.

Kolejnym ważnym mechanizmem jest błąd nieudziału (non-response bias), zwany też błędem uczestnictwa, który występuje, gdy pewne grupy rzadziej biorą udział w procesie zbierania danych. Przykładowo, w zbiorze danych opartym na ankietach do przewidywania preferencji konsumentów, jeśli niektóre grupy demograficzne znacznie rzadziej odpowiadają na ankiety, ich preferencje będą niedoreprezentowane w danych treningowych. Powoduje to, że zbiór danych wydaje się zrównoważony, ale w rzeczywistości odzwierciedla wzorce uczestnictwa, a nie prawdziwe cechy populacji. W opiece zdrowotnej, jeśli dane z badań klinicznych pochodzą głównie z miast posiadających zaawansowane placówki medyczne, modele AI mogą nie sprawdzać się w społecznościach wiejskich lub zaniedbanych.

Błąd próbkowania (sampling bias) to kolejny mechanizm, gdzie podczas zbierania danych nie stosuje się odpowiedniej randomizacji. Zamiast losowo wybierać dane, zbierający mogą wybierać pierwsze dostępne próbki lub korzystać z wygodnych metod doboru. Powoduje to systematyczne błędy, ponieważ wybrane próbki nie są reprezentatywne dla całej populacji. Na przykład, jeśli model AI do przewidywania niespłacania kredytów jest trenowany na danych z konkretnego regionu lub okresu, może nie przewidywać poprawnie niespłacalności w innych regionach lub w różnych warunkach ekonomicznych.

| Rodzaj błędu | Mechanizm | Przykład z życia |

|---|---|---|

| Błąd pokrycia | Systematyczne wykluczenie populacji | Rozpoznawanie twarzy trenowane tylko na jasnej karnacji |

| Błąd nieudziału | Luki w uczestnictwie podczas zbierania | Modele zdrowotne trenowane tylko na miejskich populacjach |

| Błąd próbkowania | Nieprawidłowa randomizacja wyboru | Modele kredytowe trenowane na jednym regionie geograficznym |

| Błąd czasowy | Dane z określonych okresów | Modele trenowane na danych sprzed pandemii używane po pandemii |

| Błąd różnorodności źródeł | Ograniczenie liczby źródeł danych | Zbiory obrazów medycznych z jednego szpitala |

Konsekwencje błędu doboru źródeł w systemach AI są głębokie i dalekosiężne, dotyczące zarówno jednostek, jak i organizacji. W ochronie zdrowia błąd ten doprowadził do powstania systemów diagnostycznych, które znacznie słabiej działają dla określonych grup pacjentów. Badania wykazały, że algorytmy AI do diagnozowania raka skóry mają znacznie niższą dokładność u osób o ciemniejszej karnacji, a niektóre analizy pokazują zaledwie połowę skuteczności w porównaniu do pacjentów o jasnej skórze. Ta różnica prowadzi bezpośrednio do opóźnionych diagnoz, niewłaściwych zaleceń terapeutycznych i gorszych wyników zdrowotnych dla niedostatecznie reprezentowanych grup. Gdy dane treningowe pochodzą głównie od pacjentów jednej grupy demograficznej, modele uczą się wzorców charakterystycznych dla tej grupy i nie potrafią uogólnić ich na inne.

W finansach błąd doboru źródeł w algorytmach oceny zdolności kredytowej i udzielania pożyczek utrwalił historyczną dyskryminację. Modele trenowane na historycznych danych, które odzwierciedlają wcześniejsze dyskryminacyjne praktyki, powielają te same uprzedzenia podczas podejmowania nowych decyzji kredytowych. Jeżeli pewne grupy były historycznie pozbawiane kredytu z powodu systemowej dyskryminacji, a te dane są używane do trenowania modeli AI, modele będą odmawiać kredytu podobnym grupom w przyszłości. Tworzy to błędne koło, gdzie historyczne nierówności zostają zakodowane w algorytmicznych decyzjach i wpływają na dostęp do kapitału i możliwości ekonomiczne.

Rekrutacja i zatrudnienie to kolejny obszar, gdzie błąd doboru źródeł powoduje poważne szkody. Narzędzia AI używane do selekcji CV wykazują uprzedzenia względem rasy czy płci, a badania pokazują, że nazwiska kojarzone z białą rasą były preferowane w 85% przypadków w niektórych systemach. Gdy dane treningowe pochodzą z historycznych rejestrów zatrudnienia odzwierciedlających wcześniejsze dyskryminacje lub jednolite wzorce rekrutacji, modele AI uczą się powielać te schematy. Oznacza to, że błąd doboru źródeł w danych rekrutacyjnych utrwala dyskryminację w miejscu pracy na szeroką skalę, ograniczając szanse dla niedostatecznie reprezentowanych grup i zmniejszając różnorodność zespołów.

W wymiarze sprawiedliwości błąd doboru źródeł w systemach predykcyjnych do prewencji przestępczości prowadził do nieproporcjonalnego ukierunkowania na określone społeczności. Gdy dane treningowe pochodzą z historycznych rejestrów zatrzymań, które same w sobie były stronnicze względem marginalizowanych grup, modele te wzmacniają uprzedzenia, przewidując wyższy poziom przestępczości w tych społecznościach. Tworzy się błędne koło: stronnicze predykcje prowadzą do intensywniejszego nadzoru w danym obszarze, co generuje kolejne dane o zatrzymaniach i pogłębia uprzedzenia w modelu.

Wykrywanie błędu doboru źródeł wymaga systematycznego podejścia łączącego analizę ilościową, ocenę jakościową i ciągły monitoring przez cały cykl życia modelu. Pierwszym krokiem jest kompleksowy audyt danych, który bada źródła, metody zbierania i reprezentatywność danych treningowych. Obejmuje to dokumentowanie, skąd pochodzą dane, jak zostały zebrane oraz czy proces ten mógł systematycznie wykluczyć pewne populacje lub scenariusze. Należy zadawać kluczowe pytania: Czy wszystkie istotne grupy demograficzne były reprezentowane podczas zbierania danych? Czy istniały bariery udziału, które mogły zniechęcić pewne grupy? Czy okres zbierania danych lub zasięg geograficzny ograniczał reprezentację?

Analiza parytetu demograficznego to ilościowa metoda wykrywania błędu doboru źródeł. Polega na porównaniu rozkładu kluczowych cech w danych treningowych z rozkładem w rzeczywistej populacji docelowej. Jeżeli w danych treningowych pewne grupy demograficzne, przedziały wiekowe, regiony geograficzne lub inne istotne cechy są znacząco niedoreprezentowane, mamy dowód na występowanie błędu doboru źródeł. Przykładowo, jeśli dane treningowe zawierają jedynie 5% kobiet, a w populacji docelowej stanowią one 50%, oznacza to poważny błąd pokrycia, który prawdopodobnie przełoży się na słabe działanie modelu dla kobiet.

Analiza wydajności dla wycinków populacji (performance slice analysis) to kolejna ważna technika, polegająca na ocenie efektywności modelu osobno dla różnych grup demograficznych i podpopulacji. Nawet jeśli ogólna dokładność modelu wydaje się akceptowalna, wydajność może drastycznie się różnić między grupami. Jeśli model osiąga 95% dokładności ogólnej, ale jedynie 70% dla danej grupy demograficznej, oznacza to, że błąd doboru źródeł w danych treningowych sprawił, iż model nauczył się wzorców charakterystycznych dla większości, pomijając mniejszości. Analizę tę należy przeprowadzać nie tylko na podstawie ogólnej dokładności, ale także metryk sprawiedliwości, takich jak równość szans czy wskaźnik zróżnicowanego wpływu.

Testowanie adwersarialne polega na celowym tworzeniu przypadków testowych mających ujawnić potencjalne uprzedzenia. Może to obejmować testowanie modelu na danych z niedostatecznie reprezentowanych populacji, przypadkach brzegowych czy scenariuszach słabo reprezentowanych w zbiorze treningowym. Poprzez testowanie modelu na różnorodnych danych można zidentyfikować luki powstałe przez błąd doboru źródeł. Jeśli model był trenowany głównie na danych miejskich, należy dokładnie sprawdzić działanie na danych wiejskich. Jeśli dane treningowe pochodzą z określonego okresu, należy przetestować model na danych z innych okresów, by wykryć błąd czasowy.

Ograniczanie błędu doboru źródeł wymaga działań na różnych etapach cyklu życia AI, rozpoczynając od zbierania danych, przez ocenę modelu, aż po wdrożenie. Najskuteczniejszym podejściem jest data-centric mitigation, czyli eliminowanie uprzedzeń u źródła poprzez poprawę jakości i reprezentatywności danych treningowych. Zaczyna się to od różnorodnego zbierania danych, w którym aktywnie dąży się do uwzględnienia niedoreprezentowanych populacji i scenariuszy w zbiorze treningowym. Zamiast polegać na wygodnych próbkach lub istniejących zbiorach, organizacje powinny prowadzić celowe zbieranie danych, by zapewnić reprezentację wszystkich istotnych grup i przypadków użycia.

Techniki ponownego próbkowania i ważenia to praktyczne metody radzenia sobie z nierównowagą w istniejących zbiorach. Losowe nadpróbkowanie polega na duplikowaniu przykładów z niedoreprezentowanych grup, a losowe podpróbkowanie na redukcji przykładów z nadreprezentowanych grup. Bardziej zaawansowane podejścia, jak próbkowanie warstwowe, zapewniają proporcjonalną reprezentację wielu cech jednocześnie. Ważenie polega na przypisaniu większego znaczenia próbkom z mniejszości podczas trenowania modelu, co skutkuje większą uwagą algorytmu na wzorce charakterystyczne dla tych grup. Techniki te najlepiej sprawdzają się w połączeniu z aktywnym zbieraniem bardziej zróżnicowanych danych, a nie jako jedyne rozwiązanie na ograniczonym zbiorze.

Generowanie danych syntetycznych to kolejna ścieżka walki z błędem doboru źródeł, zwłaszcza gdy zebranie rzeczywistych danych od niedostatecznie reprezentowanych grup jest trudne lub kosztowne. Techniki takie jak Generative Adversarial Networks (GAN) czy Wariacyjne Autoenkodery (VAE) pozwalają tworzyć realistyczne przykłady syntetyczne dla tych grup. Bardziej wyspecjalizowane podejścia, jak SMOTE (Synthetic Minority Over-sampling Technique), tworzą syntetyczne przykłady poprzez interpolację pomiędzy istniejącymi próbkami mniejszościowymi. Jednak dane syntetyczne należy stosować ostrożnie i dokładnie weryfikować, ponieważ mogą one wprowadzić własne uprzedzenia, jeśli nie zostaną wygenerowane poprawnie.

Algorytmy świadome sprawiedliwości (fairness-aware algorithms) to strategia ograniczania na etapie trenowania modelu. Algorytmy te explicite uwzględniają ograniczenia sprawiedliwości podczas nauki, zapewniając, że model osiąga akceptowalną wydajność dla wszystkich grup demograficznych, nie tylko dla większości. Przykładowo, adwersarialne odbiasowanie wykorzystuje sieć adwersarialną, by upewnić się, że predykcje modelu nie pozwalają wywnioskować chronionych cech, takich jak rasa czy płeć. Regularizacja sprawiedliwościowa dodaje karę do funkcji straty za zachowania dyskryminacyjne. Pozwala to na świadome wyważenie kompromisu między ogólną dokładnością a sprawiedliwością, wybierając proporcje zgodne z priorytetami etycznymi.

Ciągły monitoring i ponowne trenowanie zapewniają, że błąd doboru źródeł nie pojawi się lub nie pogłębi z czasem. Nawet jeśli początkowe dane treningowe są reprezentatywne, rzeczywisty rozkład populacji może się zmieniać pod wpływem zmian demograficznych, gospodarczych lub innych czynników. Wdrożenie systemów monitorowania wydajności, które śledzą dokładność modelu osobno dla różnych grup demograficznych, pozwala wykryć pojawiające się uprzedzenia. Gdy wykryte zostanie pogorszenie wydajności, ponowne trenowanie na zaktualizowanych danych odzwierciedlających bieżący rozkład populacji może przywrócić sprawiedliwość. Ten proces jest ciągły i podkreśla, że ograniczanie uprzedzeń to nie jednorazowe działanie, lecz ciągła odpowiedzialność.

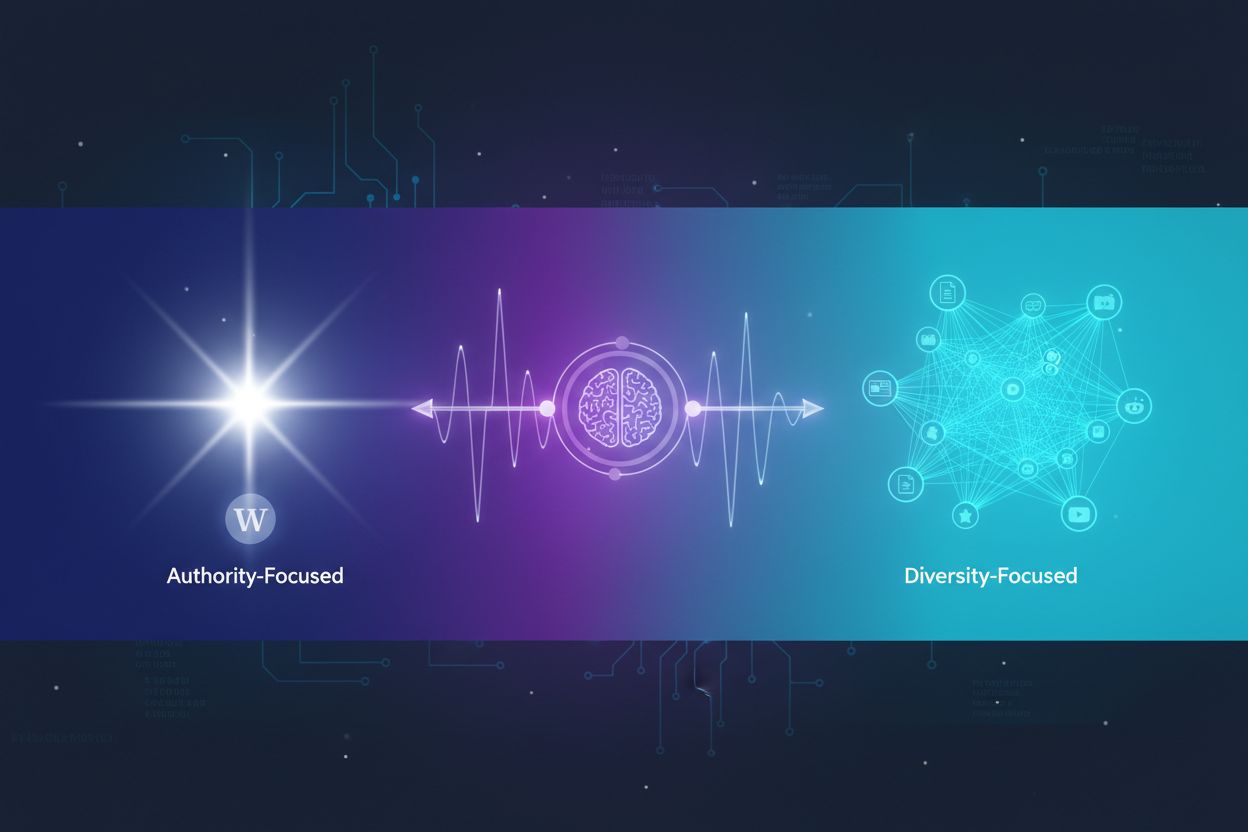

Zrozumienie błędu doboru źródeł staje się coraz ważniejsze w kontekście monitorowania odpowiedzi AI i widoczności marki. Ponieważ systemy AI takie jak ChatGPT, Perplexity i inne generatory odpowiedzi stają się głównym źródłem informacji dla użytkowników, źródła, które cytują te systemy oraz prezentowane przez nie informacje są kształtowane przez dane treningowe. Jeśli dane treningowe tych systemów AI wykazują błąd doboru źródeł, generowane odpowiedzi będą to odzwierciedlać. Na przykład, jeśli dane treningowe systemu AI nadmiernie reprezentują określone strony internetowe, publikacje czy perspektywy, a inne są niedoreprezentowane, system będzie częściej cytować i wzmacniać informacje z nadreprezentowanych źródeł.

Ma to bezpośrednie konsekwencje dla monitorowania marki i widoczności treści. Jeśli Twoja marka, domena lub adresy URL są niedoreprezentowane w danych treningowych głównych systemów AI, Twoje treści mogą być systematycznie pomijane lub rzadko pojawiać się w odpowiedziach AI. Z drugiej strony, jeśli dane treningowe nadmiernie reprezentują konkurencyjne marki lub źródła dezinformacji, te zyskują niewspółmiernie dużą widoczność. Monitorowanie obecności marki w odpowiedziach AI na różnych platformach pozwala zrozumieć, czy błąd doboru źródeł w tych systemach wpływa na Twoją widoczność i reputację. Śledząc, które źródła są cytowane, jak często pojawiają się Twoje treści i czy prezentowane informacje są rzetelne, możesz zidentyfikować potencjalne uprzedzenia w sposobie prezentacji Twojej marki i branży przez systemy AI.

Błąd doboru źródeł w AI to kluczowy problem sprawiedliwości, który powstaje już na etapie zbierania danych i propaguje się przez wszystkie zastosowania modeli uczenia maszynowego. Występuje, gdy dane treningowe systematycznie wykluczają lub niedoreprezentują określone populacje, scenariusze lub cechy, prowadząc do modeli generujących niedokładne lub niesprawiedliwe predykcje wobec niedostatecznie reprezentowanych grup. Konsekwencje są poważne i szerokie – dotyczą wyników zdrowotnych, dostępu do finansowania, możliwości zatrudnienia oraz decyzji w wymiarze sprawiedliwości. Wykrycie błędu doboru źródeł wymaga kompleksowych audytów danych, analizy parytetu demograficznego, analizy wydajności dla wycinków populacji i testowania adwersarialnego. Ograniczenie tego błędu wymaga wielowymiarowego podejścia, obejmującego różnorodne zbieranie danych, ponowne próbkowanie i ważenie, generowanie danych syntetycznych, algorytmy świadome sprawiedliwości oraz ciągły monitoring. Organizacje muszą zrozumieć, że adresowanie błędu doboru źródeł nie jest opcjonalne, lecz niezbędne do budowy systemów AI sprawiedliwych, dokładnych i godnych zaufania dla wszystkich populacji i przypadków użycia.

Upewnij się, że Twoja marka jest prawidłowo prezentowana w odpowiedziach generowanych przez AI na platformach takich jak ChatGPT, Perplexity i inne. Śledź, jak systemy AI cytują Twoje treści oraz identyfikuj potencjalne uprzedzenia w odpowiedziach AI.

Dowiedz się, czym są błędy indeksowania AI – problemy techniczne uniemożliwiające botom AI dostęp do treści. Poznaj zagadnienia renderowania JavaScript, robots....

Dowiedz się, jak systemy AI decydują, czy cytować wiele źródeł, czy koncentrować się na tych autorytatywnych. Poznaj wzorce cytowań w ChatGPT, Google AI Overvie...

Dowiedz się, jak systemy AI wybierają i porządkują źródła do cytowania. Poznaj algorytmy, sygnały i czynniki decydujące o tym, które strony internetowe są cytow...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.